departamento de eléctrica y electrónica

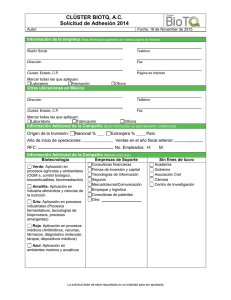

Anuncio