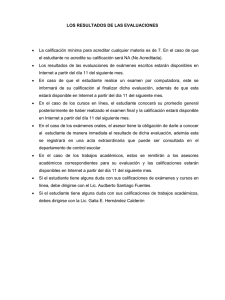

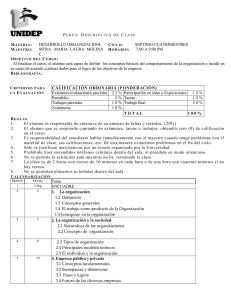

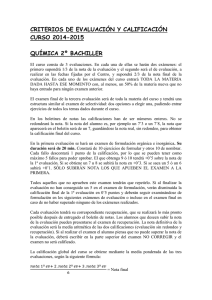

Los exámenes teóricos y los criterios de calificación. Sus

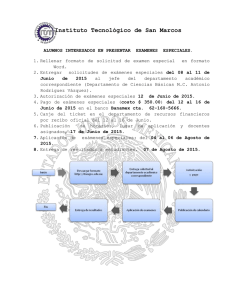

Anuncio