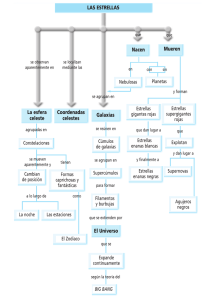

Número completo - Información y Actualidad Astronómica

Anuncio