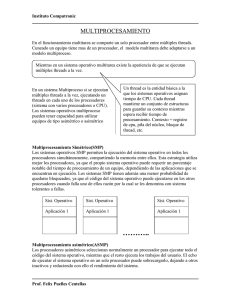

Optimización de Rutinas Multinivel de Álgebra Lineal en Sistemas

Anuncio