LOS FUNDAMENTOS DE LA INTELIGENCIA ARTIFICIAL. La

Anuncio

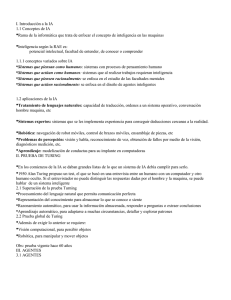

LOS FUNDAMENTOS DE LA INTELIGENCIA ARTIFICIAL. La inteligencia artificial es un campo, es heredera de diversas ideas puntos de vista y técnicas de otras disciplinas. Durante más de 400años de matemáticas, han surgido teorías formales relacionadas con la lógica probabilidad, toma de decisiones y la computación. La sicología ofrece herramientas que permiten la investigación de la mente humana, así como un lenguaje científico para expresar las teorías que se van obteniendo. La lingüística ofrece teorías sobre la estructura y significado del lenguaje, la ciencia y la computación, de la que se toman las herramientas que permiten que la IA sea una realidad. FILOSOFIA (428 A.C AL PRECENTE): Todo empezó con el nacimiento de platón en 428 a.c. la temática de su obra es diversa: política, matemáticas, física, astronomía y diversas ramas de la filosofía. Aristóteles consideraba que no todas las partes de la mente estaban gobernadas por procesos lógicos. Consideraba también la noción de una razón intuitiva. Habría que esperar a rene descartes (1596 a1650), para contar con un estudio claro de la diferencia entre mente y materia los problemas que origina. Descartes propuso la noción del dualismo. Sostenía que existe una parte de la mente que está al margen de la naturaleza, exenta dela influencia de las leyes físicas. Una alternativa al dualismo es el materialismo, que considera que todo el mundo funciona sujeto a leyes físicas. El movimiento empírico, iniciado con el novom organum de Francis Bacon (1561 a 1626), se caracteriza por el aforismo John Locke (1632 a1704):”nada existe en la mente que no haya pasado antes por los sentidos”. David Hume (1711 a 1776) propone lo que actualmente se conoce como principio de la inducción: las reglas generales se obtienen por contacto con repetidas asociaciones entre sus elementos. Bertrand Russell (1872 a1970): indujo el positivismo lógico. Esta doctrina sostiene que todo el conocimiento se puede caracterizar mediante teorías relacionadas, en última instancia, con oraciones de observación, que corresponda en entradas sensoriales. Con la teoría de la confirmación se intenta comprender como se puede obtener conocimientos a partir de la experiencia. MATEMATICAS (aproximado del año 800 al presente). La idea de expresar un cálculo mediante un algoritmo formal se remonta a la época de al-jwarizmi, matemático árabe del siglo ix. La lógica data por lo menos desde Aristóteles, su naturaleza era más filosófica que matemática, hasta que George Boole (1815 a 1864). Introdujo su lenguaje formal para hacer inferencias lógicas en 1847. El método de Boole no estaba completo pero era bastante bueno. En 1879, Gottlob Fregué (1848 a 1825) creo una lógica que, excepto por algunos cambios en la notación, constituye la lógica de primer orden que se utiliza actualmente como sistema básico de representación del conocimiento. Alfred Tarski (1902 a 1983) introdujo una teoría de referencia que enseña como relacionar objetos de una lógica con los objetos del mundo real. En 1930 kurt godel 1906 a 1978) demostró que existen procedimientos eficientes para demostrar cualquier aseveración verdadera en la lógica de primer orden de fregué y Russell. En 1931 demostró que el efecto existen límites reales. Mediante su teorema de incompletos demostró que en cualquier lenguaje que tuviera la capacidad suficiente ´para expresar las propiedades de los números naturales, existen aseveraciones verdaderas indecidibles: no es posible definir su valides mediante ningún algoritmo. Lo anterior motivo a Alan Turíng(1912 a 1954( a tratar de caracterizar las funciones que si eran susceptibles de ser calculadas. La tesis de chur-turing goza de aceptación generalizada en cuanto a definición suficiente. Turing demostró también que existen algunas funciones que no es posible calcular mediante la máquina de turing. La noción de la intratabilidad tuvo repercusiones más importantes en términos generales, se dice que una clase de problema se denomina intratable si el lapso necesario ´para la resolución de casos particulares de dicha clase crese el menos exponencial mente con el tamaño de tales casos. El segundo concepto importante en la teoría de la complejidad es la reducción. Una reducción es la trasformación general de problemas a otra. Además de la lógica y el cálculo una gran contribución de las matemáticas a la IA es la teoría de la probabilidad. Gerolamo cardano (1501 a 1576) quien concibiera primero la noción de la probabilidad y representó como posibles resultados de los juegos de apuesta. Pierre Fermat (1601 a1665), Blas pascal (1623 a 1662), james Bernoulli (1654 a 1705), Pierre Laplace (1749 a 1827) y otros más hicieron avanzar esta teoría e introducir nuevos métodos estadísticos. Thomas valles (1702 a1761) propuso una regla para la actualización de las probabilidades subjetivas a la luz de nuevas evidencias. En la teoría de las decir iones propuesta por John bond Neumann y óscar morgenstern (1944 se combinan las teorías de la probabilidad y de la utilidad permiten discernir entre elecciones buenas y acciones malas. PSICOLOGIA: DE 1879 AL PRESENTE: La psicología científica se inició con los trabajos del método médico alemán Herman Vond Helmholsz (1821 a 1894) y su disípalo willhenm Wundt (18321920). El 1879, el mismo año de que Fregué dio a conocer su lógica de primer orden, Wundt inicio el primer laboratorio de psicología. El movimiento conductista de John Watson (1878 a 1958) y de Edward lee Thorndike (1874 a 1949) fue una respuesta contra el subjetivismo por considerarlos “psicología popular” no científica. La psicología cognoscitiva se remota por lo menos a las obras de William james (1842-1910). En los inicios no existía una distinción entre IA y ciencia cognoscitiva era frecuente ver programas de IA caracterizados como si fueran resultados psicológicos. HISTORIA DE LA IA: Génesis de la IA (1943 a 1956). Reconocido en general como el primer trabajo de la IA fue realizado por Warren McuClloch y Walter Pitts(1943:propucieron un modelo constituido por neuronas artificiales.donall Hebb 1949 demostró una sencilla regla de actualización para modificar las intensidades de las conexiones entre neuronas . Entusiasmo inicial, grandes esperanzas 1952 a 1969 El SGP (solucionador general de problemas) posiblemente fue el primer programa que incorporo el enfoque del pensar como humano. McCarthy definió el lenguaje de alto nivel Lisp, que se convertía en el lenguaje de programación dominante en IA. Lisp, es el segundo lenguaje de programación más antiguo que todavía se utiliza actualmente. Marvin Minsk y supervisaba el trabajo de unos estudiantes, quienes eligieron problemas limitados cuya solución parecía requerir de la inteligencia. Estos dominios limitados vinieron a ser conocidos como micromundos. El más famoso de los micromundos fue el de los bloques, formando por un conjunto de bloques solidos colocados en la cubierta de una mesa. Rosenblat demostró el famoso teorema de convergencia del perceptron, con lo que mostro que su algoritmo de aprendizaje podía ajustar las intensidades de conexión de un perceptron para que correspondiera a cualquier dato de entrada, siempre y cuando tal correspondencia fuese factible. Una dosis de realidad (1966 a 1974): Desde el principio, los investigadores de IA expresaron predicciones sobre el exitoso futuro que les aguardaba. El primer obstáculo se originó en los antiguos programas los cuales contaban con poco o ningún conocimiento de la materia objeto de estudio. El segundo obstáculo fue el de la intratabilidad de muchos de los programas que se estaban intentando resolver mediante IA. Los primeros experimento en el campo de la evolución de maquina o computadora estaban basados en la cintura correcta permiso de que efectuando una adecuada serie de pequeñas mutaciones aun programa de código de maquina se podía general un programa con buen desempeño en la realización de cualquier tarea sencilla. Sistemas basados en el conocimiento. ¿Clave del poder? (1969 a 1979) La resolución de problemas durante la primera década de la investigación en IA recibía en un mecanismo de búsqueda de propósito general, a ese procedimiento se le ha denominado métodos débiles debido a que la información sobre el dominio con que cuentan es débil. El programa dendral constituye uno de los primero ejemplos de este enfoque, la primera versión del programa generaba todas las posibles estructuras que correspondieran ala formula. Feigenbaum y otros, dieron inicio al proyecto de programación heurística, dedicado a determinar el grado con el que la nueva metodología de los sistemas expertos podía aplicarse a otras áreas de la actividad humana. El crecimiento de las aplicaciones para el problema del mundo real provoco el respectivo aumento en la demanda de esquemas y representación de reconocimiento que si funcionara. La IA se convierte en una industria: En 1981 los japoneses anunciaron el proyecto “quinta generación” para construir computadoras inteligentes, el proyecto de la quinta generación suscito el interés de la ia y aprovechando el temor a un posible dominio por parte de los japoneses En la floreciente industria de la IA figuraban también compañías tales como camegie grour inference, intellicop y teknowledge. Más de un centenar de compañías construyeron sistemas de visión robótica para su uso industrial. El regreso de las redes neuronales 1986 al presente: En la ciencia de la computación se ha hecho a un lado el campo de las redes neuronales, se ha continuado trabajando en otros campos especialmente en física. Físicos utilizaron técnicas de la mecánica estadística para analizar las propiedades de almacenamiento y optimización de las redes. Psicólogos continuaron con el estudio de los modelos de la memoria basados en redes neuronales, el impulso más fuerte se produjo a mediados de la década de los 80´s, cunado 4 grupos distintos reinventaron el algoritmo de aprendizaje de retro propagación durante una época redes neuronales he IA tradicional se vieron como rivales entre sí, más que como campos que aportaban enfoques complementarios en la solución de un mismo problema. Acontecimientos recientes 1987 al presente: En años recientes se ha producido un cambio en contenido como en metodología de investigación de IA. Actualmente es más común construir sobre teorías ya existentes que proponer teorías nuevas. La invención del formalismo de red de creencia obedece la necesidad de poder razonar eficientemente ante una combinación de evidencias inciertas. Similares revoluciones se han dado en robótica, visión por computadora, autoaprendizaje de máquinas y representación del conocimiento. Una mejor comprensión de los problemas y de su complejidad, a una mayor capacidad de manejo matemático, han favorecido la factibilidad de investigaciones. El también llamado movimiento situado intenta dilucidar el funcionamiento de agentes inmersos en entornos reales, sujetos a entradas sensoriales continuas.