sobre una forma generalizada de aplicar pruebas sobre

Anuncio

SOBRE UNA FORMA GENERALIZADA DE APLICAR PRUEBAS SOBRE

PROPORCIONES

INTRODUCCIÓN

En múltiples problemas del mundo real es necesario manejar proporciones, porcentajes

o probabilidades. Por ejemplo, los partidos políticos utilizan instrumentos estadísticos

para determinar la proporción de votantes a su favor; los mercadólogos aplican la

estadística para determinar las fracciones de mercado que corresponden a ciertas

marcas de un producto determinado;

en el muestreo de aceptación interesa la

proporción de unidades defectuosas en un lote, y, en base en dicha proporción se toma

una decisión acerca de la calidad del mismo; en las pruebas de vida útil se desea

conocer el porcentaje de tiempo durante el cual ciertos componentes tendrán un

rendimiento satisfactorio o la probabilidad de que un componente dado dure al menos

un número previamente establecido de horas; en fin, podemos encontrar que el uso de

proporciones se encuentra lo mismo en la Mercadotecnia que en la Ingeniería, en la

Biología que en las Ciencias Sociales, en la Química que en la Medicina, etc., y que,

por lo mismo, la importancia de su estudio y análisis es vital para optimizar la toma de

decisiones.

Al mismo tiempo, con estos ejemplos es claro que los problemas relativos a

proporciones, porcentajes o probabilidades son en realidad equivalentes; un porcentaje

es simplemente una proporción multiplicada por 100 y una probabilidad puede

interpretarse como una proporción a largo plazo.

1

En todas las aplicaciones, por lo general se utilizan modelos estadísticos univariados, o

en el mejor de los casos sus extensiones directas cuando se trata de más de dos

proporciones. No existen trabajos reportados en donde se hayan hecho aplicaciones de

modelos multivariados para este caso, a no ser por aquellos en donde se utiliza la

distribución multinomial. En este artículo se presenta una forma generalizada para

verificar hipótesis sobre vectores de proporciones. En dicha forma generalizada,

quedan incluidas automáticamente las pruebas clásicas (normal, t de Student y Chicuadrada), con lo que su uso, permite abordar cualquier caso de pruebas de hipótesis

sobre proporciones con un solo procedimiento, en lugar de tener que buscar el

adecuado para cada situación. La prueba sugerida es más potente que las clásicas,

debido fundamentalmente al mejor uso que se hace de la información presente en la

muestra. Se recurre a la prueba T cuadrada de Hotelling contrastándose los resultados,

mediante simulación, con las pruebas clásicas correspondientes.

A continuación se describe el estadístico Chi Cuadrada y la técnica de pruebas de

hipótesis correspondiente. Se describe primero la distribución exacta para verificar

estas hipótesis, y se enuncian los teoremas que encuentran al estadístico Chi Cuadrada

cuando, por los tamaños de muestra involucrados, se hace impráctico utilizar las

distribuciones exactas.

La distribución Binomial es una de las distribuciones exactas a que se hace

referencia en el párrafo anterior. Hemos dedicado una sección para demostrar que la

aproximación Normal, derivada como una aproximación de la distribución Binomial,

puede aplicarse para probar hipótesis cuando para un ítem determinado sólo hay dos

2

opciones de respuesta. También se muestra en dicha sección cómo se llega a la

distribución Chi Cuadrada a partir de las variables Binomiales para verificar las hipótesis

que nos ocupan.

La distribución multinomial es otra de las distribuciones exactas que mencionamos

líneas arriba. Puede aplicarse para probar hipótesis cuando para un ítem determinado

hay dos o más opciones de respuesta. Se le dedicó una sección especial para mostrar

su distribución asintótica (distribución normal multivariada) ya que esta es necesaria en

la justificación de la utilización de la prueba T Cuadrada de Hotelling, la cual es tratada

en la sección que sigue.

Posteriormente, se muestran algunos de los resultados del estudio comparativo de las

pruebas usando simulación en Excel. Los resultados obtenidos justifican totalmente el

uso de la prueba generalizada propuesta.

PRUEBA CHI CUADRADA

La prueba Chi Cuadrada es una prueba sumamente versátil y universalmente utilizada

en prácticamente todas las disciplinas científicas. Es una prueba muy antigua (Karl

Pearson, 1900). Su amplia popularidad se debe a su simplicidad de uso y a su validez

para una amplia variedad de situaciones. Para explicar su naturaleza y forma de

aplicación supondremos el siguiente contexto: dos grupos son investigados para

conocer su respuesta X ante los estímulos, categorías u opciones 1, 2 y 3. Los grupos

pueden ser de personas, animales, plantas, o cualquier otro ente que pueda responder

ante un estímulo determinado. Asumiremos, para contextualizar aún más la situación,

3

que se trata de personas que a una determinada pregunta (ítem) de una encuesta

deben seleccionar entre las tres opciones antes mencionadas.

Ho: La variable X no es una variable que separe a los dos grupos

H1: Los grupos se comportan de manera distinta respecto a la variable X

Con base en las observaciones se forma la siguiente tabla de contingencia:

Opción 1

Opción 2

Opción 3

Total

Grupo 1

n11

n12

n13

n1.

Grupo 2

n21

n22

n23

n2.

Total

n.1

n.2

n.3

n..

La cantidad ni. representa el total de personas del grupo i; de éstos, ni1 seleccionaron la

opción 1, ni2 la opción 2 y ni3 la opción 3. Resulta así que la opción 1 fue seleccionada

por n.1 = n11 + n21 encuestados; la opción 2 fue seleccionada por n.2 = n12 + n22

encuestados; y la opción 3 fue seleccionada por n.3 = n13 + n23 encuestados. En total n..

personas contestaron a este ítem de la encuesta.

La idea tras esta prueba es la siguiente: Si la respuestas al ítem no dependen del grupo

que las selecciona, entonces el total de respuestas a cada opción debe repartirse

proporcionalmente entre los dos grupos. El primer grupo está representado en una

proporción n1./n..; la proporción del segundo grupo es n2./n... Luego, si las respuestas a

la opción j no dependen de si quien las contestó es del primero o del segundo grupo,

4

esperaríamos que la cantidad n.j de respuestas que obtuvo el la opción j se repartieran

de tal forma que n.j*n1./n.. correspondieran al primer grupo y n.j*n2./n.. correspondieran al

segundo. Dicho de una manera más general: si las respuestas a la opción j no

dependen del grupo al que pertenece quien las contestó, esperaríamos que la cantidad

n.j de respuestas que obtuvo

la opción j se repartieran de tal forma que n.j*ni./n..

correspondieran al grupo i. Estas cantidades esperadas se concentran en la siguiente

tabla:

Opción 1

Opción 2

Opción 3

Grupo 1

e11

e12

e13

Grupo 2

e21

e22

e23

En donde

eij =

(ni. )(n. j )

n..

i = 1,2; j = 1, 2,3

(1)

El estadístico de prueba (Stevenson, W illiam j., pág. 343) a utilizar es el siguiente

2

3

χ = ∑∑

2

i =1 j =1

(nij − eij ) 2

eij

(2)

Si las respuestas a cada una de las tres opciones consideradas no dependen del grupo

al que pertenece quien las contestó, las cantidades observadas (nij) serían cercanas a

las esperadas (n.jni./n..). En este caso el estadístico χ2 tendería a cero. Por otra parte, si

5

los miembros del grupo 1 tienden a concentrar sus respuestas en opciones distintas a

las elegidas por los del grupo 2, las cantidades observadas tenderían a separarse de

las esperadas, dando lugar a que el estadístico χ2 calculado con la expresión (2), tome

valores grandes. Pareciera por tanto, que existe un valor crítico del estadístico de

prueba ( χ c2 ) a partir del cual se podría considerar que en realidad las proporciones no

son iguales. Pearson demostró que, bajo ciertas condiciones, el valor crítico χ c2 podía

calcularse con el apoyo de una distribución matemática conocida actualmente como Chi

Cuadrada. De ahí el nombre de la prueba. Esta distribución aparece tabulada en

prácticamente todos los libros de estadística, y el algoritmo para su cálculo está incluido

en todos los paquetes estadísticos. Así, la hipótesis nula se rechaza a un nivel de

significancia α, si χ 2 > χ c2 , en donde χ c2 = χ α2 ,( 2−1)(3−1) ,.

Las condiciones que se deben cumplir para una exitosa aplicación de la prueba Chi

Cuadrada de Pearson son: que un quinto o más de las frecuencias esperadas sea

mayor o igual a 5, y que en ningún caso una frecuencia esperada sea menor a uno. La

recomendación que se hace, cuando no se cumple alguno de estos requisitos, es

combinar opciones adyacentes hasta el tanto ambos requisitos se cumplan( Cramér, H.

pág. 450).

Es necesario destacar que la distribución encontrada por Pearson no es una

distribución exacta sino asintótica, queriendo decir con esto que ella es válida sólo para

valores grandes del tamaño de la muestra. En realidad las distribuciones exactas (para

observaciones independientes) que sustituirían con éxito total a la prueba Chi Cuadrada

son derivadas de la distribución Multinomial.

6

El concepto de “grande” requerido para la aplicación de la prueba Chi Cuadrada de

Pearson no es, en la práctica, tan grande como pudiéramos suponer. Se encuentran

reportadas aplicaciones en centros de investigación, empresas, universidades y textos

de estadística no-paramétrica, con tamaños de muestra tan pequeños como 30,

cumpliendo, eso sí, con las condiciones antes señaladas.

DISTRIBUCIÓN BINOMIAL Y SU APROXIMACIÓN NORMAL

Iniciaremos esta sección con una situación aplicable al siguiente contexto: Se realiza un

experimento como resultado del cual se observa una variable U que sólo puede tomar

dos valores. Asumiremos que éstos son: “1” o éxito, con probabilidad p, y “0” o fracaso,

con probabilidad 1 – p, es decir:

p = P(U = 1)

(3)

Una variable aleatoria con estas características es llamada Variable Bernoulli.

Supongamos que el experimento a que hicimos referencia se repite n veces y que la

probabilidad de éxito se mantiene de un experimento a otro. Sea X la variable aleatoria

que representa el número de éxitos. Es claro que X es una suma de variables Bernoulli.

Se puede demostrar que X se distribuye Binomial de parámetros n y p, es decir, la

probabilidad de que la variable X tome el valor k está dada por:

n

P( X = k ) = p k (1 − p) n− k ; k = 1,

k

, n

(4)

La prueba exacta para verificar la hipótesis:

H 0 : p = p 0 v.s. H 1 : p ≠ p 0 ,

(5)

7

hace uso de la distribución binomial, sin embargo, la dificultad para el cálculo de los

factoriales aunado a la cantidad de términos de las sumas involucradas, cuando n es

grande, dio lugar, desde hace muchos años, a la búsqueda de alternativas más

prácticas. Todas ellas consistieron en buscar aproximaciones satisfactorias al cálculo

de la expresión correspondiente. La aproximación más utilizada, es la que se logra

mediante el uso de la distribución normal. En estas condiciones el estadístico de prueba

utilizado es

Z=

( pˆ − p 0 ) n

p 0 (1 − p 0 )

(6)

En donde Z es una variable aleatoria con distribución normal con media cero y

desviación estándar 1.

La hipótesis nula se rechaza, entonces, si Z > zα / 2 para un nivel de significancia α.

De la teoría de la Estadística sabemos que si una variable se distribuye Normal de

media cero y varianza uno, entonces su cuadrado se distribuye Chi Cuadrada con 1

grado de libertad. De aquí resulta que la prueba estadística asintótica normal coincide

con la aplicación de una prueba Chi Cuadrada con un grado de libertad.

Ahora, consideremos el caso en que dos grupos son investigados para conocer su

respuesta X ante los estímulos, categorías u opciones 1 y 2. AL igual que antes, los

grupos pueden ser de personas, animales, plantas, o cualquier otro ente que pueda

responder ante un estímulo determinado. Siguiendo el proceso que efectuamos al

introducir la prueba χ2, asumiremos, para contextualizar aún más la situación, que se

trata de personas que a una determinada pregunta (ítem) de una encuesta deben

8

responder afirmativa o negativamente. Nos ponemos el problema de verificar la

hipótesis:

Ho: La variable X no es una variable que separe a los dos grupos

H1: Los grupos se comportan de manera distinta respecto a la variable X

Sean p1 y p2 las proporciones de personas del primero y segundo grupo,

respectivamente, que responden de manera afirmativa. En términos estadísticos las

hipótesis H0 y H1 pueden expresarse como:

H 0 : p1 = p 2 vs H 1 : p1 ≠ p 2

(7)

El estadístico de uso generalizado para esta prueba es (Stevenson, William J. pág.

339):

Z=

pˆ 1 − pˆ 2

1

1

pˆ (1 − pˆ ) +

n1 n2

donde pˆ =

x1 + x 2

n1 + n2

(8)

siendo xi (i=1,2) la cantidad de personas del grupo i que respondieron afirmativamente

∧

al item, ni el tamaño del grupo i, y p i la correspondiente proporción (es decir, xi/ni).

Este estadístico actúa bien para tamaños grandes de muestra rechazando Ho

aproximadamente el α% de las veces cuando Ho es cierta y p no es lejana de 0.5. Su

distribución, cuando n→∝, es la Normal estandarizada.

Un estadístico alternativo que cumple con la misma función, es el dado por la expresión

t=

pˆ 1 − pˆ 2

1

1

S +

n1 n 2

donde S =

n1 p1 (1 − p1 ) + n 2 pˆ 2 (1 − pˆ 2 )

n1 + n2 − 2

(9)

9

Este estadístico tiende a distribuirse t de student con n1+n2-2 grados de libertad y es un

caso particular del estadístico T2 de Hotelling que abordaremos más adelante, cuya

utilización la hemos destacado como la contribución principal del presente trabajo.

DISTRIBUCIÓN MULTINOMIAL Y SU APROXIMACIÓN NORMAL MULTIVARIADA

Supongamos que deseamos probar las hipótesis

H 0 : p 1 = p 2 vs H 1 : p 1 ≠ p 2

(10)

en donde las p1 = (p11, p12, ..., p1k)’ y p2 = (p21, p22, ..., p2k)’ representan vectores de k

proporciones cada uno.

Si Xi = (Xi1, Xi2, ..., Xik)’, i=1,2, representa al vector aleatorio cuyas componentes son la

suma de observaciones de la clase “i”, i= 1, 2, ..., k, respectivamente. Es claro que Xi es

la suma de vectores MultiBernoulli. Se puede demostrar que X1 y X2 se distribuyen

Multinomiales de parámetros n1 y p1, y n2 y p2, respectivamente, es decir, la

probabilidad de que el vector Xi tome el valor (xi1, xi2, ..., xik) está dada por:

P{ X i = ( xi1 , xi 2 ,

, x

ik )} =

ni !

pix11 p ix22

x i1! x i 2 ! x ik !

p

k

xk

ik

,

∑ xij = ni ,

j =1

k

∑p

j =1

ij

= 1, i = 1, 2 (11)

Se puede probar la siguiente relación (Pérez, L. A., 1981):

lim P{ X i = ( x i1 , x i 2 ,

n1 →∞

donde xi = ( xi1 ,

, x

ik −1

)′; µ i = (ni pi1 ,

, x

, n p

i

1

ik −1 )} =

ik −1

(2π )

k −1

2

| Σi |

1

2

e

−

[

1

( xi − µ i )′ Σi−1 ( xi − µ i )

2

]

(12)

)′ ;

10

i

− ni pi1 pi 2

ni p i1 (1 − pi1 )

−n p p

ni pi 2 (1 − pi 2 )

i i 2 i1

=

− ni pik −1 p i 2

− ni pik −1 p i1

− ni pi1 pik −1

− ni p i 2 pik −1

ni pik −1 (1 − pik −1 )

(13)

La expresión (12) se puede leer diciendo que, cuando n es grande la distribución del

vector Multinomial es Normal Multivariada de vector de medias y matriz de varianzacovarianza dadas por la expresión (13). Es estas expresiones se ha eliminado el késimo término; sin embargo, el resultado será el mismo si se elimina cualquier otro

término i (i=1, . . . k-1) del vector. Si en dichas ecuaciones se incluyeran los k términos,

entonces la inversa

-1

a utilizar sería la inversa generalizada. Esta aproximación a la

Distribución Normal Multivariada es el argumento base de la distribución que se aborda

en la siguiente sección.

ESTADÍSTICO T2 DE HOTELLING

Como se mencionó anteriormente la distribución Multinomial es la distribución base

exacta para verificar hipótesis sobre los vectores de proporciones(Bernoulli). Sin

embargo, su utilización requiere de cálculos engorrosos de factoriales, además de

ciertas sumas, tanto para valores pequeños, como para valores grandes de n, lo cual

hace necesaria la búsqueda de alternativas más prácticas. La solución que más se

utiliza es la que recurre al uso del estadístico Chi Cuadrada que explicamos líneas

arriba. Desafortunadamente, aún cuando es ampliamente aplicado para muestras

relativamente pequeñas, no es muy bueno rechazando la hipótesis Ho cuando debe ser

rechazada.

11

Aún recurriendo a algoritmos computacionales existen demasiadas condiciones que se

deben programar para buscar una adecuada adaptación de la prueba. Por fortuna

existe una prueba menos popular que la Chi Cuadrada, conocida como T Cuadrada de

Hotelling. La razón de su escasa popularidad es que hace necesario el cálculo matricial

(productos de matrices, inversas, transpuestas) y operaciones matemáticas más

complejas, además de que fundamenta su filosofía en la teoría estadística multivariada,

la que a su vez hace uso de conceptos estadísticos que no se enseñan en los cursos

tradicionales de estadística. En lo que sigue se dará la definición del estadístico T2 de

Hotelling, la que después se utiliza para determinar los estadísticos de prueba para

proporciones.

Definición 1. Si X es un vector aleatorio con distribución Np(0, I) y M es una matriz

independiente de X con distribución W(I, n), entonces Y = nX´M-1X sigue una

distribución T2 de Hotelling con parámetros p y n; lo cual se escribe como Y∼T2(p, n)

(Mardia, 1979, pág. 74).

En el caso particular cuando p = 1, T2 se reduce a la t de Student con n grados de

libertad. La T2 de Hotelling es así, la generalización multivariada de la t de Student. Esto

también se extiende a sus aplicaciones, las cuales son las análogas multivariadas de

las correspondientes aplicaciones univariadas de la t de Student.

Tomando como base la definición dada anteriormente, se puede demostrar [Mardia,

1979, pág. 74; Anderson, 1971,pág. 163] que

np

T 2 ( p, n) =

F p, n− p+1

(n − p + 1)

(14)

12

Si X1, . . ., Xn es una muestra aleatoria de X∼Np(µ,

),

entonces de la definición se

desprende que

n( X − )′S −1 ( X − ) ∼ T 2 ( p, n − 1)

(15)

en donde

n

n

X = ∑ Xi y S =

∑ (X

i =1

i

− X )(X i − X )′

(16)

n −1

i =1

Por tal motivo se tendrá

(n − 1) p

n( X − )′S −1 ( X − ) =

F p ,n − p

n− p

(17)

Así para probar la hipótesis H0: µ = µ0, utilizando el ensayo de la razón de verosimilitud,

la región crítica será (Anderson, 1971, págs. 157-159)

n( n − p )

( X − )′S −1 ( X − ) > Fα , p , n − p

(n − 1) p

(18)

para un nivel de significancia α dado.

Otra situación en la cual se usa el estadístico T2 es aquella en la cual la hipótesis es H0:

µ(1) = µ(2), es decir, la hipótesis indica que las medias de dos poblaciones normales

multivariadas son iguales. En esta aplicación se supone que las matrices de covarianza

de ambas poblaciones son iguales, pero desconocidas. Específicamente si X1(1) ,

es una muestra de N(µ(1), \ X1(2) ,

, X

(2)

n

, X

(1)

n1

es una muestra de N(µ(2), HQWRQFHV

n1 n2

( X (1) − X ( 2) )′S −1 ( X (1) − X ( 2) ) = T p2, n1 + n2 −2

n1 + n2

(19)

13

en donde X (1) y X ( 2) son las medias de las muestras correspondientes y

S=

n1

n2

i =1

i =1

∑ (X i(1) − X (1) )(X (i1) − X (1) )′ + ∑ (X (i 2) − X ( 2) )(X (i 2) − X ( 2 ) )′

n1 + n2 − 2

(20)

La región crítica para la prueba es:

T2 >

(n1 + n2 − 2)

Fα , p, n1 + n2 − p −1

n1 + n2 − p − 1

(21)

La teoría expuesta anteriormente se puede aplicar del mismo modo a aquellos casos

en donde las hipótesis involucran proporciones. Así, cuando la hipótesis nula es H 0:

p=p0 en donde

p1

p10

p

p

p = 2 y p 0 = 20 ,

pk

pk 0

(22)

entonces, una muestra aleatoria X 1, X2, . . ., Xn de un vector Bernoulli k-dimensional,

tendrá como estimados de la media y de la matriz de varianza-covarianza a (Pérez, L.

A., 1981):

n

pˆ =

∑ Xi

i =1

pˆ 1 (1 − pˆ 1 )

− pˆ pˆ

2 1

ˆ = S = n

n −1

− pˆ k pˆ 1

n

pˆ 1

p

ˆ

= 2,

pˆ k

− pˆ 1 pˆ 2

pˆ 2 (1 − pˆ 2 )

− pˆ k pˆ 2

(23)

− pˆ 1 pˆ k

− pˆ 2 pˆ k

,

pˆ k (1 − pˆ k )

(24)

14

y como estadístico de prueba a T2 de Hotelling con p = k-1,

n(n − k + 1)

(p̂ − p 0 )′S −1 (p̂ − p 0 ) .

(k − 1)(n − 1)

(25)

Con lo cual H0 será rechazada si

n(n − k + 1)

(p̂ − p 0 )′S −1 (p̂ − p 0 ) > Fα ,k −1, n− k +1

(k − 1)(n − 1)

(26)

para un nivel de significancia α.

Si consideramos ahora, que la hipótesis es H 0: p1 =p2, con

p11

p

p1 = 12 ,

p1k

p 21

p

p 2 = 22 ,

p 2k

(27)

y que además se toma una muestra aleatoria de tamaño n1 de la población 1, y una

muestra de tamaño n2 de la población 2, cuyos estimados de los vectores media y de

las matrices de varianza-covarianza son pˆ 1 , pˆ 2 , S1 , S 2 respectivamente, calculados

mediante la aplicación de (23) y (24) a las muestras correspondientes, entonces el

estadístico de prueba a aplicar será

n1 n 2 (n1 + n2 − k )

(p̂1 − p̂ 2 )′S −1 (p̂1 − p̂ 2 )

(n1 + n 2 )(n1 + n 2 − 2)(k − 1)

(28)

H0 será rechazada si

n1n 2 (n1 + n2 − k )

(p̂1 − p̂ 2 )′S −1 (p̂1 − p̂ 2 ) > Fα , k −1, n1 + n2 −k

(n1 + n 2 )(n1 + n 2 − 2)(k − 1)

(29)

para un nivel de significancia α.

15

Si en (29) hacemos k=2, tenemos:

(p̂1 − p̂ 2 ) 2

n1 n2

(p̂1 − p̂ 2 )′S′ −1 (p̂1 − p̂ 2 ) =

> Fα ,1, n1 + n2 − 2

(n1 + n 2 )

1

1

S ′ +

n1 n2

= t > tα , n1 + n2 −2

(30)

en donde S´ es igual a S2 calculada de acuerdo a (9). Queda así demostrado que el

estadístico t es un caso particular del estadístico T2 de Hotelling.

ESTUDIO COMPARATIVO UTILIZANDO SIMULACIÓN

Se llevaron a cabo estudios de simulación en la hoja de cálculo Excel para determinar

el comportamiento de las diferentes pruebas. Se determinó el porcentaje de rechazos

para cada prueba para diferentes valores de n1, n2, p1 y p2, el valor del nivel de

significancia fue 5%. A continuación se dan algunos resultados.

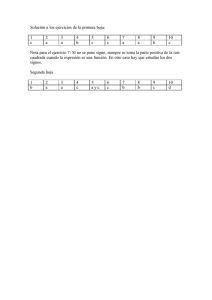

Parámetros

% de rechazos

n1

n2

p1

p2

α

Prueba

Normal

Prueba t

(1)

5

6

0.1

0.1

0.05

0.65625

0.65625

0.1

0.3

5.0625

5.0625

0.1

0.5

23.9375

23.9375

0.1

0.7

58.9375

58.9375

0.1

0.9

89.9687

89.9687

0.2

0.2

2.5312

2.5312

0.2

0.4

8.7187

8.7187

0.2

0.6

29.0312

29.0312

16

Parámetros

% de rechazos

n1

n2

p1

p2

α

Prueba

Normal

Prueba t

(1)

10

35

0.1

0.1

0.05

3.5935

3.5935

0.1

0.3

19.0526

19.0625

0.1

0.5

69.5312

69.5312

0.1

0.7

96.7500

96.7500

0.1

0.9

10.0000

100.0000

0.2

0.2

3.5937

3.5937

0.2

0.4

18.7500

18.7500

0.2

0.6

64.6562

64.6562

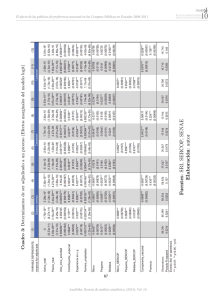

Parámetros

% de rechazos

n1

n2

p1

p2

α

Prueba

Normal

Prueba t

(1)

60

60

0.1

0.1

0.05

11.5312

11.5312

0.1

0.3

38.2187

38.2187

0.1

0.5

99.5937

99.5937

0.2

0.6

99.125

99.125

Parámetros

n1

10

40

n2

35

40

% de rechazos

Vector Vector

p1

p2

0.25

0.4

0.25

0.25

0.25

0.25

0.25

0.1

0.1

0.3

0.2

0.2

0.2

0.1

0.5

0.4

α

0.05

Chi cuadrada

Prueba T2

de

Hotelling

21.0454

21.6590

52.0681

52.5454

Prueba

17

Los resultados obtenidos muestran que:

1. la prueba normal y la prueba t de Student se comportan de manera idéntica para

todos los tamaños de muestra y diferencias p1-p2 utilizadas en la simulación.

2. El estadístico T2 de Hotelling resultó ser una prueba más potente que el

estadístico Chi-cuadrada para todas las combinaciones de n1, n2, p1 y p2

simuladas.

CONCLUSIONES

Los procedimientos Z y t conducen a resultados idénticos, lo cual indica que puede

usarse

t en lugar del Z para probar H0:p1=p2. Chi-cuadrada es la extensión de la

prueba normal cuando se prueban hipótesis que involucran dos vectores de

proporciones. Si tratamos con vectores aleatorios de proporciones, necesariamente

debemos utilizar

modelos estadísticos multivariados apropiados para el caso bajo

estudio. Esto nos conduce al estadístico T2 de Hotelling

como el más adecuado

cuando las hipótesis se relacionan con dos vectores aleatorios de proporciones. Por

tanto, este estadístico puede utilizarse de manera generalizada para resolver toda esa

gama de posibilidades, pues t es un caso particular de T2 según (30), a su vez T2 de

Hotelling desplaza a la prueba Chi-cuadrada debido a su mayor potencia. Por lo que se

deduce que el estadístico T2 de Hotelling puede sustituir perfectamente a los

estadísticos Z, t y Chi-cuadrada. Esto es particularmente útil cuando se diseña software,

pues al disponer de un solo procedimiento se facilita y simplifica considerablemente el

diseño de los algoritmos correspondientes.

18

REFERENCIAS

1. Anderson, T. W., An Introduction to Multivariate Statistical Analysis, John Wiley

and Sons, 1971.

2. Bilodeau M. and Brenner D., Theory of Multivariate Statistics, Springer, 1999.

3. Cramér, H., Mathematical Methods of Statistics, Princeton University Press,

1991.

4. Kshirsagar, Anant M., Multivariate Analysis, Marcel Dekker, Inc., 1972.

5. Mardia, K. V., Kent, J. T. And Bibby J. M., Multivariate Analysis, Academic Press,

1979.

6. Pérez, L. A., Estadística matemática, 2° Coloquio del Departamento de

Matemáticas, Centro de Investigación y de Estudios Avanzados del IPN, 1981.

7. Scheffé, Henry, The Analysis of Varianza,John Wiley and Sons, Inc., 1959.

8. Srivastava, M. S., An Introduction to Multivariate Statistics, North Holland. New

York, 1979.

9. Stevenson, William J., Estadística para administración y economía, Harla, 1981.

19