Cadenas de Markov desde un punto de vista de Aplicaciones.

Anuncio

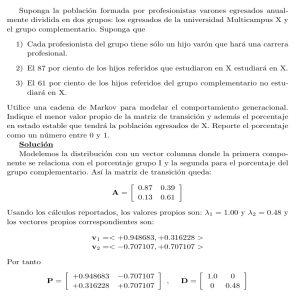

UNIVERSIDAD VERACRUZANA

FACULTAD DE MATEMÁTICAS

Cadenas de Markov

desde un punto de vista

de Aplicaciones.

TESIS

Que para aprobar la Experiencia Educativa

Experiencia Recepcional

Correspondiente al Plan de Estudios de la

Licenciatura en Matemáticas

P R E S E N T A:

José Salas Martı́nez.

DIRECTORES DE TESIS:

Dr. Raquiel Rufino López Martı́nez.

Dr. Francisco Sergio Salem Silva.

Diciembre 2013

Xalapa-Enrı́quez, Ver. México

Índice general

Introducción.

1. Conceptos Básicos.

1.1. Probabilidad . . . . . . .

1.2. Probabilidad condicional.

1.3. Fórmula de Bayes. . . .

1.4. Procesos Estocásticos. .

V

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

1

1

3

5

9

2. Cadenas de Markov.

2.1. Definición y Propiedad de Markov. . . . . . . . . . . . .

2.2. Matriz de Transición. . . . . . . . . . . . . . . . . . . . .

2.3. Transición de m pasos. . . . . . . . . . . . . . . . . . . .

2.4. Distribución Inicial. . . . . . . . . . . . . . . . . . . . . .

2.5. Distribución Estacionaria. . . . . . . . . . . . . . . . . .

2.6. Distribución Lı́mite. . . . . . . . . . . . . . . . . . . . .

2.7. Periodicidad. . . . . . . . . . . . . . . . . . . . . . . . .

2.8. Teorema de la Convergencia. . . . . . . . . . . . . . . . .

2.9. Cadenas doblemente estocásticas. . . . . . . . . . . . . .

2.10. Cadenas de Tiempo Continuo. . . . . . . . . . . . . . . .

2.10.1. Proceso de Poisson. . . . . . . . . . . . . . . . . .

2.10.2. Una Cadena de Markov Continua de dos Estados.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

11

11

14

18

22

23

27

30

34

37

38

38

42

.

.

.

.

.

.

.

.

45

45

46

48

49

49

50

50

51

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

3. Aplicaciones.

3.1. Cadena del Monopoly. . . . . . . . . .

3.1.1. Matriz de Transición. . . . . . .

3.1.2. Distribución Estacionaria. . . .

3.1.3. Distribución Lı́mite. . . . . . .

3.2. Cadena de Tiempo (Clima). . . . . . .

3.2.1. Función de Transición para Xn .

3.2.2. Distribución de Xn . . . . . . . .

3.2.3. Simulación en EXCEL. . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

Conclusiones.

57

Bibliografı́a

58

iii

Introducción.

Los conceptos básicos de las cadenas de Markov fueron introducidos por Andrew A. Markov

durante 1907, a partir del trabajo de Markov es cuando se inicia formalmente el desarrollo de los

procesos estocásticos. Weiner durante 1923 fue el primero en tratar rigurosamente el caso continuo de la cadena de Markov y fue Kolmogorov durante los años 30’s quien desarrolló la teorı́a

general de los procesos estocásicos. A partir de este momento un gran número de matemáticos

se involucran dándole un gran auge. La importancia de estudiar las cadenas como un estudio de

variables aleatorias es que una gran cantidad de aplicaciones tienen la propiedad de Markov, esto

dio lugar a una gran cantidad de investigaciones en la teorı́a de los procesos estocásticos [1, 9].

Las cadenas de Markov son útiles en ciertas ramas de la Fı́sica como lo son la Termodinámica,

en Meteorologı́a ayuda a tener predicciones más acertadas en el cambio del tiempo de un dı́a a

otro, en Ciencias Biológicas se explican modelos Epidemiológicos, en Teorı́a de juegos, Finanzas,

Ciencias Sociales, Estadı́stica y Matemáticas [7, 8]. El concepto de Cadena de Markov fue sin duda

una de las contribuciones más grandes de Andrew, y ha sido reconocida durante el paso del tiempo.

Este trabajo tiene tres propósitos importantes: primero es el estudio de las Cadenas de Markov

mediante el estudio de la teorı́a y de ejemplos bastante claros, el segundo es mostrar que las cadenas de Markov tienen diferentes aplicaciones y por último es modelar de una manera muy sencilla

cómo se comporta un proceso de este tipo sin que una persona sea experta en la materia. A lo

largo de este trabajo describiremos qué es una cadena de Markov, para qué sirven estos procesos

y cómo se clasifican dichas cadenas. Veremos además cómo se conforman estos procesos. Es decir,

analizar cuáles son los elementos primordiales que conforman una cadena de Markov, entre otras.

Esta tesis será estructurada de la siguiente manera:

- En el capı́tulo 1 damos un breve repaso de la Teorı́a de la Probabilidad, pasando por la

Probabilidad Condicional y usando la Fórmula de Bayes, resolviendo problemas que resultan

interesantes. También daremos la definición y algún ejemplo de Proceso Estacástico [2, 3, 4,

6, 5].

- A lo largo del capı́tulo 2 definiremos lo que es una Cadena de Markov, los estados, su clasificación y veremos qué sucede con estos procesos a largo plazo. Para esto se demostrará un

resultado importante conocido como Teorema de la Convergencia y aplicaremos éste resultado en varias aplicaciones. Cabe mencionar que analizaremos una manera sencilla de ver una

cadena mediante el uso de matrices (Matriz de Transición), además analizaremos los ejemplos

clásicos como lo son la cadena de Ehrenfest, la cadena de la Ruina del Jugador y el Modelo

de Wright-Fisher. En estos modelos podremos apreciar lo que ocurre cuando llegamos a un

v

determinado estado y éste no permite abandonarlo (Estado Absorbente), además estudiaremos ejemplos donde los periodos de tiempo no son fijos (el Proceso de Poisson). Como las

cadenas de Markov son sucesiones de variables aleatorias con cierta estructura, éstas pueden

ser continuas o discretas, para nuestros fines sólo analizaremos variables aleatorias discretas

(espacios de estados a lo más numerables) [1, 2, 4, 5, 8, 9].

- Finalmente en el capı́tulo 3 analizaremos dos interesantes aplicaciones; primero el conocido juego de mesa Monopoly. Este puede modelarse mediante una cadena de Markov y

estudiaremos el comportamiento a largo plazo con la Matriz de transición. Investigaremos

analı́ticamente si existe la distribución estacionaria y simularemos la cadena para estimar

su distribución lı́mite usando Phyton. En la segunda aplicación usamos Excel para resolver

el problema de como cambia el tiempo (clima) de un dı́a a otro. En particular usaremos

condiciones lógicas y generamos números aleatorios que serán la distribución de la variable

aleatoria (el tiempo) y compararemos estos valores con las probabilidades de transición de

los diferentes estados [7, 9, 5].

Capı́tulo 1

Conceptos Básicos.

1.1.

Probabilidad

La teorı́a de la probabilidad es bastante amplia y rica en ejemplos. Dentro de las matemáticas

podemos encontrar los Procesos Estocásticos, en los cuales basaremos este trabajo recepcional,

para ello comenzaremos analizando los conceptos básicos de la teorı́a de probabilidad. Existen

diferentes fenómenos que observamos a lo largo de nuestras vidas, cuando no podemos determinar

a ciencia cierta el resultado de dicho fenómeno, decimos que es un fenómeno aleatorio [6].

Ejemplos bastante claros de fenomenos aleatorios son: lanzar una moneda, el lanzamiento de un

dado, jugar ruleta, entre otros [6]. Es por ello que la probabilidad se encarga de modelar este tipo

de fenómenos, lo que nos lleva a definir todos los elementos que estos implican.

Definición 1.1.1 El espacio constituido por los posibles resultados de un fenómeno aleatorio se

le llama espacio muestral y se denota normalmente por Ω.

El espacio muestral (Ω) en otras palabras es el conjunto de todos los posibles resultados que nuestro

fenómeno aleatorio puede experimentar. Para fines prácticos nos enfocaremos al estudio de espacios

muestrales finitos o numerables, de la definición 1.1.1 obtenemos la siguiente definición:

Definición 1.1.2 Un subconjunto A del espacio muestral, es decir, A ⊂ Ω diremos que es un

evento o suceso del fenómeno aleatorio.

Para tener una idea más clara de estas dos definiciones analizaremos el siguiente ejemplo [4].

Ejemplo 1.1.1 Consideremos que una persona lanza un dado.

Es fácil ver que Ω = {1, 2, 3, 4, 5, 6} y un evento A lo definiremos como la posibilidad de que se

obtenga un número par, esto es A = {2, 4, 6}, además de que A ⊂ Ω.

Una vez que ya hemos comprendido estas dos definiciones bastante básicas para la teorı́a de la

probabilidad con base en la Definición 1.1.2, definiremos de manera matemática lo que es un suceso

o evento.

Definición 1.1.3 Sea ℑ la colección de todos los subconjuntos posibles de un espacio muestral Ω,

denotamos a ℑ como la σ−álgebra de Ω si ℑ cumple con las siguientes condiciones:

1

CAPÍTULO 1

2

(i) Ω ∈ ℑ

(ii) A ∈ ℑ =⇒ Ac ∈ ℑ.

(iii) A1 , A2 , . . . ∈ ℑ =⇒

∞

S

Ak ∈ ℑ

k=1

y diremos que A es un evento si A ⊂ Ω.

Ya que hemos definido de manera formal un suceso, definiremos una función que nos lleva de la

σ− álgebra al intervalo [0, 1] que será llamada función de probabilidad.

Definición 1.1.4 Sean Ω un espacio muestral, ℑ la σ−álgebra generada por Ω, y A ∈ ℑ definimos

una función de probabilidad como una función que asigna a cada evento A el número real P(A),

donde P(A) es llamada probabilidad del evento A, y P cumple con las siguientes propiedades:

a) P(A) ≥ 0, ∀ A ∈ ℑ.

b) P(Ω) = 1.

c) 0 ≤ P(A) ≤ 1, ∀ A ∈ ℑ.

d) Ai ∈ ℑ tal que si i 6= j, Ai ∩ Aj = ∅ entonces

!

∞

∞

[

X

P

Ai

=

P(Ai )

i=1

i=1

Ya que hemos definido algunos conceptos importantes para esta rama de las matemáticas nos

enfocaremos a analizar que dado un fenómeno aleatorio con su respectivo espacio muestral Ω, ℑ

la σ−álgebra generada por Ω y una función de probabilidad P, decimos que la terna (Ω, ℑ, P) es

un espacio de probabilidad [3]. Con ayuda de esta definiremos un concepto muy importante que

usaremos a lo largo de este trabajo.

Definición 1.1.5 Consideremos un espacio de probabilidad (Ω, ℑ, P), definimos la función X :

Ω → R, decimos que X es una variable aleatoria si el conjunto {X ≤ x} ∈ ℑ para cualquier

x ∈ R.

Existen distintos tipos de variables aleatorias, pero en este trabajo sólo nos enfocaremos en variables

aleatorias discretas y para no expresar en cada definición y resultado que necesitamos un espacio

de probabilidad, desde ahora quedará implı́cito que requerimos dicho espacio. Lo que nos lleva a

la siguiente definición:

Definición 1.1.6 Sea H = {x1 , x2 , . . .} una colección

finita o numerable de números reales tales

P

que P(X = xk ) > 0 para cualquier xk , además si

P(X = xk ) = 1 decimos que X es una variable

k

aleatoria discreta y H es el conjunto de todos los posibles valores que puede tomar X.

Proposición 1.1.1 Considere dos eventos A, B, entonces:

1. Si A ∩ B 6= ∅, entonces P(A ∪ B) = P(A) + P(B) − P(A ∩ B). (ver figura 1.1 (a))

CAPÍTULO 1

3

Figura 1.1: Eventos A, B y su intersección [4].

2. Si A ∩ B = ∅, entonces P(A ∪ B) = P(A) + P(B). (ver figura 1.1 (b))

Una vez analizados estos conceptos que nos serán de mucha utilidad, tomaremos en cuenta el

siguiente ejemplo para tener una idea clara de dichos conceptos y ası́ poderlos comprender de una

mejor manera.

Ejemplo 1.1.2 Supongamos que tenemos un experimento aleatorio que consiste en lanzar tres

monedas.

Si X denota el número de caras (C) que aparecen al observar dicho experimento, entonces X es una

variable aleatoria y puede tomar los siguientes valores {0, 1, 2, 3} con las siguientes probabilidades:

P(X = 0) = P({AAA}) =

1

8

3

8

3

P(X = 2) = P({ACC}, {CAC}, {CCA}) =

8

1

P(X = 3) = P({CCC}) =

8

P(X = 1) = P({AAC}, {ACA}, {CAA}) =

Como X debe tomar uno de los valores 0, 1, 2, 3, debemos tener en cuenta que:

!

3

3

[

X

P

(X = i)

=

P(X = i) = 1

i=0

i=0

Es la suma de las probabilidades anteriores.

1.2.

Probabilidad condicional.

Ahora que ya hemos definido algunos de los conceptos básicos de la teorı́a de probabilidad,

nos enfocaremos en estudiar una de las herramientas más importantes de dicha teorı́a, la cual es

CAPÍTULO 1

4

el cálculo de probabilidades condicionales, es decir, calcular la probabilidad de un evento teniendo

en cuenta que ha ocurrido otro [4], lo que nos lleva a analizar los siguientes ejemplos para tener

una idea más precisa de lo que pretendemos explicar.

Ejemplo 1.2.1 Supongamos que tenemos una población de N personas, donde ND son daltónicas

y NM son mujeres.

Sean D y M los eventos de que una persona sea daltónica y mujer, respectivamente, entonces:

ND

N

NM

P(M) =

N

P(D) =

Considaremos ahora la subpoblación de mujeres, la probabilidad de que una persona elegida al

NDM

, donde NDM es el número de mujeres

azar entre esta subpoblación sea daltónica es igual a

N

daltónicas. Hasta ahora no tenemos ninguna idea nueva, pero sı́ necesitamos una nueva notación

para identificar qué subpoblación particular estamos analizando. Lo que nos lleva a la definición

formal de probabilidad condicional.

Definición 1.2.1 Sean A y B dos eventos, supongamos que P(A) > 0. Entonces la probabilidad

de B dado que ocurrió A es:

P(B|A) =

P(A ∩ B)

P(A)

(1.1)

Como usamos un ejemplo para introducir la definición formal de probabilidad condicional, analizaremos uno que nos permita ver cómo funciona este concepto de manera numérica.

Ejemplo 1.2.2 Consideremos un experimento que consiste en lanzar dos dados.

Supongamos que A es el evento de que la suma de las caras es 8, y B que el número obtenido en

la primer cara es un 3, de esta manera los eventos quedan constituidos de la siguiente manera:

A = {(2, 6), (3, 5), (4, 4), (5, 3), (6, 2)}

B = {(3, 1), . . . , (3, 6)}

Podemos ver que A ∩ B = {(3, 5)}, de esta manera:

5

36

6

P(B) =

36

1

P(A ∩ B) =

36

P(A) =

Por lo que, la probabilidad de que ocurra el evento B dado que ocurrió el evento A está dada por:

P(B|A) =

P(A ∩ B)

1/36

1

=

=

P(A)

5/36

5

CAPÍTULO 1

5

De igual manera podemos calcular:

P(A ∩ B)

1/36

1

=

=

P(B)

6/36

6

P(A|B) =

Con todo lo anterior, tenemos que mostrar las siguientes observaciones:

Observación 1.2.1

(i) Si P(A) = 0 en (1.1) entonces P(B|A) no está definida.

(ii) Los ejemplos anteriores nos llevan a pensar que la probabilidad condicional es una función

de probabilidad, B → P(B|A).

(iii) La probabilidad condicional cumple con los axiomas de probabilidad, esto es:

a) 0 ≤ P(B|A) ≤ 1, puesto que 0 ≤ P(A ∩ B) ≤ P(A).

P(Ω ∩ A)

=1

b) P(Ω|A) =

P(A)

c) Dados B1 , B2 tales que B1 ∩ B2 = ∅, entonces:

P((B1 ∪ B2 )|A) =

=

=

=

=

P((B1 ∪ B2 ) ∩ A)

P(A)

P((B1 ∩ A) ∪ (B2 ∩ A)

P(A)

P(B1 ∩ A) + P(B2 ∩ A)

P(A)

P(B1 ∩ A) P(B2 ∩ A)

+

P(A)

P(A)

P(B1 |A) + P(B2 |A)

(iv) En general para B1 , B2 , . . . con Bi ∩ Bj = ∅ para i 6= j tenemos:

!

[

X

P

Bi |A

=

P(Bi |A)

i

i

que se demuestra mediante inducción matemática [6].

1.3.

Fórmula de Bayes.

Una vez definido la probabilidad condicional, vamos a introducir un teorema muy importante

relacionado con este concepto, pero antes de eso analizaremos una definición y un teorema que

nos permitirá comprender mejor cómo funciona la Fórmula de Bayes y cómo nos ayuda a calcular

diferentes probabilidades.

Definición 1.3.1 Sean Ω un espacio muestral y {Hk , 1 ≤ k ≤ n} una colección de subconjuntos

n

S

Hk donde Hi ∩ Hj = ∅ para i ≤ i, j ≤ n, i 6= j

disjuntos cuya unión es todo Ω, es decir, Ω =

k=1

decimos que los Hk forman una partición para Ω.

CAPÍTULO 1

6

Figura 1.2: Partición de un espacio muestral en subconjuntos disjuntos.

En la Figura 1.2 podemos ver un esquema que nos permite analizar de una manera gráfica cómo

se puede particionar un espacio muestral [3]. Con base en esto y la probabilidad condicional enunciaremos el siguiente teorema que nos facilitará la comprensión de la Fórmula de Bayes.

Teorema 1.3.1 Sea {Hk , 1 ≤ k ≤ n} una partición de Ω, entonces para cualquier evento A ⊂ Ω,

tenemos:

P(A) =

n

X

P(A|Hk ) · P(Hk )

k=1

El Teorema 1.3.1 se conoce como la ley de la probabilidad total, podemos ver que dada una

partición de un espacio muestral y dado un evento A, este evento se puede ver como la intersección

del evento con los elementos de la partición, es por ello que la probabilidad de éste puede ser

expresada como una probabilidad condicional, por lo que, podemos calcular la probabilidad del

evento A dado que ocurren los eventos Hk . Una vez visto esto enunciaremos la Fórmula de Bayes.

Teorema 1.3.2 Sea {Hk , 1 ≤ k ≤ n} una partición de Ω. Entonces, para cualquier evento A ⊂ Ω,

tenemos:

P (Hk |A) =

P (A|Hk ) · P (Hk )

P (A)

(1.2)

Por 1.3.1

P (Hk |A) =

P (A|Hk ) · P (Hk )

n

P

k=1

P (A|Hk ) · P (Hk )

(1.3)

CAPÍTULO 1

7

Notamos que en el Teorema 1.3.2 dada una partición y un evento cualquiera A, podemos calcular

la probabilidad condicional de algún elemento de la partición dado que ocurre el evento A, esta

se puede expresar en función de la probabilidad condicional del evento A dado Hk . Observando el

denominador de la Ecuación (1.2) aplicamos el Teorema 1.3.1 para llegar a la Ecuación (1.3), que

conocemos como fórmula de Bayes. Para tener más claros estos teoremas ası́ como la definición

de partición, consideraremos los siguientes ejemplos. El primero es un ejemplo que nos permite

interpretar con detalle la importancia del Teorema 1.3.2, dicho ejemplo está relacionado con una

encuesta realizada fuera de unas casillas durante las elecciones para gobernador de un estado [5].

Ejemplo 1.3.1 En las elecciones de un estado durante el año de 1982, una estación de televisión

predijo con base en éstas, que la persona Roberto ganarı́a las elecciones. La encuesta consistı́a en

cuestionar a la gente al salir del lugar de la votación. Cuando los votos fueron contados Roberto

perdió ante Juan por un margen considerable. ¿Qué hizo que las encuestas fallaran?

Sean H1 , H2 los eventos de que las personas que votaron por Roberto y las que votaron por Juan

respectivamente y A el evento donde el votante se detiene a contestar la encuesta. Sabemos:

P (H1) = 0,45

P (H2) = 0,55.

Conociendo que el 40 % de los votantes de Roberto responde frente al 30 % de los votantes de Juan,

esto es:

P (A|H1 ) = 0,4

P (A|H2 ) = 0,3.

Estamos interesados en conocer P (H1|A), esto es la fracción de los votantes de Roberto que contestaron la encuesta, para ello podemos ver que:

P (H1 |A)

P (A)

P (H1 ∩ A)

=

P (H1 ∩ A) + P (H2 ∩ A)

P (H1 |A) =

Además, sabemos que P (H1 ∩ A) = P (A|H1) · P (H1) y P (H2 ∩ A) = P (A|H2 ) · P (H2 ), aplicando

la Fórmula de Bayes tenemos que:

P (H1 ∩ A)

P (H1 ∩ A) + P (H2 ∩ A)

P (A|H1 ) · P (H1 )

= 2

P

P (A|Hi ) · P (Hi )

P (H1|A) =

i=1

P (A|H1) · P (H1 )

P (A|H1) · P (H1 ) + P (A|H2) · P (H2 )

0,18

(0,4)(0,45)

=

= 0,5217

=

(0,4)(0,45) + (0,3)(0,55)

0,345

=

CAPÍTULO 1

8

Esto nos dice que el 52,17 % de los votantes de Roberto respondió a la encuesta sobre cómo votó,

lo que no implica que Roberto ganarı́a la elección.

El siguiente ejemplo está relacionado con una enfermedad llamada Hemofilia, y el cómo podemos

usar la Fórmula (1.3) para calcular la probabilidad de que una persona posea la enfermedad dado

otro evento [5], dicho esto analizamos el ejemplo.

Ejemplo 1.3.2 Elena tiene un hermano con hemofilia, y sus padres no tienen la enfermedad. Ya

que la hemofilia es causada por un alelo recesivo h en el cromosoma X, se puede inferir que su

madre es portadora, mientras que su padre tiene el alelo sano en su único cromosoma X. Elena

recibió un cromosoma X de su padre y el otro de su madre, hay un 50 % de probabilidad de que

sus hijos tengan la enfermedad. Si ella tiene dos hijos sanos ¿Cuál es la probabilidad de que ella

sea portadora?

Figura 1.3: Diagrama de Hemofilia.

Al analizar la Figura 1.3 podemos ver el diagrama de cómo se puede transmitir la hemofilia. Sean

H1 , H2 los eventos, ella es portadora y ella no es portadora respectivamente, y A el evento tiene 2

hijos sanos. Podemos ver que:

1

,

2

1

.

P (H2) =

2

P (H1) =

1

Debido que ella tiene dos hijos sanos, cuando es portadora la probabilidad es de , mientras que

4

1

es 1 cuando ella no lo sea, es decir P (A|H1 ) = y P (A|H2) = 1, estamos interesados en conocer

4

CAPÍTULO 1

9

la P (H1|A):

P (H1|A)

P (A)

P (H1 ∩ A)

.

=

P (H1 ∩ A) + P (H2 ∩ A)

P (H1 |A) =

Sabemos que P (H1 ∩ A) = P (A|H1 ) · P (H1) y P (H2 ∩ A) = P (A|H2) · P (H2 ), aplicando la fórmula

de Bayes tenemos que:

P (H1 ∩ A)

P (H1 ∩ A) + P (H2 ∩ A)

P (A|H1) · P (H1 )

= 2

P

P (A|Hi ) · P (Hi )

P (H1 |A) =

i=1

P (A|H1) · P (H1 )

P (A|H1) · P (H1 ) + P (A|H2) · P (H2 )

1/8

1

(1/2)(1/4)

=

= .

=

(1/2)(1/4) + (1/2)(1)

5/8

5

=

Lo que nos dice que la probabilidad de que ella sea portadora, dado que tiene dos hijos sanos, es

de 1/5.

Ahora que ya hemos comprendido claramente la Fórmula de Bayes, podemos resolver cualquier

problema de probabilidad condicional usando dicha fórmula y una partición del espacio muestral.

Con estos dos ejemplos y todos los conceptos anteriores podemos comenzar a analizar lo que realmente deseamos estudiar; los procesos estocásticos y algunos ejemplos. En los capı́tulos posteriores

los estudiaremos a detalle mediante el uso de las Cadenas de Markov y analizaremos algunas

aplicaciones de éstas.

1.4.

Procesos Estocásticos.

A continuación definiremos qué son los procesos estocásticos. Para ello considere la posibilidad

de un sistema que puede moverse sobre un conjunto de posibles valores (llamado espacio de estados,

que definiremos en el siguiente capı́tulo), supongamos además que el sistema cambia con alguna

ley en especifico, sea Xt el sistema al tiempo t, si el sistema evoluciona de tal manera que no es

determinista, sino que es provocada por algún fenómeno aleatorio, lo que nos lleva a pensar que

Xt es una variable aleatoria [9]. Esto nos lleva a la siguiente definición.

Definición 1.4.1 Consideramos un espacio de probabilidad (Ω, ℑ, P) y S un espacio de estados.

Un proceso estocástico es una colección de variables aleatorias {Xt : t ∈ T }, donde T es

conocido como el espacio parametral.

Observación 1.4.1 (a) T puede ser un subconjunto de los enteros no negativos, o un subconjunto de R, por ejemplo {0, 1, ..., n}, [0, t], [0, ∞].

CAPÍTULO 1

10

(b) Si T es de la forma {0, 1, ..., n} o los enteros no negativos, diremos que es un porceso a

tiempo discreto. Mientras que si T es de la forma [0, t] o [0, ∞] diremos que el proceso es a

tiempo continuo.

(c) Para nuestros fines trabajaremos con espacios de estados finitos o a lo más numerables.

Dicho esto analizamos un sencillo ejemplo de estos procesos, ya que en secciones posteriores tenemos

un sin número de ejemplos.

Ejemplo 1.4.1 Consideramos un proceso estocástico {Xt : t ∈ T }, donde T = {0, 1, . . . , n} y

S = {0, 1}

Esto es X0 = 0, X1 = 1, . . ., de esta manera, para cada n ∈ T Xn es 0 ó 1. Para tener una

mejor idea veamos la Figura 1.4. Ejemplos de este tipo de procesos son: las cadenas de Markov a

Figura 1.4: Proceso Estocástico.

tiempo discreto y a tiempo continuo, el proceso de Poisson, los martingales, los porcesos de Levy,

los procesos Gausianos [9]. Sin más preámbulos estudiemos las cadenas de Markov a lo largo del

siguiente capı́tulo, ası́ como el proceso de Poisson, que es un claro ejemplo de las cadenas a tiempo

continuo.

Capı́tulo 2

Cadenas de Markov.

Las cadenas de Markov forman una parte muy importante dentro de los procesos estocásticos

y la teorı́a de probabilidad, puesto que tienen una amplia teorı́a y un sin número de aplicaciones

[5]. Existen diferentes tipos de cadenas de Markov y nos enfocaremos en el estudio de las cadenas homogéneas, donde éstas no dependen del tiempo [8], dicho esto comenzaremos analizando la

definición formal de cadena de Markov ası́ como sus diferentes componentes. Teniendo en cuenta

que para el estudio de esta teorı́a, como en el capı́tulo anterior, es necesario un espacio de probabilidad (Ω, ℑ, P), donde Ω es el espacio muestral, ℑ es la familia de todos los subconjuntos de Ω y

P es una función de probabilidad. De esta manera no necesitaremos mencionar a lo largo de este

capı́tulo.

2.1.

Definición y Propiedad de Markov.

Existen diferentes procesos que se pueden modelar mediante una cadena de Markov y gracias

a éstas podemos ver cómo cambia nuestro modelo conforme avanza en tiempo. Algunos ejemplos

clásicos de este tipo de modelos son: la ruina del jugador [1], el modelo de Wright-Fisher, la cadena

de Ehrenfest [5], el tiempo de una determinada ciudad, aunque no se modela de una manera muy

exacta podemos aproximarnos a su comportamiento mediante dicho concepto [7], existen un sin

número de aplicaciones de este tipo de modelos, primero definiremos lo que es un estado, ası́ como

un espacio de estados y posteriomente daremos la definición formal de una cadena de Markov.

Definición 2.1.1 Sean X una variable aleatoria y S un conjunto de números, sea i ∈ S decimos

que i es un estado, si la variable aleatoria X toma el valor de i, es decir, P(X = i) > 0, y el

conjunto S es conocido como espacio de estados.

De la Definición 2.1.1 podemos deducir que un estado es el posible valor que toma una variable

aleatoria. Un espacio de estados es el conjunto de todos los posibles estados por los que puede

pasar una variable aleatoria. Para fines prácticos consideraremos que nuestro espacio de estados sea

finito o numerable, más aún tomaremos conjuntos de números enteros, para que nuestras variables

aleatorias sean discretas. De esta manera analizaremos la idea fundamental de este trabajo, esta

es la definición formal de una cadena de Markov.

Definición 2.1.2 Sea {Xn , n ≥ 0}, una sucesión de variables aleatorias, S un espacio de estados,

11

CAPÍTULO 2

12

i0 , i1 , . . . , in−1 , i, j ∈ S, si:

P(Xn+1 = j|Xn = i, Xn−1 = in−1 , . . . , X0 = i0 ) = P(Xn = j|Xn−1 = i)

(2.1)

Decimos que la sucesión {Xn , n ≥ 0}, es una cadena de Markov.

La Ecuación (2.1) es conocida como propiedad de Markov, ésta nos dice que la probabilidad de un

evento futuro sólo depende del evento inmediato anterior y no de la evolución del sistema, lo cual

implica que las cadenas de Markov son procesos sin memoria [5]. Ahora que ya tenemos entendido

lo que es una cadena de Markov, podemos enfocarnos en ciertas cadenas que serán objeto de

nuestro estudio, lo que nos lleva a la siguiente definición:

Definición 2.1.3 Sea {Xn , n ≥ 0}, una cadena de Markov con espacio de estados S, decimos que

{Xn , n ≥ 0}, es una cadena de Markov Homogénea, si:

P(Xn+1 = j|Xn = i) = P(X1 = j|X0 = i),

para i, j ∈ S

Dicho de otra manera la Definición 2.1.3 se refiere al hecho de que si una cadena de Markov no

depende del tiempo, es decir, no depende de n, ésta es considerada una cadena homogénea [8],

una vez que ya tenemos definido nuestro objeto de estudio, usaremos una función para ver cómo

evoluciona o se mueve una cadena entre los diferentes estados. Esta es la función de transición, y

nos permitirá verlo con mayor facilidad.

Definición 2.1.4 Sea {Xn , n ≥ 0} una cadena de Markov con espacio de estados S. Definimos

la función p(i, j) como:

p(i, j) = P(Xn+1 = j|Xn = i).

Donde p(i, j) es la función de transición del estado i al estado j, y cumple con las siguientes

propiedades:

(i) p(i, j) ≥ 0, para i, j ∈ S,

P

(ii)

p(i, j) = 1, ya que cuando Xn = i, Xn+1 va a algún j.

j

Es necesario mencionar que p(i, j) es conocida como la transición en un sólo paso del estado i al

estado j. En otras palabras si estamos en el instante i y queremos llegar a j en un sólo paso, lo

denotamos por p(i, j), de la Definición 2.1.4 es claro ver que (i) es cierto puesto que p(i, j) es una

probabilidad, mientras que la propiedad (ii) se refire a que la suma de las probabilidades de ir de i

a j es uno [5], para tener un concepto más claro, consideremos un ejemplo bastante sencillo donde

se muestra lo dicho hasta ahora.

Ejemplo 2.1.1 Consideramos una cadena de Markov con dos estados, 1 y 2, de tal manera que

podemos ir de 1 a 2 con probabilidad p y de 2 a 1 con probabilidad q, para ver el comportamiento

de esta cadena veamos la figura 2.1.

CAPÍTULO 2

13

Figura 2.1: Dinámica de una cadena de Markov de dos estados para el Ejemplo 2.1.1.

De esta manera podemos notar que S = {1, 2} y:

p(1, 2) = p , p(2, 1) = q

p(1, 1) = 1 − p , p(2, 2) = 1 − q

Visto de otra manera tenemos que:

1

2

1 1−p

p

2

q

1−q

Existen modelos que a simple vista no pueden modelarse mediante una cadena de Markov, como

se mostrará en el siguiente ejemplo, sin embargo bajo ciertas condiciones podemos obtener una

cadena que nos permita modelarlos. Para tener una idea más clara, pensemos en un jugador de

baloncesto que hace dos lanzamientos libres, la probabilidad de que enceste los dos tiros no es

precisamente una cadena de Markov [5], dicho esto veamos el ejemplo.

Ejemplo 2.1.2 Consideramos un jugador de baloncesto, que hace un tiro libre con las siguientes

probabilidades:

1/2 si falló los últimos dos tiros libres

2/3 si encestó alguno de los dos anteriores

3/4 si encestó los dos últimos tiros

Para formular la cadena de Markov que modele los tiros libres es necesario notar que Xn+1 no

sólo depende de Xn también de Xn−1 , por lo que dejaremos que los estados de este proceso sean

los resultados de sus últimos dos tiros, S = {EE, EF, F E, F F }, donde E denota el hecho de que

enceste y F que falle, de esta manera la probabilidad de transición es:

EE EF F E F F

EE 3/4 1/4 0

0

EF

0

0 2/3 1/3

F E 2/3 1/3 0

0

FF

0

0 1/2 1/2

Para explicar esto supongamos que estamos en el estado EF , es decir Xn−1 = E y Xn = F , en este

caso el siguiente resultado sera H con probabilidad 2/3, cuando esto ocurre, el siguiente estado

será (Xn , Xn+1 ) = F E con probabilidad 2/3, y falla con probabilidad 1/3 esto es (Xn , Xn+1 ) = F F .

CAPÍTULO 2

2.2.

14

Matriz de Transición.

Ahora que ya manejamos de una manera más fácil la función de transición, lo definiremos de

una manera sencilla, esto es, ver cómo podemos ir de un estado a otro, es decir, cómo interactúan

los estados de la cadena entre sı́. Es por ello que nos basaremos en algunos conceptos de álgebra

lineal para hacerlo posible, lo que nos lleva a la siguiente definición.

Definición 2.2.1 Sea p(i, j) la función de transición de una cadena de Markov, diremos que

p(i, j) es la ij−ésima entrada de la matriz P , y diremos que ésta es la matriz de transición de

dicha cadena.

Observación 2.2.1 Como P está formada por cada una de las transiciones de la cadena podemos

afirmar que P es una matriz no negativa, lo que implica que cada una de sus entradas es positiva,

esto es cierto por (i) de la definición 2.1.4.

De lo anterior es fácil deducir que a lo largo de este trabajo usaremos matrices no negativas,

además de ser no negativas, cada una de las filas de estas matrices suma 1, sabemos que las

variables aleatorias pasan por diferentes estados conforme ésta se mueve, pero qué sucederı́a si

la cadena llega a un estado especı́fico y no sale de éste [5], el estado se convierte en un estado

absorbente, lo que resulta en la siguiente definición.

Definición 2.2.2 Sea k ∈ S un estado de la cadena de Markov, diremos que k es un estado

absorbente si p(k, k) = 1.

Para que sea preciso el concepto antes analizado, consideremos los siguientes ejemplos que son

clásicos en la teorı́a de las cadenas de Markov, en los cuales hay estados absorbentes.

Ejemplo 2.2.1 (Ruina del jugador) Cosideremos la posibilidad de un juego de casino, en que un

jugador gana $1 cada turno con probabilidad p = 0,4 y pierde $1 con probabilidad 1 − p = 0,6.

Con las siguientes condiciones, si el jugador llega a $N deja de jugar, mientras que si llega a 0, el

casino lo obliga a dejar el juego.

Sea Xn la cantidad de dinero que el jugador tiene en el n−ésimo juego, suponiendo que Xn tiene la

propiedad de Markov, entonces para predecir el siguiente estado Xn+1 para esto debemos tener en

cuenta que si el jugador sigue jugando entonces Xn = i con 0 < i < N, ya que 0 y N son estados

absorbentes puesto que si llegamos a ellos automáticamente dejamos de jugar. De esta manera

vemos que:

p(i, i + 1)

p(i, i − 1)

p(0, 0)

p(N, N)

=

=

=

=

0,4

0,6

1

1

CAPÍTULO 2

15

Una forma de traducir lo anterior es:

0

1

2

3

..

.

N

0

1

1

0

0.6 0

0 0.6

0

0

..

..

.

.

0

0

2

3 ... N

0

0 ... 0

0.4 0 . . . 0

0 0.4 . . . 0

0.6 0 . . . 0

..

..

.

..

. ..

.

.

0

0 ... 1

Para tener una visión más clara de la tabla anterior observemos la Figura 2.2.

Figura 2.2: Dinámica de una cadena de la ruina del jugador.

Con base en la tabla anterior y a la Figura 2.2

éste modelo es:

1

0

0,6 0

0 0,6

P = 0

0

..

..

.

.

0

0

podemos afirmar que la matriz de transición para

0

0 ... 0

0,4 0 . . . 0

0 0,4 . . . 0

0,6 0 . . . 0

.. . . ..

..

. .

.

.

0

0 ... 1

Otro ejemplo bastante sencillo para comprender todos estos conceptos es el siguiente.

Ejemplo 2.2.2 (Modelo de Wright-Fisher) Consideremos una población fija de n genes que pueden

ser de dos tipos A ó a. Estos tipos de genes se llaman alelos. La población en el tiempo n + 1 se

obtiene mediante la elaboración con reemplazo de la población en el estado n. En este caso si permitimos que Xn sea el número de alelos en el tiempo n, entonces Xn es una cadena de Markov

con probabilidad de transición

j n−j

i

i

n

p(i, j) =

1−

0 ≤ i, j ≤ n

(2.2)

j

n

n

Donde el lado derecho de la Ecuación (2.2) es la distribución para n ensayos independientes con

i

probabilidad de éxito . Tengamos en cuenta cuando i = 0, tenemos p(0, 0) = 1 y cuando i = n.

n

CAPÍTULO 2

16

Entonces p(n, n) = 1. Considerando el caso en el que n = 4 tenemos:

0

1

2

3

4

0

1

0

0

0

0

1 81/256 27/64 27/128 3/64 1/256

2 1/16

1/4

3/8

1/4

1/16

3 1/256 3/64 27/128 27/64 81/256

4

0

0

0

0

1

Figura 2.3: Modelo Wright-Fisher.

Es claro ver que en este modelo los estados 0 y n son estados absorbentes, porque estando en ellos

dificilmente salimos de éstos, ya que eventualmente entra en alguno de los estados absorbentes. Para

que este modelo sea más interesante y más realista, introduciremos la probabilidad de mutaciones:

un alelo A que se dibuja termina siendo un alelo a en la siguiente generación con probabilidad u,

mientras que una a que se dibuja termina siendo una A en la proxima generación con probabilidad

v, en este caso la probabilidad de que una A sea generada por un sorteo dado es:

ρi =

i

n−i

(1 − u) +

v.

n

n

Es decir, podemos obtener una A dibujando una A y no tener una mutación, o dibujamos una A

que tiene una mutación. Dado que los sorteos son independientes, la probabilidad de transición

todavı́a tiene la forma binomial:

n

p(i, j) =

(ρi )j (1 − ρi )n−j .

j

Aquı́ observamos el paso de la biologı́a a las matemáticas [5].

Ejemplo 2.2.3 (Cadena de Ehrenfest) Imaginemos dos volúmenes cúbicos conectados por un

pequeño agujero. En su versión matemática, tenemos dos “urnas ”, es decir, dos contenedores

usados en la teorı́a de la probabilidad, en los que hay un total de N bolas. Se elige una de las n

bolas al azar y se mueve a la otra urna (ver Figura 2.4).

Sea Xn el número de bolas en la urna de la izquierda tras la n-ésima extracción, debe quedar

claro que Xn tiene la propiedad de Markov, es decir, si queremos adivinar el estado en el tiempo

CAPÍTULO 2

17

Figura 2.4: Cadena de Ehrenfest.

n + 1, entonces el número actual en la urna de la izquierda, Xn , es la única información relevante

observada en la secuencia de estados Xn , Xn−1 ,. . .,X0 . Para comprobar esto observemos que:

P(Xn+1 = i + 1|Xn = i, Xn−1 = in−1 , . . . , X0 = i0 ) =

n−i

n

Ya que para aumentar el número de bolas tenemos que escoger una de las n − i bolas en la urna,

i

el número también puede disminuir en 1 con probabilidad . Y la probabilidad de transición

n

está dada por:

n−i

,

n

i

p(i, i − 1) =

.

n

p(i, i + 1) =

Para 0 ≤ i ≤ n. Con p(i, j) = 0 en otro caso, cuando n = 5, por ejemplo, la matriz de transición

es:

0

1

2

3

4

5

0 0 5/5 0

0

0

0

1 1/5 0 4/5 0

0

0

2 0 2/5 0 3/5 0

0

3 0

0 3/5 0 2/5 0

4 0

0

0 4/5 0 1/5

5 0

0

0

0 5/5 0

Aquı́, hemos escrito al menos un 5/5 para enfatizar el patrón en las diagonales de la matriz.

Ejemplo 2.2.4 (Cadena de Tiempo.) Sea Xn el tiempo en n dı́as en una determinada ciudad,

supongamos que tenemos los siguientes estados 1 lluvioso, 2 nublado sin lluvia y 3 soleado, a pesar

de que el clima no es exactamente una cadena de Markov, podemos proponerla como un sencillo

modelo, cuya matriz de transición es:

0,2 0,5 0,3

P = 0,1 0,3 0,6

0,7 0,2 0,1

CAPÍTULO 2

18

Es indispensable ver que esta cadena no posee estados absorbentes, ya que para ningún estado

p(i, i) = 1, podemos notar en la matriz de transición que después de un dı́a nublado sin lluvia (2)

sigue un dı́a lluvioso (3) es 0,6, es decir, p(2, 3) = 0,6, mientras que un dı́a soleado (1) es seguido

de un dı́a lluvioso (3) con probabilidad 0,3, en otras palabras p(1, 3) = 0,3, por otra parte, que un

dı́a nublado (2) sea seguido de un dı́a soleado (1) es p(2, 1) = 0,1.

2.3.

Transición de m pasos.

A razón de que hemos visto esta parte de la teorı́a, nos preguntamos ¿Qué otra utilidad tienen

estas cadenas de Markov?, es decir, ahora que conocemos un poco de éstas, qué más podemos

saber de ellas aparte de la información que nos arroja cada modelo, nos dedicaremos a responder

una sencilla cuestión ¿Qué pasa a largo plazo con dichas cadenas? [5], es fácil de deducir esto ya

que el modelo está dado en forma de matriz, relacionaremos esto con lo que ocurre en más de un

paso. Básicamente analizar la potencia de la matriz de transición [9]. Lo que nos lleva a la siguiente

definición.

Definición 2.3.1 Sean {Xn , n ≥ 0}, una cadena de Markov, p(i, j) = P(Xn+1 = i|Xn = i) la

probabilidad de ir de i a j en un paso, definimos la probabilidad de ir de i a j en m pasos, con

m > 1, como:

pm (i, j) = P(Xn+m = j|Xn = i)

Es necesario ver que esta propiedad sı́ es válida, supongamos que deseamos calcular:

p2 (i, j) = P(Xn+2 = j|Xn = i)

Vemos que para llegar a que Xn+2 = j pero Xn+1 debe pasar por algún estado k, esto es:

p2 (i, j) = P(Xn+2 = j|Xn = i)

X

=

P(Xn+2 = j, Xn+1 = k|Xn = i)

k

X P(Xn+2 = j, Xn+1 = k, Xn = i)

=

P(Xn = i)

k

X P(Xn+2 = j, Xn+1 = k, Xn = i) P(Xn+1 = k, Xn = i)

=

·

P(X

P(Xn+1 = k, Xn = i)

n = i)

k

X P(Xn+2 = j, Xn+1 = k, Xn = i) P(Xn+1 = k, Xn = i)

·

=

P(X

P(Xn = i)

n+1 = k, Xn = i)

k

X

=

P(Xn+2 = j|Xn+1 = k, Xn = i) · P(Xn+1 = k|Xn = i)

k

=

X

p(i, k)p(k, j).

k

Podemos notar que el último renglón es la (i, j)−ésima entrada de la matriz P 2 . Si se sigue por

inducción matemática podemos concluir esto en lo siguiente.

CAPÍTULO 2

19

Teorema 2.3.1 La probabilidad de transición de m pasos:

pm (i, j) = P(Xn+m = j|Xn = i)

Es la m-ésima potencia de la matriz de transición P , es decir, P m = P

· · P}.

| ·{z

m veces

Dicha demostración se sigue por inducción, una vez establecido que para ir de i a j en m pasos se

necesita calcular la m-ésima potencia de la matriz de transición, la importancia de esto es poder

demostrar la ecuación de Chapman-Kolmogorov [5], la cual está dada en la siguiente proposición.

Proposición 2.3.1 Sean n, m ∈ Z+ , entonces la probabilidad de ir de i a j en m + n pasos es

pm+n (i, j) =

X

pm (i, k)pn (k, j).

(2.3)

k

A continuación nos dedicaremos a demostrar que la Ecuación (2.3) es correcta, es decir, mostraremos

la veracidad de ésta, tenemos que tener en cuenta que para ir de i a j en m + n pasos tenemos que

ir de i a k en m pasos y de k a j en n pasos entonces [2]:

P(Xn+m = j|X0 = i) =

X

P(Xm+n = j, Xm = k|X0 = i)

k

=

X

P(Xm+n = j, Xm = k|X0 = i)

k

X P(Xm+n = j, Xm = k, X0 = i)

=

P(X0 = i)

k

X P(Xm+n = j, Xm = k, X0 = i) P(Xm = k, X0 = i) =

·

P(X0 = i)

P(Xm = k, X0 = i)

k

X P(Xm+n = j, Xm = k, X0 = i) P(Xm = k, X0 = i) =

·

P(Xm = k, X0 = i)

P(X0 = i)

k

X

=

(P(Xm+n = j|Xm = k, X0 = i) · P(Xm = k|X0 = i))

k

=

X

pm (i, k)pn (k, j)

k

Para tener una idea más clara de esta demostración para la ecuación (2.3), tengamos en cuenta el

análisis de la Figura 2.5, que básicamente nos explicará el por qué es necesario ir de i a k y de k

a j.

Como ya hemos demostramos el teorema y la ecuación de Chapman-Kolmogorov, podemos estudiar

con más detalle algunos ejemplos.

Ejemplo 2.3.1 Consideremos la cadena de la movilidad social, sea Xn la clase social de una

familia en la generación n-ésima, supongamos que 1 es la clase baja, 2 es media baja, 3 es la

CAPÍTULO 2

20

Figura 2.5: Ecuación de Chapman-Kolmogorov.

Clase media, 4 es la clase media alta y 5 es la clase alta, ahora consideremos los cambios entre los

estados de la siguiente manera:

1

2

3

4

5

1 0,5 0,2 0,15 0,1 0,05

2 0,3 0,3 0,2 0,15 0,05

3 0,1 0,2 0,4 0,2 0,1

4 0,05 0,15 0,2 0,3 0,3

5 0,1 0,15 0,15 0,2 0,4

Supongamos que una familia comienza en la clase media en la generación 0. ¿Cuál es la probabilidad

de que la generación 1 se eleve a la clase alta y la generación 2 caiga a la clase baja?, ¿Cuál es la

probabilidad de que una familia que inicia en la clase media en la generación 0 sea de clase baja

en la generación 2?.

Responderemos a la primera cuestión de la siguente manera, puesto que necesitamos calcular lo

siguiente:

P(X2 = 1, X1 = 5|X0 = 3) =

=

=

=

=

=

=

=

P(X2 = 1, X1 = 5, X0 = 3)

P(X0 = 3)

P(X2 = 1, X1 = 5, X0 = 3) P(X1 = 5, X0 = 3)

·

P(X0 = 3)

P(X1 = 5, X0 = 3)

P(X2 = 1, X1 = 5, X0 = 3) P(X1 = 5, X0 = 3)

·

P(X1 = 5, X0 = 3)

P(X0 = 3)

P(X2 = 1|X1 = 5, X0 = 3)P(X1 = 5|X0 = 3)

P(X2 = 1|X1 = 5)P(X1 = 5|X0 = 3)

p(3, 5)p(5, 1)

(0,1)(0,1)

0,01

CAPÍTULO 2

21

Por otro lado para responder a la segunda pregunta tenemos que analizar:

P(X2 = 1|X0 = 3) =

5

X

P(X2 = 1, X1 = k|X0 = 3)

k=1

=

5

X

p(3, k)p(k, 1)

k=1

= (0,1)(0,5) + (0,2)(0,3) + (0,4)(0,1) + (0,2)(0,05) + (0,1)(0,1)

= 0,17

Con estos dos ejercicios simples podemos notar que es bastante tedioso estar calculando este tipo

de procesos. Mencionamos en páginas anteriores que el último cálculo es una de las entradas de la

matriz de transición elevada al cuadrado, para ello vemos que:

0,5 0,2 0,15 0,1 0,05

0,3 0,3 0,2 0,15 0,05

P =

0,1 0,2 0,4 0,2 0,1

0,05 0,15 0,2 0,3 0,3

0,1 0,15 0,15 0,2 0,4

Calculando P 2 :

P

2

=

0,335 0,2125 0,2025 0,15

0,1

0,2725 0,22 0,2225 0,17

0,115

0,17

0,205

0,27

0,2

0,155

0,135 0,185 0,2225 0,2175 0,24

0,16

0,185 0,205 0,2025 0,2475

Fijándonos en la entrada que ésta ubicada en la intersección de la tercera fila y la primera columna,

es la probabilidad de ir del estado 3 al estado 1 exactamente en 2 pasos. Que en esencia es el cálculo

que hicimos para resolver a la segunda cuestión de nuestro problema.

Ejemplo 2.3.2 Consideremos la cadena de tiempo, estudiada en el Ejemplo 2.2.4, sabemos que

tenemos la siguiente matriz de transición:

0,2 0,5 0,3

P = 0,1 0,3 0,6

0,7 0,2 0,1

¿Qué sucede a largo plazo?

Para entender qué es lo que deseamos calcular con la pregunta de este problema, usaremos el

teorema anterior porque necesitamos calcular qué pasa con las diferentes transiciones conforme

pasa el tiempo, esto es, calcular las diferentes potencias de la matriz de transición para ver el

comportamiento de los estados, por ejemplo calculamos P 2 :

0,3 0,31 0,39

P 2 = 0,47 0,26 0,27

0,23 0,43 0,34

CAPÍTULO 2

22

Esta nos da la información necesaria para ir del estado i al estado j en dos pasos, si calculamos

P 3 obtendremos el comportamiento de los estados en 3 estapas:

0,364 0,321 0,315

P 3 = 0,309 0,367 0,324

0,327 0,312 0,361

Multiplicando nuevamente por P tenemos:

0,3254 0,3413 0,3333

P 4 = 0,3253 0,3294 0,3453

0,3493 0,3293 0,3214

Aplicando la ecuación de Chapman-Kolmogorov, es decir, P 4 · P 4 = P 8 :

0,33333174 0,33323893 0,33342933

P 8 = 0,33361973 0,33323654 0,33314373

0,33304853 0,33352453 0,33342694

Análogamente tenemos:

0,3333332789589 0,33333336097561 0,33333336006549

P 16 = 0,33333335915538 0,33333327941396 0,33333336143066

0,33333336188572 0,33333335961044 0,33333327850385

Si continuamos con lo cálculos podemos notar que mientras n crece entonces la matriz P n tiende

a:

1/3 1/3 1/3

1/3 1/3 1/3

1/3 1/3 1/3

Por lo anterior podemos decir que nuestra matriz converge cuando n es lo suficientemente grande.

2.4.

Distribución Inicial.

Una vez que ya hemos analizado algunas cadenas y sus estados podemos preguntarnos qué sucederı́a si nuestro primer estado es aleatorio, es decir, considerar la posibilidad de que el primer estado

de nuestra cadena de Markov sea un estado generado aleatoriamente [5], si esto fuera tendremos

en cuenta lo siguiente:

X

P(Xn = j) =

P(X0 = i, Xn = j)

i

=

X

P(X0 = i)P(Xn = j|X0 = i)

(2.4)

i

En la Ecuación (2.4) podemos ver que P(Xn = j|X0 = i) = pn (i, j), suponiendo que P(X0 = i) =

q(i) tenemos:

X

P(Xn = j) =

q(i)pn (i, j)

(2.5)

i

CAPÍTULO 2

23

En otras palabras, la Ecuación (2.5) nos dice que multipliquemos por la izquierda la matriz de

transición por las probabilidades iniciales, dicho de otra manera, para que ésta operación esté bien

definida, como la matriz de transición es de tamaño k × k necesitamos multiplicar por una matriz

de tamaño 1 × k (matriz fila), lo que nos lleva a la siguiente definición:

Definición 2.4.1 Sea {Xn , n ≥ 0}, una cadena de Markov, llamaremos distribución inicial al

vector fila, cuyas entradas son la probabilidad de que la variable aleatoria comience en un estado

y será denotada por π0 , es decir:

π0 = (q(0), q(1), . . . , q(k))

P

Donde 0, 1, . . . , k ∈ S, q(i) = P(X0 = i) y

q(i) = 1.

(2.6)

i

Para tener una mejor idea podemos analizar los siguentes ejemplos, y ası́ comprender la importancia

de esta definición.

Ejemplo 2.4.1 Consideremos la cadena de tiempo estudiada en el Ejercicio 2.2.4, supongamos

además que la distribución inicial es q(1) = 0,3, q(2) = 0,5 y q(3) = 0,2.

De esta manera podemos ver que:

π0 · P =

=

0,2 0,5 0,3

0,3 0,5 0,2 · 0,1 0,3 0,6

0,7 0,2 0,1

0,25 0,34 0,41

Donde 0,25 es la probabilidad de que la variable aleatoria X1 = 1, 0,34 es la probabilidad de que

la variable aleatoria X1 = 2 y 0,41 es la probabilidad de que la variable aleatoria X1 = 3, dicho

esto podemos observar que el producto de la distribución inicial por la matriz de transición es la

distribución de la variable aleatoria X1 .

Ejemplo 2.4.2 En la cadena de movilidad social estudiada en el Ejemplo 2.3.1, supongamos que

la distribución inicial está dada por q(1) = 0,2, q(2) = 0,2, q(3) = 0,3, q(4) = 0,15 y q(5) = 0,15.

Multiplicando la distribución inicial por la matriz de trancisión tenemos:

0,5 0,2 0,15 0,1 0,05

0,3 0,3 0,2 0,15 0,05

0,2 0,2 0,3 0,15 0,15 ·

π0 · P =

0,1 0,2 0,4 0,2 0,1

0,05 0,15 0,2 0,3 0,3

0,1 0,15 0,15 0,2 0,4

0,2125 0,205 0,2425 0,185 0,155

=

2.5.

Distribución Estacionaria.

Es determinante ver que la distribución inicial y la distribución de la variable X1 no son iguales

en los Ejemplos 2.4.1 y 2.4.2 que se analizaron. Serı́a interesante saber qué ocurre cuando la

distribución inicial es igual que la distribución de la variable aleatoria X1 [5], lo que nos lleva a la

siguiente definición:

CAPÍTULO 2

24

Definición 2.5.1 Si la distribución en el tiempo 0, es la misma que en el tiempo 1, la propiedad

de Markov nos asegura que será la distribución en todo momento n, y será llamada distribución

estacionaria, es decir:

π·P = π

Para tener una mejor idea realicemos algunos ejemplos y, de esta manera, despejaremos cualquier

duda acerca de la distribución estacionaria y tendremos una idea clara de cómo calcularla.

Ejemplo 2.5.1 Supongamos que tenemos una cadena de Markov de dos estados con matriz de

transición:

1−a

a

P =

b

1−b

Calcule la distribución estacionaria para esta cadena.

Sabemos que para que una distribución sea estacionaria π · P = π, es decir:

1−a

a

π1 π2

π1 π2 ·

=

b

1−b

Del cual obtendremos el siguiente sistema de ecuaciones:

−π1 a + π2 b = 0

π1 a − π2 b = 0

Que no nos aporta ninguna información acerca de cómo son π1 y π2 , recordemos además que la

suma de las π’s es 1, de esta manera construimos el siguiente sistema:

π1 + π2 = 1

π1 a − π2 b = 0

Del cual sabemos que las soluciones son π1 =

b

a

y π2 =

, para comprobar esto vemos que:

a+b

a+b

a

b − ba + ab

b

b

(1 − a) +

(b) =

=

a+b

a+b

a+b

a+b

b

a

ba + a − ab

a

(a) +

(1 − b) =

=

a+b

a+b

a+b

a+b

Con estos cálculos ya sabemos cuál es la distribución estacionaria, para cualquier cadena de Markov

de dos estados.

Ejemplo 2.5.2 Calcule la distribución estacionaria para una cadena de Markov de tres estados.

CAPÍTULO 2

25

Considerando que es una cadena de tres estados, entonces su matriz de transición está dada por:

a b 1−a−b

P = c d 1−c−d

e f 1−e−f

De esta manera:

π ·

P = π

a b 1−a−b

(π1 π2 π3 ) · c d 1 − c − d = (π1 π2 π3 )

e f 1−e−f

De lo anterior obtenemos el siguente sistema de ecuaciones:

aπ1 + cπ2 + eπ3 = π1

bπ1 + dπ2 + f π3 = π2

(1 − a − b)π1 + (1 − c − d)π2 + (1 − e − f )π3 = π3

Sabemos que π1 + π2 + π3 = 1, por lo que reemplazaremos la tercera ecuación del sistema anterior

por esta última, de esta manera obtenemos:

aπ1 + cπ2 + eπ3 = π1

bπ1 + dπ2 + f π3 = π2

π1 + π2 + π3 = 1

Usando algún método para resolver sistemas de ecuaciones obtenemos:

cf − e(d − 1)

(a − 1)(d − 1) + e(b − d + 1) + f (c − a + 1) − bc

be − f (a − 1)

=

(a − 1)(d − 1) + e(b − d + 1) + f (c − a + 1) − bc

(a − 1)(d − 1) − bc

=

(a − 1)(d − 1) + e(b − d + 1) + f (c − a + 1) − bc

π1 =

π2

π3

Con esto hemos calculado la distribución estacionaria para cualquier cadena de Markov de tres

estados, sin embargo, en los siguiente ejemplo no lo usaremos, puesto que deseamos que el lector

se dé cuenta de un detalle fino en los cálculos para la distribución estacionaria.

Ejemplo 2.5.3 Calcule la distribución estacionaria para la cadena de Markov de tres estados que

tiene la siguiente matriz de transición:

0,8 0,1 0,1

P = 0,2 0,6 0,2

0,2 0,4 0,4

CAPÍTULO 2

26

De igual manera al ejercicio anterior vemos

0,8

π1 π2 π3 · 0,2

0,2

Cuyo sistema de ecuaciones es:

que:

0,1 0,1

0,6 0,2 =

0,4 0,4

π1 π2 π3

0,8π1 + 0,2π2 + 0,2π3 = π1

0,1π1 + 0,6π2 + 0,4π3 = π2

0,1π1 + 0,2π2 + 0,4π3 = π3

El cual no nos aporta ninguna información sobre cómo son nuestas π’s, debido a que si sumamos

las tres ecuaciones obtendremos π1 + π2 + π3 = π1 + π2 + π3 , pero sabemos que π1 + π2 + π3 = 1 y

reemplazándola por la tercera ecuación del sistema anterior tendremos:

−0,2π1 + 0,2π2 + 0,2π3 = 0

0,1π1 − 0,4π2 + 0,4π3 = 0

π1 + π2 + π3 = 1

De la tercera ecuación vemos que π3 = 1 − π1 − π2 y sustituyendo en las dos primeras obtenemos:

0,5π1 + 0,1π2 = 0,3

0,2π1 + 0,7π2 = 0,3

Multiplicando la primera ecuación por 0.7 y -0.1 por la segunda entonces:

1,8 = (0,35 − 0,02)π1 ó π1 =

6

11

Multiplicando la primera ecuación por 0.2 y multiplicando por -0.5 la segunda nos da:

−0,09 = (0,02 − 0,35)π2 ó π2 =

3

11

2

Dado que las tres suman 1, entonces π3 = . de esta manera la distribución estacionaria está dada

11

por:

3

2

6

π =

11 11 11

Ejemplo 2.5.4 Consideremos la cadena de la movilidad social del Ejercicio 2.3.1 y calculemos su

distribución estacionaria:

0,5 0,2 0,15 0,1 0,05

0,3 0,3 0,2 0,15 0,05

0,1 0,2 0,4 0,2 0,1

0,05 0,15 0,2 0,3 0,3

0,1 0,15 0,15 0,2 0,4

CAPÍTULO 2

27

Usando las primeras dos ecuaciones del sistema π · P = π y el hecho de que la suma de las π’s es

1, obtenemos el siguiente sistema:

0,5π1 + 0,2π2 + 0,15π3 + 0,1π4 + 0,05π5

0,3π1 + 0,3π2 + 0,2π3 + 0,15π4 + 0,05π5

0,1π1 + 0,2π2 + 0,4π3 + 0,2π4 + 0,1π5

0,05π1 + 0,15π2 + 0,2π3 + 0,3π4 + 0,3π5

π1 + π2 + π3 + π4 + π5

=

=

=

=

=

π1

π2

π3

π1

1

Esto se truduce como la distribución estacionaria por una matriz A, igual a un vector que tiene

de última coordenada un uno y puros ceros, es decir, π · A = (0 0 1) donde:

−0,5 0,2 0,15 0,1 1

0,3 −0,7 0,2 0,15 1

0,1

0,2

−0,6

0,2

1

A=

0,05 0,15 0,2 −0,7 1

0,1 0,15 0,15 0,2 1

Tengamos en cuenta que las dos primeras columnas de la matriz A consiste en las primeras dos

columnas de la matriz de transición restando 1 de la diagonal, y la columna final es de unos. Es

fácil ver que el sistema π · A = (0 0 1) y se ve como π = (0 0 1) · A−1 . Calculando la inversa de A:

−1,716559 −0,100598 0,006381

0,196317

1,614459

−0,411028 −1,204932 −0,072821 0,112610

1,576171

−1

1,438411

A = −0,027401 −0,080328 −1,338188 0,007507

0,093842

0,001126 −0,074698 −1,1216005 1,1013306

0,218652

0,202623

0,225952

0,186670 0,1661004

De la última fila de esta matriz tenemos:

0,218652 0,202623 0,225952 0,186670 0,1661004

2.6.

Distribución Lı́mite.

Como ya hemos visto a lo largo de las secciones anteriores, el comportamiento a largo plazo

de una cadena de Markov es importante, porque que vemos cómo se comportará dicha cadena.

Al igual que la distribución inicial podemos definir un vector fila para cada instante n de ésta. El

vector tiene como componentes la probabilidad de iniciar en uno de los estados en el instante n

[9]:

πn = (πn (1), . . . , πn (k))

Con

πn (j) ≥ 0 ,

k

X

j=0

πn (j) = 1

CAPÍTULO 2

28

Lo que nos lleva a la siguiente relación:

πn (j) = P(Xn = j)

k

X

=

P(X0 = i)P(Xn = j|X0 = i)

=

i=1

k

X

π0 (i)P(Xn = j|X0 = i)

i=1

Si usamos la teorı́a de matrices para los cálculos de distribuciones, podemos ver lo anterior de la

siguiente manera:

πn = π0 P n

Como ya se mencionó, toda matriz de transición P determina una sucesión de distribuciones

π0 , π1 , . . . sobre el espacio de estados S [9], y ésta está dada por:

πn = πn−1 P = . . . = π0 P n , n ≥ 1

(2.7)

Bajo determinadas condiciones la sucesión anterior es convergente a una distribución de probabilidad π, supongamos entoces que:

π = lı́m πn

n→∞

Dicho esto analizaremos las propiedades de la distribución π, tomando el lı́mite cuando n → ∞ en

la igualdad (2.7) tendremos:

π = πP

(2.8)

y

π = π0

lı́m P n

n→∞

Esto nos lleva al análisis de varios resultados intuitivos:

Observación 2.6.1

estacionaria.

(2.9)

(i) La Ecuación (2.8) nos dice que la distribución lı́mite es una distribución

(ii) (2.8) indica que la distribución lı́mite no depende de la distribución inicial.

(iii) (2.9) implica que la distribución lı́mite está dada por la n−ésima potencia de la matriz P .

(iv) A partir de (2.9) el lı́mite de las potencias de P es una matriz con todas sus filas iguales y

las entradas de dicha matriz serán los elementos de la distribución lı́mite.

Dicho todo esto analizaremos entonces la definición formal de la distribución lı́mite.

CAPÍTULO 2

29

Definición 2.6.1 Consideremos una cadena de Markov con matriz de transición P y distribución

inicial π0 . Llamaremos distribución lı́mite de esta cadena a la matriz fila:

π = lı́m π0 P n = lı́m π0 pn (i, j)

n→∞

n→∞

Para tener una idea más precisa de esto analizaremos algunos ejemplos, en los cuales quedará resuelta la gran mayorı́a de nuestras dudas acerca de lo estudiado hasta este momento en esta

sección.

Ejemplo 2.6.1 Consideremos la cadena de tiempo y distribución estacionaria estudiadas en el

Ejemplo 2.4.1:

0,3 0,5 0,2

π0 =

0,2 0,5 0,3

P = 0,1 0,3 0,6

0,7 0,2 0,1

Como ya vimos en el Ejemplo 2.4.1:

π1 = π0 P =

0,2

0,5

0,3

0,3 0,5 0,2 · 0,1 0,3 0,6 = 0,25 0,34 0,41

0,7 0,2 0,1

Si continuamos con los cálculos tenemos que:

0,3

0,31

0,39

0,3 0,5 0,2 · 0,47 0,26 0,27 = 0,371 0,309 0,32

π2 = π0 P 2 =

0,23 0,43 0,34

Continuando con el proceso:

π4 = π0 P 4 =

Similarmente:

π8 = π0 P 8 =

=

De esta manera:

0,3254 0,3413 0,3333

0,3 0,5 0,2 · 0,3253 0,3294 0,3453 = 0,33013 0,33295 0,33692

0,3493 0,3293 0,3214

0,33333174

0,33323893

0,33342933

0,3 0,5 0,2 · 0,33361973 0,33323654 0,33314373

0,33304853 0,33352453 0,33342694

0,333419093 0,333294855 0,333286052

lı́m πn =

n→∞

1

3

1

3

1

3

CAPÍTULO 2

2.7.

30

Periodicidad.

Comenzaremos esta sección analizando la cadena de Ehrenfest estudiada en el Ejemplo 2.2.3

para el caso en el que n = 5.

Ejemplo 2.7.1 La matriz de trancisión está dada por:

P =

0

1

0

0

0

0

1/5 0 4/5 0

0

0

0 2/5 0 3/5 0

0

0

0 3/5 0 2/5 0

0

0

0 4/5 0 1/5

0

0

0

0

1

0

Por lo que:

A =

Calculando la inversa tenemos:

−1,33333

−0,36458

−0,16145

−1

A

=

−0,07812

−0,03125

0,03125

−1 1

0

0

0 1

0,2 −1 0,8 0

0 1

0 0,4 −1 0,6 0 1

0

0 0,6 −1 0,4 1

0

0

0 0,8 −1 1

0

0

0

0

1 1

−1,66667

−1,82291

−0,80729

−0,39062

−0,15625

0,15625

−0,83333 0,83333

1,66667 1,33333

−1,14583 0,52083

1,51041 1,30208

−1,61458 0,05208

1,27604 1,25520

−0,78125 −0,78125 0,85937 1,17187

−0,31250 −0,31250 −0,15625 0,96875

0,31250

0,31250

0,15625 0,03125

Donde la última fila de esta matriz está dada por:

Que converge a:

0,03125 0,15625 0,31250 0,31250 0,15625 0,03125

1

32

5

32

10

32

10

32

5

32

Con base en esto podemos decir:

n

k

π(k) =

2n

1

32

CAPÍTULO 2

31

Para comprobar que es correcto observemos que para 0 < k < n, podemos terminar en el estado

k sólo si subimos de k − 1 ó por bajando de k + 1, por lo que:

n

n

k−1

k+1

n−k+1

k+1

π(k − 1)p(k − 1, k) + π(k + 1)p(k + 1, k) =

·

+

·

n

n

n

2

n

2

1

(n + 1)!

(n − 1)!

= n

+

2

(k − 1)!(n − k)! (k)!(n − k + 1)!

k n−k

1

n

= π(k)

+

= n

k

2

n

n

La única manera de terminar en 0 es porque bajamos de 1, entonces:

n 1

π(1)p(1, 0) = n · = π(0)

2 n

Del mismo modo, la única manera de terminar en n es porque subimos de n − 1, esto es:

n 1

π(n − 1)p(n − 1, n) = n · = π(0)

2 n

Sin embargo si consideramos esta cadena con n = 3 tenemos que la matriz de transición para este

caso es:

0

1

0

0

1/3 0 2/3 0

Q =

0 2/3 0 1/3

0

0

1

0

Calculando la trancisión en dos pasos tendremos:

1/3 0 2/3 0

0 7/9 0 2/9

Q2 =

2/9 0 7/9 0

0 2/3 0 1/3

Podemos ver que el patrón se desplazó, si continuamos con la transición de tres pasos obtenemos:

0

7/9

0

2/9

7/27

0

20/27

0

Q3 =

0

20/27

0

7/27

2/9

0

7/9

0

Continuando con Q4 tenemos:

Q4

7/27

0

20/27

0

0

61/81

0

20/81

=

20/81

0

61/81

0

0

20/27

0

7/27

Hemos visto que el patrón efectivamente se desplazó, además, es fácil ver que en Q2n tenemos

q 2n (i, j) > 0 si i + j es par y q 2n+1 (i, j) = 0 si i + j es impar. Caso contrario en Q2n+1 pues

q 2n+1 (i, j) > 0 si i + j es impar y q 2n+1 (i, j) = 0 si i + j es par. Lo que hace muy difı́cil notar la

convergencia de Qn cuando n → ∞. Lo que nos lleva a las siguientes definiciones:

CAPÍTULO 2

32

Definición 2.7.1 Sea {Xn , n ≥ 0}, una cadena de Markov con matriz de transición P , decimos

que P es irreducible, si para cada i y j se puede llegar de i a j, es decir, pm (i, j) > 0 para algún

m ≥ 1.

Definición 2.7.2 Sea i un estado de una cadena de Markov, diremos que i es una estado aperiódico, si el máximo común divisor de Ji = {n ≥ 1 : pn (i, i) > 0} es 1, es decir:

gcd(Ji ) = 1

Supongamos que el máximo común divisor de Ji es k, en otras palabras, k = gcd(Ji ) diremos que

k es el periodo del estado i.

Consideremos el siguiente ejemplo para tener una idea más clara de lo que sucede con estas definiciones.

Ejemplo 2.7.2 (Triángulo y cuadrado.) Consideremos el espacio de estados S = {−2, −1, 0, 1, 2, 3}

y la probabilidad de transición es:

−2

−1

0

1

2

3

−2 −1 0 1 2 3

0

0 1 0 0 0

1

0 0 0 0 0

0 1/2 0 1/2 0 0

0

0 0 0 1 0

0

0 0 0 0 1

0

0 1 0 0 0

Es decir, 0 → −1 → −2 → 0 es un triángulo y 0 → 1 → 2 → 3 → 0 es un cuadrado. (ver Figura

2.6)

Figura 2.6: Cadena triángulo y cuadrado.

Pongamos nuestra atención en el estado 0, es claro que tenemos la misma probabilidad de ir a 1

ó -1, más aún p3 (0, 0) > 0 puesto que p3 (0, 0) = p(0, −1)p(−1, −2)p(−2, 0) y p4 (0, 0) > 0 ya que

p4 (0, 0) = p(0, 1)p(1, 2)p(2, 3)p(3, 0), dicho esto sabemos que 3, 4 ∈ J0 , por lo que:

J0 = {3, 4, 6, 7, 8, 9, 10, . . .}

CAPÍTULO 2

33

Podemos ver que 5 ∈

/ J0 pues no hay forma de llegar a 0 en 5 pasos, y después de 6 el resto de los

números estan en J0 . Observemos que J0 es cerrado bajo la suma, dicho esto no es difı́cil concluir

que el máximo común divisor de J0 es 1, por lo tanto 0 es un estado aperiódico.

Ejemplo 2.7.3 Consideremos una cadena de Markov con espacio de estados S = {1, 2, 3, 4} y

matriz de transición:

0,5 0,5 0

0

0,3 0,7 0

0

P =

0

0 0,2 0,8

0

0 0,8 0,2

La dinámica de cadena de Markov se puede ver de una manera más gráfica en la Figura 2.7.

Figura 2.7: Dinámica de la cadena de Markov con espacio de estados S = {1, 2, 3, 4}.

Veamos que si la cadena comienza en 1 ó 2 se queda en esos dos estados, de manera muy similar

si comienza en los estados 3 ó 4, por lo que la cadena es reducible. Para ver que esto es cierto,

tengamos en cuenta que si la cadena comienza en 1 ó 2, ésta se comporta como una cadena de

Markov con espacio de estados S1 = {1, 2} y matriz de transición:

0,5 0,5

P1 =

0,3 0,7

Sucede lo mismo si comienza en 3 ó 4, esto puede ser un ejemplo muy sencillo que nos muestre

cómo es el comportamiento de una cadena de Markov reducible, pues en éstas se puede analizar

el comportamiento a largo plazo reduciendo la cadena en subcadenas con espacios de estados más

pequeños.

CAPÍTULO 2

2.8.

34

Teorema de la Convergencia.

Teorema 2.8.1 Si P es irreducible y tiene un estado aperiódico, entonces hay una única distribución estacionaria π para cualquier i y j, es decir:

lı́m pn (i, j) = π(j)

(2.10)

n→∞

Demostración. Sea {Yn , n ≥ 0}, una cadena de Markov independiente de la cadena {Xn , n ≥ 0},

pero con la misma matriz de transición. De esta manera definimos {Zn , n ≥ 0}, como Zn = (Xn , Yn )

es una cadena de Markov con probabilidad de transición:

P(Zn = (xn+1 , yn+1)|Zn = (xn , yn )) = p(xn , xn+1 )p(yn , yn+1 )

Podemos verificar fácilmente que Zn tiene distribución estacionaria, es decir:

πZ = πX πY

Para ver que efectivamente esto es cierto, tomemos (x0 , y0 ) ∈ S ′ , donde S ′ es el espacio de estados

de {Zn , n ≥ 0}, de esta manera:

X

πZ ((x0 , y0))p((x0 , y0 ), (x, y)) =

XX

=

πX (x0 )πY (y0 )p(x0 , x)p(y0 , y)

y0

x0

(x0 ,y0 )

X

πX (x0 )p(x0 , x)

x0

!

X

πY (y0 )p(y0 , y)

y0

!

= πX (x)πY (y) = πZ ((x, y))

Veamos que, como P es irreducible entonces existe un natural n0 , tal que:

pn (x0 , x) > 0 y pn (y0 , y) > 0

para toda n ≥ n0

Por lo que:

pn ((x0 , y0), (x, y)) = pn (x0 , x)pn (y0 , y)

para toda n ≥ n0

Lo anterior es cierto debido a que Xn y Yn son aperiódicas, por lo que Zn es recurrente positiva y

en particular es recurrente.

Sea j un estado de la cadena original (Xn ), definimos el primer momento en el que la cadena

Zn , n ≥ 0, visita por primera vez el estado (j, j) como τj = mı́n {n ≥ 1 : Zn = (j, j)}, sea τ =

mı́n {n ≥ 1 : Xn = Yn }, y τ será el primer momento en el que coinciden las dos cadenas, como

CAPÍTULO 2

35

Zn , n ≥ 0, es recurrente entoces P(τ < ∞) = 1, además τ ≤ τj , por la propiedad de Markov

P(Xn = x, τ ≤ n) =

n

XX

r=1

n

XX

P(Xn = x, Xr = j, τ = r)

j

=

=

r=1

n

XX

P(Xn = x|Xr = j, τ = r)P(Xr = j, τ = r)

j

r=1

n

XX

P(Yn = x|Yr = j, τ = r)P(Yr = j, τ = r)

j

=

j

P(Yn = x|Yr = j)P(Yr = j, τ = r)

r=1

= P(Yn = x, τ ≤ n)

Es decir, sobre el evento (τ ≤ n), las variables aleatorias Xn y Yn tienen la misma distribución de

probabilidad, por otra parte:

P(Xn = j) = P(Xn = j, τ ≤ n) + P(Xn = j, τ > n)

= P(Yn = x, τ ≤ n) + P(Xn = j, τ > n)

≤ P(Yn = j) + P(τ > n)

(2.11)

P(Yn = j) = P(Yn = j, τ ≤ n) + P(Yn = j, τ > n)

= P(Xn = x, τ ≤ n) + P(Yn = j, τ > n)

≤ P(Xn = j) + P(τ > n)

(2.12)

Mientras que:

De (2.11) y (2.12) concluimos que:

|P(Xn = j) − P(Yn = j)| ≤ P(τ > n) → 0

Cuando n → ∞. Tomando X0 = i con probabilidad uno, tenemos:

P(Xn = j) = P(Xn = j|X0 = i)P(X0 = i)

= pn (i, j)P(X0 = i)

= pn (i, j)

Si tomamos Y0 con la distribución estacionaria π, entonces:

X

P(Yn = j) =

P(Yn = j|Y0 = i)π(i)

i

=

X

π(i)pn (i, j)

i

= π(j)

(2.13)

CAPÍTULO 2

36

Sustituyendo en (2.13) podemos concluir que:

|pn (i, j) − π(j)| → 0

El Teorema 2.8.1 es conocido como Teorema de la Convergencia, y como consecuencia inmediata

a éste, tenemos el siguiente resultado [9].

Corolario 2.8.1 Si para algún n, pn (i, j) > 0 para todo i y j entoces hay una única distribución

estacionaria π, y:

lı́m pn (i, j) = π(j)

n→∞

Demostración. Como P es irreducible, entonces podemos llegar a cualquier estado en n pasos, es

decir, pn (i, j) > 0, como i y j son arbitrarios, entoces todos los estados son aperiódicos, de esta

manera pn+1 (i, j) > 0 por lo que n, n + 1 ∈ Ji asi gcd Ji = 1.

Haciendo n = 1 en el corolario, es fácil ver que se puede aplicar el teorema de la convergencia a la

cadena de tiempo, mientras que este teorema no es aplicable a la cadena de la ruina del jugador,

porque en éste último tenemos estados absorbentes y, por lo tanto no son irreducibles. Ademas

como vimos en la cadena de Ehrenfest con n = 3 todos los estados tienen periodo 2, por lo que

ahora analizaremos otro modelo conocido como la cadena de inventario [5]. Veamos el siguiente

ejemplo en el cual podemos apreciar cómo aplicar los dos resultados anteriores.

Ejemplo 2.8.1 Una tienda vende un determinado producto, si al final del dı́a el número de

unidades que posee la tienda es 0 ó 1, se adquiere más producto, teniendo en cuenta que el lı́mite

de productos que puede tener es 5. Suponiendo que la nueva mercancı́a llega antes de abrir la tienda, al dı́a siguiente, sea Xn , n ≥ 0, el número de unidades en el inventario al final del n−ésimo

dı́a, si suponemos que el número de clientes que compran el producto cada dı́a es 0, 1, 2, 3 con