Capítulo 6 - Departamento de Informática

Anuncio

Capítulo 6

Héctor Allende O.

!

#$ %

"

!

#

!

&

$

% '

∈

(

ω

&

∈

ω ∈Ω

∀ ∈

Ω ℑ

!

!

"

!

!

)

$

%

, $ω %

&

'

.%

,$ %

&

-

%

.

()

ω

'

* +

$*

'

"

'/

#

0

0

1

∈

2 +

!

3

4

∈

5 +

!

4

µ

σ

- →ℜ

→µ

→σ

= , +

σ

)

µ

)

= ,

→ℜ

-

+=

= , +=

=

− , +

∀ ∈

∀∈

!

4

!

*

0

*6

4

0

∈

7 +

.

*

∈

7 +

!

!

4

4

ρ

- × →ℜ

→

=

,

−µ

=

- × →ℜ

+

→ρ

−µ

=

,

σ

+

σ

/

0

*6

=

*

!

1

+

'

+

− ,

=

8

4

4

,

= ,

0

+

−

− ,

Ωℑ

- Ω×

&9

!

++

−

=

= ,

+=

=

=

!!!

=

-8

+

τ =

,

+τ + = γ τ

.

-

!!!!

∈

∈Ν

→ℜ

!

5:

,

+

!

#

5:

$

%&

;

!

'

!

$

*

!!!!

+<∞ ∀ ∈

,

τ

+τ

8

[ ]≡ σ

$[2 ] < ∞

!

*+

= µ −µ <∞ ∀ ∈

,$ %

$$

∀ ∈

+ τ !!!!

+τ

%

*

;

"% &

!

%&

'

!

!

'

*"

$

("

"

!

$

;

!

$

,$ %

!

;

#

;

4 %

'

4

;

%

,

<#$ %=>

+=

)

& )

()

!

)

& )

()

& !

=

0

%

<#$ % #$ ?τ%= > @$τ%

%6

"

#

;

;

"

;

!

!

$

!

'

%

+

!

−

+

> B2C

@

;

,$ %

!

!

A

, %

4

;

−

*

−

<

.

1

"

≤

=

D

6

3

=

=

−

1

3

;

=

3

≤

1

D

,$ %

!

1

D

!!!

=

−

<

−

D

1

< !!!!

=

!!

−

−

=

<

3

!!!

D

!!!

3

−

×

−

=

!!!

3

3

×

−

!!!

−

=

−

!!!

−

−

−

!!!

−

−

!

)

8

1

D

∏

=

!!!

3

−

=

/

1

0

D

6

6

"

!

'

( $ %

1

D

A

#

;

<B 9 =

'

"

3

"

1

−

4

D

@

;

τ

+τ 3

−

+τ =

3

−

0

(

5

()

&

&

6

(

*

;

"

;

#

$E

;

*

*

*

F

#$ %

!

#$ %

*

G

(

%

;

'

0

(

"

!

!

'

G

@

#

H

I

1

H

*

,$ %

"

H

'

*

'

I

F

($ %

"

4

% ,$ %

% &

% <,$ %=>B

% ,$B%>B

% ( $ %

% ( $B%>B

%

A

!

'

%υ

$

τ

;

υτ

;

J

;

+

4

H

*

+τ −

=

=

−υτ

υτ

= 0 !!!

6

'

"

#

I

!

;

+τ −

,

+=

,

6

4

+

0

0<

)

−

#

I

<τ

#

+

#

'

+=

A

!! !

+ ,$ %

,

,

"

,

'

ν

+τ −

=ν τ −

−

0

)

0<

−

<τ

=

!! !

D #

!

−

=

= −

4

*

E

.

I

1

+

+

1

∈

∈

+

7

0σ

∀ ∈

∀

!!!

+θ

'

−

+ !!!!! + θ

−

∈

!

(

G

+

−

θ !!!! θ ∈ ℜ θ ≠ 0

+ = δ ×σ

,

%

+θ

=

+=0

,

%

7

∈

/

0

"

;

E1

∈

+

;

=φ

+φ

−

+ !!! + φ

−

−

+

=φ

'

7

(

I

"

*

;

!

' B ≤ ε$ % ≤ 5π

−

+

+θ

−

+ !!! + θ

−

∈

7

Generación de Procesos Estocásticos

;

ω0 + ε

=

#

ωB >

+ !!! + φ

Generación de Procesos Estocásticos

'

#$ %

#$ %

−

%

φ !!!! φ θ !!! θ ∈ ℜ φ ≠ 0 θ ≠ 0

∈

(

;

$

φ !!!! φ ∈ ℜ φ ≠ 0

'

∈

+

ε$ %

B≤ $ % ≤ ∞

$ % '

'

Generación de Familias de v.a. {2t}t ∈T

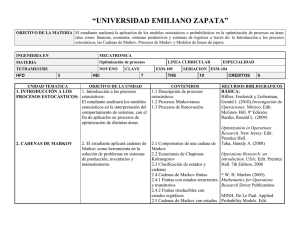

Comenzaremos con las cadenas de Markov homogéneas.

Cadena de Markov en Tiempo Discreto

Para generar una cadena de Markov con espacio de estado S

y matriz de transición P = [ pij ] donde p ij = P(2n+1=j / 2 = i). La

forma más simple de simular la transición (n+1)-ésima,

conocida 2n, es generar 2n+1~{pxnj : j ∈ S}

π

ω

0

π

ω

0

π

ω

0

π

ω

0

π

ω

0

Generación de Procesos Estocásticos

Generación de Procesos Estocásticos

Alternativamente se puede simular Tn, el tiempo hasta el

siguiente cambio de estado y, después el nuevo estado

2n+Tn. Si 2n = s, Tn ~ Geo (pss) y 2n+Tn tiene una distribución

discreta con cuantía {psj / (1 - pss) : j ∈ S \ {s}}.

Para muestrear N transiciones de la cadena suponiendo

2o = io

Algoritmo

Hacer t=0, 2o = io

Mientras t < N

Generar h ~ Geo(pxtxt)

Generar 2t+h ~ {pxtj / (1 - pxtxt) : j ∈ S \ {s}}.

Hacer t=t+h

"

OBS. 1) La primera forma de simular una cadena de

Markov, que corresponde a una estrategia

sincrónica, es decir en la que el tiempo de

simulación avanza a instantes iguales.

2) La estrategia asincrónica es más complicada de

simular [Ver. B. Ripley 1996]

#

#

Generación de Procesos Estocásticos

Generación de Procesos Estocásticos

Cadenas de Markov en Tiempo Continuo

La simulación asincrónica de cadenas de Markov en

tiempo continuo es sencilla de implantar.

- Las cadenas de Markov de Tiempo Continuo vienen

caracterizadas por los parámetros vi de las distribuciones

exponenciales de tiempo de permanencia en el estado i y

la matriz de transición P; con pii = 0; pij = 1

- Sea Pi la distribución de la fila i-ésima. Entonces si 2o= io,

para simular hasta T se tiene :

≠

Algoritmo

Hacer t = 0, 2o = io , j = 0

Mientras t < N

Generar tj ~ exp(vxj)

Hacer t = t + tj

Hacer j = j + 1

Generar 2j ~ Pxj-1

*

Generación de Procesos Estocásticos

.

Generación de Procesos Estocásticos

Proceso de Poisson

1) Para procesos de Poisson no homogéneos, con

En el Proceso de Poisson P(λ), el número de eventos NT

en un intervalo (0,T) es P(λT) y los NT ~ (0,T)

intensidad λ(t) y u(t) =

0

- Generar NT ~ P(u(t))

Algoritmo

- Generar

1,

2

,...,

4T

~

λ(s) ds . Entonces

λ

µ

,0

+

-Generar NT ~ P(λT)

- Generar

1,

...,

T

2) Los procesos de Poisson son un caso particular

de los procesos de renovación. La forma de generar

los primeros se extiende a los procesos de

renovación.

~ (0,T)

/

Generación de Procesos Estocásticos

- Sean S0 = 0,

S1, S2, ...

Los tiempos de ocurrencia

- Ti = Si - Si-1 los tiempos entre sucesos.

- Para un proceso de renovación, los Ti son v.a.i.i.d. según

cierta distribución τ.

- Simular hasta el instante T.

Hacer S0 = 0

Mientras Si < T

Generar Ti ~ τ

Hacer Si = Ti + Si-1

Hacer i = i + 1

0

Generación de Procesos Estocásticos

Procesos no Puntuales (Movimiento Browniano)

- La simulación de procesos (no puntuales) en tiempo

continuo es más complicada que la simulación de procesos

puntuales.

-Una solución es generar procesos en suficientes instantes

discretos y aproximar la trayectoria por interpolación.

*

Generación de Procesos Estocásticos

Generación de Procesos Estocásticos

Como ejemplo, consideremos el movimiento Browniano

con parámetro σ2

Entonces para ∆t fijo,

Hacer 20 = 0

- 20 = 0

Desde i = 1 hasta n

- Para s1 ≤ t1 s2 ≤ t2 ..... ≤ sn ≤ tn las v.a.

2t1 - 2s1, ..., 2tn - 2sn son independientes

Generar 8i ~ N(0, (t-s) σ2)

Hacer 2i∆t = 2(i-1)∆t + Yi

2t - 2s ~ N(0, (t-s) σ2)

- Para s < t,

Interpolar la trayectoria en {(i∆t, 2i∆t)}

-Las trayectorias son continuas

Otros ejemplos de Simulación de Procesos continuos [Ver

B. Ripley 1987]

Generación de Procesos Estocásticos

Generación de Procesos Estocásticos

El Proceso de Gibbs

El creciente interés en los métodos de cadenas de Markov,

se debe al uso en Inferencia Bayesiana del Muestrador de

Gibbs. [Geman and Geman (1984)]

P(2=1)

= p2 + p4 (Marginal)

P(2/8=1)

=

Las Distribuciones condicionales

Ejemplo: Sean (2,8) v.a.d. Bernoulli con distribución

x

0

1

0

1

y P(2,8)

0

p1

0

p2

1

p3

1

p4

=0

=

P(2=1/8=1) =

= 09 = 0

= 09 =

=

=

=

=

pi > 0

+

+

+

= 9 =0

= 9 =

+

+

"

#

Generación de Procesos Estocásticos

Algoritmo

Escoger 80 = y0 , j =1

Repetir

Generar 2j ~ 2/8 = yj-1

Generar 8j ~ 8/2 = xj

j=j+1

Generación de Procesos Estocásticos

Como las probabilidades pi > 0, la cadena es ergódica y

tiene distribución límite, que es la marginal de 2

=

+

+

+

+

Entonces {Xn} define una cadena de Markov con matriz de

transición

A = Ayx Axy

*

2n

2 ; 8n

1)

El procedimiento descrito se llama muestrador de

Gibbs [Gibbs Sampler] y nos proporciona una

cadena de Markov, con distribución límite deseada y

se puede generalizar.

8 ; (2n, 8n)

(2,8)

Para muestrear un vector aleatorio p-variante

2 = (21, 22, ..., 2p) con distribución π, conociendo

las distribuciones condicionadas 2s/2r, r ≠ s

.

.

Generación de Procesos Estocásticos

Generación de Procesos Estocásticos

Se puede verificar que 2n = (21n, 22n,..., 2pn) define una

cadena de Markov con Matriz de transición

Sea π (:s/:r, r ≠ s) Distribución Condicionada

El [Gibbs Sampler] en este caso es

Pg (2n, 2n+1) =

- Escoger 210, 220,..., 2p0 ; j = 1

Repetir

Generar 21j ~ 21/ 22j-1,..., 2pj-1

Generar 22j ~ 22/ 21j, 23j-1,..., 2pj-1

....

Generar 2pj ~ 2p/ 21j, 22j,..., 2p-1j

j = j+1

∏π

+

9

>

+

<

=

Bajo condiciones suficientemente generales [Ver Roberts

Smith (1994)]

/

Generación de Procesos Estocásticos

Generación de Procesos Estocásticos

El muestreador Gibbs

Ejemplo : Muestrear la densidad

π (:1/:2) =

π

:),−

+

Escoger x20 ; j = 1

+

Repetir

siendo D = R+ × R

π (:1/:2) = π π

= :),−

:),

−

+

π (:2/:1) =

:1/:2 ~

:), +

"0

+

Generar X1j ~ exp[1+(x2j-1)2]

+

Generar X2j ~ N(0, 1/2:1j)

OBS: Las secuencias podrían efectuarse en forma

aleatoria en lugar de usar la secuenciación natural

+

Estudiar el Algoritmo de Metropolis-Hastings.

:2/:1 ~ N(0, σ2=(1/2:1))

"

0

&

2*

&

(

I

!

'

K

;

4

5B 52 CK B

L

'

;

@

6

A

;

;

5*+

!

"

!

$)

"

E 1

*++,

1

$59295%

- . $/ +

"

/