Transparencias del capitulo 3. - Uprm

Anuncio

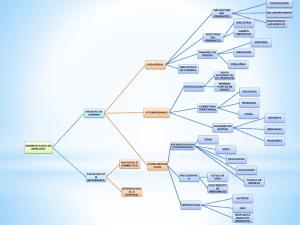

CAPÍTULO 3 DIAGNÓSTICOS DE REGRESIÓN Edgar Acuña Fernández Departamento de Matemáticas Universidad de Puerto Rico Recinto Universitario de Mayagüez Edgar Acuña Analisis de Regresion 1 3.1 “Outliers”, puntos de leverage alto y valores influenciales Una observación (y*,x*1,……..x*p) es considerado un “outlier” si está bastante alejado de la mayoría de los datos sea en la dirección vertical o en la horizontal. Sin embargo, la mayoría de los textos llaman “outlier” a un valor alejado solamente en la dirección vertical y Punto de leverage alto a una observación alejada en la dirección horizontal. Edgar Acuña Analisis de Regresion 2 Valor Influencial Una observación (y*,x*1,……..x*p) es considerado un valor influencial si su presencia afecta tremendamente el comportamiento del modelo. Por ejemplo, en el caso de regresión simple remover un valor influencial podría cambiar dramáticamente el valor de la pendiente. Edgar Acuña Analisis de Regresion 3 Ejemplo de una observación que es “outlier” y punto leverage alto pero que no es influencial. Edgar Acuña Analisis de Regresion 4 Ejemplo de una observación que es punto de leverage alto y que también es influencial. Este punto tendrá un gran efecto sobre el R2 y el cambio drástico en la pendiente. Edgar Acuña Analisis de Regresion 5 3.2 Residuales y detección de “outliers”. • Consideremos el modelo Y=XB+e , donde E(e)=0 y Var(e)=σ2I ) ) ) Luego Y = Xβ,donde β = (X'X) X'Y ) la matriz HAT (sombrero) H de Y = X(X' X))X' Y = HY actúa como una transformación de Y a Y . n ) - En particular yi = ∑ hij y j j =1 h es el elemento de la matríz H que está en la i-ésima fila y j-ésima columna. Así ) ) ) e = Y − Y = Y − HY = (I − H)Y donde e = y − ∑ h y −1 −1 ij n i Edgar Acuña Analisis de Regresion i j =1 ij j 6 3.2.1 Media y Varianza del vector de residuales i ) E (e ) = (I − H) E ( Y ) = 0 ii ) Var (e) = Var[(I − H)Y] = σ 2 (I − H) , I-H es simétrica e idempotente. En particular ) Var (ei ) = σ 2 (1 − hii ) ) ) Cov(ei , e j ) = −hij σ 2 se estima por s2(1-hii). Notar que : a) Tanto los errores ei como los residuales tienen media 0. b) La varianza de los errores es constante, pero la de los residuales no lo es. c) Los errores no están correlacionados, pero los residuales si. Edgar Acuña Analisis de Regresion 7 3.2.2 Residuales Estudentizados internamente • Se define por ri∗ = ) ei σ 1 − hii También son llamados residuales estandarizados. • La covarianza de los residuales estudentizados es igual a ) ) ) ) − hij e Cov ( e e j i,ej ) i = Cov (ri∗ , rj∗ ) = Cov ( , )= 2 σ 1 − hii σ 1 − h jj σ (1 − hii )(1 − h jj ) (1 − hii )(1 − h jj ) Edgar Acuña Analisis de Regresion 8 3.2.4 Residuales estudentizados externamente • Supongamos que la i-ésima observación es eliminada del conjunto de datos y que se ajusta el modelo lineal con las n-1 observaciones restantes. Luego, usando la identidad de Gauss (X'X)−1 xi x'i (X'X)−1 (X'(i) X(i) ) = (X'X) + 1− hii −1 −1 • Se obtienen las siguientes relaciones entre β̂ y ) β (i) y 2 entre s2 y s (i ) −1 ˆβ = βˆ − ( X' X) x i eˆi (i) 1 − hii eˆi2 n − p −1 2 2 s (i ) = s − n− p−2 (n − p − 2)(1 − hii ) Edgar Acuña Analisis de Regresion 9 La identidad de Gauss • Es un caso particular de la Identidad de ShermanMorrison-Woodburry (1950) (A ± uv') −1 A −1 uv' A −1 =A m 1 ± v' A −1 u −1 Donde: A es una matríz cuadrada nosingular n x n, y u y v son dos vectores de dimensión n. En nuestro caso, A=X’X y u = v = xi y X'(i)X(i) = X'X− xi x'i Donde x’i es la i-ésima fila de X Edgar Acuña Analisis de Regresion 10 Varianza del Residual yi -~yi Si ~yi representa el valor estimado de la variable de respuesta para la i-ésima observación ) ~ y i = x'i β (i) yi son independientes, (la i-ésima observación no yi y ~ fue usada en la estimación del modelo ) Var ( yi − ~ yi ) = Var ( yi ) + Var ( ~ yi ) = σ 2 + σ 2 x'i (X' ( i ) X ( i ) ) −1 x i Edgar Acuña Analisis de Regresion 11 Residual Estudentizado Externamente σ2 2 s por (iy) • Estimando considerando que si yi no es un outlier entonces E(yi - ~yi ) = 0 se obtiene ti = yi − ~ yi s (i ) 1 + x'i (X ' ( i ) X ( i ) ) −1 x i ti es llamado un residual estudentizado externamente y tiene n-p-2 grados de libertad. Edgar Acuña Analisis de Regresion 12 Propiedad: • Relación entre el residual usual y el residual usando un modelo eliminando la i-ésima observación êi ~ y i - yi = 1 - hii • Relación entre los distintos tipos de residuales 1/ 2 ) ei ⎛ n− p−2 ⎞ ∗⎜ ⎟ ti = = ri ⎜ n − p − 1 − r *2 ⎟ s(i ) 1 − hii i ⎠ ⎝ Edgar Acuña Analisis de Regresion 13 3.2 Diagnósticos para detectar “outliers” y puntos de leverage alto • Los diagnósticos más básicos son: • Si |hii|>2p/n (algunos usan 3p/n. Aquí p es el número de parámetros) entonces la i-ésima observación es considerado un “punto de leverage alto” y pudiera ser influencial • Si |ti|>2 ( o si |ri|>2) entonces la i-ésima observación es considerada un “outlier” y también puede ser influencial. Edgar Acuña Analisis de Regresion 14 Otros Diagnósticos i) La Distancia Cook (Cook, 1977) Mide el cambio que ocurriría en el vector de coeficientes estimados de regresión si la i-ésima observación fuera omitida. Se calcula por: CDi2 = (βˆ − βˆ (i) )' X' X(βˆ − βˆ (i) ) ps 2 = ) ) ) ) (y − y (i) )' (y − y (i) ) ps 2 = r *i2 hii p (1 − hii ) Un CD > 1 indica que la i-ésima observación es potencialmente influencial. Una observación con CD <0.1 no merece ninguna discusión si CD <.0.5 merece un poco de atención. En particular, una observación con CDi2> F(0.50,p,n-p) es considerado como un valor influencial. 2 i 2 i 2 i Edgar Acuña Analisis de Regresion 15 Otros Diagnósticos ii) DFFITS (Belsley, Kuh, y Welsch, 1980). DFFITS i2 = | DFFITS i |> 2 Un Notar que: p n ) ) ) ) ( y − y (i) )' (y − y (i) ) s(2i ) = ti2 hii (1 − hii ) indica un posible valor influencial. ri2 2 CDi = DFFITS i2 2 pt i Edgar Acuña Analisis de Regresion 16 Otros Diagnósticos iii) DFBETAS (Belsley, Kuh, y Welsch, 1980). Mide la influencia de la i-ésima observación en cada uno de los coeficientes de regresión. Se calcula por β j − β j ,( i ) i=1,..,n, j=0,…,p ( DFBETAS ) = ji s ( i ) c jj Donde cjj es el j-ésimo elemento de la diagonal de (X’X)-1. • Si |DFBETAS|ji > 2n para algun j entonces la i-esima observacion es posiblemente un valor influencial. Edgar Acuña Analisis de Regresion 17 Otros Diagnósticos iv) COVRATIO (Belsley, Kuh, y Welsch, 1980) Mide el efecto en la variabilidad de los coeficientes de regresión al remover la i-ésima observación. COVRATIOi = det[s(2i ) ( X ' (i ) X (i ) ) −1 ] det[s 2 ( X ' X ) −1 ] i =1,…,n. Usando propiedades de determinantes se tiene p ⎛ s2 ⎞ 1 ⎜ (i ) ⎟ (COVRATIO) i = ⎜ ⎟ ⎜ s 2 ⎟ (1 − hii ) ⎝ ⎠ Si (COVRATIO)i >1+3p/n o si (COVRATIO)i<1-3p/n entonces la i-ésima observación tiene un valor influencial grande. Edgar Acuña Analisis de Regresion 18 3.3 Plot de Residuales para detectar casos influenciales • Se usan para estudiar el efecto de añadir una nueva variable predictora en un modelo. • Permiten detectar la presencia de casos influenciales. • Para ver la importancia de la variable predictora xj Consideremos el modelo Y=X-jB-j+βjxj +e Donde X-j es la matriz X sin incluir la columna j Edgar Acuña Analisis de Regresion 19 Residuales Definamos los siguientes residuales i ) eY / X − j = ( I − H − j )Y ii ) eY / x , X − j = ( I − H )Y iii ) ex j / X − j = (I − H − j ) X j Edgar Acuña se han considerado en el modelo todas las predictoras excepto xj están consideradas todas las variables predictoras son los residuales de la regresión de xj versus las otras variables predictoras. Analisis de Regresion 20 Plot de residuales versus la variables predictoras. ) • eY / x , X j −j versus xj Si el modelo es adecuado los puntos se deberían alinear a lo largo de una franja horizontal. Si se observa algún patrón no lineal entonces la variable predictora debería ser transformada. Este plot no sirve para cuantificar la importancia de xj en el modelo. Edgar Acuña Plot de residuales versus las predictora HP de Millaje. Analisis de Regresion 21 Plots de regresión parciales (plot de variable añadida) ) ) eY / X − j versus e x j / X − j Se plotea los residuales de la regresión de y considerando todas las variables predictoras excepto xj versus los residuales de la regresión de xj contra todas las variables predictoras distintas a ella. Edgar Acuña Analisis de Regresion 22 Plots de regresión parciales (plot de variable añadida) Plot de regresión parcial considerando la variable HP asumiendo que el modelo solo contiene a VOL. La variable VOL puede entrar al modelo en forma lineal Edgar Acuña Analisis de Regresion 23 Plot de residuales parciales o de residuales más componente ) eY / x , X + x jβversus x j j −j j Es más efectivo para detectar nolinealidad que el plot de regresión parcial No es muy adecuado para detectar casos influenciales. Plot de residuales parciales aumentados ) ey / X 2 − j ,x j + x j β j + x 2j β jj versus xj Este plot fue propuesto por Mallows (1986) y es el más adecuado para cotejar si la variable xj debe entrar en forma cuadrática al modelo. Edgar Acuña Analisis de Regresion 24 3.4 Plot de residuales para detectar Normalidad • La suposición de la normalidad de los errores es bién importante para el proceso de hacer inferencia en regresión lineal múltiple. • Puede ser cotejado haciendo un plot de normalidad para los errores estudentizados internamente. • El plot de normalidad consiste en un plot de los scores normales (estadísticos de orden normales) versus los residuales estandarizados ordenados. Edgar Acuña Analisis de Regresion 25 Score Normal • El i-ésimo score normal es aproximado en forma bastante precisa por: z (i ) = Φ −1 i − 3/8 ) ( n + 1/ 4 • donde Φ representa la función de distribución acumulada de una normal estándar y n (n>5) es el número de observaciones en la muestra. Edgar Acuña Analisis de Regresion 26 Plot de normalidad acompañado de pruebas noparamétricas para detectar normalidad. 1 0 -2 -1 Sam pleQuantiles 2 3 Normal Q-Q Plot -2 -1 0 1 2 Theoretical Quantiles El “p-value” de la prueba de Kolmogrov-Smirnov es mayor que 0.05 por lo tanto se acepta la hipótesis de que hay normalidad de los residuales. Edgar Acuña Analisis de Regresion 27 3.5 Detectando varianza no constante La suposición de que en el modelo de regresión lineal múltiple, los errores tienen varianza constante es importante para que los estimadores mínimos cuadráticos sean óptimos. • La varianza no constante viene acompañado del hecho que no hay normalidad. • Para detectar si la varianza es constante o no se hace un plot de residuales estudentizados versus los valores ajustados ŷi‘s. Edgar Acuña Analisis de Regresion 28 La varianza de los errores no es constante Este plot muestra que la varianza de los errores no es constante y que varia En forma proporcional a la media de la variable de respuesta Este plot es típico cuando los errores siguen una distribución Poisson o log-normal. Edgar Acuña Analisis de Regresion 29 Remedios cuando la varianza poblacional σ2 no es constante • Usar mínimos cuadrados ponderados donde los pesos que se usan son hallados en base a los datos tomados. • Transformar la variable de respuesta Y usando tranfomación que estabiliza la varianza Edgar Acuña Analisis de Regresion 30 3.6 Errores correlacionados en Regresión • Una de las suposiciones que se hace en regresión lineal es que los errores no se correlacionan entre si • Cov( ei , e j )=E( ei e j)=0 para i ≠ j . Edgar Acuña Analisis de Regresion 31 Autocorrelación • Cuando la variable predictora es tiempo, pudiera ocurrir que E (ei , ei +k ) ≠ 0 para un cierto k en este caso se dice que los errores tiene una correlación serial y estan autocorrelacionados . • Gráficamente, cuando los residuales cambian frecuentemente de signo hay autocorrelación negativa y si hay un conglomerado de residuales de un mismo signo antes de cambiar a otro entonces la autocrrelación es positiva. Edgar Acuña Analisis de Regresion 32 Gráfica de las 3 series de tiempo • En los dos primeros plots la autocorrelación es negativa y en la última es positiva Edgar Acuña Analisis de Regresion 33 Plot de los residuales en el tiempo t versus los residuales en el tiempo t-1. Edgar Acuña Analisis de Regresion 34 La prueba de Durbin-Watson • Se usa para detectar si hay una positiva correlación serial de orden uno. • Ho: ρ = 0 vs Ha: ρ > 0. n 2 ( − ) e e t t −1 • La prueba está dada porD = ∑ t =2 n 2 e ∑t t =1 • Se rechaza Ho si D<DL • Se acepta Ho si D>DU • La prueba no lleva a ninguna conclusión si DL<D<DU. Los valores límites DL y DU son leidos de tabla de Edgar Acuña Analisis de Regresion 35 Durbin-Watson. Prueba de dos lados Se tienen las hipótesis: Ho: ρ = 0, versus Ha:ρ ≠ 0 entonces • Se rechaza Ho: si D<DL ó 4-D<DL, al nivel de significación de 2α. • No se rechaza Ho: si D>DU y 4-D>DU • Para cualquier otro valor de D la prueba no llega a ninguna conclusión. Edgar Acuña Analisis de Regresion 36