BIT Y BYTE - WordPress.com

Anuncio

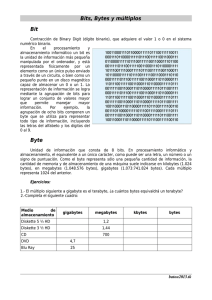

BIT Y BYTE Definición de Byte Un byte es la unidad fundamental de datos en los ordenadores personales, un byte son ocho bits contiguos. El byte es también la unidad de medida básica para memoria, almacenando el equivalente a un carácter. La arquitectura de ordenadores se basa sobre todo en números binarios, así que los bytes se cuentan en potencias de dos (que es por lo que alguna gente prefiere llamar los grupos de ocho bits octetos). Los términos Kilo (en Kilobyte, abreviado como K) y mega (en Megabyte, abreviado como M) se utilizan para contar bytes (aunque son engañosos, puesto que derivan de una base decimal de 10 números). Byte proviene de bite (en inglés "mordisco"), como la cantidad más pequeña de datos que un ordenador podía "morder" a la vez. El cambio de letra no solo redujo la posibilidad de confundirlo con bit, sino que también era consistente con la afición de los primeros científicos en computación en crear palabras y cambiar letras. Sin embargo, en los años 1960, en el Departamento de Educación de IBM del Reino Unido se enseñaba que un bit era un Binary digIT y un byte era un BinarY TuplE. Un byte también se conocía como "un byte de 8 bits", reforzando la noción de que era una tupla de n bits y que se permitían otros tamaños. Es una secuencia contigua de bits en un flujo de datos serie, como en comunicaciones por módem o satélite, o desde un cabezal de disco duro, que es la unidad de datos más pequeña con significado. Estos bytes pueden incluir bits de inicio, parada o paridad y podrían variar de 7 a 12 bits para contener un código ASCII de 7 bits sencillo. Es un tipo de datos o un sinónimo en ciertos lenguajes de programación. C, por ejemplo, define byte como "unidad de datos de almacenamiento direccionadle lo suficientemente grande para albergar cualquier miembro del juego de caracteres básico del entorno de ejecución" (cláusula 3.6 del C estándar). En C el tipo de datos unsigned char tiene que al menos ser capaz de representar 256 valores distintos (cláusula 5.2.4.2.1). La primitiva de Java byte está siempre definida con 8 bits siendo un tipo de datos con signo, tomando valores entre – 128 y 127. Historia Werner Buchholz Artículo principal: Werner Buchholz El término byte fue acuñado por Werner Buchholz en 1957 durante las primeras fases de diseño del IBM 7030 Stretch. Originalmente fue definido en instrucciones de 4 bits, permitiendo desde uno hasta dieciséis bits en un byte (el diseño de producción redujo este hasta campos de 3 bits, permitiendo desde uno a ocho bits en un byte). Los equipos típicos de E/S de este periodo utilizaban unidades de seis bits, pero tras la necesidad de agregar letras minúsculas, así como una mayor cantidad de símbolos y signos de puntuación, se tuvieron que idear otros modelos con mayor cantidad de bits. Un tamaño fijo de byte de 8 bits se adoptó posteriormente y se promulgó como un estándar por el IBM S/360. DEFINICION DE BIT Es el acrónimo Binary digit (‘dígito binario’). Un bit es un dígito del sistema de numeración binario. Las unidades de almacenamiento tienen por símbolo bit.1 Mientras que en el sistema de numeración decimal se usan diez dígitos, en el binario se usan solo dos dígitos, el 0 y el 1. Un bit o dígito binario puede representar uno de esos dos valores: 0 o APAGADO O ENCENDIDO El bit es la unidad mínima de información empleada en informática, en cualquier dispositivo digital, o en la teoría de la información. Con él, podemos representar dos valores cuales quiera, como verdadero o falso, abierto o cerrado, blanco o negro, norte o sur, masculino o femenino, rojo o azul, etc. Basta con asignar uno de esos valores al estado de "apagado" (0), y el otro al estado de "encendido" (1).