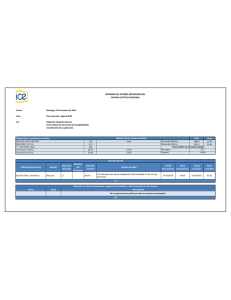

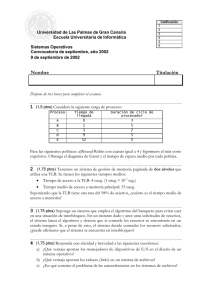

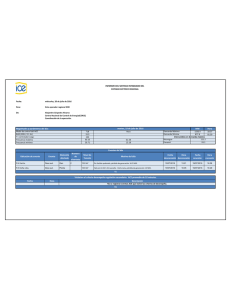

Documento

Anuncio