Regresión Lineal Simple

Anuncio

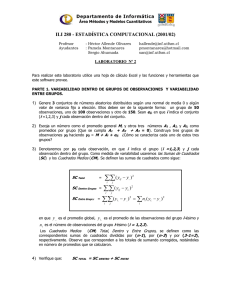

REGRESION LINEAL SIMPLE Jorge Galbiati Riesco Se dispone de una mustra de observaciones formadas por pares de variables: (x1, y1) (x2, y2) .. (xn, yn) A través de esta muestra, se desea estudiar la relación existente entre las dos variables X e Y. Es posible representar estas observaciones mediante un gráfico de dispersión, como el siguiente También se puede expresar el grado de asociación mediante algunos indicadores, que se verán a continuación. MEDIDAS DE ASOCIACION DE VARIABLES Covarianza entre las variables X e Y. Es una medida de la variación conjunta. Se define como cov( X , Y ) = 1 1 ( xi − x)( yi − y ) = S xy ∑ n n 1 Puede tomar valores positivos o negativos. Positivo, significa que ambas variables tienden a variar de la misma forma, hay una asociación positiva. Negativo, significa que si una aumenta, la otra tiende a disminuir, y vice versa. Covarianza cercana a cero indica que no hay asociación entre las variables. Ejemplo 1 DATOS DEL CLUB DE SALUD Datos correspondientes a 20 empleados del club de salud de una empresa X Y pulsasiones or minuto en reposo tiempo en correr 1 milla ( reg) Fuente: S. Chatterjee - A. Hadi: " Sentivity Analysis in Linear Regression" obs 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 Promedios: X 67 52 56 66 65 80 77 65 68 66 70 59 58 52 64 72 57 59 70 63 64,3 Y 481 292 357 396 345 469 425 393 346 401 267 368 295 391 487 481 374 367 469 252 382,8 2 Calcularemos de la covarianza entre estas dos variables. Covarianza Valores centrados y productos: obs X-64,3 1 2,7 2 -12,3 3 -8,3 4 1,7 5 0,7 6 15,7 7 12,7 8 0,7 9 3,7 10 1,7 11 5,7 12 -5,3 13 -6,3 14 -12,3 15 -0,3 16 7,7 17 -7,3 18 -5,3 19 5,7 20 -1,3 Promedio : La covarianza entre las variables X e Y es igual a Y-382,8 98,2 -90,8 -25,8 13,2 -37,8 86,2 42,2 10,2 -36,8 18,2 -115,8 -14,8 -87,8 8,2 104,2 98,2 -8,8 -15,8 86,2 -130,8 prod 265,14 1116,84 214,14 22,44 -26,46 1353,34 535,94 7,14 -136,16 30,94 -660,06 78,44 553,14 -100,86 -31,26 756,14 64,24 83,74 491,34 170,04 239,41 239,41 Coeficiente de correlación lineal. La covariaza tiene el inconveniente de que su valor no es acotado, por lo que, a partir de él es dificil juzgar si es grande o pequeña. Se define la correlación, que es una medida de asociación lineal independiente de las unidades de medida. Es igual a la covarianza dividida por las desviaciones standard: corr ( X , Y ) = cov( X , Y ) = dsX * dsY ∑ ( x − x)( y − y) ∑ ( x − x) ∑ ( y − y ) i i 2 i 3 i 2 = S xy S xx S yy El valor de la correlación entre cualquier par de variables es un número entre -1 y 1. n valor alto de correlación no indica que existe alguna relación de causa-efecto entre las variables. Ejemplo (continuación) Coeficiente de Correlación Se deben calcular las desviaciones standard. Para ello se deben elevar al cuadrado las observaciones centradas y promediar, obteniéndose las varianzas. Las desviaciones standard son las raíces cuadradas de éstas. obs 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 Promedios : (varianzas) cuadrados de X-64,3 Y-382,8 7,3 9643,2 151,3 8244,6 68,9 665,6 2,9 174,2 0,5 1428,8 246,5 7430,4 161,3 1780,8 0,5 104,0 13,7 1354,2 2,9 331,2 32,5 13409,6 28,1 219,0 39,7 7708,8 151,3 67,2 0,1 10857,6 59,3 9643,2 53,3 77,4 28,1 249,6 32,5 7430,4 1,7 17108,6 54,11 4896,46 Las desviaciones standard son dsX = 7,36 ds Y = 69,97 Para obtener las correlaciones se debe dividir la covarianza por las desviaciones standard: corr(X,Y) = 239.41 / * 69.97 ) = ( 7.36 0,465 4 El siguiente es un gráfico de dispersión que muestra estos datos. Tiempo en recorrer 1 milla Club de Salud 600 500 400 300 200 100 0 0 20 40 60 80 100 Pulsaciones por minuto La interpretación del coeficiente de correlación puede ilustrarse mediante los siguientes gráficos. 5 REGRESION LINEAL SIMPLE Ahora asumiremos que si hay una relación de causalidad de la variable X (causa) hacia la variable Y (efecto). Además, se sabe que esa relación es de tipo lineal, dentro del rango de los datos. Estableceremos un modelo para explicar la cai¡usa (Y) en términos del efecto (X), del tipo siguiente: Yi = a + bX i + ei para i = 1,2,..., n en que a y b son dos cantidades fijas (parámetros del modelo) y los ei son cantidades aleatorias que representan las diferencias entre lo que postula el modelo a + bx y lo que realmente se observa, y. Por esa razón a los e los llamaremos "errores" o "errores aleatorios". Se asume que tienen valor esperado 0 y desviación standard común σ . Ejemplo 2 Venta de automóviles Se piensa que si aumentan el porcentaje de comisión pagada al vendedor de automóviles, aumenta la venta. Estudio sobre 15 concesionarios similares X Comisiones pagadas a vendedores de autos en un mes (%) Y Ganancias netas por ventas, en el mismo mes (Millones de $) obs 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 X 3.6 5.2 5.3 7.3 5.0 5.2 3.0 3.1 3.2 7.5 8.3 6.1 4.9 5.8 7.1 Y 11.28 14.74 18.46 20.01 12.43 15.37 9.59 11.26 8.05 27.91 24.62 18.80 13.87 12.11 23.68 6 Representación de los datos en un gráfico de dispersión: Ganancias netas versus com isiones Ganancias (MM$) 30.00 25.00 20.00 15.00 10.00 5.00 0.00 0.0 2.0 4.0 6.0 8.0 10.0 com isión (%) Se puede apreciar la relación lineal existente entre ambas variables observadas. Nuestro problema es estimar los parámetros a, b y σ 2 para poder identificar el modelo. Para estimar a y b se utiliza el método de Mínimos cuadrados, que consiste en encontrar aquellos valores de a y de b que hagan mínima la suma de los cuadrados de las desviaciones de las observaciones respecto de la recta que representa el modelo, en el sentido vertical. 7 En la figura, son los cuadrados de los segmentos verticales cuya suma de cuadrados se debe minimizar, para determinar a y b. Estos segmentos representan los errores e del modelo. b se llama pendiente de la recta que representa los datos y a se llama intercepto sobre el eje vertical. La solución está dada por las siguientes fórmulas: b= ∑ ( x − x)( y − y) = S S ∑ ( x − x) i i xy 2 i xx a = y − bx Ejemplo 2 (continuación) Calculamos los promedios de ambas variables y se las restamos a los valores. Promedio de la X : Promedio de la Y : 5.4 16.1 8 Desviaciones respecto de las medias, sus cuadrados y productos: obs 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 sumas X-5.4 -1.8 -0.2 -0.1 1.9 -0.4 -0.2 -2.4 -2.3 -2.2 2.1 2.9 0.7 -0.5 0.4 1.7 0.0 Y-16.1 -4.9 -1.4 2.3 3.9 -3.7 -0.8 -6.6 -4.9 -8.1 11.8 8.5 2.7 -2.3 -4.0 7.5 0.0 cuadrados 3.1 23.7 0.0 2.0 0.0 5.3 3.7 14.9 0.1 13.8 0.0 0.6 5.6 42.9 5.2 23.8 4.7 65.6 4.5 138.5 8.6 71.8 0.5 7.0 0.2 5.2 0.2 16.3 3.0 56.8 39.6 488.3 Sxx Syy Entonces utilizando las fórmulas de arriba, b= 3.18 a= prod. 8.6 0.2 -0.2 7.4 1.4 0.1 15.6 11.1 17.6 25.0 24.8 1.9 1.1 -1.7 13.0 126.1 Sxy -0.96 El modelo, para estos datos, es Yi = −0.96 + 3,18 X i + ei para i=1,2,.. 15 Representa una recta, cuyo intercepto con el eje vertical es -0.96, y su pendiente es 3.18, o sea, si el porcentaje de comisión X aumenta en 1%, la ganancia neta Y aumenta en 3.18 Millones de pesos. Ganancias netas versus com isiones 30.00 Ganancias (MM$) 25.00 20.00 15.00 10.00 5.00 0.00 -5.00 0.0 2.0 4.0 6.0 com isión (%) 9 8.0 10.0 Valores ajustados al modelo. El modelo de regresión lineal se puede utilizar para obtener valores de Y ajustados al modelo, Los valores puntuales se obtienen mediante la fórmula Yi = a + bX i en que a y b son los valores estimados por el procedimiento indicado anteriormente, y Xi toma los valores de la muestra. Los puntos que representan estos valores en el gráfico de dispersión, yacen sobre la recta. Ejempol 2 (continuación) La tabla siguiente contiene los valores de Y ajustados , para cada valor de X, además de los valores de Y observados, a modo de comparación. Los ajustados se obtienen por la fórmula Yi = −0.96 + 3.18 X i obs 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 promedio X 3.6 5.2 5.3 7.3 5.0 5.2 3.0 3.1 3.2 7.5 8.3 6.1 4.9 5.8 7.1 5.4 Y 11.28 14.74 18.46 20.01 12.43 15.37 9.59 11.26 8.05 27.91 24.62 18.80 13.87 12.11 23.68 16.1 10 Yajust. 10.50 15.59 15.91 22.28 14.96 15.59 8.59 8.91 9.23 22.92 25.46 18.46 14.64 17.50 21.64 16.1 dif 0.78 -0.85 2.54 -2.27 -2.52 -0.23 1.00 2.36 -1.18 5.00 -0.84 0.34 -0.77 -5.40 2.04 0.00 Se puede observar que el promedio de los valores ajustados es igual al promedio de los valores observados, y que el promedio de las diferencias es cero. La raíz cuadrada del promedio de los cuadrados de las diferencias entre los valores observados y ajustados, es una estimación de la varianza del error, σ . En el ejemplo, la suma de las diferencias al cuadrado es 19.8, luego la estimación de la desviación standard del error es igual a σ = 1 19.8 = 1.32 = 1.15 15 Millones de pesos Coeficiente de determinación Es una medida de bondad de ajuste del modelos de regresión lineal a los datos. Es deseable que los valores de Y ajustados al modelo, sean lo más parecidos posible a los valores observados. Una medida de lo parecido que son, es el coeficiente de correlación. Se define el coeficiente de determinación, R2, como el cuadrado del coeficiente de correlación entre los valores de Y observados y los valores de Y ajustados. Sin embargo se puede demostrar que es igual a la siguiente expresión: R = 2 S xy2 S xx S yy [∑ ( x − x)( y − y)] = [∑ ( x − x) ][∑ ( y − y) ] 2 i i 2 i 11 2 i El rango de R2 es entre 0, cero ajuste, hasta 1, ajuste perfecto (cuando los puntos aparecen en un línea recta). Ejemplo 2 (continuación) Más arriba se calcularos las sumas de cuadrados y de productos, y dieron los siguientes valores: Sxx = 39.6 , Syy = 488.3 , Sxy = 126.1 Entonces el coeficiente de determinación es R2 = (126.1) 2 = 0.82 39.6 * 488.3 que señala que el ajuste del modelo a los datos es bueno. Ejemplo 3 Los datos siguientes corresponde al Indice de Producción Física de la Industria Manufacturera, por agrupación, de los meses de mayo de 2002 y mayo de 2003, entregado por el Instituto Nacional de Estadísticas. Es un índice cuya base 100 es el promedio de producción de cada agrupación, en el año 1989. 12 Agrupaciones Fabricac. de productos alimenticios Industrias de bebidas Industria del tabaco Fabricac. de textiles Fabricac. prendas de vestir, excepto calzado Industria del cuero; produc. de cuero y sucedáneos Fabricac. de calzado, exc. de caucho o plástico Industria de madera y sus productos exc. muebles Fabricac. de muebles y accesorios, exc. metálicos Fabricac. de papel y productos de papel Imprentas, editoriales e industrias conexas Fabricac. de sustancias químicas industriales Fabricac. de otros productos químicos Refinerías de petróleo Fabricac. prod. derivados de petróleo y carbón Fabricac. de productos de caucho Fabricac. de productos plásticos Fabricac. de objetos de loza y porcelana Fabricac. de vidrio y productos de vidrio Fabricac. otros productos minerales no metálicos Industrias básicas de hierro y acero Industrias básicas de metales no ferrosos Fabricac. prod. metálicos exc. maquinaria y equipo Construcción de maquinaria, exc. la eléctrica Construcción máq., aparatos y acces. eléctricos Construcción de material de transporte Fabricac. equipo profesional y artículos oftálmicos Otras industrias manufactureras Mayo 02 140.2 134.6 151.1 70.9 34.7 59.3 52.6 132.3 114.0 189.5 107.5 229.4 212.4 136.0 143.2 141.4 305.8 68.2 268.6 185.6 123.1 119.8 153.6 282.5 87.0 103.4 67.7 66.0 El gráfico de dispersión es el siguiente: Prod. Física Industria Manufacturera Indice mayo 2003 600 400 200 0 0 100 200 Indice m ayo 2002 13 300 400 Mayo 03 133.5 133.7 140.5 70.3 30.5 56.7 45.3 141.6 132.4 205.3 108.0 231.4 209.6 165.2 156.2 177.4 399.7 61.1 266.4 186.5 167.1 108.7 153.5 289.7 83.0 73.4 64.1 67.5 Cálculos parciales, en que X es el índice mayo 2002, Y el índice mayo 2003: n = 28 x = 136.6 y = 144.9 S xx = ∑ ( xi − x) 2 = 134,913.6 S yy = ∑ ( yi − y ) 2 = 187,813.7 S xy = ∑ ( xi − x)( yi − y ) = 154,350.8 Estimación de los parámetros del modelo: b= S xy S xx = 154,350.8 = 1.14 134,913.6 a = y − b x = −13.61 Bondad de ajuste: R = 2 S xy2 S xx S yy = (154,350.8) 2 = 0.940 (134,913.6) * (187,350.8) que indica un muy buen ajuste. El siguiente gráfico muestra de recta de regresión estimada: Prod. Física Industria Manufacturera Indice mayo 2003 600 400 200 0 0 100 200 -200 Indice m ayo 2002 14 300 400 Predicción por bandas de confianza. Se pueden hacer predicciones de valores Y para valores X que no están en el conjunto de observaciones, dentro o fuera de su rango, utilizando la fórmula de la regresión lineal, con los parámetros a y b estimados. Tambien se pueden hacer predicciones por intervalos de confianza verticales, que tienen la ventaja de proporcionar una cuantificación del error de predicción. Los intervalos tienen la propiedad de ser de diferente ancho, según el valor de X, siendo más angostos cuando X es igual al promedio, ensanchándose a medida que nos alejamos del promedio. Cuando se sale del rango de los datos, se ensanchan más fuertemente. Esto significa que mientras más nos alejamos del centro de los valores de la variable X, más imprecisas serán nuestras estimaciones del valor de la variable Y, lo que parece razonable. Si unimos los extremos superiores (o los inferiores) de todos los intervalos de confianza, se obtienen dos curvas con forma de hipérbola, como se muestra en la figura: 15 El gráfico siguiente muestra las bandas de confianza de coeficeinte 95%, para el ejemplo de la producción física manufacturera. Mientras mayor es el coeficiente de determinación R2, más angostas son las bandas de confianza; lo mismo mientras mayor es la desviación standard de las X, y lo mismo si el tamaño muestral aumenta. Y a medida que nos alejamos del promedio de las X, se ensanchan las bandas. 16