Segmentación y realce en señales de voz usando

Anuncio

Segmentación y Realce de Señales

de Voz Usando la Transformada

Wavelet y DSP’s

por Doubert Geovanny Sánchez Marín

Director:

Jorge Iván Marín Hurtado

Modalidad: Proyecto de Grado

ARMENIA

UNIVERSIDAD DEL QUINDIO

FACULTAD DE INGENIERIA

PROGRAMA DE INGENIERIA ELECTRONICA

2004

Índice General

Agradecimientos

iii

1 Introducción

1

2 Características Acústicas

3

2.1 Realización Fonética ………………………………………………… 3

2.2 Clasificación de los Fonemas ………………………………………. 4

2.2.1 Fonemas Consonánticos ………………………………… 4

2.2.2 Fonemas Vocálicos ………………………………………. 6

2.3 Características del Oído ……………………………………………. 7

2.3.1 El Oído como Analizador de Frecuencias ………………… 8

2.4 Audiometría …………………………………………………………. 9

2.4.1 Componentes de un audífono ………………………………11

3 Transformada Wavelet

13

3.1 Introducción ………………………………………………………… 13

3.2 Repaso a la Transformada de Fourier ………………………………. 14

3.3 ¿Qué Son Las Wavelet? ……………………………………………. 15

3.4 Transformadas Wavelet …………………………………………….. 16

3.4.1 Transformada Wavelet Continua (CWT) ………………… 18

3.4.2 La Transformada Wavelet Discreta (DWT) ……………… 20

3.4.2.1 Transformada Wavelet Rápida (FWT) …………. 23

3.4.2.2 Algoritmo de la Transformada Wavelet Rápida …25

4 Sistema de Segmentación

4.1

Implementación del Sistema de Segmentación de Fonemas

en MATLAB ……………………………………………………

4.1.1 Adquisición de la Señal de Voz ………………………....

4.1.2 Preprocesamiento ………………………………………..

4.1.3 Extracción de Características …………………………...

4.1.3.1 Trasformada Wavelet …………………………….

4.1.3.2 Selección de la Wavelet Madre ………………….

4.1.3.3 Wavelet Denoising ………………………………

4.1.3.4 Normalización …………………………………...

4.1.3.5 Energías Sub-bandas …………………………….

2

26

27

30

31

32

32

34

35

35

36

4.1.4 Reglas de Selección …………………………………….. 37

4.1.5 Realce de la Señal ……………………………………… 44

4.1.6 Transformada Wavelet Inversa ………………………… 44

5 Implementación en el DSP

46

5.1 Captura y Pre-procesamiento de la Señal …………………………… 48

5.2 Conversión de Datos ………………………………………………... 49

5.3 Función Procesar Segmento ………………………………………… 49

5.4 Pruebas de Desempeño ……………………………………………… 52

6 Conclusiones

54

7 Proyecciones

55

Bibliografía

56

A Código fuente para MATLAB

58

A.1 Código fuente del programa principal …………………………………….. 58

B Código fuente para el DSP TMS320C6701

61

B.1 Código fuente del programa principal ……………………………………… 61

B.2 Código fuente función que procesa el segmento …………………………… 62

B.2.1 Archivo de cabecera segmentación.h …………………………….. 62

B.2.2 Archivo fuente segmentación.c …………………………………… 63

3

Índice de Figuras

1.1 Sistema de Segmentación ……………………………………………………. 1

2.1a Esquema del Aparato Fonador Humano ......………………………………. 4

2.1b Esquema aproximado de la producción de la voz ………………………… 4

2.2 El Oído Humano …………………………………………………………… 7

2.3 Membrana basilar "estirada" ……………………………………………….. 8

2.4 Banco de filtros de escalas de Mel ………………………………………….. 9

2.5 Audiograma ………………………………………………………………….. 10

2.6 Audífono Intracanal ………………………………………………………… 11

3.1 Desplazamiento de ventana para la STFT …………………………………. 15

3.2 Inconvenientes de la STFT …………………………………………………. 15

3.3 Izquierda wavelet a diferentes escalas, derecha traslación de wavelet ……. 16

3.4 Graficas de algunas wavelet madre. ………………………………………... 18

3.5 Variable escala ……………………………………………………………… 20

3.6 Proceso de análisis en diferente escala y traslación

(a) escala fija a 1 y traslación variante ………………………………….. 21

(b) escala fija a 20 y traslación variante …………………………………. 21

3.7 Planos de Tiempo-Frecuencia analizado con la TW ……………………….. 22

3.8 Planos Tiempo-Frecuencia para (a) STFT (b) TW …………………………. 22

3.9 Transformada Wavelet Rápida (FWT) o Algoritmo de Mallat …………….. 24

3.10 Diagrama de bloques de la descomposición multiresolución de una señal

por medio de la transformada wavelet.

(a) Banco de análisis …………………………………………………….. 24

(b) síntesis ………………………………………………………………. 24

3.11 Respuesta en frecuencia del banco de filtros Wavelet …………………… 25

4.1 Sistema de Segmentación de Señales Propuesto en el Proyecto 195 ……….

4.2 Estructura del Sistema de Segmentación …………………………………..

4.3 Esquema en memoria del vector de muestras a filtrar ……………………..

4.4 Diagrama de flujo de la simulación en MATLAB …………………………

4.5. Análisis por bloque del filtro pre-énfasis …………………………………

4.6 Bloque de Extracción de Características …………………………………..

4.7 Análisis de Descomposición por nivel en Matlab …………………………

4.8 Descomposición de un Bloque X = 512 datos de la señal en

niveles de detalle y uno de aproximación ……………………………….

4.9 Bloque de normalización ……………………………………………………

4.10 Palabra “mata” etiquetada …………………………………………………

4.11 Detección de segmentos de silencio en la palabra ‘mata’ …………………

4

27

27

28

29

32

32

33

33

36

38

39

4.12 Esquema de la Transformada Wavelet Inversa, para recuperar un

bloque de 512 datos ……………………………………………………... 45

4.13 Señal de la palabra “mata” recuperada ……………………………………... 45

5.1 Técnica de doble buffer usando DMA para captura de un bloque de 64ms

con su respectivo análisis y reproducción ………………………………. 47

5.2 Diagrama de flujo del programa principal y la ISR ………………………….48

5.3 Esquema en memoria del vector de muestras a filtrar ………………………. 50

5

Índice de Tablas

2.1 Clasificación de las consonantes de acuerdo a su articulación …………….. 6

2.2 Clasificación de los fonemas vocálicos ……………………………………. 6

4.1 Ejemplos de algunas muestras de voz previamente capturadas ……………. 31

4.2 Número de coeficientes entregados por cada nivel de la wavelet con los

coeficientes que se analizan y los que sirven de condiciones iniciales

para los siguientes bloques ……………………………………………… 34

4.3 Rango de frecuencias ……………………………………………………….. 34

4.4 Umbral de ruido para cada nivel ……………………………………………. 35

4.5 Número de Coeficientes de cada nivel en un bloque de 512 muestras de la

señal para el Cálculo de las Energías …………………………………… 36

4.6 Etiquetado Manual de la palabra “mata” …………………………………… 37

4.7 Cambio de energía entre segmentos por banda …………………………….. 38

5.1 Tiempos promedio de ejecución de las funciones dentro de la rutina

del servicio de interrupción …………………………………………….. 52

5.2 Tiempos promedio de ejecución de conversión de los datos ……………….. 53

5.3 Tiempo total de la ISR ……………………………………………………… 53

6

Capitulo 1

Introducción

Este trabajo plantea una aplicación al sistema de segmentación propuesto por el grupo

GDSPROC de la Universidad del Quindío. El objetivo fundamental es diseñar un sistema

automático de realce de voz por medio de la segmentación de señales utilizando la

Transformada Wavelet. El proceso de segmentación juega un papel muy importante en

aplicaciones que corresponden a la construcción de sistemas de reconocimiento continuo de

voz y al realce de las señales de voz, en audífonos para personas con deficiencias auditivas,

en donde está enfocado nuestro trabajo. Partiendo de las investigaciones realizadas por el

Grupo de Procesamiento Digital de Señales GDSPROC en el proyecto 195, apéndice D

[Hur03], en el cual plantean el sistema de segmentación de señales mostrado en la figura

1.1, proponemos una aplicación que realza los segmentos de la señal identificados, con el

fin de ser utilizados en sistemas de apoyo a personas con deficiencias auditivas.

El proyecto consiste en segmentar una señal de voz independiente del hablante y de las

condiciones de captura, con el fin de identificar segmentos de fonemas sonoros, sordos y de

silencio por medio de la Transformada Wavelet, la cual descompone la señal en diferentes

bandas de frecuencia, se analizan en sub-bloques de 4ms, la evolución de la energía en cada

banda y se establecen reglas de selección para identificar los segmentos. Una vez

identificados estos segmentos se efectúa en ellos un realce en las diferentes bandas de

frecuencia por medio de un factor de escala que dependerá del tipo de segmento

identificado y/o la banda a realzar, finalmente se recupera la señal con las características

antes mencionadas y libre de ruido, por medio de la transformada wavelet inversa.

Figura 1.1 Sistema de Segmentación

7

Para la implementación del proyecto en tiempo real se empleó un DSP TMS320C6701 de

la Texas Instrument [Tex00]. Finalmente contaremos con el criterio de una persona con

limitaciones auditivas en cuanto al funcionamiento del sistema y las posibles mejoras para

el futuro.

El planteamiento del trabajo es el siguiente:

Capítulo 2 (Características Acústicas): Analizaremos una visión global de cómo se

producen los sonidos, como están clasificados los fonemas y cuales son las características

del oído.

Capítulo 3 (Transformada Wavelet): Presentaremos la teoría necesaria para comprender

las ventajas de la Transformada Wavelet con respecto a la Transformada de Fourier en el

análisis de señales.

Capítulo 4 (Sistema de Segmentación): Se hará una descripción del sistema de

segmentación, así como su implementación en Matlab y los resultados obtenidos en la

simulación con señales previamente capturadas.

Capítulo 5 (Implementación en el DSP): En este capítulo explicaremos las rutinas

utilizadas en C++ para la implementación en tiempo real del sistema, el costo

computacional del software y el criterio de un paciente con limitaciones auditivas.

Capitulo 6 (Conclusiones): Desarrollamos las conclusiones fundamentales del trabajo

presentado.

Capítulo 7 (Proyecciones): Plantearemos los posibles trabajos futuros que se puedan

derivar de este proyecto o que sirvan de complemento para otros trabajos.

Apéndice A (Código Fuente para Matlab): Presentaremos todo el código fuente en

Matlab para la simulación del sistema expuesto en el capítulo 4.

Apéndice B (Código Fuente del Sistema en Tiempo Real): Expondremos el código en C

desarrollado para la implementación del sistema en tiempo real en un DSP TMS320C6701.

8

Capítulo 2

Características Acústicas

Un fonema es una unidad del habla y un conjunto de fonemas determina los sonidos con los

cuales se pueden construir palabras en un lenguaje determinado. Por otro lado, un alófono

es una de las diferentes pronunciaciones para un fonema en particular. El fonema es una

abstracción y realmente no puede ser pronunciado excepto en términos de uno de sus

alófonos [Dal69]. Tomando en cuenta lo anterior se puede decir que en cualquier lenguaje

el número de fonemas es obviamente más pequeño que el número de fonos o alófonos.

Tenemos la idea ortográfica de que es muy fácil separar la palabra “mesa” en cuatro

sonidos: /m/e/s/a/, pero físicamente es un continuo de principio a final. Como

Consecuencia, en la vocal /e/ hay elementos de la /m/ y de la /s/. Además, para poder hablar

de prisa no llegamos a efectuar los movimientos completos, y los dejamos a medias. Por

esas y otras razones, el reconocimiento automático de fonemas no es tan fácil como uno

quisiera.

2.1 Realización Fonética

Los sonidos se producen cuando el aire espirado por los pulmones llega hasta la laringe,

donde se encuentran las cuerdas vocales. Estas cuerdas vocales son dos músculos gemelos,

elásticos, que vibran cuando el aire espirado pasa por ellas. Es entonces cuando se produce

el sonido que llamamos voz (figura 2.1a). La voz pasa a la cavidad bucal o la cavidad nasal,

donde los órganos, principalmente los de la boca, configuran y matizan los diversos sonidos

en el habla [Cas99].

Los fonemas se realizan por medio de sonidos. Los encargados de producir esos sonidos, de

realizarlos fonéticamente son los órganos de fonación.

La señal de voz se limita a una banda de frecuencias que va desde 300 Hz hasta 3300 Hz. A

pesar de esto, tal señal no está compuesta únicamente por tonos puros en esa gama de

frecuencias, ya que adicionalmente, la voz posee otro componente representado en un

proceso de ruido blanco gaussiano con una densidad espectral de potencia también ubicada

en la gama de 300 Hz a 3300 Hz. Los tonos puros, conocidos como “pitchs”, corresponden

a los fonemas sonoros (vocales); en cambio, la señal de ruido blanco, corresponde a los

fonemas sordos (consonantes), El tracto vocal es modelado como un sistema que modifica

la se˜nal (sonora o sorda) proveniente de la laringe, actuando generalmente como un filtro

del tipo todo polos (AR) [DJH00] [PM98]. Finalmente el modelo aproximado que

representa la producción de la señal de voz y el tracto vocal se muestra en la figura 2.1b.

9

2.2 Clasificación de los Fonemas

Los sonidos están divididos en dos grupos principales:

Consonantes: Si la corriente de aire es detenida u obstruida.

Vocales: Si el aire sale libremente.

Figura 2.1(a) Esquema del Aparato Fonador Humano

Figura 2.1b Esquema aproximado de la producción de la voz

2.2.1 Fonemas Consonánticos

Se producen sonidos consonánticos cuando el aire al salir encuentra un obstáculo, ya sea

cerrándole totalmente el paso, o dejándole una estrechez por donde pasa con fricción. Para

clasificar a las consonantes se tendrá en cuenta el concepto de articulación. Se entiende por

articulación de un sonido la posición adoptada por los órganos de la cavidad bucal en el

momento de producirse un sonido.

10

En la producción y clasificación de las consonantes hay que tener en cuenta los siguientes

factores:

1. Lugar de articulación.

2. Manera de articulación.

3. Articulaciones sonoras o sordas.

Lugar de Articulación

Para el idioma Español hay nueve lugares de articulación para las

consonantes:

1. Bilabial. El labio inferior contra o cerca del labio superior. Ejemplo: [m] en más.

2. Labiodental. El labio inferior contra o cerca del borde de los dientes frontales

superiores. Ejemplo: [f] en fuente.

3. Dental. Posición de la lengua contra el borde o atrás de los dientes superiores

frontales. Ejemplo: [d] en dar.

4. Alveolar. Posición de la lengua contra o cerca de la zona alveolar. Ejemplo: [l] en

luna.

5. Palatal. Posición de la lengua contra o cerca del paladar duro. Ejemplo: [c] en

chico.

6. Velar. Dorso de la lengua contra o cerca del velo. Ejemplo: [k] en calor.

7. Bilabio−velar. El labio inferior cerca del labio superior y al mismo tiempo el dorso

de la lengua cerca del velo. Ejemplo: [w] en hueso.

8. Uvular. Dorso de la lengua contra el uvula. Ejemplo: [rr] en carro.

9. Glotal. Movimiento de cuerdas vocales. Ejemplo: [h] en jardín.

Manera de Articulación

Independientemente de cual sea la zona o punto de articulación, los órganos adoptan una

postura o una posición al producir los fonemas. A esto se le llama modo de articulación. En

español hay seis maneras de articulación en las consonantes.

1. Oclusivas. En algún punto de la articulación del sonido la corriente de aire queda

detenida y después es liberada con una pequeña explosión. Ejemplo: [p] en pasar.

2. Fricativas. La corriente de aire, sin ser detenida, es forzada a través del tracto vocal

existiendo un cierre parcial, provocando que el aire salga con turbulencia.

3. Africativas (Oclusiva + Fricativa). La corriente de aire es detenida como en una

oclusiva; pero en lugar de ser liberada abruptamente, es liberada con fricción como

en un fricativo.

4. Nasales. El velo es bajado y la corriente de aire pasa a través de la cavidad nasal con

gran resonancia. Ejemplo: [m] en más.

5. Semivocales. La cavidad oral es cerrada a la mitad, pero la corriente de aire escapa

por ambos lados del lugar de articulación. [l] en luna.

6. Vibrantes. La posición de la lengua, bajo tensión, conecta el alveolar una vez que la

corriente de aire pasa a través del tracto vocal. Ejemplo: [r] en pero y [rr] en perro.

Articulaciones Sonoras o Sordas

Todo fonema, sea cual sea su punto o manera de articulación, puede producirse con

vibraciones de las cuerdas vocales o sin ellas.

11

•

•

Sonoros, si las cuerdas vocales se aproximan y comienzan a vibrar. Tendremos que

separar los sonidos vocálicos, de los consonánticos.

Sordos, si las cuerdas vocales se acercan entre si pero no llegan a vibrar.

Fonemas Sonoros

s, j, f, ch, p, t, k

Fonemas Sordos

b, d, g, m, n, ñ, l, r, rr, y

Tabla 2.1 Clasificación de las consonantes de acuerdo a su articulación

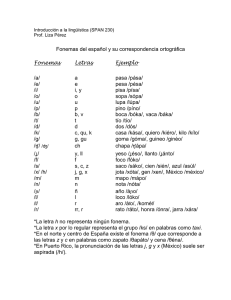

2.2.2 Fonemas Vocálicos

Con las vocales, la posición de la lengua y la forma en que se posiciona la boca determinan

su timbre. Debido a que el aire no es bloqueado o detenido, no hay contacto entre los

articuladores superiores e inferiores. En su lugar, la posición de la lengua es significante

debido a que cambia el tamaño y forma de la cavidad oral.

Acústicamente, cuando pronunciamos una vocal hay unas bandas de frecuencia que se

amplifican más según donde pongamos la lengua: una A, por ejemplo, se articula de forma

más estrecha en la zona de la faringe y más ancha en la zona de la boca, lo cual lleva a la

amplificación de un tramo de frecuencia que está alrededor de los 700Hz, y otro de los

1300Hz. Estos tramos se conocen como formantes.

Hay tres posiciones verticales de la lengua, las cuales determinan el grado de abertura de la

cavidad oral: Alto, cuando la lengua está cerca del paladar; medio, cuando la lengua se

encuentra a la mitad de la boca; y bajo. También hay tres posiciones de la lengua de frente

hacia atrás: Anterior, cuando la parte alta de la lengua está muy cerca del alveolar; central,

cuando la parte más alta de la lengua está en el centro de la cavidad oral; y posterior, donde

la parte más alta de la lengua, el dorso, está muy cerca del velo.

Por esto se puede clasificar a las vocales en un cuadro bidimensional. En español hay cinco

posiciones principales.

Alto

Medio

Bajo

Anterior

i

e

Central

Posterior

u

o

a

Tabla 2.2 Clasificación de los fonemas vocálicos

Las vocales son de mayor duración que las consonantes y están bien definidas

espectralmente. Por esto las vocales usualmente son fáciles de reconocer y contribuyen

significativamente al proceso de reconocimiento de voz. De acuerdo a la manera en que el

tracto vocal se configure se determinan las frecuencias de resonancia del tracto (las

formantes) y por ello el sonido se produce. Las vocales se identifican por sus formantes, las

cuales son muy fuertes durante todo el fonema.

12

El principal motivo para la clasificación de los fonemas de acuerdo a su manera y lugar de

articulación es para poder más adelante hacer experimentos en los cuales se agrupan los

fonemas para efectos de mejoras en el reconocimiento.

2.3 Características del Oído

La audición es el resultado de una serie de procesos acústicos, mecánicos, nerviosos y

mentales dentro de la combinación oído/cerebro que dan a una persona la impresión de

sonido [Ber69].

El oído consta de tres partes principales (figura 2.2):

·

·

·

El oído externo

El oído medio

El oído interno

Figura 2.2: El Oído Humano

El oído externo

Los sonidos del mundo exterior son recogidos por el oído externo, el cual está formado por

el pabellón auricular (la oreja) y el conducto auditivo externo. Cuando las ondas sonoras

penetran en el oído, el conducto auditivo externo incrementa la sonoridad de los tonos que

nos ayudan a comprender el habla. Al mismo tiempo el conducto auditivo externo (1)

protege otra parte importante del oído: el tímpano (2) – una membrana flexible, circular que

vibra cuando es alcanzada por las ondas sonoras.

El oído medio

Las vibraciones del sonido continúan su viaje hacia el oído medio, que contiene tres

pequeños huesos llamados yunque, martillo y estribo (3, 4, 5). Estos hacen de puente entre

el tímpano y el oído interno. Incrementan y amplifican las vibraciones del sonido aún mas,

antes de transmitirlas sin peligro hacia el oído interno vía la ventana oval.

13

El oído interno

El oído interno o cóclea, similar a la concha circular de un caracol, alberga un sistema de

tubos que están rellenos de un fluido acuoso. Cuando las ondas sonoras pasan a través de la

ventana oval (6), el fluido empieza a moverse, haciendo que unos pequeños cilios se

muevan a su vez. Posteriormente, estos cilios transforman las vibraciones en impulsos

eléctricos que viajan por el nervio auditivo (9) hasta el mismo cerebro. Aún se desconoce

cómo traduce el cerebro estos impulsos nerviosos.

2.3.1 El oído como analizador de frecuencias

Como se ve en la figura 2.3, la membrana basilar se estira por la cóclea. Esta membrana

varía en masa y rigidez a lo largo de su longitud. En el extremo más próximo a la ventana

oval y al tímpano, la membrana es rígida y ligera, así que su frecuencia de resonancia es

alta. En el extremo distante, próximo al ápice, la membrana es pesada y suave, y resuena a

baja frecuencia. El rango de frecuencias de resonancia disponible determina el rango de

frecuencias de la audición humana, que va desde los 20Hz hasta los 20KHz, sin embargo,

en la práctica sólo llega hasta los 16 KHz, siendo las frecuencias más audibles las ubicadas

en el medio del espectro, aproximadamente entre 1 KHz y 4 KHz..

Figura 2.3. Membrana basilar "estirada"

Frecuencias diferentes en la entrada de sonido causan que diferentes áreas de la membrana

basilar vibren. Cada área tiene diferentes terminaciones nerviosas para permitir discriminar

el tono. El comportamiento resonante de la membrana basilar es un paralelo exacto con el

comportamiento de un analizador de espectros; la parte de dicha membrana que resuena

como resultado de la aplicación de un sonido es una función de la frecuencia.

Según estudios realizados por Bark y Mel [MMO95], encontraron una relación no lineal

entre la frecuencia entrante al oído y la que éste realmente percibe. Tales estudios se

resumen en dos ecuaciones empíricas que relacionan estas dos frecuencias:

0.76 f

f2

f bark ( f ) = 13 arctan

+ 3.5 arctan

(2.1)

100

7500 2

14

1+ f

(2.2)

700

Donde esta última es la más usual en aplicaciones del tratamiento de la voz. A partir de esta

concepción caprichosa adoptada por nuestro oído, es posible desarrollar un banco de filtros

que analice la señal de voz, no en una escala lineal, sino usando las escalas de Mel. La

respuesta en frecuencia del banco de filtros de Mel se muestra en la figura 2.4.

f mel = 2595 log

Figura 2.4: Banco de filtros de escalas de Mel

2.4 Audiometría

Es un conjunto de pruebas para medir la audición, se lleva a cabo de dos formas [Mar99]:

Vía aérea: Se llama de esta manera cuando se evalúa la habilidad para oír sonidos

transmitidos a través del aire. Se usan unos auriculares para presentar los sonidos.

Vía ósea: Evalúa la capacidad para oír el sonido a través de los huesos de la cabeza. Se usa

un altavoz especial que transmite vibraciones.

La audiometría convencional suele usar tonos puros. Un tono puro se compone de una

única frecuencia de estimulación. Se suelen utilizar las frecuencias correspondientes a las

octavas comprendidas entre 125 y 8000 Hertzios o Hz (125, 250, 500, 1000, 2000, 4000 y

8000 Hz), en total 8 frecuencias. Las frecuencias medias, es decir, las comprendidas entre

500 y 2000 Hz, son las más importantes para la audición de la palabra ya que en dicho

rango se sitúan la mayoría de los fonemas que componen la voz humana.

La audiometría se realiza mediante la utilización de un aparato electrónico denominado

audiómetro. Dicho aparato se compone de un generador de estímulos que son transmitidos

al individuo a través de unos auriculares aplicados estrechamente al oído, o un vibrador

aplicado al hueso situado inmediatamente detrás del mismo (mastoides).

En cualquier audiometría se van a realizar dos tipos de mediciones. Por un lado vamos a

estudiar el umbral audiométrico a través de la vía aérea, esto es, utilizando el auricular

aplicado al pabellón auditivo, y por otro a través de la vía ósea, mediante la aplicación de

un vibrador al hueso de la mastoides.

En el primero de los casos, el ruido debe transmitirse a través del conducto auditivo externo

(donde se forman los tapones de cera), a través del oído medio (donde están los huesecillos

más pequeños del cuerpo), y del oído interno, más conocido como caracol, hasta llegar al

15

nervio auditivo y al cerebro. En el caso de la estimulación por vía ósea se prescinde tanto

del oído externo como del medio, produciéndose una estimulación directa del oído interno a

través de los huesos del cráneo.

Para realizar una audiometría, bien mediante la estimulación aérea (con auriculares) u ósea

(con vibrador), se introduce normalmente a la persona en una cabina aislada acústicamente,

de forma que el ruido de estimulación no se mezcle con el ruido ambiente de la sala de

exploración. Seguidamente se le van presentando al paciente correlativamente ruidos (tonos

puros) de diferentes frecuencias, como hemos mencionado anteriormente, comprendidas

entre 125 y 8000 Hz. El explorador solicita a la persona que es explorada que levante la

mano o bien apriete un indicador cuando oiga, por poco que sea, cada una de las

estimulaciones, de forma que para cada una de las frecuencias vamos obteniendo su umbral

auditivo.

La audiometría se representa en una gráfica llamada audiograma la cuál viene definida por

un eje de ordenadas dividido en intervalos de 10 dBs. y un eje de abscisas donde se sitúan

los diferentes tonos que utilizamos para estimular, desde los más graves (125 y 500 Hz)

hasta los más agudos (4000 y 8000 Hz). Una vez realizadas las 8 mediciones, éstas se

anotan en el audiograma (ver figura 2.5).

Figura 2.5 Audiograma

La audiometría es normal cuando cumple dos premisas:

• Todos los umbrales audiológicos se sitúan en todas las frecuencias por debajo de los

20 dBs.

• No hay una diferencia superior a 5 dBs. entre las respuestas obtenidas mediante la

estimulación con los auriculares por vía aérea y el vibrador óseo.

16

Evidentemente la audiometría es anormal cuando no se cumple alguna de las dos premisas

anteriores. Si los umbrales se sitúan por encima de 20 dBs estaremos hablando de una

pérdida auditiva, o hipoacusia que podrá afectar:

•

A las frecuencias graves (125-250 Hz).

•

A las frecuencias intermedias (500-2000 Hz).

•

A las frecuencias agudas (2000-8000 Hz).

•

A todas ellas (hipoacusia pantonal).

El grado de dicha pérdida puede denominarse:

•

Leve (umbral entre 20 y 40 dBs.).

•

Moderada (umbral entre 40 y 60 dBs.).

•

Severa (umbral entre 60 y 80 dBs.).

•

Profunda (umbral mayor de 80 dBs.).

Cuando los umbrales en el audiograma se sitúan por encima de los 20 dBs. las diferencias

de la conducción ósea y la vía aérea nos van a permitir intuir que porción, de todos los

elementos que intervienen en la audición, no está funcionando de forma correcta.

2.4.1 Componentes de un audífono

Todos los audífonos (figura 2.6) constan de tres componentes importantes. Permanecen

juntos en una funda protectora que suele ser de plástico.

Figura 2.6 Audífono Intracanal

•

Micrófono El micrófono recoge los sonidos del aire y los convierte en señales

eléctricas.

•

Amplificador El amplificador aumenta la intensidad de las señales del micrófono.

Los filtros modifican los sonidos de modo que sólo se amplifican aquellos que son

importantes para la persona.

•

Altavoz El tercer componente básico es el "altavoz" (receptor). Convierte las señales

eléctricas en acústicas, que la persona puede oír.

17

•

Microordenador Estos tres componentes se encuentran en todos los audífonos.

Además, en los audífonos digitales, por ejemplo, se puede programar un

microordenador para manipular las señales y adaptarse a la pérdida de audición de

la persona con una deficiencia de audición en particular.

Algunos audífonos están equipados con controles de volumen y otras funciones de

control, que se pueden utilizar para realizar ajustes individuales.

18

Capítulo 3

TRANSFORMADA WAVELET

3.1

INTRODUCCIÓN

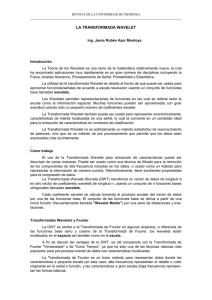

Durante la última década, la transformada wavelet ha sacudido las matemáticas aplicadas y

la investigación en ingeniería, demostrado ser de gran utilidad como herramienta de

procesamiento. El interés en la transformada wavelet ha aumentado conforme las

aplicaciones se han hecho más numerosas y se está convirtiendo en parte de los futuros

estándares en el análisis de señales y compresión de imagen y video. La teoría de las

wavelets es una herramienta matemática reciente, basada en la Teoría de Conjuntos y la

representación en funciones integrables cuadráticas, que permiten presentar una señal o un

campo tanto en escala, espacio y posibles direcciones [Jal00].

La Transformada Wavelet es también conocida como “el microscopio matemático”

[ADJ03], que tiene como antecedente la Transformada de Fourier, la cual es útil cuando se

estudian señales con propiedades estadísticas constantes en el tiempo o en el espacio, dado

que ésta representa una señal como una superposición de sinusoides (con duración infinita

en el tiempo), con diferentes frecuencias, donde los coeficientes de Fourier miden la

contribución de las sinusoides a esas frecuencias. De forma similar, la transformada de

wavelet representa una señal como una suma de wavelet con diferentes localizaciones y

escalas. Los coeficientes de wavelet esencialmente cuantifican la fuerza de la contribución

de las wavelets a esas localizaciones y escalas, su característica principal es la multiresolución, lo que permite el cambio de escala, constituyendo un medio adecuado para el

análisis de señales no estacionarias, sobre todo aquellas que presentan transiciones

abruptas.

Sin embargo, las señales reales tienen usualmente propiedades estadísticas que cambian con

el tiempo y parece más natural emplear funciones localizadas o “wavelet” para representar

estas señales en lugar de funciones seno y coseno. De esta manera, la representación de

señales no estacionarias como suma de un conjunto de funciones base localizadas

19

temporalmente permite obtener una representación más compacta y precisa de las

propiedades de la señal que la obtenida utilizando series de Fourier.

Existen dos tipos de wavelet: las continuas y las discretas. El tratamiento con wavelet

discretas analiza la señal a diferentes bandas de frecuencia con diferentes resoluciones al

descomponer la señal en aproximaciones y detalles, empleando para ello dos conjuntos de

funciones: las funciones de escalamiento y las funciones wavelet respectivamente, ésta

permite una aplicación directa a procesos computacionales. Las wavelet continuas

presentan por una parte la dificultad de su manejo al tener que evaluar un gran número de

integrales y tener en consecuencia una redundancia de información, pero por otra parte

permiten la flexibilidad de poder adaptarse a situaciones en las que las discretas no dan un

resultado satisfactorio.

Algunas propiedades de las wavelet son las siguientes:

• Las wavelet son bloques constructores de funciones. Es decir, podemos expresar

cualquier función f en términos de wavelet.

• Las wavelet tienen localización espacial y de frecuencia.

• Con las wavelet es posible implementar algoritmos rápidos de cálculo para la

transformada. Esto es más practico que teórico.

3.2

Repaso de la Transformada de Fourier

La Teoría de Wavelet trabaja de manera similar que la Teoría de Fourier, la cual dice que

una señal se compone de una serie de funciones sinusoidales y de ésta forma es más

sencillo su análisis. Recordando un poco, la Transformada de Fourier (FT) de la señal x(t)

está definida por la ecuación 3.1 :

∞

FT ( f ) =

−i 2πft

(

)

x

t

e

dt

∫

(3.1)

−∞

La transformada de Fourier trabaja bien si la señal x(t) está compuesta de unos cuantos

componentes estacionarios [ALA03], pero se puede observar en FT(f) se ha perdido

totalmente la dependencia temporal de la señal original, es decir, no tenemos información

del instante de tiempo en el cual un acontecimiento determinado ocurre en la señal, lo

implica una gran falencia ante la necesidad de analizar una señal no estacionaria como la

voz. Para contrarrestar estas desventajas se ha modificado la Transformada de Fourier

dando origen a lo que es la Short Time Fourier Transform (STFT) también conocida como

la transformada de Gabor. La STFT aplica una función g(t) utilizada como ventana de

análisis que se mueve sobre x(t) para determinar el espectro en cada instante de tiempo, ver

figura 3.1 y 3.2. La expresión que nos permite este análisis es:

∞

STFT

(b , f ) =

∫ x (t ) g

*

( t − b ) e − iπ

2 ft

dt

−∞

(3.2)

Donde el parámetro b indica la posición en el tiempo en la que se hace el análisis y *

denota el complejo conjugado. La desventaja que presenta esta transformada es que la

ventana de análisis es de un tamaño fijo (figura 3.1), por lo existe un límite de precisión y

resolución y por eso no puede adaptarse a las características de la señal en ciertos puntos

20

interesantes de analizar, ya que puede proveer poca información espectral o en algunos

casos redundar en esta información. Por ejemplo, cuando la ventana está ubicada en el

instante de tiempo T = 0, la STFT puede determinar con precisión la frecuencia de la señal

presente en este segmento, dado a que la longitud de la ventana abarca más de un período

completo (Figura 3.2a), sin embargo, cuando la ventana se ubica en T = T1, no se logra

abarcar un período completo, y por ende no es posible determinar con precisión el

contenido de frecuencia de este segmento de tiempo (Figura 3.2b).

En pocas palabras, la STFT puede resolver con buena resolución el contenido de altas

frecuencias pero es incapaz de hacerlo para regiones que involucren frecuencias más bajas

de lo que permita la longitud de la ventana, es así como, para un análisis de mejor

resolución frecuencia-tiempo, se prefiere emplear un tipo de transformada que presente una

longitud variable de la ventana, tal es el caso de la Transformada Wavelet [Hur02b].

Figura 3.1: Desplazamiento de ventana para la STFT

(a)

(b)

Figura 3.2: Inconvenientes de la STFT

Por lo visto anteriormente es que ha cobrado tanta fuerza la Teoría de las Wavelet, dado

que mantiene las ideas principales de un análisis tiempo-frecuencia utilizando una ventana

de análisis diferente.

3.3 ¿Qué son las wavelet?

Las wavelet son un conjunto de familias de funciones ortonormales básicas que no

requieren ser de duración infinita, por lo que se dice que son ondas localizadas y su

comportamiento en el dominio de la frecuencia equivale a un banco de filtros pasa-bandas,

examinando a la señal de interés para obtener sus características de espacio y tamaño

[Teo98]. La característica de las wavelet es la posible dilatación o contracción (figura 3.3),

que consiste en la variación de un parámetro a llamado factor de escala, en la función

generadora de la wavelet, alargando su duración en el tiempo y modificando su amplitud, lo

que permite modificar su respuesta en frecuencia y se define por:

21

ψ

a ,b

1

(t ) =

t − b

ψ

a

a

(3.3)

donde a, b∈R, a ≠ 0 y ψ (t ) es la “wavelet madre”, que se considera una función pasa

banda, a esa función madre se le agregan un par de variables que son la escala ‘a’ que

permite hacer las dilataciones y contracciones de la señal y la variable de traslación ‘b’, que

nos permite mover a la señal en el tiempo. Estas variables son números reales y obviamente

para una escala de ‘a’= 0 la wavelet no existirá y el análisis se indeterminará.

2

f (t ) = ψ (t ); a = 1

1

0

-1

0

5

10

15

1

0

-1

-2

0

5

10

f (t ) = ψ (2t ); a =

1

2

f (t ) = ψ (4t ); a =

1

4

15

2

0

-2

0

5

10

15

Figura 3.3: Izquierda wavelet a diferentes escalas, derecha traslación de wavelet

La Wavelet ψ (t ) debe satisfacer las siguientes condiciones:

1. Ser una señal de energía,

2

∫ψ (t ) dt < ∞ .

2. Exhibir una pequeña oscilación, de tal forma que tenga media cero.

Existe un sin número de funciones ψ (t ) que cumplen las condiciones anteriormente

mencionadas, de las cuales las más sobresalientes fueron desarrolladas por científicos

como: Alfred Haar, Ingrid Daubechies, Jean Morlett, Ronald Coifman, Yves Meyer, entre

otros. En la figura 3.4 se muestran algunas.

El objetivo primordial de la Transformada Wavelet, es el representar una señal o función

x(t), como la combinación lineal de un número infinito de wavelet escaladas (dilatadas o

contraídas) y desplazadas a lo largo de toda la señal [MYG97],

3.4 Transformada Wavelet

Las Transformadas Wavelet Comprenden la Transformada Continua de Wavelet y la

Transformada Discreta de Wavelet. Estas son las herramientas matemáticas que permiten el

análisis de señales de manera muy similar como lo hace la Transformada de Fourier de

22

Tiempo Corto dando información en el dominio del tiempo y en el dominio de la

frecuencia.

1.51

0.8

1

0.6

0.5

0.4

0

0.2

-0.5

0

-1

-0.2

-1.5

-0.4 0

-8

0.1

0.2

-6

-4

0.3

0.4

-2

0.5

0

0.6

2

0.7

0.8

4

0.9

6

1

8

Wavelet Haar

Wavelet Mexican Hat

1.5

1

0.5

0

-0.5

-1

-1.5

0

1

2

3

4

5

6

7

8

9

Wavelet Daubechies de orden 5

2

1.4

1.2

1.5

1

0.8

1

0.6

0.4

0.5

0.2

00

-0.2

-0.5

-0.40

0

0.5

0.5

1

1.5

1

2

2.5

1.5

3

2

3.5

4

2.5

4.5

3

5

Wavelet symmlet de orden 2

Wavelet Coiflet de orden 1

23

11

0.8

0.5

0.6

0.4

0

0.2

0

-0.5

-0.2

-0.4

-1

-0.6

-0.8

-1.5

-10

-8

-6

-4

5

-2

0

10

2

4

6

15

8

Wavelet Daubechies 8

Wavelet Morlet

Figura 3.4: Graficas de algunas wavelet madre.

3.4.1 Transformada Wavelet Continua (CWT)

La Transformada Wavelet Continua es un operador lineal que asocia un número real o

complejo, a una señal de energía finita, con una función particular “ψ ”denominada

wavelet madre, una vez seleccionado el instante y la escala de observación. Permite así

analizar estructuras de la señal que dependen del tiempo y de la escala, siendo una

herramienta útil para detectar, caracterizar y clasificar señales con características

espectrales extravagantes, contenidos transitorios y otras propiedades relacionadas con la

falta de estacionariedad.

Sea x(t) una señal del espacio L2(R) y ψ una wavelet madre, para la que más tarde se darán

especificaciones. Las denominadas wavelet analizadoras se construyen partiendo de

ψ ,, realizando sobre ella operaciones de traslación en el tiempo y dilatación, de forma que

la posicionan y la dilatan hasta conseguir el efecto de análisis deseado.

Para a, b ∈ R, a > 0, se define la familia de funciones de test o de wavelet analizadoras en

la forma:

ψ a ,b (t ) =

t −b

ψ

a a

1

(3.4)

Los coeficientes de la transformada wavelet de la señal x(t) respecto de la wavelet madre ψ

son los productos escalares de x con las funciones de test:

CWT x ( a , b ;ψ ) = x ,ψ a ,b =

∞

* t − b

(

)

x

t

ψ

dt

∫

a

a −∞

1

(3.5)

El parámetro ‘b’ desliza la wavelet en busca de información local y el parámetro ‘a’

controla el ‘tamaño’ de la wavelet (a≠0), de forma que cuando a tiende a 0, se obtiene algo

parecido a un ‘zoom’ del comportamiento de la señal x(t) en torno al instante t = b, la

variable de escala ‘a’ puede ser vista como a = f / fo donde fo denota la frecuencia central

24

de la wavelet. De esta manera tendremos que la ecuación (3.5) se puede expresar también

de la siguiente manera:

CWT

x

( f , b ;ψ ) =

x ,ψ

a ,b

∞

* f

dt

(

)

−

t

b

(

)

ψ

x

t

∫− ∞

fo

f

fo

=

(3.6)

De esta forma esta transformada permite la representación de la señal x(t) en el plano

tiempo escala.

Lo siguiente es explicar como: la CWT transforma la señal de un dominio a otro que

depende de 2 variables. La variable escala lleva en si la información de la dilatación y la

contracción de la señal (figura 3.5), pero podría verse desde otro punto de vista donde lo

que cambia es la frecuencia y con ello al dilatarse, la frecuencia se reduce y al contraerse, la

frecuencia aumenta. Aquí es justamente donde se aprovecha está característica de las

wavelet para obtener la información de la señal y conocer sus componentes de frecuencia.

En el dominio del tiempo el análisis es más sencillo ya que la variable de traslación tiene la

información de tiempo (figura 3.6), pues nos indica en que lugar del eje del tiempo, se

encuentra la wavelet. De este modo se van completando los datos en forma de una matriz,

donde para cada integral que resolvamos tendremos un punto del plano traslación-escala,

que es equivalente a tener la información en el plano tiempo-frecuencia [Her03].

Es importante aclarar que el proceso de transformación de una señal es reversible debido a

que se preserva la energía de la señal, lo que se conoce con el nombre de Transformada

Wavelet Inversa Continua (ICWT), que está dada por la ecuación 3.7:

x (t ) =

1

CΨ

∫∫

t−b

CWT ( a , b )ψ a

2

a

dbda

(3.7)

donde la constante C Ψ (denominada condición de admisibilidad) depende sólo de la

función wavelet madre ψ (t ) , de acuerdo con:

C Ψ = 2π

∞

∧

∫ ψ (ξ )

−∞

2

ξ

−1

dξ < ∞

(3.8)

Sin embargo la Transformada Wavelet de Tiempo Continuo no se presta para aplicaciones

prácticas donde las señales se representan de manera discreta.

25

Figura 3.5: Variable escala

3.4.2

Transformada Wavelet Discreta (DWT)

Partiendo de la ecuación (3.3) la DWT emplea valores para ‘a’ y ‘b’, en una escala de

potencias de dos denominada diádica (a = 2-k y b = n2-k), permitiendo expresar la

transformada en un banco de filtros de octavas. La DWT se define sobre una secuencia de

subespacios cerrados Vj, (j= 0, 1, ...,J), tales que V j ⊂ V j −1 ⊂ ... ⊂ V1 ⊂ V0 , siendo V0 = l2(Z)

el espacio de secuencias de números enteros de cuadrado sumable [VK95]. Estos

subespacios Vj son completos y satisfacen la propiedad, ∪ Vj = l2(Z), j∈[0,J]. La

descomposición multiresolución de una señal xn se deriva asumiendo que cualquier

elemento en Vj se puede representar de manera única como la suma de dos elementos de los

subespacios Vj+1 y Wj+1, siendo Vj = Vj+1 ⊕ Wj+1. Si existe una secuencia g n ∈V0 tal que

{

{g n−2 k }k∈Z

}

es una base de V1, entonces existe una secuencia hn ∈ V0 tal que hn −2 k k∈Z es

una base de W1, y V0 se descompone como: V0 = W1 ⊕ W2 ⊕ … ⊕ Wj ⊕ Vj

simplemente iterando la ley anterior de descomposición J veces. En el caso de estar

definiendo el concepto de multiresolución por medio de wavelets ortogonales, Wj+1 se

define como el complemento ortogonal de Vj+1 en Vj.

26

(a)

(b)

Figura 3.6: Proceso de análisis en diferente escala y traslación.

(a) escala fija a 1 y traslación variante, (b) escala fija a 20 y traslación variante.

27

Lo atractivo de esta transformada es que el desarrollo en serie de wavelet conduce a una

estructura de descomposición multiresolución por medio de un eficiente algoritmo de

cálculo basado en la implementación piramidal de un banco de filtros. El banco de filtros de

análisis o descomposición calcula los productos escalares con las funciones bases de los

subespacios W1, W2, ..., WJ y VJ. Así, la secuencia de entrada se descompone en una

componente o aproximación en el subespacio VJ y una serie de detalles en los subespacios

Wj (j= 1, 2, ..., J)[Per01].

La DWT permite realizar lo que se denomina Análisis de Multiresolución (MRA), que

consiste en estudiar la señal empleando por cada componente de frecuencia una resolución

diferente. Esto es una alternativa más sobre la STFT que analiza todas las componentes de

frecuencia a una misma resolución (sección 3.2). En general, las ventajas que ofrece este

método es que, con el uso de wavelet, a altas frecuencias (bajas escalas) se tiene una buena

resolución en tiempo y poca resolución en frecuencia, información detallada o parámetros

escondidos en la señal (que usualmente ocurren en periodos cortos de tiempo), mientras que

para bajas frecuencias (grandes escalas) corresponden a información global de la señal y los

resultados requieren buena resolución en frecuencia y poca resolución en tiempo [Pol96],

como se aprecia en la figura 3.7.

Figura 3.7:. Plano de Tiempo-Frecuencia analizado con la TW

Mientras que para la STFT las ventanas serían de igual dimensión para todos los casos ya

que para ese análisis no se dilatan ni se contrae, ver figura 3.8(a), lo que representa una

ventaja de la WT sobre la STFT, ya que se puede tener mayor detalle del comportamiento

de la señal, dada la resolución que se puede alcanzar.

(a)

(b)

Figura 3.8: Planos Tiempo-Frecuencia para (a) STFT (b) TW

28

3.4.2.1 Transformada Wavelet Rápida (FWT)

La transformada discreta wavelet unidimensional (1-D DWT) se puede calcular por medio

de la Transformada Wavelet Rápida (FWT) o algoritmo piramidal desarrollado por Mallat

[Mal89] (figura 3.9), la cual es una implementación computacionalmente eficiente donde

su costo computacional es Θ(L) (siendo L la longitud de la señal de entrada).

La Transformada Wavelet Rápida (FWT) descompone una señal en sus secuencias de

aproximación y detalle en diferentes niveles u octavas (figura 3.10a). El cálculo de la

transformada wavelet se inicia con una señal de entrada, a(0)n . Sean a(i-1)n y d(i-1)n sus

secuencias de aproximación y detalle en el nivel de descomposición i-1, respectivamente.

La aproximación y detalle de la señal en el nivel i se definen como:

a

(i )

n

d

(i )

n

N −1

= ∑ g k a 2(in−−1k)

k =0

=

N −1

∑h a

K =0

k

( i −1)

2n−k

Filtro Pasa-Bajo

(3.9)

Filtro Pasa-Alto

(3.10)

siendo gk y hk los coeficientes de los filtros paso baja y paso alta de orden N,

respectivamente (figuras 3.9 , 3.10(a)).

Las ecuaciones (3.9 y 3.10) describe el cálculo de la Transformada Wavelet Rápida. Los

coeficientes de los filtros se obtienen a partir de la representación de la wavelet madre en

tiempo continuo.

La resolución de las diferentes aproximaciones a n(i ) así obtenidas disminuye al aumentar i.

Puesto que las señales a n(i ) (i = 1, 2, ..., J) representan a la señal original en varias

resoluciones, la FWT también se conoce como una técnica de descomposición

multiresolución de señales, esta estructura recibe el nombre de banco de filtros de análisis,

el proceso consiste en una serie de filtrados repetitivos usando el concepto de diezmado, es

decir, al principio se utiliza un filtro pasa bajas y otro pasa altas con frecuencia de corte de

la mitad de la máxima componente de frecuencia de la señal a analizar, posteriormente la

salida de ambos filtros se vuelve a enviar a otro par de filtros de las mismas características,

la frecuencia de corte del segundo filtro es la mitad de la máxima componente de

frecuencia de la señal que va a entrar a ese filtro, ver figura 3.11. De éste modo se va

reduciendo el ancho de banda y eso se traduce en la reducción a la mitad de la resolución,

lo que significa que a mayor número de etapas de filtrado se tendrá una mayor resolución a

baja frecuencia.

La señal de entrada a n( 0) se puede reconstruir a partir de su descomposición multiresolución

de acuerdo con:

{

an(i −1) = ∑ ak(i ) g n−2 k + d k(i ) hn−2 k

}

(3.11)

k

Esta ecuación describe el banco de filtros de síntesis, que consta de un filtro paso baja y

otro paso alta de coeficientes g n y hn , respectivamente, y que se encuentran fijados por las

condiciones de reconstrucción perfecta [VK95] y de la wavelet madre en tiempo continuo.

La figura 3.10(a)(b) muestra un diagrama de bloques de los bancos de filtros de análisis y

síntesis respectivamente.

29

Figura 3.9: Transformada Wavelet Rápida (FWT) o Algoritmo de Mallat

(a)

(b)

Figura 3.10. Diagrama de bloques de la descomposición multiresolución de una

señal por medio de la transformada wavelet. (a) Banco de análisis y (b) síntesis.

Resulta interesante evaluar el número de operaciones de filtrado que se deben realizar por

cada muestra de la entrada a n( 0) . Nótese que los bancos de filtros de análisis y síntesis

conllevan exactamente el mismo número de operaciones. La señal de entrada a n( 0) se utiliza

como entrada de los dos filtros y de la salida de estos dos filtros sólo se utiliza una de cada

dos muestras debido a la decimación por 2. De esta manera, la primera pareja de filtros sólo

30

realiza 2(1/2)= 1 operaciones de filtrado por cada muestra de entrada. En el segundo nivel

de descomposición y puesto que la frecuencia de la señal a n(1) es la mitad de la frecuencia de

la señal de entrada, sólo se realizan ½ operaciones de filtrado por muestra de entrada.

Extendiendo este desarrollo se determina que el número de operaciones de filtrado por cada

muestra de entrada está acotado superiormente por 1+1/2+1/4+..... = 2.

Figura 3.11: Respuesta en frecuencia del banco de filtros Wavelet

3.4.2.2

Algoritmo Transformada Wavelet Rápida (FWT)

La 1-D DWT se puede implementar por medio del algoritmo piramidal (PA:Pyramid

Algortithm) desarrollado por Mallat [Mal89]. Dada una secuencia x(n) de longitud L, este

algoritmo se define mediante:

Inicio {Algoritmo Piramidal Directo}

Para (i = 1 a J )

Para (n = 1 a 2J-i )

a

(i )

n

d

(i )

n

N −1

= ∑ g k a 2(in−−1k)

k =0

=

N −1

∑h a

K =0

k

( i −1)

2n−k

Filtro Pasa-Bajo

Filtro Pasa-Alto

Fin {Algoritmo Piramidal Directo}

Siendo a n( 0) = x(n) , L = 2J, con J representando el número de octavas, y N siendo la

longitud de los filtros paso baja y pasa alta.

31

Capítulo 4

Sistema de Segmentación

El sistema de segmentación de señales tiene como objetivo identificar los segmentos de voz

sonoros, sordos y los tramos de silencio, utilizando transformada wavelet con el fin de

hacer un realce en la señal independiente del segmento identificado, por ejemplo, aumentar

algunas bandas de frecuencia para los sonidos sordos, no aumentar las vocales en lo

absoluto y reducir por completo los segmentos de ruido y de silencio. La Transformada

Wavelet juega un papel muy importante en el planteamiento de este proyecto ya que

autores como Tan et al. [TLS94] y Long y Datta [LD96] han mostrado que los fonemas

correspondientes a sonidos sordos se relacionan con las escalas de mayor resolución, en

cambio, los fonemas sonoros, tales como las vocales, con las escalas de menor resolución,

El sistema de segmentación propuesto que se plantea en el Apéndice D del proyecto de

investigación 195 de la Universidad del Quindío [Hur03] figura 4.1, se basa en utilizar la

DWT con la wavelet madre que mejor se ajuste a las características de la señal para

descomponerla en cuatro niveles o sub bandas y hacer una identificación entre fonemas

sonoros, sordos y tramos de silencio o ruido. El método para la segmentación y

clasificación de los fonemas en tiempo real consiste en capturar bloques de 64ms que

equivalen a 512 datos, y analizar pequeños sub-bloques de 4ms de longitud

correspondientes a 32 muestras por medio de una FWT, hacer una clasificación mediante

reglas de selección, las cuales se obtienen mediante un estudio de evolución de las energías

de cada uno de los niveles de descomposición, para facilitar el proceso de segmentación , la

información se suaviza por medio de un filtro de media móvil de 8 coeficientes. Una vez

identificado los segmentos de los fonemas se efectúa un realce en las diferentes bandas de

descomposición según el segmento identificado y se procede a recuperar la señal utilizando

la IDWT, la señal recuperada traerá las características adecuadas para la escucha en una

persona con deficiencias auditivas.

A continuación analizaremos la estructura del sistema de segmentación, de la figura 4.2,

detallando cada uno de los bloques que comprenden dicho sistema, y su implementación en

Matlab. Se ejecutaron simulaciones con frases de voz previamente almacenadas en formato

(.wav) con el fin de obtener las resultados adecuados que nos permitieron clasificar los

segmentos.

32

d-1……d-4

Extracción de

características a

bloques de 32

muestras

Filtro

media

móvil

d / dt

Detector

del

Segmento

Clasificador

d-1…..d-8, a-8

Figura 4.1 Sistema de Segmentación de Señales Propuesto en el Proyecto 195.

DWT

Captura

Señal de Voz

Pre-énfasis

Adquisición

Preprocesamiento

Wavelet

Denoising

Log

∂t

∫

exp{ }

Cálculo de

Energías

Normalización

Extracción de Características

Identificación

del Fonema

Realce

Segmentación

Realce de la Señal

Figura 4.2 Estructura del Sistema de Segmentación

4.1 Implementación del Sistema de Segmentación de Fonemas en

MATLAB

Para el desarrollo del proyecto y la obtención de los resultados deseados se efectuaron

simulaciones en MATLAB que obedecen al diagrama de flujo de la figura 4.3. Con

muestras de voz de diversos hablantes previamente capturadas de pequeña longitud, las

cuales formaban frases que contenían entre de 3 y 5 fonemas tanto sonoros como sordos y

segmentos de silencio, se realizó el análisis correspondiente y se establecieron las reglas de

selección adecuadas para segmentar la señal en 3 categorías diferentes de voz: sonidos

sonoros (vocales), sonidos sordos (consonantes) y segmentos de silencio o ruidos de fondo.

33

La implementación y funcionamiento del programa en matlab se detalla a continuación. La

señal de entrada X es un vector de cierta longitud, del cual se toman tramas de 512 datos

correspondientes a 64ms de la señal total, este se analiza independientemente de los otros

bloques teniendo en cuenta las últimas N-1 muestras del bloque anterior para su

descomposición por medio de la transformada wavelet y garantizando una continuidad de la

señal de entrada, siendo N el tamaño de la respuesta al impulso en este caso la longitud de

la wavelet madre seleccionada, la figura 4.3 ilustra el esquema en la memoria del DSP de

los bloques de entrada a cada una de las etapas del banco de filtros wavelet, se descompone

la señal hasta obtener los coeficientes wavelet de la señal de voz de los 4 niveles de detalle

de mayor resolución. Estudiando la evolución de energías de cada uno de los niveles se

establecieron los criterios de segmentación de cualquier señal de voz independiente del

hablante y de las condiciones de captura, una vez identificados los segmentos se efectúa un

realce de la señal, dicho realce se produce por medio de un factor de escala sobre los

coeficientes entregados por el bloque wavelet denoising, es por esta razón que en el

diagrama de flujo de la figura 4.4 se divide en dos partes, ya que los coeficientes entregados

por la etapa wavelet denoising son utilizados para identificar los segmentos y realzar la

señal. Por convicción este planteamiento en el diagrama de flujo no se puede plantear pero

es una forma muy simple de ilustrar el desarrollo del algoritmo.

El sistema de segmentación de la voz de la figura 4.4 está conformado por 6 etapas

clasificadas de la siguiente manera:

•

•

•

•

•

•

Adquisición de la señal de voz

Preprocesamiento

Extracción de Características

Segmentación

Realce de la señal

Recuperación de la señal de voz

512 Muestras leídas

Primera captura

de muestras

N-1 muestras

anteriores

N-1 muestras

512 Muestras leídas

Segunda captura de

muestras

N-1 muestras

anteriores

N-1 muestras

Figura 4.3. Esquema en memoria del vector de muestras a filtrar

34

INICIO

Lectura del

Archivo .wav

Conversión de

Fs a 8KHz

Ajuste de la Señal a un

Múltiplo de 512 Datos

Selección de

Bloque de 512

Datos

Filtrado de Pre-énfasis

Transformada Wavelet

Wavelet Denoising

Normalización

Cálculo Energías

Sub-bandas

Reglas de

Selección

Realce de

la Señal

Transformada Inversa

Wavelet del Bloque

Concatenación de Bloques

Conversión Señal a Formato .wav

FIN

Figura 4.4 Diagrama de flujo de la simulación en MATLAB

35

4.1.1 Adquisición de la Señal de Voz

La señal de voz básicamente está constituida por ondas de presión producidas por el aparato

fonador humano como se explicó en el capítulo 2. La manera más apropiada de capturar

este tipo de señal se realiza mediante un micrófono, el cual se encargará de convertir la

onda de presión sonora en una señal eléctrica. La siguiente etapa será aquella que se

encargue de amplificar las señales a niveles que sean manejables. A partir de la señal

analógica obtenida se hace necesario convertir la señal a formato digital para poder

procesarla en la computadora, y se realiza mediante dos procesos: muestreo y

cuantificación. Este proceso de dos etapas se conoce como Modulación por Código de

Pulsos (PCM). La mayor parte de los sonidos vocales tiene energía espectral significativa

hasta los 4khz, entonces la frecuencia de muestreo debe de ser por lo menos dos veces la

frecuencia máxima (según el Teorema de Shanon), por lo que fs = 8 KHz, que corresponde

a la calidad telefónica.

Las muestras de voz fueron tomadas de diversos hablantes entre hombres y mujeres y en

diversos ambientes de ruido de fondo con el fin de establecer criterios en señales

producidas en diferentes medios, para ello utilizamos la tarjeta de sonidos del computador

que permite guardar las frases en formato .wav a una frecuencia de muestreo de 22050Hz

usando 8 bits por muestra para ser manipuladas en el entorno de matlab por medio de la

función [X,fs] = wavread (‘.wav’) [MMOP07] la cual lee un archivo con extensión .wav, y

devuelve un vector X con los valores de amplitud de cada una de las muestras, y fs es la

frecuencia de muestreo de la señal. Debido a que la frecuencia de muestreo en el momento

de la captura es de 22050Hz debemos llevar a cabo una conversión a 8Khz ya que como se

mencionó anteriormente, nuestra frecuencia de muestreo óptima es de fs = 8Khz, las

muestras de voz capturadas quedan almacenadas en una base de datos para su respectivo

análisis, algunas se pueden ver en le tabla 4.1 teniendo en cuenta el análisis de los fonemas

del capítulo 2 sección 2.2.

Fonemas Consonánticos

Fonema

B

C

Ch

D

F

G

H

J

K

L

Ll

M

N

Ñ

Ejemplo

Bote

Casa

Pecho

Donde

Fama

Goma

Jardín

Paja

Queso

Lana

Llave

Mamá

Nana

Leña

36

Clasificación

Bilabial, Oclusivo

Velar, Oclusivo

Palatal, Africado

Dental, Oclusivo

Labiodental, Fricativo

Velar, Oclusivo

Glotal

Alveolar, Fricativo

Velar, Oclusivo

Alveolar, Semivocal

Palatal, Africativa

Bilabial, Nasal

Alveolar, Nasal

Palatal, Nasal

P

Q

R

RR

S

T

V

W

X

Y

Z

Papa

Queso

Pero

Carro

Sopa

Atar

Nueve

Hueso

Paja

Mayo

Caza

Bilabial, Oclusivo

Velar, Oclusivo

Alveolar, Vibrante

Uvular, Vibrante

Alveolar, fricativo

Dental, Oclusivo

Fricativa

Biobio-velar

Alveolar, Fricativo

Palatal, Fricativo

Interdental, Fricativo

Fonemas Vocálicos

Fonema

A

E

I

O

U

Ejemplo

A

E

I

O

U

Clasificación

Central, Abierta

Anterior, Media

Anterior, Cerrada

Posterior, Media

Posterior, Cerrada

Tabla 4.1 Ejemplos de algunas muestras de voz previamente capturadas

4.1.2 Preprocesamiento

Esta etapa consta de un filtro de Pre-énfasis, un filtro FIR empleado en los sistemas de

reconocimiento para eliminar el ruido de la señal, reducir los efectos de volumen y

contrarrestar en cierto grado la atenuación impuesta por el tracto vocal del hablante,

haciendo que el análisis sea independiente de las condiciones de captura. Se usa un filtro

digital de primer orden cuya función de transferencia es [BR99]:

H ( z ) = 1 − az −1

(4.1)

Donde 0 < a · 1, pero t´ıpicamente se emplea un valor de a = 0:95 permitiendo una

amplificación de 20dB para las componentes de alta frecuencia. Su implementación en

Matlab se efectúa por medio de la función de la convolución entre la señal de entrada X y

H(z), su salida Y es un vector de la señal filtrada.

Y = conv( X , [1 − 0.95])

(4.2)

Como la señal se analiza por bloques de 512 datos, hay que tener en cuenta el último dato

entregado del bloque actual para el análisis del bloque siguiente, técnica conocida como

solapamiento y suma [Hur02b]ver Figura 4.5.

37

Figura 4.5. Análisis por bloque del filtro pre-énfasis

4.1.3 Extracción de Características

Esta etapa involucra el análisis de las señales de voz. Está compuesta por cuatro bloques

(figura 4.6) que nos permiten obtener el comportamiento o evolución de las energías en los

diferentes niveles de descomposición para determinar y clasificar los segmentos de voz.

Trasformada

Wavelet

Wavelet

Denoising

Normalización

Energías

Sub-banda

Figura 4.6 Bloque de Extracción de Características

4.1.3.1Trasformada Wavelet

El primer bloque consiste en descomponer la señal por medio de la Transformada Wavelet

en sus 4 niveles de mayor resolución, para ello se hace uso del wavelet toolbox de MATLAB

el cual tiene embebida la función [C, L] = dwt ( X , ‘w_name’), que descompone la señal

de entrada X de longitud n igual a 512 datos (bloque de 64ms). Utilizando la wavelet madre

‘db8’ de longitud 2N con N = 8 (ver sección selección wavelet madre), en dos vectores C1,

L1 de longitud igual a 263 datos cada uno ( floor ((n-1)/2) + N ) asociados al nivel de

aproximación y detalles respectivamente, se puede apreciar en la figura 4.7 un análisis de

38

descomposición en matlab [MMOP07], que para el segundo nivel de detalle y

aproximaciones C2 y L2, la señal de entrada corresponde a los coeficientes de

aproximaciones del primer nivel C1 de longitud 263 datos, dando como resultado los

vectores de detalle y aproximaciones del nivel 2 de longitud 139 datos cada uno, el

procedimiento se repite hasta obtener los 4 niveles de detalle y uno de aproximaciones de la

señal a analizar, como muestra la figura 4.8. Para los bloques de 512 datos siguientes se

deben de tener en cuenta las condiciones iniciales que corresponden a los últimos N-1

datos del bloque anterior en el mismo nivel, ya que en el algoritmo de mallat se emplean

filtros FIR los cuales dependen de entradas anteriores. Por este motivo la longitud de los

coeficientes wavelet en cada nivel será siempre mayor que la longitud de la señal

descompuesta. En la tabla 4.2 podemos observar el número de datos que se analizan por

cada nivel y las condiciones iniciales tenidas en cuenta para los siguientes bloques.

La señal de voz se descompone en 4 bandas de frecuencia (H1, H2, H3, H4), en la tabla 4.3

se presenta el rango de frecuencias de las 4 bandas con su respectiva frecuencia central en

las que se descompone la señal.

Figura 4.7 Análisis de Descomposición por nivel en Matlab

X

h(-n)

2

g(-n)

2

a1 = 263

d-1 = 256 datos

h(-n)

2

g(-n)

2

a2 = 139

X = 512 datos

d-2 = 128 datos

h(-n)

2

g(-n)

2

a3 = 77

d-3 = 64 datos

h(-n)

2

g(-n)

2

d-4 = 32 datos

a-4 = 32 datos

Figura 4.8 Descomposición de un Bloque X = 512 datos de la señal en 4 niveles de detalle

y uno de aproximación

39

Nivel de Entrada

# Coeficientes Entregados

Ao = Bloque 512

A1 = 263

A2 = 139

A3 = 77

A1 = 263

A2 =139

A3 = 77

A3 = 46

D1 = 263

D2 = 139

D3 = 77

D4 = 46

Coeficientes

Analizados

D1 = 256

D2 = 128

D3 = 64

D4 = 32

Condiciones Iniciales

sgte bloque

D1 = 7

D2 = 11

D3 = 13

D4 = 14

Tabla 4.2 Número de coeficientes entregados por cada nivel de la wavelet con los

coeficientes que se analizan y los que sirven de condiciones iniciales para los siguientes

bloques

Nivel

Frecuencia Mínima

(Hz)

Frecuencia Máxima

(Hz)

H1

H2

H3

H4

Tabla 4.3 Rango de frecuencias

4.1.3.2 Selección de la Wavelet Madre

Lo primero a tener en cuenta a la hora de realizar un análisis wavelet es cuál wavelet madre

utilizar ya que se hace necesario determinar la señal Ψ(t) que mejor se adapte al sistema;

para esto se hizo referencia al proyecto de investigación 195 “Reconocimiento de Voz en

Tiempo Real por medio de la Transformada Wavelet Y Procesadores Digitales de Señales”

[Hur03a] realizado en la universidad del Quindío. Entre los criterios tenidos en cuenta

están:

•

•

•

Mayor similitud con las muestras de las señales de voz. Bajo este criterio la wavelet

Haar se descarta debido a su gran diferencia con una señal de voz. La symlets son

bastante simétricas y las señales de voz son asimétricas, por lo tanto también se

descartan. Así que solo quedan la Daubechies y la Coeiflet.

Menor carga computacional. Un orden alto de la función wavelet implica una

longitud mayor en los coeficientes de los filtros usados en el análisis y por lo tanto

un costo computacional más alto. Para las wavelets daubechies y symlets la longitud

de los filtros de análisis hn y síntesis gn es 2N, donde N es el orden de la función

wavelet, en cambio para las coiflets, esta longitud se triplica ya que las longitudes

de dichos filtros son 6N. Por tal motivo fué descartada.

Se empleó el método de determinación de la mejor base el cual hace uso de la

entropía µ de DWT, y el algoritmo de la selección de la mejor base, llegando a la

conclusión de emplear la Wavelet Daubechies de orden 8.

40

4.1.3.3 Wavelet Denoising

Es una técnica mediante la cual se elimina el ruido ambiente de fondo y el producido por el

sistema de grabación utilizado. Esta técnica tiene la ventaja de que se incorpora

directamente dentro del algoritmo de cálculo de la transformada y no requiere de demasiada

carga computacional. Para esto se realiza lo que se conoce como un soft-thresholding que

consiste en restar cierto umbral a los coeficientes arrojados por el cálculo de la DWT de

cada uno de los niveles de descomposición cuyo valor absoluto sea mayor a éste y llevar a

cero los coeficientes cuyo valor absoluto se encuentre por debajo. Para calcular el umbral

se capturan datos con el micrófono en ausencia de voz (ruido) y se hace uso de la siguiente

ecuación [RB98]:

2 * log n *σ

u=

(4.3)

n

donde:

u = Umbral.

n = Número de datos (tamaño del ruido capturado).

σ 2 = Varianza del ruido

En la tabla 4.4 se muestran los valores de umbral de ruido en cada una de las bandas

obtenidos haciendo uso de la transformada wavelet discreta de 8 niveles, es muy notorio la

reducción de ruido utilizando el bloque wavelet denoising a la hora de recuperar la señal, si

se utiliza un umbral muy fuerte puede ocasionar pérdidas de energía importante que

repercuten en la identificación de los segmentos.

Nivel

Detalle 1

Detalle 2

Detalle 3

Detalle 4

Aproximación 4

Umbral

12.4 e -3

6.1 e -3

3.1 e -3

1.9 e -3

1 e -3

Tabla 4.4 Umbral de ruido para cada nivel

4.1.3.4 Normalización

Es de notar en el sistema que el bloque de normalización está antes del cálculo de energías,

el cual emplea el logaritmo del valor absoluto de los coeficientes wavelet, la derivada

temporal, la integración y la exponenciación (ver figura 4.9), este conjunto de bloques

garantizan, para los parámetros extraídos, una independencia del volumen de la señal.

log W g {Af (t )} = log A + log W g { f (t )}

(4.4)

∂

∂

log W g {Af (t )}(s, t ) = log W g {Af (t )}(s, t )

(4.5)

∂t

∂t

Al emplear el calculo del logaritmo del valor absoluto se logra una independencia del factor

de amplitud de la señal (Ec. 4.4), el cual puede ser eliminado por medio de la derivada

41

temporal al conjunto de datos (Ec. 4.5) logrando una independencia de amplitud de los

parámetros extraídos, la derivada temporal en matlab se implementa por medio de un

derivador de primer orden dado por la ecuación de recurrencia

y[n ] = x[n] − x[n − 1]

(4.6)

y para la operación de integración un integrador de suma continua dado por la función de

transferencia [LF94]

1

H (z ) =

(4.7)

1 − z −1

Tanto el derivador (ecu4.6) como el integrador (ecu.4.7) se pueden implementar en

MATLAB [MMOP07] por medio de la función Y = FILTER (bk, ak, x) teniendo en cuenta

como condición inicial para el siguiente bloque de datos, el último dato de cada uno de los

niveles de descomposición ya que el derivador y el integrador dependen de la entrada (FIR)

y salida (IIR) anterior respectivamente.

∂t

Log

∫

exp{ }

Normalización

Figura 4.9 Bloque de normalización

4.1.3.5 Energías Sub-bandas

Una vez obtenidos los coeficientes wavelet normalizados de cada uno de los 4 niveles de

detalle y 1 de aproximación, procedemos a calcular la energía aportada por cada uno de los

niveles de detalle en los que se toman sub-bloques de 4ms que corresponden a segmentos

de 32 muestras para analizar la evolución de la energía y establecer las reglas de selección

adecuadas, para este análisis se utilizó la siguiente ecuación:

Ebanda

i

=

N

i

∑

C

K =1

i

(k )2

(4.8)

Donde Ci son los coeficientes de la banda i, Ni es la longitud por banda y Ebandai es un

vector de una longitud 16 datos que contiene la energía de la banda i por cada segmento de

32 datos (4ms) del total del bloque capturado de 512 datos (64ms), en la tabla 4.5 se puede

observar el número de coeficientes que aporta cada banda por bloque y por segmento para

el cálculo de energía por cada nivel.

Nivel

Datos Por

Datos Por Segmento

Bloque (64ms)

(4ms)

Detalle 1

256

16

Detalle 2

128

8

Detalle 3

64

4

Detalle 4

32

2

Aproximación 4

32

2

Tabla 4.5 Número de Coeficientes de cada nivel en un bloque de 512 muestras de la señal

para el Cálculo de las Energías

42

Una vez obtenidos los vectores de energía de cada uno de los niveles de detalle, y para

facilitar el proceso de segmentación, la información se suaviza por medio de un filtro de

media móvil de 8 coeficientes, cabe recordar que cada vector tiene una longitud de 16 datos

en cada nivel y que corresponden a solo un bloque de 512 datos (64ms) de la señal, es decir

un dato en cada vector equivale a la energía contenida en un segmento de 32 muestras

(4ms) por banda.

4.1.4 Reglas de Selección

En esta sección se describen una serie de pruebas, que fueron llevadas a cabo de cara a

realizar la segmentación de las frases componentes de la base de datos de una manera

automática. El objetivo de dichas pruebas, era el de evaluar la posibilidad de realizar la

segmentación de fonemas de las frases componentes de nuestra base de datos de una

manera automática (la segmentación consiste en delimitar mediante etiquetas la posición de

los fonemas dentro de las frases), con el fin de establecer reglas de selección que permitan

identificar el tipo de segmento. En efecto, debemos especificar que dicho proceso de

segmentación es realizado manualmente (empleando herramientas de edición de sonido

como, Sound forge 5.0 y Cool Edit Pro 2.0), para lo cual se debe escuchar una a una las

frases, y colocar las etiquetas que aislan cada uno de los fonemas de forma manual, estas

etiquetas se graban en un archivo de formato .phn con el mismo nombre del archivo .wav

que contenga la frase, el archivo .phn contiene el número de fonemas en la frase y el

posicionamiento de cada fonema (Tabla 4.6), no hay que olvidar que los valores obtenidos

de las etiquetas se toman de los archivos cuya frecuencia de muestreo es aproximadamente

22Khz y que se debe hacer la conversión a 8Khz, para ser visualizados (ver figura 4.10) y

poder observar el comportamiento de la energía entre fonemas de cada una de las bandas.

# de Fonemas

4

/m/

/a/

/t/

/a/

Etiquetado Manual

Posición

Longitud

544

2880

3447

3734

9856

540

10440

3585

Tabla 4.6 Etiquetado Manual de la palabra “mata”

Claramente, este procesado manual requiere una gran cantidad de tiempo y además, en

algunos casos, lleva asociado también errores. Estos errores pueden venir derivados del

cansancio que este trabajo implica, por esta razón se produce errores de criterio en la