Supervisión de Procesos Complejos mediante Técnicas de Data

Anuncio

Universidad de Oviedo

Departamento de Ingenierı́a Eléctrica, Electrónica,

de Computadores y Sistemas

Tesis Doctoral

Supervisión de Procesos Complejos mediante

Técnicas de Data Mining con Incorporación

de Conocimiento Previo

Abel Alberto Cuadrado Vega

Noviembre 2002

2

Universidad de Oviedo

Departamento de Ingenierı́a Eléctrica, Electrónica,

de Computadores y Sistemas

TESIS

SUPERVISIÓN DE PROCESOS COMPLEJOS

MEDIANTE TÉCNICAS DE DATA MINING CON

INCORPORACIÓN DE CONOCIMIENTO PREVIO

Memoria presentada para la obtención del grado de

Doctor por la Universidad de Oviedo

Autor: Abel Alberto Cuadrado Vega

Directores: Alberto B. Diez González

Ignacio Dı́az Blanco

Gijón, Noviembre de 2002

4

Agradecimientos

Este trabajo sólo ha podido salir adelante con la inestimable ayuda y

apoyo incondicional de mis directores, Alberto Diez e Ignacio Dı́az. Muchas

gracias por darme esta oportunidad, por enseñarme, por orientarme, y por

proporcionarme proyectos tan interesantes durante estos cuatro años.

Una gran parte de la “culpa” de que, después varios años de agotadora

carrera, recuperara la ilusión inicial por hacer Ingenierı́a Industrial el mismo

dı́a que empecé el proyecto fin de carrera la tiene Nacho (bueno, unos meses

después; ese dı́a concretamente me dejó a cuadros). Desde entonces, cada dı́a

me contagia con su entusiasmo por descubrir cosas nuevas.

Gracias a toda la gente del Área de Ingenierı́a de Sistemas y Automática

(incluidos los que ya no están): desde proyectantes, becarios, PAS, profesores, hasta el mismo Director del Departamento, Guillermo Ojea. No podrı́a

haberme imaginado un lugar de trabajo mejor. Gracias a Alberto Diez y a

Juan Carlos Álvarez por darme unas pistas de lo que es la vida real; a Hilario López, por inspirarme la idea de hacer esta carrera; a Diego Álvarez y a

Juan Manuel Guerrero, porque nos ha tocado seguir caminos paralelos desde

que empezamos la carrera allá por el 91, y muchas veces me han servido

de referencia y me han echado una mano cuando me hacı́a falta; a Alfonso

Fernández de Lera por hacer que pasar la jornada entera en el campus sea

más ameno; Gracias a Felipe González, Alfonso Fernández Vázquez, Alberto

Pintado y Eva Janeiro, por trabajar tan duramente conmigo en diferentes

proyectos (y a Pablo Garcı́a, que encima me ha prestado una pedalera para

la guitarra). Gracias a todos, porque quisiera nombrar uno a uno, y hacer

más menciones especiales, pero ni hay espacio ni vienen a cuento aquı́.

Gracias al personal de Aceralia, porque nos ponen en contacto con la

industria real: Faustino Obeso, José Luis Rendueles, Luis Rodrı́guez Loredo,

Pablo Fernández Quiroga y demás.

Por supuesto, gracias a mis amigos, sin los cuales la vida serı́a bastante

más aburrida: Ángel, Adriana, Jorge (y ahora Sara también), Eloy, Ana,

Pedro C., Pedro F., Fran, José, Joseba, Sonia, Rafa, Ernesto y, cómo no,

Carlos (ese ı́nclito elemento que hasta recuerda alguna que otra rabieta mı́a

5

6

en segundo de EGB).

Por último, gracias a mi familia. A mi madre y a mi padre, que han sido

capaces de criar a “los tres mosqueteros” (éstos se llaman Marcos, Sonia y

Alberto, no Athos, Porthos y Aramis), y que han confiado en mı́ y siempre

me han ayudado en mi objetivo de trabajar en lo que más me gusta.

Resumen

La calidad del producto fabricado y la ausencia de fallos en el proceso de

fabricación son requisitos fundamentales en una planta industrial. Cada vez

se desarrollan métodos más eficaces y eficientes de asegurar el cumplimiento

de estos dos requisitos, métodos que generalmente se basan en enfoques totalmente automáticos implementados en un computador. Esta tesis propone

un enfoque global de aplicación de técnicas de visualización a la supervisión

de procesos que complementa la enorme potencia de cálculo y memoria de un

computador con la creatividad y grandes capacidades de percepción visual

del ser humano, permitiendo incorporar conocimiento previo que éste posee

sobre el proceso, y extraer nuevo conocimiento relacionando leyes fı́sicas, reglas extraı́das de la experiencia y datos provenientes del proceso. La idea

principal es representar gráficamente toda esta información bajo una misma

forma unificada, que, sobre todo, facilita la comprensión del gran volumen

de datos que se pueden generar en un proceso.

Esta forma unificada de representación está constituida por un espacio de

visualización, al que por medio de técnicas de proyección no lineal se traslada

información/conocimiento disponible en el espacio de las variables del proceso, espacio éste de muy alta dimensionalidad y por tanto no visualizable

directamente. Este esquema se complementa con la aplicación de una técnica

de redundancia analı́tica que se basa en el modelo del proceso constituido

por una técnica de proyección y que encaja perfectamente en el marco de este

enfoque de Data Mining Visual para la supervisión de procesos complejos.

En esta tesis, además, se presenta una aplicación software diseñada según

estos mismos principios y se muestran algunos resultados de esta metodologı́a

aplicada sobre casos reales: un motor de inducción de 4 kW en laboratorio y

un motor de continua de 6000 kW de un tren de laminación de la empresa

siderúrgica Aceralia.

7

8

Índice general

1. Introducción y Objetivos

13

1.1. Introducción . . . . . . . . . . . . . . . . . . . . . . . . . . . . 13

1.2. Motivación y objetivos . . . . . . . . . . . . . . . . . . . . . . 14

1.3. Formulación del problema . . . . . . . . . . . . . . . . . . . . 18

2. Técnicas de Supervisión de Procesos

2.1. Introducción . . . . . . . . . . . . . . . . . . .

2.2. Técnicas basadas en modelos analı́ticos . . . .

2.2.1. Ecuaciones de paridad . . . . . . . . .

2.2.2. Estimación de parámetros . . . . . . .

2.2.3. Observadores de estado . . . . . . . . .

2.3. Técnicas basadas en conocimiento . . . . . . .

2.3.1. Métodos cualitativos . . . . . . . . . .

2.3.2. Sistemas expertos basados en reglas . .

2.3.3. Sistemas de inferencia borrosos . . . .

2.4. Técnicas basadas en datos . . . . . . . . . . .

2.4.1. Clasificadores . . . . . . . . . . . . . .

2.4.2. Redundancia analı́tica basada en datos

2.4.3. Control estadı́stico de procesos . . . .

2.5. Técnicas hı́bridas . . . . . . . . . . . . . . . .

2.5.1. Técnicas de visualización . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

3. Técnicas de Reducción de la Dimensión

3.1. Introducción . . . . . . . . . . . . . . . . . . . . . . .

3.2. Selección de variables . . . . . . . . . . . . . . . . . .

3.3. Extracción de caracterı́sticas . . . . . . . . . . . . . .

3.3.1. Normalización . . . . . . . . . . . . . . . . . .

3.3.2. Técnicas de análisis espectral . . . . . . . . .

3.3.3. Otras técnicas de extracción de caracterı́sticas

3.4. Técnicas de proyección . . . . . . . . . . . . . . . . .

3.4.1. Técnicas de Proyección Lineal . . . . . . . . .

9

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

23

23

25

26

26

27

27

27

28

28

30

30

31

32

33

34

.

.

.

.

.

.

.

.

35

35

36

37

39

40

49

49

50

10

ÍNDICE GENERAL

3.4.2.

3.4.3.

3.4.4.

3.4.5.

Escalado Multidimensional .

Modelos Autoasociativos . .

Mapas Topológicos . . . . .

Otras técnicas de proyección

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

52

54

57

63

4. Data Mining Visual

4.1. Introducción . . . . . . . . . . . . . . .

4.2. Formas básicas de representación . . .

4.3. Proyección de datos . . . . . . . . . . .

4.4. El error de modelado . . . . . . . . . .

4.5. Representación visual de conocimiento

4.5.1. Etiquetado . . . . . . . . . . . .

4.5.2. Planos de componentes . . . . .

4.5.3. Mapa de distancias . . . . . . .

4.5.4. Mapas de activación . . . . . .

4.5.5. Mapas borrosos . . . . . . . . .

4.5.6. Mapas de modelos . . . . . . .

4.5.7. Mapas de correlaciones . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

65

65

66

69

70

72

72

72

73

74

75

76

78

.

.

.

.

.

.

.

.

.

81

81

81

82

84

84

86

86

87

87

.

.

.

.

.

.

.

.

.

.

89

89

89

89

90

93

94

94

94

94

96

5. Residuos en Modelos de Datos

5.1. Introducción . . . . . . . . . . . . . . . . .

5.2. Generación de residuos . . . . . . . . . . .

5.3. Detección de Novedades . . . . . . . . . .

5.4. Residuo vectorial . . . . . . . . . . . . . .

5.4.1. Validez del residuo vectorial . . . .

5.4.2. Representación del residuo vectorial

5.5. Consideraciones en el uso de residuos . . .

5.5.1. Elección de datos para el modelo .

5.5.2. Modelo con interpolación . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

6. Metodologı́a de Supervisión

6.1. Introducción . . . . . . . . . . . . . . . . . . . . . .

6.2. El sistema MAPREX . . . . . . . . . . . . . . . . .

6.2.1. MAPREX: un sistema de monitorización . .

6.2.2. MAPREX: una herramienta de Data Mining

6.2.3. Estructura de la aplicación MAPREX . . . .

6.3. Una sesión con MAPREX . . . . . . . . . . . . . .

6.3.1. Selección de señales . . . . . . . . . . . . . .

6.3.2. Visualización de las señales en tiempo real .

6.3.3. Selección de caracterı́sticas . . . . . . . . . .

6.3.4. Preparación de datos para modelado . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

. . . .

. . . .

. . . .

Visual

. . . .

. . . .

. . . .

. . . .

. . . .

. . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

ÍNDICE GENERAL

11

6.3.5. Generación del modelo . . . . . . . . . . . . . . . . . . 96

6.3.6. Explotación del modelo . . . . . . . . . . . . . . . . . . 96

7. Resultados

7.1. Introducción . . . . . . . . . . . . . .

7.2. Monitorización de sistemas en tiempo

7.2.1. Descripción del sistema . . . .

7.2.2. Obtención del modelo . . . .

7.2.3. Aplicación del modelo . . . .

7.3. Data Mining de procesos industriales

7.3.1. Descripción del proceso . . . .

7.3.2. Obtención del modelo . . . .

7.3.3. Aplicación del modelo . . . .

. . .

real

. . .

. . .

. . .

. . .

. . .

. . .

. . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

99

99

99

99

101

101

106

106

108

108

8. Conclusiones

117

8.1. Conclusiones . . . . . . . . . . . . . . . . . . . . . . . . . . . . 117

8.2. Aportaciones . . . . . . . . . . . . . . . . . . . . . . . . . . . 118

8.3. Lı́neas futuras . . . . . . . . . . . . . . . . . . . . . . . . . . . 120

A. Nomenclatura

123

12

ÍNDICE GENERAL

Capı́tulo 1

Introducción y Objetivos

1.1.

Introducción

El buen funcionamiento de una planta industrial viene condicionado por

la eficacia y eficiencia de cada uno de los tres niveles en los que se suele

dividir la automatización de la misma: gestión, supervisión y control. Cada

nivel tiene unos objetivos diferenciados y actúa sobre el nivel inmediatamente inferior para lograrlos1 . El nivel de gestión es el que marca los objetivos

principalmente económicos, realiza la planificación y tiene unos tiempos entre actuaciones sobre el nivel de supervisión relativamente largos. El nivel

de supervisión tiene la función de verificar el correcto funcionamiento de la

planta, pudiendo incluirse en ello la búsqueda de la calidad en la producción, tan importante hoy en dı́a para cumplir objetivos económicos debido a

la gran competencia existente en el mercado mundial. Ello lo consigue por

medio de acciones sobre el nivel más bajo, el nivel de control, reconfigurando

sus estrategias o realizando acciones radicales, como paradas completas, ante

una posibilidad de fallo catastrófico. El nivel de control es el que interacciona

de forma más cercana con los procesos de fabricación, actuando directamente sobre la maquinaria y requiriendo velocidades de actuación muy elevadas

ante eventos en el proceso.

Ası́ pues, la importancia de la supervisión radica, primero, en la necesidad de verificar que los procesos de control funcionan de manera adecuada,

y segundo, que lo hagan con la precisión que los objetivos de calidad del

producto final requieren. El verificar que el control del proceso funcione de

manera adecuada tiene que ver con el buen estado de toda la maquinaria del

proceso. Un elemento del proceso en mal estado no estará de acuerdo con los

modelos matemáticos que se tienen de él y, por tanto, el sistema de control,

1

O sobre el proceso directamente, en el caso del nivel más bajo, el de control.

13

14

CAPÍTULO 1. INTRODUCCIÓN Y OBJETIVOS

que se habrá diseñado teniendo en cuenta dichos modelos, no realizará su

trabajo correctamente, dando lugar a un producto de baja calidad. También,

en caso extremo, se podrı́a producir un fallo grave que pudiera hacer que el

proceso de fabricación se detuviera completamente.

1.2.

Motivación y objetivos

La detención completa de un proceso de fabricación suele conllevar grandes pérdidas económicas. A su vez, un producto de mala calidad es una

desventaja para la competitividad de la empresa en los mercados, lo cual

supone un obstáculo para el objetivo de maximización de beneficios. Como

consecuencia de ello, las estrategias de mantenimiento han evolucionado a

lo largo del tiempo para evitar estos inconvenientes interfiriendo lo menos

posible en la continuidad del proceso de fabricación.

Ası́, en un sistema de mantenimiento básico, la sustitución de componentes en el proceso de fabricación sólo se realiza cuando se produce el fallo de

los mismos (mantenimiento correctivo). Este sistema tiene tres inconvenientes principalmente. Por un lado, un fallo que provoque la parada total del

proceso puede producirse en un momento inconveniente, en el que las pérdidas económicas sean mayores respecto a otro momento. Por otro lado, un

fallo total en un elemento del proceso puede dar lugar a fallos en elementos

adyacentes, y puede convertirse incluso en un problema de seguridad para los

trabajadores de la planta, generando accidentes. Una tercera razón también

podrı́a ser el stock de componentes que habrı́a que tener para la sustitución.

Otra estrategia de mantenimiento que intenta evitar estos inconvenientes

es el mantenimiento preventivo, que consiste en la sustitución de componentes

en función de datos estadı́sticos de vida útil de los mismos. Ello permite

también planificar paradas del proceso con antelación, cuando sea necesario,

para la sustitución. Sin embargo este sistema de mantenimiento también

tiene un inconveniente, sobre todo en componentes de alto coste, y es que

a veces se desperdician componentes que todavı́a están en perfecto estado.

Además, siempre existe la posibilidad de que los componentes fallen antes de

lo previsto.

El sistema que actualmente presenta más ventajas es el mantenimiento predictivo o mantenimiento por condición. Por este método se realiza la

sustitución de los componentes basándose en el estado de los mismos, deducido a través de su monitorización, ya sea continua o discontinua en función

principalmente de lo crı́tico que sea el elemento dentro del proceso.

La función de la supervisión de procesos, por consiguiente, se puede resumir como la verificación del funcionamiento óptimo de procesos, con tres

1.2. MOTIVACIÓN Y OBJETIVOS

15

objetivos:

Detectar fallos en la maquinaria e instrumentación de forma anticipada

para prevenir paradas no planificadas del proceso.

Detectar en el proceso desviaciones del funcionamiento correcto y que

dan lugar a la fabricación de producto defectuoso o de baja calidad.

Actuar o sugerir actuación para volver al óptimo en los dos casos anteriores.

Llevar a cabo estos objetivos a través de la monitorización no es, sin

embargo, tarea fácil. La mayorı́a de los procesos industriales se pueden calificar como “complejos”. Este adjetivo se deriva del hecho de que los procesos

industriales generan una cantidad enorme de datos provenientes de muchas

variables que suelen estar relacionadas de forma no lineal. La caracterı́stica

de no linealidad es un problema importante, puesto que la mayor parte de

la teorı́a de control de sistemas se centra en sistemas lineales. Un modelo

en ecuaciones explı́citas de un proceso no lineal suficientemente preciso, si

existe, suele ser difı́cil de tratar. En cuanto al gran número de variables,

es un inconveniente debido a la maldición de la dimensionalidad (curse of

dimensionality) que plantea que el número de datos que hace falta para hacer estimaciones suficientemente precisas a partir de los mismos (estimación

de funciones de densidad de probabilidad, aproximación de funciones, etc.)

aumenta exponencialmente con la dimensión del espacio de datos [7].

El problema de la no linealidad, y la dificultad derivada de obtener modelos explı́citos, hace que se piense en recurrir a modelos basados en datos

frente a otros modelos analı́ticos basados en ecuaciones explı́citas. Respecto

al problema de la dimensionalidad, hace necesario el uso de técnicas de reducción de la dimensionalidad para eliminar componentes de los vectores de

datos (variables) que no contengan información significativa o que contengan

información redundante.

Para la supervisión de maquinaria son tı́picos los métodos que fijan umbrales para determinadas variables como método para detectar problemas

(métodos de umbral ). Es muy común en máquinas rotativas (motores y generadores eléctricos, bombas, ventiladores, turbinas, . . . ) medir valores de niveles de vibración (valor eficaz en una banda de frecuencia), que no deberán

sobrepasar unos valores estándar o dados por el fabricante para considerar

que funcionan correctamente [88]. En estos casos también se suelen emplear

métodos algo más sofisticados de análisis espectral de las vibraciones para

descubrir qué fallo concreto que se está produciendo.

Quizás, el mayor esfuerzo en investigación en los últimos años para la

detección y diagnóstico de fallos se ha dirigido hacia enfoques en los que

16

CAPÍTULO 1. INTRODUCCIÓN Y OBJETIVOS

todo el proceso de detección y diagnóstico, desde la adquisición de datos

hasta la señalización e indicación de fallos, se realiza de forma automática.

Ası́, son de aparición frecuente en la bibliografı́a técnicas como las de

redundancia analı́tica, en las que para el diagnóstico se usan las diferencias

entre las salidas de un modelo analı́tico del proceso y el proceso real. En realidad, el concepto de redundancia analı́tica se puede referir al uso de cualquier

modelo no fı́sico (matemático) para ese fin. Las técnicas que usan un modelo matemático en forma de ecuaciones explı́citas, como las de ecuaciones

de paridad, las de estimación de parámetros y las de estimación de estado,

se pueden englobar dentro de un grupo que podrı́amos denominar técnicas

basadas en modelos analı́ticos. Sin embargo este grupo de técnicas necesitan

para su aplicación un modelo del proceso suficientemente preciso, lo cual es

infrecuente en procesos complejos. Gertler, en [37], hace un resumen de estas técnicas para detección y diagnóstico de fallos basadas en modelos para

plantas complejas.

Otro grupo de técnicas no tienen unos requerimientos tan fuertes en cuanto al conocimiento del modelo del proceso y les basta con un conocimiento

impreciso, incompleto o incluso más bien intuitivo, expresado en forma similar al lenguaje humano. Entre ellas se encuentran las técnicas basadas en

conocimiento. Éstas incluyen enfoques como el razonamiento cualitativo, la

lógica difusa o los sistemas expertos basados en reglas. Por ejemplo, relacionado con este grupo de técnicas, Isermann [44] presenta aplicaciones de lógica

difusa para control, supervisión y diagnóstico de fallos.

También son posibles combinaciones de modelos analı́ticos y modelos basados en conocimiento. Ası́, Ballé [3] enfoca la detección y diagnóstico de

fallos en procesos no lineales a través de modelos difusos lineales locales y

estimación de parámetros. Isermann [46] integra información analı́tica y conocimiento heurı́stico para diagnóstico de fallos a través de lógica difusa. Patton

[70] resume varias técnicas disponibles de inteligencia artificial aplicadas al

diagnóstico de fallos, y de ellas escoge B-splines cómo método que integra un

enfoque cualitativo y otro cuantitativo, y que se demuestra equivalente a los

sistemas difusos. Gertler [38] añade la posibilidad de razonamiento aproximado (evidential reasoning) en la metodologı́a basada en modelos, aumentando

la capacidad de toma de decisiones en el diagnóstico.

Sin embargo, a veces el conocimiento previo sobre el proceso que se posee

es prácticamente nulo, pero en cambio se dispone de una gran cantidad de

datos de historial de variables del proceso. Para esos casos son aplicables

las técnicas basadas en datos. Este tipo de técnicas incluye desde métodos

estadı́sticos hasta métodos de inteligencia artificial como las redes neuronales.

Ası́, dentro de las técnicas basadas en datos se han propuesto metodologı́as

de reconocimiento de patrones (clasificadores), de redundancia analı́tica con

1.2. MOTIVACIÓN Y OBJETIVOS

17

modelos basados en datos y de control estadı́stico de procesos (Statistical

Process Control, SPC). Sorsa [84] aplica con éxito perceptrones multicapa en

la detección de fallos, usándolos como clasificadores. Dı́az [30] muestra, en

cuanto a la generación de residuos a partir de modelos basados en datos, las

ventajas de enfoques que tienen en cuenta el dominio de los datos en la etapa

de cálculo del modelo (GRNN, por ejemplo) frente a los que no (perceptrón

multicapa, Radial Basis Functions networks,. . . ). Wilson [103] presenta un

método en el que se halla un modelo basado en redes RBF (Radial Basis

Functions), con el que se realiza una proyección de los datos en un espacio

bidimensional y como criterio para detectar fallos se usa el error de modelado.

Esto último también lo realiza Harris [39], pero por medio de una red SOM

(Self-Organizing Map).

También son posibles combinaciones de técnicas basadas en datos con las

anteriormente mencionadas. Sugeno [86] estudia el modelado cualitativo basado en lógica difusa a partir de datos. De forma semejante, Lu [59] presenta

un sistema de diagnóstico de fallos para automóviles basado en un sistema

difuso, con la particularidad de que a partir de datos se deducen reglas y se

ajustan las funciones de pertenencia. Bonissone [14] trata las combinaciones

posibles entre las distintas técnicas de computación flexible (Soft Computing) aplicadas a tareas de diagnosis, control y predicción. Filippetti [34]

hace una recopilación de recientes desarrollos en el diagnóstico de fallos en

accionamientos de motores de inducción a través de técnicas de inteligencia

artificial, concretamente sistemas expertos basados en reglas, redes neuronales, lógica difusa y neuro-fuzzy.

Sin embargo, todas estas técnicas no pueden evitar completamente la posibilidad de detecciones erróneas, y muchas veces no dan información acerca

de cómo se realizó cada diagnóstico concreto, o no proporcionan una medida de la fiabilidad de dichos diagnósticos. Esto puede llegar a hacer que el

personal técnico desconfı́e de los equipos de monitorización basados en éstas

técnicas, o bien deje de confiar después de sucesivos diagnósticos erróneos.

Un enfoque bien distinto es el proporcionado por la técnicas de visualización aplicadas a la monitorización de la condición [56] [83] [93] [13]. En

ellas el diagnóstico final lo realiza el ser humano, gracias a que los datos

se han transformado y se representan de forma que éste pueda aprovechar

sus habilidades de procesamiento visual de la información, superiores a la de

cualquier máquina. Para llevarlo a cabo se cuenta con numerosas técnicas

de proyección no lineal, muy usadas en tareas de procesamiento de datos

de alta dimensionalidad en numerosos campos de la ciencia, como el SelfOrganizing Map (SOM) [53], Generative Topographic Mapping (GTM) [13],

Curvilinear Component Analysis (CCA) [23], y otras [89] [79]. Esta tesis se

centrará en este enfoque de visualización para la incorporación y extracción

18

CAPÍTULO 1. INTRODUCCIÓN Y OBJETIVOS

Técnicas basadas en

modelos analíticos

Ecuaciones de paridad

Estimación de parámetros

Observadores de estado

Técnicas basadas en

conocimiento

Métodos cualitativos

Sistemas expertos basados en reglas

Sistemas de inferencia borrosos

Técnicas basadas en

datos

Clasificadores

Redundancia analítica basada en datos

Control estadístico de procesos

Técnicas híbridas

Hibridación de técnicas de soft computing

Técnicas de visualización

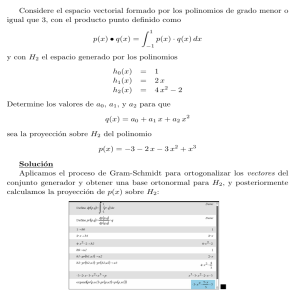

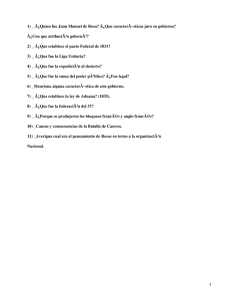

Figura 1.1: Clasificación de técnicas de detección y diagnóstico de fallos.

de conocimiento en la supervisión de procesos industriales.

1.3.

Formulación del problema

El planteamiento del problema de la supervisión de procesos complejos se

puede realizar a través de la Teorı́a de Sistemas en Espacio de Estados (ver

por ejemplo [69] para una explicación de las ideas básicas). El estado de un

sistema (el proceso) puede ser descrito completamente por un conjunto de

variables denominadas variables de estado. No existe un único conjunto de

variables de estado para un sistema, pero lo que siempre se cumple es que el

número de variables de estado en cada conjunto de un sistema es siempre el

mismo. Sea x(t) el vector de variables de estado en cada instante de tiempo

t. Este vector x(t) describe una trayectoria en el espacio de todos los posibles

estados del sistema X ⊂ Rn , siendo n el número de variables de estado del

sistema. Esta trayectoria será función del estado inicial del sistema x(t0 ), y de

las entradas u(t) que reciba el sistema en cada instante t ≥ t0 . Esta relación

se puede expresar como una ecuación diferencial, denominada ecuación de

estado:

ẋ(t) = f (x(t), u(t), t)

(1.1)

1.3. FORMULACIÓN DEL PROBLEMA

19

Las variables de estado de un sistema no tienen por qué ser accesibles para

medir, e incluso no necesariamente tienen interpretación fı́sica. Sin embargo,

los valores de las medidas que se puedan tomar en el sistema, dependerán

por un lado de su estado, y por otro de la entrada al sistema, lo cual se puede

expresar con la llamada ecuación de salida:

y(t) = g(x(t), u(t), t)

(1.2)

siendo y(t) un vector de medidas del proceso. La dependencia de t en (1.1) y

en (1.2) expresa el hecho de que tanto f como g pueden ser, en caso general,

variantes con el tiempo.

Cuando se trata de procesos complejos, la dimensión del espacio de estados puede ser enorme, haciendo el problema del seguimiento del estado

computacionalmente casi imposible. Sin embargo, manejar tal número de variables de estado puede ser totalmente innecesario para los objetivos que se

suelen plantear en la supervisión de procesos. Esto es exactamente lo que

ocurre, por ejemplo, en el estudio de un fluido. El “estado” de un fluido

puede caracterizarse tanto por variables macroscópicas (presión, temperatura, volumen; tres dimensiones) como por variables microscópicas (posición y

cantidad de movimiento de cada molécula; número de dimensiones de orden

superior a 1015 ). La elección de uno u otro punto de vista depende del nivel

de detalle necesario para los objetivos del estudio. Ası́, por ejemplo, para determinar en qué fase se encuentra un fluido en equilibrio, bastan las variables

macroscópicas “presión” y “temperatura”.

Basándose en estas ideas, se puede definir condición de un proceso como

un conjunto de estados del mismo que se etiquetan bajo el mismo nombre.

La distinción del estado dentro de cada conjunto en general no será relevante

para la supervisión. Es decir, una condición que podamos denominar “normal”, por ejemplo, corresponderá habitualmente a un conjunto de estados,

y el conocimiento del estado concreto en cada instante no interesará. Como

resultado, el espacio de estados del proceso quedará dividido en regiones y

el problema será determinar en qué región se encuentra el proceso en cada

instante, no el punto concreto.

Un enfoque visual para la supervisión de procesos tiene como objetivo la

representación gráfica de las regiones correspondientes a las diferentes condiciones de los procesos. Esto presenta un problema fundamental puesto que,

como ya se dijo, las variables de estado pueden no ser accesibles para su medición. La deducción del valor de x(t) a partir de un vector de medidas y(t) en

procesos complejos en general tampoco es posible, ya sea por la complejidad

de f y g, o por la no observabilidad [69] de dichos procesos.

Sin embargo, lo que se pretende no es hallar el valor de x(t), sino que

se trata de detectar la presencia del proceso en uno de los conjuntos de

20

CAPÍTULO 1. INTRODUCCIÓN Y OBJETIVOS

estados, o condiciones. Cabe pensar que el vector de medidas y(t) puede llevar

suficiente información sobre el estado para poder discernir en que condición

se encuentra el sistema en cada instante. En general, esta hipótesis no es

muy restrictiva y suele ser suficiente elegir de forma adecuada las variables a

medir en el sistema para que su condición se refleje en el vector de medidas.

Esta elección es lo que determina la función g. Como resultado, se traslada

el problema de la representación de las regiones de las distintas condiciones

en el espacio de estados a un problema equivalente pero en un espacio de

medidas.

La evolución a lo largo del tiempo del vector de medidas en su espacio

puede ser muy complejo. Aun permaneciendo el proceso en una determinada

condición, las medidas pueden estar variando de forma rápida y con patrones

complicados. Esto provoca que las regiones correspondientes a las distintas

condiciones del proceso estén fuertemente entrelazadas, resultando muy dificultosa su interpretación y separación en el mencionado espacio de medidas.

Teniendo en cuenta esto, se pueden clasificar las señales del proceso en dos

grandes grupos:

Señales estáticas, que son señales que pueden considerarse invariantes

respecto a la condición del proceso.

Señales dinámicas, que son señales que varı́an aun permaneciendo constante la condición del proceso.

De las señales estáticas se puede usar directamente su valor instantáneo para el vector de medidas. En cambio, sobre las señales dinámicas habrá que

realizar un proceso denominado extracción de caracterı́sticas que pretende

obtener un vector de parámetros representativos de la dinámica de la señal

(caracterı́sticas) que sean constantes respecto a la condición del proceso2 .

Se trata ası́ de eliminar la información redundante presente en el complicado patrón de variación de la señal original y que no sirva para diferenciar

condiciones del proceso. Como resultado de la extracción de caracterı́sticas

—incluyendo los valores de las señales estáticas, que pueden considerarse resultado de una extracción de caracterı́sticas trivial, o haber sufrido un filtrado

para eliminar ruido— de nuevo se ha trasladado el problema de un espacio a

otro, en este caso de un espacio de medidas a un espacio de caracterı́sticas.

Finalmente, ya sólo queda abordar el problema de la representación gráfica de la trayectoria que será indicación de la condición del proceso en el espacio de caracterı́sticas. Salvo procesos muy simples, el espacio de caracterı́sticas tendrá una dimensión mayor de tres y no será, por tanto, representable

2

Es decir, que no cambien a menos que cambie la condición del proceso.

1.3. FORMULACIÓN DEL PROBLEMA

21

gráficamente. La solución consiste en realizar una proyección del espacio de

caracterı́sticas en un espacio que se pueda representar (2D, por ejemplo) que

se denominará espacio de visualización.

En principio se podrı́an poner dos objeciones a esta solución. La primera es que en el espacio de caracterı́sticas aparecerán relaciones no lineales

entre variables (caracterı́sticas), al igual que ocurrı́a en el espacio de estados original entre las variables de estado. En ese caso, el uso de una técnica

de proyección lineal (por ser más simple) hará que probablemente se pierda

información referente a la condición del proceso. Es decir, regiones correspondientes a distintas condiciones del proceso podrı́an aparecer proyectadas

en el mismo lugar del espacio de visualización. Como segunda objeción, se

podrı́a argumentar que al proyectar se pierde toda la información sobre las

variables del proceso que se tenı́a en el espacio de caracterı́sticas y puesto

que las caracterı́sticas generalmente tendrán un significado fı́sico acerca del

proceso, convendrı́a conservarlas.

Para evitar el inconveniente apuntado por la primera objeción será necesario utilizar un método de proyección no lineal. Respecto al inconveniente

citado en la segunda objeción, a lo largo de esta tesis se verá que empleando

las técnicas adecuadas no sólo puede conservarse la información del proceso

que se poseı́a en el espacio de caracterı́sticas al proyectar sobre el espacio

de visualización, sino que además se facilitará la extracción de nuevo conocimiento en dicho espacio de visualización que relacione variables del proceso

del espacio de caracterı́sticas. Un esquema que ilustra las ideas mencionadas

en este apartado se muestra en la figura 1.2.

El resto de esta tesis se distribuye de la siguiente forma. En el capı́tulo 2

se describen las diferentes técnicas existentes para la supervisión de procesos.

En el capı́tulo 3 se explican las técnicas de reducción de la dimensión que

servirán de base para el planteamiento del enfoque de Data Mining Visual

para supervisión de procesos que se propondrá en el capı́tulo 4. Ello se complementa con una descripción, en el capı́tulo 5, de un método de aplicación de

redundancia analı́tica aprovechando las mismas técnicas de proyección que

se usan en Data Mining Visual. En el capı́tulo 6 se enmarcará este enfoque

de Data Mining Visual aplicado a supervisión dentro de un estándar de Data

Mining, como es CRISP-DM, y se describirá una implementación real de un

sistema de supervisión que aplica las técnicas de los capı́tulos 4 y 5, un sistema denominado MAPREX. Por último, se muestran algunos resultados de

aplicación a un motor de inducción en laboratorio y a un motor de continua

de 6000 kW de un tren de laminación en el capı́tulo 7, y se termina con las

conclusiones y algunas propuestas de trabajo futuro dentro de la misma lı́nea

en el capı́tulo 8.

(Inaccesible)

~ 1015D

Espacio de

Estados

(Significado físico)

~ 105D

Espacio de

Medidas

EC

(Todavía con significado físico)

~101D

Espacio de

Características

TP

?

AA prioriB

2D, 3D

Espacio de Visualización

C

no physical

meaning

Extracción de Características (EC)

Usa conocimiento previo sobre

Típicamente aprovecha la estructura

la geometría de las regiones

estadística de los datos.

O sobre la física del proceso

Conocimiento previo

se usa aquí para

Técnica de Proyección (TP)

la interpretación

Pocas o ninguna hipótesis

de las regiones.

sobre los datos.

El enfoque de Reducción de la Dimensión

sensores

22

CAPÍTULO 1. INTRODUCCIÓN Y OBJETIVOS

Figura 1.2: Esquema de reducción de la dimensión para el enfoque visual de

la supervisión de procesos.

Capı́tulo 2

Técnicas de Supervisión de

Procesos

2.1.

Introducción

Para poder hablar acerca de “supervisión de procesos” es necesario definir

previamente ciertos términos fundamentales. Se puede definir supervisión1

como la monitorización de un sistema fı́sico y la ejecución de las acciones

apropiadas para mantener el funcionamiento en caso de fallo. A su vez, se

entiende por monitorización (monitoring) como una tarea en tiempo real

para determinar las condiciones de un sistema fı́sico registrando información,

y reconociendo e indicando anomalı́as en su comportamiento.

Un fallo (fault) es una desviación no permitida de al menos una propiedad

caracterı́stica o variable del sistema respecto al comportamiento considerado

aceptable/usual/estándar/nominal. Un fallo total (failure) es un fallo que

implica una interrupción permanente de la capacidad del sistema para llevar a

cabo una función requerida bajo condiciones de funcionamiento especificadas.

Una perturbación es una entrada desconocida y no controlada actuando

sobre el sistema.

La detección de fallos (fault detection) es determinar si hay fallos presentes en el sistema. El aislamiento de fallos (fault isolation) es la determinación de la localización del fallo, es decir, de qué componente ha fallado.

La identificación de fallos (fault identification) es la determinación de la

cuantı́a y el comportamiento a lo largo del tiempo de un fallo.

Ası́, el término “diagnóstico de fallos” (fault diagnosis) de forma genérica

suele referirse algunas veces a detección, aislamiento e identificación de fallos,

y otras solamente a aislamiento e identificación de fallos. En la bibliografı́a

1

Estas y otras definiciones en este apartado han sido tomadas de [45].

23

24

CAPÍTULO 2. TÉCNICAS DE SUPERVISIÓN DE PROCESOS

fallos

ruido

entradas

perturbación

salidas

PLANTA

Generador

de residuos

(con modelo

de la planta)

residuos

Método de

decisión

diagnóstico

Figura 2.1: Diagrama de bloques de la aplicación de redundancia analı́tica.

están bien asentados términos como “detección y aislamiento de fallos” (FDI,

Fault Detection and Isolation) y “detección, aislamiento e identificación de

fallos” (FDII, Fault Detection, Isolation and Identification).

El problema de la detección, aislamiento e identificación de fallos es un

subconjunto del problema de la supervisión, puesto que en principio no incluye la actuación sobre el sistema estudiado para llevarlo al funcionamiento

considerado correcto. Sin embargo, si se puede llegar hasta la identificación

del fallo, la acción correctora a realizar suele ser inmediatamente deducible,

además de ser muy especı́fica del problema y proceso concreto.

Son muchas las herramientas usadas en el problema de la detección, aislamiento e identificación de fallos. Generalmente las técnicas usadas para ese

fin se basan en el uso de modelos del sistema, en muy diversas formas, que

son usados como referencia para comparar con el comportamiento real del

sistema y descubrir fallos (desviaciones en el comportamiento del sistema).

Esta idea, denominada redundancia analı́tica deriva del uso que se hizo tradicionalmente de múltiples elementos (sensores, indicadores, etc.) realizando

la misma función (midiendo la misma magnitud) para poder ser comparados y detectar fallos en ellos2 y a lo que se denomina redundancia fı́sica. Un

esquema de un sistema de redundancia analı́tica se representa en la figura

2.1.

Existe una clase de métodos, muy empleados, denominados métodos de

2

Con dos se detecta que hay fallo, con más se puede detectar qué elemento, o elementos,

según número, han fallado.

2.2. TÉCNICAS BASADAS EN MODELOS ANALÍTICOS

25

umbral que, estrictamente hablando, usan modelos —muy burdos, en ciertos

casos— consistentes en la comprobación de lı́mites y el análisis frecuencial

(o modelos de señales en general, como lo denomina Isermann [46] [44]).

Los modelos más simples después de los mencionados, menos frecuentemente aplicables en procesos complejos, son los modelos lineales. Los modelos

lineales de sistemas han sido ampliamente estudiados por la Teorı́a de Control y para ellos existen multitud de técnicas aplicables a detección de fallos.

Otra forma de modelar sistemas, aplicable ya a sistemas más complejos, deriva de la llamada fı́sica cualitativa. Los modelos cualitativos son descripciones

no numéricas de los sistemas y están orientados a captar los aspectos fundamentales del sistema o mecanismo, suprimiendo gran parte del detalle y

manteniendo las propiedades más significativas de su comportamiento. Los

sistemas expertos basados en reglas y los sistemas borrosos de inferencia se

basan también en este conocimiento impreciso tı́pico del ser humano.

Muchas veces no se dispone ni de modelos analı́ticos ni de conocimiento

del proceso pero sı́ de una cantidad ingente de datos provenientes del mismo.

En estos casos tradicionalmente se han aplicado técnicas estadı́sticas y, más

recientemente, han aparecido técnicas que apenas dependen de una estructura fija para el modelo y sı́ más de un gran número de parámetros que se

obtienen a partir de los datos por medio de un “aprendizaje” o “entrenamiento”. Las redes neuronales, por ejemplo, son buenos aproximadores de

funciones no lineales y son por tanto muy útiles cuando se trata con sistemas

complejos.

En los siguientes apartados se profundizará algo más en todas éstas técnicas y en sus ámbitos de aplicación, que dependen de la información previa

que se tenga del sistema o proceso.

2.2.

Técnicas basadas en modelos analı́ticos

Las técnicas basadas en modelos analı́ticos son aplicables cuando se tienen

modelos analı́ticos del sistema (ecuaciones explı́citas). Esto ocurre especialmente con sistemas lineales. En muchos casos, sin embargo, no son aplicables

estos métodos porque los modelos disponibles son sólo aproximaciones que

no son lo suficientemente precisas [70] [44].

26

CAPÍTULO 2. TÉCNICAS DE SUPERVISIÓN DE PROCESOS

2.2.1.

Ecuaciones de paridad

Se basa en expresar el comportamiento del sistema por medio de ecuaciones diferenciales3 lineales explı́citas de la forma:

fi (x) = 0

i = 1, . . . , n

(2.1)

donde x es el vector de variables y sus derivadas. Cuando, en un momento

determinado de la evolución del proceso, no se cumple el modelo dado por

esas ecuaciones debido a un fallo se obtiene:

fi (x) = i

i = 1, . . . , n

(2.2)

donde al menos un i es distinto de cero. Esos i se denominan residuos.

Un residuo es, en general, un indicador de fallo basado en la desviación

entre medidas y cálculos derivados de modelos del sistema. La utilidad de

los residuos no reside sólo en su capacidad para detectar fallos, sino también

para aislarlos. Esto es posible transformando las ecuaciones de forma que

cada i sea indicador de un determinado fallo [37] [38].

Realmente los residuos nunca son exactamente nulos debidos a imprecisiones del modelo y ruidos en las medidas. Debido a ellos hay que aplicar

sobre los residuos métodos de decisión.

2.2.2.

Estimación de parámetros

Los métodos de estimación de parámetros se basan en modelos analı́ticos

para detectar e identificar los fallos a través de desviaciones en los parámetros

del proceso respecto a valores esperados. Los parámetros del proceso pueden

estimarse de forma continua (on line) a través de técnicas como RLS, el filtro

de Kalman, etc.

Un caso especialmente interesante se presenta cuando los parámetros tienen un significado fı́sico claro (la resistencia del rotor en un motor de inducción, por ejemplo [6]). En esos casos es inmediata la aplicación de conocimiento experto para el aislamiento de los fallos.

Una forma particular de estimación de parámetros se aplica cuando existe

una variable que no es medible o fácilmente medible directamente, pero se

puede deducir de otras variables que si están accesibles para su medición.

Las técnicas que se emplean con este fin suelen recibir el nombre de sensores

virtuales [73].

3

O ecuaciones en diferencias para sistemas muestreados.

2.3. TÉCNICAS BASADAS EN CONOCIMIENTO

2.2.3.

27

Observadores de estado

Este tipo de métodos también están basados en modelos analı́ticos. Se

detectan e identifican los fallos a través de la estimación del estado por medio

de técnicas como el filtro de Kalman, el filtro de Wiener, etc., denominados,

en general, observadores.

2.3.

Técnicas basadas en conocimiento

Cuando no se dispone de modelos analı́ticos del proceso, una alternativa

la constituye lo que se puede denominar como técnicas basadas en conocimiento. Estas técnicas hacen uso del conocimiento acerca del proceso de

carácter incompleto e impreciso, tı́pico del ser humano, y que es codificado

y representado de diversas formas, como se verá a continuación.

2.3.1.

Métodos cualitativos

Una forma de modelar sistemas aplicable a sistemas complejos deriva de

la llamada fı́sica cualitativa o también razonamiento cualitativo [35] [57].

Los modelos cualitativos son descripciones no numéricas de los sistemas y

están orientados a captar los aspectos fundamentales del sistema o mecanismo, suprimiendo gran parte del detalle y manteniendo las propiedades más

significativas de su comportamiento.

Por medio de simulación cualitativa se puede obtener la evolución del

sistema a través de diferentes estados cualitativos. Un ejemplo puede ser la

descripción del estado cualitativo de un balón subiendo:

la posición del balón está ascendiendo y la velocidad hacia

arriba está descendiendo.

Posteriormente, por simulación cualitativa, se obtendrı́a el resultado de que

el balón en algún punto de su ascenso se detendrá y comenzará a descender

(sucesión de estados cualitativos). En muchos casos, dependiendo del nivel

de detalle de la información que se usa en la simulación (resolución), pueden

obtenerse diferentes soluciones alternativas para dicha sucesión de estados.

Para intentar eliminar estas ambigüedades se puede añadir información

cuantitativa. Una simulación semicuantitativa es una simulación cualitativa

que usa información cuantitativa, como valores numéricos o intervalos, para

restringir (acotar) sus resultados [95] [47].

28

CAPÍTULO 2. TÉCNICAS DE SUPERVISIÓN DE PROCESOS

2.3.2.

Sistemas expertos basados en reglas

Los sistemas expertos basados en reglas (rule-based expert systems) identifican fallos por medio de conocimiento sobre el proceso puesto en forma de

un conjunto de reglas “SI-ENTONCES” de la forma:

SI sı́ntoma ENTONCES conclusión

donde la conclusión de una regla puede servir como sı́ntoma de otra. El sistema experto las evalúa hasta que llega a conclusiones finales que serán sobre

la existencia o no de fallos y su aislamiento. Los sı́ntomas en las primeras reglas del árbol de deducciones serán relaciones de observaciones en el proceso

(medidas de variables o valores derivados de éstas, propiedades del proceso

que pueden ser percibidas por el operador, etc.) [34] [37] [76]. El conjunto de

reglas que usa el sistema experto se denomina base de conocimiento. El elemento que realiza el proceso de razonamiento o decisión se denomina motor

de inferencia.

2.3.3.

Sistemas de inferencia borrosos

Los sistemas de inferencia borrosos (FIS, Fuzzy Inference System) son

semejantes a los sistemas basados en reglas del apartado anterior en cuanto

a que el conocimiento se expresa en forma de reglas “SI-ENTONCES”. Sin

embargo, los sistemas borrosos son mucho más adecuados cuando se trata

con información vaga, imprecisa e incompleta [48] [58].

Un sistema de inferencia borroso (en adelante FIS), cuyo esquema se

muestra en la figura 2.2, incluye tres elementos:

Un conjunto de reglas, que codifican un conocimiento disponible.

Un conjunto de funciones de pertenencia, cuya finalidad es codificar y

decodificar información numérica en información difusa (borrosa).

Un mecanismo de razonamiento, que realiza la inferencia a partir de

las reglas y unas variables de entrada o “hechos” para obtener unas

variables de salidas o “conclusiones”.

Un FIS funciona de la siguiente manera4 . Las variables de entrada pueden

ser crisp (valores numéricos concretos) o fuzzy (valores imprecisos). Lo que

en la figura 2.2 aparece como (x es A1 ) es una forma compacta de expresar:

(x1 es A11 ) y (x2 es A21 ) y . . . y (xn es An1 )

4

Como ejemplo de FIS se va a explicar el caso de un FIS Mamdani.

2.3. TÉCNICAS BASADAS EN CONOCIMIENTO

29

Regla 1

x es A1

w1

y es B1

(Fuzzy)

Regla 2

x

x es A2

w2

y es B2

(Fuzzy)

Agregador

(Crisp o

fuzzy)

(Crisp)

Defuzzificador

y

Regla r

x es Ar

wr

y es Br

(Fuzzy)

Figura 2.2: Diagrama de bloques de un sistema de inferencia borroso.

que es el antecedente de la regla. Con (x1 es A11 ) se está evaluando la pertenencia del valor de x1 a un conjunto borroso denominado A11 . Al contrario

que en la teorı́a de conjuntos crisp tradicional, donde la pertenencia de un

elemento a un conjunto sólo puede ser “pertenece ” o “no pertenece” (1 o

0 respectivamente), en los conjuntos borrosos la pertenencia puede ser cualquier valor real en el intervalo [0, 1], indicando un mayor grado de pertenencia

cuanto más se acerque dicho valor a 1. La pertenencia de una variable a un

conjunto borroso se define por medio de una función de pertenencia que tiene el mismo dominio que la variable en cuestión y devuelve valores en el

intervalo [0, 1].

Los resultados de evaluar los (xi es Aij ) se combinan por los operadores lógicos (“y”, “o”) que intervengan en cada regla (en el ejemplo sólo hay

“y”). Estos operadores lógicos se denominan respectivamente t-norma y tconorma, y existen varias opciones en cuanto la elección de estos operadores

mientras cumplan ciertas condiciones. Se suelen tomar las funciones “mı́nimo” y “máximo” respectivamente.

El siguiente paso es evaluar el consecuente “entonces (y es Bi )”. La implicación consiste en recortar la función de pertenencia que aparece en el

consecuente, que en este caso denominamos Bi , con el resultado que se obtuvo en el antecedente wi (grado de cumplimiento o fuerza de activación). Como

resultado se obtiene una nueva función de pertenencia (variable borrosa).

Todo estos pasos se realizan para cada regla. Posteriormente hay que

agregar los resultados de todas las reglas para obtener un único resultado

30

CAPÍTULO 2. TÉCNICAS DE SUPERVISIÓN DE PROCESOS

borroso. Ello se suele hacer con una t-conorma (la función máximo, por

ejemplo). Finalmente, si lo que se necesita es un resultado crisp, hay que

realizar lo que se denomina defuzzificación, que consiste en extraer un único

valor a partir de la función de pertenencia resultado de la agregación de las

reglas. Existen varios métodos para realizarlo, como pueden ser el centroide

del área bajo la función, el bisector de dicha área, la media de los puntos

donde la función de pertenencia es máxima, el extremo superior de los puntos

donde es máxima, el extremo inferior de los puntos donde es máxima, etc.

Se puede observar que un FIS es equivalente a una función no lineal

y = f (x), o lo que es lo mismo, una hipersuperficie, y puede constituir, por

tanto, un modelo de un proceso [86] [48] [58] [59] [9]. Esta idea se utiliza en

el apartado 4.5.5.

2.4.

Técnicas basadas en datos

Además de los modelos analı́ticos y el conocimiento fı́sico que se tiene del

funcionamiento de un proceso, existe otra importante fuente de información

acerca del mismo: las magnitudes medibles en él durante su funcionamiento.

2.4.1.

Clasificadores

Los clasificadores son un conjunto de técnicas incluidas en la disciplina

denominada Reconocimiento de Patrones que sirven para indicar a qué grupo

pertenece un dato muestra de entre un conjunto de grupos predeterminados.

Este tipo de técnicas son muy útiles cuando se dispone de datos del proceso

para los diferentes estados o tipos de fallos que se quieren detectar, que aparecerán en dichos datos como agrupaciones. Al implementar un clasificador,

se le proporcionan los datos de los que se dispone y, posteriormente, ante

datos nuevos “decide” a qué grupo de los datos proporcionados previamente

pertenecen. Algunos métodos generan además una probabilidad o grado de

pertenencia a cada uno de los grupos, que da una idea de la fiabilidad de la

clasificación de cada nuevo dato. Existen multitud de tipos de clasificadores,

pero en los siguientes subapartados sólo se menciona un pequeño número

de ellos. Una descripción más completa puede encontrarse en bibliografı́a de

Reconocimiento de Patrones [12] [32] [90].

Clasificadores no supervisados

Los clasificadores no supervisados (también llamadas técnicas de clustering) no necesitan conocer de antemano la pertenencia de cada dato de

2.4. TÉCNICAS BASADAS EN DATOS

31

entrenamiento para realizar los agrupamientos, por lo que estas técnicas se

pueden aplicar cuando no se dispone de dicha información. Si se dispone de

ella, sin embargo, esa información puede utilizarse posteriormente para evaluar la calidad de los agrupamientos y para “etiquetar” (ponerle nombre) a

cada grupo.

Existe una enorme variedad de métodos de clasificación no supervisados.

Entre los métodos más conocidos con origen estadı́stico se tiene k-means.

Una generalización de éste empleando funciones de pertenencia borrosas es

el llamado fuzzy c-means, que proporciona un grado de certeza de pertenencia

a cada grupo de datos. También existen clasificadores no supervisados entre

las redes neuronales, como el Self-Organizing Map (SOM).

Existen también técnicas que realizan agrupamientos a distintos niveles

de detalle. Son las técnicas de Agrupamiento Jerárquico, que pueden tener

dos enfoques: aglomerativo, que partiendo de datos individuales van creando

grupos cada vez más grandes, y partitivo, que parten de un único grupo que

se descompone progresivamente en grupos más pequeños.

Clasificadores supervisados

Estas técnicas de clasificación de patrones aprovechan la información suministrada por un “tutor” externo, relativa a la pertenencia a grupos predeterminados de los datos que se usan en su aprendizaje. Entre los métodos

con base estadı́stica se encuentran, por ejemplo, los clasificadores de Bayes y

el discriminante de Fisher.

Otros métodos son Learning Vector Quantization (LVQ) [53] [54], Support

Vector Machines [81], redes neuronales feedforward [100] [102] [36] y redes

RBF (Radial Basis Functions) [12] [41].

El uso de clasificadores supervisados permite la aplicación posterior de

la filosofı́a del razonamiento basado en casos (Case-Based Reasoning), que

para supervisión de procesos consistirı́a en la interpolación y extrapolación

sobre casos ya conocidos en cuanto a diagnóstico y aplicación de acciones

correctoras.

2.4.2.

Redundancia analı́tica basada en datos

Una caracterı́stica deseable en los métodos de clasificación aplicados a

FDI es poder detectar “novedades” (novelty detection), o lo que es lo mismo,

datos que no pertenecen a ninguno de los grupos predeterminados y que,

por tanto, corresponderán con condiciones nuevas del proceso, condiciones

que no se presentan en los datos disponibles previamente. Esta caracterı́stica

está muy relacionada con la generación de residuos. La generación de residuos

32

CAPÍTULO 2. TÉCNICAS DE SUPERVISIÓN DE PROCESOS

a partir de modelos no sólo es posible con modelos analı́ticos, sino también

con modelos que se pueden denominar “basados en datos”.

Puede decirse que un modelo basado en datos se diferencia de uno analı́tico en que su estructura es bastante genérica y polivalente, es decir, aplicable

a cualquier sistema, lineal o no lineal. En un modelo analı́tico tiene tanta

importancia (o quizá más) la estructura como los parámetros. En un modelo basado en datos, sin embargo, la dificultad estriba en encontrar unos

parámetros adecuados. Dichos parámetros se hallarán por aprendizaje o entrenamiento a partir de datos tomados del proceso. Este aprendizaje o entrenamiento consiste en la aplicación de métodos de optimización de una función

objetivo relacionada con el error de ajuste a los datos de entrenamiento.

La idea básica de la redundancia analı́tica basada en datos es semejante

a la de modelos analı́ticos. Se le introduce al modelo un vector de variables

(caracterı́sticas) del proceso y el generador de residuos devuelve un vector de

residuos que da indicaciones de fallos.

En sucesivos capı́tulos se verá que usando una técnica de proyección (proyección lineal, red neuronal autoasociativa, mapa topológico, etc.) el generador de residuos puede consistir en proyectar el vector de variables del proceso

en el subespacio topológico definido por el modelo de datos, siendo el vector

de residuos la diferencia entre en el original y el proyectado [104] [103] [26]

[30].

2.4.3.

Control estadı́stico de procesos

El control estadı́stico de procesos (Statistical Process Control, SPC) ha

sido tradicionalmente aplicado al control de calidad de productos de fabricación por lotes (batch). Básicamente trata de comparar el estado actual

del proceso con las condiciones operativas consideradas normales; cuando no

está en dichas condiciones normales, se dice que el proceso está fuera de

control. Los métodos clásicos se basan en la representación en gráficas de la

evolución de unas pocas caracterı́sticas de calidad obtenidas en cada lote a

partir de muestras del producto final. Los gráficos de Shewhart, CUSUM y

EWMA (Exponentially Weighted Moving Average), son métodos monovariable de este estilo [4], aunque también existen versiones multivariable de los

mismos.

Recientemente se ha derivado hacia enfoques multivariable y on line, más

precisos y que permiten acciones correctoras inmediatas sobre el proceso.

Ejemplos de este último enfoque son las técnicas Multiway Principal Component Analysis (MPCA) y Multi-way Partial Least Squares (MPLS), muy

relacionadas con las técnicas de visualización multivariable del siguiente apartado, y los gráficos de contribución (contribution plots) [63] [42] [33].

2.5. TÉCNICAS HÍBRIDAS

2.5.

33

Técnicas hı́bridas

La clasificación expuesta en este capı́tulo no pretende abarcar todos los casos posibles, sino quizá los más relevantes en la bibliografı́a sobre diagnóstico

de fallos. Serı́a importante resaltar que también existen múltiples combinaciones de muchos de ellos, que podrı́amos denominar técnicas hı́bridas, y que

intentan aprovechar las ventajas de cada técnica, combinando información

sobre el proceso de las diversas fuentes: modelos analı́ticos, conocimiento,

datos [14].

El conocimiento a priori particularmente está presente en formas muy

diversas y sutiles —en forma lingüı́stica, en imágenes, . . . — y todos ellos

generalmente son de carácter impreciso, difuso. Los métodos matemáticos

que aprovechan estas caracterı́sticas de la forma de razonar del ser humano

están en auge en los últimos años. Debido a este carácter heterogéneo del

conocimiento, muchos de esos métodos hay que clasificarlos como técnicas

hı́bridas puesto que combinan técnicas que por separado se ocupan de un

sólo aspecto de la forma de razonar del ser humano. Como primeros ejemplos de aplicación práctica se pueden mencionar la combinación de métodos

analı́ticos con métodos basados en conocimiento como la lógica borrosa [46]

[70] [3], el uso de métodos de datos para obtener una interpretación cualitativa [101], sistemas expertos y redes neuronales [99], y la generación de reglas

borrosas y funciones de pertenencia a partir de datos [59] [68].

Un caso en el que la hibridación se da frecuentemente es entre técnicas de

soft computing. Soft computing (computación flexible) es un grupo de metodologı́as de computación que incluye la lógica borrosa, las redes neuronales,

la computación evolutiva y la computación probabilı́stica [14]. En general son

todas metodologı́as que aprovechan la tolerancia a la imprecisión, la incertidumbre y la verdad parcial para conseguir maleabilidad, robustez, bajo coste

en la solución, y mayor compenetración con la realidad. Está especialmente

extendida la combinación de redes neuronales con lógica borrosa, aportando

las primeras su capacidad para aprender de datos y añadiéndose la posibilidad de interpretar lo aprendido de los datos en términos de lógica borrosa

[66] [34] [48] [58]. Un ejemplo de hibridación de computación evolutiva con

redes neuronales es el uso de la primera para la elección de la topologı́a o el

cálculo de los pesos de las segundas.

Un caso particular de hibridación, que se considerará aparte por constituir

el tema central de esta tesis, es el caso de las técnicas de visualización.

34

CAPÍTULO 2. TÉCNICAS DE SUPERVISIÓN DE PROCESOS

2.5.1.

Técnicas de visualización

El objetivo final de prácticamente todas las técnicas mencionadas hasta

ahora es el de detectar y dar diagnósticos de fallos, desde los más incipientes hasta los más severos, a través de la información recogida del proceso

en diversas formas y de múltiples procedencias —principalmente datos, pero

también información proveniente de los sentidos (información visual, auditiva, olfativa, etc.)— que es comparada con los modelos del proceso generados

a partir de información y conocimiento acerca del proceso disponibles previamente, también en varias formas. Todo ello es realizado generalmente de

forma automática5 por el sistema de diagnóstico, que es una máquina (computador). Sin embargo, con este enfoque, las habilidades del ser humano en

cuanto a reconocimiento de patrones (sobre todo de forma visual), superiores

a las de cualquier máquina, no son aprovechadas.

La idea de las técnicas de visualización es “traducir” modelos de comportamiento complejos a forma visual [15] [50] [51] [52]. La información se

puede codificar para fluir a través de diversos canales visuales de transmisión

multidimensional: color, tamaño, posición, forma, movimiento. El espectador (observador), posteriormente, pasa de patrones visuales a la abstracción,

genera modelos mentales, razona con ellos e incluso puede filtrar ruido empleando conocimiento a priori. Por supuesto, para que todo ello sea efectivo

hay conseguir reducir una cantidad ingente de datos a la información estrictamente necesaria y útil, y elegir las formas de representación gráfica más

adecuadas.

Esta tesis transcurrirá en esta lı́nea de aplicación de técnicas de visualización. Ası́, el enfoque aquı́ adoptado consiste en aplicar las técnicas de

reducción de la dimensión para proyectar datos del proceso con multitud

de variables sobre un espacio visualizable, para posteriormente “cartografiar” este espacio, relacionando cada zona con cada condición del proceso,

pudiendo usar para este fin conocimiento expresable en forma de reglas difusas (mapas borrosos), modelos analı́ticos conocidos (mapas de modelos) y

casos conocidos —datos etiquetados— (mapas de activación). Este enfoque

también hace posible la extracción de nuevo conocimiento acerca del proceso

(data mining, minerı́a de datos) en este espacio de visualización (mapas de

correlaciones), dejando todavı́a la puerta abierta a numerosas ideas dentro

de esta misma lı́nea.

5

O semiautomática. Obviamente la información recogida por los sentidos del operario

o técnico, por ejemplo, debe introducirse en el sistema de diagnóstico de forma manual.

Capı́tulo 3

Técnicas de Reducción de la

Dimensión

3.1.

Introducción

Las técnicas de reducción de la dimensión se usan tı́picamente en problemas con manejo de datos de alta dimensionalidad (gran número de variables).

Los objetivos más comunes que justifican el empleo de técnicas de reducción

de la dimensión son esquivar inconvenientes como la maldición de la dimensionalidad (curse of dimensionality), la mejora de la capacidad de generalización en clasificadores y la reducción de los requerimientos computacionales

en la clasificación de patrones [62].

En el marco de Data Mining Visual, en el que se encuadra esta tesis, el

objetivo es llegar hasta un espacio visualizable (2D, 3D) donde sean representables los conceptos procedentes del espacio multidimensional original, que

son con los que es posible razonar. En la aplicación de Data Mining Visual

a procesos complejos son imprescindibles las técnicas de reducción de la dimensión, incluso varias usadas en cadena, puesto que tales procesos son, por

naturaleza, de una altı́sima dimensionalidad. Se puede realizar una clasificación de estas técnicas atendiendo a la aplicación de conocimiento previo, de

los datos y del problema en sı́, que requieren:

Selección de variables. Puede realizarse tanto usando conocimiento previo como sin él (de forma automática).

Extracción de caracterı́sticas. Generalmente se aplica conocimiento previo en la elección de caracterı́sticas.

Técnicas de proyección. No suelen aplicar conocimiento previo, sino

sólo consideraciones en la geometrı́a de la distribución de los datos.

35

36

CAPÍTULO 3. TÉCNICAS DE REDUCCIÓN DE LA DIMENSIÓN

Además, este orden expuesto suele ser en general el orden de aplicación a los

datos de este tipo de técnicas, y en particular para Data Mining Visual. A

lo largo de este capı́tulo se describirán diversas técnicas disponibles de los

tres tipos, haciendo especial énfasis en aquellas más útiles para Data Mining

Visual.

3.2.

Selección de variables

Cuando el número de variables del proceso disponibles inicialmente es

extremadamente grande, de tal forma que aparecen problemas derivados de

la maldición de la dimensionalidad (curse of dimensionality) [7], puede ser

necesario un paso previo de selección de variables, que puede realizarse tanto

aplicando conocimiento a priori —escogiendo variables que ya se sabe que

son significativas en cuanto a la condición del proceso— como por métodos estadı́sticos —basándose en medidas de la cantidad de información que

contiene cada variable o grupo de variables—.

Un esquema tı́pico para la selección del subconjunto de variables óptimo

por métodos estadı́sticos tiene dos partes:

1. Escoger un criterio de selección: para decidir de entre dos subconjuntos

de variables cual es mejor. Cuando se trata de diseño de clasificadores

para reconocimiento de patrones, el criterio suele ser la minimización

del error de clasificación. En otros casos los criterios pueden derivar de

la Teorı́a de la Información (entropı́a, información mutua, etc.). Entre

posibles criterios de selección se encuentran los métodos de contrastes

de hipótesis y los de medidas de separabilidad de clases (divergencia1 ,

lı́mite de Chernoff y distancia de Brattacharyya, matrices de dispersión).

2. Ejecutar un procedimiento de búsqueda: escoger subconjuntos de variables para compararlos posteriormente por medio del criterio de selección

mencionado. Para esta búsqueda existen multitud de métodos:

Búsqueda exhaustiva (exhaustive search).

Rama y lı́mite (branch and bound ).

Selección secuencial hacia adelante (sequential forward selection).

Genera soluciones no óptimas pero es más rápido.

1

Una forma de la medida de distancia Kullback-Leibler.

3.3. EXTRACCIÓN DE CARACTERÍSTICAS

37

Eliminación secuencial hacia atrás (sequential backward elimination). Al igual que el anterior genera soluciones no óptimas pero

es más rápido.

Búsqueda flotante (floating search).

Algoritmos de Programación Dinámica.

Estos métodos son también aplicables a caracterı́sticas (resultado de extracciones de caracterı́sticas, que se verán en el siguiente apartado) en lugar

de a variables. En ese caso, estos métodos se pueden denominar “pasivos”

porque seleccionan caracterı́sticas de entre las ya obtenidas. Existen también

métodos que se pueden denominar “activos” que tratan de hallar caracterı́sticas que sean óptimas.

Se puede encontrar abundante información sobre estas técnicas en algunas

de las referencias clásicas de Reconocimiento de Patrones [12] y [90].

3.3.

Extracción de caracterı́sticas

El primer obstáculo que se encuentra al interpretar los datos que se generan en un proceso es el gran volumen de los mismos. Los datos pueden

imaginarse organizados como una gran matriz en la que las filas son las m

variables del proceso y las columnas son las n sucesivas muestras de dichas

variables tomadas a lo largo del tiempo, como se puede ver en la figura 3.1. El

número total de datos vendrá dado por el producto de ambos valores: m · n.

Una de las justificaciones del proceso de extracción de caracterı́sticas es la

pretensión de reducir este valor. La razón es la gran carga computacional que

suele conllevar en pasos posteriores ese gran volumen de datos.

Otra razón para aplicar una extracción de caracterı́sticas a los datos procedentes de un proceso es la reducción de la complejidad en la variaciones de

los datos. El objetivo último es la detección de diferentes condiciones en el

proceso y un patrón de variación complejo en los valores de sus variables a lo

largo del tiempo dificulta dicho objetivo. Se trata, en definitiva, de obtener

un vector de caracterı́sticas invariante a la condición, es decir, que no cambie

a menos que cambie la condición del proceso, como se planteó en el apartado

1.3. Respecto a este problema de búsqueda de invarianza ante la condición

se puede hablar de dos tipos de señales:

1. Señales estáticas. Son señales consideradas invariantes respecto a la

condición del proceso. De ellas se usarán como caracterı́sticas sus valores instantáneos (o filtrados, medias, para eliminar ruidos). Ejemplo

tı́pico de señal estática es la temperatura.

38

CAPÍTULO 3. TÉCNICAS DE REDUCCIÓN DE LA DIMENSIÓN

2. Señales dinámicas. Son señales que varı́an aun permaneciendo el proceso dentro de una condición dada. Requieren la aplicación de técnicas

que generen caracterı́sticas que sean invariantes respecto a la condición. Ejemplo de ello pueden ser las técnicas de análisis espectral, para

la obtención de energı́as en determinadas bandas de frecuencias de cada señal. En estos caso puede obtenerse más de una caracterı́stica por

cada variable del proceso (varias bandas) o puede interesar caracterizar

una señal dinámica por un único valor (su valor eficaz por ejemplo).

Ejemplo tı́pico de señal dinámica es la vibración.