LINEAR DISCRIMINANT ANALYSIS

Anuncio

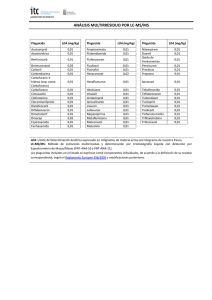

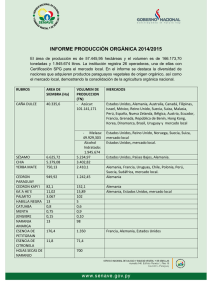

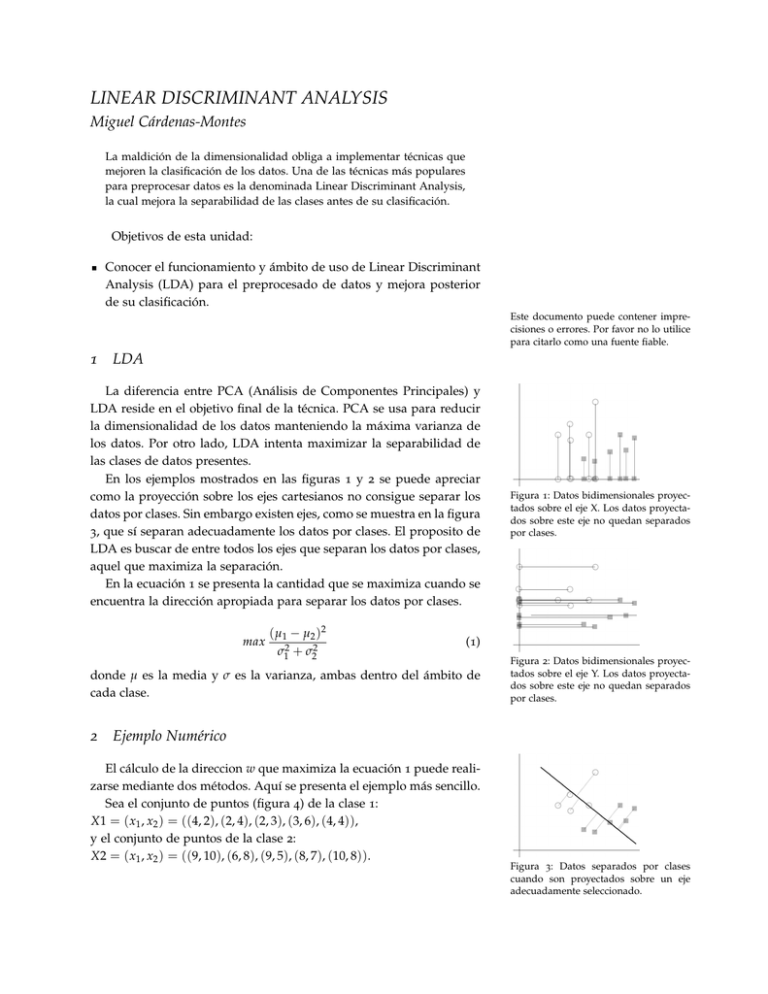

LINEAR DISCRIMINANT ANALYSIS Miguel Cárdenas-Montes La maldición de la dimensionalidad obliga a implementar técnicas que mejoren la clasificación de los datos. Una de las técnicas más populares para preprocesar datos es la denominada Linear Discriminant Analysis, la cual mejora la separabilidad de las clases antes de su clasificación. Objetivos de esta unidad: Conocer el funcionamiento y ámbito de uso de Linear Discriminant Analysis (LDA) para el preprocesado de datos y mejora posterior de su clasificación. Este documento puede contener imprecisiones o errores. Por favor no lo utilice para citarlo como una fuente fiable. 1 LDA La diferencia entre PCA (Análisis de Componentes Principales) y LDA reside en el objetivo final de la técnica. PCA se usa para reducir la dimensionalidad de los datos manteniendo la máxima varianza de los datos. Por otro lado, LDA intenta maximizar la separabilidad de las clases de datos presentes. En los ejemplos mostrados en las figuras 1 y 2 se puede apreciar como la proyección sobre los ejes cartesianos no consigue separar los datos por clases. Sin embargo existen ejes, como se muestra en la figura 3, que sí separan adecuadamente los datos por clases. El proposito de LDA es buscar de entre todos los ejes que separan los datos por clases, aquel que maximiza la separación. En la ecuación 1 se presenta la cantidad que se maximiza cuando se encuentra la dirección apropiada para separar los datos por clases. max ( µ1 − µ2 )2 σ12 + σ22 (1) donde µ es la media y σ es la varianza, ambas dentro del ámbito de cada clase. 2 Figura 1: Datos bidimensionales proyectados sobre el eje X. Los datos proyectados sobre este eje no quedan separados por clases. Figura 2: Datos bidimensionales proyectados sobre el eje Y. Los datos proyectados sobre este eje no quedan separados por clases. Ejemplo Numérico El cálculo de la direccion w que maximiza la ecuación 1 puede realizarse mediante dos métodos. Aquí se presenta el ejemplo más sencillo. Sea el conjunto de puntos (figura 4) de la clase 1: X1 = ( x1 , x2 ) = ((4, 2), (2, 4), (2, 3), (3, 6), (4, 4)), y el conjunto de puntos de la clase 2: X2 = ( x1 , x2 ) = ((9, 10), (6, 8), (9, 5), (8, 7), (10, 8)). Figura 3: Datos separados por clases cuando son proyectados sobre un eje adecuadamente seleccionado. m Figura 4: Ejemplo práctico de aplicación de LDA. 10 10 8 8 6 6 Y m Y 2 4 4 2 2 0 0 2 4 X 6 8 10 (a) Datos originales. 0 0 2 4 X 6 8 10 (b) Datos originales con la línea de proyección que maximiza la separabilidad de las clases. Para cada clase se construye su matriz de covarianza. En el ejemplo es para la primera clase: ! 1,0 −0,5 −0,5 3,3 y para la segunda clase: 2,3 −0,05 −0,05 3,3 ! Posteriormente se contruya la matriz de dispersión dentro de las clases como Sw = S1 + S2: ! 3,3 −0,55 −0,55 6,6 También se construye la media de los puntos de cada clase: µ1 = (3,0, 3,6) y µ2 = (8,4, 7,6), y se hace la diferencia µ1 − µ2 = (−5,1, −4,0). Finalmente se calcula el producto de la inversa de la matriz Sw por µ1 − µ2 . ! −15,62 −1 w = Sw · ( µ1 − µ2 ) = −23,43 La recta que pasa por los puntos (0, 0) y (−15,62, −23,43) también pasa por (15,62, 23,43). Esta recta está representada justo a los datos en la figura 4. Como se puede apreciar, la proyección de los puntos sobre dicha recta los separa por clases.