unidad ii - WordPress.com

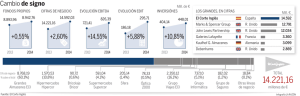

Anuncio