Teoría. Probabilidad.

Anuncio

Índice general

Índice general

I

1. Teorı́a de la Probabilidad

1.1. Medida de Probabilidad . . . . . . . . . . . . . . . . . . .

1.2. Asignación de Probabilidades . . . . . . . . . . . . . . . .

1.2.1. Conteo: Conceptos Fundamentales de Combinatoria

1.3. Probabilidad Condicional . . . . . . . . . . . . . . . . . . .

1.3.1. Dependencia e Independencia . . . . . . . . . . . .

1.4. Teorema de Bayes . . . . . . . . . . . . . . . . . . . . . . .

1.5. Redes Probabilı́sticas . . . . . . . . . . . . . . . . . . . . .

1.5.1. Sistemas Inteligentes . . . . . . . . . . . . . . . . .

1.5.2. Sistemas Inteligentes Probabilı́sticos . . . . . . . . .

1.5.3. Redes Bayesianas . . . . . . . . . . . . . . . . . . .

1.5.4. Razonamiento Probabilı́stico. Inferencia . . . . . .

1.6. Ejercicios . . . . . . . . . . . . . . . . . . . . . . . . . . .

i

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

1

1

2

4

6

6

7

10

11

12

15

16

16

CAPÍTULO 1

Teorı́a de la Probabilidad

1.1. Medida de Probabilidad

Para medir la incertidumbre existente en un experimento aleatorio1 dado,

se parte de un espacio muestral M en el que se incluyen todos los posibles resultados individuales del experimento (sucesos elementales); es decir,

el conjunto muestral es un conjunto exhaustivo (contiene todas las posibles

ocurrencias) y mútuamente exclusivo (no pueden darse dos ocurrencias a

la vez). Una vez definido el espacio muestral, el objetivo consiste en asignar a todo suceso compuesto A ⊂ M un número real que mida el grado

de incertidumbre sobre su ocurrencia. Para obtener medidas con significado

matemático claro y práctico, se imponen ciertas propiedades intuitivas que

definen una clase de medidas que se conocen como medidas de probabilidad.

Definición 1.1 Medida de Probabilidad. Una función p que proyecta los

subconjuntos A ⊂ M en el intervalo [0, 1] se llama medida de probabilidad si

satisface los siguientes axiomas2 :

Axioma 1 (Normalización): p(M) = 1.

1

Un experimento se denomina aleatorio cuando puede dar resultados distintos al realizarse en las mismas condiciones (por ejemplo, lanzar un dado al aire y observar el nmero

resultante).

2

Formalmente, una medida de probabilidad se define sobre una σ-álgebra del espacio

muestral, que es una colección de subconjuntos que es cerrada para los operadores de unión

A∪B y complementario Ā = M\A (por tanto, también para intersecciones A∩B = Ā ∪ B̄).

Sin embargo, optamos por una definición menos rigurosa y más intuitiva para introducir

este concepto.

1

2

1. TEORÍA DE LA PROBABILIDAD

Axioma 2 (Aditividad): Para cualquier sucesión infinita, A1 , A2 , . . .,

de subconjuntos disjuntos de M, se cumple la igualdad

p

̰

[

i=1

!

Ai =

∞

X

p (Ai ).

(1.1)

i=1

El Axioma 1 establece que, independientemente de nuestro grado de certeza,

ocurrirá un elemento del espacio muestral M (es decir, el conjunto M es

exhaustivo). El Axioma 2 es una fórmula de agregación que se usa para

calcular la probabilidad de la unión de subconjuntos disjuntos. Establece que

la incertidumbre de un cierto subconjunto es la suma de las incertidumbres

de sus partes (disjuntas). Nótese que esta propiedad también se cumple para

sucesiones finitas.

De los axiomas anteriores pueden deducirse propiedades muy interesantes

de la probabilidad. Por ejemplo:

Complementariedad: La probabilidad de un suceso y la de su complementario suman uno, p(A) + p(Ā) = 1.

Normalización: La evidencia asociada a una ausencia completa de

información es cero, p(φ) = 0. Su demostración es sencilla:

1 = p(M) = p(M ∪ φ) = p(M) + p(φ) ⇒ p(φ) = 0.

Acotación: La probabilidad de cualquier suceso es menor o igual que

la unidad, p(A) ≤ 1, para A ⊂ M.

Monotonicidad: La evidencia de la pertenencia de un elemento a un

conjunto debe ser al menos la evidencia de cualquiera de sus subconjuntos. Si A ⊆ B ⊆ M, entonces p(A) ≤ p(B).

p(B) = p((B ∩A)∪(B \A)) = p(A∪(B \A)) = p(A)+p(B \A) ≥ p(A).

Inclusión-Exclusión: Dado cualquier par de subconjuntos A y B de

M, se cumple siempre la siguiente igualdad:

p(A ∪ B) = p(A) + p(B) − p(A ∩ B).

(1.2)

Esta propiedad establece que las probabilidades de los conjuntos A, B, A∩

B, y A ∪ B no son independientes.

1.2. Asignación de Probabilidades

Para un mismo experimento aleatorio, existen numerosas medidas de probabilidad que cumplen los axiomas anteriores; sin embargo, la medida de

probabilidad que se asigna a un experimento real debe de ajustarse a la incertidumbre real asociada con cada uno de los posibles sucesos. Ası́, sabemos

1.2. ASIGNACIÓN DE PROBABILIDADES

3

que al jugar a los dados, los seis nmeros tienen la misma probabilidad de ocurrir, si los dados no están trucados. Esta idea se corresponde con el enfoque

clásico de la asignación de probabilidades, que se remonta al nacimiento de

esta disciplina (Bernoulli, Laplace), y se basa en el principio de indiferencia:

todos los sucesos elementales del espacio muestral son equiprobables (por

ejemplo, en el caso de un dado no trucado). En este caso, la probabilidad

de un suceso dado se puede obtener como el cociente del número de casos

favorables a dicho suceso entre el número de casos posibles.

En la práctica, la probabilidad asociada a un suceso cualquiera de un

experimento se puede asignar repitiendo el experimento un número suficiente

de veces y observando las frecuencias relativas de dicho suceso. Por ejemplo, si

se quiere asignar una probabilidad a los suscesos elementales del lanzamiento

de un dado, se puede repetir el experimento un número elevado de veces y

observar las frecuencias de aparición del 1, 2, 3, 4, 5 y 6; en este caso, si

alguna de las frecuencias se separa mucho del valor 1/6 se puede concluir que

es un dado trucado. Ello lleva a definir la probabilidad de un suceso A como

el lı́mite asintótico de la frecuencia relativa de ocurrencia de dicho suceso en

la realización del experimento: p(A) = n→∞

lı́m fn (A), donde fn (A) representa

la frecuencia relativa del suceo A en n realizaciones del experimento. En

la práctica una aproximación del lı́mite asintótico se obtiene repitiendo el

experimento un número suficientemente elevado de veces, a partir del cual

fn (A) se estabiliza.

Por ejemplo, si queremos asignar una probabilidad a los distintos sucesos

meteorológicos que pueden producirse según la estación del año, la dirección

del viento y la ausencia o no de lluvia, podemos definir una medida de probabilidad en base a las frecuencias observadas en un perı́odo amplio de tiempo

(por ejemplo, diez años):

N=3650

NE

SE

SW

NW

INVIERNO

Seco Lluvia

190

99

24

18

98

223

49

150

PRIMAVERA

Seco Lluvia

287

166

6

4

18

119

95

277

VERANO

Seco Lluvia

360

162

1

9

15

71

108

251

OTOÑO

Seco Lluvia

177

89

33

26

94

248

36

147

Una vez que se han hallado las probabilidades de los sucesos elementales,

se pueden aplicar las propiedades de la probabilidad descritas anteriormente

para calcular la probabilidad de sucesos compuestos como “que sea invierno

o llueva”, que “el viento no sople del NE”, o “que sea invierno y llueva”.

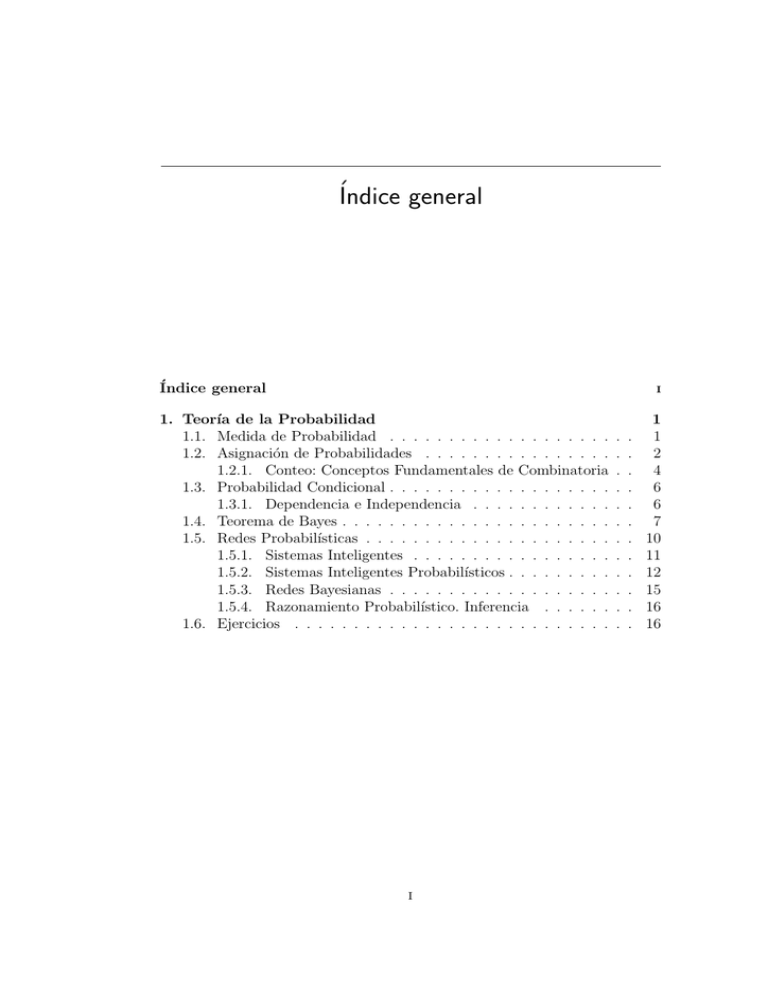

Ejemplo 1.1 (Lanzamiento de un dado). Un ejemplo clásico que ilustra

los axiomas y la asignación de probabilidades es el del lanzamiento de un

dado no trucado. En este caso el espacio muestral es M = {1, 2, 3, 4, 5, 6}, es

decir, el conjunto de los posibles resultados del lanzamiento. Las frecuencias

relativas de cada uno de estos sucesos elementales convergen al valor 1/6,

indicando que son equiprobables (ver figura 1.1). A partir de esta asignación

de probabilidades, y utilizando las propiedades de las medidas de probabilidad,

4

1. TEORÍA DE LA PROBABILIDAD

se puede calcular p({1, 3}) = p({1}) + p({3}) = 1/3, p(impar) = p{1, 3, 5}

= 1/2, etc.

Un experimento equivalente a lanzar el dado consiste en extraer una bola

de una urna que contiene seis bolas numeradas. Como se ve en la figura

1.1 los espacios muestrales y las asignaciones de probabilidades coinciden en

ambos casos, indicando que ambos experimentos son equivalentes.

x Ps(x) s(x)

1

2

Dado

x

P(x)

1

2

3

4

5

6

1/6

1/6

1/6

1/6

1/6

1/6

4

3

6

5

1

2

3

4

5

6

1/6

1/6

1/6

1/6

1/6

1/6

1

1

1

1

1

1

Urna 1

x Ps(x) s(x)

2

2

1

2

4

4

3

5

6

1

2

3

4

5

6

1/9

3/9

1/9

2/9

1/9

1/9

1.5

0.5

1.5

0.75

1.5

1.5

Urna 2

Figura 1.1: Experimentos aleatorios equivalentes y no equivalentes.

1.2.1. Conteo: Conceptos Fundamentales de Combinatoria

En numerosas situaciones prácticas, el problema de la asignación de probabilidades se reduce a un simple problema de combinatoria en el que es

necesario contar el número de resultados posibles (sucesos elementales) y

cuántos de éstos son favorables al suceso cuya probabilidad se quiere calcular.

La siguentes definiciones muestran las reglas de conteo más elemtales, con

las cuales pueden resolverse numerosas situaciones prácticas.

Definición 1.2 Regla multiplicativa. Dados k conjuntos con n1 , . . ., nk

elementos, respectivamente, el número de muestras distintas de k elementos

que pueden obtenerse tomando un elemento de cada conjunto es n1 . . . nk .

Definición 1.3 Combinaciones y Variaciones. Dado un conjunto de n

elementos, el número de suconjuntos (no importa el orden) de m elementos

distintos que pueden formarse viene dado por el número combinaciones de n

elementos tomados de m en m:

Ã

n

Cm

=

n

m

!

=

n!

.

(n − m)! m!

(1.3)

1.2. ASIGNACIÓN DE PROBABILIDADES

5

Por otra parte, el número de conjuntos con elementos repetidos viene dado

por las combinaciones con repetición:

Ã

n

CRm

=

n

m

!

=

(n + m − 1)!

.

(n − 1)! m!

(1.4)

En cambio, el número de vectores (conjuntos ordenados) de m elementos

distintos viene dado por variaciones de n elementos tomados de m en m:

Vmn = n(n − 1) . . . (n − m + 1) =

n!

.

(n − m)!

(1.5)

Ası́mismo, cuando existe repetición se habla de variaciones con repetición

n

V Rm

= mn .

La regla multiplicativa permite dividir un problema en partes (que serán

finalmente multiplicadas) y las variaciones y combinaciones permiten tratar

cada una de estas partes.

Ejemplo 1.2 En una competición donde participan 50 atletas, ¿Cuántos podium (primero, segundo y tercero) distintos se pueden dar?, ¿de cuántos formas distintas se puede elegir el conjunto de los tres mejores atletas?

El número total de podium distintos viene dado por las permutaciones de las 50

personas tomadas de tres en tres 20 19 18

³ = ´6840. En cambio, las posibilidades

para elegir a los tres mejores atletas son 20

= 1140.

3

Ejemplo 1.3 Al lanzar una moneda 4 veces, ¿de cuántas formas se pueden

obtener 3 caras?. Y ¿dos caras y dos cruces?.

De

³

4

3

´

=4y

³

4

2

´

= 6, respectivamente.

Ejemplo 1.4 (El problema de cumpleaños). Si k personas están en una

habitación, ¿Cuál es la probabilidad p(k) de que almenos dos personas cumplan años el mismo da?.

El número total de combinaciones de dı́as para los cumpleaños de k personas es

365k . Calculamos la probabilidad del suceso complementario al pedido en el enunciado, es decir, el suceso “todas las personas cumplen años en das distintos”.

El número de permutaciones posibles es a = 365 × 364 × . . . × 365 − k + 1 =

365!/(365 − k)!. Por tanto la probabilidad de que todas la personas cumplan años

en dı́as distintos es b = a/365k y la probabilidad de su suceso complementario, es

decir, que al menos dos personas cumplan años el mismo dı́a será:

p(k) = 1 − b = 1 −

365!

Vk365

=

1

−

.

365k (365 − k)!

V Rk365

Por ejemplo, se puede observar que para que la probabilidad sea mayor de 0.5

es necesario un grupo de, al menos, 21 personas.

6

1. TEORÍA DE LA PROBABILIDAD

1.3. Probabilidad Condicional

El conocimiento de la ocurrencia de un suceso puede modificar las probabilidades de otros sucesos. Por ejemplo, la probabilidad de obtener un dos

al lanzar un dado cambia si se sabe que el resultado es un número par, también la probabilidad de que un paciente tenga una enfermedad dada puede

cambiar tras el conocimiento de los resultados de un análisis de sangre. Por

ello, cada vez que se dispone de nueva información, las probabilidades de los

sucesos pueden, y suelen, cambiar. Esto conduce al concepto de probabilidad

condicional.

Definición 1.4 Probabilidad condicional. Sean A e B dos sucesos tales

que p(B) > 0. Entonces, la probabilidad condicional de A dado B viene dada

por

p(A ∩ B)

p(A|B) =

.

(1.6)

p(B)

La ecuación (1.6) implica que la probabilidad del suceso A ∩ B viene dada

por

p(A ∩ B) = p(B)p(A|B).

(1.7)

Esta fórmula puede generalizarse para intersecciones de más conjuntos,

dando lugar a la llamada regla de la cadena:

p(A1 ∩ A2 ∩ . . . ∩ An ) = p(A1 )p(A2 |A1 ) . . . p(An |A1 ∩ . . . ∩ An−1 ).

(1.8)

Esta fórmula puede probarse de forma sencilla a partir de (1.7).

1.3.1. Dependencia e Independencia

Cuando un suceso sucesos no suministra información alguna sobre la ocurrencia de otro se dice que éstos dos sucesos son independientes.

Definición 1.5 (Independencia de sucesos) Sean A y B dos sucesos tales

queP (A) > 0 y P (B) > 0, se dice que el suceso B es independiente del A si

P (B/A) = P (B).

Una propiedad importante de la relación de independencia es su simetrı́a.

Recordando la definición de probabilidad condicionada se tiene

P (B/A) =

P (B ∩ A)

= P (B)

P (A)

⇔

P (A ∩ B) = P (A) P (B)

y por tanto

P (A/B) =

P (A) P (B)

P (A ∩ B)

=

= P (A)

P (B)

P (B)

1.4. TEOREMA DE BAYES

7

luego si A es independiente de B, también B es independiente de A, por lo

que se dice que A y B son independientes. Nótese que en la definición 1.5

puede utilizarse la condición

P (A ∩ B) = P (A)P (B)

(1.9)

Ejemplo 1.5 Supongamos que durante 10 aos los fenómenos: estación del

ao, dirección del viento y lluvia se han dado con las frecuencias mostradas

en la siguiente tabla:

N=3650

NE

SE

SW

NW

TOTAL

ANUAL

Seco Lluvia

1014

516

64

57

225

661

288

825

1591

2059

INVIERNO

Seco Lluvia

190

99

24

18

98

223

49

150

361

490

PRIMAVERA

Seco Lluvia

287

166

6

4

18

119

95

277

406

566

VERANO

Seco Lluvia

360

162

1

9

15

71

108

251

484

493

OTOO

Seco Lluvia

177

89

33

26

94

248

36

147

340

510

Si tomamos como sucesos elementales cada una las posibles combinaciones (estacion, viento, lluvia), podemos calcular:

→ P (lluvia) = 2059/3650 = 0.564.

→ P (lluvia|SW ) = P (LL ∩ SW )/P (SW ) = 661/886 = 0.746

De esta forma vemos que los sucesos lluvia y viento son dependientes.

Supongamos ahora que en lugar de considerar la estación del ao, consideramos la fase lunar:

N=3650

NE

SE

SW

NW

TOTAL

ANUAL

Seco Lluvia

1014

516

64

57

225

661

288

825

1591

2059

Llena

Seco Lluvia

255

137

12

12

59

165

51

192

377

506

C. Menguante

Seco Lluvia

208

106

16

16

65

166

77

231

366

519

C. Creciente

Seco Lluvia

297

132

22

12

58

175

82

225

459

544

Nueva

Seco Lluvia

254

141

14

17

43

155

78

177

389

490

Ahora:

→ P (lluvia) = 2059/3650 = 0.564.

→ P (lluvia|CC) = 490/(490 + 389) = 0.557

→ P (lluvia|LN ) = 544/(544 + 459) = 0.542

→ P (lluvia|CM ) = 519/(519 + 366) = 0.586

→ P (lluvia|LL) = 506/(506 + 377) = 0.573,

lo que indica que la lluvia y la fase lunar son independientes.

1.4. Teorema de Bayes

El teorema de Bayes es una útil fórmula que nos permite “dar la vuelta.a

las probabilidades condicionadas y resolver casos prácticos en los que la inforamción disponible a priori no permite realizar el cálculo de forma directa.

8

1. TEORÍA DE LA PROBABILIDAD

Teorema 1.1 (Probabilidad total). Sea {A1 , A2 , . . . An } una clase exhaustiva (su unión es el espacio muestral) de sucesos incompatibles dos a

dos. Entonces se tiene que

P (B) =

n

X

P (B/Ai ) P (Ai )

i=1

Este teorema se puede demostrar fácilmente de la siguiente forma:

P (B) = P (B ∩ (

n

S

i=1

=

Ai )) = P (

n

P

i=1

n

S

i=1

(B ∩ Ai )) =

P (B ∩ Ai ) =

n

P

i=1

P (B/Ai ) P (Ai )

Por ejemplo, la siguiente figura muestra (en su zona sombreada) los individuos que poseen una enfermedad (cáncer de estómago), denotado con g,

mientras que la zona blanca son los individuos libres de la enfermedad, ḡ

(estos dos sucesos son exhaustivos e incompatibles). A su vez, existen otros

sucesos (sı́ntomas) presentes en la población. El teorema de la probablidad

total dice que la probabilidad de un sı́ntoma (por ejemplo, dolor d) se puede

obtener como P (d) = P (d|g)P (g) + P (d|ḡ)P (ḡ).

Teorema 1.2 (Bayes). En las condiciones del teorema anterior se tiene:

P (B/Ai ) P (Ai )

P (Ai /B) = P

n

P (B/Ai ) P (Ai )

i=1

La demostración de este teorema también es muy sencilla:

P (Ai ∩ B) = P (B/Ai ) P (Ai ) = P (Ai /B) P (B)

1.4. TEOREMA DE BAYES

9

y despejando P (Ai /B) y teniendo en cuenta el teorema de la probabilidad

total resulta el teorema de Bayes.

A las probabilidades P (Ai ) se las suele llamar probabilidades a priori, por

ser las probabilidades antes de conocer la información B. Las probabilidades

P (Ai /B), que son las probabilidades de Ai después de conocer la información B, reciben el nombre de probabilidades a posteriori. Finalmente, las

probabilidades P (B/Ai ) se llaman verosimilitudes.

Los conceptos presentados en este capı́tulo tienen mucha importancia

en diversos campos aplicados como, por ejemplo en la inteligencia artificial

(sistemas expertos probabilsticos) pues permiten inferir conclusiones en base

a información cuantitativa; en estos sistemas, los modelos de aprendizaje se

basan fundamentalmente en la probabilidad condicionada. En el siguiente

ejemplo se muestra una de las aplicaciones más importantes de este campo

(el diagnóstico médico) a la vez que se ilustra la aplicación del teorema de

Bayes.

Ejemplo 1.6 (Diagnóstico Médico).Un centro médico tiene una base de

datos consistente en los historiales clı́nicos de n = 1000 pacientes; hay 700

pacientes (la región sombreada) que tienen la enfermedad adenocarcinoma

gástrico (g), y 300 que no la tienen. Tres sı́ntomas, dolor (d), pérdida de peso

(p) y vómitos (v), se considera que están ligados a esta enfermedad. Por

tanto, cuando un paciente nuevo llega al centro médico, hay una probabilidad

700/1000 = 70 % de que el paciente tenga adenocarcinoma gástrico. Esta es

la probabilidad inicial, o “a priori”, puesto que se calcula con la información

inicial, es decir, antes de conocer información alguna sobre el paciente. Por

tanto, pueden hacerse las afirmaciones siguientes:

probabilidad “a priori”: 440 de 1000 pacientes vomitan. Por ello, p(v) =

card(v)/n = 440/1000 = 0.44, donde card(v) denota la frecuencia absoluta de pacientes de la base de datos que vomitan. Esto significa que

el 44 % de los pacientes vomitan.

Verosimilitud: El 50 % de los pacientes que tienen la enfermedad vomitan, puesto que p(v|g) = card({v, g})/card(g) = 350/700 = 0.5,

mientras que sólo 30 % de los pacientes que no tienen la enfermedad

vomitan, puesto que p(v|ḡ) = card({v, ḡ})/card(ḡ) = 90/300 = 0.3.

Verosimilitud: El 45 % de los pacientes que tienen la enfermedad vomitan y pierden peso, p({v, p}|g) = card({v, p, g})/card(g) = 315/700 =

0.45, mientras que sólo el 12 % de los que no tienen la enfermedad vomitan y pierden peso, p({v, p}|ḡ) = card({v, p, ḡ})/card(ḡ) = 35/300 ≈

0.12.

Puesto que la probabilidad inicial de que el paciente tenga adenocarcinoma gástrico, p(g) = 0.7, no es suficientemente alta para hacer un diagnóstico

(nótese que tomar una decisión ahora implica una probabilidad 0.3 de equivocarse), el doctor decide examinar al paciente para obtener más información.

Supóngase que los resultados del examen muestran que el paciente tiene los

10

1. TEORÍA DE LA PROBABILIDAD

sı́ntomas vómitos y pérdida de peso. Ahora, dada la evidencia (el paciente

tiene esos sı́ntomas), ¿cuál es la probabilidad de que el paciente tenga la

enfermedad? Esta probabilidad “a posteriori” puede ser obtenida de la probabilidad “a priori” y de las verosimilitudes, aplicando el teorema de Bayes

en dos etapas, como sigue:

Tras observar que el paciente vomita la probabilidad “a posteriori” es

p(g|v) =

=

p(g)p(v|g)

p(g)p(v|g) + p(ḡ)p(v|ḡ)

0.7 × 0.5

= 0.795.

(0.7 × 0.5) + (0.3 × 0.3)

Tras observar que el paciente vomita y presenta pérdida de peso la

probabilidad “a posteriori” es

p(g|{v, p}) =

=

p(g)p({v, p}|g)

p(g)p({v, p}|g) + p(ḡ)p({v, p}|ḡ)

0.7 × 0.45

= 0.9.

(0.7 × 0.45) + (0.3 × 0.12)

(1.10)

Nótese que cuando se aplica el teorema de Bayes sucesivamente, la probabilidad “a posteriori” calculada en una etapa dada es la misma que la probabilidad “a priori” en la etapa siguiente. Por ejemplo, la probabilidad “a

posteriori”, que se ha calculado en la primera etapa anterior, puede ser usada

como probabilidad “a priori” en la segunda etapa, es decir,

p(g|{v, p}) =

=

p(g|v)p(p|{g, v})

p(g|v)p(p|{g, v}) + p(ḡ|v)p(p|{ḡ, v})

0.795 × 0.9

= 0.9,

(0.795 × 0.9) + (0.205 × 0.389)

que da la misma respuesta que en (1.10). Nótese también que la probabilidad

cambia tras observar las evidencias. La probabilidad de tener la enfermedad

era inicialmente 0.7, después aumentó a 0.795, y luego a 0.9 tras observar

la evidencia acumulada. Al final de la última etapa, el paciente tiene una

probabilidad 0.9 de tener la enfermedad. Esta probabilidad puede ser suficientemente alta (comparada con la probabilidad “a priori” 0.7) para que el

doctor diagnostique que el paciente tiene la enfermedad. Sin embargo, serı́a

conveniente observar nuevas evidencias antes de hacer este diagnóstico.

1.5. Redes Probabilı́sticas

Durante los últimos años la probabilidad se ha convertido en una herramienta fundamental en distintas áreas de la computación: aprendizaje automático (machine learning), computación neuronal, etc. En la última década