sistema de medición cuantitativa del riesgo operacional en

Anuncio

UNIVERSIDAD PONTIFICIA COMILLAS

ESCUELA TÉCNICA SUPERIOR DE INGENIERÍA (ICAI)

INGENIERO EN INFORMÁTICA

PROYECTO FIN DE CARRERA

SISTEMA DE MEDICIÓN CUANTITATIVA

DEL RIESGO OPERACIONAL EN

ENTIDADES FINANCIERAS

AUTOR: JOSÉ IGNACIO GIMÉNEZ MARTÍNEZ

MADRID, JUNIO 2006

INDICE

1.

INTRODUCCIÓN............................................................................................................................... 4

1.1

1.2

INTRODUCCIÓN A BASILEA ............................................................................................................ 4

INTRODUCCIÓN A LA METODOLOGÍA: ........................................................................................... 12

2.

OBJETIVOS Y APORTACIÓN....................................................................................................... 15

3.

DESCRIPCIÓN DE LAS TECNOLOGÍAS..................................................................................... 28

3.1

TECNOLOGÍA UTILIZADA .................................................................................................... 28

3.1.1

BASE TEÓRICA Y PARADIGMAS ........................................................................................ 28

3.1.2

COMPONENTES UTILIZADOS ............................................................................................ 41

3.2

MODELO DE DOMINIO .......................................................................................................... 42

3.3

DIAGRAMA DE CASOS DE USO............................................................................................ 42

3.3.1

CÁLCULO DEL VaR CUANTITATIVO ................................................................................. 44

3.3.2

GESTIÓN DE USUARIOS..................................................................................................... 47

3.3.3

GESTIÓN DE LÍNEAS DE NEGOCIO .................................................................................. 50

3.3.4

GESTIÓN DE CATEGORÍAS DE RIESGO............................................................................ 53

3.4

OTROS REQUISITOS............................................................................................................... 56

3.4.1

REGLAS DE NEGOCIO........................................................................................................ 56

3.4.2

RESTRICCIONES ................................................................................................................. 56

3.4.3

REQUERIMIENTOS NO FUNCIONALES............................................................................. 60

3.5

DIAGRAMA DE ARQUITECTURA ......................................................................................... 61

3.5.1

DIAGRAMA DE PAQUETES ................................................................................................ 61

3.5.2

DESCRIPCIÓN ..................................................................................................................... 61

3.6

MODELO DINÁMICO DETALLADO...................................................................................... 64

3.6.1

DIAGRAMAS DE INTERACCIÓN......................................................................................... 64

3.7

MODELO ESTRUCTURAL DETALLADO .............................................................................. 86

3.7.1

SUBSISTEMA COM.MSSPAIN.SIMCRO.CORE.................................................................... 86

3.7.2

SUBSISTEMA COM.MSSPAIN.SIMCRO.IU.......................................................................... 87

3.7.3

SUBSISTEMA COM.MSSPAIN.SIMCRO.SERVICES............................................................. 90

3.7.4

SUBSISTEMA COM.MSSPAIN.SIMCRO.DAO...................................................................... 91

3.7.5

SUBSISTEMA COM.MSSPAIN.SIMCRO.DOMAIN............................................................... 92

3.8

DISEÑO DE LA BASE DE DATOS.......................................................................................... 93

3.9

DISEÑO DE LA APLICACIÓN ................................................................................................ 94

3.9.1

IDENTIFICACIÓN................................................................................................................ 94

3.9.2

PANTALLA PRINCIPAL ....................................................................................................... 95

3.9.3

INFORME DE EVENTOS DE PÉRDIDA .............................................................................. 96

3.9.4

SELECCIÓN AGRUPACIÓN FRECUENCIA ........................................................................ 97

3.9.5

DISTRIBUCIÓN DE FRECUENCIAS ................................................................................... 98

3.9.6

AJUSTE DE LA DISTRIBUCIÓN .......................................................................................... 99

3.9.7

AJUSTE DE LA DISTRIBUCIÓN II .................................................................................... 100

3.9.8

DISTRIBUCIÓN DE SEVERIDAD ...................................................................................... 101

3.9.9

QQ-PLOT............................................................................................................................ 102

3.9.10

FUNCIÓN DE EXCESO SOBRE LA MEDIA .................................................................. 103

3.9.11

PP – PLOT ..................................................................................................................... 104

3.9.12

PARAMETRIZACIÓN DE LA SIMULACIÓN DE MONTECARLO.................................. 105

3.9.13

INFORME VaR............................................................................................................... 106

2

3.9.14

3.9.15

4.

MÓDULO ADMINISTRACIÓN....................................................................................... 108

MÓDULO ADMINISTRACIÓN II ................................................................................... 109

METODOLOGÍA CUANTITATIVA ............................................................................................ 111

4.1

DESCRIPCIÓN GENERAL DEL MODELO ........................................................................... 111

4.2

MODELIZACIÓN DE LA FUNCIÓN DE LA DISTRIBUCIÓN DE FRECUENCIAS............. 115

4.2.1

“Regla sencilla” ................................................................................................................. 115

4.2.2

Histograma ......................................................................................................................... 118

4.2.3

Test de bondad de ajuste CHI- CUADRADO....................................................................... 119

4.3

MODELIZACIÓN DE LA FUNCIÓN DE LA DISTRIBUCIÓN DE LOS IMPACTOS

(SEVERIDAD)...................................................................................................................................... 126

4.3.1

Método de eliminación de distribuciones candidatas: Gráficos “QQ-plot” ......................... 126

4.3.2

Test de bondad de ajuste: Chi-Cuadrado, Kolmogorov-Smirnov y Cramer-Von Mises......... 131

4.3.3

Gráfico “FUNCIÓN EXCESO SOBRE LA MEDIA” ........................................................... 145

4.3.4

Gráficos – “PP-plot” (utilizando los parámetros estimados) ............................................... 148

4.4

OBTENCIÓN DE LA DISTRIBUCIÓN DE PÉRDIDAS OPERACIONALES PARA CADA

EVENTO / LÍNEA DE NEGOCIO. CÁLCULO DEL VALOR EN RIESGO OPERACIONAL ............. 152

4.5

VERIFICACIÓN DE RESULTADOS Y BACK TESTING DEL MODELO ............................ 157

5.

CONCLUSIONES........................................................................................................................... 165

6.

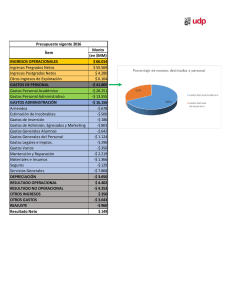

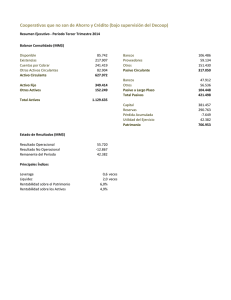

ESTUDIO ECONÓMICO Y PLANIFICACIÓN........................................................................... 167

6.1

6.2

7.

ESTUDIO ECONÓMICO........................................................................................................ 167

PLANIFICACIÓN ................................................................................................................... 169

BIBLIOGRAFÍA............................................................................................................................. 172

ANEXO 1: TABLA DE KOLMOGOROV-SMIRNOV.......................................................................... 173

ANEXO 2: TABLA DE CRAMER-VON MISES ................................................................................... 176

ANEXO 3: SIMPLIFICACIÓN DEL ESTADÍSTICO DE KOLMOGOROV-SMIRNOV................... 177

ANEXO 4: EXPRESIÓN ANALÍTICA DE LA FUNCIÓN EXCESO SOBRE LA MEDIA ................ 178

ANEXO 5: SIMULACIONES DE LA FUNCIÓN EXCESO SOBRE LA MEDIA ............................... 180

ANEXO 6: FUNCIÓN DE DENSIDAD DE LA PÉRDIDA OPERACIONAL....................................... 183

3

1. Introducción

1.1 Introducción a Basilea

En un seminario realizado en Washington entre el 1 y 3 de Junio de 2004 fue

manifestado que: “Basilea II no es un complemento a la gestión de riesgos, es un marco

regulatorio e incentiva la gestión de riesgos”. Suena importante. Más aún cuando quienes

coincidieron en la afirmación fueron Alan Greenspan (FED) y Jaime Caruana (BIS).

¿Qué es Basilea II?:

Cuando mencionamos a Basilea II nos referimos - en una suerte de simplificación

– al Nuevo Acuerdo de Capital emitido por el Comité de Basilea que debe comenzar a

aplicarse a fines de 2006 y 2007 oficialmente y en prueba a partir de 2006 por los Bancos

que indiquen los Bancos Centrales que conforman el Comité de Basilea.

Este comité tiene sede en la ciudad Suiza del mismo nombre y se reúne en el

edificio del Bank for International Settlements (BIS). El Comité de Basilea es también

conocido como el “Banco Central de los Bancos Centrales” porque está integrado por

representantes de los Bancos Centrales de más de 100 países miembros. Debe aclararse

que Basilea emite recomendaciones que orientan pero que no son mandatorias para los

Supervisores Bancarios (léase bancos centrales) de cada país.

Ya sabemos que es Basilea, ahora ¿por qué II?

Su antecesor, el Acuerdo de Capitales de Basilea (Basilea I), fue pronunciado en

1988 y entró en vigencia en 1992. En 15 años, este Comité no ha emitido sólo dos

recomendaciones sino cientos. En efecto, es ésta una muestra más de la importancia que

el mundo asigna al Nuevo Acuerdo al denominarlo Basilea II.

4

Basilea I, en su momento surgió como una exigencia de los países más

industrializados para aumentar la solvencia de los sistemas financieros. Su rotundo éxito

se debió a la simplicidad de su aplicación y a que permitió uniformar criterios en una

industria que internacionalmente se encontraba con criterios muy dispares.

Entre los problemas más destacados que presenta es que su propia simpleza no

permite una adecuada identificación de los verdaderos riesgos. No olvidemos que ha sido

en la década de los ’90 en la que se han producido avances notables en la medición y en

la gestión de riesgos (modelos no contemplados por Basilea I).

Como resultado de esto paulatinamente se ha venido incrementando el desfase

entre los negocios bancarios cada vez mayores y el capital regulado que permite cumplir

con los objetivos de solvencia y eficiencia que persiguen justamente las regulaciones.

El reconocimiento de esta situación sumado a los nuevos modelos y tendencias

internacionales en materia de riesgo y “corporate governance” han sido los disparadores

materiales e intelectuales del Nuevo Acuerdo de Basilea.

Entre los objetivos que persigue Basilea II se destacan:

- Perfeccionar el acuerdo anterior;

- Promover la seguridad y la salud de los sistemas financieros;

- Fomentar la competencia en igualdad de condiciones;

- Definición de capitales mínimos regulados en base a criterios más

sensibles al riesgo;

- Mejora en “performance” de los procesos bancarios: eficiencia;

- Mejorar la supervisión bancaria (a través de los Bancos Centrales);

- Transparencia en las informaciones.

5

Para lograr los objetivos mencionados Basilea II se basa en tres “pilares”:

Los Pilares del Nuevo Acuerdo:

- Pilar I. Requerimiento mínimo de capital: persigue una adecuada

gestión de riesgos por parte de las entidades bancarias fomentando el

desarrollo de modelos de gestión de riesgos propietarios.

- Pilar II: Proceso de examen supervisor: busca un doble objetivo de aumentar

la fiscalización por parte de los Bancos Centrales a la vez de hacer más

profesional la administración bancaria.

- Pilar III: Disciplina de mercado: se pretende uniformar la gestión de

informaciones a brindar al mercado asegurando su corrección y transparencia.

Pilar I Requerimientos mínimos de Capital:

Sin entrar en cuestiones demasiado técnicas, mencionaremos que Basilea II no

presenta modificaciones en cuanto a regulaciones de capital para riesgo de mercado

entendiendo que está adecuadamente cubierto con el Acuerdo anterior. Sí presenta

importantes modificaciones para el riesgo de crédito e incorpora la gestión de riesgos

operacionales.

Adelantemos que, tanto en los requerimientos de capital regulatorio para riesgo

crediticio como para riesgo operacional Basilea propone tres métodos para su

implementación. Dichos métodos contienen diferente nivel de complejidad y requisitos. Los

más simples son menos costosos en su implementación inicial pero requieren una mayor

integración de capital porque los ponderadores de riesgos son más elevados. Los más

desarrollados, además de la disminución en el capital total regulado, al tener mayores

requisitos para su implementación se verán beneficiados en el mediano y largo plazo al

obtener mayor eficiencia operativa mediante una mejor gestión de riesgos.

El siguiente cuadro demuestra lo mencionado anteriormente:

6

Requerimiento de capital para Riesgo Operacional:

En este caso en el método básico la previsión por riesgo operativo implica

simplemente calcular el 15% del Resultado bruto de la entidad.

Una variante tampoco demasiado buena es la del método estándar (el intermedio

del gráfico) que fija porcentajes a aplicar al resultado bruto por línea de negocio según el

siguiente detalle:

Líneas de Negocio

Valor

Finanzas corporativas

18%

Negociación y ventas

18%

Banca minorista

12%

Banca comercial

15%

Liquidaciones y pagos

18%

Servicios de agencias

15%

Administración de activos

12%

7

Intermediación minorista

12%

Por último, aparece el método avanzado (AMA) con las principales innovaciones

y mejoras. En este caso el capital regulatorio surge como resultado de aplicar sistemas de

gestión de riesgos propietarios suficientemente desarrollados cuyas estimaciones de

pérdidas deberán considerar fallos internos y externos, madurez del ambiente de control

interno, análisis de escenarios, entorno de negocios y, con un interválo de confianza del

99.9%, calcular las estimaciones como sumatoria de las pérdidas esperadas y no

esperadas por la organización.

Los Supervisores bancarios exigirán a las entidades para poder adoptar este

método, además de la solidez del modelo a aplicar, el cumplimiento de requisitos

cualitativos de admisión, tales como:

- Consejo Directivo y los principales ejecutivos involucrados en la gestión de

riesgos;

- La existencia de función de gestión de riesgo operacional independiente,

responsable por la implementación de la estructura de riesgo operacional de la

institución;

- Integración del sistema de medición de riesgo en la rutina diaria de

gestión del riesgo;

- Proceso de reporte regular a la gerencia de la unidad de negocios, ejecutivos y

Consejo Directivo;

- Existencia de sistemas para documentar, monitorear y gestionar los riesgos;

- Validación del sistema de medición de riesgo por los organismos reguladores y

por la auditoría externa.

Pilar II: Proceso de examen supervisor:

Mediante 4 principios se exige a los Bancos contar con un proceso permanente

que permita evaluar la suficiencia de capital total y se pretende de los Supervisores

Bancarios la facultad de fiscalización, de exigencia de medidas correctivas cuando fuere

necesario y en su caso intervenir las entidades que no cumplan con los requerimientos de

capital.

8

Pilar III: Disciplina de mercado:

Establece la necesidad de contar con una política formal de divulgación de las

informaciones que permitirá a los usuarios evaluar aspectos básicos referidos a:

- El ámbito de aplicación;

- Las exposiciones al riesgo;

- Los procesos de evaluación del riesgo;

- La suficiencia de capital de la institución

- La entidad debe contar con un proceso de evaluación permanente de dicha

política.

Quién debe aplicar Basilea II:

La letra pequeña del acuerdo obliga a los Bancos que son internacionalmente

activos. Previendo distintos niveles de consolidación de riesgos para todas las inversiones

del conglomerado financiero, ya sea en Bancos locales, Sociedades de valores, otras

entidades financieras controladas, compañías de seguros, y hasta participaciones en

sociedades comerciales.

Entonces surge la siguiente pregunta: ¿una organización que no pertenece al grupo

anterior no debería preocuparse por Basilea II?

Europa ya ha decidido implantar el Nuevo Acuerdo en todos los Bancos

independientemente que sean internacionales o no, en principio para uniformar el sistema

financiero y permitir a nivel macroeconómico contar con un sistema solvente y que

contribuya al desarrollo económico de los países y, a nivel microeconómico, evitar que

aquéllos Bancos que no lo implanten y permanezcan en Basilea I pierdan competitividad

respecto de aquéllos que implanten Basilea II.

9

Este razonamiento es totalmente trasladable a América Latina que sufrirá

posibles consecuencias de fragmentación de su sistema financiero. Es decir, si el Banco

Central de un país no obliga a implantar Basilea II puede ocurrir que los Bancos de

capitales nacionales continúen con Basilea I y que los de capitales extranjeros lo implanten

o no en función de las exigencias de sus casas matrices.

Por otra parte, se entiende que las entidades que utilicen modelos de gestión de

riesgos antiguo no tendrán la misma calificación crediticia que las de Basilea II con lo cual

su acceso al crédito se verá dificultado y con la necesidad de pagar sobretasas

compensatorias por trasladar al prestador un mayor nivel de riesgo.

¿Basilea II afectará sólo a los Bancos?

Es indudable la influencia que tiene el sistema financiero en la actividad

económica y en las posibilidades de desarrollo de un país. En general los países

importadores de capital pueden verse perjudicados en la medida que los tomadores no

puedan demostrar que tienen una adecuada gestión de riesgos.

Ahora bien, si analizamos la cuestión desde el punto de vista de cada

organización en particular, es fácil percibir que para los nuevos modelos de gestión de

riesgos, Basilea II presenta un incentivo muy importante y la vez una base conceptual para

comenzar a gestionar riesgos de una forma más adecuada.

Es claro que los riesgos de mercado y de crédito no hacen al negocio principal de

una explotación industrial o comercial sin embargo estas podrían aprovechar muchas

lecciones sobre riesgo operacional. Todas ellas sufren (o pueden sufrir) fraudes internos o

externos, fallos tecnológicas, productos mal diseñados, errores en la gestión de clientes,

siniestros, errores de procesamiento, etc.

Por otra parte, presentar un mejor perfil de riesgo por parte de una Empresa

puede ser importante a la hora de negociar condiciones con los Bancos. Explicamos que

Basilea II propone calificar los riesgos de crédito en base a su tasa de recuperación por lo

que los Bancos que lo apliquen van a preferir los clientes sanos en cuanto a riesgo ya que

un cliente que presente problemas de pago va a afectar su tasa de recuperación. Sin duda

la mayor demanda de clientes con buen perfil de riesgos va a generar una competencia a

nivel de pricing.

10

Conclusiones:

El Nuevo Acuerdo de Capitales presenta notorias ventajas respecto del anterior

permitiendo una mejor relación entre capital económico y regulatorio.

Esto se logrará ya que impulsa una gestión de riesgos moderna que incluye:

- La utilización de sistemas integrados de gestión de riesgos de crédito, mercado

y operacional;

- La utilización de indicadores que permitan gestión de riesgos en el día a día;

- Herramientas de estimación de pérdidas futuras;

- El compromiso de la Alta Dirección con la gestión de Riesgos; y

- La figura del “Risk Officer” exigiendo una oficina de riesgos totalmente

independiente de la gestión operativa.

Por otra parte, se alinea también con los modelos más desarrollados de

“Corporate Governance” en su tercer pilar al fomentar la uniformidad de informes

financieros y su transparencia.

La mejora en la gestión de riesgos y una mayor transparencia en las

informaciones son importantes para la sociedad en su conjunto porque ayudan a mejorar

la salud y la solvencia del sistema financiero. A la vez el incentivo a mejorar los niveles de

eficiencia en general hace a dicho sistema más competitivo y con un mejor nivel de

servicio para los usuarios.

Finalmente no debemos dejar de lado la oportunidad de alinearnos con los

avances en materia de gestión de riesgos ya que es una materia que obviamente traerá

beneficios directos e indirectos a la profesión.

11

1.2 Introducción a la metodología:

Una vez se ha explicado brevemente qué es Basilea II pasamos a definir el

objetivo de este proyecto que no es otro que proponer una metodología para la evaluación

1

cuantitativa del Riesgo Operacional basada en los modelos avanzados propuestos por el

2

Comité de Basilea en el Nuevo Acuerdo de Capital (en adelante, Basilea II o BIS II).

La metodología aquí propuesta presenta un enfoque global en cuanto a que

integra (según varias alternativas) las metodologías cuantitativas con información obtenida

a partir de técnicas cualitativas.

El documento se estructura en los siguientes apartados:

•

Descripción de una metodología de evaluación cuantitativa del Riesgo Operacional

(cálculo del VaR Operacional). Esta metodología se fundamenta en el Modelo de

distribución de pérdidas (LDA) propuesto por Basilea II. Incluye este apartado una

descripción de las pruebas de validación y back testing a realizar.

La metodología anterior parte de la modelización de una distribución de pérdidas

operacionales a partir del ajuste de distribuciones de frecuencias y severidades a unos

determinados datos. Estos datos se obtienen a partir de los datos recogidos en una

base de datos de eventos operacionales3.

1

Los modelos avanzados definidos por Basilea son los métodos más ajustados al riesgo. El consumo de

capital calculado a través de ellos será el resultado del sistema interno de medición del riesgo de la

Entidad y de la base de datos de pérdidas operacionales asociada.

2

En enero de 2001, el Comité publicó un primer documento de consulta en el que se desarrollaba el

Nuevo Acuerdo de Capital. Asimismo, en febrero de 2003 publicó las “Sound Practices for Management

and Supervision of Operational Risk”. El Acuerdo de Capital definitivo se publicó a lo largo de 2004 y su

aplicación efectiva está prevista para fin de 2006.

3

La modelización estadística a partir de los datos de eventos operacionales tiene como premisa

fundamental el disponer de una base de datos de eventos de pérdidas íntegra y con un volumen suficiente

de datos para que las cifras de riesgo obtenidas sean fiables. Para el caso de pérdidas de baja frecuencia

y muy alto impacto se podrá optar por la utilización de datos procedentes de bases de datos externas. Ello

requerirá la aplicación de metodologías que permitan el escalado de dichos datos al tamaño de la Entidad.

12

•

Descripción de los mecanismos de integración de las metodologías cualitativas con las

4

cuantitativas . Estos mecanismos, si bien introducen un componente subjetivo en el

resultado final, presentan las siguientes ventajas:

Permiten cubrir y ofrecer una primera estimación cuantitativa en aquellas áreas

5

donde no existen datos de pérdidas .

Facilitan el escalado de las bases de datos históricas, al recoger la visión actual de

los sistemas operativos de la entidad.

Permiten realizar comparaciones con los resultados obtenidos de las metodologías

cuantitativas “puras” y elaborar un plan de acción para su refinamiento.

La integración de ambas metodologías permite obtener una visión más realista de la

situación de cada área al considerar todas las fuentes de información existentes en la

entidad (datos de pérdida y conocimiento de los responsables).

En relación al VaR Operacional y las metodologías a aplicar es relevante

destacar los siguientes aspectos:

•

Observar que en el caso de Riesgo Operacional, y por contraposición a Riesgo de

6

Crédito, el VaR calculado computará de forma íntegra a efectos de capital regulatorio .

4

Basilea II establece que las Entidades podrán utilizar ajustes cualitativos para asignar el capital por

riesgo operacional y recoger de esta forma el posible empeoramiento o mejora futuro de la exposición y

entorno de control actuales. Estos ajustes deberán ser realizados de una manera rigurosa y siguiendo

unos criterios razonables.

5

En principio la aproximación cualitativa por si sola no podrá utilizarse para el cálculo de consumo de

capital de la Entidad.

6

El VaR equivale a la suma de las Pérdidas Esperadas (coste del negocio o valor medio de las pérdidas)

e Inesperadas (volatilidad de las pérdidas). En el caso de Riesgo de Crédito las pérdidas esperadas se

encuentran cubiertas con las provisiones contables realizadas y las pérdidas inesperadas con el capital

regulatorio. Sin embargo, en el caso de Riesgo Operacional, para el que a priori no existen este tipo de

provisionamientos, la legislación establece que “las entidades deben calcular los requerimientos de capital

como la suma de pérdidas esperadas e inesperadas (VaR), a no ser que puedan demostrar que la pérdida

esperada se recoge adecuadamente en su práctica de negocio” (“Working document of the Commission

Services on Capital Requirements for Credit Institutions and Investment Firms”, Comisión Europea, (futuro

CAD 3)).

13

•

Mientras una Entidad no pueda demostrar disponer de un sistema íntegro que permita

calcular estimaciones válidas de correlaciones, el VaR total de la Entidad se calculará

mediante la agregación de los VaR calculados a nivel de cada línea de negocio y

tipología de evento.

•

Las entidades podrán reconocer, a efectos de requerimientos de capital, la mitigación

del riesgo derivada de un contrato de seguros que sea contratado a tales efectos.

Dichos contratos deberán cumplir los requerimientos determinados por el supervisor.

Finalmente, mencionar que la metodología propuesta en este documento sigue

las pautas establecidas por los documentos de trabajo emitidos por el Comité de

Supervisión Bancaria de Basilea.

14

2. OBJETIVOS Y APORTACIÓN

La gestión de riesgos es la función principal de las entidades financieras, en torno

a la cual se deben estructurar el resto de funciones. Ello implica que todas las áreas deben

estar involucradas directa o indirectamente en la función de la gestión de riesgos,

definiéndose la estructura organizativa en sintonía con esta filosofía.

El proceso parte de la Alta Dirección de la Entidad, que aprueba el marco de

actuación de riesgos definiendo los tipos de riesgos que desea, los mecanismos de control

y el modelo de evaluación de las diferentes actividades.

Las unidades involucradas en el desarrollo del negocio identifican nuevas

oportunidades de negocio y deben optimizar el perfil de rentabilidad ajustada al riesgo.

Esta actividad se lleva a cabo por los tomadores del riesgo, realizando un análisis y gestión

de la cartera, de forma que permita adecuar el desarrollo del negocio al perfil de riesgo

deseado.

15

Finalmente, se produce el proceso de la Función de Riesgos, que consiste en la

medición diaria de los riesgos incurridos por las unidades tomadoras, el control de los

niveles de riesgo y la evaluación del desempeño de cada uno de ellos.

Las fases y objetivos de la Función de Riesgos son:

Una vez introducido el concepto de gestión del riesgo, distinguiremos entre tres

tipos de riesgo, extendiéndonos más en el que será objetivo de este proyecto.

RIESGO DE MERCADO

El riesgo de mercado es el riesgo de pérdida al que se halla expuesta la entidad

como consecuencia de movimientos adversos en los precios de las variables del mercado.

Atendiendo a la naturaleza de las variables del mercado, se pueden distinguir los

siguientes riesgos de mercado:

-

Riesgo de precio

Riesgo de volatilidad

Riesgo de correlación

Riesgo de liquidez de mercado

16

RIESGO DE CRÉDITO

El riesgo de crédito es el riesgo derivado de la incapacidad y/o intención de la

contraparte de no cumplir con sus obligaciones contractuales. Se pueden distinguir las

siguientes acepciones del riesgo de crédito:

-

Riesgo de contraparte

Riesgo de entrega

RIESGO OPERACIONAL

La definición de riesgo operacional varía desde visiones amplias (todo aquello

que no pueda ser considerado como riesgo de crédito ni riesgo de mercado en sentido

estricto), hasta visiones más restrictivas (riesgo de pérdidas resultado de procesos internos

inadecuados y/o erróneos, personas , sistemas o sucesos externos).

En este sentido, no estarían contemplados:

-

Riesgos de negocio y estratégicos, es decir, errores en la propia toma de

decisiones estratégicas, por parte de la entidad.

Riesgos reputacionales o de imagen ante clientes o medio de comunicación.

Riesgos sistémicos o del entorno. Por ejemplo, incremento general de los

precios de los seguros ante un atentado terrorista en otra entidad.

En cambio, sí estarían contemplados los riesgos legales y regulatorios, es decir, las

posibles sanciones y multas derivadas de no cumplir, en un momento determinado, el

marco regulatorio establecido.

En cualquier caso, las pérdidas operacionales pueden ser directas (quebranto

financiero), indirectas (pérdida de reputación, clientela, etc.) y de coste de oportunidad

(falta de capacidad para acometer negocios).

17

Con anterioridad a iniciar un proceso de definición e implantación de un sistema

de riesgo operacional, se deben establecer claramente los objetivos en relación con el

mismo. Estos objetivos pueden ser cualitativos, cuantitativos o mixtos.

Objetivos cualitativos:

Detectar los riesgos (actuales y potenciales) para tomar decisiones acerca

de los que no desea mantener y desea reducir.

Detectar aquellos riesgos poco frecuentes pero que podrían suponer

grandes pérdidas.

Mejorar continuamente los procesos y sistemas de control para minimizar los

riesgos en los que se puede incurrir.

Objetivos cuantitativos:

Crear conciencia en la organización sobre el nivel y naturaleza de los

eventos de pérdida operacional.

Asignar fondos para la cobertura del mismo.

Medir correctamente la eficiencia de las líneas de negocio incorporando este

riesgo en el cálculo del RAROC.

Incorporar este coste en el pricing de los productos.

18

Objetivos Mixtos:

Evaluar la conveniencia y eficiencia de implantar procedimientos de control

interno.

Evaluar la eficacia de las medidas reductoras de riesgo.

RIESGO OPERACIONAL Y BASILEA II

El Banco Internacional de Pagos, en adelante BIS, fue creado en 1930 y se

constituye como la principal institución para cooperación entre Bancos Centrales

internacionales.

Integra el Comité de Basilea (creado en 1974, del que forman parte los principales

supervisores bancarios, Banco de España desde 2001).

Sus acuerdos y recomendaciones son seguidas por las Entidades Reguladoras de

los países que participan el en Comité, pero también de la mayor parte del resto del

mundo desarrollado.

Su objetivo es formular prácticas estándares en la supervisión bancaria a la espera

de que las autoridades nacionales den los pases necesarios para la puesta en práctica de

dichos estándares (Directivas, leyes, circulares, etc.), ya que en principio no posee ninguna

autoridad formal y sus conclusiones no tienen fuerza legal por sí solas.

Más de 100 países han adoptado el Acuerdo de capital de 1998 (BIS I), que supuso

un gran avance en su momento, pues suponía calcular el consumo de capital por riesgo de

crédito y por riesgo de mercado de la cartea con unas mismas reglas de juego.

En Junio de 1999, el Comité de Basilea (BIS) publicó un primer documento de

consulta sobre el Nuevo Acuerdo de Capital, en el que por primera vez hace referencia al

riesgo operacional.

19

En Enero 2001, el Comité publicó un nuevo documento de consulta en el que se

desarrolla el Nuevo Acuerdo de Capital, y que supuso la introducción de requerimientos de

capital por Riesgo Operacional.

Finalmente, en Junio de 2004, el Comité ha publicado el documento definitivo del

Nuevo Acuerdo de Capital recogiendo dichos requerimientos.

En Julio de 2004 la Comisión Europea ha publicado una propuesta de

modificaciones a sus Directivas (llamado CAD III) que traspone los requerimientos de

capital por Riesgo Operacional de BIS II que, en su versión definitiva, ha sido aprobada por

el Parlamento Europeo el 28 de Septiembre de 2005.

El nuevo acuerdo de Capital (Basilea II) tiene por objeto establecer las directivas

sobre cómo las entidades deben medir su Capital Regulatorio. ¿Qué se entiende por

Capital Regulatorio? Son aquellos recursos de los que debe disponer toda Entidad para

absorber las posibles pérdidas a las que se puede enfrentar su negocio. Dichas pérdidas

pueden ser:

-

Pérdidas esperadas: Son un coste del negocio, reflejan lo que realmente se

espera perder en promedio (valor medio de las pérdidas).

Pérdidas inesperadas: Son una medida de riesgo (volatilidad de pérdidas) que

surge como consecuencia de que las pérdidas reales pueden ser superiores a

las esperadas.

El capital regulatorio son los recursos que legalmente debe mantener una Entidad

para cubrir las pérdidas inesperadas, entendiendo que las pérdidas esperadas se

encuentran cubiertas con las provisiones contables realizadas. No obstante, en el caso de

Riesgo Operacional, para el que a priori no existen este tipo de provisionamientos, las

entidades calcularían los requerimientos de capital como la suma de pérdidas esperadas e

inesperadas (VaR).

20

Tradicionalmente, la gestión del riesgo desarrollada por las entidades se ha

centrado en medir y controlar los riesgos de mercado y de crédito.

Sin embargo, la cada vez más compleja actividad de las entidades financieras y,

fundamentalmente, las experiencias pasadas han reorientado su tratamiento tradicional

(mitigarlo a través de la implantación de procedimientos de control) hacia una gestión

integral del Riesgo Operacional, incluyendo la utilización de metodologías cuantitativas,

anteriormente no utilizadas, de cara a su medición.

En este sentido, las principales entidades financieras españolas han creado una

función de Riesgo Operacional, con responsabilidades que abarcan la medición y el control

del riesgo operacional en un sentido amplio (con creciente involucración de la Alta

Dirección en su identificación).

El desarrollo de esta área en las diferentes entidades debería ir acompañado de la

implantación de un sistema de medición y gestión de riesgo operacional.

21

Objetivos del proyecto

Una de las metodologías que establece el Nuevo Acuerdo de Capital (Basilea II)

para la medición del Riesgo Operacional es la medición a partir de datos internos de

eventos de pérdidas operacionales que se producen en las Entidades. Para ello es

necesario abordar la construcción de una Base de Datos de pérdidas operacionales

(fraudes, multas o sanciones, el valor de los bienes que se destruyen, etc.).

La construcción de dicha base de datos permite:

-

Conocer las pérdidas actuales en las que la Entidad va incurriendo día a día y

los motivos por los que se producen (Fallos en los sistemas, Error en los

procesos, etc.).

Estimar las pérdidas potenciales o inesperadas, a partir de la aplicación de

técnicas estadísticas.

De acuerdo con lo anterior, el Objetivo del Proyecto es:

22

El objetivo del proyecto es desarrollar una aplicación informática que permita

cuantificar el riesgo operacional en las entidades financieras7.

El proyecto de desarrollo de un sistema de medición cuantitativa del riesgo

operacional ha constado de cinco fases.

1.- Diseño de un modelo de datos que sustentara toda la información necesaria

para los cálculos y la información de gestión / reporting a generar.

2.- Desarrollo e implementación de los algoritmos matemático - estadísticos sobre

los que se sustentan los cálculos cuantitativos del Riesgo Operacional. Dada la

importancia de éstos se ha separado en un paquete propio llamado corelib.

Gracias a corelib, paquete matemático – estadístico anteriormente mencionado,

la aplicación es capaz de modelizar tanto en frecuencia como en severidad los datos que

se albergan en la base de datos (eventos de pérdida), dando como resultado un set de

distribuciones estadísticas con sus parámetros, tests y gráficos poder tomar una decisión

correcta acerca de qué distribución ajusta mejor los datos tanto en frecuencia como en

severidad.

3.- Desarrollo e implementación de un simulador de Monte Carlo. El simulador

realizado es un simulador genérico, es decir, válido para un par cualquiera de

distribuciones de frecuencia y severidad. No es necesario que las distribuciones sean unas

de las preseleccionadas, el sistema está concebido de tal manera que el propio usuario

pueda crear su propia distribución. Esta funcionalidad está pensada para dar soporte a

una necesidad que ha surgido del trabajo con la metodología cuantitativa, necesidad que

recibe el nombre de mixtura de distribuciones consistente en crear una nueva distribución

estadística que se ajusta mejor a los datos a partir de dos o más distribuciones

predefinidas.

7

Pérdidas que pueden producirse en una entidad financiera como consecuencia de fallos de

procesos, sistemas, personas o eventos externos

23

4.- Implementación de todos los cálculos y algoritmos desarrollados en una

aplicación web. Se necesitaba una herramienta que fuera capaz de calcular e informar de

los resultados de una manera distribuida. La solución a ese requisito fue una aplicación

J2EE que llamamos simcro. La funcionalidad de cálculo se agrupó en un paquete llamado

corelib, mencionado en el punto 2.-, de manera que quedó aislada de la capa de

presentación y del acceso a base de datos. Al utilizar la plataforma J2EE, la aplicación web

simcro accede a ese paquete y distribuye los resultados del cálculo.

5.- Incorporación de nuevas tecnologías a la aplicación J2EE desarrollada. Nos

referimos a tecnologías tales como:

Mondrian, herramienta OLAP que nos va a proporcionar informes con capacidad

de consulta multidimensional y dinámica.

JCharts, herramienta que nos va a proporcionar todo el soporte gráfico de la

aplicación, es decir, nos va a permitir visualizar los gráficos de ajuste a los datos de la

distribución estadística, gráficos PP – Plot, QQ – Plot y función de exceso sobre la media.

JSci, paquete de distribuciones estadísticas que nos facilita los cálculos de

parámetros y resultados derivados de las distribuciones.

Metodología de trabajo y recursos a utilizar

24

Dentro del marco descrito por la imagen que podemos ver sobre estas líneas,

arquitectura general de una aplicación de cálculo integral del riesgo operacional,

definiremos la arquitectura sobre la que trabajaremos en este proyecto, subconjunto de la

arquitectura que vemos.

25

La tecnología que utilizaremos será J2EE, por lo que el lenguaje de programación

será Java.

En la siguiente imagen podemos ver la descripción del proceso mediante el cual

enviamos peticiones a un servidor y éste nos contesta con la información pedida, esto es

la parte marcada en azul y denominada Contenedor Web. Esto se realizará mediante el

paradigma de request/response del protocolo HTTP.

26

La base de datos contra la que realizaremos todas nuestras será Oracle 9i.

Utilizaremos para llevar a cabo todos los objetivos el paradigma MVC2, Model

View Controller con Jakarta Struts. En el que podemos identificar a la base de datos como

Model, los JSPs como View y El servlet como Controller.

27

3. DESCRIPCIÓN DE LAS TECNOLOGÍAS

En este apartado se intentarán describir tanto las tecnologías utilizadas como la

estructura y funcionamiento interno de la aplicación.

3.1 TECNOLOGÍA UTILIZADA

En este punto se especificará todo lo necesario para haber realizado la aplicación

de medición de riesgo operacional. En primer lugar se explicarán brevemente algunos

conceptos teóricos y paradigmas en los que nos hemos basado en la realización del

proyecto, tras esta explicación se describirán desde las versiones de los componentes

utilizados hasta cómo hacer que éstos funcionen correctamente.

3.1.1

BASE TEÓRICA Y PARADIGMAS

3.1.1.1 TECNOLOGÍA J2EE

28

3.1.1.2 SERVLETS

PARADIGMA REQUEST/RESPONSE

29

CICLO DE VIDA DE UN SERVLET

30

31

ESTRUCTURA

DESPLIEGUE

32

3.1.1.3 JSP

CICLO DE VIDA DE UNA PÁGINA JSP

3.1.1.4 JDBC

33

DRIVERS JDBC

UTILIZACIÓN JDBC

ESTABLECIMIENTO DE LA CONEXIÓN

34

En nuestro caso estableceremos la conexión por medio de un DataSource,

concepto que pasamos a explicar:

DATASOURCE

Una vez que definimos el DataSource obtenemos un objeto de tipo conexión

mediante el cual podemos realizar consultas a base de datos y una vez que hayamos

terminado de realizar estas consultas debemos cerrar.

3.1.1.5 PATRONES DE DISEÑO

35

PATRÓN LAYERS

NIVELES DE UN SISTEMA J2EE

36

MVC2 O WEB MVC

MODELO

-

Representa los datos de la aplicación

-

Expone servicios genéricos para consultar y actualizar el estado

-

Notifica de cambios de estado

-

Solicita el estado del modelo

-

Presenta el modelo

-

Envía las acciones del usuario

VISTA

CONTROLADOR

-

Define el comportamiento de la aplicación

-

Mapea acciones del usuario a actualizaciones del modelo

-

Selecciona la siguiente vista

37

FRONT CONTROLLER

SESSIÓN FAÇADE

38

DATA ACCESS OBJECT (DAO)

39

3.1.1.6 STRUTS

- Framework para crear aplicaciones Web.

- Basado en MVC2

- Software abierto.

- Albergado por Apache Software Foundation

- http://struts.apache.org

- Versión 1.0 en junio 2001

- 30 desarrolladores

- Arquitecto principal: Craig R. McClanahan

40

3.1.2

COMPONENTES UTILIZADOS

A continuación enumeraremos los componentes software que se han necesitado

para la realización de este proyecto.

- Java SDK 1.4.2

- Entorno de desarrollo Eclipse 3.1

- Herramienta Ant para construcción automática

- Servidor J2EE 1.3 (Servidor de referencia API J2EE 1.3.1)

- Oracle 9i

- Struts

- Mondrian (Herramienta de informes multidimensionales)

- JCharts 0.7.5 (Servidor de gráficos e imágenes)

- JSci (Paquete de funciones matemáticas)

- JaMa (Paquete de tratamiento de matrices)

41

3.2 MODELO DE DOMINIO

3.3 DIAGRAMA DE CASOS DE USO

ACTORES:

Usuario

CASOS DE USO:

Usuario:

-

Calcular VaR.

-

Gestionar Usuarios.

-

Gestionar Líneas de Negocio.

-

Consultar Categorías de Riesgo.

42

Caso de uso: Calcular VaR

El usuario de la aplicación, siguiendo los pasos pertinentes, va a calcular el VaR

en las condiciones definidas por él mismo.

Caso de uso: Gestionar Usuarios

El usuario va a poder dar de alta, baja, modificar y realizar listados de los

usuarios existentes.

Caso de uso: Gestionar Líneas de Negocio

El usuario va a poder dar de alta, baja, modificar y realizar listados de las líneas

de negocio existentes.

Caso de uso: Gestionar Categorías de Riesgo

El usuario va a poder dar de alta, baja, modificar y realizar listados de las

categorías de riesgo existentes.

43

3.3.1

CÁLCULO DEL VaR CUANTITATIVO

ACTOR PRIMARIO: Usuario

ACTORES SECUNDARIOS: No hay

TRIGGER: El usuario desea realizar un lanzamiento del VaR

PRECONDICIONES: No hay

ESCENARIO PRIMARIO:

1. El usuario se identifica mediante su login y contraseña.

2. El usuario introduce los criterios de filtrado de los eventos de pérdida.

3. El sistema propone unas distribuciones de frecuencia y severidad.

4. El usuario selecciona la distribución de frecuencia.

5. El usuario selecciona la distribución de severidad.

6. El usuario introduce los datos de parametrización del simulador de Monte

Carlo y lanza el cálculo del VaR.

7. El sistema devuelve los resultados para la simulación lanzada.

44

EXTENSIONES:

1 a. El usuario se ha identificado incorrectamente.

1. El sistema muestra un aviso de que el login o la contraseña son

incorrectos.

2. Se vuelve al paso 1.

4 a. El usuario selecciona ver el gráfico de ajuste de la distribución a los datos.

1. El usuario pulsa el botón diseñado para este uso.

2.

El sistema muestra el gráfico de la distribución seleccionada.

5 a. El usuario selecciona ver el gráfico PP-Plot.

1. El usuario pulsa el botón diseñado para este uso.

2. El sistema muestra el gráfico de la distribución seleccionada.

5 b. El usuario selecciona ver el gráfico QQ-Plot.

1. El usuario pulsa el botón diseñado para este uso.

2. El sistema muestra el gráfico de la distribución seleccionada.

5 c. El usuario selecciona ver el gráfico de Función de Exceso sobre la Media.

1. El usuario pulsa el botón diseñado para este uso.

2. El sistema muestra el gráfico de la distribución seleccionada.

45

DESCRIPCIÓN DE DATOS:

Identificador de datos 1: Criterios de filtrado.

Slicer.

Nota: Slicer es una variable de tipo String que nos devuelve el informe

de eventos de pérdida según vamos filtrando por unos criterios u otros.

Identificador de datos 2: Datos de la parametrización.

Número de veces a realizar.

Número de escenarios.

Alfa.

OTROS REQUERIMIENTOS:

Reglas de negocio: No aplican

46

3.3.2

GESTIÓN DE USUARIOS

ACTOR PRIMARIO: Usuario

ACTORES SECUNDARIOS: No hay

TRIGGER: El usuario desea realizar una operación que tiene como objeto un usuario

PRECONDICIONES: No hay

ESCENARIO PRIMARIO:

1. El usuario se identifica mediante su login y contraseña.

2. El usuario selecciona gestión de usuarios.

3. El usuario realiza las operaciones que desee.

47

EXTENSIONES:

1 a. El usuario se ha identificado incorrectamente.

1. El sistema muestra un aviso de que el login o la contraseña son

incorrectos.

3. Se vuelve al paso 1.

3 a. El usuario selecciona dar de alta un nuevo usuario.

1. El usuario rellena los datos del usuario.

2. El sistema da de alta al usuario definido anteriormente.

3 b. El usuario selecciona modificar un usuario.

1. El usuario selecciona consulta de usuarios y dentro de esta opción, pulsa

el botón definido para la modificación.

2.

El usuario cambia los datos del usuario que desee del usuario en

cuestión.

3. El sistema modifica los datos solicitados por el usuario.

3 c. El usuario selecciona eliminar un usuario.

1. El usuario selecciona consulta de usuarios y dentro de esta opción, pulsa

el botón definido para la eliminación.

2. El sistema elimina el usuario solicitado por el usuario.

48

DESCRIPCIÓN DE DATOS:

Identificador de datos 1: Datos de un usuario.

Nombre.

Contraseña.

Rol.

OTROS REQUERIMIENTOS:

Reglas de negocio: No aplican

49

3.3.3

GESTIÓN DE LÍNEAS DE NEGOCIO

ACTOR PRIMARIO: Usuario

ACTORES SECUNDARIOS: No hay

TRIGGER: El usuario desea realizar una operación que tiene como objeto una línea de

negocio

PRECONDICIONES: No hay

ESCENARIO PRIMARIO:

4. El usuario se identifica mediante su login y contraseña.

5. El usuario selecciona gestión de líneas de negocio.

6. El usuario realiza las operaciones que desee.

50

EXTENSIONES:

1 a. El usuario se ha identificado incorrectamente.

2. El sistema muestra un aviso de que el login o la contraseña son

incorrectos.

4. Se vuelve al paso 1.

3 a. El usuario selecciona dar de alta una nueva línea de negocio.

1. El usuario rellena los datos de la línea de negocio.

2. El sistema da de alta la línea de negocio definido anteriormente.

3 b. El usuario selecciona modificar una línea de negocio.

1. El usuario selecciona consulta de líneas de negocio y dentro de esta

opción, pulsa el botón definido para la modificación.

2.

El usuario cambia los datos de la línea de negocio que desee de la

línea de negocio en cuestión.

3. El sistema modifica los datos solicitados por el usuario.

3 c. El usuario selecciona eliminar una línea de negocio.

1. El usuario selecciona consulta de líneas de negocio y dentro de esta

opción, pulsa el botón definido para la eliminación.

2. El sistema elimina la línea de negocio solicitada por el usuario.

51

DESCRIPCIÓN DE DATOS:

Identificador de datos 1: Datos de una línea de negocio.

Descripción.

Nivel.

OTROS REQUERIMIENTOS:

Reglas de negocio: No aplican

52

3.3.4

GESTIÓN DE CATEGORÍAS DE RIESGO

ACTOR PRIMARIO: Usuario

ACTORES SECUNDARIOS: No hay

TRIGGER: El usuario desea realizar una operación que tiene como objeto una categoría

de riesgo

PRECONDICIONES: No hay

ESCENARIO PRIMARIO:

7. El usuario se identifica mediante su login y contraseña.

8. El usuario selecciona gestión de categorías de riesgo.

9. El usuario realiza las operaciones que desee.

53

EXTENSIONES:

1 a. El usuario se ha identificado incorrectamente.

3. El sistema muestra un aviso de que el login o la contraseña son

incorrectos.

5. Se vuelve al paso 1.

3 a. El usuario selecciona dar de alta una nueva categoría de riesgo.

1. El usuario rellena los datos de la categoría de riesgo.

2. El sistema da de alta la categoría de riesgo definido anteriormente.

3 b. El usuario selecciona modificar una categoría de riesgo.

1. El usuario selecciona consulta de categorías de riesgo y dentro de esta

opción, pulsa el botón definido para la modificación.

2.

El usuario cambia los datos de la categoría de riesgo que desee del

usuario en ocasión.

3. El sistema modifica los datos solicitados por el usuario.

3 c. El usuario selecciona eliminar una categoría de riesgo.

1. El usuario selecciona consulta de categorías de riesgo y dentro de esta

opción, pulsa el botón definido para la eliminación.

2. El sistema elimina la categoría de riesgo solicitado por el usuario.

54

DESCRIPCIÓN DE DATOS:

Identificador de datos 1: Datos de una categoría de riesgo.

Descripción.

Nivel.

OTROS REQUERIMIENTOS:

Reglas de negocio: No aplican

55

3.4 OTROS REQUISITOS

3.4.1

REGLAS DE NEGOCIO

No aplican.

3.4.2

RESTRICCIONES

La base de datos del sistema será Oracle 9i.

El motor de servlets y el servidor Web será J2EE 1.3.1.

El lenguaje de programación utilizado para la aplicación Web será Java. Los

fuentes deberan ser compatibles, sin errores, y ejecutables con la versión 1.4.2 del JDK de

SUN.

Se utilizarán servlets (versión 2.4) y páginas JSP (versión 2.0) para el nivel de

presentación de la aplicación.

Se utilizará el framework transaccional JOTM versión 2.0.10.

Se utilizará el framework MVC Structs 1.2.

Se utilizará la herramienta Ant para construcción automática..

Se utilizará Mondrian (Herramienta de informes multidimensionales).

Se utilizará JCharts 0.7.5 (Servidor de gráficos e imágenes).

Se utilizará JSci (Paquete de funciones matemáticas).

Se utilizará JaMa (Paquete de tratamiento de matrices).

56

El sistema debe estar acabado a finales de Mayo.

El proyecto se va a dividir en cuatro partes:

-

Diseño de la herramienta.

-

Desarrollo Matemático.

-

Desarrollo de la aplicación J2EE.

-

Integración con otras tecnologías.

-

Documentación

Diseño de la herramienta

Fecha: Navidades; consta de:

Modelo de dominio: uno o varios diagramas de clase mostrando entidades del

dominio, sus propiedades y relaciones relevantes. Un glosario ordenado describiendo cada

una de las clases del modelo.

Modelo de casos de uso: uno o varios diagramas que muestren los casos de uso

y actores del sistema. Una descripción detallada de los casos de uso incluidos en la

iteración.

Otros requisitos: Reglas de negocio, restricciones y requerimientos no

funcionales.

57

Diagrama de la arquitectura: un diagrama de paquetes mostrando los

subsistemas en que se descompone el sistema y las dependencias entre ellos. Una

descripción del contenido y la función de cada uno de los subsistemas.

Modelo dinámico detallado: Diagrama de iteración (secuencia o colaboración)

para cada caso de uso incluido en la iteración. Al menos uno para cada escenario primario.

Al menos un diagrama de actividad, este puede ser para un caso de uso completo o bien

algún algoritmo complejo. Al menos un diagrama de estado para alguna clase compleja.

Modelo estructural detallado: Diagramas de clase detallados de cada uno de los

paquetes o subsistemas de la arquitectura, consistentes con el modelo de dominio

detallado.

Diseño de la base de datos: diseño lógico de a base de datos: tablas, campos y

sus tipos, claves primarias y extranjeras.

Desarrollo matemático

Fecha: Navidades; consta de:

Corelib: Conjunto de clases matemáticas que darán todo el soporte de cálculo a

la herramienta.

Set de pruebas con Matlab: Las clases que se dedican a la realización de

cálculos, clases que acabamos de describir, serán probadas en su totalidad con el

desarrollo de unas pequeñas clases de prueba en Matlab. El objetivo de estas pruebas es

comprobar que nuestro paquete matemático es fiable.

58

Desarrollo de la aplicación J2EE

Fecha: Semana Santa; consta de:

Simcro: Siglas que representan: “Sistema de Medición Cuantitativa de Riesgo

Operacional”. Así es como se ha nombrado a esta aplicación. El desarrollo de la aplicación

no es otra cosa que implementar todo el diseño de la aplicación realizado en la primera

fase de este proyecto.

Integración con otras tecnologías

Fecha: 31 Mayo 2006; consta de:

En esta última fase se ha integrado Simcro con Corelib y con otras tecnologías ya

mencionadas como Mondrian y JCharts principalmente. Como resultado obtenemos una

herramienta de medición de cálculo operacional con unos informes multidimensionales de

los eventos de pérdida que conforman el lanzamiento del cálculo del VaR y apoyo gráfico

para la toma de decisión que hay que realizar al modelizar la pérdida en cuanto a

frecuencia y a severidad.

Documentación

Fecha: A lo largo de todo el proyecto; consta de:

Desarrollo de la memoria del proyecto.

59

3.4.3

REQUERIMIENTOS NO FUNCIONALES

El sistema deberá tener una disponibilidad e 24 x 7.

Un usuario experto en el dominio deberá dominar el sistema en una semana tras

haber recibido un curso básico de formación.

60

3.5 DIAGRAMA DE ARQUITECTURA

3.5.1

DIAGRAMA DE PAQUETES

3.5.2

DESCRIPCIÓN

Se muestra el diagrama de paquetes del sistema. El sistema se divide en cinco

subsistemas:

-

subsistema com.msspain.simcro.core

-

subsistema com.msspain.simcro.iu

-

subsistema com.msspain.simcro.services

-

subsistema com.msspain.simcro.dao

-

subsistema com.msspain.simcro.domain

61

En el subsistema com.msspain.simcro.core están las clases comunes a todo el

proyecto tales como algunas constantes de la aplicación, una clase de excepciones

y la clase ChartServlet que es la que define todo el comportamiento del servidor de

imágenes de la aplicación.

En el subsistema com.msspain.simcro.iu están todos los paquetes que se

encargan de interactuar con el usuario, se han creado tres paquetes:

-

paquete com.msspain.simcro.iu.actions

-

paquete com.msspain.simcro.iu.forms

-

paquete com.msspain.simcro.iu.graphics

El paquete actions recoge todas las acciones que realiza el usuario en nuestra

aplicación, sabe como tratarlas y las encamina a los servicios necesarios para

obtener los resultados deseados por el usuario.

El paquete forms incluye lo que se denominan form-bean, que son clases que

únicamente están formadas por la definición de atributos con sus getters y setteres,

típicamente se utilizan para facilitar la interacción con el usuario.

Por último, el paquete graphics está compuesto por las clases necesarias para

poder visualizar los gráficos solicitados.

Este subsistema depende del subsistema com.msspain.simcro.services y del

subsistema com.msspain.simcro.domain.

En el subsistema com.msspain.simcro.services se han agrupado todos los

servicios que se le ofrecen al subsistema com.msspain.simcro.iu, en ellos están la

lógica del sistema. Este subsistema servicios depende del subsistema

com.msspain.simcro.dao y del subsistema com.msspain.simcro.domain.

62

En el subsistema com.msspain.simcro.dao se han agrupado todos los

paquetes que se encargan de interactuar con la base de datos. Este subsistema

depende del subsistema com.msspain.simcro.domain.

En el subsistema com.msspain.simcro.domain se encuentran todos los

paquetes que se encargan de los objetos que existen en el sistema. En él se

apoyan el resto de subsistemas.

63

3.6 MODELO DINÁMICO DETALLADO

3.6.1

DIAGRAMAS DE INTERACCIÓN

3.6.1.1 CASO DE USO: CÁLCULO DEL VaR

3.6.1.1.1 FILTRADO DE EVENTOS DE PÉRDIDA

64

3.6.1.1.2 PARAMETRIZAR FRECUENCIA

65

3.6.1.1.3 VER HISTOGRAMA DE FRECUENCIAS

66

3.6.1.1.4 SELECCIONAR DISTRIBUCIÓN DE FRECUENCIA

67

3.6.1.1.5 VER GRÁFICO PP – PLOT

68

3.6.1.1.6 VER GRÁFICO QQ – PLOT

69

3.6.1.1.7 VER GRÁFICO FUNCIÓN DE EXCESO SOBRE LA MEDIA

70

3.6.1.1.8 SELECCIONAR DISTRIBUCIÓN DE SEVERIDAD

71

3.6.1.1.9 LANZAR SIMULACIÓN

72

3.6.1.1.10 OBTENER RESULTADOS

73

3.6.1.2 CASO DE USO: GESTIONAR USUARIOS

3.6.1.2.1 DAR DE ALTA UN USUARIO

74

3.6.1.2.2 MODIFICAR UN USUARIO

75

3.6.1.2.3 ELIMINAR UN USUARIO

76

3.6.1.2.4 CONSULTAR UN USUARIO

77

3.6.1.3 CASO DE USO: GESTIONAR LÍNEAS DE NEGOCIO

3.6.1.3.1 DAR DE ALTA UNA LÍNEA DE NEGOCIO

78

3.6.1.3.2 MODIFICAR UNA LÍNEA DE NEGOCIO

79

3.6.1.3.3 ELIMINAR UNA LÍNEA DE NEGOCIO

80

3.6.1.3.4 CONSULTAR UNA LÍNEA DE NEGOCIO

81

3.6.1.4 CASO DE USO: GESTIONAR CATEGORÍAS DE RIESGO

3.6.1.4.1 DAR DE ALTA UNA CATEGORÍA DE RIESGO

82

3.6.1.4.2 MODIFICAR UNA CATEGORÍA DE RIESGO

83

3.6.1.4.3 ELIMINAR UNA CATEGORÍA DE RIESGO

84

3.6.1.4.4 CONSULTAR UNA CATEGORÍA DE RIESGO

85

3.7 MODELO ESTRUCTURAL DETALLADO

3.7.1

SUBSISTEMA COM.MSSPAIN.SIMCRO.CORE

86

3.7.2

SUBSISTEMA COM.MSSPAIN.SIMCRO.IU

87

88

89

3.7.3

SUBSISTEMA COM.MSSPAIN.SIMCRO.SERVICES

90

3.7.4

SUBSISTEMA COM.MSSPAIN.SIMCRO.DAO

91

3.7.5

SUBSISTEMA COM.MSSPAIN.SIMCRO.DOMAIN

92

3.8 DISEÑO DE LA BASE DE DATOS

93

3.9 DISEÑO DE LA APLICACIÓN

3.9.1

IDENTIFICACIÓN

94

3.9.2

PANTALLA PRINCIPAL

95

3.9.3

INFORME DE EVENTOS DE PÉRDIDA

96

3.9.4

SELECCIÓN AGRUPACIÓN FRECUENCIA

97

3.9.5

DISTRIBUCIÓN DE FRECUENCIAS

98

3.9.6

AJUSTE DE LA DISTRIBUCIÓN

99

3.9.7

AJUSTE DE LA DISTRIBUCIÓN II

100

3.9.8

DISTRIBUCIÓN DE SEVERIDAD

101

3.9.9

QQ-PLOT

102

3.9.10 FUNCIÓN DE EXCESO SOBRE LA MEDIA

103

3.9.11 PP – PLOT

104

3.9.12 PARAMETRIZACIÓN DE LA SIMULACIÓN DE MONTECARLO

105

3.9.13 INFORME VaR

106

107

3.9.14 MÓDULO ADMINISTRACIÓN

108

3.9.15 MÓDULO ADMINISTRACIÓN II

109

110

4. METODOLOGÍA CUANTITATIVA

La metodología cuantitativa genera, a partir de la información recogida de la base

de datos de pérdidas operacionales una cifra de VaR Operacional (en adelante, VaR

Operacional Cuantitativo)

4.1 DESCRIPCIÓN GENERAL DEL MODELO

El modelo de distribución de pérdidas (LDA) requiere de la modelización de la

función de distribución de las pérdidas operacionales para cada tipología de evento y

línea de negocio, durante un determinado período de tiempo, de acuerdo con los datos

históricos de pérdidas operacionales recogidas en la base de datos de pérdidas.

Esta modelización se realizará, en un principio, y suponiendo que existiera

información histórica suficiente, sobre tipología de eventos de Nivel 3 (o Nivel 2 en su

caso) de Basilea. Si no existieran datos suficientes a este Nivel, la modelización se

8

realizaría a niveles superiores , documentando debidamente esta decisión.

En algunos casos la Entidad podrá realizar hipótesis sobre la distribución a

utilizar para ajustar la frecuencia y severidad de determinadas tipologías de riesgos (por

ejemplo, una distribución de Poisson en la frecuencia y una distribución Lognormal en la

severidad). Esto podrá ser de especial aplicación en los casos en que exista un problema

de datos.

Realizar la modelización para cada tipología de evento de Nivel 3 (o niveles

superiores en su caso) conlleva cubrir las siguientes etapas:

1. Modelización de la función de distribución de la frecuencia de ocurrencia de los

eventos operacionales.

2. Modelización de la función de distribución de los impactos o pérdidas por evento

(severidades).

3. Obtención de la distribución agregada de pérdidas operacionales para dicho

evento / línea de negocio. Cálculo del Valor en Riesgo Operacional, Pérdidas

esperadas e inesperadas.

8

Este caso podría suponer trabajar con una población de eventos de muy distinta naturaleza lo cual

dificultaría el ajuste de la distribución de pérdidas operacionales.

111

Núm ero de

ev en to s

Núm e ro de

ev en tos

Probabilidad

in

Im

p

div ac

id t o

ua

l

in

Im

p

d iv a ct

id o

ua

l

Probabilidad

Probabilidad

Probabilidad

Núm e ro de

ev en tos

P é rd id a s o p e r a c io n a le s

La necesidad de modelizar de forma separada las distribuciones de probabilidad

de las frecuencias de ocurrencia de los eventos y las pérdidas de los mismos se

fundamenta en que determinadas acciones o inacciones operacionales no suelen afectar a

ambos procesos por igual.

112

Calculados los VaRs Operacionales para cada tipología de evento a un

determinado Nivel (Nivel 3 por ejemplo), el paso a los niveles superiores se llevará a cabo

mediante la suma de los VaRs de los correspondientes eventos de nivel inferior que lo

compongan, obteniendo así el Valor en Riesgo Operacional para cada evento / línea de

negocio.

Recogida y

agrupación de

información

Inputs de la

metodología

•Identificación de

eventos de pérdida

•Recogida en BBDD

corporativa

•Agrupación de

eventos a Nivel III

Modelización de

frecuencias y

severidades

•Ajuste de la

distribución de

frecuencia (Poisson,

Binomial Negativa, etc.)

•Ajuste de la

distribución de

severidades (Weibull,

Lognormal, etc.)

Cálculo de

Value-at-Risk

•Cálculo de VaR a Nivel III

mediante convolución de

distribuciones utilizando

simulaciones de Monte

Carlo.

•El VaR a Nivel II y I se

obtiene sumando los VaR de

Nivel III

BBDD externa

Ajuste distribución Frecuencia

Ajuste distribución Severidad

+

+

VaR

Nivel I

Base de

datos de

Eventos

VaR

Nivel II

Entradas manuales

VaR Nivel

III

Transaccional

III

Eventos

Basilea II

I

II

III

Modelización y

cálculo de VaR

Eventos

Entidad

II

Basilea II

I

Entidad

Entidad

Basilea II

Registros contables

I

II

III

Eventos

* Diagrama realizado para el supuesto de modelización a Nivel 3.

Una vez realizada la modelización para cada evento / línea de negocio, la

Entidad podría aplicar coeficientes de correlación entre los diversos eventos de pérdida y

entre estos y los diferentes factores de Riesgo Operacional a efectos del cálculo del VaR

final.

Para ello debería disponer de datos suficientes y de un modelo de cálculo que le

9

permita su cálculo. En caso contrario el cálculo del capital regulatorio se obtendrá por

mera agregación de los Valores en Riesgo calculados para cada tipología de evento y

línea de negocio (sin considerar, por tanto, el efecto de la correlación).

9

Existen algunos estudios cuantitativos sobre como modelizar dichas correlaciones, si bien se encuentran

todavía en una fase muy preliminar.

113

En los siguientes apartados desarrollamos cada una de las etapas mencionadas

para la obtención del Riesgo Operacional para cada evento / línea de negocio a un

determinado nivel de riesgo.

114

4.2 MODELIZACIÓN DE LA FUNCIÓN DE LA DISTRIBUCIÓN DE

FRECUENCIAS

Las funciones de distribución de probabilidad que mejor modelizan la frecuencia

de ocurrencia de los eventos operacionales son las distribuciones discretas de Poisson,

Binomial y Binomial Negativa, ya que estas distribuciones estadísticas se utilizan para

modelizar experimentos cuyo resultado es, precisamente, la ocurrencia o no de un

determinado evento (en nuestro caso la ocurrencia o no ocurrencia de un evento de riesgo

operacional determinado).

Para seleccionar, de estas 3 distribuciones, la que mejor se ajuste a los datos

disponibles proponemos 3 métodos de análisis complementarios:

“REGLA SENCILLA”

HISTOGRAMA

TEST DE BONDAD DE AJUSTE CHI-CUADRADO.

4.2.1

“Regla sencilla”

Se calcula la media y la varianza de los datos de frecuencia disponibles en el

período de observación. Cuando la varianza y la media son similares, se optaría por la

distribución de Poisson, cuando la media es claramente inferior a la varianza, por la

Binomial Negativa (significa que existe riesgo de grandes pérdidas frente a la media) y, en

el caso contrario, por la distribución Binomial.

Esta regla sencilla es utilizada, más que como regla de selección de

distribuciones, como regla de eliminación. Por ejemplo, el hecho de que la media sea

menor que la varianza elimina la posibilidad de elección de la Binomial ya que no es

posible calcular los parámetros de ésta en dicha situación.

La Binomial queda unívocamente determinada mediante los parámetros n y p, siendo n

un número Natural mayor que 0 y p un número Real entre 0 y 1. El estimador de los momentos para

ellos es:

p estimado =

media − var ianza

media

nestimado =

media 2

media − var ianza

Sólo si la media es mayor que la varianza estos parámetros tomarán valores en sus respectivos

rangos de definición, pues en caso contrario p<0 y n<0.

115

Lo mismo ocurre con la Binomial Negativa, en el caso en que la media sea mayor

que la varianza.

La Binomial Negativa queda unívocamente determinada mediante los parámetros N y p,

siendo N un número Natural mayor que 0 y p un número Real entre 0 y 1. El estimador de los

momentos para ellos es:

p estimado =

N estimado

media

var ianza

media 2

=

var ianza − media

Sólo si la media es menor que la varianza estos parámetros tomarán valores en sus

respectivos rangos de definición, pues en otro caso p>1 y N<0.

Sin embargo, eliminar o no la distribución de Poisson lleva consigo definir el

“significado de similitud” de la media y la varianza. Es decir: ¿qué distancia máxima ha de

existir entre media y varianza para que puedan considerarse similares?

La Poisson queda unívocamente determinada por un único parámetro (λ) que coincide

con la media y la varianza. El estimador de los momentos y de máxima verosimilitud del parámetro

es la media.

λestunado = media

Por este motivo la decisión de eliminar o no la distribución de Poisson no se

tomará en esta fase sino a partir del estudio de los histogramas y los test de ajuste como

se explica a continuación.

EJEMPLO:

Se obtiene de la base de datos de eventos operacionales, el número de fraudes diarios

que se producen en la Red de sucursales de una entidad bancaria.

116

Se calcula la media y la varianza:

MEDIA: Número medio de fraudes que se producen al día.

n

MEDIA =

∑x

i

i =1

n

donde:

n: número de días en los que se han observado la cantidad de fraudes ocurridos.

x i: número de fraudes observados en el día i-ésimo.

117

En el ejemplo la media es 4.8788 y se puede calcular con la función “AVERAGE” de EXCEL.

VARIANZA: Medida del grado de dispersión de los datos en relación con la media.

2

n

VARIANZA =

∑ (x

i =1

i

− media )

n

en la cual n y xi se definen de la misma manera que el apartado anterior.

En el ejemplo la varianza es 10.8338 y se puede calcular con la función “VAR” de EXCEL.

CONCLUSIÓN EJEMPLO:

En este caso la media es menor que la varianza con lo cual la distribución Binomial queda

descartada. La elección ahora está entre la Poisson y la Binomial Negativa. Dado que el número de

observaciones no es muy grande, descartar la Poisson sería arriesgado. Se dejará a los

histogramas y test de bondad de ajuste esta decisión.

Fichero de EXCEL de referencia: frecuencia.xls / método sencillo.

4.2.2

Histograma

El histograma es una representación gráfica de las frecuencias observadas de

distintos sucesos. Cada suceso se representa en el histograma mediante una barra cuya

altura representa la frecuencia de dicho suceso.

En el caso que nos ocupa, los sucesos son el número de eventos de un riesgo

operacional concreto, que se producen en un intervalo de tiempo definido a priori.

Construyendo una gráfica que incluya el histograma y varios ajustes teóricos se

podrá tener una visión gráfica de qué distribución proporciona el mejor ajuste.

EJEMPLO:

Una vez descartada la Binomial, la elección está entre la Poisson y la Binomial negativa.

El gráfico muestra la relación entre frecuencias observadas y esperadas mediante el

histograma y los ajustes Poisson y Binomial Negativa, lo que permite comparar qué distribución se

ajusta mejor a los datos.

118

8

7

6

frec.observadas

5

frec.teórica

Poisson

4

3

frec.teórica

Binomial

Negativa

2

1

0

0

1

2

3

4

5

6

7

8

9 10 11 12 13

CONCLUSIÓN EJEMPLO:

Se observa que la distribución Binomial Negativa ajusta mejor los datos que la Poisson.

Por tanto la conclusión del histograma es que el mejor ajuste es el que proporciona la Binomial

Negativa.

Fichero de EXCEL de referencia: frecuencia.xls / gráficos

4.2.3

Test de bondad de ajuste CHI- CUADRADO

Es el test estadístico más comúnmente utilizado para medir la bondad del

ajuste de los datos empíricos a la distribución teórica, en el caso de distribuciones

discretas.

Este test consiste en medir las distancias entre las frecuencias observadas y las

frecuencias esperadas o ajustadas por la distribución teórica. Si estas distancias son

pequeñas se concluirá que la población se ajusta a la distribución elegida y en caso

contrario se rechazará esa distribución.

El estadístico en el que se fundamenta el test es el Estadístico de Pearson (Tk),

cuya distribución es conocida.

119

Este estadístico para ser calculado precisa dividir el recorrido de la distribución

poblacional en k conjuntos disjuntos A 1, A 2,...., A k y se define del siguiente modo:

k

(Oi − ei )2

i =1

ei

Tk = ∑

k

(Oi − npi 0 )2

i =1

np i 0

=∑

donde:

pi0: probabilidad de cada A i bajo la distribución teórica elegida que denotaremos por F0.

n: tamaño de la población.

Oi: número de observaciones que forman Ai

ei: número de observaciones esperadas para Ai, esto es: ei = n*pi0.

Por tanto, Tk acumula las diferencias al cuadrado entre el número de observaciones en

cada conjunto Ai y el número de ellas que cabría esperar según F0, ponderándolas mediante 1/ei

(puesto que no parece lógico dar la misma importancia a una diferencia de 2, por ejemplo, donde

eran de esperar 20 observaciones que donde había que esperar solamente 5).

2

La distribución del estadístico Tk, cuando n tiende a infinito, converge a una χ k-1-p

siendo k el número de grupos realizados y p el número de parámetros que ha sido necesario

2

estimar para definir la distribución teórica. Luego una χ k-1-p proporciona una distribución

aproximada para Tk. Ahora bien, para que la aproximación sea aceptable, es aconsejable que:

Los conjuntos A i , se elijan de forma que cumpla que npi0 ≥ 5 para cada i=1,2,...,k.

El número k de elementos de la partición no sea inferior a 5 (salvo en ajustes a

distribuciones discretas con menor número de valores posibles) .