1. Mínimos Cuadrados

Anuncio

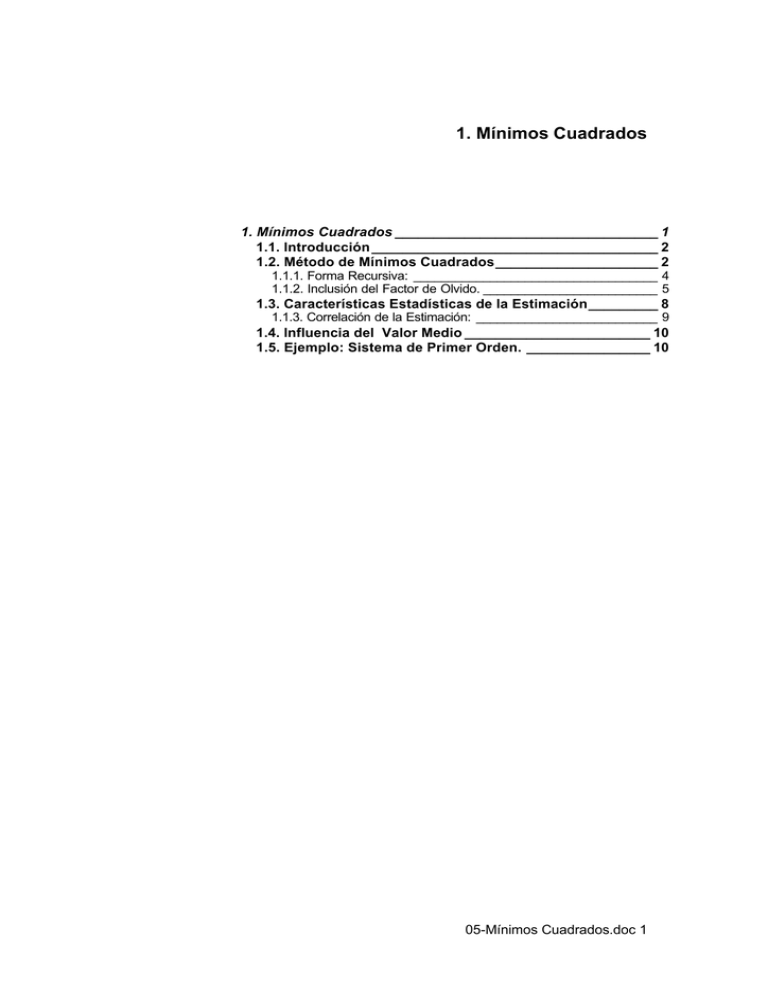

1. Mínimos Cuadrados 1. Mínimos Cuadrados __________________________________ 1 1.1. Introducción _____________________________________ 2 1.2. Método de Mínimos Cuadrados_____________________ 2 1.1.1. Forma Recursiva: ___________________________________ 4 1.1.2. Inclusión del Factor de Olvido. _________________________ 5 1.3. Características Estadísticas de la Estimación_________ 8 1.1.3. Correlación de la Estimación: __________________________ 9 1.4. Influencia del Valor Medio ________________________ 10 1.5. Ejemplo: Sistema de Primer Orden. ________________ 10 05-Mínimos Cuadrados.doc 1 1.1. Introducción Se abordará en este capítulo la modelización de sistemas lineales mediante técnicas de mínimos cuadrados ya que es uno de los pilares para el desarrollo del control adaptativo. Este mecanismo es llamado comúnmente Identificación de Sistemas. Lo que intenta el método es automatizar la búsqueda de la relación causa-efecto entre excitación y respuesta de un proceso dado. De igual manera, se perturba al sistema con una determinada señal y se toman pares de muestras de entrada y salida. Se construye una tabla con estos pares para calcular los coeficientes de un modelo previamente definido. El método más usual para este cómputo es el de mínimos cuadrados del cual se desprenden una cantidad apreciable de algoritmos modificados. Se particularizará el análisis para modelos lineales expresados en ecuaciones en diferencias. La representación gráfica del método se puede ver en la figura siguiente en donde se observa que la excitación tiene efecto sobre la planta y sobre el modelo. Ambos generan una salida que serán más o menos similares dependiendo de la bondad del modelo. La diferencia, llamada también error de estimación o predicción, es la que se utiliza como realimentación para corregir el modelo. Excitación Planta Salida de la Planta + Error de Estimación - Modelo Salida del Modelo Ilustración 1-1 Identificación de Parámetros 1.2. Método de Mínimos Cuadrados Se considera, a los efectos del análisis, la siguiente planta real: n m i=1 i=0 n m i=1 i=0 y k +1 = ∑ a i y k-i +1 + ∑ biuk −i + ek = x kT θ k + ek [1-1] siendo e′ una perturbación o incertidumbre por momento genérica. Se propone un modelo de la misma forma es decir: yˆ k +1 = ∑ aˆ i y k-i +1 + ∑ bˆi u k-i = x Tk θˆk [1-2] 05-Mínimos Cuadrados.doc 2 donde aˆ 1 yk M M aˆ n y k-n +1 xk = θˆk = ˆ b0 uk M M bˆm 1× N = n +m +1 u k-m 1× N = n +m +1 [1-3] Se ha definido una forma vectorial de escribir el modelo y planta a fin de compactar la notación. Para cada instante k habrá un error o diferencia entre la salida de la planta y la del modelo: ek +1 = yk +1 − yˆk +1 [1-4] Si se toman todas las muestra, desde 0 hasta k se puede construir un vector de errores de la forma: ek +1 Ek +1 = M = Y k +1 - φ kθˆ e1 [1-5] con y k +1 Y k +1 = M y1 aˆ1 M aˆn , θˆ = ˆ b0 M bˆm x Tk y k K φk = M = M x T0 y 0 K [1-6] y k-n +1 u k K u k-m M M M y1-n u 0 K u -m [1-7] El modelo será más exacto cuanto más pequeño sea el error de estimación. Este error es dependiente de las mediciones y del vector de parámetros θˆ . Ahora el objetivo es buscar este vector tal que el error entre modelo y planta sea el menor posible. Una forma de lograrlo es construyendo un funcional J de la forma J k = e Tk ⋅ e k [1-8] y minimizarlo, es decir estamos calculando el mínimo error cuadrático en el modelo. Para realizar esto se deriva con respecto a θˆ resultando: 05-Mínimos Cuadrados.doc 3 T T ∇ pJ |pˆ = 2φ Y - 2φ φθˆ = 0 el valor de θˆ que hace mínimo J es: * T θˆk = φ k φ k −1 φk Y k T [1-9] [1-10] Con esto estaría resuelto el problema de encontrar un modelo ya que θˆ queda expresado en función de datos. Existen en esta forma de expresar el modelo dos inconvenientes: primero, se debe conocer previamente todas las muestras y segundo, en el cálculo se presenta la inversión de una matriz que no es muy cómodo desde el punto de vista computacional. Se analizará más adelante una vía de llegar a otra expresión que evite estos problemas. 1.1.1. Forma Recursiva: Analicemos una forma más cómoda de expresar la ecuación [1-10]. Primero definamos la matriz P como sigue: x Tk-N k-N -1 φ kT φ = P -1k = [ x k-N K x0 ] M = ∑ x i x iT = P k-1 + x k x Tk xT0 i=0 [1-11] Del mismo modo el vector b será: y k-N k-N T bk = φ k Y k = [ x k-N K x0 ] M = ∑ x i y i = bk-1 + x k y k i=0 y 0 [1-12] Entonces [1-10] se expresará θˆk = P k bk [1-13] La inversa de la matriz P en un instante k puede expresarse en función de su valor anterior más otra matriz [1-14] P -1k = P -1k-1 + x k x kT Si la premultiplicamos por Pk Pk P k = I = Pk P -1k-1 + Pk x k x Tk y luego, posmultiplicando por Pk −1 resulta: -1 P k-1 = P k + P k x k xTk P k-1 [1-15] [1-16] o lo que es lo mismo P k-1 - P k = P k x k x kT P k-1 [1-17] Posmultipliquemos [1-16] por xk T T P k-1 x k = P k x k + P k x k x k P k-1 x k = P k x k 1 + x k P k-1 x k [1-18] y agrupemos. 05-Mínimos Cuadrados.doc 4 -1 T P k-1 x k 1 + x k P k-1 x k = P k x k [1-19] Ahora, reemplazando [1-19] en [1-17] T P k-1 - Pk = P k-1 x k x k P k-1 1 + xTk P k-1 x k [1-20] o su equivalente T P k-1 x k x k P k-1 P k = P k-1 1 + xTk P k-1 x k [1-21] Haremos lo mismo con el vector θ . Por la ecuación [1-19] tenemos [1-22] T P k x k x k P k-1 [b k-1 + x k y k ] θˆk = P k-1 1 + xTk P k-1 x k = θˆk-1 - T P k-1 x k x k P k-1 [bk-1 + x k y k ] + P k-1 x k y k 1 + x Tk P k-1 x k por [1-19] sabemos que: Pk x k = P k-1 x k 1 + x Tk P k-1 x k [1-23] reemplazando en la anterior T T θˆk = θˆk-1 - P k x k x k P k-1 bk-1 - P k x k x k P k-1 x k y k + P k-1 x k y k = θˆk-1 - P k x k x kT pˆ k-1 + P k-1 - P k x k x kT P k-1 x k y k [1-24] de [1-17] resulta P k = P k-1 - P k x k x kT P k-1 [1-25] quedando T θˆk = θˆk-1 - P k x k x k θˆk-1 - y k [1-26] en resumen el algoritmo está formado por las dos ecuaciones siguientes: θˆk = θˆk-1 - P k x k [ yˆ k - y k ] T P k-1 x k x k P k-1 = P k P k-1 1 + xTk P k-1 x k [1-27] 1.1.2. Inclusión del Factor de Olvido. En el algoritmo anterior pesamos de igual manera las medidas muy viejas y las nuevas. Esto puede traer complicaciones cuando la planta cambie sus parámetros. En este caso el vector θ no podrá converger al nuevo valor. Modificaremos este algoritmo para pesar de forma exponencial las distintas muestras según el instante en que han sido tomadas. Esto se logra modificando el funcional J siendo ahora J = eTk ⋅ Q ⋅ ek [1-28] 05-Mínimos Cuadrados.doc 5 donde Qk = 1 0 M 0 0 α M 0 L L L k-N α 0 0 M [1-29] La matriz Q pondera las muestras dándole más o menos importancia a la historia con respecto al último valor según el parámetro α el cual se llama factor de olvido. Igual que antes derivamos J para obtener el mínimo. T T [1-30] ∆ pJ |pˆ = 2Φ Q Y - 2 Φ Q Φpˆ = 0 resultando -1 * T T θˆk = Φ k Q k Φ k Φ k Q k Y k [1-31] La matriz P ahora será: x Tk- N φ Tk Qφ = P -1k = [ x k-N K x 0] Q M = xT0 [1-32] k-N = ∑ α i xi x Ti = α P -1k-1 + x k xTk i=0 T -1 T P = φ k Qk φk = α P k-1 + x k x k -1 k [1-33] Del mismo modo el vector b será: y k - N k-N i bk = φ Y k = [ x k-N K x0 ] Q M = ∑ α x i y i = α b k-1 + x k y k i=0 y 0 T bk = φ k Q k Y k = α b k-1 + xk y k T k [1-34] [1-35] Entonces se expresará θˆk = P k bk [1-36] La inversa de la matriz P en un instante k puede expresarse en función de su valor anterior más otra matriz Pk−1 = α Pk−−11 + xk xkT [1-37] Si la premultiplicamos por Pk Pk Pk−1 = I = α Pk Pk−−11 + Pk xk xkT y luego, posmultiplicando por Pk −1 resulta: Pk −1 = α Pk + Pk xk xTk Pk−1 [1-38] [1-39] o lo que es lo mismo 05-Mínimos Cuadrados.doc 6 Pk −1 − α Pk = Pk xk xTk Pk−1 [1-40] Posmultipliquemos [1-39] por xk Pk −1xk = α Pk xk + Pk xk xTk Pk −1xk = Pk xk α + xkT Pk −1 xk [1-41] y agrupemos. −1 Pk −1xk α + xkT Pk −1 xk = Pk xk [1-42] Ahora, reemplazando [1-19] en [1-17] Pk −1 − α Pk = Pk −1xk xTk Pk−1 α + xTk Pk −1 xk [1-43] o su equivalente 1 Pk −1xk xTk Pk −1 Pk = Pk −1 − α α + xkT Pk −1 xk [1-44] Haremos lo mismo con el vector θ . Por la ecuación [1-19] tenemos [1-45] θˆk = Pk −1xk xTk Pk −1 1 P − [α bk-1 + xk yk ] = α k −1 α + xkT Pk −1xk = θˆ k-1 − 1 1 P k-1 x k xTk P k-1 bk −1 + x k y k + Pk −1xk y k T α + x k P k-1 x k α α por [1-19] sabemos que: Pk x k = P k-1 x k α + xTk P k-1 x k [1-46] reemplazando en la anterior 1 1 T θˆk = θˆk-1 − P k x k x k P k-1 bk-1 + x k y k + P k-1 x k y k α α 1 1 = θˆk-1 − P k x k xTk P k-1b k-1 − P k x k xTk P k-1 x k y k + P k-1 x k y k α α 1 = θˆk-1 − P k x k xTk θˆk-1 + P k-1 − P k x k xTk P k-1 x k y k α [1-47] de [1-17] resulta 1 P k-1 - P k x k xTk P k-1 α Pk −1 − Pk xk xTk Pk −1 = α Pk Pk = [1-48] [1-49] quedando T θˆk = θˆk-1 - P k x k x k θˆk-1 - y k [1-50] en resumen el algoritmo está formado por las dos ecuaciones siguientes: 05-Mínimos Cuadrados.doc 7 θˆk = θˆk-1 - P k x k [ yˆ k - y k ] Pk −1 xk xTk Pk−1 1 Pk = α Pk −1 − α + xT P x k k −1 k [1-51] Se puede asemejar esta idea a la introducción de un filtro en el cálculo de la inversa de P según lo muestra la figura siguiente: xk xkT 1 1 − α q −1 Pk−1 Figura 4-1Inclusión del factor de olvido 1.3. Características Estadísticas de la Estimación A continuación se verá qué características estadísticas tiene el modelo obtenido y qué condiciones se deben cumplir para que éste converja al sistema real. Primeramente se observará la forma que tiene el corchete de la ecuación [1-10] que, desplegado resulta: K yk M y T φ k φ k = k-n +1 uk M u k-m y0 M y K y + u k K u k-m k-n 1 K y 1-n k ⋅ M M M M [1-52] K u 0 y K y1-n u 0 K u -m M 0 K u -m Si se supone que, tanto entradas como salidas tienen media nula, cada elemento corresponderá, para un gran número de muestras, a la autocovarianza o covarianza cruzada según sea el término. Tomando el elemento [1,1] como ejemplo se verifica que tiene la siguiente forma: k φ φ k [1,1] = y + L + y = ∑ yi2 = ry ( 0 ) T 2 k 2 0 [1-53] i =0 La matriz total se llama matriz de covarianza del algoritmo y será: 05-Mínimos Cuadrados.doc 8 K r y (o) M M T φk φk = r uy( n - m - 1 ) K M K r uy(n-1) r y(n-1) M M r uy(n-1) M r uy( n - m - 1 ) K M r uy(n-1) r u(0) M ruy( n - m - 1 ) r u(m) r uy(n-1) M K r uy( n - m - 1 ) K r u(m) M K r u(0) [1-54] Veremos ahora qué condiciones se deben cumplir para que exista una convergencia del algoritmo. Para esto calculemos la media de θˆ . -1 T T lim E θˆk = lim E φ k φ k φ k Y k = E θˆk k →∞ k →∞ -1 T T = lim E φ k φ k φ k [φ k θ + e k ] k →∞ [1-55] -1 T T = lim E [θ ] + lim E φ k φ k φ k e k k →∞ k →∞ -1 T T E θˆk = lim E [θ ] + lim E φ k φ k φ k e k k →∞ k →∞ [1-56] Por lo tanto la media de la estimación coincidirá con el valor real -1 T de θ si el error e es incorrelado con φ φ φ . En cualquier otro T caso existirá un sesgo en la estimación. También debemos notar que para que exista solución la matrizφ φ 1debe ser invertible o sea T det φ T φ ≠ 0 [1-57] Observando la ecuación 0 podemos inferir que esto se puede lograr si el sistema está persistentemente excitado. 1.1.3. Correlación de la Estimación: Calculemos la correlación de θ que tiene la siguiente forma: [1-58] T E θˆk - θ θˆk - θ = T -1 -1 T T T T E φ φ φ [φ θ + e] - θ φ φ φ [φ θ + e ] - θ -1 -1 T T T = E φ φ φ e eT φ φ φ -1 T si se cumple que e es incorrelado con φ φ φ 4 se verifica: T 05-Mínimos Cuadrados.doc 9 [1-59] -1 T -1 T T T rθˆ = E φ φ φ e e φ φ φ -1 = E φ T φ E e eT Suponiendo que el ruido es incorrelado consigo mismo llamaremos T 2 [1-60] r e = E e e = σ e I y se cumplirá que E ek eTk+τ = 0 ∀ τ ≠ 0 [1-61] -1 T 2 rθˆ = E φ φ σ e [1-62] por lo tanto la correlación de θ resulta: 1.4. Influencia del Valor Medio Otra consideración a tener en cuenta en una estimación es que las mediciones de u e y no deben tener un valor medio distinto de cero ya que estamos suponiendo que el modelo del sistema es lineal. En caso de que éste exista deberemos eliminarlo. Si las variaciones son muy lentas se puede usar el siguiente filtro de primer orden: x n = α x n-1 + (1- α ) x n [1-63] 1.5. Ejemplo: Sistema de Primer Orden. Para familiarizarnos un poco más con el funcionamiento del estimador veamos un ejemplo sencillo. Sea un sistema de primer orden cuya ecuación en diferencias es: [1-64] y k = a y k-1 + b u k-1 con a = 0,5 y b = 1 En la siguiente tabla se muestran los valores de la respuesta a un escalón. k yk uk 0 0 1 1 b =1 1 2 b (1 + a ) = 1,5 1 05-Mínimos Cuadrados.doc 10 3 b (1 + a + a 2 ) = 1,75 1 4 b (1 + a + a 2 + a 3 ) = 1,875 1 El vector φ será, para tres muestras, 1,75 1 φ = 1,5 1 1 1 [1-65] su transpuesta, 1,75 1,5 1 φT = 1 1 1 [1-66] el vector de medidas de la salida, 1,875 Y k = 1,75 1,5 [1-67] la matriz de covarianza, 6,3125 4,25 T φ φ = 3 4.25 [1-68] la matriz P: -1 3.4286 -4.8571 φ T φ = -4.8571 7.2143 [1-69] y finalmente el vector 7,4063 T φ Y= 5,125 [1-70] Con estos datos ya podemos calcular la estimación de los dos parámetros del sistema resultando obviamente, -1 0,5 θˆ = φ T φ φ T Y = 1 [1-71] 05-Mínimos Cuadrados.doc 11