5. Variables aleatorias

Anuncio

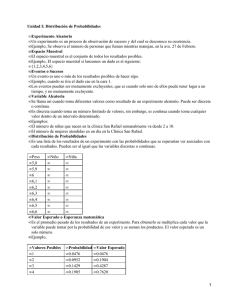

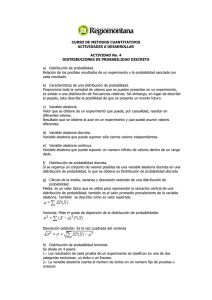

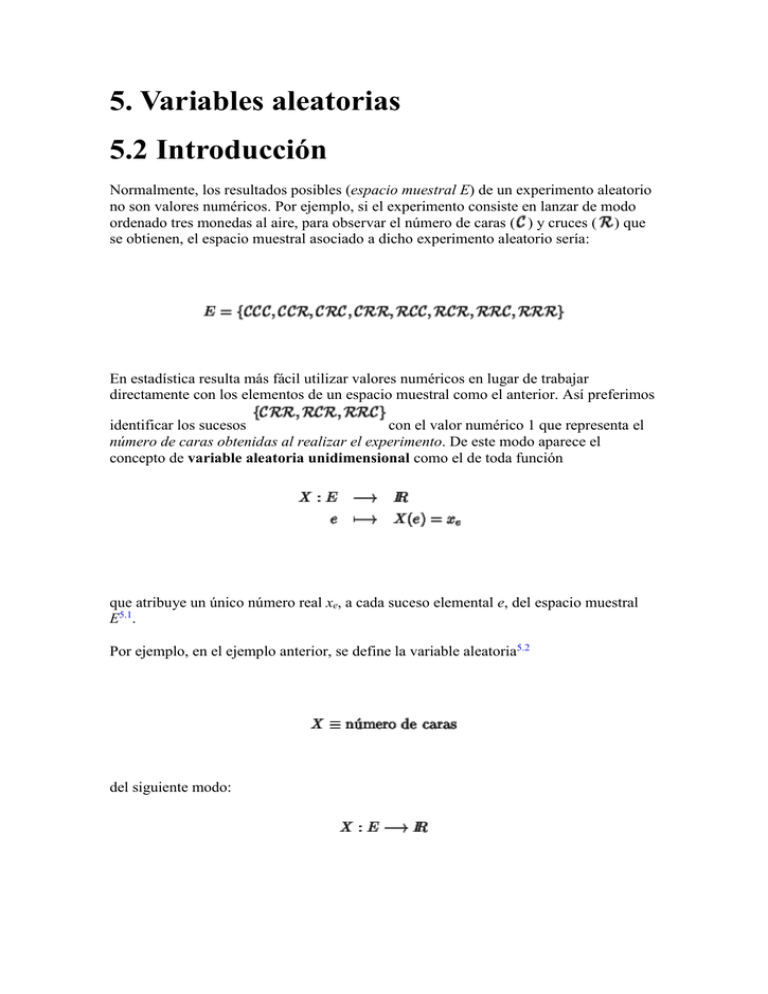

5. Variables aleatorias 5.2 Introducción Normalmente, los resultados posibles (espacio muestral E) de un experimento aleatorio no son valores numéricos. Por ejemplo, si el experimento consiste en lanzar de modo ordenado tres monedas al aire, para observar el número de caras ( ) y cruces ( ) que se obtienen, el espacio muestral asociado a dicho experimento aleatorio sería: En estadística resulta más fácil utilizar valores numéricos en lugar de trabajar directamente con los elementos de un espacio muestral como el anterior. Así preferimos identificar los sucesos con el valor numérico 1 que representa el número de caras obtenidas al realizar el experimento. De este modo aparece el concepto de variable aleatoria unidimensional como el de toda función que atribuye un único número real xe, a cada suceso elemental e, del espacio muestral E5.1. Por ejemplo, en el ejemplo anterior, se define la variable aleatoria5.2 del siguiente modo: 5.2.0.1 Observación La variable X no recibe el calificativo de aleatoria por el hecho de que atribuya de modo imprevisible un valor cualquiera a un elemento ya que este valor está definido de forma precisa (determinística). Lo que es aleatorio en realidad, es que al hacer el experimento, no sabemos qué elemento de E puede ocurrir. =1.00mm La composición de una función real5.3 con una variable es también variable aleatoria, pues está definida sobre Ey a cada elemento suyo le asocia un valor real. En función de los valores que tome la variable, esta puede ser clasificada en discreta o continua del siguiente modo: v.a. discreta es aquella que sólo puede tomar un número finito o infinito numerable de valores. Por ejemplo, v.a. continua es la que puede tomar un número infinito no numerable de valores. 5.2.0.2 Observación Si sobre los elementos de E existe una distribución de probabilidad, esta se transmite a los valores que toma la variable X. Es decir, toda v.a. conserva la estructura probabilística del experimento aleatorio que describe, en el sentido de que si es la función de probabilidad definida sobre el espacio muestral E, ésta induce otra función definida sobre , de forma que conserva los valores de las probabilidades (figura 5.1): Figura: Una v.a. transmite la estructura probabilística del espacio muestral a . De ahora en adelante omitiremos el asterisco y no diferenciaremos entre las probabilidades calculadas sobre el espacio muestral del experimento aleatorio original, E, y las calculadas sobre . Vamos a estudiar los conceptos más importantes relacionados con la distribución de probabilidad de una v.a., diferenciando entre los casos de v.a. discreta y v.a. continua. 5.4 Variables aleatorias discretas Dada una v.a. discreta , su función de probabilidad f, se define de modo que f(xi) es la probabilidad de que X tome ese valor: Si xi no es uno de los valores que puede tomar X, entonces f(xi)=0. La representación gráfica de la función de probabilidad se realiza mediante un diagrama de barras análogo al de distribución de frecuencias relativas para variables discretas (figura 5.3). Por ejemplo, si retomamos el caso del lanzamiento de 3 monedas de forma que cada una de ellas tenga probabilidad 1/2 de dar como resultado cara o cruz, se tiene que (véase la figura 5.2): Figura: Equivalencia entre las probabilidades calculadas directamente sobre el espacio muestral E de resultados del experimento aleatorio, y las calculadas sobre el subconjunto mediante la v.a. X. 5.4.0.1 Observación Obsérvese que X está definido sobre el espacio muestral de sucesos E, mientras que f lo está sobre el espacio de números reales . Las propiedades de la función de probabilidad de v.a. se deducen de forma inmediata de los axiomas de probabilidad: Es evidente que si tenemos tres constantes a<b<c, los sucesos son mutuamente exclusivos, es decir, . Por ello, si se define y , luego , se tiene que Otro concepto importante es el de función de distribución de una variable aleatoria discreta, F, que se define de modo que si X tome un valor inferior o igual a xi: , F(xi) es igual a la probabilidad de que Esta función se representa gráficamente del mismo modo que la distribución de frecuencias relativas acumuladas (figura 5.3). Volviendo al ejemplo de las tres monedas, se tiene que Hay que observar que a valores no admisibles por la variable les pueden corresponder valores de F no nulos. Por ejemplo, Figura: Función de probabilidad a la izquierda, y función de distribución a la derecha de una v.a. discreta Es sencillo comprobar que las siguientes propiedades de la función de distribución son ciertas: 5.4.0.2 Proposición (Distribuciones discretas) La función de distribución F, es una función no decreciente, es decir, Además, es continua a la derecha y 5.6 Variables aleatorias continuas Si una variable discreta toma los valores x1, ..., xk, la proposición de la página afirma que las probabilidad de que al hacer un experimento, X tome uno de esos valores es 1, de modo que cada posible valor xi contribuye con una cantidad f(xi) al total: Aun cuando la variable tomase un número infinito de valores, x1, x2, ..., no hay ningún problema en comprobar que cada xi contribuye con una cantidad f(xi) al total de modo que Cuando la variable es continua, no tiene sentido hacer una suma de las probabilidades de cada uno de los términos en el sentido anterior, ya que el conjunto de valores que puede tomar la variable es no numerable. En este caso, lo que generaliza de modo natural el concepto de suma ( ) es el de integral ( ). Por otro lado, para variables continuas no tiene interés hablar de la probabilidad de que , ya que esta debe de valer siempre 0, para que la suma infinita no numerable de las probabilidades de todos los valores de la variable no sea infinita. De este modo es necesario introducir un nuevo concepto que sustituya en v.a. continuas, al de función de probabilidad de una v.a. discreta. Este concepto es el de función de densidad de una v.a. continua, que se define como una función integrable, que verifica las dos propiedades siguientes: y que además verifica que dado a<b, se tiene que Figura: Función de densidad f. La probabilidad de un intervalo, es el área que existe entre la función y el eje de abscisas. 5.6.0.1 Observación Por ser f una función integrable, la probabilidad de un punto es nula: y por ello al calcular la probabilidad de un intervalo no afectara nada el que este sea abierto o cerrado por cualquiera de sus extremos, pues estos son puntos y por tanto de probabilidad nula: La función de distribución de la v.a. continua, F, se define de modo que dado , F(x) es la probabilidad de que X sea menor o igual que x, es decir Figura: Función de distribución F, calculada a partir de la función de densidad f. 5.6.0.2 Observación Dado un intervalo de la forma (a,b], tenemos que Es decir, la cantidad F(b) - F(a) representa la masa de probabilidad extendida a lo largo de dicho intervalo. Si dividimos esta cantidad por la longitud del intervalo, tenemos la masa media de probabilidad por unidad de longitud en (a,b], es decir, su densidad media de probabilidad. Si hacemos tender a hacia b, , la cantidad es la densidad de probabilidad del punto b (que como hemos mencionado no se ha de confundir con la probabilidad de b). 5.6.0.3 Proposición Distribuciones continuas La función de distribución F, es no decreciente Además, es una función absolutamente continua que verifica: Demostración Los sucesos y son mutuamente exclusivos, siendo su unión el suceso . Por tanto El resto es evidente pues por la relación (5.1) y por otro lado 5.6.2 Cambio de variable Sea X una v.a. cualquiera. Si realizamos el cambio de variable Y=h(X), tenemos una nueva v.a. de modo que las probabilidades sobre la misma se calculan del modo: Si X es una v.a. continua cuya función de densidad es fx, la función de densidad de Y, fy, admite la siguiente expresión: 5.6.2.1 Proposición Si X es una v.a. continua e Y=h(X), donde h es una función derivable e inyectiva, entonces se tiene que para los elementos y de su imagen, donde se tiene que En el caso en que la aplicación no sea inyectiva, podemos tener para un y dado ciertos x1, x2, ..., xn tales que f(xi)=y. En este caso: donde Una aplicación interesante del cambio de v.a. es la siguiente: Sea X una v.a. continua cualquiera con función de distribución derivable, con derivada no nula (en su soporte), Fx. Veamos cual es la distribución de la nueva v.a. Y=Fx-1(X) Como F es creciente, es también inyectiva. Por tanto para , La distribución de Y aparecerá más adelante con el nombre de distribución uniforme en [0,1], y como justificación del método de Montecarlo. Otro cambio de variable importante es Y=X2 ( relación entre los puntos de y anterior se tiene entonces que , h(x)=x2). En este caso la no es inyectiva. Aplicando la proposición Esta última relación será de interés cuando más adelante definamos la distribución . 5.8 Medidas de tendencia central y dispersión de v.a. De forma análoga a lo que se se hizo en el capítulo 2 sobre estadística descriptiva podemos definir para variables aleatorias medidas de centralización, dispersión, simetría y forma. Por su interés nos vamos a centrar en dos medidas sobre v.a. que son la esperanza matemática que desempeña un papel equivalente al de la media y el momento central de segundo orden, también denominado varianza. 5.8.2 Valor esperado o esperanza matemática Sea X una v.a. discreta. Se denomina esperanza matemática de X o valor esperado, y se denota bien o bien , a la cantidad que se expresa como: donde es el conjunto numerable de índices de los valores que puede tomar la variable (por ejemplo para un número finito de valores de la v.a. o bien para una cantidad infinita numerable de los mismos. Si X es una v.a. continua, se define su esperanza a partir de la función de densidad como sigue: 5.8.2.1 Observación Recordamos que si y por tanto tiene sentido calcular su esperanza matemática: Por las analogías existente entre la definición de media aritmética y esperanza matemática, las propiedades de linealidad de la primera se trasladan a la segunda, como es inmediato comprobar: 5.8.4 Varianza La varianza la denotamos mediante o bien : Obsérvese que del mismo modo en que se demuestra la relación 2.11 se comprueba que y que usando la demostración de la proposición de la página se tiene que 5.8.4.1 Ejemplo Consideramos una variable aleatoria discreta con función de probabilidad: Obtener: 1. El valor de la constante c para que sea una función de probabilidad. 2. Los valores de las funciones de probabilidad y distribución para 3. Calcular Solución: 1. y . ya que tenemos la suma de una progresión geométrica de razón menor que la unidad: Luego c=3. Así la función de probabilidad es: 2. Calculemos sucesivos valores de f(x) y F(x): xi f(x) F(x) 2 3/4=0,75 0,75 3 3/16=0,19 0,94 4 3/64=0,047 0,987 5 3/256=0,012 0,999 Se observa que cuando , y 3. ; 5.8.4.2 Ejemplo Consideremos una variable aleatoria continua con función de densidad Se pide: 1. El valor de la constante c para que sea una función de densidad. 2. La función de distribución. 3. La media o valor esperado. 4. Probabilidad de que la variable este comprendida entre 0,2 y 0,7 Solución: 1. Por ser f una densidad se ha de verificar: 2. Luego, la función de distinción es 3. Media : 4. 5.8.4.3 Ejemplo La variable aleatoria continua X tiene como función de densidad: Determinar : 1. Media 2. Varianza 3. Solución: 1. 2. . El momento central de primer orden con respecto al origen ya ha sido calculado antes. El momento central de segundo orden con respecto al origen, es: Luego 3. Hay que calcular la probabilidad del intervalo de la Figura 5.6: Figura: La probabilidad del intervalo 0,2--0,8 es el área de la zona sombreada La esperanza matemática y la varianza pueden ser calculadas a partir de otras medidas, que son los momentos. 5.8.6 Momentos de una v.a. Se denomina momento de orden r ( ), , a: Asimismo se denomina momento central de orden r, mr, a: De este modo, es claro que la esperanza matemática es el momento de primer orden y que la varianza es el momento central de segundo orden 5.8.8 Desigualdad de Tchebycheff y v.a. tipificadas Si X es una variable aleatoria con esperanza , y varianza , se puede demostrar que en general, una gran parte de la masa se encuentra en un intervalo centrado en y que tiene por amplitud varias veces . Más precisamente, la desigualdad de Thebycheff afirma que si consideramos un intervalo de centro y radio k veces , la probabilidad de realizar una observación de la variable y que esta no esté en dicho intervalo es inferior o igual a 1/k2. Matemáticamente esto se formula como: 5.8.8.1 Teorema (Thebycheff) Si X es v.a. con y , entonces Este importante resultado, por si sólo, justifica el que sea una medida de centralización y (o bien ) de dispersión de X y motiva la introducción del concepto de tipificación de variables aleatorias. Dada una v.a. X, definimos su v.a. tipificada, Z, como: que es una v.a. tal que El teorema de Thebycheff afirma sobre U que 5.8.10 Función característica Para una v.a. X se define su función característica como: donde recordamos que . Esta función también es conocida como transformada de Fourier de f. Su denominación proviene del hecho de que una vez conocida la función característica podemos determinar la función de distribución de la v.a. y recíprocamente. 5.8.10.1 Teorema (Fourier) Si X es una v.a. cuya función característica es densidad de probabilidad) es , su función de probabilidad (o Esta propiedad de es fundamental, ya que en una gran cantidad de casos es mucho más fácil trabajar con la función característica que con la propia función de probabilidad (o densidad). La razón de ello estriba en una serie de propiedades de la función característica que la hacen muy manejable desde el punto de vista matemático. Algunas de estas propiedades son enunciadas a continuación. 5.8.10.2 Proposición Para se verifican las relaciones Demostración Vamos a suponer que X es continua, pues la demostración para el caso discreto es totalmente análoga. Gracias a la relación (5.1), se tiene que Por otro lado, es claro que integración es conocido que Por último . De la teoría de la . Por todo ello se tiene que si En lo referente a cambios de origen y escala, el comportamiento de la función característica es el siguiente: 5.8.10.3 Proposición Demostración Una propiedad de que es muy usada es que la suma de v.a. independientes tiene por función característica el producto de las respectivas funciones características. Es decir: 5.8.10.4 Teorema Sean X e Y v.a. independientes. Entonces Este resultado es también cierto para el caso de n v.a. independientes. La última propiedad de que enunciamos es que al igual que la función generatriz de momentos, esta nos permite calcular los momentos de la variable (y por tanto su esperanza y su varianza). 5.8.10.5 Proposición Demostración