Document

Anuncio

Regresión Múltiple

(SW Capítulo 5)

Estimación MCO de la relación entre las notas y el

número de estudiantes por profesor:

! = 698.9 – 2.28¥STR, R2 = .05, SER = 18.6

Notas

(10.4) (0.52)

¿es ésta una estimación creíble del efecto causal de un

cambio en el número de estudiantes por profesor sobre

las notas?

No: existen factores omitidos (como la renta familiar

o si los estudiantes hablan un inglés nativo) que

sesgan el estimador MCO: STR podría “recoger” el

efecto de dichos factores.

5-1

Sesgo de Variables Omitidas

(SW Sección 5.1)

El sesgo en el estimador MCO que ocurre como

consecuencia de un factor omitido se denomina sesgo de

variables omitidas. Para que ocurra el sesgo de variables

omitidas, el factor omitido “Z” debe ser:

1. un determinante de Y; y

2. correlacionado con el regresor X.

Ambas condiciones deben cumplirse para que la

omisión de Z produzca un sesgo de variables omitidas.

5-2

En el ejemplo anterior:

1. La habilidad para hablar en inglés (si el inglés es la

segunda lengua del estudiante) plausiblemente

afectará a las notas: Z es un determinante de Y.

2. Las comunidades de inmigrantes tienden a tener

menores presupuestos escolares – y mayor STR: Z

está correlacionada con X.

• Por tanto, βˆ1 será sesgado

• ¿Cuál es la dirección del sesgo?

• ¿qué sugiere el sentido común?

• Si el sentido común se equivoca, existe una

fórmula...

5-3

Fórmula del sesgo de variables omitidas:

1 n

vi

( X i − X )u i

∑

∑

n i =1

i =1

ˆ

β1 – β1 = n

=

n −1 2

2

(Xi − X )

∑

sX

n

i =1

n

donde vi = (Xi – X )ui ≅ (Xi – µX)ui.

La hipótesis #1 de MCO,

E[(Xi – µX)ui] = cov(Xi,ui) = 0.

Pero ¿qué ocurre si E[(Xi – µX)ui] = cov(Xi,ui) = σXu ≠ 0?

5-4

Entonces

1 n

vi

( X i − X )u i

∑

∑

n i =1

i =1

ˆ

β1 – β1 = n

=

n −1 2

2

(Xi − X )

∑

sX

n

i =1

n

por tanto

n

∑ ( X i − X )u i

σ Xu σ u σ Xu

i =1

ˆ

E( β1 ) – β1 = E n

×

≅ 2 =

σ

σ

σ

σ

( X − X )2

X

X X u

∑

i

i =1

donde ≅ es = cuando n es grande; en concreto,

σu

ˆ

β1 → β1 +

σX

p

ρ Xu , donde ρXu = corr(X,u)

5-5

Fórmula del sesgo de variables omitidas:

σu

ˆ

β1 → β1 +

ρ Xu .

σX

p

Si un factor omitido Z es simultáneamente:

(1) un determinante de Y (contenido en u); y

(2) correlacionado con X,

entonces ρXu ≠ 0 y el estimador MCO βˆ1 será sesgado.

Aquellos distritos con un menor número de estudiantes

de inglés (EL), (1) obtienen mejores notas y (2) tienen

mayor presupuesto escolar; por tanto, ignorar el factor EL

sesga hacia arriba el efecto del STR.

¿Es esto cierto en los datos CA?

5-6

• Distritos con menor EL obtienen mejores notas

• Con menor porcentaje de EL (PctEL), hay menor STR.

• En distritos con PctEL comparable, el efecto de STR es

pequeño

5-7

Tres formas de evitar el sesgo de variables omitidas

1. Llevar a cabo un experimento controlado aleatorio en

el que STR esté asignado aleatoriamente: entonces

PctEL sería todavía un determinante de las notas, pero

estaría incorrelacionada con STR. (Esta situación no

es realista en la práctica.)

2. “Tabulación cruzada”, con mayor graduación de STR

y PctEL ( pronto nos quedaremos sin datos y ¿qué

ocurre con otros determinantes como la renta

familiar y la educación de los padres?)

3. Incluir PctEL como un regresor adicional en una

regresión múltiple.

5-8

El Modelo de Regresión Poblacional Múltiple

(SW Section 5.2)

Considerar la situación con dos regresores:

Yi = β0 + β1X1i + β2X2i + ui, i = 1,…,n

• X1, X2 son las variables independientes (regresores)

• (Yi, X1i, X2i) es la i-ésima observación en Y, X1, y X2.

• β0 = ordenada en el origen

• β1 = efecto en Y de un cambio en X1, manteniendo X2

constante

• β2 = efecto en Y de un cambio en X2, manteniendo X1

constante

• ui = “término de error” (factores omitidos)

5-9

Interpretación de los coeficientes

Yi = β0 + β1X1i + β2X2i + ui, i = 1,…,n

Cambiemos X1 en ∆X1 manteniendo X2 constante:

Recta de regresión poblacional antes del cambio:

Y = β0 + β1X1 + β2X2

Recta de regresión poblacional, después del cambio:

Y + ∆Y = β0 + β1(X1 + ∆X1) + β2X2

5-10

Antes:

Y = β0 + β1X1 + β2X2

Después:

Y + ∆Y = β0 + β1(X1 + ∆X1) + β2X2

Diferencia:

Entonces,

∆Y = β1∆X1

∆Y

β1 =

, manteniendo X2 constante

∆X 1

también,

∆Y

, manteniendo X1 constante

β2 =

∆X 2

y

β0 = predicción de Y cuando X1 = X2 = 0.

5-11

El Estimador MCO en una Regresión Múltiple

(SW Section 5.3)

Con dos regresores, el estimador MCO resuelve:

n

min b0 ,b1 ,b2 ∑ [Yi − (b0 + b1 X 1i + b2 X 2i )]2

i =1

• El estimador MCO minimiza la media de las diferencias

al cuadrado entre los valores de Yi y sus predicciones a

partir de la recta de regresión estimada.

• El problema de minimización se resuelve empleando

cálculo matemático

• El resultado son los estimadores MCO de β0 y β1.

5-12

Ejemplo: Datos de CA

! = 698.9 – 2.28¥STR

Notas

Ahora, incluimos PctEL:

! = 696.0 – 1.10¥STR – 0.65PctEL

Notas

• ¿Qué ocurre con el coeficiente de STR?

• ¿Por qué? (Pista: corr(STR, PctEL) = 0.19)

5-13

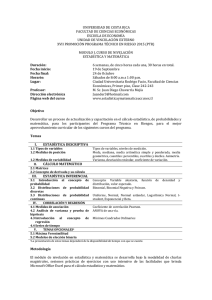

Regresión múltiple en STATA

reg testscr str pctel, robust;

Regression with robust standard errors

Number of obs

F( 2,

417)

Prob > F

R-squared

Root MSE

=

=

=

=

=

420

223.82

0.0000

0.4264

14.464

-----------------------------------------------------------------------------|

Robust

testscr |

Coef.

Std. Err.

t

P>|t|

[95% Conf. Interval]

-------------+---------------------------------------------------------------str | -1.101296

.4328472

-2.54

0.011

-1.95213

-.2504616

pctel | -.6497768

.0310318

-20.94

0.000

-.710775

-.5887786

_cons |

686.0322

8.728224

78.60

0.000

668.8754

703.189

------------------------------------------------------------------------------

! = 696.0 – 1.10¥STR – 0.65PctEL

Notas

¿Cuáles son las distribuciones muestrales de βˆ1 y βˆ2 ?

5-14

Hipótesis del MCO en la Regresión Múltiple

(SW Section 5.4)

Yi = β0 + β1X1i + β2X2i + … + βkXki + ui, i = 1,…,n

1. La distribución condicional de u dadas las X’s posee

media cero, es decir, E(u|X1 = x1,…, Xk = xk) = 0.

2. (X1i,…,Xki,Yi), i =1,…,n, son i.i.d.

3. X1,…, Xk, y u poseen momentos de cuarto orden:

E( X 1i4 ) < ∞,…, E( X ki4 ) < ∞, E( ui4 ) < ∞.

4. No existe multicolinealidad perfecta.

5-15

Hipótesis #1: la media condicional de u dadas la X’s

incluidas es cero.

• Posee la misma interpretación que en la regresión

con un único regresor.

• Si una variable omitida (1) pertenece a la ecuación

(por tanto está en u) y (2) está correlacionada con

una variable incluida X, entonces esta condición no

se cumple

• Incumplimiento de esta condición lleva al sesgo de

variables omitidas

• La solución – si es posible – es incluir la variable

omitida en la regresión.

5-16

Hipótesis #2: (X1i,…,Xki,Yi), i =1,…,n, son i.i.d.

Se cumple automáticamente con el muestreo aleatorio

simple.

Hipótesis #3: momentos de cuarto orden finitos

Esta es una hipótesis técnica que se satisface

automáticamente para variables con un dominio

acotado (notas, PctEL, etc.)

Hipótesis #4: No existe de multicolinealidad perfecta

Multicolinealidad Perfecta se produce cuando uno de

los regresores es una función lineal exacta de otros

regresores.

5-17

Ejemplo: Suponer que accidentalmente se incluye dos

veces STR:

regress testscr str str, robust

Regression with robust standard errors

Number of obs =

420

F( 1,

418) =

19.26

Prob > F

= 0.0000

R-squared

= 0.0512

Root MSE

= 18.581

------------------------------------------------------------------------|

Robust

testscr |

Coef.

Std. Err.

t

P>|t|

[95% Conf. Interval]

--------+---------------------------------------------------------------str | -2.279808

.5194892

-4.39

0.000

-3.300945

-1.258671

str | (dropped)

_cons |

698.933

10.36436

67.44

0.000

678.5602

719.3057

-------------------------------------------------------------------------

β1 es el efecto sobre Notas de un cambio unitario en STR,

manteniendo STR constante (???)

5-18

Segundo ejemplo: Llevar a cabo la regresión de Notas

sobre una constante, D, y B, donde: Di = 1 si STR ≤ 20, =

0 caso contrario; Bi = 1 si STR >20, = 0 caso contrario;

por tanto, Bi = 1 – Di y existe multicolinealidad perfecta

• ¿Existiría multicolinealidad perfecta si la ordenada en

el origen se eliminara de la regresión?

• Multicolinealidad Perfecta generalmente refleja un

error en las definiciones de los regresores, o un

problema en los datos

5-19

La Distribución Muestral del Estimador MCO

(SW Section 5.5)

Considerando las cuatro Hipótesis del MCO,

• βˆ1 posee media β1 y var( βˆ1 ) inversamente

proporcional a n.

• La distribución exacta es muy complicada

p

• βˆ1 es consistente: βˆ1 → β1 (LLN)

βˆ1 − E ( βˆ1 )

•

se distribuye aproximadamente como

var( βˆ )

1

N(0,1) (CLT)

• Igualmente para βˆ2 ,…, βˆk

5-20

Contrastes de Hipótesis e Intervalos de Confianza

para un Coeficiente de la Regresión Múltiple

(SW Section 5.6)

βˆ1 − E ( βˆ1 )

•

se distribuye aproximadamente N(0,1)

var( βˆ )

1

• Por tanto, es posible contrastar hipótesis sobre β1

mediante el estadístico habitual t, y los intervalos de

confianza mediante { βˆ1 ± 1.96×SE( βˆ1 )}.

• Igual para β2,…, βk.

• βˆ1 y βˆ2 , en general, no se distribuyen

independientemente– tampoco lo están sus

estadísticos t.

5-21

Ejemplo: Datos de CA

(1)

! = 698.9 – 2.28¥STR

Notas

(10.4) (0.52)

(2)

! = 696.0 – 1.10¥STR – 0.650PctEL

Notas

(8.7) (0.43)

(0.031)

• El coeficiente de STR en (2) representa el efecto sobre

Notas de un cambio unitario en STR, manteniendo

constante PctEL.

• El coeficiente de STR disminuye a la mitad

• 95% intervalo de confianza para el coeficiente de STR

en (2) es {–1.10 ± 1.96×0.43} = (–1.95, –0.26)

5-22

Contrastes de Hipótesis Conjuntas

(SW Section 5.7)

Expn = gastos por estudiante.

Considerar el modelo de regresión poblacional:

Notasi = β0 + β1STRi + β2Expni + β3PctELi + ui

Hipótesis nula: “los recursos escolares no importan,”

H0: β1 = 0 y β2 = 0

vs. H1: bien β1 ≠ 0 ó β2 ≠ 0 ó ambas

5-23

Notasi = β0 + β1STRi + β2Expni + β3PctELi + ui

H0: β1 = 0 y β2 = 0

vs. H1: bien β1 ≠ 0 ó β2 ≠ 0 ó ambas

Una hipótesis conjunta especifica un valor para dos o

más coeficientes; es decir, impone una restricción en dos

o más coeficientes.

• Un contraste de “sentido común” consistiría en

rechazar cuando cualesquiera de los estadísticos

individuales t excediera de 1.96 en valor absoluto.

• ¡Pero el “sentido común” no funciona! El contraste

resultante no posee el nivel de significación adecuado!

5-24

Explicación: Cálculo de la probabilidad de rechazar

incorrectamente la hipótesis nula empleando el

contraste de “sentido común” a partir de dos

estadísticos t individuales. Para simplificar los cálculos,

suponer que βˆ1 y βˆ2 están independientemente

distribuidos. Sean t1 y t2 los estadísticos t:

βˆ1 − 0

βˆ2 − 0

y t2 =

t1 =

ˆ

SE ( β1 )

SE ( βˆ2 )

El contraste de “sentido común” es:

rechazar H0: β1 = β2 = 0 si |t1| > 1.96 y/o |t2| > 1.96

¿Cuál es la probabilidad de que este contraste de “sentido

común” rechace H0, cuando H0 es en realidad verdadera?

(Debería ser 5%.)

5-25

Probabilidad de rechazar incorrectamente la nula

= PrH [|t1| > 1.96 y/o |t2| > 1.96]

0

= PrH [|t1| > 1.96, |t2| > 1.96]

0

+ PrH [|t1| > 1.96, |t2| ≤ 1.96]

0

+ PrH [|t1| ≤ 1.96, |t2| > 1.96]

0

(eventos disjuntos)

= PrH [|t1| > 1.96] × PrH [|t2| > 1.96]

0

0

+ PrH [|t1| > 1.96] × PrH [|t2| ≤ 1.96]

0

0

+ PrH [|t1| ≤ 1.96] × PrH [|t2| > 1.96]

0

0

(t1, t2 son independientes por hipótesis)

= .05×.05 + .05×.95 + .95×.05

= .0975 = 9.75% – que no es el deseado 5%!!

5-26

El tamaño de un contraste es la tasa de rechazo bajo la

hipótesis nula.

• ¡El tamaño del contraste de “sentido común” no es

5%!

• Su tamaño en realidad depende de la correlación entre

t1 y t2 (y por tanto, de la correlación entre βˆ1 y βˆ2 ).

Dos Soluciones:

• Emplear un valor crítico diferente en este

procedimiento, – no 1.96 (este es el método de

“Bonferroni” – ver App. 5.3)

• Emplear un contraste estadístico diferente, que

contraste ambos β1 y β2 a la vez: el estadístico F.

5-27

El estadístico F

El estadístico F contrasta todos los elementos de una

hipótesis conjunta a la vez.

Fórmula para el caso especial de la hipótesis conjunta β1

= β1,0 y β2 = β2,0 en una regresión con dos regresores:

2

2

1 t1 + t2 − 2 ρˆ t1 ,t2 t1t2

F=

2

2

1 − ρˆ t1 ,t2

donde ρˆ t ,t estima la correlación entre t1 y t2.

1 2

Rechazar cuando F es “grande”

5-28

El estadístico F,

2

2

+

t

t

1 1 2 − 2 ρˆ t1 ,t2 t1t2

F=

2

2

1 − ρˆ t1 ,t2

• El estadístico F es grande cuando t1 y/o t2 es grande

• El estadístico F corrige (de forma adecuada) la

correlación entre t1 y t2.

• La formula para más de dos β’s es complicada a

menos que se emplee álgebra matricial.

• Proporciona al estadístico F una distribución

aproximada en muestras-grandes, que es…

5-29

Distribución de muestras grandes del estadístico F

Considerar el caso especial en el que t1 y t2 son

p

independientes, por tanto ρˆ t ,t → 0; en muestras grandes

1 2

la fórmula se convierte en

2

2

+

t

t

1 2 2

1 1 2 − 2 ρˆ t1 ,t2 t1t2

≅ (t1 + t2 )

F=

2

2

2

1 − ρˆ t1 ,t2

• Bajo la hipótesis nula, t1 y t2 poseen distribuciones

normales estándar; en este caso especial, serían

independientes

• La distribución de muestras grandes del estadístico F

es la distribución de la media de dos variables

aleatorias normales independientes al cuadrado.

5-30

La distribución chi-cuadrado con q grados de libertad

( χ q2 ) se define como la distribución de la suma de q

variables aleatorias independientes normales al cuadrado.

En grandes muestras, F se distribuye como χ q2 /q.

Selección de valores críticos de χ q2 /q

q

1

2

3

4

5

5% valor crítico

3.84

(¿por qué?)

3.00

(el caso q=2 anterior)

2.60

2.37

2.21

5-31

p-valor empleando el estadístico F:

p-valor = probabilidad de la cola derecha de χ q2 /q a

partir del valor calculado del estadístico F.

Implementación en STATA

Emplear el comando “test” después de la regresión

Ejemplo: Contrastar la hipótesis conjunta de que los

coeficientes poblacionales de STR y gastos por estudiante

(expn_stu) son ambos cero contra la alternativa de que al

menos uno de ellos es distinto de cero.

5-32

Ejemplo de Contraste F, Datos de CA:

reg testscr str expn_stu pctel, r;

Regression with robust standard errors

Number of obs

F( 3,

416)

Prob > F

R-squared

Root MSE

=

=

=

=

=

420

147.20

0.0000

0.4366

14.353

-----------------------------------------------------------------------------|

Robust

testscr |

Coef.

Std. Err.

t

P>|t|

[95% Conf. Interval]

-------------+---------------------------------------------------------------str | -.2863992

.4820728

-0.59

0.553

-1.234001

.661203

expn_stu |

.0038679

.0015807

2.45

0.015

.0007607

.0069751

pctel | -.6560227

.0317844

-20.64

0.000

-.7185008

-.5935446

_cons |

649.5779

15.45834

42.02

0.000

619.1917

679.9641

-----------------------------------------------------------------------------NOTE

test str expn_stu;

( 1)

( 2)

The test command follows the regression

str = 0.0

expn_stu = 0.0

F(

2,

416) =

Prob > F =

There are q=2 restrictions being tested

5.43

0.0047

The 5% critical value for q=2 is 3.00

Stata computes the p-value for you

5-33

Dos cuestiones (relacionadas) no consideradas:

1. Sólo versiones homoscedásticas del estadístico F

2. La distribución “F”

F con homoscedasticidad (“regla rápida”)

Para calcular el estadístico F con homoscedasticidad:

• Emplear la formulas anteriores, pero empleando

únicamente errores estándar homoscedásticos; o

• Realizar dos regresiones, una bajo la hipótesis nula

(regresión “restringida”) y otra bajo la hipótesis

alternativa (regresión “sin restringir”).

• El segundo método posee una fórmula sencilla

5-34

Regresiones “restringidas” y “sin restringir”

Ejemplo: ¿son los coeficientes de STR y Expn cero?

Regresión poblacional restringida (es decir, bajo H0):

Notasi = β0 + β3PctELi + ui (¿por qué?)

Regresión poblacional sin restringir (bajo H1):

Notasi = β0 + β1STRi + β2Expni + β3PctELi + ui

• El número de restricciones bajo H0 = q = 2.

• El ajuste será mayor (R2 mayor) en la regresión sin

restricciones (¿ por qué?)

5-35

¿Cuánto deberá incrementar el R2 para que los

coeficientes en Expn y PctEL se consideren

estadísticamente significativos?

Fórmula sencilla para el estadístico F con

homoscedasticidad:

F=

2

( Rno2 restringido − Rrestringido

)/q

(1 − Rno2 restringido ) /( n − kno restringido − 1)

donde:

2

Rrestringido

= R2 en la regresión restringida

Rno2 restringido = R2 en la regresión sin restringir

q = número de restricciones bajo la hipótesis nula

kno restringido = número de regresores en la regresión

sin restringir.

5-36

Ejemplo:

Regresión restringida:

! = 644.7 –0.671PctEL, R 2

Notas

restringido = 0.4149

(1.0) (0.032)

Regresión sin restringir:

! = 649.6 – 0.29STR + 3.87Expn – 0.656PctEL

Notas

(15.5) (0.48)

(1.59) (0.032)

Rno2 restringido = 0.4366, kno restringido = 3, q = 2

por tanto:

F=

2

( Rno2 restringido − Rrestringido

)/q

(1 − Rno2 restringido ) /( n − kno restringido − 1)

(.4366 − .4149) / 2

= 8.01

=

(1 − .4366) /(420 − 3 − 1)

5-37

El estadístico F con homoscedasticidad

F=

2

( Rno2 restringido − Rrestringido

)/q

(1 − Rno2 restringido ) /( n − kno restringido − 1)

• Rechaza cuando al añadir las dos variables se

incrementa el R2 lo “suficiente” – es decir, cuando al

añadir las dos variables se incrementa el ajuste de la

regresión “suficientemente”

• Si los errores son homoscedásticos, entonces el

estadístico F con homoscedasticidad posee una

distribución χ q2 /q en grandes muestras.

• Si los errores son heteroscedásticos, la distribución en

grandes muestras es complicada y no una χ q2 /q

5-38

La distribución F

Si:

1. u1,…,un se distribuyen Normal; y

2. Xi se distribuye independientemente de ui (en

particular ui es homoscedástico)

entonces el estadístico F con homoscedasticidad posee

una distribución “Fq,n-k–1”, donde q = número de

restricciones y k = número de regresores bajo la

alternativa (modelo sin restringir).

5-39

La distribución Fq,n–k–1:

• La distribución F está tabulada

• Cuando n se hace grande, la distribución Fq,n-k–1 tiende

asintóticamente a la distribución χ q2 /q:

Fq,∞ es otro nombre para χ q2 /q

• Para q no muy elevado y n≥100, la distribución

Fq,n–k–1

y la distribución χ q2 /q son prácticamente idénticas.

• Muchos programas de regresión calculan los p-valores del

estadístico F empleando la distribución F (lo cual es

correcto si el tamaño muestral es ≥100)

• Encontraremos la distribución “F” en los trabajos

empíricos publicados.

5-40

Digresión: Un poco de historia en estadística…

• La teoría del estadístico F con homoscedasticidad y

las distribuciones de Fq,n–k–1 descansa en hipótesis

muy fuertes no verosímiles (¿están los ingresos

normalmente distribuidos?)

• Estos estadísticos datan de principios del Siglo XX,

cuando “calcular” era un trabajo descriptivo y el

número de observaciones escasas.

• El estadístico F y la distribución Fq,n–k–1 constituyeron

dos avances significativos: una fórmula sencilla de

calcular; un conjunto sencillo de tablas que se podían

publicar de una vez, aplicarlas en múltiples ocasiones;

y una justificación matemática precisa y elegante.

5-41

Un poco de historia de estadística, continuación…

• Las hipótesis tan fuertes parecían un precio menor

comparado con la gran aportación.

• Pero con los ordenadores actuales y muestras grandes

podemos emplear estadísticos F robustos a la

heteroscedasticidad y la distribución Fq,∞, que sólo

requiere las cuatro hipótesis de MCO.

• Este legado histórico persiste en los programas de

ordenador, en los que los errores estándar con

homoscedasticidad (y estadísticos F) constituyen la

opción por defecto, y en los que los p-valores se

calculan empleando la distribución Fq,n–k–1.

5-42

Resumen: Distribución de F con homoscedasticidad

• Se justifican únicamente en situaciones muy estrictas

– más estrictas que realistas en la práctica habitual.

• Con todo, son ampliamente empleadas.

• Debería emplearse el F robusto, con valores críticos

χ q2 /q (es decir, Fq,∞).

• Para n ≥ 100, la distribución F es esencialmente la

distribución χ q2 /q.

• Para pequeños n, la distribución F no tiene por qué ser

una aproximación “mejor” a la distribución muestral

del estadístico F – sólo si la condiciones fuertes son

ciertas.

5-43

Resumen: contrastando hipótesis conjuntas

• La aproximación de “sentido común” de rechazar si el

estadístico t excede 1.96 rechaza más del 5% de las

veces bajo la hipótesis nula (el tamaño excede el nivel

de significación deseado)

• El estadístico robusto F se encuentra construido en

STATA (comando“test”); contrasta todas las

restricciones a la vez.

• Para n grande, F se distribuye como χ q2 /q (= Fq,∞)

• El estadístico homoscedástico F es importante

históricamente y es intuitivamente llamativo, pero

inválido cuando existe heteroscedasticidad

5-44

Contraste de Restricciones Simples en los Coeficientes

(SW Section 5.8)

Yi = β0 + β1X1i + β2X2i + ui, i = 1,…,n

Considerar las hipótesis nula y alternativa,

H0: β1 = β2

vs. H1: β1 ≠ β2

Esta nula impone una restricción simple (q = 1) sobre

múltiples coeficientes – no es una hipótesis conjunta con

múltiples restricciones (comparar con β1 = 0 y β2 = 0).

5-45

Dos métodos para contrastar restricciones simples con

múltiples coeficientes:

1. transformar la regresión

Reagrupar los regresores de forma que la

restricción se convierta en una restricción sobre

un coeficiente individual en una regresión

equivalente

2.

Realizar el contraste directamente

Algunos programas (software), incluyendo

STATA, permiten contrastar restricciones

empleando múltiples coeficientes directamente

5-46

Metodo 1: Transformar la regresión

Yi = β0 + β1X1i + β2X2i + ui

H0: β1 = β2

vs. H1: β1 ≠ β2

Sumar y restar β2X1i:

Yi = β0 + (β1 – β2) X1i + β2(X1i + X2i) + ui

ó

Yi = β0 + γ1 X1i + β2Wi + ui

donde

γ1 = β1 – β2

Wi = X1i + X2i

5-47

(a) Sistema original:

Yi = β0 + β1X1i + β2X2i + ui

H0: β1 = β2 vs. H1: β1 ≠ β2

(b) Sistema transformado:

Yi = β0 + γ1 X1i + β2Wi + ui

donde γ1 = β1 – β2 y Wi = X1i + X2i

por tanto

H0: γ1 = 0 vs. H1: γ1 ≠ 0

El problema de contrastar es ahora una cuestión simple:

Contrastar si γ1 = 0 en la especificación (b).

5-48

Método 2: Realizar el contraste directamente

Yi = β0 + β1X1i + β2X2i + ui

H0: β1 = β2

vs. H1: β1 ≠ β2

Ejemplo:

Notasi = β0 + β1STRi + β2Expni + β3PctELi + ui

Para contrastar con STATA si β1 = β2:

regress testscore str expn pctel, r

test str=expn

5-49

Regiones de Confianza con Múltiples Coeficientes

(SW Section 5.9)

Yi = β0 + β1X1i + β2X2i + … + βkXki + ui, i = 1,…,n

¿Cómo es una región de confianza conjunta de β1 y β2?

Una región de confianza del 95% es:

• Una función conjunto de los datos que contiene el

verdadero parámetro(s) en el 95% de hipotéticas

muestras repetidas.

• El conjunto de valores de los parámetros que no pueden

rechazarse para un nivel de significación del 5% cuando

se consideran como la hipótesis nula.

5-50

La tasa de cobertura de una región de confianza es la

probabilidad de que la región de confianza contenga los

verdaderos valores de los parámetros

Una región de confianza de “sentido común” es la unión

de los intervalos de confianza del 95% de β1 y β2, es

decir, el rectángulo:

{ βˆ1 ± 1.96×SE( βˆ1 ), βˆ2 ± 1.96 ×SE( βˆ2 )}

• ¿Cuál es la tasa de cobertura de esta región de

confianza?

• ¿Es la tasa de cobertura igual al nivel de confianza

deseado del 95%?

5-51

Tasa de Cobertura de “sentido común”:

Pr[(β1, β2) ∈ { βˆ1 ± 1.96×SE( βˆ1 ), βˆ2 1.96 ± ×SE( βˆ2 )}]

= Pr[ βˆ1 – 1.96SE( βˆ1 ) ≤ β1 ≤ βˆ1 + 1.96SE( βˆ1 ),

βˆ2 – 1.96SE( βˆ2 ) ≤ β2 ≤ βˆ2 + 1.96SE( βˆ2 )]

βˆ1 − β1

βˆ2 − β 2

= Pr[–1.96≤

≤1.96, –1.96≤

≤1.96]

SE ( βˆ1 )

SE ( βˆ2 )

= Pr[|t1| ≤ 1.96 y |t2| ≤ 1.96]

= 1 – Pr[|t1| > 1.96 y/o |t2| > 1.96] ≠ 95% !

¿Por qué?

¡El tamaño no iguala el nivel de significación!

5-52

La probabilidad de rechazar incorrectamente la nula

= PrH [|t1| > 1.96 y/o |t2| > 1.96]

0

= PrH [|t1| > 1.96, |t2| > 1.96]

0

+ PrH [|t1| > 1.96, |t2| ≤ 1.96]

0

+ PrH [|t1| ≤ 1.96, |t2| > 1.96]

0

(eventos disjuntos)

= PrH [|t1| > 1.96] × PrH [|t2| > 1.96]

0

0

+ PrH [|t1| > 1.96] × PrH [|t2| ≤ 1.96]

0

0

+ PrH [|t1| ≤ 1.96] × PrH [|t2| > 1.96]

0

0

(si t1, t2 son independientes)

= .05×.05 + .05×.95 + .95×.05

= .0975 = 9.75% – no es el deseado 5%!!

5-53

Por el contrario, use un contraste cuyo tamaño sea igual

al nivel de significación:

Sea F(β1,0,β2,0) el estadístico robusto F para contrastar la

hipótesis de que β1 = β1,0 y β2 = β2,0:

95% región de confianza = {β1,0, β2,0: F(β1,0, β2,0) < 3.00}

• 3.00 es el valor crítico al 5% de la distribución F2,∞

• Esta región posee una tasa de cobertura del 95%

porque el contaste sobre el que se realiza posee

tamaño 5%.

5-54

La región de confianza del estadístico F es una elipse

2

2

1 t1 + t2 − 2 ρˆ t1 ,t2 t1t2

≤ 3.00}

{β1, β2: F =

2

2

1 − ρˆ t1 ,t2

Por tanto,

1

2

2

ˆ

t

t

×

+

F=

1

2 − 2 ρ t1 ,t2 t1t2

2

2(1 − ρˆ t1 ,t2 )

=

1

×

2

2(1 − ρˆ t1 ,t2 )

βˆ − β 2 βˆ − β 2

ˆ − β βˆ − β

β

2,0

1

1,0

1

1,0

2

2,0

2

ˆ

2

ρ

+

+

t1 ,t2

SE ( βˆ ) SE ( βˆ )

SE ( βˆ2 ) SE ( βˆ1 )

1

2

Esta es una forma cuadrática en β1,0 y β2,0 – la frontera

del conjunto F = 3.00 es una elipse.

5-55

Región de confianza basado en F

5-56

El R2, SER, y R 2 en la Regresión Múltiple

(SW Section 5.10)

Real = predicción + residuo: Yi = Yˆi + uˆi

Al igual que en la regresión con un único regresor, el

SER (y el RMSE) es una medida de la dispersión de las

Y’s alrededor de la recta de regresión:

SER =

n

1

2

ˆ

u

∑

i

n − k − 1 i =1

5-57

El R2 es la fracción de la varianza explicada:

SSR

ESS

R =

= 1−

,

TSS

TSS

2

donde ESS =

n

2

ˆ

ˆ

−

Y

Y

, SSR =

(

)

∑ i

i =1

n

2

ˆ

u

∑ i , y TSS =

i =1

n

2

−

(

Y

Y

)

– en una regresión con un regresor.

∑ i

i =1

• El R2 aumenta cuando se añade otro regresor

• El R 2 corrige este problema “penalizando” la

inclusión de otro regresor:

n − 1 SSR

2

2

R = 1−

R

so

<

R

−

−

n

k

1

TSS

2

5-58

¿Cómo interpretar el R2 y R 2 ?

• Un elevado R2 (o R 2 ) significa que los regresores

explican la variación en Y.

• Un elevado R2 (o R 2 ) no significa que se haya

eliminado el sesgo de variables omitidas.

• Un elevado R2 (o R 2 ) no significa que tengamos un

estimador insesgado del efecto causal (β1).

• Un elevado R2 (o R 2 ) no significa que las variable

incluidas sean estadísticamente significativas – esto

debe determinarse empleando contrastes de hipótesis.

5-59

Ejemplo: Estudio más detallado de los datos de CA

(SW Section 5.11, 5.12)

Un enfoque general para seleccionar variables y

especificación de modelos:

• Especificar un modelo de “base”

• Especificar un rango plausible de modelos

alternativos, que incluyan variables alternativas

candidatas.

• ¿Cambian estas variables el β1 de interés?

• ¿Es la candidata estadísticamente significativa?

• Emplear juicio razonado, no una “receta” mecánica …

5-60

Variables que nos gustaría ver en los datos de CA:

Características escolares:

• Cociente estudiantes-profesor

• Calidad del profesorado

• ordenadores por estudiante

• diseño curricular…

Características de los Estudiantes:

• Nivel de inglés

• Disponibilidad de actividades extracurriculares

• Ambiente de aprendizaje en casa

• nivel de educación de los padres …

5-61

Variables encontradas en los datos de CA:

• cociente estudiantes-profesor (STR)

• porcentaje de estudiantes que tienen el inglés como

segunda lengua (PctEL)

• porcentaje de personas elegibles para el subsidio de

comida

• porcentaje de ayudas públicas de renta

• renta promedio del distrito

5-62

5-63

Digresión: presentación de los resultados en una tabla

• Hacer un listado de todas las ecuaciones de regresión

puede resultar confuso cuando hay muchos regresores y

muchas ecuaciones.

• Tablas con los resultados de forma compacta.

• Información a incluir:

! Variables (dependiente e independientes)

! coeficientes estimados

! errores estándar

! resultados de los contrastes F pertinentes

! alguna medida de ajuste

! número de observaciones

5-64

5-65

Resumen: Regresión Múltiple

• La regresión múltiple nos permite estimar el efecto en

Y de un cambio en X1, manteniendo X2 constante.

• Si una variable es observable, evitaremos el sesgo de

variables omitidas incluyéndola en la regresión.

• No hay una receta sencilla para decidir qué variables

incluir en una regresión – emplear sentido común.

• Una aproximación consiste en especificar un modelo

de base – fundado en razonamientos a-priori –

posteriormente explorar la sensibilidad de las

estimaciones con especificaciones alternativas.

5-66