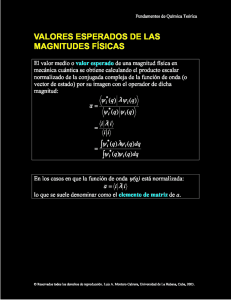

Mecánica_Cuántica: Una_revolución_en_el_pensamiento científico

Anuncio