Capítulo 3 Variables aleatorias

Anuncio

Capítulo 3

Variables aleatorias

3.1

Definición, tipos

En ocasiones de un experimento aleatorio sólo nos interesará medir ciertas características del mismo.

En estos casos nos bastará con conocer la distribución o modelo de probabilidad de cada característica.

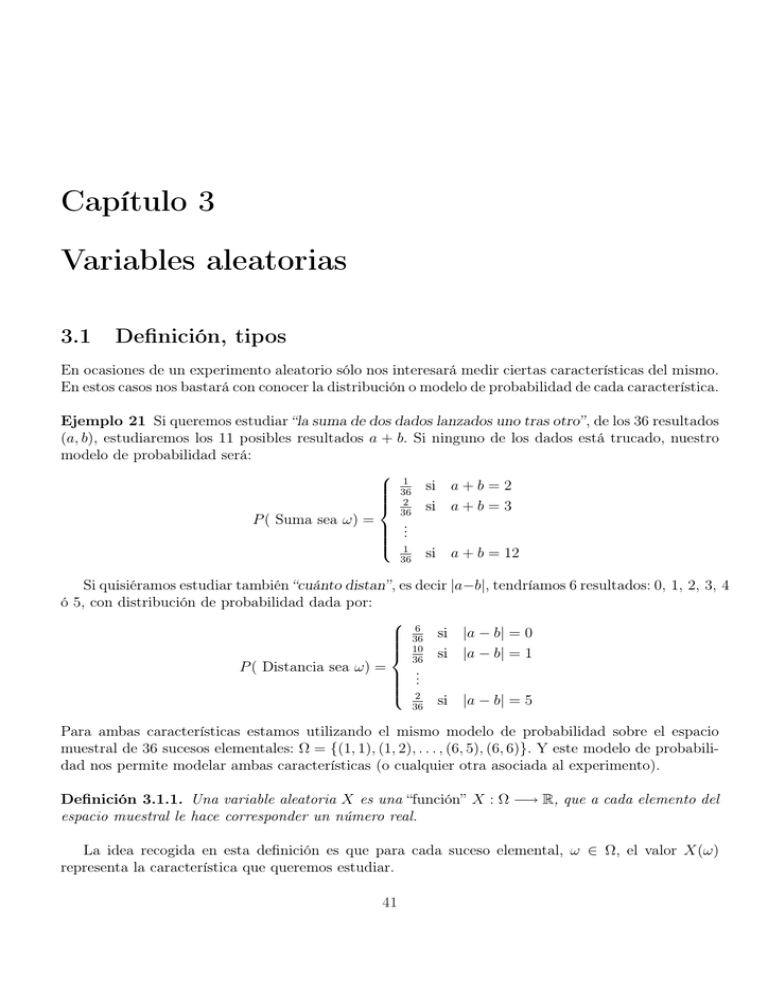

Ejemplo 21 Si queremos estudiar “la suma de dos dados lanzados uno tras otro”, de los 36 resultados

(a, b), estudiaremos los 11 posibles resultados a + b. Si ninguno de los dados está trucado, nuestro

modelo de probabilidad será:

1

si a + b = 2

36

2 si a + b = 3

36

P ( Suma sea ω) =

..

.

1

si a + b = 12

36

Si quisiéramos estudiar también “cuánto distan”, es decir |a−b|, tendríamos 6 resultados: 0, 1, 2, 3, 4

ó 5, con distribución de probabilidad dada por:

6

si |a − b| = 0

36

10 si |a − b| = 1

36

P ( Distancia sea ω) =

..

.

2

si |a − b| = 5

36

Para ambas características estamos utilizando el mismo modelo de probabilidad sobre el espacio

muestral de 36 sucesos elementales: Ω = {(1, 1), (1, 2), . . . , (6, 5), (6, 6)}. Y este modelo de probabilidad nos permite modelar ambas características (o cualquier otra asociada al experimento).

Definición 3.1.1. Una variable aleatoria X es una “función” X : Ω −→ R, que a cada elemento del

espacio muestral le hace corresponder un número real.

La idea recogida en esta definición es que para cada suceso elemental, ω ∈ Ω, el valor X(ω)

representa la característica que queremos estudiar.

41

Densidad y distribución

Ejemplo 22 En el experimento del lanzamiento sucesivo de dos dados, estamos considerando las

siguientes variables aleatorias:

X =

Y =

suma de los dados ;

diferencia (en valor absoluto) de ambos dados .

A partir de ellas podemos definir distintos sucesos aleatorios. Por ejemplo:

A1 = {ω ∈ Ω : X(ω) = 5} ;

A3 = {ω ∈ Ω : Y (ω) ≤ 4} ;

A2 = {ω ∈ Ω : X(ω) > 7} ;

A4 = {ω ∈ Ω : (X − Y )(ω) = 6} .

Y nos interesará conocer la probabilidad de los diferentes sucesos correspondientes a una variable

aleatoria, es decir, su modelo o función de probabilidad.

Definición 3.1.2. Sea X : Ω −→ R una variable aleatoria. Si A es un subconjunto de R, definimos:

P (A) = P (X ∈ A) := P ({ω ∈ Ω : X(ω) ∈ A}) .

Ejemplo 23 De los tres primeros sucesos del ejemplo anterior, considerando que los dados no están

trucados, tenemos que:

1

5+4+3+2+1

15

5

2

17

7

4

= ; P (A2 ) =

=

=

; P (A3 ) = 1 −

=

; P (A4 ) =

36

9

36

36

12

36

18

36

que hemos calculado con las siguientes evidentes igualdades:

¢

P (A2 ) = P (X > 7)) = P (X = 8) + P (X = 9) + P (X = 10) + P (X = 11) + P (X = 12)

P (A1 ) =

P (A3 ) = P ((Y ≤ 4)) = 1 − P ((Y = 5)) .

Obsérvese el abuso de notación, P (X > x) en lugar de P (X(ω) > x) por ejemplo, que utilizaremos,

para simplificar, siempre que esté claro lo que queremos decir. Por último, los casos ω = (a, b) en que

se verifica (X − Y )(ω) = 6 son siete: (3, 3), (3, 4), (4, 3), (3, 5), (5, 3), (3, 6) y (6, 3).

3.2

Función de masa o de densidad, función de distribución

Definición 3.2.1. La función de distribución de una variable aleatoria se define como:

F (x) = P ((−∞, x]) = P ({ω ∈ Ω : X(ω) ≤ x})

Propiedades de las funciones de distribución

1. lı́m F (x) = 0;

x→−∞

2. lı́m F (x) = 1;

x→∞

3. si x1 < x2 , entonces F (x1 ) ≤ F (x2 );

4. F es continua por la derecha, es decir:

lı́m F (x + h) = F (x) .

h→0+

42

para todo x ∈ R .

Variables aleatorias

Es fácil, dada una función de distribución, calcular la probabilidad de diferentes tipos de intervalos de la recta real. Basta tomar la definición, P ((−∞, x]) = F (x) y las propiedades generales de

cualquier función de distribución. Denotaremos por

F (x− ) = lı́m+ P ((−∞, x − h]) = P ((−∞, x)) .

h→0

Se tienen así las siguientes identidades:

P ((a, b])

P ((a, b))

P ([a, b])

P ({b})

=

=

=

=

P ((−∞, b]) − P ((−∞, a]) = F (b) − F (a)

P ((−∞, b)) − P ((−∞, a]) = F (b− ) − F (a)

P ((−∞, b]) − P ((−∞, a)) = F (b) − F (a− )

((−∞, b]) − P ((−∞, b)) = F (b) − F (b− ) = “salto” de F en el punto b .

La última de ellas nos dice que si la función de distribución, F , tiene un salto en un punto, la

probabilidad de ese punto es positiva.

Ya hemos dicho que al estudiar una variable aleatoria nos interesará conocer su función de probabilidad. La función de distribución caracteriza completamente la de probabilidad. Ahora bien, para

los casos más interesantes de variables aleatorias que trataremos, hay herramientas más sencillas que

la función de distribución para conocer el reparto de probabilidad. Éstas son: la función de masa,

para una variable aleatoria discreta; la función de densidad, si la variable aleatoria es continua.

3.2.1

Variables aleatorias discretas

Definición 3.2.2. Una variable aleatoria, X, se dice discreta cuando sólo puede tomar un número

finito o numerable de valores x1 , . . . , xn , . . . .

La función de probabilidad de una variable aleatoria discreta X queda totalmente caracterizada

por su función de masa, que nos da la probabilidad de cada uno de esos posibles valores:

P (X = xi ) = P ({xi }) = P (xi ) = P ({ω ∈ Ω : X(ω) = xi }) i = 1, 2, 3, . . . , n, . . . .

Se sigue de la definición que

discreta tiene forma de escalera:

P

P (xi ) = 1. La función de distribución de una variable aleatoria

i

F (x)

•

•

•

x1

x2

x3

x

Obsérvese que la función de distribución, F (x), es no decreciente (¿por qué?).

43

Densidad y distribución

Ejemplo 24 Calcular la función de masa y la función de distribución de la variable aleatoria

X =“suma de los dados”, en el experimento de tirar sucesivamente dos dados no trucados.

Solución: El espacio muestral tiene 36 elementos:

Ω = {(1, 1), (1, 2), . . . , (6, 5), (6, 6)} .

La variable aleatoria X, es una función del espacio muestral Ω en R que sólo toma los 11 valores enteros: 2, 3, . . . , 12. Puesto que los dados no están trucados, los sucesos elementales son equiprobables,

y así:

1

, para cualquier (a, b) ∈ Ω .

P ({(a, b)}) =

36

Puesto que podemos contar cuántos elementos de Ω hay en cada uno de los sucesos X = 2, X = 3,

. . . , X = 12, conocemos la función de masa de la variable X. La siguiente tabla de valores, determina

completamente la función de masa de X:

xi

2

3

4

5

6

7

8

9

10

11

12

P (X = xi )

1

36

2

36

3

36

4

36

5

36

6

36

5

36

4

36

3

36

2

36

1

36

Obsévese que

1+2+3+4+5+6+5+4+3+2+1

= 1.

36

Por su parte la función de distribución, F : R −→ [0, 1], viene dada por:

F (x) = 0

si x < 2 ,

F (x) = 1

si x ≥ 12

y para 2 ≤ x < 12, va subiendo de 0 a 1 paulatinamente creando una gráfica con escalones horizontales

entre cada dos enteros consecutivos, con los saltos en cada entero determinados por la función de

masa (dibujar la gráfica).

3.2.2

Variables aleatorias continuas

Definición 3.2.3. Una variable aleatoria, X, se dice continua cuando puede tomar cualquiera

de los valores de un intervalo. La función de probabilidad de una variable aleatoria continua queda

caracterizada por su función de densidad, que es una función f : R −→ R verificando:

1. f (x) ≥ 0, para todo x ∈ R;

Z

f (x) dx = 1.

2.

R

La probabilidad de un suceso, A, relativo a una variable aleatoria continua, X, con función de

densidad f se calcula mediante la fórmula:

Z

P (A) =

f (x) dx

A

44

Variables aleatorias

Conviene resaltar que para una variable aleatoria continua X, los sucesos unitarios, A = {t}, tienen

probabilidad 0 pues:

Z

P ({t}) =

f (x) dx = 0 .

{t}

Este hecho viene a decir que si X es una variable aleatoria continua, la probabilidad de que X tome

un valor particular es nula: P (X = t) = P ({t}) = 0. Como consecuencia, la función de distribución

no tiene saltos, es decir, es continua.

La función de distribución se obtiene a partir de la función de densidad:

Z x

F (x) = P ((−∞, x]) =

f (t) dt .

−∞

Además, en los puntos en que F (x) es derivable:

f (x) = F 0 (x) .

Ejemplo 25 Sea un segmento OA de longitud 5. ¿Cuál es la probabilidad de que un punto B,

situado al azar en OA, se encuentre en un segmento CD de OA? ¿Cuál es la función de densidad de

la distancia OB?

Solución: El conjunto Ω de sucesos es no numerable. La probabilidad de que B sea un punto

cualquiera del segmento CD, es nula. La probabilidad de que B esté sobre CD se define mediante

la razón de las longitudes: CD/OA. Modelizaremos el experimento tomando OA sobre el intervalo

[0, 5] de la recta real:

B

•

O=0

ª

◦

C

U

◦

D

q

•

A=5

Podemos definir la función de distribución de la variable aleatoria continua X =“distancia OB”,

de manera que sea igual a 1 cuando B esté en A:

Z 5

f (x) dx = 1 .

0

Puesto que el punto B se sitúa al azar en el intervalo OA, la distribución

decir, la función de densidad es constante, y así:

0

(

Z x1

0 si x ∈

/ [0, 5]

x

dt =

1

f (x) =

=⇒ F (x) =

si x ∈ [0, 5]

5

0 5

5

1

f (x)

1

5

F (x)

x

x

45

es uniforme sobre OA, es

si x < 0

si x ∈ [0, 5]

si x ≥ 5 .

Esperanza: media y varianza

3.3

Esperanza: media y varianza

Con frecuencia de los experimentos aleatorios que estudiemos, podremos realizar un estudio estadístico previo. Para ello, se toma cierta muestra, realizando varias veces el experimento, y se

recogen datos sobre distintas características del mismo. El objetivo último es adaptar, para las distintas características del experimento (variables aleatorias), modelos de probabilidad teóricos que

nos permitan predecir el comportamiento real (su probabilidad) de estas características.

De los datos tomados se calculan ciertas medidas que intentan darnos una idea de la distribución

de cada una de las características objeto de estudio. Destacamos entre estas la media (medida

de centralización), la varianza y la desviación típica (medidas de dispersión). En esta sección

definiremos los parámetros homónimos de estas medidas de la Estadística.

Definición 3.3.1. Dada una variable aleatoria discreta, X, con función de masa P (xi ), i = 1, 2, . . . ,

se define su media o esperanza como:

X

xi P (xi ) .

µ = E[X] =

i

De manera análoga, si X es una variable aleatoria continua, con función de densidad f (x), se

define su media o esperanza como:

Z

µ = E[X] =

xf (x) dx .

R

Pasemos a las medidas de dispersión (en el capítulo de Estadística vimos la utilidad de estas

medidas).

Definición 3.3.2. La varianza de una variable aleatoria discreta, X, con función de masa P (xi )

y media µ se define como:

X

σ 2 = V [X] = E[(X − µ)2 ] =

(xi − µ)2 P (xi ) .

i

Análogamente, la varianza de una variable aleatoria continua, X, con función de densidad f (x)

media µ se define como:

Z

2

2

σ = V [X] = E[(X − µ) ] = (x − µ)2 f (x) dx .

R

La desviación típica, σ, de una variable aleatoria se define como la raíz cuadrada positiva de

su varianza.

Ejercicio 1 Demostrar, en los casos discreto y continuo, la siguiente identidad para la varianza de

una variable aleatoria:

σ 2 = E[X 2 ] − µ2

46

Variables aleatorias

Solución: Si X es una variable aleatoria discreta con función de masa P (xi ), desarrollando el

cuadrado y simplificando, se obtiene:

X

σ2 =

(xi − µ)2 P (xi )

i

X

=

(x2i − 2xi µ + µ2 )P (xi )

i

=

X

x2i P (xi ) − 2µ ·

¡X

¢

¢

¡X

P (xi )

xi P (xi ) + µ2 ·

i

i

i

2

2

2

2

2

= E[X ] − 2µ + µ = E[X ] − µ .

En el caso continuo, desarrollando el cuadrado y simplificando, se obtiene:

Z

2

σ =

(x − µ)2 f (x) dx

µZ

¶

µZ

¶

ZR

2

2

x f (x) dx − 2µ

xf (x) dx + µ

f (x) dx

=

R

R

2

2

2

R

2

2

= E[X ] − 2µ + µ = E[X ] − µ .

Ejemplos

Ejemplo 26 Una persona participa en un concurso de televisión con las siguientes reglas:

• Si contesta correctamente a una pregunta con cinco respuestas posibles (sólo una correcta) gana

10 000e.

• En caso contrario se le propone una segunda pregunta con tres respuestas posibles (sólo una

correcta). Si acierta gana 1 000e.

• Si tampoco acierta la segunda respuesta, se le propone una tercera con dos respuestas posibles

(sólo una correcta). Si acierta no gana nada, pero si falla debe pagar 500e.

El juego termina cuando la persona acierta o tras fallar la tercera pregunta. Si un concursante contesta

al azar, calcúlese:

a) probabilidad de que obtenga una respuesta correcta;

b) la ganancia esperada;

c) E[X] y V [X], siendo X el número de preguntas propuestas al concursante.

Solución: Sea Ai el suceso “el concursante responde correctamente la cuestión i-ésima”, i = 1, 2, 3.

Los sucesos A1 , A2 y A3 son independientes.

a) La probabilidad de que una respuesta sea correcta es:

P (A1 ) + P (A2 )P (Ac1 ) + P (A3 )P (Ac1 )P (Ac2 ) =

47

11

1 1 4 1 4 2

+ · + · · =

.

5 3 5 2 5 3

15

Esperanza: media y varianza

b) Sea Y la variable aleatoria “ganancia”. Es claro que esta variable toma los valores:

y1 = 10 000

con

y2 = 1 000

con

y3 = 0

con

y3 = −500

con

1

;

5

4

P (y2 ) = ·

5

4

P (y3 ) = ·

5

4

P (y3 ) = ·

5

P (y1 ) =

1

3

2

3

2

3

=

4

;

15

1

4

=

;

2

15

1

4

· =

.

2

15

·

Por tanto, la ganancia esperada es:

E[Y ] = 10 000 ·

1

4

4

4

+ 1 000 ·

+0·

− 500 ·

= 2 133.33e .

5

15

15

15

c) La variable aleatoria X (= número de preguntas formuladas) puede tomar los valores:

1

,

5

x1 = 1

con

P (X = 1) = P (A1 ) =

x2 = 2

con

P (X = 2) = P (A2 )P (Ac1 ) =

x3 = 3

con

1

3

2

P (X = 3) = P (Ac2 )P (Ac1 ) =

3

4

4

=

,

5

15

4

8

· =

.

5

15

·

Así:

µ = E[X] =

3

X

xi P (xi ) = 1 ·

i=1

2

2

V [X] = E[X ] − µ =

4

8

35

1

+2·

+3·

=

= 2.33 ;

5

15

15

15

3

X

x2i P (xi ) − µ2

i=1

µ ¶2

1

4

8

35

= 1· +4·

+9·

−

5

15

15

15

91 1225

1365 − 1225

140

28

=

−

=

=

=

= 0.622 .

15

225

225

225

45

Ejemplo 27 La longitud de ciertos tornillos en centímetros se distribuye según la función de densidad:

( 3

(x − 1)(3 − x) si x ∈ [1, 3]

f (x) =

4

0

si x ∈

/ [1, 3] .

i) Calcúlese E[X] y σ[X].

ii) Si los tornillos son válidos sólo si su longitud está entre 1.7 y 2.4 cm., calcúlese la probabilidad

de que un tornillo sea válido.

48

Variables aleatorias

Solución: i) Aplicamos directamente las fórmulas a la variable aleatoria continua X =longitud del

tornillo, que tiene función de densidad f (x):

Z

E[X] =

=

=

E[X 2 ] =

=

σ 2 [X] =

σ[X] =

Z

3

3 3

x(x − 1)(3 − x) dx =

(−3x + 4x2 − x3 ) dx

4

4

1

1

´

3³ 3

4

1

− (9 − 1) + (27 − 1) − (81 − 1)

4

2

3

4

´ 3 8

3³

104

− 12 +

− 20 = · = 2 ;

4

3

4 3

Z 3

´

1

3

3³

− (27 − 1) + (81 − 1) − (243 − 1)

(−3x2 + 4x3 − x4 ) dx =

4 1

4

5

³

´

3

242

3 28

21

− 26 + 80 −

= ·

=

4

5

4 5

5

21

1

E[X 2 ] − µ2 =

−4=

5

5

r

√

1

5

=

= 0.447 .

5

5

3

ii) Nos piden calcular P (1.7 < x < 2.4), que, por definición, es:

Z

2.4

P (1.7 < x < 2.4) =

1.7

=

=

=

3.4

3

f (x) dx =

4

Z

2.4

(−3 + 4x − x2 ) dx

1.7

´

3 ³

1

· − 3(2.4 − 1.7) + 2(2.42 − 1.72 ) − (2.43 − 1.73 )

4

3

´ 1 ³

´

3 ³

1

· − 2.1 + 5.74 − 8.911 = · 10.92 − 8.911

4

3

4

2.009

= 0.50225 .

4

Varias variables

En un mismo experimento aleatorio podemos considerar distintas variables aleatorias: X1 , X2 , . . . .

En ocasiones interesará considerar sucesos determinados por valores referidos a varias de ellas, en cuyo

caso tendremos que “mezclar” adecuadamente la información de las variables individuales.

En el mejor de los casos la información de cada variable no influirá en la de las demás. Diremos

que estamos ante variables independientes. Cuando esto no sea así, tendremos una relación entre

ellas más o menos fuerte. La covarianza de dos variables aleatorias es un número que nos mide

esta posible relación.

Definición 3.4.1. (Vectores aleatorios) Un vector aleatorio (o variable aleatoria de dimensión n)

es una “función”

(X1 , . . . , Xn ) : Ω −→ Rn .

que a cada elemento ω del espacio muestral Ω le hace corresponder n números reales X1 (ω), . . . , Xn (ω).

49

Varias variables

Ejemplo 28 En el experimento “tirar dos dados perfectos sucesivamente”, se considera el vector

aleatorio

(X, Y ) : Ω −→ R2

que dado un elemento ω = (a, b) nos devuelve:

(X, Y )(ω) = (a + b, |a − b|) .

En el concurso televisivo del Ejemplo 26, se considera el vector aleatorio

(X, Y ) : Ω −→ R2

que a cada elemento del espacio muestral, ω, le asocia:

(X, Y )(ω) = ( preguntas propuestas al concursante , ganancia del concursante ) .

En la producción de tornillos del Ejemplo 27, consideramos el vector aleatorio

(X, Y, Z) : Ω −→ R3

que al tomar cada tornillo ω ∈ Ω, nos dice:

(X, Y, Z)(ω) = ( su longitud , diámetro de la cabeza , longitud de la rosca ) .

En lo que sigue definiremos los conceptos análogos al caso de una variable aleatoria para vectores

aleatorios de dimensión 2. El caso n–dimensional es la generalización natural del de dimensión 2.

Además, al considerar vectores aleatorios de la forma:

(X, Y ) : Ω −→ R2

podremos hacer representaciones sobre el plano, ganando en claridad a la hora de asimilar los conceptos.

Definición 3.4.2. Si A es un subconjunto de R2 descrito como conjunto de posibles valores del vector

aleatorio (X, Y ) : Ω −→ R2 , definimos:

P (A) = P ((X, Y ) ∈ A) = P ({ω ∈ Ω : (X(ω), Y (ω)) ∈ A}) .

Definición 3.4.3. La función de distribución de un vector aleatorio (X, Y ) se define como:

F (x, y) = P ({(s, t) ∈ R2 : s ≤ x, t ≤ y})

= P ({ω ∈ Ω : X(ω) ≤ x, Y (ω) ≤ y})

para todo (x, y) ∈ R2 .

Las propiedades de las funciones de distribución de un vector aleatorio son, en cierto modo,

parecidas al caso de una variable. Sin embargo son menos manejables, de manera que utilizaremos

las funciones de masa conjunta o de densidad conjunta, para el cálculo de probabilidades.

Ejercicio 2 Calcular la función de distribución del vector aleatorio

(X, Y ) : Ω −→ R2

correspondiente al concurso televisivo del Ejemplo 28.

50

Variables aleatorias

3.4.1

Densidad conjunta

Definición 3.4.4. Un vector aleatorio (X, Y ) es discreto cuando sólo puede tomar un número

finito o numerable de valores. El modelo de probabilidad conjunta de un vector aleatorio

(X, Y ) discreto queda caracterizado por la función de masa conjunta:

P (X = xi , Y = yj ) = P ({ω ∈ Ω : X(ω) = xi , Y (ω) = yj }) i = 1, . . . , m ; j = 1, . . . , n .

Cuando esté claro por el contexto, utilizaremos la siguiente notación: pi,j = P (X = xi , Y = yj ).

La función de masa conjunta suele presentarse con una tabla de doble entrada:

Y

X

y1

···

x1

..

.

yj

···

yn

···

···

..

.

xi

..

.

···

···

pi,j

..

.

xm

Ejemplo 29 Para el concurso televisivo descrito en el Ejemplo 26, calcular la función de masa del

vector aleatorio determinado por:

(X, Y )(ω) = ( preguntas propuestas al concursante , ganancia del concursante ).

Solución: Este vector aleatorio puede tomar 3 × 4 = 12 valores, tomando la primera componente

3 posibles valores, y 4 la segunda. La siguiente tabla nos representa la función de masa conjunta:

Y

X

−500

0

1 000

1

0

0

2

0

4

15

0

4

15

0

4

15

0

3

10 000

1

5

0

0

En el caso de vectores aleatorios, aparte de la distribución conjunta, hay otras distribuciones

también muy interesantes: las distribuciones marginales y las condicionadas.

Definición 3.4.5. Las distribuciones marginales de un vector aleatorio (X, Y ) son las que se

obtienen al considerar cada característica por separado. Así tenemos:

Distribución marginal de X: es de tipo discreto y su función de masa marginal viene

dada por:

n

X

P (X = xi ) =

P (X = xi , Y = yj ) , i = 1, . . . , m .

j=1

Distribución marginal de Y : es de tipo discreto y su función de masa marginal viene

dada por:

m

X

P (Y = yj ) =

P (X = xi , Y = yj ) , j = 1, . . . , n .

i=1

51

Varias variables

Obsérvese que, de la definición, es fácil obtener cada distribución marginal si la función de masa

conjunta viene representada por una tabla de doble entrada: basta en cada caso sumar por filas o

por columnas.

Ejemplo 30 Las distribuciones marginales del ejemplo anterior se obtienen a partir de la tabla como

se indica:

Y

X

−500

0

1 000

1

0

0

0

2

0

0

4

15

0

3

4

15

4

15

0

0

4

15

4

15

4

15

8

15

4

15

4

5

1

5

P (Y = yj )

FY (yj )

3.4.2

10 00

1

5

P (X = xi )

1

5

4

15

8

15

FX (xi )

1

5

7

15

1

1

Covarianza

Antes de pasar a las distribuciones condicionadas conviene definir: covarianza e independencia.

Definición 3.4.6. La covarianza entre dos variables aleatorias discretas X e Y se define como:

£

¤

Cov(X, Y ) = E (X − E[X])(Y − E[Y ])

m X

n

X

=

(xi − E[X])(yj − E[Y ])P (X = xi , Y = yj ) .

i=1 j=1

Decimos que X e Y están incorreladas, cuando Cov(X, Y ) = 0.

Se define, también, el coeficiente de correlación lineal de (X, Y ) como:

r=

Cov(X, Y )

.

σ[X]σ[Y ]

Este coeficiente verifica que −1 ≤ r ≤ 1, y sirve para estudiar la existencia de una posible relación

lineal entre X e Y : digamos Y = aX + b para ciertos coeficientes a, b ∈ R. Si r = 1 ó r = −1, existe

tal relación lineal. Su utilidad quedó más clara en los capítulos sobre Estadística.

Ejercicio 3 Demostrar la siguiente fórmula:

Cov(X, Y ) = E[XY ] − E[X] · E[Y ] .

52

Variables aleatorias

Solución: Desarrollando el sumatorio y usando las propiedades de las funciones de distribución

conjunta y marginales, tenemos:

Cov(X, Y ) =

=

m X

n

X

i=1 j=1

m X

n

X

(xi − E[X])(yj − E[Y ])P (X = xi , Y = yj )

xi yj P (X = xi , Y = yj ) − E[Y ]

i=1 j=1

−E[X]

m

X

xi

i=1

n

X

yj

m

³X

j=1

= E[XY ] − E[Y ]

n

³X

´

P (X = xi , Y = yj )

j=1

m X

n

´

X

P (X = xi , Y = yj ) + E[X]E[Y ]

P (X = xi , Y = yj )

i=1

m

X

i=1 j=1

xi P (X = xi ) − E[X]

i=1

n

X

yj P (Y = yj ) + E[X]E[Y ]

j=1

= E[XY ] − E[Y ]E[X] − E[X]E[Y ] + E[X]E[Y ] = E[XY ] − E[X]E[Y ] .

3.4.3

Independencia

Definimos a continuación la independencia de variables aleatorias discretas, de manera análoga a la

definición de independencia de sucesos.

Definición 3.4.7. Dos variables aleatorias discretas, X e Y , se dicen independientes cuando:

P (X = xi , Y = yj ) = P (X = xi ) · P (Y = yj )

para

i = 1, . . . , m ; j = 1, . . . , n .

Surge, de manera directa, la siguiente propiedad:

“Si X e Y son variables aleatorias discretas independientes entonces

E[XY ] = E[X] · E[Y ] .

En particular son incorreladas, es decir: Cov(X, Y ) = 0” .

Ejercicio 4 Demostrar la propiedad anterior.

Solución: Supongamos que X e Y son independientes, es decir:

P (X = xi , Y = yj ) = P (X = xi ) · P (Y = yj ) ,

para i = 1, . . . , m ; j = 1, . . . , n. Calculemos la esperanza de la variable producto X · Y :

E[XY ] =

=

=

m X

n

X

i=1 j=1

m X

n

X

xi yj P (X = xi , Y = yj )

xi yj P (X = xi ) · P (Y = yj )

i=1 j=1

m

X

n

³X

´

xi P (X = xi )

yj P (Y = yj )

i=1

j=1

m

³X

= E[Y ]

´

xi P (X = xi ) = E[Y ]E[X] .

i=1

53

Varias variables

En particular Cov(X, Y ) = E[XY ] − E[X]E[Y ] = 0, en otras palabras, X e Y son incorreladas

siempre que sean independientes.

Ejercicio 5 Calcular la covarianza de las variables aleatorias X = “número de preguntas propuestas

al concursante” e Y = “ganancia de un concursante”, del Ejemplo 26.

Solución: De la tabla de las funciones de masa conjunta y marginales del vector (X, Y ) vemos que

no son independientes, pues, por ejemplo:

P (X = 3, Y = 0) =

4

15

mientras que

P (X = 3) · P (Y = 0) =

8 4

4

·

6=

.

15 15

15

Con los datos de la tabla calculamos:

1

4

8

35

7

+2·

+3·

=

=

5

15

15

15

3

1

4

4

4

32 000

6 400

E[Y ] = 10 000 · + 1 000 ·

+0·

− 500 ·

=

=

5

15

15

15

15

3

1

4

4

4

32 000

6 400

E[XY ] = 1 · 10 000 · + 2 · 1 000 ·

+3·0·

+ 3 · (−500) ·

=

=

5

15

15

15

15

3

³

´

6 400 7 6 400

7

−25 600

6 400

Cov(X, Y ) = E[XY ] − E[X]E[Y ] =

− ·

= 1−

=

·

3

3

3

3

3

9

E[X] = 1 ·

de donde:

3.4.4

Densidades condicionadas

Finalizamos esta sección con el concepto de probabilidad condicionada.

Definición 3.4.8. La distribución de la variable aleatoria X, condicionada por un valor fijo, yj , de

la variable aleatoria Y , viene dada por la función de masa condicionada:

P (X = xi | Y = yj ) =

P (X = xi , Y = yj )

,

P (Y = yj )

i = 1, . . . , m .

Es fácil comprobar que si X e Y son independientes, las distribuciones condicionadas coinciden

con las distribuciones marginales correspondientes:

P (X = xi , Y = yj )

P (Y = yj )

P (X = xi ) · P (Y = yj )

=

= P (X = xi ) ,

P (Y = yj )

P (X = xi | Y = yj ) =

i = 1, . . . , m .

Y, análogamente, para Y : P (Y = yj | X = xi ) = P (Y = yj ), j = 1, . . . , n.

3.4.5

Vectores aleatorios continuos

Definición 3.4.9. Un vector aleatorio (X, Y ) es continuo cuando toma valores en un subconjunto

no discreto de R2 ; por ejemplo: un cuadrado, un rectángulo, un triángulo, un círculo, un sector

circular, . . . .

El modelo de probabilidad conjunta de un vector aleatorio (X, Y ) continuo queda caracterizado por la función de densidad conjunta, que es una “función” f : R2 −→ R, verificando:

1. f (x, y) ≥ 0 para todo (x, y) ∈ R2 ;

54

Variables aleatorias

ZZ

2.

f (x, y) dx dy = 1.

R2

La probablidad de cualquier suceso A ⊂ R2 relativo al vector aleatorio continuo (X, Y ), se calcula

por la fórmula:

ZZ

P (A) =

f (x, y) dx dy .

A

Definición 3.4.10. Las distribuciones marginales de un vector aleatorio (X, Y ) son las que

se obtienen al considerar cada característica por separado. Así tenemos:

Distribución marginal de X: es de tipo continuo y su función de densidad marginal

viene dada por:

Z

f (x) =

f (x, y) dy ,

para todo x ∈ R .

R

Distribución marginal de Y : es de tipo continuo y su función de densidad marginal

viene dada por:

Z

f (y) =

f (x, y) dx , para todo y ∈ R .

R

Definición 3.4.11. La covarianza entre dos variables aleatorias continuas X e Y se define como:

ZZ

£

¤

Cov(X, Y ) = E (X − E[X])(Y − E[Y ]) =

(x − E[X])(y − E[Y ])f (x, y) dx dy .

R2

Decimos que X e Y están incorreladas, cuando Cov(X, Y ) = 0. El coeficiente de correlación lineal de (X, Y ) se define como:

Cov(X, Y )

r=

.

σ[X]σ[Y ]

Ejercicio 6 Demostrar la igualdad: Cov(X, Y ) = E[XY ] − E[X]E[Y ].

Definición 3.4.12. Dos variables aleatorias continuas, X e Y , se dicen independientes si:

f (x, y) = f (x)f (y)

para cualesquiera x ∈ R, y ∈ R .

Se tienen, también, la siguiente propiedad:

“Si X e Y son variables aleatorias continuas independientes entonces

E[XY ] = E[X] · E[Y ] .

En particular son incorreladas, es decir: Cov(X, Y ) = 0” .

Definición 3.4.13. La distribución de la variable aleatoria X, condicionada por un valor fijo, y, de

la variable aleatoria Y , viene dada por la función de densidad condicionada:

f (x | y) = f (x | Y = y) =

f (x, y)

,

f (y)

para todo x ∈ R .

Obsérvese que es necesario que f (y) > 0. Intuitivamente, esto quiere decir que estamos condicionando por un valor de Y potencialmente observable.

55

Varias variables

Es fácil comprobar que si X e Y son independientes, las distribuciones condicionadas coinciden

con las distribuciones marginales correspondientes:

f (x | y) =

f (x)f (y)

= f (x) , para todo x ∈ R ;

f (y)

f (y | x) =

f (x)f (y)

= f (y), para todo y ∈ R .

f (x)

Ejercicio 7 La función de densidad conjunta de dos variables aleatorias continuas es:

½

f (x, y) =

k(x + xy)

0

si x ∈ (0, 1), y ∈ (0, 1)

en otro caso.

1) ¿Cuál es el valor de k?

2) Calcular la densidad marginal, la esperanza y la varianza de cada variable.

3) ¿Son variables independientes?

4) Calcular la covarianza.

Solución: 1) Puesto que es una función de densidad hemos de tener integral total 1. Integrando

tenemos:

ZZ

Z 1Z 1

f (x, y) dx dy = k

(x + xy) dx dy

R2

0

0

Z 1 ³Z 1

Z 1 ³

´

´

1

= k

x

(1 + y) dy dx = k

x (1 − 0) + ( − 0) dx

2

0

0

Z 1 0

¢ 3k

3k

3k ¡ 1

4

=

x dx =

−0 =

=⇒ k = .

2 0

2 2

4

3

2) Las densidades marginales serán:

Z

f (x) =

f (x, y) dy

ZR1

¢

4

4x ¡

1

x(1 + y) dy =

(1 − 0) + ( − 0) = 2x

3

3

2

½0

2x si x ∈ (0, 1)

de donde: f (x) =

0

en otro caso;

Z

f (y) =

f (x, y) dx

R

Z 1

¢ 2

4

4(1 + y) ¡ 1

ahora bien:

(1 + y)x dx =

− 0 = (1 + y)

3

3

2

3

(0 2

(1 + y) si y ∈ (0, 1)

de donde: f (y) =

3

0

en otro caso.

ahora bien:

56

Variables aleatorias

Con las densidades marginales calculamos los parámetros pedidos de cada variable:

Z

µX = E[X] =

E[X 2 ] =

2

σX

= E[X 2 ] − µ2X

=

µY = E[Y ] =

E[Y 2 ] =

σY2 = E[Y 2 ] − µ2Y

=

³1

´ 2

x · 2x dx = 2

−0 =

3

3

0

Z 1

1

1

x2 · 2x dx = (1 − 0) =

2

2

0

1 4

1

− =

2 9

18

Z 1

2

2³1 1´

=

y · (1 + y) dy =

+

3

3 2 3

0

Z

2 1 2

2³1 1´

=

y (1 + y) dy =

+

3 0

3 3 4

7

25

13

−

=

18 81

162

1

5

9

7

18

3) La densidad conjunta es el producto de las marginales:

f (x, y) = f (x) · f (y)

y, por tanto, son variables independientes.

4) Al ser variables independientes, directamente son incorreladas, es decir: Cov(X, Y ) = 0.

3.5

Suma de variables independientes

Es especialmente ventajoso considerar variables que se distribuyen de manera independiente pues

combinándolas linealmente se obtienen otras variables cuyas distribuciones se conocen a partir de las

primeras.

En la Estadística Descriptiva que hemos tratado en el Capítulo 1, es interesante que las muestras

recogidas nos sirvan para inferir la distribución de cierta cualidad en determinada población. Para

ello tomamos medidas numéricas de la muestra. Si cada dato muestral es representativo de la cualidad

(o variable aleatoria) a inferir, nos gustaría, por ejemplo, que la media muestral fuese representativa

de la media de dicha cualidad (se dice de la media poblacional); y así con el resto de las medidas:

varianza, desviación típica, mediana, . . .

Si consideramos a cada muestra, de tamaño N , como un valor concreto de un vector aleatorio

(X1 , X2 , . . . , XN ), con cada componente la misma variable, el requisito de independencia de las Xi

simplifica tanto los cálculos como el análisis.

Definición 3.5.1. Dadas n variables aleatorias X1 , X2 , . . . , Xn decimos que son variables aleatorias

independientes igualmente distribuidas, en adelante v.a.i.i.d., si todas siguen el mismo modelo de

probabilidad, digamos Xi ∼ X, y son independientes dos a dos.

Ejercicio 8 Probar que si X1 , X2 , . . . , Xn son v.a.i.i.d. con distribución común Xi ∼ X, µ = E(X)

y σ 2 = V (X) entonces:

E(X1 + X2 + · · · + Xn ) = nµ , V (X1 + X2 + · · · + Xn ) = nσ 2 .

¢

¡

Es más si X̄ = n1 X1 + X2 + · · · + Xn entonces µ(X̄) = µ y V (X̄) = σ 2 /n.

57

Problemas

Podemos, por último, tratar el caso más general de combinaciones lineales de variables aleatorias independientes. Basta enunciar los resultados para dos variables. Los presentamos en forma de

ejercicio:

Ejercicio 9 Sean X e Y dos variables aleatorias independientes, y consideremos la nueva variable

T = aX + bY (con a, b ∈ R). Entonces:

E(T ) = aE(X) + bE(Y ) ,

V (T ) = a2 V (X) + b2 V (Y ) .

Cerramos la sección con la observación de que si no se tiene independencia (ni tan siquiera

incorrelación) entre las variables, la covarianza juega un papel importante en la fórmula de la varianza

de la combinación (ver el problema 1).

Problemas

1. Demuestra las siguientes propiedades de esperanzas y varianzas de variables aleatorias:

(a) E[kX] = kE[X].

(b) E[X + Y ] = E[X] + E[Y ].

(c) V [kX] = k 2 V [X].

(d) Si X e Y son incorreladas: E[XY ] = E[X]E[Y ].

X

(e) V [X1 + · · · + Xn ] = V [X1 ] + · · · + V [Xn ] + 2

Cov(Xi , Xj ).

i<j

(f) Si X1 , . . . , Xn son variables aleatorias incorreladas:

V [X1 + · · · + Xn ] = V [X1 ] + · · · + V [Xn ] .

(g) V [X − Y ] = V [X] + V [Y ] − 2Cov(X, Y ).

(h) Si X e Y son variables aleatorias incorreladas: V [X − Y ] = V [X] + V [Y ].

2. Dadas las variables aleatorias independientes X e Y con funciones de densidad f y g respectivamente, dadas por:

( y

½

si 0 ≤ y ≤ 2

2x si 0 ≤ x ≤ 1

f (x) =

g(y) =

2

0

en otro caso;

0

en otro caso;

calcula:

i) E[X + Y ];

ii) E[2X − 3Y + 5];

iii) E[2XY ];

iv) V [4X − 2Y − 3];

v) V [2X + 3Y ].

58

Variables aleatorias

3. En un experimento aleatorio el suceso A ocurre con probabilidad 0.2. Se realiza el experimento

tres veces y se define la variable aleatoria X = “número de veces que ha ocurrido A” en las tres

pruebas que se suponen independientes.

(a) Calcular E[X] y V [X].

(b) Representar gráficamente la función de distribución de X.

(c) Calcular P (X > 2) a partir de la función de distribución.

4. La variable aleatoria X está distribuida de tal forma que su función de densidad determina con

los ejes un triángulo rectángulo con ángulo recto en el origen y base sobre el intervalo (0, 1).

Calcula sus funciones de densidad y distribución, la esperanza, µ, la desviación típica, σ, y la

probabilidad de que X ∈ (µ − σ, µ + σ).

5. Un semáforo está verde para los coches durante un minuto y medio, y rojo durante 15 segundos.

Suponiendo que un automovilista llega al semáforo con igual probabilidad en cualquier instante,

calcúlese el tiempo medio de espera.

6. Una diana está formada por tres círculos concéntricos de radios 10, 20 y 30 cm. respectivamente.

Si se cae en el círculo central se obtienen 5 puntos, 3 puntos si se cae en la primera corona

y 1 punto al caer en la tercera corona. La probabilidad de que un tiro caiga en cada zona es

proporcional al área de la misma (y ningún tiro cae fuera de la diana). Si se efectúan cuatro

disparos, calcúlese:

(a) la puntuación esperada;

(b) la probabilidad de la puntuación total se mayor que 17.

7. Un examen consta de 5 temas numerados. Para elegir un tema al azar, se propone lanzar un

dado; si sale de 1 a 5, el número del tema es el resultado del dado; si sale 6 se vuelve a tirar

hasta que sale de 1 a 5. Sabemos que el dado está trucado de tal manera que la probabilidad

de que salga el número 2 es 2/7 y la probabilidad de cualquier otro número es 1/7. Sea X la

variable aleatoria que representa el tema seleccionado finalmente. Halla la probabilidad de que

X valga 1 (que nos interesa especialmente ya que el tema 1 es el único que hemos estudiado).

8. El vector aleatorio (X, Y ) tiene una distribución de probabilidad dada por:

P (X = 0, Y = 1) = 0.3 ; P (X = 1, Y = 1) = 0.1 ; P (X = 2, Y = 1) = 0.1 ;

P (X = 0, Y = 2) = 0.1 ; P (X = 1, Y = 2) = 0.2 ; P (X = 2, Y = 2) = 0.2 .

Calcúlese:

(a) Las distribuciones marginales y condicionadas;

(b) las esperanzas de cada variable, y la de XY ;

(c) las varianzas de cada variable y Cov(X, Y );

(d) el coeficiente de correlación lineal.

59

Problemas

9. La vida útil de cierto producto perecedero es una variable aleatoria con función de densidad

½ −x

e

si x > 0

f (x) =

0

en otro caso.

Si X1 y X2 representan la vida útil de dos unidades de dicho producto, seleccionadas al azar,

calcúlese P (X1 ≤ 2, 1 ≤ X2 ≤ 3).

10. Dado el vector aleatorio (X, Y ) y la función

½

k(x + y) si 0 ≤ x ≤ 2 0 ≤ y ≤ 2x − x2

f (x, y)

0

en otro caso.

(a) Determínese k para que f (x, y) sea su función de densidad.

(b) Calcular P (0 ≤ X ≤ 1).

11. Las etiquetas de cierta bebida pueden tener un premio de forma que en cada 1000 etiquetas

hay 500 correspondientes a “inténtelo otra vez”, 300 con premio de 5 euros, 150 con premios de

10 euros, 40 con premios de 50 euros y 10 con premios de 100 euros. Una persona compra una

botella que cuesta 10 euros.

(a) Si X es la variable aleatoria correspondiente al beneficio obtenido por el comprador, ¿cuál

es la distribución de X?

(b) ¿Cuál es el beneficio esperado del comprador?

(c) ¿Cuál es la probabilidad de perder dinero?

(d) Si se sabe que el comprador ha ganado dinero, ¿cuál es la probabilidad de que le haya

tocado una etiqueta de 100 euros?

12. En una ciudad hay una proporción p de personas que fuman. Se define una variable aleatoria

X que toma el valor 1 si al preguntar a una persona seleccionada aleatoriamente responde que

es fumador, y toma el valor 0 si responde que no lo es.

(a) En función de p calcula la esperanza de X e interpreta el valor obtenido.

(b) Calcula la varianza de X en función de p. ¿Para qué valor de p es máxima la varianza?

(c) Si se pregunta a n personas seleccionadas aleatoriamente con reemplazamiento, y la variable

aleatoria Y representa el número de fumadores entre los n seleccionados, calcula la esperanza

y la varianza de Y .

13. Sea X una variable aleatoria continua con función de densidad

½

k(1 + x), si x ∈ (0, 2)

f (x) =

0,

si x ∈

/ (0, 2)

(a) Calcula la constante k.

(b) Calcula la probabilidad de que X tome valores entre 0 y 1.

(c) Sabiendo que X es mayor que 1, ¿cuál es la probabilidad de que sea menor que 1.5?

(d) Calcula P{|X − E(X)| > 0.2}

14. El tiempo de vida activa de un plaguicida (en días) es una variable aleatoria X con función de

densidad

½ 1 − 1 x

e 500 , si x ≥ 0

500

f (x) =

0,

si x < 0

60

Variables aleatorias

(a) Calcula el valor m tal que la probabilidad de que X sea menor o igual que m es 0.5.

Interpreta el resultado obtenido.

(b) Si al cabo de 800 días el plaguicida ya no estaba activo, ¿cuál es la probabilidad de que

tras 600 días todavía lo estuviera?

15. El vector aleatorio (X, Y ) tiene una distribución uniforme en el cuarto de círculo de centro

(0, 0) y radio r correspondiente al primer cuadrante. Obténganse las densidades conjunta y

marginales de X e Y , y estudiar si son variables independientes.

16. Una pareja decide encontrarse en un lugar prefijado entre las tres y las cuatro de la tarde, de

forma que el primero que llegue sólo esperará al otro durante 15 minutos. Suponiendo que los

momentos de llegada de ambos al lugar son independientes y se distribuyen uniformemente

entre las tres y las cuatro, calcúlese la probabilidad de que no se encuentren.

17. Una fábrica produce una pieza en dos calidades diferentes: el 60 % de la producción es de

calidad A. La duración (en años) de una pieza de esta calidad viene dada por la función de

densidad

½ −x

e

si x > 0

fA (x) =

0

en el resto.

El 40 % restante es de calidad B. La duración viene dada, en este caso, por la función de

densidad

½ −2x

2e

si x > 0

fB (x) =

0

en el resto.

(a) Calcula la probabilidad de que una pieza de calidad A dure más de 1 año.

(b) Si tomamos una pieza al azar de toda la producción, ¿cuál es la probabilidad de que dure

más de 1 año?

(c) Si tomamos una pieza al azar de toda la producción, y observamos que dura más de 1 año,

¿cuál es la probabilidad de que sea de calidad A?

18. Una empresa suministra energía eléctrica a través de dos líneas de alta tensión A y B. En la

siguiente tabla se muestran las probabilidades conjuntas pij = P {X = xi , Y = yj }, para las

variables X ≡ número de fallos mensuales en la línea A e Y ≡ número de fallos mensuales en

la línea B.

X

0

1

2

3

0

0.20

0.20

0.06

0.04

1

0.15

0.06

0.02

0.02

Y

2

0.05

0.08

0.02

0

3

0.04

0.03

0

0

4

0.02

0.01

0

0

(a) Calcula las distribuciones marginales de X e Y .

(b) Calcula la distribución del número de fallos que se producen en la línea B en un mes en que

no se produce ningún fallo en la línea A. ¿Cuál es el número esperado de fallos en este caso?

(c) ¿Son independientes los fallos en las dos líneas?

61

Problemas

19. Dos características, X e Y , son variables aleatorias con función de densidad conjunta:

½

kye−2x e−y si x > 0, y > 0

f (x, y) =

0

en el resto.

(a) Hallar el valor de k. ¿Son independientes X e Y ?

(b) Calcular la esperanza de X.

20. Dos sustancias, A y B, se encuentran en la sangre en cantidades X e Y , respectivamente. Estas

cantidades varían de un individuo a otro. La densidad conjunta de ambas es:

½ 2 2

xy

si 0 < x < 3, 0 < y < 3

81

f (x, y) =

0

en el resto.

Calcúlese:

(a) la densidad marginal de Y y la esperanza de Y ;

(b) la probabilidad de que, en un individuo tomado al azar, haya más sustancia A que B.

62