- Ninguna Categoria

capitulo 3 - U

Anuncio

Capítulo 3

TEORÍA GENERAL DEL MODELO

LINEAL

57

58

3.1.

Introducción.

Un problema muy frecuente en estadística consiste en buscar y estimar interdependencias entre variables. En

efecto, cuando un par de variables aleatorias (X,Y ) no son independientes, el conocimiento del valor por X

cambia nuestro incertidumbre con respecto a la realización de Y : disminuye en general esta incertidumbre,

ya que la distribución de Y dado X = x tiene una varianza que en promedio es menor que la varianza marginal

de Y :

Var(Y ) = EX {Var(Y |X)} +VarX {E(Y |X)}

Demostración: Observamos en primer lugar que EX (E(Y |X)) = E(Y ).

Consideramos

Z

(y − E(Y ))2 dIPY (y)

Var(Y ) =

Como y − E(Y ) = y − E(Y |X) + E(Y |X) − E(Y ), se tiene que

(y − E(X))2 = (y − E(Y |X))2 + (E(Y |X) − E(Y ))2 + 2(y − E(Y |X))(E(Y |X) − E(Y ))

Además dIP(x, y) = dIPY |X (y)dIPX (x), en donde IPY |X es la distribución condicional de Y dado X y IPX es la

distribución marginal de X. Luego

Z Z

Var(Y ) =

2

Y |X

(y − E(Y |x)) dIP

Z

+2

Z Z

X

2

Y |X

(y) dIP (x) +

(E(Y |x) − E(Y )) dIP (y) dIPX (x)

(E(Y |x) − E(Y ))

Z

Y |X

(y − E(Y |x))dIP

(y) dIPX (x)

Pero por definiciones y algunos desarrollos vemos que:

EX (Var(Y |X)) =

VarX (E(Y |X)) =

Z

Z Z

Z Z

Y |X

2

(y − E(Y |x)) dIP

2

(y) dIPX (x)

Y |X

(E(Y |x) − E(Y )) dIP

(y) dIPX (x)

(y − E(Y |x))dIPY |X (y) = 0

Luego Var(Y ) = EX {Var(Y |X)} +VarX {E(Y |X)}.

Se deduce que EX {Var(Y |X))} ≤ Var(Y ). Es un resultado promedio, eso no impide que para algunos valores

de X, Var(Y |X) sea el mayor que Var(Y ).

Cuando se puede aceptar que el fenómeno aleatorio representado por una variable o un vector X puede servir

para predecir aquel representado por Y , hay que buscar una fórmula de predicción. Algunas relaciones son

fáciles de plantear y verificar, como las relaciones planteadas a partir de leyes físicas o mecánicas, pero

59

cuando la aleatoriedad juega un papel importante, el estudio se hace más difícil.

Se busca aquí descubrir como un conjunto de variables X1 , X2 , ·Xp influye sobre una o varias otras variables

Y . Para este propósito, se busca una función f que permita reconstruir los valores obtenidos sobre una

muestra de la variables respuesta Y :

Y = f (X1 , X2 , . . . Xp }.

Las variables {X1 , X2 , ·Xp } se llaman variables explicativas o variables independientes o variables exógenas y la variables Y se llama variable a explicar o variable respuesta o variables dependiente o variable

endógena.

Daremos algunos ejemplos, en que se ocupan estos modelos:

Ejemplo 3.1 La distancia que una partícula recorre en el tiempo t está dada por la fórmula:

d = α + βt

en que β es la velocidad promedio y α la posición de la partítula en el tiempo inicial t = 0. Si α y β

son desconocidos, observando la distancia d en dos épocas distintas, la solución del sistema de las dos

ecuaciones lineales obtenidas permite obtener α y β. Sin embargo es difícil obtener en general una distancia

sin error de medición. Por lo cual se observa una variable aleatoria: Y = d + ε en vez de d, en que ε (ruido

blanco") es de tipo aleatorio. En ese caso no basta tener dos ecuaciones sino valores de la distancia para

varios valores del tiempo. Los métodos estadísticos basados en la aleatoriedad del error permiten estimar a

α, β y d sobre la base de una relación funcional de tipo lineal.

Ejemplo 3.2 Si consideramos el peso P y la talla T de las mujeres chilenas adultas, está claro que no

existe una relación funcional entre P y T , pero existe una tendencia. Considerando que P y T son variables

aleatorias de ditribución conjunta normal bivariada:

P = f (T ) + ε

con

f (T ) = E(P|T )

en que ε refleja la variabilidad del peso P entre las chilenas de la misma talla con respecto a la media. El

tipo de funcional f no es evidente.

Ejemplo 3.3 Para decidir la construcción de la nueva central eléctrica, ENDESA busca prever el consumo

total de electricidad en Chile después del año 2002. Se construye un modelo que liga el consumo de electricidad con variables económicas, demográficas y metereológicas, y este modelo estima en base a datos

obtenidos en el pasado. Se aplica entonces el modelo para predecir el consumo de electricidad según ciertas

evoluciones económicas, metereológicas y demográficas.

60

Ejemplo 3.4 Para establecer una determinada publicidad en la televisión, se cuantifica el efecto de variables culturales y socio-económicas en la audiencia de los diferentes programas. Sobre la base de una

encuesta telespectadores se construye un modelo que determina los efectos de las variables culturales y

socio-económicas en la audiencia.

Ejemplo 3.5 Ajuste polinómial. El modelo lineal puede ser generalizado tomando funciones de las variables explicativas y/o de la variable a explicar. Es el caso cuando se tiene una variables respuesta Y a partir

de una sola variable X en un modelo polinomial: Y = a0 + a1 X 2 + · · · + a p X p en donde X j es la potencia j

de X.

Ejemplo 3.6 Se quiere estimar la constante g de la gravitación. Se toman los tiempos de caída t de un objeto

1

desde la altura h dada del suelo: d = gt 2 .

2

Observamos en los distintos ejemplos que las variables pueden ser aleatorias o no, las relaciones lineales o

no y que cuando no son lineales pueden eventualmente existir transformaciones de las variables que llevan

a relaciones lineales.

Se presenta a modo de introducción un enfoque teórico de la regresión funcional, para presentar después el

caso lineal sobre valores muestrales.

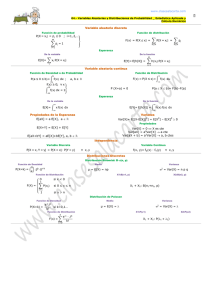

Se usaran dos métodos de estimación:

El método matemático de ajuste de los mínimos cuadrados, que permite estimar los coeficientes del

modelo lineal a partir de valores observados. En este caso no se toma en cuenta la aleatoriedad de las

variables en la estimación del modelo.

El método de máxima verosimilitud basado en un modelo probabilístico normal, que permite justificar

el método de mínimos cuadrádos y discutir las propiedades de los estimadores y la precisión del ajuste.

Finalmente se usará el modelo lineal para predecir. Se enfatizará los aspectos geométricos del problema y

como hacer una crítica de los supuestos probabilísticos usuales.

3.2.

Modelo teórico condicional.

Proposición 3.1 Sean la v.a. Y ∈ IR y el vector aleatorio X ∈ IR p . El mínimo de E{(Y − f (X))2 } se alcanza

en f (X) = E(Y |X).

Demostración: Geométricamente, en el espacio de Hilbert L2p+1 de dimensión p + 1 tomando como producto escalar

< U,V >= E(UV t )

61

E(Y |X) es la proyección ortogonal de Y sobre el subespacio LX2 generado por las funciones de X.

El criterio para minimizar es el error cuadrático medio

E{(Y − g(X))2 }

Si f (X) = E(Y |X), entonces para toda función g(X), se tiene:

E{(Y − g(X))2 } = E{(Y − f (X))2 } + E{( f (X) − g(X))2 } ≥ E{(Y − f (X))2 }.

En efecto

E{(Y − f (X))( f (X) − g(X))} = E{( f (X) − g(X))E{(Y − f (X))|X}}

dado que f (X) − g(X) es independiente de Y y E{(Y − f (X)|X) = 0 se obtiene el resultado.

Un índice para medir la calidad del modelo está dado pro el coeficiente de correlación entre Y y E(Y |X)

cuyo cuadrado es:

Var{E(Y |X)}

Var(ε)

= 1−

Var(Y )

Var(Y )

ηY2 |X = Cor2 (Y, E(Y |X)) =

donde ε = Y − E(Y |X), y entonces

Var(ε) = (1 − ηY2 |X )Var(Y ).

En efecto:

Cov(Y, E(Y |X)) = E[(y − E(Y ))(E(Y |X) − E(Y ))]

Como E(ϕ(X,Y ))) = EX {EY |X (ϕ(X,Y )|X)}

Cov(Y, E(Y |X)) = EX E{(Y − E(Y ))(E(Y |X) − E(Y ))|X}

Ahora bien:

E{(Y − E(Y ))(E(Y |X) − E(Y ))|X} = (E(Y |X) − E(Y ))(E(Y |X) − E(Y )) = (E(Y |X) − E(Y ))2

y

Cov(Y, E(Y |X)) = EX {(E(Y |X) − E(Y ))2 } = Var(E(Y |X))

Finalmente

Cor2 (Y, E(Y |X)) =

Var(E(Y |X))

Var(E(Y |X))2

=

Var(Y )Var(E(Y |X))

Var(Y )

En el caso lineal f (X) = E(Y |X) = βT X y E(ε) = 0.

62

Minimizar Var(ε) equivale a tomar Cov(ε, X) = 0. Luego Cov(Y, X) = βVar(X) en donde β = (Var(X))−1Cov(Y, X):

Var(Y ) = Var{E(Y |X)} +Var(ε).

3.3.

Estimación de los parámetros del modelo lineal

Sean {(yi , xi,1 , xi,2 , . . . , xi,p )|i = 1, 2, . . . , n} los valores obtenidos sobre una muestra aleatoria simple de

tamaño n del vector (Y, X1 , X2 , . . . , Xp ) de IR p+1 . Se plante el modelo lineal:

E(Y |X = (xi,1 , xi,2 , . . . , xi,p )) = β0 + β1 xi,1 + β2 xi,2 + · · · + β p xi,p .

Consideraremos aquí el vector X como no aleatorio.

Denotamos ∀i = 1, 2, . . . , n : xi = (xi,1 , xi,2 , . . . , xi,p ) y hacemos los siguientes supuestos sobre los errores:

εi = yi − E(Y ) ∼ N(0, σ2 ), independientes entre si e independientes de los xi . Tenemos entonces p + 2

parámetros a estimar, que son β0 , β1 , . . . , β p y σ2 . Dos tipos de métodos de estimación se pueden usar aquí:

el método de ajuste de los mínimos cuadrados y el método de máxima verosimilitud.

3.3.1.

Solución de los mínimos cuadrados

Se busca minimizar una función de los errores, como por ejemplo:

p

∑ ε2i ,

i=1

n

∑ |εi |,

máx{εi }

i

i=1

n

El criterio de los mínimos cuadrados toma como función

∑ ε2i cuya solución es fácil de obtener y que

i=1

tiene una interpretación geométrica simple. Escribiremos matricialmente el modelo aplicado a la muestra de

observaciones.

y1

Sea Y =

y2

..

.

,

1 x1,1 x1,2 . . .

x1,p

X =

1 x2,1 x2,2 . . .

..

..

..

..

.

.

.

.

x2,p

..

.

,

1 xn,1 xn,2 . . .

xn,p

yn

β0

β=

β1

..

.

,

βp

ε1

ε=

ε2

..

.

.

εn

Entonces el modelo se escribe

Y = Xβ + ε.

El criterio de los mínimos cuadrados consiste en buscar el punto del subespacio vectorial W = Im(X) de IRn

generado por las columnas de la matriz X más cercano al punto Y . La solución es la proyección ortogonal

63

del punto Y sobre W y esta es obtiene de las ecuaciones normales con la métrica usual:

X t Xβ = X t Y

Este sistema de ecuaciones lineales tiene una solución única cuando las columnas de X son lineales independientes, es decir que forman una base del subespacio vectorial de W , o sea que la dimensión del rango

de X es igual a p + 1. En este caso la solución de los mínimos cuadrados es igual a:

βˆ = (X t X)−1 X t Y.

Se deduce que el operador de proyección ortogonal sobre W , que es un operador lineal idempotente de orden

2 y simétrico, se escribe matricialmente como:

P = X(X t X)−1 X t

Si el rango de X es inferior a p + 1, basta encontrar una base de W entre las columnas de X, y reemplazar X

por X1 la matriz formada por estas columnas linealmente independientes. Se observará que si bien βˆ no es

necesariamente único, Y = Xβ = PY y ε̂ = Y − X βˆ = (I − P)Y lo son. El método no permite estimar a σ2 .

3.3.2.

Solución de máxima verosimilitud

En el párrafo anterior, para estimar los coeficientes β j se usó un criterio ma temático que permite ajustar un

hiperplano afin de IR p+2 . Aquí usaremos el método de máxima verosimilitud para estimarlos. El modelo

probabilístico se basa en los errores. El modelo

E(Y ) = β0 + β1 X1 + · · · + β p Xp = Xβ

con Y = E(Y ) + ε = Xβ + ε en donde se supone ε ∼ Nn (0, σ2 In ). La función de verosimilitud utilizada es la

densidad conjunta de los errores:

f (ε1 , ε2 , . . . , εn ) =

2

f (ε1 , ε2 , . . . , εn ; β, σ ) =

1

2πσ2

1

2πσ2

n2

1 t

exp − 2 ε ε

2σ

1

exp − 2 (Y − Xβ)t (Y − Xβ)

2σ

Calculemos el estimador de máxima verosimilitud de β:

XTY

n2

(Ecuaciones normales).

64

∂ ln f

∂(Y − Xβ)t (Y − Xβ)

=0⇒

= 0 ⇒ (X t X)βˆ =

∂β

∂β

Calculemos el estimador de máxima verosimilitud de σ2 :

ˆ t (Y − X β)

ˆ

∂ ln f

(Y − X β)

2

=

0

⇒

σ

=

∂σ2

n

ˆ entonces

y si ε̂ = Y − X β,

σ̂2 =

1 n 2

∑ ε̂i

n i=1

Es decir que la función de verosimilitud es máxima cuando se cumplen las ecuaciones normales: (X t X)βˆ =

1 n

ˆ i ; en

X t Y y además σ̂2 = ∑ ε̂2i llamado la varianza residual dado que es la varianza empírica de los ∈

n i=1

efecto ya que Y = X βˆ + ε̂, ε̂ ∈ Im(X) y

n

X βˆ ∈ (Im(X))⊥ ⇒ ε̂ ⊥ 1n ⇒ ∑ ε̂2i = 0

i=1

El estimador de los mínimos cuadrados es igual entonces al estimador de máxima verosimilitud cuando se

tiene el supuesto de normalidad ε ∼ Nn (0, σ2 In ).

3.4.

Propiedades del estimador

Las propiedades del estimador βˆ solución de las ecuaciones normales están ligadas a los supuestos hechos

sobre los errores εi . Supondremos aquí que X es de rango completo (p + 1).

Propiedades:

El estimador βˆ es un estimador insesgado de β:

ˆ =β

E(ε) = 0 ⇒ E(Y ) = Xβ ⇒ E(β)

El estimador Ŷ = PY = X βˆ es un estimador insesgado de Xβ.

ε ∼ Nn (0, σ2 In ) ⇒ Ŷ ∼ Nn (Xβ, σ2 P) donde P era el proyector ortogonal sobre W en IRn .

ε ∼ Nn (0, σ2 In ) ⇒ ε̂ ∼ Nn (o, σ2 (In − P)), con ε̂ ortogonal a W o ε̂ independiente de X.

βˆ ∼ Np+1 (β, σ2 (X t X)−1 ).

1 n 2

∑ ε̂i es un estimador sesgado para σ2 . En efecto:

n i=1

!

2

ε̂

∑ i X = (n − p − 1)σ2 ;

i=1

n

E

65

luego σ̃2 =

n

1

∑ ε̂2i es un estimador insesgado para σ2 . En efecto,

n − p − 1 i=1

ε̂ = (In − P)Y = (In − P)Xβ + (In − P)ε = (In − P)ε.

Luego

ε̂t ε̂ = εt (In − P)ε = Traza((In − P)εεt )

y

E(ε̂t ε̂) = σ2 Traza((In − P)) = (n − p − 1)σ2

βˆ es independiente de

n

∑ ε̂2i .

i=1

βˆ es un estimador consistente para β y σ̃2 =

n

1

ε̂2 es consistente para σ2 .

∑

n − p − 1 i=1 i

El estimador es óptimo con respecto a la varianza (ver el teorema de Gauss Markov a continuación).

Consideremos la siguiente definición:

Definición 3.1 Sean A, B ∈ Mn (IR). Se dice que A ≤ B si y solamente si B = A + C, en donde C es

semi-definida positiva

Teorema 3.1 Teorema de Gauss-Markov: si E(ε) = 0 y E(εεT ) = σ2 In , entonces βˆ tiene varianza entre

los estimadores insesgados de β, lineales en Y . Además si ε ∼ Nn (0, σ2 In ), entonces βˆ tiene mínima

varianza entre los estimadores insesgados de β.

Demostración: Si entre los estimadores insesgados de β y lineales en Y , βˆ tiene la varianza más pequeña,

hay que mostrar que:

ˆ ≤ Var(β∗ ).

∀β∗ = GY : E(β∗ ) = β ⇒ Var(β)

Sea βˆ = AY una solución de las ecuaciones normales, entonces β∗ = βˆ + DY , en que D = G − A.

ˆ = E(DY ) = 0 y como Y = Xβ + ε entonces DX = 0.

Como los dos estimadores son insesgados, E(β∗ − β)

Calculemos la varianza de β∗ :

ˆ +Var(DY ) + 2Cov(β,

ˆ DY )

Var(β∗ ) = Var(β)

en donde

ˆ DY ) = E((βˆ − β)(DY )t ) = E(βY

ˆ t Dt ) = E((X t X)−1 X t YY t Dt ) =

Cov(β,

(X t X)−1 X t E(YY t )Dt = (X t X)−1 [Var(Y ) + E(Y )E(Y )t ]Dt = 0

ˆ + σ2 DDt en donde DDt es semi-definida positiva.

Finalmente Var(β∗ ) = Var(β)

66

Si además los errores siguen una distribución normal, el estimador βˆ es de mínima varianza entre todos

los estimadores insesgados de β. En efecto la cantidad de información de la muestra multivariada para el

parámetro β es igual a

In (β) =

1 t

XX

σ2

y el estimador βˆ tiene una matriz de varianza igual a σ2 (X t X)−1 . Luego se obtiene la igualdad en la desigualdad de Cramer-Rao.

Se obtiene facílmente una generalización de este teorema cuando Var(ε) = Γ, Γ que supondremos invertible.

El estimador de mínima varianza es entonces:

βˆ = (X t Γ−1 X)−1 X t Γ−1Y

Es decir que estamos proyectando ortogonalmente en el sentido de la métrica Γ−1 .

3.5.

Calidad del modelo

Para ver si el modelo es válido, hay que realizar varios estudios: la verificación de los puestos sobre los

errores, la forma y significación de las dependencias, el aporte de cada variable explicativa. Lo que se hará

estudiando, mediante gráficos, índices y test, no solamente la calidad del modelo global y el aporte individual

de cada variable explicativa, sino que el aporte de un grupo de m variables explicativas también.

3.5.1.

Calidad global del modelo.

Los residuos ε̂i dan la calidad del ajuste para cada observación de la muestra. Pero es una medida individual

que depende de la unidad de medición. Un índice que evita este problema está dado por:

n

∑ ŷ2i

i=1

n

∑ y2i

i=1

que representa el cuadrado del coseno del ángulo del vector Y con el vector Ŷ en IRn (Figura ??).

Se puede comparar las siguientes varianzas:

Varianza residual:

1 n 2

∑ ε̂i .

n i=1

Varianza explicada por el modelo:

1 n

∑ (ŷi − ȳ)2 .

n i=1

67

Varianza total:

1 n

∑ (yi − ȳ)2 .

n i=1

Figura 3.1: Proyección del vector Y en W

Un índice estadísticamente más interesante es el coeficiente de correlación múltiple R o su cuadrado, el

coeficiente de determinación:

n

∑ (ŷi − ȳ)2

IR2 =

i=1

n

∑ (yi − ȳ)2

i=1

que compara la varianza explicada por el modelo con la varianza total. El coeficiente de correlación múltiple

R es el coeficiente de correlación lineal entre Y e Ŷ . El valor de R está comprendido entre 0 y 1. Cuando

R = 0, el modelo obtenido es ∀i : ŷi = ȳ, la media muestral de los valores yi y en consecuencia las variables

no explican nada en el modelo. En cambio cuando R es igual a 1, el vector Y pertenece al subespacio

vectorial W , es decir que existe un modelo lineal que permite escribir las observaciones yi exactamente

como combinación de las variables explicativas. Cuando R es cercano a 1, el modelo es bueno siendo que

los valores estimados ŷi ajustan bien los valores observados yi .

Para el caso general se tiene:

Corr(Y, Ŷ ) =

kŶ − ȳ1n k

= máx Corr(Y, Z)

kY − ȳ1n k Z=Xβ

en donde 1n es el valor de la bisectriz de IRn de componentes todas iguales a 1.

Si se plantea la hipótesis global H0 : β1 = β2 = · · · = β p = 0 ⇐⇒ H0 : E(Y ) = β0 1n , esta hipótesis significa

que los valores de las p variables explicativas no influyen en los valores de Y . Como ε̂ ∼ Nn (0, σ2 (In − P))

68

e Ŷ ∼ Nn (Xβ, σ2 P), si r es el rango de la matriz X, se tiene:

n

∑ ε̂2i

i=1

=

σ2

(n − r)σ̂2

∼ χn−r .

σ2

Como Ŷ |H0 ∼ Nn (β1 1n , σ2 P) ⇐⇒ βˆ 0 = ȳ, se tiene:

n

∑

i=1

yi − β0

σ

2

n

y

∑

i=1

ŷi − ȳ

σ

2

∼ χ2r−1

n

∑ ŷ2i

Además

i=1

σ2

n

y

∑

i=1

ŷi − ȳ

σ

2

son independientes. Se tiene entonces que bajo la hipótesis nula H0 :

n

∑ (ŷi − ȳ)2 /(r − 1)

F=

i=1

∼ Fr−1,n−r

n

∑ ε̂2i /(n − r)

i=1

en donde Fr−1,n−r sigue una distribución de Fisher a r − 1 y n − r grados de libertad. Se puede expresar F

en función del coeficiente de correlación múltiple R:

F

(n − r)R2

.

(r − 1)(1 − R2 )

La región crítica para la hipótesis nula H0 : E(Y |X) = β0 1n contra la hipótesis alternativa H1 : E(Y |X) = Xβ

con un nivel de significación α está definida por

IP(Fr−1,n−r > cα ) = α.

Se rechaza H0 , por lo tanto se declara el modelo globalmente significativo cuando se encuentra un valor F

en la muestra mayor que cα .

En la práctica, se define la probabilidad crítica o p-valor que es el valor pc tal que IP(Fr−1,n−r > F) = pc .

Si el valor de la probabilidad crítica pc es alta, no se rechaza H0 , es decir que se declara el modelo como

poco significativo.

3.5.2.

Medición del efecto de cada variable en el modelo

Cuando las variables explicativas son independientes, el efecto asociado a l variable X j se mide con X j βˆ j .

Se observará que el modelo lineal es invariante por el cambio de escalas de mediciones.

69

Consideramos la hipótesis nula H0 : β j = 0. Como βˆ j ∼ N(β j , σ2j ) en donde σ2j = Var(βˆ j ) (σ2j = σ2 (X t X)−1

j, j

ˆβ j − β j

(n − r)σ̂

∼ χ2n−r , se

en el caso del modelo con rango completo), σ j ∼ N(0, 1). Por otra parte, como

σ2

deduce que

βˆ j − β j

∼ tn−r .

σ̂ j

Bajo la hipótesis nula H0 : β j = 0,

βˆj

∼ tn−r .

σ̂ j

βˆ j

Si la probabilidad crítica o P-valor IP |tn−r | >

= pc es grande, no se rechaza H0 y si es pequeña se

σ̂ j

rechaza H0 , lo que en este caso muestra un efecto significativo de la variables X j sobre Y .

Estos test individuales sobre los efectos tienen validez cuando las variables explicativas son relativamente

independientes. Cuando no es el caso, es decir cuando una variable X j puede tener un efecto sobre Y distinto

cuando se combina con otras variables, hay entonces que eliminar los efectos de las otras variables. Para eso

se puede usar el coeficiente de correlación parcial.

3.5.3.

Coeficiente de correlación parcial

El efecto de una variable X sobre la variable Y puede estar afectado por una tercera variable Z cuando Z

tiene efecto sobre X también. El estudio se basa entonces en las dos relaciones del tipo lineal:

X = αZ + ϑ

Y = γZ + η.

Una vez eliminada la influencia de la variable Z sobre las variables X e Y se mide solamente a partir de los

restos:

X − αZ = ϑ

Y − γZ = η.

Definición 3.2 El coeficiente de correlación parcial entre X e Y bajo Z constante es el coeficiente de

correlación entre los errores ϑ y γ:

ρ(X,Y |Z) = Corr(ϑ, γ)

Se observa que si X y Z son muy correlacionados entonces la correlación parcial entre X e Y es muy pequeña.

En efecto X aporta casi ninguna información nueva sobre Y (o vice-versa) cuando Z es conocida.

Se usa el gráfico de los errores para medir los efectos y el tipo de efecto (lineal o no). Del gráfico3.2(a)

podemos decir que la variable X2 no tiene efecto sobre la variable Y en presencia de la variable X1 . Pero en

70

el gráfico3.2(b) la variable X2 aporta a la explicación de la variable Y aún si la variable X1 es presente en el

modelo.

Figura 3.2: Interpretación de los errores y del coeficiente de correlación parcial

Se puede generalizar a más de 2 variables Z j , j = 1, 2, . . . , q. Si

q

X=

q

∑ α jZ j + ϑ Y =

j=1

∑ Zj +γ

j=1

entonces se define el coeficiente de correlación parcial entre X e Y , dadas las variables Z j , por:

ρ(X,Y |Z1 , Z2 , . . . , Zq ) = Corr(ϑ, γ).

Si las variables Z j no tienen efecto sobre X e Y , es decir que las correlaciones Corr(X, Z j ) y Corr(Y, Z j ) son

todas nulas, entonces ρ(X,Y |Z1 , Z2 , . . . , Zq ) = Corr(X,Y ).

Se generaliza también la matriz de correlación parcial con mas de dos variables. Definimos para eso la

matriz de varianza-covarianza del vector X dado el vector Z fijo:

Var(X|Z) = ΓXX − ΓXZ Γ−1

ZZ ΓZX .

Se tiene una intertretación geométrica del coeficiente parcial ρ(X,Y |Z) mediante los triángulos esféricos: El

ángulo (A) del triángulo esférico(ABC) está definido por el ángulo entre las dos tangentes en A a los lados

del triángulo esférico (Gráfico3.3). El ángulo (A) es entonces igual a la proyección del ángulo entre OX y

OY sobre el plano ortogonal a OZ. Los ángulos siendo relacionados a los arcos, se tiene:

cos(A) =

cos(a) − cos(b) cos(c)

.

sin(b) sin(c)

Luego:

71

Figura 3.3: Representación esférica del coeficiente de correlación parcial

Figura 3.4: (a) ρ(X,Y |Z) = −1

(b) Corr(X, Z) = 0, Corr(Y, Z) = 0, 01, ρ(X,Y |Z) = 1.

Corr(X,Y ) −Corr(X,

q Z)Corr(Y, Z)

ρ(X,Y |Z) = q

1 −Corr2 (X, Z) 1 −Corr2 (Y, Z)

En la figura3.4a, el ángulo A = π2 , el coeficiente de correlación parcial es −1. Pero puede haber un efecto

escondido de la variable X sobre la variable Z como se ilustra en la figura3.4b: el coeficiente de correlación

múltiple de X e Y sobre Z es igual a 1, a pesar que el coeficiente de correlación entre X y Z es nulo y el

coeficiente de correlación entre Y y Z es muy pequeño aquel entre X e Y cercano a 1. El coeficiente de

correlación parcial es igual a 1 también.

3.5.4.

Efecto de un grupo de variables

Vimos que el efecto global de todas las variables explicativas y los efectos individuales. Veremos aquí el

efecto de un grupo de k variables, sean X j1 , X j2 , . . . , X jk (k ≤ p), entre las p variables. El efecto de estas

72

variables se mide considerando la hipótesis nula H0 : β j1 = β j2 = · · · = β jk = 0 contra H1 : E(Y ) = β0 +

β1 X1 + · · · + β p Xp .

Sean X jk+1 , X jk+2 , . . . , X j p el restante de las P variables. Bajo H0 , el modelo se escribe: Y = γ0 + γ jk+1 X jk+1 +

· · · + γ j p X j p + εo . Se tiene la varianza residual bajo H1 menor que la varianza residual bajo H0 :

∑ ε̂2i ≤ ∑ ε̂2oi

i

i

Se puede estudiar el cociente de las dos varianzas residuales

∑ ε̂2oi

i

∑ ε̂2i

o su complemento

i

∑ ŷ2oi

i

∑ ε̂2i

en donde

i

yˆoi = yi − ε̂2oi son las componentes del estimador E(Y |X) bajo H0 .

Bajo la hipótesis H0

∑(ŷi − ŷoi )2 /k

Q=

i

∑ ε̂2i /(n − r)

∼ Fk,n−r .

i

Lo que conduce a un test de región crítica de la forma Q ≥ cα .

Considerando otra forma de escribir el problema. Sea la hipótesis nula H0 : E(Y ) = X0 β ∈ W0 , con X0 de

rango s, contra H1 = Xβ ∈ W .

La hipótesis H0 equivale a (X − X0 )β = 0 lo que corresponde a k = p − s + 1 ecuaciones independientes

D β = 0, en que D es de rango k. Para que el test tenga sentido, Dβ tiene que ser estimable, es decir que

|{z}

k×(p+1)

el estimador Dβ no debe depender de una solución particular βˆ de las ecuaciones normales.

Sean Ŷ e Y ∗ las proyecciones Y sobre W y W0 respectivamente y E(Y ) = µ0 bajo H0 y E(Y ) = µ bajo H1 .

kY − µ0 k2 = kY −Y ∗ +Y ∗ − µ0 k2 = kY −Y ∗ k2 + kY ∗ − µ0 k2

kY − µk2 = kY − Ŷ k2 + kŶ − µk2

∗ 2

kY −Y ∗ k2

2 = kŶ −Y k . Bajo H , se tiene n − p − 1 R2 ∼ F

y

R

0

k,n−r . La región crítica es de la

k

kY − Ŷ k2

kY − Ŷ k2

n−r 2

forma

R > C.

k

Sean S2 =

máx L

H

0

0

Se puede plantear el test de razón de verosimilitudes también: Λ = máx

L . La región crítica se escribe S > C

Este test coincide con el test F.

Se observará que

kY −Y ∗ k2 kŶ −Y ∗ k2

y

son ambos estimadores insesgados de σ2 bajo H0 .

n−s

k

73

Cuando la varianza σ2 es conocida, la razón de verosimilitudes es igual a:

máx L

1

∗ 2

Λ=

= exp − 2 kŶ − y k .

máx L

2σ

H0

La región crítica del test se escribe entonces kŶ −Y ∗ k2 > σ2 χ2k .

βˆ t Dt Γ−1 Dβˆ

∼ χ2k .

σ2

Pero este test no equivale en general al test de razón de verosimilitudes basado en kŶ −Y ∗ k2 .

Se puede construir un test a partir de Dβˆ ∼ N(Dβ, σ2 Γ) cuando ε ∼ N (0, σ2 Γ). Bajo H0 ,

3.5.5.

Caso de una hipótesis lineal general

Sea la hipótesis nula H0 : Aβ = c contra la hipótesis alternativa H1 : Aβ 6= c, en donde A ∈ Mk,p+1 es conocida

y de rango k. Aβ tiene que ser estimable, es decir no debe depender de una solución de las ecuaciones

normales. Se supondrá aquí un modelo de rango completo.

Sea βˆ = (X t X)−1 X t Y el estimador de máxima verosimilitud sin restricción y βˆ 0 el estimador bajo H0 : Aβ =

c. Se obtiene βˆ 0 usando los multiplicadores de Lagrange:

Q = (Y − Xβ)t (Y − Xβ) + 2λ(Aβ − c)

∂Q

= 0 ⇒ X t X βˆ 0 = X t Y + At Λ ⇒ βˆ 0 = (X t X)−1 (X t Y + At λ) = βˆ + (X t X)−1 At λ.

∂β

ˆ

Utilizando la restricción Aβˆ 0 = c, obtenemos que λ = [A(X t X)−1 At ]−1 (c − Aβ)

ˆ

⇒ βˆ 0 = βˆ + (X t X)−1 At [A(X t X)−1 At ]−1 (c − Aβ)

ˆ es decir tales que P0Y = X βˆ 0 y Py = X β.

ˆ

Sean P0 y P los proyectores asociados respectivamente a X βˆ 0 y X β,

Entonces

ˆ

P0Y = PY + X(X t X)−1 At [A(X t X)−1 At ]−1 (c − Aβ).

ˆ t (Y − X β)

ˆ y la varianza residual bajo

Sea la varianza residual del modelo sin restricción: V = (Y − X β)

t

H0 : T = (Y − X βˆ 0 ) (Y − X βˆ 0 ). Como T ≥ V ,consideramos U = T −V que compararemos a V .

Proposición 3.2 La diferencia de las varianzas residuales con y sin restricción es:

U = (Aβˆ − c)t [A(X t X)−1 At ]−1 (Aβˆ − c)

y bajo la hipótesis nula

Demostración:

U

∼ χ2k .

σ2

ˆ t (Y − X β)

ˆ = Y t (P − P0 )Y.

U(Y − X βˆ 0 )t (Y − X βˆ 0 ) − (Y − X β)

t [A(X t X)−1 At ]−1 (Aβ−

ˆ y U = Y t (P−P0 )t (P−P0 )Y ⇒ U = (Aβ−c)

ˆ

ˆ

Como P0Y = PY +X(X t X)−1 At [A(X t X)−1 At ]−1 (c−Aβ)

74

c).

U

Por otro lado como A es de rango igual a k, Aβˆ ∼ Nk (Aβ, σ2 A(X t X)−1 At ), luego 2 ∼ χ2k .

σ

Como βˆ es independiente de V = ∑ ε̂2i (ver ejercicio 1.7b), el estadístico del test es:

i

U/k

∼ Fk,n−p .

V /(n − p)

3.5.6.

Análisis de los residuos

Se supone que el efecto de numerosas causas no identificadas está contenido en los errores, lo que se traduce

como una perturbación aleatoria. De aquí los supuestos sobre los errores, que condicionan las propiedades

del estimador. Es importante entonces comprobar si los supuestos se cumplen.

La mejor forma de chequear si los errores son aleatorios de medias nulas, independientes y de la misma

varianza, consiste en estudiar los residuos

∀i = 1, 2, . . . , n : ε̂i = yi − ∑ βˆ j xi, j

j

considerándolos como muestra i.i.d. de una distribución normal.

Se puede usar el gráfico (Yi , ε̂i ), que debería mostrar ninguna tendencia de los puntos, o bien construir

test de hipótesis sobre los errores. En el gráfico de la izquierda ( 3.5) se puede ver los residuos aleatorios

independientes de Y, lo que no es el caso de los residuos del gráfico de la derecha.

Si el supuesto que los errores son N(0, σ2 ) no se cumple, tenemos que estudiar el efecto que esto tiene sobre

la estimación de los parámetros y sobre los tests de hipótesis, además tenemos que detectar si este supuesto

es cierto o no y corregir eventualmente la estimación de los parámetros y tests.

Vimos donde interviene el supuesto de normalidad en la estimación de los parámetros del modelo y en los

tests de hipótesis para verificar la significación de las variables en el modelo. Este tema se relaciona con el

concepto de la robustez (ver MILLER R.G. (1986), Beyond ANOVA, Basics of Applied Statistics).

La teoría de estimación y de test de hipótesis se basa en supuestos sobre la distribución de población. Por lo

tanto si estos supuestos son inexactos, la estimación o la conclusión del test sera distorsionada. Se buscan

entonces métodos que sean lo menos sensibles a la inexactitud de los supuestos. Se habla entonces de

robustez del método.

Se divide el estudio en tres partes: la normalidad, la independencia y la igualdad de las varianzas de los

errores.

75

Figura 3.5: Gráficos de residuos

Estudio de la normalidad de los errores

Si no se cumple la normalidad de los errores, los efectos sobre la estimación o tests relativos a los parámetros

son pequeños, pero son más importantes sobre los tests relativos a coeficiente de correlación. El problema

es más agudo en presencia de observaciones atípicas.

Tenemos entonces que verificar la hipótesis nula Ho : εi ∼ N(0, σ2 ) o sea si ui = εσi , Ho : ui ∼ N(0, 1). Esto

sugiere de comparar la función de distribución empírica Fn de los residuos normalizados con la función de

distribución de la N(0, 1). Sea F la función de distribución de la N(0, 1), que es invertible.

Entonces si los ui provienen de N(0, 1), F −1 (Fn (ui )) ≈ ui . Consideramos entonces los estadísticos de orden

de los ui , que son los residuos normalizados ordenados de menor a mayor: sea u(1) ≤ u(2) ≤ ... ≤ u(n) . La

función de distribución empírica es entonces:

Fn (u) =

card{u(i) ≤ u}

n

Se define los cuantiles empíricos qi = F −1 (Fn (u(i) ). Notemos que Fn (u(i) ) = Fn (ε(i) ).

Si Fn se parece a F, los puntos (ui , qi ) deberían ser colineales (sobre la primera bisectriz). Este gráfico se

llama probit o recta de Henri ( gráfico 3.6).

Si los puntos en ell gráfico probit aparecen como no lineal, se rechaza la normalidad de los errores y se

puede corregir utilizando la regresión no paramétrica basada o bien otras alternativas según la causa de la

no normalidad (no simetría, observaciones atípicas, etc..

76

Figura 3.6: Recta de Henri

Test de Durbin y Watson

Test para la igualdad de las varianzas

3.6.

Predicción.

Si se tiene una nueva observación para la cual se conocen los valores de las variables explicativas, sean

x0,1 , x0,2 , . . . , x0,p , pero se desconoce el valor Y0 de la variables respuesta, se puede entonces usar el modelo

para inferir un valor para Y0 a través de su modelo esperado:

µ0 = E(y0 ) = xt0 β

en que xt0 = (x0,1 x0,2 . . . x0,p ).

Si βˆ es el estimador de β obtenido sobre las antiguas observaciones, se estima µ0 dados los valores tomados

por las variables explicativas por:

ˆ

µ̂0 = E(y0 ) = xt0 β.

Se puede calcular un intervalo de confianza para µ0 : la distribución de ŷ0 es N(µ0 , σ2 xt0 (X t X)−1 x0 ), luego

ŷ − µ0

p t0

∼ tn−p−1 . Se usa este estadístico para construir un intervalo de confianza de nivel 1 − α

σ̃ x0 (X t X)−1 x0

para µ0 :

q

q

α/2

α/2

t

t

t

−1

t

−1

IP ŷ0 − tn−p−1 σ̃ x0 (X X) x0 ≤ µ0 ≤ ŷ0 + tn−p−1 σ̃ x0 (X x) x0 = 1 − α

Un problema distinto es de estimar un intervalo para y0 . Hablamos de un intervalo para la predicción. En

77

este caso hay que tomar en cuenta de la varianza aleatoria y0 :

y0 = ŷ0 + ε̂0 .

La varianza de ε̂0 es igual a: σ2 + σ̂2 xt0 (X t X)−1 x0 , dado que ŷ0 . Un intervalo de predicción para y0 se obtiene

y0 − ŷ0

entonces a partir de p

∼ tn−p−1

σ̂ 1 + (xt0 (X t X)−1 x0 )

El intervalo es entonces definido por:

q

q

α/2

α/2

t

t

t

−1

t

−1

IP ŷ0 − tn−p−1 σ̂ 1 + x0 (X X) x0 ≤ yo ≤ ŷ0 + tn−p−1 σ̂ 1 + x0 (X X) x0 = 1 − α.

3.7.

Caso de modelo de rango incompleto.

Vimos que en el caso de una matriz X de rango r menor que p + 1, la solución de las ecuaciones normales

no es única. se habla en este caso de modelo de rango incompleto. Construyendo una solución de las

ecuaciones normales a partir de una inversa generalizada A = (X t X)− no se obtiene necesariamente un

estimador insesgado de β. En efecto, si b es una solución de las ecuaciones normales:

(X t X)b = X t Y

entonces b = AX t Y ⇒ E(b) = AX t E(Y ) = AX t Xβ. Si H = AX t X, entonces E(b) = Hβ ⇒ Hβ 6= β en general:

b es un estimador insesgado de Hβ y no de β.

Sin embargo, Ŷ = Xb = (XAX t )Y es único, dado que XAX t no depende de la inversa generalizada A. Luego

E(Ŷ ) = E(Xb) = (XAX t )Xβ = Xβ. Los vectores Ŷ de las predicciones y ε̂ de los residuos son invariantes e

Y t (1 − XAX t )Y

insesgados y σ̂2 =

el estimador de σ2 lo es también.

n−r

Se presentan tres enfoques para estudiar estos modelos de rango incompleto

mediante un modelo reducido;

a partir de funciones estimables;

mediante restricciones identificables sobre los coeficientes del modelo.

Veremos las relaciones que existen entre estos métodos.

3.7.1.

El modelo reducido.

Sea X de rango r (< p + 1), entonces U ∈ Mr,p+1−r tal que X = (X1 |X2 ) con X1 de rango completo r

78

X2 = X1U. Entonces, si β =

β1

!

:

β2

Xβ = X1 β1 + X2 β2 = X1 (β1 +Uβ2 ) = X1 β+

El modelo se escribe entonces: Y = Xβ + ε = X1 β+ + ε, que es un modelo de rango completo sobre X1

equivalente al modelo de rango incompleto:

−1 t

t

ˆ+ ˆ

ˆ

β = β1 +U β2 = (X1 X1 ) X1Y

E(βˆ + ) = β+

Var(β+ ) = σ2 (X1t X1 )−1

3.7.2.

Funciones vectoriales estimables

Definición 3.3 Sea E = R p+1 el espacio vectorial de los parámetros β y G = Rk . Una aplicación

lineal H : E → G es estimable si existe una aplicación lineal L : IRn → G (L ∈ l(IRn , IRk )) tal que

E(LY ) = Hβ.

Cuando G = IR, se habla de función estimable.

Veamos a continuación algunas condiciones para que H sea estimable.

Teorema 3.2 Una condición necesaria y suficiente para que H : E → G sea estimable es que existe L ∈

l(IRn , IRk ) (o L ∈ Mk,n ) tal que LX = H.

Demostración: Si H es estimable ⇐⇒ ∃L ∈ l(IRn , IRk ) tal que E(LY ) = Hβ ⇐⇒ E(L(Xβ+ε)) = Hβ ⇐⇒

LX = H.

Figura 3.7: Esquema de funciones

Teorema 3.3 Una condición necesaria y suficiente para que H sea estimable es que Ker(X)⊂Ker(H).

Demostración: (⇒) Si H es estimable ⇒ ∃L ∈ l(IRn , IRk ) tq

LX = H; si Xb = 0 ⇒ Hb = 0, luego

Ker(X)⊂Ker(H).

(⇐) Si Ker(X)⊂Ker(H), luego si Xb = 0 ⇒ Hb = 0 ⇒ ∀L ∈ Mk,n : LXb = Hb = 0. Sea IR p+1 = Ker(X)⊕F,

entonces X es un isomorfismo sobre W = Im(X) = X(IR p+1 ) = X(F). Entonces a todo Y ∈ W corresponde

79

a un solo b ∈ F tal que Y = Xb. Si se toma LY = Hb, lo que define L de manera única, se tiene ∀Y ∈ W :

LY = Hb, es decir que ∀b ∈ F : LXb = Hb. Se deduce entonces que H es estimable.

Consecuencias del teorema:

Sea b una solución de las ecuaciones normales. Si H es estimable, entonces Hb no depende de la

solución particular b elegida. En efecto, b = b0 +b1 en que b0 ∈ Ker(X), b1 único. Luego b0 ∈ Ker(H)

y Hb = Hb0 + Hb1 = Hb1 que es invariante. Además LXb = Hb no depende de L. Además Hb es

insesgado para Hβ.

Si se busca un estimador insesgado de β, como se tiene q = p + 1, H es la identidad en IR p+1 y como

Ker(H) = {0} ⇒ Ker(X) = {0}. El modelo tiene que ser de rango completo.

En conclusión, en un modelo de rango completo, toda función vectorial de X es estimable.

3.7.3.

Aplicación al modelo de rango incompleto.

Sea X de rango r y X = (X1 |X2 ) en que X1 es de rango completo r y X2 = X1U. Sea β =

β1

!

la

β2

descomposición de β tal que Xβ = X1 β1 + X2 β2 . Sea β1 ∈ L1 de dimensión r y β2 ∈ L2 de dimensión

p + 1 − r. Entonces β+ = β1 +Uβ2 ∈ L1 .

Figura 3.8:

Teorema 3.4 Una condición necesaria y suficiente para que H ∈ l(IR p+1 , IRk ) sea estimable es que H2 =

H1U, en donde H1 y H2 son las restricciones de H a L1 y L2 .

Demostración:

Si H es estimable, existe L tal que LX = H y además LX1 = H1 y LX2 = H2 .

LXβ = L(X1 β1 + X2 β2 ) = LX1 β1 + LX2 β2 = H1 β1 + H2 β2 . Pero LX2 = LX1U, por lo tanto H2 = H1U.

Recíprocamente, si H2 = H1U, mostramos que se puede construir L tal que LX = H.

Observemos que basta construir L, sobre Im(X). Además X1 es de rango completo, luego ∀Y ∈ Im(X) ∃!b1 ∈

L1

tq Y = X1 b1 . Existe L tal que LY = LX1 b1 . Entonces H2 = LX1U = LX2 .

80

Figura 3.9:

Finalmente ∀β ∈ IR p+1 : LXβ = L(X1 β1 + X2 β2 ) = H1 β1 + H2 β2 = Hβ. Luego H es estimable.

Consecuencias: el teorema de Gauss-Markov, que vimos para el caso de modelo de rango completo, puede

aplicarse al caso de un modelo de rango incompleto para estimadores de funciones estimables:

Teorema 3.5 Si H es una función vectorial estimable, el único estimador lineal insesgado de mínima

varianza de Hβ es H βˆ en donde βˆ es cualquiera solución de las ecuaciones normales.

Demostración:

Hβ = H1 β1 + H2 β2 = H1 β+

H βˆ = H1 βˆ +

ˆ = Var(H1 βˆ + ) = σ2 H1 (X t X1 )−1 H t

Var(H β)

1

1

que no depende de la partición X en X1 y X2 .

3.7.4.

Estudio imponiendo restricciones.

ˆ Se

Si el rango de X es igual a r < p + 1, se tiene p + 1 − r grados de indeterminación en la elección de β.

ˆ de

puede levantar esta indeterminación imponiendo p + 1 − r restricciones lineales independientes sobre β,

manera que conociendo Ŷ , se obtenga un único estimador β∗ de β tal que Ŷ = Xβ∗ .

Las restricciones son de la forma

Kβ∗ = 0

con K ∈ M p+1−r,p+1 , K es de rango s = p + 1 − r.

Se tiene entonces que estimar β con β∗ tal que

Ŷ = Xβ∗ con la restricción Kβ∗ = 0.

(1)

Veamos que esta condición nos asegura de obtener la unicidad con cualquier K de rango s.

81

Teorema 3.6 Considerando K1 y K2 las restricciones de K a L1 y L2 , la condición necesaria y suficiente

para que (1) tenga una solución única es que K2 − K1U sea invertible.

Demostración: La ecuación (1) puede escribirse usando la partición X = (X1 , X2 );

(

βˆ + = βˆ 1 +U βˆ 2 = (X1t X1 )−1 X1t Y

K1 βˆ 1 + K2 βˆ 2 = 0

(

βˆ 1 = βˆ + −U βˆ 2

(K2 − K1U)βˆ 2 = −K1 βˆ +

(2)

este sistema de ecuaciones (2) tiene una solución única si y solo si K2 − K1U es invertible.

Notas:

K no puede ser estimable en este caso. Si lo fuera K2 = K1U y βˆ 2 no es único.

Si H es estimable, Hβ∗ no depende del estimador β∗ solución de las ecuaciones normales por lo tanto

de las restricciones elegidas.

Dos maneras de encontrar la solución de (2):

Como Kb = 0, se puede escribir las ecuaciones normales de la forma:

(X t X + MK)βK = X t Y

en donde M es una matriz tal que X t X + MK invertible. El problema es de encontrar esta matriz M.

La otra manera , más operativa, consiste en construir el modelo aumentado:

"

Si la matriz aumentada A =

XtX

Kt

K

0

XtX

Kt

K

0

#

β

0

!

=

X tY

0

!

.

!

es invertible, su inversa se escribe: A−1 =

C Pt

P

Q

!

,

entonces β∗ = CX t Y .

3.8.

Intervalos y regiones de confianza.

Vimos que los test de hipótesis sobre los parámetros individualmente no son adecuados en general. Por

la misma razón, no se construye en general intervalo de confianza para cada parámetro por separado. Se

propone construir regiones de confianza o intervalos simultáneos de confianza.

82

3.8.1.

Regiones de confianza.

Vemos aquí intervalos o regiones de confianza para parámetros individualmente o para funciones de los

parámetros.

Para cada parámetro β j del modelo lineal, se puede construir un intervalos de confianza utilizado:

βˆ j − β j

∼ tn−r

σ̂ j

−1

2

t

en donde σ̂2j es la estimación de Var(βˆ j ) = σ2 (X t X)−1

j, j ; es decir σ̂ j (X X) j, j . El intervalo de confianza de

nivel de confianza igual a 1 − α es:

h

i

α/2

α/2

βˆ j − t σ̂ j , βˆ j + t σ̂ j

n−r

n−r

at βˆ − at β

Para una combinación lineal del vector β : q

∼ tn−r , luego el intervalo de confianza es:

σ̂ at (X t X)−1 a

q

q

α/2

α/2

at βˆ − tn−r σ̂ at (X t X)−1 a, at βˆ + tn−r σ̂ at (X t X)−1 a

Para un vector Aβ ∈ IRk con A ∈ Mk,p+1 , sabemos de 2.5.5 que

ˆ t At [A(X t X)−1 At ]−1 A(β − β)

ˆ ∼ σ2 χ2

(β − β)

k

y

1

ε̂2 ∼ χ2n−r

2∑ i

σ i

son independientes.

Luego

ˆ t At [A(X t X)−1 At ]−1 A(β − β)

ˆ ≤

(β − β)

define una región de confianza elipsoidal para Aβ.

1

0

0

k 2 α

σ̂ Fk,n−r

n−r

0

Ejemplo 3.7 Sean p = 3, n = 18, (X t X)−1 = 1n 0 2 −1 , 2σ̂2 = n y βˆ = 2 .

0 −1 2

1

Las varianzas de β1 y β2 son: σ̂21 = 1 y σ̂22 = 1. Los intervalos de confianza individuales con 1 − α = 0, 95

para β1 y β2 son: β1 ∈ [−0, 13; 4, 13] y β2 ∈ [−1, 13; 3, 13].

ˆ = 3 ⇒ β1 − β2 ∈ [−2, 691; 4, 691].

El intervalo para β1 − β2 : at = ( 0 1 −1 ); Var(at β)

ˆ = 1 ⇒ β1 + β2 ∈ [0, 891; 5, 131].

El intervalo para β1 + β2 : at = ( 0 1 −1 ); Var(at β)

83

En la figura3.10a se representó los dos intervalos de confianza individuales para β1 y β2 y en la figura3.10b,

las regiones de confianza para β1 − β2 y β1 + β2 .

(b) Intervalo para β1 − β2 y β1 + β2

Figura 3.10: (a) Intervalo para β1 y β2

3.8.2.

Intervalos simultáneos de confianza.

Vimos que par un vector Aβ ∈ IRk con A ∈ Mk,p+1 , la región de confianza elipsoidal es tal que

ˆ ≤

ˆ t At [A(X t X)−1 At ]−1 A(β − β)

IP((β − β)

k 2 α

σ̂ Fk,n−r ) = 1 − α.

n−r

Ahora bien, si representamos esta región, por ejemplo, con los k intervalos asociados a los atj β, j = 1, 2, . . . k

es donde atj es la fila j de A, tomando la intersección de los k intervalos:

"

atj βˆ −

r

k

ˆ at βˆ +

σ̂F α Var(atj β),

j

n − r n−r

r

#

k

ˆ

σ̂F α Var(atj β)

n − r n−r

obtenemos una región más amplia que la definida por el elipsoide. En efecto:

t 2

(u b)

= bt C−1 b.

Proposición 3.3 Si C es invertible, entonces sup

t Cu

u

u6=0

Demostración:

ht v 2

(ht v)2

kv − αhk = α khk − 2αh v + kvk = αkhk −

+ kvk2 −

≥ 0.

khk

khk2

2

2

2

t

2

84

Para h 6= 0 ⇒ kvk2 khk2 ≥ (ht v)2 . Luego

h = C−1/2 b obtenemos

t 2

(ht v)2

2 ⇐⇒ sup (h v) = khk2 . Tomando v = C 1/2 u y

≤

khk

2

kvk2

v6=0 kvk

(bt u)2

≤ bt C−1 b.

ut Cu

Aplicando este resultado a la región de confianza de Aβ:

ˆ t At [A(X t X)−1 At ]−1 A(β − β)

ˆ ≤

IP (β − β)

k 2 α

σ̂ Fk,n−r

n−r

= 1 − α.

k σ̂2 F α , obtenemos

y tomando γ = Aβ, C = [A(X t X)−1 At ] y q = n −

k,n−r

r

(ut (γ̂ − γ)2 )

IP((γ̂ − γ)t C−1 (γ̂ − γ) ≤ q) = 1 − α ⇒ IP ∀u 6= 0 :

≤

q

= 1 − α.

ut Cu

Ahora bien, cuando se quiere un intervalo para Aβ, es equivalente a pedir k intervalos I j al mismo tiempo

para los atj β, j = 1, 2, . . . , k en donde atj es la fila j de A. De lo anterior deducimos que el elipsoide obtenido

para Aβ es más que lo que pedimos que es para ∩ j I j :

IP(∩I j ) ≥ 1 − α.

Para A = I, Scheffé propone proyectar el elipsoide asociado a β sobre los ejes de coordenadas. En general

puede ser demasiado pesimista dado que

IP(∪I j ) ≥ 1 − α.

Bonferroni propone simplemente que cada I j sea tal que IP(I j ) = 1 − α

k ( j = 1, 2, . . . , k). Aquí también se

tiene que IP(∪I j ) ≥ 1 − α. En efecto

IP(∪I j ) = 1 − IP ∪I j = 1 − IP ∩I j ≥ 1 − ∑ IP I j = 1 − ∑ α j = 1 − α.

j

3.9.

j

Ejercicios.

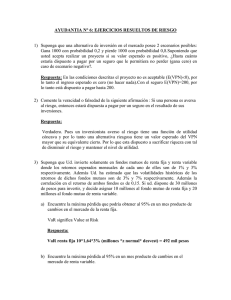

1. Cuatro médicos estudian los factores que explican porque hacen esperar a sus pacientes en la consulta.

Toman una muestra de 200 pacientes y consideran el tiempo de espera de cada uno el día de la

consulta, la suma de los atrasos de los médicos a la consulta este mismo día, el atraso del paciente a la

consulta este día (todos estos tiempos en minutos) y el números de médicos que están al mismo tiempo

es la consulta este día. Se encuentra un tiempo promedio de espera de 32 minutos con una desviación

típica de 15 minutos. Se estudia el tiempo de espera en función de las otras variables mediante un

modelo lineal cuyos resultados están dados a continuación:

85

Variable

Coeficiente Desv. típica

Constante

22,00

4,42

Atraso médico

0,09

0,01

Atraso paciente

-0,02

0,05

Número de médicos

-1,61

0,82

Coef. determinación=0,72 F de Fisher=168

t-Student IP(|X| > t)

4,98

0,00

9,00

0,00

0,40

0,66

1,96

0,05

IP(X > F) = 0, 000

Cuadro 3.1: Resultados de la regresión

a) Interprete los resultados del modelo lineal. Comente su validez global y la influencia de cada

variable sobre el tiempo de espera. Especifique los grados de libertad de las t de Student y la F

de Fisher.

b) Muestre que se puede calcular la F de Fisher a partir del coeficiente de determinación. Si se

introduce una variable explicativa suplementaria en el modelo, el coeficiente de determinación

sará más elevado?

c) Dé un intervalo de confianza a 95

d) Predecir el tiempo de espera, con un intervalo de confianza a 95que llega a la hora un día que el

consultorio funciona con 4 médicos que tienen respectivamente 10, 30, 0, 60 minutos de atraso.

2. Suponga que tenemos un modelo lineal Y = Xβ + ε con ε ∼ Nn (0, σ2 In ), βεIR p+1 , XεMn,p+1 (IR).

a) Escribamos X como: X = (X1 , X2 ), con X1 y X2 submatrices de X tales que X1t X2 = 0!(la matriz

β1

nula). El modelo inicial Y = Xβ + ε se escribe Y = X1 β1 + X2 β2 + ε con β =

. Si α̂1 es

β2

el estimador de máxima verosimilitud de α1 !

en el modelo Y = X1 α1 + ε y α̂2 es el estimador de

α̂1

máxima verosimilitud de β es igual a

.

α̂2

(Indicación:" se usará el siguiente

resultado: si A ∈ Mn,n (IR) es una matriz diagonal por bloque,

#

−1

A1

0

i.e. A−1 =

, con las submatrices A1 y A2 invertibles , entonces A es invertible, y

0 A−1

2

"

#

A

0

1

A−1 =

).

0 A2

!

α̂

1

como estimador de β, que propiedad pierde βˆ bajjo el

b) Si X1t X2 6= 0 y si se toma βˆ =

α̂2

supuesto usual E(ε) = 0.

3. Consideremos tres variables Y , X, Z observadas sobre una muestra de tamaño n = 40, {(yi , xi , zi ) tq

1, . . . , 40}. Se busca explicar Y linealmente a partir de X y Z.

86

i=

Variable Medias Desv. típica

Y

11,68

3,46

X

5,854

2,74

Constante Estimación Dev. típica estimación t-Student IP(|X| > t)

α

7,06

1,03

6,84

0,00

β

0,79

0,16

4,94

0,00

Coef. determinación=0,39

F de Fisher=24,44

IP(X > F) = 0, 000

Cuadro 3.2: Resultados de la regresión

a) Se representan los resultados de modelo lineal: yi = α + βxi + εi , i = 1, . . . , 40: Interprete estos

resultados y efectúe el test de hipótesis H0 : β = 0.

b) Dé una estimación insesgada para σ2 la varianza de los errores de este modelo.

c) Comente el gráfico de los residuos en función de los yi .

d) Se tiene una nueva observación que toma sobre la variable X el valor x0 = 6, 50. Dé una estimación ŷ0 del valor y0 que toma sobre la variable Y .

e) Se presentan los resultados del modelo lineal: yi = δ + γzi + εi :

Variable Medias Desv. típica

Y

11,68

3,46

Z

0,00

2,65

Constante Estimación Dev. típica estimación t-Student IP(|X| > t)

δ

11,68

0,36

32,54

0,00

γ

1,00

0,14

7,27

0,00

Coef. determinación=0,58

F de Fisher=52,78

IP(X > F) = 0, 000

Cuadro 3.3: Resultados de la regresión

Se tiene ∑ xi zi = 0 y ∑ zi = 0.

i

i

Muestre que si X1 = (1n |X) es una matriz formada del vector de unos y del vector de los xi y

X2 Z el vector formado de los zi , se tiene X1t X2 = 0. Usando los resultados del ejercicio 2 deduzca

las estimaciones de los parámetros del modelo yi = β0 + β1 X + β2 Z + ε.

4. Se requiere ajustar una función escalón y = f (t) con f constante en los intervalos en que j = 0, . . . , K

y a0 < a1 < . . . < aK . Para ello se observan datos {(ti , yi ) i = 1, . . . , n}. Se asume que los yi son

mutuamente independientes y que la distribución de los yi es N( f (ti ), σ2 ).

a) Formule el problema anterior como modelo lineal.

b) Obtenga la función ajustada por mínimos cuadrados.

87

Z aK

f (t)dt.

c) Concluya un intervalo de confianza para

a0

5. Sea Y ∈ IRn un vector aleatorio con E(Y ) = µ y Var(Y ) = σ2 In . Se considera el modelo lineal Y =

Xβ + ε, en que X ∈ Mn,p es de rango completo. Llamaremos W al subespacio de IRn conjunto imagen

de X e Ŷ al estimador de mínimos cuadrados de µ = E(Y ).

a) Sea a ∈ W y ∆a la recta generada por a. Se define H0 = {z ∈ W

tq

at z = 0} el suplemento

ortogonal de ∆a en W . Se tiene entonces la descomposición en suma directa ortogonal de W :

W = Ha ⊕∆a . Muestre

que el estimador de mínimos cuadrados Y ∗ de µ en Ha se escribe como:

t

Y ∗ = Ŷ − a tŶ a.

aa

b) Si b ∈ IRn , muestre que Var(bt Y ∗ ) = Var(bt Ŷ ) − σ2

(bt b)2

.

at a

∑ ε∗2

i

c) Suponiendo que los errores son normales, dé la distribución de

i

σ2

, en que ε∗i = Yi −Yi∗ .

∑ Yi∗2 /p

d) Se considera el caso particular a = In . Dé la distribbución de

i

∑ ε∗2

i /(n − p)

. Muestre que si las

i

variables son centradas, Ŷ = Y ∗ .

6. Teorema de Gauss-Markov generalizado.

Si Var(Y ) = Γ, Γ invertible, entonces el estimador βˆ insesgado de mínima varianza entre los estimadores lineales insesgados de β es aquel que minimiza kY − Xβk2Γ−1 .

a) Encuentre el estimador de máxima verosimilitud de β y Γ.

b) Demuestre el teorema.

88

c) Si el rango de X es igual a r, muestre que la norma del vector de residuos de un modelo lineal

kY − Ŷ k2Γ−1 ∼ χ2n−r

en donde Ŷ la proyección Γ−1 -ortogonal de Y sobre Im(X).

7. Sea el modelo lineal: yi = β0 + β1 xi,1 + · · · + β p xi,p + εi , i = 1, 2, . . . , n. Matricialmente Y = Xβ + ε,

con rango(X) = p + 1, E(ε) = 0, Var(ε)σ2 In .

#

"

t

n

a

. Dé las expresiones de a y V . Muestre que V es definida positiva.

a) Se escribe X t X =

a V

n

!

Muestre que a es un vector nulo cuando las variables explicativas están centradas ∀ j : ∑ xi, j = 0 .

i=1

Relacione los valores propios de V con los de V −1 .

b) Muestre que

ˆ sujeto a ∀ j :

∑ Var(β)

j

n

n

∑ xi, j = 0 y ∀ j :

i=1

∑ xi,2 j = c (c es una constante positiva)

i=1

alcanza su mínimo cuando X t X es diagonal.

c) En qué difieren de las propiedades optimales obtenidas en el teorema de Gauss-Markov?

n

n

d) Se supone que X t X es diagonal con ∀ j : ∑ xi, j = 0 y ∀ j : ∑ xi,2 j = c. Deducir las expresiones de

i=1

i=1

ˆ Var(β),

ˆ Ŷ . Exprese el coeficiente de correlación múltiple R2 en función de los coeficientes de

β,

correlación lineal de Y con las variables explicativas X.

8. Sea el modelo lineal Y = Xβ + ε, con X de rango completo pero X t X no diagonal.

a) Dé la expresión de una predicción de la variable respuesta Y y un intervalo de confianza asociado.

b) Se hace un cambio de base de las columnas de X, sea Z la matriz de las nuevas columnas,

de manera que Im(X) = Im(Z) y que Z t Z sea diagonal. Muestre que el cambio de variables

explicativas no cambia las predicciones de Y . Deduzca la expresión del intervalo de confianza

en función de Z.

9. Concluye el test de razón de verosimilitudes para la hipótesis nula H0 : Aβ = c para los supuestos

usuales. Muestre que es equivalente al test F de Fisher dado en 2.5.5.

10. Sea el modelo lineal Y = Xβ + ε con ε ∼ Nn (0, σ2 In ), X ∈ Mnp de rango incompleto. Sea Aβ una

función vectorial estimable de β, con A ∈ Msp de rango completo s. Muestre que A(X t X)− At es

invertible.

89

Anuncio

Descargar

Anuncio

Añadir este documento a la recogida (s)

Puede agregar este documento a su colección de estudio (s)

Iniciar sesión Disponible sólo para usuarios autorizadosAñadir a este documento guardado

Puede agregar este documento a su lista guardada

Iniciar sesión Disponible sólo para usuarios autorizados