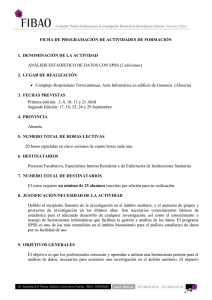

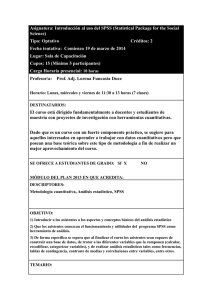

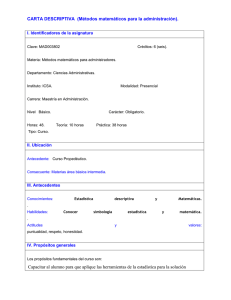

Apuntes de la asignatura

Anuncio