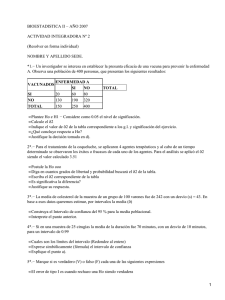

Para obtener el tema 1 en formato WORD pulsar aqui

Anuncio