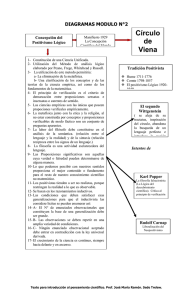

la filosofía de la ciencia hoy. problemas y posiciones

Anuncio