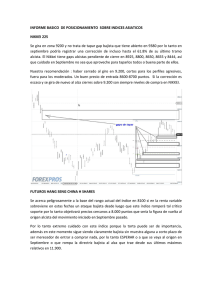

Sistemas de representación de mapas de posicionamiento

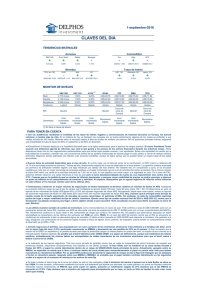

Anuncio