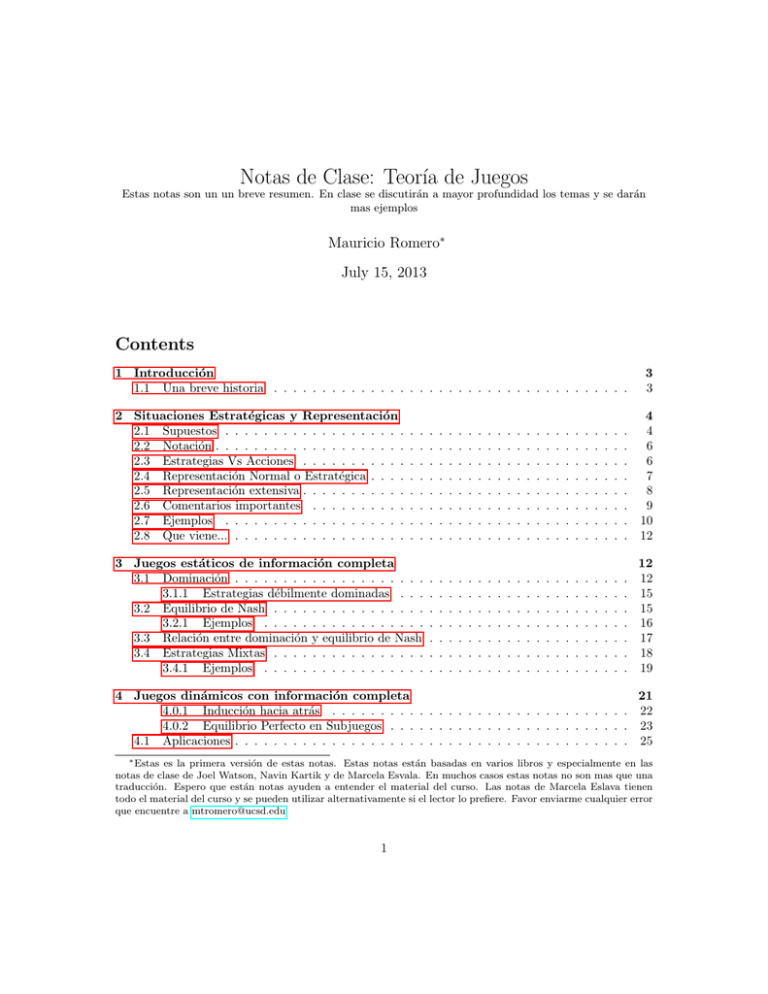

Notas de clase. Versión 15/07/2013

Anuncio