TEMA 3 : ESTIMACIÓN DEL MODELO

Anuncio

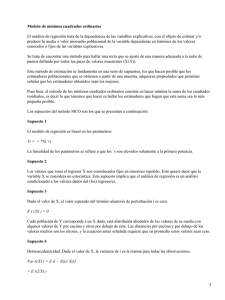

Introducción a la Econometría Tema 3: ESTIMACIÓN DEL MODELO Tema 3: ESTIMACIÓN DEL MODELO 3.1 Estimación mínimo-cuadrática. Sea el modelo de regresión lineal simple: Yi = β1 + β2 Xi + ui = E[Yi / Xi ] + ui i = 1, ... , N (3.1) Si representamos por b1 y b2 los estimadores (y, también, las estimaciones) de los parámetros β1 y β2 del modelo, entonces podríamos expresar los valores estimados de los elementos muestrales de la variable endógena como: Ŷi = b1 + b 2 X i i = 1, ... , N Llamamos residuos, que representaremos por ei , a las diferencias entre los valores observados de la variable endógena y los valores estimados: ei = Yi - Ŷi = Yi - ( b1 + b2 Xi ) = Yi - b1 - b2 Xi Podemos, entonces, escribir: Yi = β1 + β2 Xi + ui = b1 + b2 Xi + ei i = 1, ... , N Nuestro objetivo al estimar los parámetros β1 y β2 será obtener una estimación tal, que la estructura estimada “b1 + b2Xi” se aproxime lo más cerca posible a la estructura desconocida del modelo “β1 + β2Xi” como se indica en la figura : Yi b1 + b2 Xi(estimada) Yi ei β1 + β2 Xi(desconocida) ui Xi Xi Los estimadores b1 y b2 serán funciones de los valores muestrales Xi e Yi que obtendremos por los procedimientos que nos ofrece la Inferencia Estadística. El primer método que vamos a utilizar es el de los mínimos cuadrados. 23 Departamento de Estadística e Investigación Operativa II (Métodos de Decisión) El método de los mínimos cuadrados ordinarios (M.C.O. a partir de ahora), consiste en obtener las expresiones muestrales de los estimadores b1 y b2 que hagan mínima la suma de N los cuadrados de los residuos: ∑e 2 i . i =1 Expresando dicha suma en función de los estimadores b1 y b2, quedará: S(b1 , b2) = N N i =1 i =1 ∑ ei2 = ∑ (Yi - b1 - b 2Xi ) 2 Los estimadores M.C.O. serán, por tanto, las soluciones del siguiente problema de optimización: N Mínimo S(b1, b2) = Mínimo ∑ (Y - b i 1 - b 2 X i ) , según los posibles valores de b1 y b2. 2 i =1 Para obtener las soluciones que hagan mínimo S(b1 , b2 ) aplicaremos la condición necesaria o de primer orden : ∂ ∂ ∂ ∂ N S ⎫ ⎫ = 0⎪ - 2 ∑ (Yi - b1 - b 2 X i ) = 0 ⎪ b1 ⎪ ⎪ i =1 ⎬⇒ ⎬ N S = 0⎪ - 2 ∑ (Yi - b1 - b 2 X i ) ⋅ X i = 0⎪ ⎪⎭ b2 i =1 ⎭⎪ N ∑e i = 0 i=1 Es decir, los estimadores de M.C.O. cumplirán que: N ∑ ei ⋅ xi = 0 (3.2) i=1 Para despejar b1 y b2 lo expresaremos de esta otra forma: ⎫ ⎪⎪ i =1 i =1 ⎬ N N N 2⎪ Y ⋅ X = b ⋅ X + b ⋅ X ∑ i i 1 ∑ i 2 ∑ i ⎪⎭ i =1 i =1 i =1 N N ∑ Yi = N ⋅ b1 + b2 ⋅ ∑ Xi Sistema que recibe el nombre de: Sistema de ecuaciones normales de M.C.O. Dividiendo entre N en los dos miembros de cada una de las dos ecuaciones, nos queda: ⎫ ⎬ a11 = b1 ⋅ X + b 2 ⋅ a 20 ⎭ Y = b1 + b 2 ⋅ X 24 Introducción a la Econometría Tema 3: ESTIMACIÓN DEL MODELO Ahora, multiplicando por X los dos miembros de la primera ecuación y restando ésta de la segunda, obtenemos: SXY (3.3) a11 - X ⋅ Y = 0 + b 2 ⋅ a 20 - X 2 ⇒ SXY = b 2 ⋅ S2X y, por tanto, b 2 = S2X ( ) Sustituyendo este último resultado en la primera ecuación y despejando b1: b1 = Y - SXY ⋅ X (3.4) S2X Siendo las expresiones recuadradas las de los estimadores M.C.O. de los parámetros β1 y β2 del modelo de regresión lineal simple. Se puede comprobar que la solución obtenida para b1 y b2 a partir de la condición necesaria verifica, también, la condición suficiente de mínimo de S(b1 , b2 ) . Las expresiones de las segundas derivadas de S serán: ∂2S = 2N ∂ b12 N ∂2S = 2 X i2 ⋅ ∑ 2 ∂ b2 i =1 N ∂2 S = 2 ⋅ ∑ Xi ∂ b1 ∂ b 2 i =1 La matriz hessiana, que en este caso no depende ni de b1 ni de b2, quedará: ⎛ 2N H = ⎜⎜ ⎝ 2 ⋅ ∑ Xi 2N > 0 2 ⋅ ∑ Xi ⎞ ⎧ ⎟ resultando que ⎨ 2 2 2⎟ 2 ⋅ ∑ Xi ⎠ ⎩ H = 4 N ⋅ SX > 0 Y, por tanto, la matriz hessiana resulta ser definida positiva y la solución obtenida corresponde a un mínimo. 3.2 Propiedades de los estimadores. Recordemos que el modelo (3.1) se ha definido con las siguientes hipótesis: E[ui] = 0 V[ui] = E[ui]2 = σ2 Cov[ui,uj] = E[ui.uj] = 0 ∀ i ≠ j Se puede demostrar que los estimadores M.C.O.: S xy S β$2 = b2 = 2 β$1 = b1 = Y − xy2 .X Sx Sx tienen las siguientes propiedades: 25 Departamento de Estadística e Investigación Operativa II (Métodos de Decisión) I. Los estimadores M.C.O. son lineales. Cada uno de los estimadores se puede expresar como combinación lineal de las observaciones muestrales aleatorias de variable endógena Yi . Se demuestra que (ver Apéndice A3.1): X -X ⎞ ⎛1 b 2 = ∑ k i Yi (3.5) siendo k i = i 2 b1 = ∑ d i Yi (3.6) siendo d i = ⎜ − Xk i ⎟ NSx ⎠ ⎝N cumpliéndose que (ver Apéndice A3.1): ∑k i =0 ∑k X i i =1 ∑d sustituyendo en (3.5) y (3.6) i =1 ∑d X i i =0 ∑k Yi por β1 + β 2 X i + u i 2 i = 1 NS 2x ∑d 2 i = a 20 NS 2x nos queda: b 2 = ∑ k i ( β1 + β 2 X i + u i ) = β1 ∑ k i + β 2 ∑ k i X i + ∑ k i u i = β 2 + ∑ k i u i ⇒ ⇒ b 2 − β 2 = ∑ k i u i (3.7) (=0) (=1) b1 = ∑ d i ( β1 + β 2 X i + u i ) = β1 ∑ d i + β 2 ∑ d i X i + ∑ d i u i = β1 + ∑ d i u i ⇒ ⇒ b1 − β 1 = ∑ d i u i (3.8) (=1) (=0) II. Los estimadores M.C.O. son insesgados o centrados. Tomando esperanzas en (3.7) y (3.8) nos queda: E[ b 2 − β 2 ] = E[ ∑ k i u i ] = ∑ k i E[ u i ] = 0 , ya que E[ u i ] = 0 ∀i, ⇒ E[ b 2 ] = β 2 (3.9) E[ b1 − β 1 ] = E[ ∑ d i u i ] = ∑ d i E[ u i ] = 0 , ya que E[ u i ] = 0 ∀i, ⇒ E[ b1 ] = β 1 (3.10) III. Expresiones de las varianzas y la covarianza de los estimadores. Se demuestra (ver Apéndice A3.2) que las varianzas y covarianza de los estimadores tienen como expresiones: V[ b 2 ] = σ 2 1 (3.11) NS 2x V[ b 1 ] = σ 2 a 20 (3.12) NS 2x Cov(b1 , b 2 ) = σ 2 . -X (3.13) NS2x Observándose que su valor depende de los datos Xi y del valor desconocido de σ2 y, por tanto, deberán estimarse a partir de la estimación del parámetro σ2. 26 Introducción a la Econometría Tema 3: ESTIMACIÓN DEL MODELO Se deduce de (3.13) que la covarianza entre los estimadores b1 y b2 tendrá signo contrario al que tenga la media aritmética de los valores Xi . La matriz de varianzas-covarianzas de los estimadores M.C.O. quedará: ⎛ 2 a 20 X ⎞ ⎜ σ ⎟ −σ 2 2 NS x NS 2x ⎟ σ 2 ⎛ a 20 − X ⎞ ⎜ ⎟ ⎜ COV(b1 , b 2 ) = = ⎜ X 1 ⎟ NS 2x ⎜⎝ − X 1 ⎟⎠ 2 2 σ ⎜−σ ⎟ NS 2x NS 2x ⎠ ⎝ IV. Los estimadores M.C.O. son consistentes. Recordemos que una condición suficiente para que un estimadorθ$ del parámetro θ consistente es que: sea ⎧⎪ lim E( θ$) = θ (insesgado asintóticamente) ⎨ N →∞ V( θ$) = 0 (la varianza tiende a cero) ⎪⎩ Nlim →∞ En nuestro caso ambos estimadores son insesgados: E[ b1 ] = β 1 y E[ b 2 ] = β 2 Y además, si S 2x , y por tanto a 20 , toma un valor finito distinto del cero cuando N tienda a infinito, se puede comprobar fácilmente que: lim V(b1 ) = lim σ 2 N →∞ N →∞ a 20 =0 NS 2x y lim V(b 2 ) = lim σ 2 N →∞ N →∞ 1 NS 2x =0 Luego, bajo la condición de que S 2x tome un valor finito y positivo cuando N → ∞ , podemos afirmar que los estimadores M.C.O. son consistentes. V. Teorema de Gauss-Markov. Los estimadores M.C.O. tienen la mínima varianza entre los estimadores lineales e insesgados. O se puede decir también que los estimadores M.C.O. son los eficientes entre todos los estimadores lineales. S xy X -X Consideremos el estimador M.C.O. de β2: b 2 = 2 = ∑ k i Yi siendo k i = i 2 NS x Sx * Sea β 2 un estimador lineal cualquiera, de tal forma que: ⎧ w =0 , como puede β 2* = ∑ w i Yi , para que β 2* sea insesgado se tendrá que cumplir : ⎨ ∑ i ⎩∑ w i X i = 1 comprobarse. Se demuestra (ver Apéndice A3.3) que la varianza de este estimador lineal es igual a: 27 Departamento de Estadística e Investigación Operativa II (Métodos de Decisión) 1 + σ 2 ∑ (w i − k i ) 2 NS 2x V( β *2 ) = σ 2 Si w i = k i ⇒ V( β 2* ) = V(b 2 ) , cumpliéndose cuando β 2* = b 2 . Y si w i ≠ k i ⇒ V( β 2* ) > V(b 2 ) Luego la varianza del estimador M.C.O. es siempre menor que la de cualquier otro estimador lineal e insesgado. 3.3 Los residuos: relaciones más importantes. Consideremos el modelo (3.1) en el que los parámetros β1 y β2 se han estimado por M.C.O. dando lugar a las expresiones (3.4) y (3.3) de los estimadores respectivos. El modelo estimado lo podremos expresar como: Yi = b1 + b 2 X i + e i = Ŷi + e i (3.14) ⎧ N ⎪⎪ ∑ e i = 0 Donde los residuos verifican las condiciones (3.2) : ⎨ N i =1 ⎪∑ e i ⋅ X i = 0 ⎩⎪ i =1 1) La suma de los valores observados es igual a la suma de los valores estimados. A partir de (3.14): Yi = Ŷi + e i ∀ i = 1, ... ,N sumando: y como ∑e i = 0 , se obtiene que: N i =1 i =1 i =1 ∑ Y = ∑ Ŷ i i i =1 i =1 i =1 N ∑ Yi = ∑ Ŷi + ∑ e i N N N N Y dividiendo entre N, se deduce que: Y = Ŷ (3.15) La media aritmética de los valores estimados es la misma que la media aritmética de los valores observados. 2) Suma de cuadrados. pero N N N i =1 i =1 i =1 i =1 N N N N i =1 i =1 i =1 i =1 ∑ e i ⋅ Ŷi = ∑ e i ⋅ (b1 + b 2 ⋅ X i ) = b1 ⋅ ∑ e i + b 2 ⋅ ∑ e i ⋅ X i = 0 (= 0) 28 N ∑ Yi2 = ∑ Ŷi2 + ∑ e i2 + 2 ⋅ ∑ e i ⋅ Ŷi En (3.14) elevando al cuadrado y sumando: (= 0) Introducción a la Econometría Tema 3: ESTIMACIÓN DEL MODELO N N N i =1 i =1 i =1 ∑ Yi2 = ∑ Ŷi2 + ∑ e i2 (3.16) Y, por tanto, N ∑e 3) Cálculo de 2 i N i =1 N N N N i =1 i =1 i =1 i =1 i =1 ∑ e i2 = ∑ (Yi - b1 - b 2 ⋅ X i ) ⋅ e i = ∑ Yi ⋅ e i - b1 ⋅ ∑ e i - b 2 ⋅ ∑ X i ⋅ e i = N N i =1 i =1 = ∑ Yi ⋅ e i = ∑ Yi ⋅ (Yi - b1 - b 2 ⋅ X i ) N ∑e Quedando: N N N i =1 i =1 i =1 = ∑ Yi2 - b1 ⋅ ∑ Yi - b 2 ⋅ ∑ X i ⋅ Yi (3.17) 2 i i =1 3.4 Descomposición de la varianza: el coeficiente de determinación. ( ) ( Partimos de la igualdad: Yi - Y = Yi - Ŷi + Ŷi - Y ) elevando al cuadrado y sumando: ∑ (Y - Y ) = ∑ (Y - Ŷ ) + ∑ (Ŷ - Y ) N N 2 i i i =1 N 2 i i i =1 i =1 ∑ (Y - Ŷ )⋅ (Ŷ - Y ) = ∑ e ⋅ (b N N pero i i 2 i i 1 N ( )( + 2 ⋅ ∑ Yi - Ŷi ⋅ Ŷi - Y ) i =1 + b2 ⋅ Xi - Y) = i =1 i =1 N N N = b1 ⋅ ∑ e i + b 2 ⋅ ∑ e i ⋅ X i - Y ⋅ ∑ e i = 0 i =1 i =1 obteniéndose que: i =1 ∑ (Y - Y ) N N ( N = ∑ e i + ∑ Ŷi - Y 2 i 2 2 i =1 i =1 i =1 ) que dividiendo entre N en los dos miembros de la igualdad nos queda: ∑ (Y - Y ) N N ∑ ei 2 i i =1 N = i =1 N ∑ (Ŷ - Y ) N 2 2 i + i =1 N (3.18) Donde: ∑ (Y - Y ) N 2 i i =1 N = S 2y es la varianza total o marginal de las Yi . 29 Departamento de Estadística e Investigación Operativa II (Métodos de Decisión) N ∑e 2 i = S2ey es la varianza de los residuos ( e = 0 ) o varianza residual . i=1 N ∑ (Ŷ - Y ) N 2 i i =1 N = S 2Ry es la varianza de los valores estimados por el modelo de regresión lineal ( ) Ŷi Ŷ = Y , que se denomina varianza debida a la regresión o varianza explicada por la regresión. Por tanto, la igualdad (3.18) se puede expresar también: S2y = S2ey + S2Ry (3.19) Gráficamente y de forma simbólica: Yi Ŷi = b1 + b2 Xi Yi S 2ey S2y S 2Ry Y Y Xi Xi El coeficiente de determinación: R2 Se define como el porcentaje que, de la varianza total ( S 2y ), supone la varianza explicada por la regresión ( S 2Ry ). Dividiendo entre S en (3.19) se llega a 1 = 2 y R = 2 30 S 2Ry S 2y S 2Ry S 2 y + =1- 2 S ey S 2 S ey S 2y 2 y y R2 se obtendrá como: (3.20) Introducción a la Econometría Tema 3: ESTIMACIÓN DEL MODELO Indicando la proporción de la varianza de las observaciones de la variable endógena que es explicada por el modelo de regresión. Es decir, el porcentaje que, de las variaciones de Yi, explica las variaciones de Xi a través del modelo estimado. Antes del modelo la dispersión en las observaciones de la variable endógena se mide por medio de su varianza muestral ( S 2y ), pero al considerar, a través del modelo de regresión, la influencia de las observaciones de la variable exógena, la dispersión respecto a los nuevos 2 “valores medios” estimados ( Ŷi ) se mide por la varianza residual ( S ey ), de valor inferior a la anterior. La proporción de está reducción o ganancia de varianza explicada es lo que representa el valor de R2. Todo lo anterior es válido en nuestro modelo y en cualquier otro, como el modelo de regresión lineal múltiple, que verifique la descomposición de la varianza representada en (3.19). Únicamente en el modelo de regresión lineal simple se cumple que: S 2 Ry = S 2xy S 2x Demostración: S 2Ry = ( ) 2 1 N 1 N 2 ⋅ ∑ Ŷi - Y = ⋅ ∑ (b1 + b 2 X i - Y ) sabiendo que Ŷi = b1 + b 2 X i N i =1 N i =1 sustituyendo b1 y b2 por sus respectivas expresiones (3.4) y (3.3) tenemos: S 2 Ry S xy S xy ⎞ 1 N ⎛ = ⋅ ∑ ⎜⎜ Y - 2 ⋅ X + 2 ⋅ X i - Y ⎟⎟ N i =1 ⎝ Sx Sx ⎠ 2 y operando: S 2Ry = 2 S 2xy S 2xy S 2xy 1 N 1 N S xy 2 2 ⋅ ∑ 2 2 ⋅ (X i - X ) = 2 2 ⋅ ⋅ ∑ (X i - X ) = 2 2 ⋅ S 2x = 2 c.q.d. N i =1 S x ⋅ S x Sx Sx ⋅ Sx S x ⋅ S x N i =1 Obteniendo efectivamente que S 2Ry = S 2xy S 2x Sustituyendo esta expresión de la varianza debida a la regresión, para el modelo de regresión simple, en (3.20), nos queda: S 2Ry S 2xy R 2 = 2 = 2 2 (3.21) Sy Sx ⋅ Sy Al ser un porcentaje, el valor de R2 estará comprendido entre cero y uno, dando lugar a las siguientes situaciones extremas: 31 Departamento de Estadística e Investigación Operativa II (Métodos de Decisión) Si R2 = 0 ⇒ S 2Ry = 0 ; Sxy = 0 ⇒ b2 = 0 y b1 = Y . El modelo no explica nada. No existe relación lineal entre las variables. La especificación del modelo podría i = 1, ... ,N siendo su estimación: sustituirse por: Yi = μ + ui Yi = Y + e i i = 1, ... , N 2 Si R2 = 1 ⇒ S ey = 0 ⇒ ei = 0 ∀i = 1, ... ,N . El ajuste es perfecto. Los datos revelan una relación lineal exacta entre las variables. El coeficiente de correlación lineal: r Se define el coeficiente de correlación lineal entre las variables estadísticas X e Y de las que se han obtenido N pares de valores observados, como: r = S xy Sx ⋅ Sy (3.22) Elevando al cuadrado los dos miembros de la igualdad, se obtiene: r = 2 S 2xy S 2x ⋅ S 2y . Igual, por tanto, a la expresión resultante, en el modelo simple, del coeficiente de determinación. Recordando que la covarianza es una medida de la dependencia lineal entre las variables X e Y, pero que su valor depende de las unidades de medida utilizada, podemos observar que el coeficiente de correlación es esa misma medida “normalizada” al dividir entre el producto de las desviaciones típicas, y nos indicará el grado de dependencia lineal entre las variables por medio de un valor acotado entre –1 y 1, distinguiéndose los siguientes casos: r = -1 -1 < r < 0 r=0 0<r<1 r=1 Correlación lineal perfecta negativa Correlación lineal negativa o decreciente Incorrelación: No existe relación lineal entre X e Y R2 = 0 Yi = μ + ui ∀i 0 < R2 < 1 Correlación lineal positiva o creciente Correlación lineal perfecta positiva Por último, se obtiene, fácilmente que: b 2 = 32 R2 = 1 ei = 0 ∀i 0 < R2 < 1 S xy S 2x =r⋅ R2 = 1 Sy Sx ei = 0 ∀i Introducción a la Econometría Tema 3: ESTIMACIÓN DEL MODELO 3.5 Estimación de la varianza de las perturbaciones. Recordemos que en el modelo (3.1) bajo el cumplimiento de las hipótesis básicas, σ2 es la varianza de cada una de las perturbaciones aleatorias y, también, la varianza de cada Yi en el modelo: V[ Yi / Xi ] = V[β1 + β2Xi + ui ] = V[ui ] = σ2 Para su estimación hemos de tener en cuenta que las variables ui no son observables pero, después de estimados los parámetros β1 y β2, los residuos se pueden considerar estimaciones de sus valores ( siendo ui = Yi - β1 - β2Xi , los residuos se expresan como: ei = Yi - b1 - b2 Xi = û i ) y, por tanto, se propone como estimador de σ2 a la varianza muestral de los residuos o varianza residual. N 2 σ 2* = S ey = ∑e i =1 2 i N ⎡N ⎤ Pero se demuestra (ver Apéndice A3.4) que: E ⎢∑ e i2 ⎥ = (N - 2) ⋅ σ 2 ⎣ i =1 ⎦ ⎡ N 2⎤ ⎢ ∑ ei ⎥ 1 2σ 2 2 Y, por tanto, resulta que: E S ey = E ⎢ i =1 ⎥ = ⋅ ( N - 2) ⋅ σ 2 = σ 2 N ⎢ N ⎥ N ⎥⎦ ⎢⎣ Siendo la varianza residual un estimador sesgado, aunque insesgado asintóticamente, de la varianza constante del modelo. [ ] Para construir un estimador insesgado simplemente se tendrá que dividir la suma de cuadrados de los residuos entre (N – 2), en lugar de N, obteniendo la varianza residual corregida por los “grados de libertad” que representaremos por S2. N σˆ 2 = S 2 = ∑e i =1 2 i N-2 que es insesgado: [ ] [ ] E σˆ 2 = E S 2 = 1 1 ⎡N ⎤ ⋅ (N - 2) ⋅ σ 2 = σ 2 ⋅ E ⎢∑ e i2 ⎥ = N - 2 ⎣ i =1 ⎦ N - 2 N su raíz cuadrada, σˆ = S = ∑e i =1 2 i N-2 recibe el nombre de “error estándar” de la regresión. 33 Departamento de Estadística e Investigación Operativa II (Métodos de Decisión) N Nota: ∑e i =1 2 i se puede calcular por dos caminos: N 1) a partir de (3.17) ∑e N N N i =1 i =1 i =1 = ∑ Yi2 - b1 ⋅ ∑ Yi - b 2 ⋅ ∑ X i ⋅ Yi 2 i i =1 2) calculando primero: R 2 = y sabiendo que R = 1 2 N ∑e podemos calcular i =1 2 i S 2xy S 2x ⋅ S 2y 2 S ey S 2 y 2 ⇒ S ey = (1 - R 2 ) ⋅ S 2y = N ⋅ (1 - R 2 ) ⋅ S 2y 3.6 Hipótesis de normalidad. Estimación máximo verosímil. Si suponemos que se cumplen las hipótesis básicas, definidas en el Tema 2, incluida la hipótesis de normalidad, la distribución de las observaciones muestrales de la variable endógena será: Yi : N[β1 + β2Xi ; σ2 ] e independientes para i = 1, ... ,N Componiendo el conjunto de variables muestrales aleatorias observables en la estimación del modelo. Su función de densidad conjunta, dependiendo de los valores que puedan tomar los parámetros β1, β2 y σ2, constituirá la función de verosimilitud. La función de densidad marginal para cada variable muestral Yi será: f ( Yi , X i ; β 1 , β 2 , σ 2 ) -1 1 = ( 2πσ 2 ) − 2 ⋅ e 2σ 2 ⋅( Yi - β 1 - β 2 X i ) 2 ⎧ Yi ∈ R X i ∈ R para ⎨ 2 ⎩β1 ∈ R β 2 ∈ R σ > 0 Al ser las variables Yi independientes la función de verosimilitud se obtendrá como producto de las funciones de densidad marginales. L( Yi , X i ; β 1 , β 2 ,σ 2 ) = N ∏ f(Y , X i i ; β 1 , β 2 ,σ 2 ) = i=1 = f ( Y1 , X 1 ; β 1 , β 2 ,σ 2 ) ⋅ . . . ⋅ f ( YN , X N ; β 1 , β 2 ,σ 2 ) = = ( 2πσ 1 2 −2 ) -1 ⋅e 2σ 2 ⋅( Y1 - β 1 - β 2 X1 ) = (2π ) 34 -N 2 ⋅ (σ ) 2 2 ⋅ . . . ⋅ ( 2πσ -N 2 -1 ⋅e 2σ 2 N ⋅ 1 2 −2 ) -1 ⋅e ∑ ( Yi - β 1 - β 2 Xi ) 2 i=1 2σ 2 ⋅( YN - β 1 - β 2 X N ) 2 = Introducción a la Econometría Tema 3: ESTIMACIÓN DEL MODELO Resultando que la función de verosimilitud respecto a los parámetros del modelo de regresión lineal simple es: ⎧β1 ∈ R -1 N 2 -N -N ⎪ ⎧ Yi ∈ R 2 ⋅ ∑ ( Yi - β 1 - β 2 X i ) L( Yi , X i ; β 1 , β 2 ,σ 2 ) = (2π ) 2 ⋅ (σ 2 ) 2 ⋅ e 2σ i=1 para ⎨ β 2 ∈ R con⎨ ⎩X i ∈ R ⎪σ2 > 0 ⎩ Recordemos que la finalidad del método de estimación de la máxima verosimilitud es determinar los estimadores de los parámetros que asignen a éstos, sea cual sea la muestra, los valores con los que obtienen la mayor verosimilitud posible. El procedimiento que se sigue consiste en plantear el máximo de la función de verosimilitud respecto a los valores de los parámetros, tomando éstos el papel de simples variables matemáticas. Si en la condición necesaria, o de primer orden, es posible despejar los valores de los parámetros en función de las variables muestrales, estas funciones resultarán ser los estimadores de máxima verosimilitud con tal de comprobar que verifican la condición suficiente, o de segundo orden, de máximo. Si representamos por l(Yi, Xi ; β1, β2, σ2) al logaritmo neperiano de la función de verosimilitud (también denominada segunda función de verosimilitud), esta función poseerá los máximos y mínimos en los mismos puntos que L(Yi, Xi ; β1, β2, σ2) con la ventaja de que los desarrollos necesarios para la determinación de los puntos críticos son más sencillos. Por tanto plantearemos la búsqueda del máximo de la función: l( Yi , X i ; β 1 , β 2 ,σ 2 ) N 1 2 N N 2 = − ⋅ log2π − ⋅ logσ − 2 ⋅ ∑ ( Yi − β 1 − β 2 X i ) 2 2 2σ i=1 La condición necesaria será: N ⎧ ∂ l 1 = 0 ⇒ ⋅ 2 + ( Y − β 1 − β 2 Xi ) = 0 ∑ ⎪ ∂β 2σ 2 i=1 i 1 ⎪⎪ N 1 ∂ l ⎨ = 0 ⇒ + 2 ⋅ 2 ∑ ( Yi − β 1 − β 2 X i ) ⋅ X i = 0 2σ i=1 ⎪ ∂ β2 N N 1 1 2 ⎪∂ l Yi − β 1 − β 2 X i ) = 0 = 0 ⇒ − ⋅ + ⋅ ( ∑ 2 4 ⎪⎩ ∂ σ 2 2 σ 2σ i=1 Donde las dos primeras ecuaciones forman el sistema: ⎫ − β X = 0 ) ⎪ i 1 2 i i=1 ⎬ N ∑( Yi − β 1 − β 2 X i ) ⋅ X i = 0⎪⎭ i=1 N ∑( Y − β Que, dependiendo sólo de β1 y β2, es equivalente al sistema de ecuaciones normales de M.C.O., cuya solución ya se expuso en el epígrafe 3.1 de este Tema. Por tanto, en la resolución del anterior sistema se llega a despejar las siguientes expresiones de los parámetros β1 y β2 : 35 Departamento de Estadística e Investigación Operativa II (Métodos de Decisión) S xy ⎫ ⎫ ∗ X ⋅ Y = − ⋅ X = b1 ⎪ β ⎪ 1 2 2 Sx Sx ⎪ ⎪ dando lugar a los estimadores: ⎬ ⎬ S xy S xy ∗ ⎪ β2 = 2 = b2 ⎪ β2 = 2 ⎪⎭ ⎪⎭ Sx Sx β1 = Y − S xy Que coinciden con los estimadores de M.C.O.. A partir de estas soluciones, sustituyéndolas en la tercera ecuación, nos queda: N N 1 1 2 − ⋅ 2 + 4 ⋅ ∑ ( Yi − b 1 − b 2 X i ) = 0 2 σ 2σ i=1 donde despejando σ2: N ∑( Y − b σ N 1 2 = 2 = 4 ⋅ ∑ ( Yi − b 1 − b 2 X i ) ⇒ 2σ 2σ i=1 σ2 4 N i 1 − b2 Xi ) i=1 N N 2 ⇒σ2 = ∑e 2 i i=1 N N Quedando como estimador de σ2: σ 2∗ = ∑e 2 i = S 2ey (varianza residual) i=1 N Tan sólo queda comprobar que la solución obtenida cumple con la condición de segundo orden. Se puede deducir que la matriz hessiana para dicha solución es: ⎡ ⎢ − N ⎢ S 2ey ⎢ Xi ⎢ ∑ i 2 H(b 1 , b 2 , S ey ) = ⎢ − 2 S ey ⎢ ⎢ 0 ⎢ ⎢ ⎣ − − ∑X ⎤ ⎥ 0 ⎥ ⎥ ⎥ 0 ⎥ ⎥ N ⎥ − 2(S 2ey ) 2 ⎥ ⎥ ⎦ i i S 2ey ∑ X 2i i S 2ey 0 Donde se comprueba que: h11 < 0 h 11 h 12 h 21 h 22 >0 y ⏐H⏐< 0 Siendo la matriz hessiana definida negativa y la solución corresponde a un máximo. Por tanto, los estimadores de máxima verosimilitud son: ⎫ 2 ⋅ X = b1 ⎪ ⎪ Sx ⎬ S xy ∗ ⎪ β 2 = 2 = b2 ⎪⎭ Sx β 1∗ = Y − 36 S xy N y σ 2∗ = ∑e i=1 N 2 i = S 2ey Introducción a la Econometría Tema 3: ESTIMACIÓN DEL MODELO De los dos primeros, que coinciden con los de M.C.O., ya conocemos sus propiedades, a las que podríamos añadir que, ahora bajo el supuesto de normalidad, son los estimadores eficientes, es decir, son insesgados y de mínima varianza entre todos los estimadores insesgados que se pudieran proponer. Del estimador M.V. de la varianza podemos decir que es sesgado, como se comprobó en el epígrafe anterior, aunque insesgado asintóticamente. Y se puede comprobar que, como todo estimador de M.V., es consistente y eficiente asintóticamente. EJERCICIOS PROPUESTOS 3.1 En el contexto del modelo de regresión lineal simple, conteste razonadamente a las siguientes cuestiones: 1) ¿Es lineal el estimador insesgado de σ2?. 2) Dadas dos series de valores de X ( X1i y X2i ) Donde los valores X2i están más dispersos que los valores X1i , ¿cuál de las dos series elegiría para obtener una mejor estimación M.C.O. de β2 ?. 3) ¿Se podría obtener la estimación M.C.O. de β2 si todos los valores de Xi fueran iguales?. (Recogido del libro “Ejercicios de econometría” de Mª T. Aparicio, F.J. Trívez y J. Mur) 3.2 Justifíquese las respuestas a las siguientes preguntas: 1) ¿Es posible que la varianza residual sea negativa?. ¿ E igual a cero?. 2) ¿Hay algún caso en el que el coeficiente de determinación pueda tomar un valor fuera del intervalo [ 0 ; 1 ] ?. 3) La suma de cuadrados de los residuos: ∑ei2, ¿es siempre menor que la suma de los cuadrados de los valores observados de la variable endógena: ∑Yi2 ?. 3.3 En el contexto de la estimación del modelo de regresión lineal simple: Yi = β1 + β2.Xi + ui con E(ui) = 0 , V(ui) = σ2 y E(ui·uj) = 0 para i = 1, ... ,N y sin concretar el modelo de distribución de las perturbaciones aleatorias. Discuta razonadamente la veracidad o falsedad de las siguientes proposiciones: 1º: El estimador de β2 obtenido por M.C.O., que es insesgado, posee la mínima varianza entre las de todos aquellos estimadores insesgados, sean lineales o no lineales, que se pudieran proponer. 2 . 2º: El estimador insesgado de σ2 coincide con la varianza residual: S ey 3º: Las perturbaciones aleatorias o términos de error coinciden con los residuos de la estimación del modelo. 3.4 Dado el modelo lineal simple sin “ordenada en el origen”: Yi = βXi + ui i = 1, .. , N Determinar: 1) El estimador M.C.O. de β. 2) El estimador insesgado de σ2. 3) La varianza del estimador de β. 4) La expresión del coeficiente de determinación. 37 Departamento de Estadística e Investigación Operativa II (Métodos de Decisión) 3.5 En el ámbito de la estimación del modelo de regresión lineal simple: Yi = β1 + β2.Xi + ui con E(ui) = 0 , V(ui) = σ2 y E(ui·uj) = 0 para i = 1, ... ,N. Discuta razonadamente la veracidad o falsedad de las siguientes proposiciones: 1º: El estimador M.C.O. del parámetro β2 es una variable aleatoria. 2º: El estimador M.V. del parámetro σ2 es sesgado. 3º: Es posible encontrar un estimador insesgado de β2 con menor varianza que el obtenido por M.C.O., si se supone que las perturbaciones aleatorias siguen una distribución normal. 4º: Cuanto menos dispersos estén los valores observados de la variable exógena más precisa será la estimación del parámetro β2 . 3.6 Dado el modelo de regresión lineal simple: Yi = β1 + β2.Xi + ui . ¿Qué hipótesis básicas sobre la distribución de probabilidad de las perturbaciones aleatorias “ui” se deben cumplir para poder afirmar que la distribución de probabilidad del estimador M.C.O. del parámetro β2 es: b2 ∼ N[ β2; σ2(b2)]?. Relacione cada una de las características de esta distribución con las hipótesis básicas que precise. Sabiendo que σ 2 (b 2 ) = σ 2 ⋅ 1 NS 2x 3.7 Estime el modelo de regresión lineal simple que explica la calificación del examen final según la calificación de un examen previo, con los datos del ejercicio 1.2 del TEMA 1. Calcule las estimaciones M.C.O. de los dos parámetros, la estimación insesgada de σ2 y el valor correspondiente del coeficiente de determinación. 3.8 Utilizando los resultados obtenidos en el ejercicio 1.3 del TEMA 1 estime el modelo de regresión lineal del “Consumo privado” sobre la “Renta disponible” de las familias estadounidenses durante el periodo de 1960 a 2004. Calcule las estimaciones M.C.O. de los dos parámetros, la estimación insesgada de σ2 y el valor correspondiente del coeficiente de determinación. 3.9 Estime el modelo de educación de Mincer: logYi = β1 + β2Xi + ui , a partir de los datos obtenidos en la resolución del ejercicio 2.1 del TEMA 2. Calcule las estimaciones M.C.O. de los dos parámetros, la estimación insesgada de σ2 y el valor correspondiente del coeficiente de determinación. 3.10 Estime la línea característica del modelo del mercado de Sharpe: rjt = αj +βjRMt +ujt correspondiente a la volatilidad del título A, a partir de los datos obtenidos en la resolución del ejercicio 2.2 del TEMA 2. Calcule las estimaciones M.C.O. de los dos parámetros, 38 Introducción a la Econometría Tema 3: ESTIMACIÓN DEL MODELO la estimación insesgada de σ2 y el valor correspondiente del coeficiente de determinación. APÉNDICES Apéndice A3.1 Sea el modelo de regresión lineal simple: y i = β 1 + β 2 x i + u i i = 1 ... N con las hipótesis básicas: E[ui] = 0 V[ui] = E[ui]2 = σ2 Cov[ui ,uj] = E[ui.uj] = 0 ∀ i ≠ j y consideremos S xy S xy β$1 = b1 = y − 2 . x los estimadores M.C.O.: β$2 = b2 = 2 Sx Sx Se deduce que: b2 = S xy S 2 x ya que 1 N = ∑ (x - x).(y - y) = ∑ ( x - x)y − y∑ (x ∑ ( x - x) ∑ (x - x) i i 2 1 N ∑ (x i i i i - x) = ∑ (x - x)y i (x - x) = ∑ i 2 yi 2 NS x NS x i − x) = 0 y ∑ (x i - x) 2 = NS 2x i b 2 = ∑ k i y i (3.5) siendo Obteniéndose: i 2 ki = xi - x NS 2x Para el otro estimador será: b1 = y − S xy S 2 x ∑y ⎛1 ⎞ - x. ∑ k i y i = ∑⎜ − xk i ⎟.y i ⎝N ⎠ N .x = i ⎞ ⎛1 b 1 = ∑ d i y i (3.6) siendo d i = ⎜ − xk i ⎟ ⎠ ⎝N Llegando a: Los coeficientes ki y di verifican las siguientes igualdades: 1) ∑k i = ∑ (x 1 NS 2x 2) Por potro lado: Y también: Por tanto: 3) ∑k 2 i 4) ∑d i = i i 1 ( NS ) 2 2 x ∑k - x) = 0 → i =0 ∑ k (x - x) = ∑ k x - x. ∑ k = ∑ k x (x − x) ∑ (x − x) = NS − x) = ∑ (x − x) = NS NS NS i ∑ k i (x i ∑k x i i i i i i i 2 i i 2 x i 2 x 2 x 2 x =1 =1 ∑( x − x) = 2 i 1 ( NS ) 2 2 x NS 2x = 1 NS 2x ⇒ ∑k 2 i = 1 NS 2x 1 1 ⎞ ⎛1 = ∑⎜ − xk i ⎟ = ∑ − ∑ xk i = N − x ∑ k i = 1 − 0 = 1 por tanto: ⎠ ⎝N N N ∑d i =1 39 Departamento de Estadística e Investigación Operativa II (Métodos de Decisión) 5) ⎛ xi ∑x ⎞ ∑ d .x = ∑⎜⎝ N − xk x ⎟⎠ = i i i i − x ∑ k i x i = x − x.1 = 0 → i N ∑d x i i =0 6) 2 2 1 x2 ⎛1 ⎞ ⎛ 1 ⎞ N ∑ d = ∑⎜⎝ N − xk i ⎟⎠ = ∑⎜⎝ N 2 + x 2 k 2i − N xk i ⎟⎠ = N 2 + x 2 ∑ k 2i − N x ∑ k i = N + NS 2 = x a S 2x + x 2 a 20 20 2 = = es decir: ∑ d i = 2 2 NS 2x NS x NS x 2 2 i Apéndice A3.2 A partir de los resultados (3.7) y (3.8), obtenidos en el segundo epígrafe de este Tema, se deduce que las expresiones de las varianzas de los estimadores de M.C.O. son: V[ b 2 ] = E[ b 2 - β 2 ] = E[ ∑ k i u i ] = E[ k 12 u 12 +...+k 2N u 2N + 2k 1 k 2 u 1 u 2 +...] = 2 2 = k 12 E[ u12 ] +...+k 2N E[ u 2N ] + 2k 1k 2 E[ u1 .u 2 ] +...= σ 2 ∑ k 2i [ ] ya que E[ u 2i ] = σ 2 ∀i y E u i .u j = 0 ∀i ≠ j y aplicando el resultado obtenido en 3) del Apéndice A1 quedará: V[ b 2 ] = σ 2 1 (3.11) NS 2x Análogamente para la varianza de b1: V[ b 1 ] = E[ b 1 - β 1 ] = E[ ∑ d i u i ] = σ 2 ∑ d 2i por las mismas razones que antes. 2 2 Aplicando, el resultado obtenido en 6) del Apéndice A1 quedará: V[ b 1 ] = σ 2 a 20 (3.12) NS 2x La covarianza entre b1 y b2 será: [ [ ] Cov( b 1 , b 2 ) = E ( b 1 - β 1 ) . ( b 2 - β 2 ) = E ( ∑ d i u i ) . ( ∑ k i u i ) ] Cov( b 1 , b 2 ) = E[ d 1 k 1 u +...+d N k N u + d 1 k 2 u 1 u 2 +...] = d 1 k 1 E( u 12 ) +...+d N k N E( u 2N ) + d 1 k 2 E( u 1 .u 2 ) +...= 2 1 2 N ( ) = σ 2 ∑ d i k i ya que E( u 2i ) = σ 2 ∀i y E u i .u j = 0 ∀i ≠ j pero ∑d k i i 1 1 ⎛1 ⎞ = ∑⎜ − xk i ⎟.k i = ∑ k i − x ∑ k 2i = − x ⎝N ⎠ N NS 2x resultando : Cov( b 1 , b 2 ) = σ 2 . 40 -x (3.13) NS 2x Introducción a la Econometría Tema 3: ESTIMACIÓN DEL MODELO Apéndice A3.3 La varianza del estimador lineal β 2* será: V( β 2* ) = V( ∑ w i y i ) = ∑ w 2i V(y i ) = σ 2 ∑ w 2i = σ 2 ∑ ( w i − k i + k i ) = 2 = σ 2 . [ ∑ (w i − k i ) 2 + ∑ k 2i + 2 ∑ (w i − k i ).k i ] = σ 2 ∑ (w i − k i ) 2 + σ 2 1 2 2 2 + 2σ ∑ (w i k i − k i ) NS x y dado que: xi − x 1 ∑ w i xi − x ∑ w i − 1 = 1 − 1 = 0 2 − 2 = NS x NS x NS2x NS2x NS2x NS2x NS2x 1 la varianza de β 2* queda: V( β 2* ) = σ 2 + σ 2 ∑ (w i − k i ) 2 NS 2x ∑ (w k i i − k 2i ) = ∑ w i k i − ∑ k 2i = ∑ w i Apéndice A3.4 Sea el modelo: y i = β 1 + β 2 x i + u i i = 1, ... , N [3.1] S xy siendo los estimadores M.C.O. de los parámetros: β$1 = b1 = y − β$2 = b 2 = S xy 2 x S 2x x (x i − x).u i [3.2] NS 2x , sumando y dividiendo entre N: , que se puede expresar también: b 2 = β 2 + ∑ k i u i = β 2 + ∑ S los residuos serán : e i = y i − b1 − b 2 x i 0 = y − b1 − b 2 x [3.3] [3.4] restando [3.3] - [3.4] nos queda : e i = (y i − y) − b 2 (x i − x) i = 1, ... , N ∑ u i [3.6] en [3.1] sumando y dividiendo entre N : y = β 1 + β 2 x + N restando [3.1] - [3.6] : ∑ ui y i − y = β 2 (x i − x) + (u i − u) i = 1, .. , N [ 7] , llamando u = N sustituyendo [3.7] en [3.5] : [3.5] e i = β 2 (x i − x) + (u i − u) − b 2 (x i − x) ⇒ e i = (u i − u) − (b 2 − β 2 )(x i − x) [3.8] elevando al cuadrado y sumando : ∑ e = ∑ (u − u) 2 i i 2 − 2(b2 − β 2 ) ∑ (xi − x)(ui − u) + (b2 − β 2 ) 2 ∑ (xi − x) 2 ⇒ ⇒ ∑ e 2i = ∑ (u i − u) 2 − 2(b 2 − β 2 ) ∑ (x i − x)u i + (b 2 − β 2 ) 2 ⋅ NS 2x al ser ∑ (x − x)(u − u) = ∑ (x − x)u − u ∑ (x − x) = ∑ (x − x)u i i i i i i i [3.9] y ∑( x − x ) = NS 2x 2 i 41 Departamento de Estadística e Investigación Operativa II (Métodos de Decisión) A partir de [3.2] se deduce que : sustituyendo en [3.9] : quedando : ∑e 2 i ∑e 2 i ∑ (x i − x)u i = (b 2 − β 2 ) ⋅ NS 2x = ∑ (u i − u) 2 − 2(b 2 − β 2 ) 2 ⋅ NS 2x + (b 2 − β 2 ) 2 ⋅ NS 2x = ∑ (u i − u) 2 − (b 2 − β 2 ) 2 ⋅ NS 2x [3.10] donde aplicando el operador esperanza : E[ ∑ e 2i ] = E[ ∑ (u i − u) 2 ] − ∑ (x i − x) 2 E[ b 2 − β 2 ] 2 [3.11] E[ ∑ (u i − u) 2 ] = ∑ E[ u i − u] = ∑ E[ u 2i + u 2 − 2uu i ] = ∑ [ E(u 2i ) + E(u 2 ) − 2E(uu i )] = 2 = ∑σ 2 + ∑ σ2 N − 2∑ σ2 N = Nσ 2 + σ 2 − 2σ 2 = ( N − 1)σ 2 [3.12] ⎧ ⎪ E(u 2i ) = σ 2 ⎪ 2 ⎪ ⎛ ∑ ui ⎞ 1 1 σ2 2 2 2 2 2 por ser ⎨ E(u ) = E⎜ ⎟ = 2 E( u1 + u 2 +...+ u N +...) = 2 Nσ = N N N ⎝ N ⎠ ⎪ ⎪ ⎛ ∑ ui ⎞ 1 σ2 2 = = + + + + + E(u.u ) E u E u u u .u ... u ... u u . . = ( ) ⎪ ⎜ i i⎟ 1 i 2 i i N i N ⎝ N ⎠ N ⎩ E[ b 2 − β 2 ] = V[ b 2 ] = 2 sustituyendo [3.12] y [3.13] en [3.11] : E[ ∑ e 2i ] = (N − 1)σ 2 − ∑ (x i − x) 2 por tanto E[ ∑ e 2i ] = (N − 2)σ 2 c.q.d. 42 σ2 ∑ (x i − x) 2 σ2 NS 2x [3.13] = (N − 1)σ 2 − σ 2