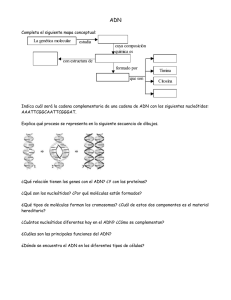

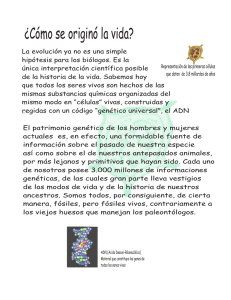

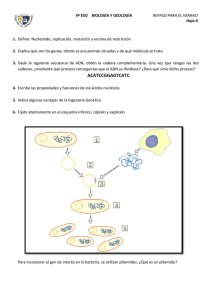

El ADN y el Origen de la Vida

Anuncio