Curs de Modelització Estadística Bàsica amb Deducer

Anuncio

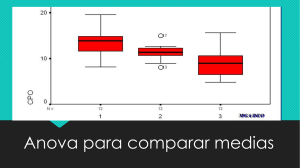

Curs de Modelització Estadística Bàsica amb Deducer Anabel Blasco Ana Vázquez Anna Espinal Llorenç Badiella Oliver Valero 1.Model de Regressió Lineal 2.Model ANOVA 3.Model Lineal General 4.Model de Regressió Logística Introducción al modelo ANOVA Estimación de parámetros Estimación de medias e IC Separación de medias Ajuste por multiplicidad de contrastes Validación del modelo ANOVA de dos factores Interacciones Es posible expresar en términos de modelo estadístico un análisis ANOVA. Admitiendo que los valores observados yij fluctúan alrededor de un valor medio μi que caracteriza a cada grupo, el modelo es de la forma: yij = µi + eij donde eij ~ N (0, σ ) son independientes entre sí. Para realizar este análisis con Deducer seleccionaremos el menú Linear Model, seleccionamos la variable respuesta como Outcome y la variable que define los grupos como Factor: Después de escoger Continue aparece el Linear Regression Model Builder donde podríamos definir el modelo que deseamos estimar. Podemos simplemente comprobar qué modelo es el propuesto y escoger Continue. A continuación aparece el Linear Regression Model Explorer donde se pueden previsualizar los resultados: Para incluir variables categóricas en el modelo, se utilizan las transformaciones a variables indicadoras (dummy). La transformación más habitual es la siguiente: Variable Original (V) A B A C A B A C V1(A) 1 0 1 0 1 0 1 0 V2(B) 0 1 0 0 0 1 0 0 V3(C) 0 0 0 1 0 0 0 1 ejemplo para una variable con 3 categorías Siempre se cumple que V1+V2+V3=1, por lo tanto, no es posible considerarlas todas ya que están auto-explicadas. Se debe eliminar una variable cuya categoría que actuará como categoría de referencia, por ejemplo la categoría C (V3). De este modo, incluir en el modelo GLM una variable categórica con tres categorías es equivalente a incluir las variables V1 y V2. El modelo para esta variable categórica quedaría: Y = β0 + β1V1 + β2V2 + ε En Deducer, la categoría de referencia es siempre la primera: Estimaciones de los parámetros para cada una de las categorías del factor respecto a un valor de referencia (RiskFactors=0). Aunque en el análisis de la varianza el objetivo primordial es comparar grupos, también es posible estimar los promedios y obtener intervalos de confianza. Esto puede permitir aportar márgenes a la estimación de las magnitudes estudiadas. Para el promedio del grupo i, el intervalo de confianza es: Yi ± t1N−α− I/ 2 MSE Ni N −I siendo: Yi el promedio observado en el grupo i, t1−α / 2 el percentil 1- α/2 para una distribución t con N-I grados de libertad; Ni el tamaño del grupo i; MSE la suma de cuadrados medios del error. Para la diferencia entre los grupos 1 y 2, el intervalo de confianza es: 1 1 Y1 − Y2 ± t1N−α− I/ 2 MSE + N1 N 2 Estas fórmulas difieren ligeramente de las empleadas para la estimación de parámetros en una o dos poblaciones en la utilización de la variabilidad común MSE y en los grados de libertad, mayores ya que el término MSE se calcula con todas las observaciones. Para obtener la estimación de los parámetros debemos seleccionar la casilla Estimate confidence intervals del menú Means: Muchas veces el interés real del estudio reside en saber qué medias difieren entre sí después de realizar la prueba ANOVA. Las comparaciones se realizan mediante sucesivas pruebas t comparando todos los posibles pares de medias 2 a 2. Cada una de estas pruebas utiliza la estimación de la variabilidad conjunta proporcionada por el modelo con todos los grupos, mejorando así el resultado de los contrastes independientes. Sin embargo, este procedimiento conduce habitualmente a un elevado número de comparaciones. Si el nivel de significación o error de tipo I (probabilidad de rechazar la hipótesis nula cuando en realidad es cierta) de cada prueba se ha fijado en el 5%, y se desea comparar las medias de 5 grupos, será necesario realizar 10 comparaciones 2 a 2 y cada una de ellas tendría un error de tipo I del 5%. Se puede comprobar que al realizar 10 pruebas (independientes entre sí) cada una al 5%, la probabilidad de rechazar al menos una de las hipótesis nulas es aproximadamente ¡del 40%! de manera que con un 40% de probabilidades se obtendría alguna conclusión falsa. Existen diversos métodos para ajustar este tipo de error y conseguir que efectivamente el error conjunto no sea superior al 5%. Para realizar comparaciones 2 a 2 debemos seleccionar el tipo de comparación Tukey en la pestaña Post Hoc. En caso de no estar interesados en realizar todas las comparaciones podríamos seleccionar otro método (por ejemplo Dunnet cuando queremos comparar todos los grupos frente a uno de referencia). Una primera aproximación al tratamiento de este problema es debida a Fisher, quién propuso que sólo se compararan las diferencias entre medias 2 a 2 si el precedente ANOVA ha resultado significativo. Estas comparaciones a posteriori se realizan sin corrección alguna. Este método es conocido cómo LSD (Least Significant Difference). El método de Bonferroni es extremadamente conservador pero no depende de la muestra, sólo del número de comparaciones. Consiste en sustituir el nivel de significación α considerado en cada prueba por α /nc siendo nc el número de comparaciones. El método de Sidak sustituye α por 1 - ( 1 - α ) 1/nc, siendo utilizado cuando el investigador sólo está interesado en analizar un número reducido de todos los posibles contrastes. Existen otros métodos para controlar el error de cada comparación, entre ellos la corrección de Scheffé (Scheffé, 1953) y el método HSD (Honestly Significant Difference) de Tukey (Tukey, 1953), el más adecuado cuando se desea realizar todas las posibles comparaciones por parejas de grupos. Cuando todas las diferencias que se quieren estudiar son respecto a un mismo grupo control, es habitual realizar el ajuste de Dunnett (Dunnett, 1955). También existen métodos de comparación de grupos de medias que permiten detectar grupos homogéneos de medias cómo el ajuste de Duncan y la corrección SNK (Student-Newman-Keuls), que son adecuados cuando los grupos están equilibrados y el interés reside en obtener una comparación global. Puede darse la situación que la prueba ANOVA no permita concluir diferencias entre grupos y sin embargo se detecten diferencias en las comparaciones múltiples. Normalmente esta situación es provocada por la consideración de demasiados grupos. En Deducer seleccionaremos la opción single-step method. Con estas opciones se obtiene: La variación observada en la respuesta se asume que es debida al efecto de los factores y a cierto error aleatorio independiente que explica la variación residual. Se asume también que dicho error aleatorio sigue una distribución normal con media 0 y desviación constante (igual en todas las observaciones). Para estudiar la validez del modelo es necesario confirmar estas hipótesis mediante el estudio de los residuos (valores predichos - valores observados): normalidad, tendencias, etc. y la realización de un contraste de homocedasticidad (homogeneidad de varianzas entre los grupos, es decir variabilidad común). En caso de que las varianzas no sean iguales podemos seleccionar la opción Robust to Unequal Variance de la pestaña Options. En la pestaña Diagnostics podemos visualizar los gráficos de diagnóstico: histograma de los residuos y QQ Plot para evaluar la normalidad, gráficos de dispersión para evaluar la homocedasticidad y la independencia, y el gráfico de Cook para identificar valores influyentes: La prueba ANOVA de dos factores permite comparar las medias de los r1 grupos que define una variable categórica de interés principal al mismo tiempo que se analiza el efecto en la respuesta de otra variable categórica secundaria con r2 grupos. La prueba de hipótesis principal de la prueba ANOVA de dos factores es: H0: Eliminando el efecto del factor secundario, no existen diferencias entre los grupos del factor principal HA: Eliminando el efecto del factor secundario, existen diferencias entre los grupos del factor principal. R cuadrado corregida: R2. Si se introduce una nueva variable en el modelo, R2 siempre aumenta (ya que se consigue explicar algo más, aunque sea muy poco). De la misma manera, al quitar una variable R2 siempre disminuye. Como nos interesa saber si es conveniente introducir/quitar una variable en el modelo, se ajusta R2 según los grados de libertad (el número de variables consideradas en el modelo): 2 R = R2 − k −1 (1 − R 2 ) n−k De esta manera, un aumento en la añadir/quitar una variable. R 2 indica que el modelo ha mejorado al Tabla del análisis de la varianza: Fuentes de Variación Suma de Cuadrados Grados de Libertad Suma de Cuadrados Medios Valor F P-valor Entre Grupos B SSB GLB MSB FB PB Entre Grupos A SSA GLA MSA FA PA Residual SSE GLE MSE Total SST GLT La interacción entre dos variables se produce cuando el efecto en la respuesta de una de ellas depende de los niveles de la otra. Para comprobar la existencia de interacciones, se puede estudiar el gráfico de interacciones. Si no se observan líneas paralelas entonces se podría considerar la existencia de la interacción. En el caso de añadir la interacción al modelo, también se calculan las correspondientes sumas de cuadrados y grados de libertad y se añade una fila a la tabla ANOVA. Las sumas de cuadrados residuales y sus grados de libertad varían ya que se añade más información al modelo. Finalmente, todos los estadísticos F deben ser recalculados.