Métodos Estadísticos alternativos de análisis con variables discretas y categóricas en investigaciones agropecuarias

Anuncio

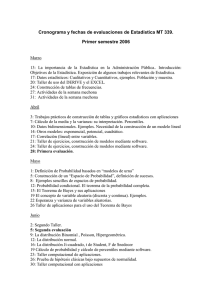

Instituto de Ciencia Animal

Departamento de Biomatemática

Métodos Estadísticos alternativos de análisis con variables

discretas y categóricas en investigaciones agropecuarias

Tesis en opción al grado científico de Doctor en Ciencias Veterinarias

Autora: Lic. Magaly Herrera Villafranca

Mayabeque

2013

Instituto de Ciencia Animal

Departamento de Biomatemática

Métodos Estadísticos alternativos de análisis con variables

discretas y categóricas en investigaciones agropecuarias

Tesis en opción al grado científico de Doctor en Ciencias Veterinarias

Autora: Lic. Magaly Herrera Villafranca

Tutoras: Dra. C. Caridad Walkiria Guerra Bustillo

Dra. C. Verena Torres Cárdenas

Mayabeque

2013

Pensamiento

Nunca antes en la historia de la Ciencia y la Estadística ha existido una mayor

necesidad para que haya interacción y colaboración entre científicos y

estadísticos.

D.E. Johnson, 2000

Agradecimientos

Mis más sinceros agradecimientos a todas las personas que de una forma u otra me han

ayudado y apoyado para la culminación de este trabajo:

Dra. C. Caridad Walkiria Guerra Bustillo, por su ayuda incondicional, por sus

sabios consejos, y estar siempre a mi lado, me demostró que con estudio y

constancia se puede llegar.

Dra. C. Verena Torres Cárdenas por la confianza que depositó en mí y colaborar

en mi formación.

Dr. C. José A. Bravo Iglesias por sus observaciones tan oportunas, y siempre

dispuesto a dar un consejo para mejorar el trabajo.

Mi amiga Lic. Lourdes Rodríguez Shade que, aunque siempre está peleando, me

apoyó durante el trabajo de investigación.

Mí siempre amigo Lic. Fermín Raúl Cobo Cuña que me ha soportado durante todo

este tiempo, y por su apoyo en el trabajo de tesis con sus observaciones

oportunas.

MSc. Profesora consultante Josefina de Calzadilla, por su ayuda y sus buenas

observaciones.

Dr. C. Alberto Caballero por su ayuda en la orientación de esta investigación,

desde el principio me aportó buenos consejos.

Yolaine Medina Mesa, siempre con su atención esmerada y su ayuda

incondicional.

Dr. C. Luis Mateo Fraga Benítez por su ayuda y siempre dispuesto a aclarar

cualquier duda.

Muchachitas las técnicas Aida Carmelita Noda Amorós y Lucía Rosario García

Sarduy, las cuales me animaron y me ayudaron en el procesamiento de la

información.

Lic. Sarai Gómez Camacho por su ayuda.

Yaisel Rodríguez González y Lyhen Sánchez Suárez.

Muchachitas del Departamento de Genética.

Lic. Nidia E. Fernández Ontivero por su colaboración y ayuda incondicional.

Los compañeros del Departamento de Matemática de La Universidad Agraria de

La Habana los que me apoyaron en el trabajo y me dieron muchos consejos.

Dr. C. Yasser Vásquez Alfonso, por su apoyo durante el trabajo de investigación y

su ayuda en la búsqueda de información referente al tema.

A mis compañeros del departamento de Monogástricos, especialmente a Lazarita.

Especial agradecimiento a Edis Dalia Arbelo Forte por su apoyo incondicional.

A Erludys Columbie Hernández, por su inestimable apoyo en el servicio de

mensajería.

Mis amigas y amigo de la biblioteca del ICA, Yeter Caraballo Rodríguez por su

ayuda incondicional en el procesamiento de la información, a Dianelis Mesa

Travieso por su apoyo, Daniela Rodríguez Carballoza, Ibrain A. Díaz Machado,

Yoandra Figueroa Puentes y Dayami Roque Chao por su ayuda en la búsqueda y

ubicación de la información bibliotecaria.

A todos muchas gracias

Dedicatoria

A mi madre querida

A mi padre

A mis hermanos

A mis abuelos (E.P.D)

A mis amigos

A la Revolución

SÍNTESIS

Con el objetivo de evaluar la efectividad de Métodos Estadísticos alternativos de

análisis con variables discretas y categóricas, se aplicó una encuesta estadística

bibliométrica sobre el empleo de Métodos Estadísticos no paramétricos y una

encuesta a investigadores para verificar el conocimiento sobre Métodos

Estadísticos alternativos para evitar el uso inadecuado de la transformación de

datos, en investigaciones agropecuarias y afines. Se analizan 100 variables

correspondientes a los Modelos de Análisis de Varianza simple y doble, de efectos

fijos. Las transformaciones de datos aplicadas fueron:

X;

X 0,375 ; arcoseno

( p ) y Log X. Se verificó el cumplimiento de los supuestos teóricos del Análisis de

Varianza, con y sin transformación de datos. Los resultados evidenciaron que el

empleo de la trasformación de datos solo fue efectiva en el 13% de los casos

analizados. Los Modelos de Análisis de Varianza (ANAVA) paramétrico y no

paramétricos presentaron resultados similares. Se aplicó el Análisis de

Componentes Principales Categórico (CATPCA) para realizar un análisis integral

de indicadores estadísticos, sobresalen por sus altas correlaciones negativas, la

potencia y la probabilidad de error tipo I en el ANAVA paramétrico (con y sin

transformación) y el no paramétrico. En un análisis comparativo del Modelo Lineal

General (MLG) y el Modelo Lineal Generalizado (MLGnz) se obtuvo que las

probabilidades de error tipo I en ambos modelos son similares, por lo que se

sugiere el MLGnz como una alternativa de análisis, pues la variable respuesta no

requiere del cumplimiento de los supuestos del ANAVA paramétrico. Finalmente

se elaboró una propuesta de acciones metodológicas relacionadas con la

aplicación del Modelo de Análisis de Varianza.

ÍNDICE

ÍNDICE

INTRODUCCIÓN

CAPÍTULO I. REVISIÓN BIBLIOGRÁFICA

Pág.

1

8

1.1 Métodos Estadísticos paramétricos y no paramétricos

8

1.2 Consecuencias del incumplimiento de los supuestos teóricos

básicos del Modelo Análisis de Varianza paramétrico

10

1.3 Potencia de una dócima, tamaño de muestra, probabilidades

de errores (tipo I y II) y tamaño de efectos

12

1.4 Transformación de datos. Origen e incidencia en las

investigaciones agropecuarias

18

1.5 Modelo Lineal Generalizado

21

1.5.1 Origen y desarrollo

21

1.6 Otros Métodos Estadísticos para el análisis con variables

discretas y categóricas

26

CAPÍTULO II. LA ENCUESTA ESTADÍSTICA EN LA

CAPTACIÓN DE INFORMACIÓN Y SU USO

32

2.1 Introducción

32

2.2 Materiales y métodos

32

2.2.1 Encuesta estadística bibliométrica

32

2.2.2 Encuesta estadística a los investigadores

33

2.2.3 Organización, procesamiento y análisis estadístico de la

información

34

2.3 Resultados y discusión

36

2.3.1 Encuesta estadística bibliométrica

36

2.3.2 Encuesta estadística a los investigadores

44

2.3.3 Diagnóstico a partir de la encuesta estadística a los

investigadores: Matriz DAFO

47

2.3.4 Consideraciones parciales

CAPÍTULO III. MODELOS DE ANÁLISIS DE VARIANZA

PARAMÉTRICO Y NO PARAMÉTRICO. USO DE

TRANSFORMACIÓN DE DATOS

49

50

3.1 Introducción

50

3.2 Materiales y métodos

51

3.2.1 Características principales de las investigaciones

51

3.2.1.1 Experimentos con Diseño Completamente Aleatorizado

51

3.2.1.2 Experimentos con Diseño de Bloques al Azar

59

3.2.2 Procesamiento y análisis estadístico de la información

3.3 Resultados y discusión

3.3.1 Modelos de Análisis de Varianza simple y doble

63

66

66

3.3.1.1 Cumplimiento de supuestos y transformación de datos

66

3.3.1.2 Probabilidad de error tipo I y potencia de la dócima F

69

3.3.2 Consideraciones parciales

72

3.3.3 Análisis de Componentes Principales Categórico. Aplicación

a indicadores de los Modelos de Análisis de Varianza

73

3.3.4 Consideraciones parciales.

83

CAPÍTULO IV. El MODELO LINEAL GENERALIZADO.

APLICACIÓN A DIFERENTES DISTRIBUCIONES.

84

4.1 Introducción

84

4.2 Materiales y métodos

84

4.2.1 Características principales de las investigaciones

84

4.2.2 Modelo Lineal Generalizado

85

4.2.2.1 Procesamiento y análisis estadístico de la información

86

4.3 Resultados y discusión

87

4.3.1 Modelo Lineal General y Modelo Lineal Generalizado.

Probabilidad de error tipo I

87

4.3.2 Análisis de Componentes Principales Categórico, para el

análisis de indicadores estadísticos del Modelo Lineal

General y del Modelo Lineal Generalizado

88

4.3.3 Análisis comparativo del Modelo Lineal General y el Modelo

Lineal Generalizado y acciones metodológicas relacionadas

con estos modelos

91

4.3.4 Consideraciones parciales

95

4.3.5 Propuesta de acciones metodológicas para investigaciones

relacionadas con la aplicación del Modelo de Análisis de

Varianza

96

CONCLUSIONES

99

RECOMENDACIONES

100

REFERENCIAS BIBLIOGRÁFICAS

ANEXOS

ÍNDICE DE ABREVIATURAS

ANAVA: Análisis de Varianza.

ARE: Eficiencia Asintótica Relativa.

CATPCA: Análisis de Componentes Principales Categórico.

CATREG: Regresión Categórica.

Cumpl S/T: Cumplimiento de los supuestos sin transformación.

Cumpl C/T: Cumplimiento de los supuestos con transformación.

C/T: Con transformación.

DCA: Diseño Completamente Aleatorizado.

DBA: Diseño de Bloques al Azar.

DDGS: Granos de destilería soluble.

Devia MLGnz: Devianza del Modelo Lineal Generalizado.

Distcod: Distribución con código.

Matriz DAFO: Matriz de Fortalezas, Debilidades, Oportunidades y Amenazas.

MLG: Modelo Lineal General.

MLGnz: Modelo Lineal Generalizado.

No. tto: Número de tratamiento.

PerrorIF: Probabilidad de error tipo I de la dócima F de Fisher.

PerrorI 2 : Probabilidad de error tipo I de la dócima 2 .

Potencia C/T: Potencia con transformación.

Potencia S/T: Potencia sin transformación.

S/T: Sin transformación.

SCerror MLG: Suma de cuadrado del error del Modelo Lineal General.

TM: Tamaño de muestra.

TMutil: Tamaño de muestra utilizado.

Tto: Tratamiento.

Valorp NP: Valor de la probabilidad de error tipo I no paramétrico.

Valorp S/T: Valor de la probabilidad de error tipo I sin transformación.

Valorp C/T: Valor de probabilidad de error tipo I con transformación.

ÍNDICE DE TABLAS

Tabla 1.1. Escalas de medidas e indicadores numéricos en los procedimientos

estadísticos paramétricos y no paramétricos.

Tabla 1.2. Relación entre el tamaño de muestra y cumplimiento de los supuestos

teóricos en procedimientos paramétricos y no paramétricos.

Tabla 1.3. Modelos más empleados según la metodología del Modelo Lineal

Generalizado.

Tabla 1.4. Comparación entre el Modelo Lineal General y el Modelo Lineal

Generalizado.

Tabla 1.5. Funciones de enlace más empleadas en el Modelo Lineal

Generalizado.

Tabla 1.6. Métodos Estadísticos relacionados con variables cualitativas.

Tabla 2.1. Encuestados por departamento.

Tabla 2.2. Interpretación de los valores del Stress (S).

Tabla 2.3. Bondad de ajuste de la configuración de los datos para los Métodos

Estadísticos no paramétricos.

Tabla 2.4. Bondad de ajuste de las temáticas por revistas donde se aplica los

Métodos Estadísticos no paramétricos.

Tabla 2.5. Transformaciones de datos más empleadas, según la encuesta

aplicada a los investigadores.

Tabla 2.6. Aspectos más frecuentes en las respuestas los investigadores.

Tabla 2.7. Bondad de ajuste de los resultados a los investigadores.

Tabla 2.8. Resultados de los pesos de las variables por cada dimensión.

Tabla 2.9. Resultados de la Matriz DAFO.

Tabla 3.1. Resumen del cumplimiento de los supuestos teóricos del ANAVA.

Tabla 3.2. Frecuencia de coincidencias en la toma de decisión.

Tabla 3.3. Resultados de la dócima de McNemar para los valores de probabilidad

de error tipo I.

Tabla 3.4. Resultados de la dócima de McNemar para las potencias de la dócima

F de Fisher.

Tabla 3.5. Resultados del coeficiente Alfa de Cronbach para los indicadores de los

Diseños Completamente Aleatorizado y Bloques al Azar.

Tabla 3.6. Resultados de los pesos de los indicadores por cada dimensión para

los Diseños Completamente Aleatorizado y Bloques al Azar.

Tabla 3.7. Resultados del coeficiente Alfa de Cronbach para los experimentos con

arreglos factorial de los tratamientos.

Tabla 3.8. Resultados de los pesos de los indicadores por cada dimensión para

los experimentos con arreglo factorial de los tratamientos.

Tabla 3.9. Estimaciones de los coeficientes de regresión en el CATREG para

potencias sin transformación.

Tabla 3.10. Importancia de los indicadores en CATREG para potencias sin

transformación.

Tabla 3.11. Estimaciones de los coeficientes de regresión en el CATREG para

potencias con transformación.

Tabla 3.12. Importancia de los indicadores en CATREG para potencias con

transformación.

Tabla 4.1. Distribuciones y funciones de enlace.

Tabla 4.2. Frecuencia de los rangos de probabilidad de error tipo I de las dócimas

F de Fisher y 2 .

Tabla 4.3. Resultados del coeficiente Alfa de Cronbach para el Modelo Lineal

General y Modelo Lineal Generalizado.

Tabla 4.4. Resultados de los pesos de los indicadores por cada dimensión para el

Modelo Lineal General y el Modelo Lineal Generalizado.

Tabla 4.5. Resultados de los criterios de bondad de ajuste al aplicar el Modelo

Lineal Generalizado.

Tabla 4.6. Resultados de los valores de probabilidad de error tipo I para el Modelo

Lineal General y el Modelo Lineal Generalizado.

ÍNDICE DE FIGURAS

Figura 2.1. Revistas relacionadas con la aplicación de los Métodos Estadísticos

no paramétricos.

Figura 2.2. Métodos Estadísticos no paramétricos más usados en estudios

agropecuarios y biológicos.

Figura 2.3. Revistas por temáticas con aplicación de los Métodos Estadísticos no

paramétricos.

.

Figura 2.4. Temáticas por revistas que emplean Métodos Estadísticos no

paramétricos para el análisis de sus investigaciones.

Figura 2.5. Necesidad de aplicar la transformación de datos.

Figura 3.1. Biplot de los indicadores analizados.

Figura 3.2. Biplot de los indicadores para los experimentos con arreglo factorial de

los tratamientos.

Figura 4.1. Biplot de los indicadores estadísticos de los Modelos Lineal General y

Lineal Generalizado.

Figura 4.2. Propuesta de acciones metodológicas para investigaciones con la

aplicación del Modelo de Análisis de Varianza.

ÍNDICE DE ANEXOS

Anexo 1. Verificación de los supuestos teóricos básicos y consecuencias de su

incumplimiento en el Análisis de Varianza.

Anexo 2. Encuesta aplicada a los investigadores.

Anexo 3. Matriz de correlaciones de las variables transformadas por dimensión

para los Diseños Completamente Aleatorizado y Bloques al Azar.

Anexo 4. Matriz de correlaciones de las variables transformadas para los diseños

con arreglos factorial de los tratamientos.

Anexo 5. Matriz de correlaciones de las variables transformadas de los Modelos

Lineal General y Lineal Generalizado.

INTRODUCCIÓN

INTRODUCCIÓN

La Estadística es una de las ramas de la Matemática de mayor universalidad, ya

que en su devenir histórico muchos de sus métodos se han desarrollado para

resolver situaciones específicas en diferentes esferas del conocimiento y la

ciencia.

Méndez (1993) señala que la Estadística se ha convertido en una forma de pensar

y una herramienta muy poderosa en muchas áreas de la actividad humana, como

son: la investigación científica, los procesos productivos y de servicios, en las

acciones y decisiones de gobiernos de países, estados e instituciones, entre otras.

Los Métodos Estadísticos como elementos de apoyo en la investigación agrícola

son fundamentales, puesto que cuantifican y cualifican objetivamente los

resultados de la investigación, estos métodos y procedimientos varían según la

naturaleza y estructura del resultado experimental. Así, si las Ciencias Biológicas

proponen o innovan procedimientos y técnicas que describan la variabilidad de

poblaciones agronómicas, entonces es necesario proveer de herramientas

estadísticas a las nuevas propuestas experimentales (Martínez, 1995).

Di Rienzo et al. (2005) señalan que la enseñanza de la Estadística en las Ciencias

Agropecuarias no es un tributo a la modernidad, sino una larga tradición que se

origina en los trabajos de Fisher que, a comienzos del siglo XX, sentaron las

bases de la Estadística aplicada a la experimentación agrícola.

1

El Análisis de Varianza paramétrico es el Método Estadístico más difundido en el

análisis de datos, desarrollado por Fisher en la década de los años 20 del pasado

siglo, siendo necesario para su empleo el cumplimiento de los supuestos teóricos

básicos, en los que se enmarcan: que los errores experimentales deben ser

normalmente distribuidos; con homogeneidad de varianza e independientes, así

como la aditividad del modelo. Sin embargo cuando algunos de estos supuestos

teóricos fallan, suelen emplearse otros métodos de análisis, como el uso de

transformación de datos y Métodos Estadísticos no paramétricos, entre otros.

Los Métodos Estadísticos no paramétricos presentaron un acelerado desarrollo en

la década de los años 50, en estudios relacionados con las Ciencias Sociales, de

la Conducta, Médicas y Biológicas. Sin embargo en la literatura consultada se

aprecia que estos métodos han sido poco aplicados en las investigaciones

desarrolladas en el campo de las Ciencias Agropecuarias, siendo estos una

alternativa ante el incumplimiento de los supuestos teóricos básicos de algunos

Métodos Estadísticos paramétricos, como es el caso del Análisis de Varianza.

De Calzadilla (1999) y De Calzadilla et al. (2002) al aplicar procedimientos de la

Estadística no paramétrica en investigaciones agropecuarias, en las condiciones

de Cuba, hacen referencia a la poca aplicación de estos métodos en esta área de

la ciencia y detectaron poca efectividad en el uso de la transformación de datos.

Por otra parte, Cristo (2001), al investigar el comportamiento de dócimas no

paramétricas respecto a sus homólogas paramétricas en distribuciones no

2

normales

y

su

eficiencia,

recomendó

que

con

muestras

pequeñas

e

incumplimiento de los supuestos del Análisis de Varianza, lo más conveniente es

el empleo de Métodos Estadísticos no paramétricos.

Con posterioridad, Vásquez (2011) realizó una contribución al tratamiento

estadístico de datos con distribución Binomial en el Modelo de Análisis de

Varianza, en un diseño de Bloques al Azar y Cabrera (2012) evaluó sin éxito el

comportamiento de diferentes transformaciones de datos en una investigación

relacionada con plagas agrícolas, por lo que fue más conveniente la aplicación del

Análisis de Varianza no paramétrica.

Ojeda (2004) señala que la Modelación Estadística se puede considerar como un

área de estudio y especialización, en la que convergen los aspectos teóricos,

metodológicos y computacionales de los Modelos Estadísticos. Este autor indica

que, sin temor a equívoco, es posible asegurar que el detonante de la Modelación

Estadística en datos discretos, lo constituye el trabajo de Nelder y Wedderburn

(1972), que presenta, a partir de los Modelos Lineales Generalizados, un marco

teórico general para el estudio de los Modelos Estadísticos.

El Modelo Lineal Generalizado ha sido muy utilizado en diversas áreas de la

investigación, con el objetivo de dar respuesta al incumplimiento de los supuestos

teóricos del Análisis de Varianza, y al igual que los Métodos Estadísticos no

paramétricos, han sido una alternativa de análisis, principalmente cuando las

variables son de tipo discretas y categóricas, lo cual corroboran Ojeda (2004) y

3

Fox (2007). En las Ciencias Agropecuarias en Cuba se han encontrado pocas

aplicaciones de estos modelos y se considera que pueden ser una alternativa

viable para el análisis.

Las investigaciones realizadas resultan antecedentes necesarios de gran valor

científico, para identificar determinadas situaciones en cuanto al uso de la

transformación de datos y de los Métodos Estadísticos no paramétricos, pero se

considera que con el estado actual de la ciencia, se hace necesario profundizar en

nuevas acciones, que generen un núcleo de orientaciones científicas y

metodológicas, que guíen la aplicación de estos procedimientos en la actividad

científico-investigativa, para evitar el:

Uso inadecuado de la transformación de datos.

Empleo de la trasformación de datos sin que se resuelva el cumplimiento de

los supuestos teóricos básicos del Análisis de Varianza.

No empleo de Métodos Estadísticos alternativos, ante el incumplimiento de

los supuestos teóricos básicos del Análisis de Varianza.

Por lo que se identifica como Problema de investigación: ¿Cómo evitar el uso

inadecuado de la transformación de datos en variables discretas y categóricas en

el Modelo de Análisis de Varianza de efectos fijos, en investigaciones

agropecuarias?

4

Objeto de estudio: La transformación de datos considerando variables discretas y

categóricas en el Modelo de Análisis de Varianza de efectos fijos, en

investigaciones agropecuarias.

Hipótesis

Si se emplean Métodos Estadísticos alternativos de análisis con variables

discretas y categóricas, se evitaría un uso inadecuado de la transformación de

datos en los Modelos de Análisis de Varianza de efectos fijos.

Objetivo general

Evaluar la efectividad de Métodos Estadísticos alternativos para evitar el uso

inadecuado de la transformación de datos con variables discretas y categóricas en

los Modelos de Análisis de Varianza de efectos fijos, en investigaciones

agropecuarias.

Objetivos específicos

1. Diagnosticar el estado actual del uso de la transformación de datos y de

Métodos Estadísticos no paramétricos en investigaciones agropecuarias en

Cuba.

2. Evaluar el comportamiento de la transformación de datos en el

cumplimiento de los supuestos teóricos básicos con variables discretas y

5

categóricas en los Modelos de Análisis de Varianza simple y doble de

efectos fijos.

3. Establecer criterios de valor teórico-práctico, a partir de un análisis integral

de indicadores estadísticos de los Modelos de Análisis de Varianza

paramétricos y no paramétricos y del Modelo Lineal Generalizado.

4. Proponer acciones metodológicas para investigaciones relacionadas con la

aplicación del Modelo de Análisis de Varianza.

Novedad científica

La novedad científica radica en que por primera vez en las condiciones de la

Ciencia Agropecuaria en Cuba, se establecen Métodos Estadísticos alternativos

para evitar el uso inadecuado de la transformación de datos, con variables

discretas y categóricas, en los Modelos de Análisis de Varianza de efectos fijos.

Aporte social

La capacitación a técnicos y usuarios de los Métodos Estadísticos, mediante

cursos, talleres, conferencias y seminarios, entre otras modalidades, sobre el uso

adecuado de la transformación de datos, los Modelos de Análisis de Varianza

paramétricos y no paramétricos, y el Modelo Lineal Generalizado, con variables

discretas y categóricas en la investigación científica.

6

Aporte práctico

Se proponen acciones metodológicas para el tratamiento y el análisis de la

información experimental con variables discretas y categóricas, en los aspectos

relacionados con el uso de la transformación de datos y alternativas de análisis

basadas en los Modelos de Análisis de Varianza paramétricos y no paramétricos,

y el Modelo Lineal Generalizado.

7

CAPÍTULO I

REVISIÓN BIBLIOGRÁFICA

CAPÍTULO I. REVISIÓN BIBLIOGRÁFICA

1.1. Métodos Estadísticos paramétricos y no paramétricos

En la docimasia de hipótesis, los Métodos Estadísticos paramétricos son los que

se utilizan con más frecuencia, siendo necesario para su empleo el cumplimiento

de diversos supuestos sobre la población que se estudia.

La técnica conocida como Análisis de Varianza (ANAVA), fue desarrollada por R.

A. Fisher para facilitar el análisis e interpretación de los datos desde ensayos de

campo y experimentos de laboratorio, en la agricultura e investigaciones biológicas

(Eisenhart, 1947).

El ANAVA, es una de las técnicas más utilizadas en el proceso de investigación

Norell (2003). Es descrito por Tejedor (1999); Khan y Rayner (2003) y Spiegel et

al. (2003) como una colección de modelos estadísticos y sus procedimientos

asociados, apropiada para evaluar la igualdad entre poblaciones o tratamientos,

en el cual la varianza está fraccionada en ciertos componentes, debido a

diferentes factores o variables explicativas, incluidas en el modelo.

Los Métodos Estadísticos no paramétricos no requieren de supuestos severos

sobre la población que se estudia. Según Servy et al. (2007) una prueba

Estadística no paramétrica está basada en un modelo que especifica sólo

condiciones muy generales y ninguna acerca de la forma específica de la

distribución de la población de la que fue tomada la muestra.

8

Los Métodos Estadísticos no paramétricos resultan una alternativa importante, ya

que no dependen de la distribución de los datos, pueden usarse en caso de

muestras pequeñas y, en general, resultan más rápidos y sencillos de aplicar

(Siegel y Castellan 1995, Gómez et al. 2003 y Santos et al. 2005). En este sentido

se considera que una alternativa está dada en el ANAVA paramétrico, cuando se

incumplen los supuestos con serias implicaciones en el análisis.

A partir de lo señalado anteriormente se establecen las diferencias entre los

estadígrafos correspondientes en el empleo de los procedimientos paramétricos y

no paramétricos, autores como Siegel y Castellan (1995), De Calzadilla (1999) y

Guerra et al. (2000) se han referido al respecto, por lo que se resumen en la Tabla

1.1.

Tabla 1.1. Escalas de medidas e indicadores numéricos en procedimientos

estadísticos paramétricos y no paramétricos.

Procedimientos

Paramétricos

Aspectos a analizar

Escala de Medida

Localización o Posición

Dispersión

Asociación

Métricas

Media aritmética

Media geométrica

Media armónica

Mediana

Moda

Varianza

Desviación típica o estándar

Coeficiente de variación

Correlación de Pearson

Covarianza

No Paramétricos

Métricas y no métricas

Mediana

Cuartiles

Percentiles

Rango medio

Rango

Rango intercuartílico

Rango interpercentílico

Correlación de Rango de

Spearman

Correlación de Kendall

Coeficiente de contingencia

9

1.2. Consecuencias del incumplimiento de los supuestos teóricos básicos

del Modelo Análisis de Varianza paramétrico

La distribución Normal de los errores, señalan Steel y Torrie (1992) y Peña (1994),

tiene poca influencia en el ANAVA para comparar medias, dado que esta técnica

es robusta frente a desviaciones de los errores; sin embargo, plantean que la falta

de normalidad puede afectar otros supuestos como, la homogeneidad de varianza,

sobre todo, cuando el número de observaciones de los grupos son muy diferentes,

sin embargo cuando se analizan componentes de varianza, la normalidad si puede

afectar el resultado del análisis.

El incumplimiento de algunos de los supuestos del ANAVA pude afectar tanto los

niveles de significación como la sensibilidad de la prueba F de Fisher o t de

Student, lo que conlleva a la pérdida de exactitud en los estimadores obtenidos

para los efectos de tratamientos (Cochran y Cox, 1999 y Vilar, 2011).

Las decisiones estadísticas, son probabilísticas y por tanto, lo más importante no

es tomar una decisión, sino conocer la probabilidad de equivocarse al tomar esta

(Miranda 1997). Los modelos de análisis estadístico, como el ANAVA son

sensibles a las propiedades estadísticas de los términos de error aleatorio del

modelo lineal (Avanza et al. ,2006 y Balzarini et al., 2008).

El incumplimiento de alguno de estos supuestos lleva a conclusiones erróneas

como rechazar la hipótesis nula siendo verdadera o viceversa, lo que trae consigo

10

resultados falsos en los experimentos que al materializarse en los sistemas de

producción introducen pérdidas económicas y error en el proceso de toma de

decisiones (Pérez et al., 2002).

Martín y Luna (1994), señalan que la heterogeneidad de varianzas viene

acompañada de variables no normales, por lo que ante esta situación

recomiendan aplicar transformaciones y además expresan que en tales

circunstancias la misma transformación que estabiliza las varianzas suele

normalizar la respuesta.

Sin embargo, Peña (1994) ha sugerido que antes de transformar los datos se debe

estudiar gráficamente la distribución de los residuos y si la misma resulta muy

asimétrica, entonces conviene realizar la transformación, lo cual resulta una

opción antes de proceder a la misma.

En el Anexo 1 se establecen los supuestos teóricos del ANAVA, las dócimas de

uso más frecuente para normalidad, homogeneidad e independencia, así como

sus estadísticos, características y consecuencias de su incumplimiento en el

análisis estadístico.

En sentido general el incumplimiento de algunos de estos supuestos pueden

incidir en los resultados investigativos y por ende pueden conllevar a conclusiones

erróneas como rechazar la hipótesis nula siendo verdadera o viceversa. Cuando

11

estos supuestos teóricos del ANAVA son satisfechos las inferencias del modelo

estadístico son mejores.

1.3. Potencia de una dócima, tamaño de muestra, probabilidades de errores

(tipo I y II) y tamaño de efectos

Bono y Arnau (1995), realizan un recuento histórico del desarrollo del concepto de

potencia de una dócima, señalando que este se le atribuye a Neyman y Pearson

en el período de 1928 al 1933, apareciendo otros autores que tenían en cuenta la

potencia estadística, como Cox en 1948, McNemar en 1960 y Tukey en 1960,

entre otros.

Estos autores señalan que hay dos formas de estimar la potencia, a priori y a

posteriori, la primera alerta al investigador sobre el tamaño de muestra necesario

para una potencia adecuada y con este fin se construyen las tablas de potencia.

La potencia a posteriori, es importante en la interpretación de los resultados de

estudios ya acabados, que es el caso analizado en este trabajo de investigación.

Numerosos autores, entre ellos Kreyszig (1974) y Ostle (1974) concuerdan en

señalar que un experimento dado cuando se prueba una hipótesis específica, el

valor 1-β es conocido como la potencia de la prueba, esta expresión se expresa en

función del parámetro verdadero, siendo conocida como función de potencia y es

expresada como 1-β (θ), donde θ representa el valor verdadero del parámetro.

12

Mood y Graybill (1972) y Rodríguez (2008) denotan a la función de potencia como:

η (θ)= 1- β(θ) = 1- P(II)= P(rechazar H0| H0 es falsa), y se tiene que:

α = P(I), si θ = θ0 Є H0 (hipótesis nula)

η (θ)=

1- β(θ), si θ = θ1 Є H1 (hipótesis alternativa)

En esencia la función de potencia toma el valor α, cuando se cumple la hipótesis

nula, por lo que resulta muy conveniente que η (θ) tome valores bajos cuando se

cumple H0 (α) y tome altos valores cuando se cumple H1 (1- β(θ) ).

Scheffé (1959) hace referencia a la potencia de la dócima F en Modelos de

Análisis de Varianza con efectos fijos, observaciones independientes y

homogeneidad de varianzas, como la probabilidad β de rechazar la hipótesis

probada, siendo expresada por:

β = Pr{F´ (ν1, ν2, δ) > Fα(ν1, ν2)}, donde:

F´ (ν1, ν2, δ) es llamada distribución F no central, con ν1 y ν2 grados de libertad con

parámetro de no centralidad δ.

Fα (ν1, ν2) es un percentil de la distribución F, con ν1, ν2 grados de libertad del

numerador y denominador respectivamente.

13

Este autor se refiere a las tablas de potencia calculadas por Tang en 1938, solo

para los valores de α = 0,01 y 0,05 y reproduce los gráficos de potencia para la

dócima F, construidos por Pearson y Hartley en 1951.

Bono y Arnau (1995), señalan que las estimaciones de la potencia estadística

quedan determinadas por tres componentes:

Tamaño muestral, es decir cuanto más grande sea la muestra, mayor será la

potencia.

Nivel de significación, dado que al incrementarse la probabilidad de error tipo I,

la potencia también aumenta.

Tamaño del efecto (TE) o grado en que el fenómeno de interés está presente,

de modo que cuando los efectos son grandes, la potencia se incrementa.

Sabín (1999) realizó un estudio sobre la determinación de la potencia a posteriori,

utilizando experimentos conducidos en el Instituto de Ciencia Animal con diseños

clásicos, a partir de la expresión de potencia dada por Scheffé (1959), utilizó la

aproximación dada por Patnaik en 1949, mediante la cual se aproxima la F no

central a una F central.

Camacho (2007) en relación con la potencia estadística, coincide con los tres

aspectos anteriores, incluyendo uno muy importante que es la variabilidad de la

respuesta estudiada.

Siegel y Castellan (1995) en el área de la Estadística no paramétrica, introducen el

concepto de Potencia – Eficiencia, referido al incremento en el tamaño de la

14

muestra necesario para hacer la prueba B tan poderosa como la A, al ser la

prueba A de las conocidas, la más poderosa de su tipo (cuando se usa con datos

que satisfacen sus condiciones), al ser la prueba B, que se presta al mismo diseño

de investigación, tan poderosa con Nb casos como la prueba A con Na casos, con

lo que se tiene:

Potencia - Eficiencia de la prueba B = Na/Nb (100).

Fraser (1957) y Gibbons (1971) proponen que para obtener una medida asintótica

útil para la Eficiencia relativa de una prueba no paramétrica con respecto a su

homóloga paramétrica, la Eficiencia Asintótica Relativa, usualmente conocida como

ARE (en inglés, Asymptotic Relative Efficiency), conocido también como Eficiencia

de Pitman.

20

Daniel (1978) plantea que el ARE de la dócima de Kruskal-Wallis es de 0,955,

comparada con la prueba paramétrica más poderosa, F de Fisher. Este mismo

autor refiere que en el caso de la dócima Friedman esta posee un ARE de 0,955

(k/k+1), cuando las poblaciones son normales; en poblaciones con distribución

uniforme el ARE se expresa como k/k+1 y en poblaciones que poseen distribución

exponencial doble este se identifica como 3/2 (k/k+1)

Johnson (1990) indica que la elección de un contraste o prueba de hipótesis no

puede apoyarse únicamente en su poder (potencia) y eficiencia. Algunas veces la

utilización de ciertas pruebas de hipótesis se ve forzada por los datos que se

15

analizan, cuando debe llegarse a una decisión al respecto, hay que considerar tres

factores:

El poder del contraste.

La eficiencia del contraste.

El tipo de datos y la cantidad de observaciones disponibles.

Este mismo autor señala que los métodos no paramétricos desperdician

información, pues sacrifican el valor de la variable sustituyéndolas por un signo o

un rango, siendo por lo general menos eficientes que sus contrapartes

paramétricas.

Es real lo que plantea este autor, dado por el criterio de Potencia-Eficiencia

propuesto por Siegel (1970), Daniel (1978) y Siegel y Castellan (1995), sin

embargo, se sugieren los Métodos Estadísticos no paramétricos como alternativa

de análisis, cuando existan serias implicaciones por el incumplimiento de los

supuestos teóricos de los Métodos Estadísticos paramétricos o por otros criterios

técnicos aportados por los especialistas.

Álvarez (2008) expresa que en muestras menores de 11 casos, la potencia

estadística de las pruebas paramétricas y no paramétricas es equivalente,

teniendo en cuenta que las exigencias para las pruebas no paramétricas son

menores y que detectar violaciones de las condiciones de aplicabilidad en las

pruebas paramétricas es más difícil.

16

Generalmente, en la práctica no se tiene en cuenta la relación inversa que existe

entre estas dos probabilidades (α y β) y se hace referencia exclusivamente a los

niveles de significación obtenidos en el ANAVA, sin tomar en consideración que

para los valores bajos de α se puede obtener valores altos de β que pueden poner

en riesgo la toma de decisiones (Torres y Segui, 2001).

López y Romero (1986) realizan un análisis detallado donde exponen la relación

que existe entre el tamaño de muestra y el cumplimiento de los supuestos

teóricos, con el método estadístico a utilizar. En la tabla 1.2 se muestra un

resumen a partir de este enfoque.

Tabla 1.2. Relación entre el tamaño de muestra y cumplimiento de los supuestos

teóricos de los procedimientos paramétricos y no paramétricos.

Tamaño de

muestra

Pequeña

Grande

Cumplimiento de los supuestos

Se cumplen

Se duda

No se cumplen

Paramétrica

No paramétrica

No paramétrica

Paramétrica

Análisis más

profundo para

valorar cual es la

mejor opción

No paramétrica

Cristo (2001), en una investigación relacionada con el comportamiento de las

dócimas no paramétricas respecto a las paramétricas en distribuciones no

normales, así como la eficiencia de estos métodos con sus homólogos

paramétricos, obtuvo que al emplear muestras pequeñas con el incumplimiento de

los supuestos del Análisis de Varianza, lo más conveniente es el empleo de los

Métodos Estadísticos no paramétricos.

17

Menchaca (1974, 1975); Venereo (1976); Caballero (1979) y Menchaca y Torres

(1985), aportaron tablas de tamaños de muestra y número de réplicas en Diseños

Completamente Aleatorizados, Bloques al Azar, Cuadrado Latino y Diseños de

Cambio, teniendo en consideración: la máxima diferencia estandarizada entre dos

medias (∆), la cantidad de tratamientos (t), el nivel de significación (α) y la potencia

de la dócima (1-β), las cuales representan valiosas herramientas de trabajo para

investigadores de diferentes ramas y se considera que no han sido aprovechadas

con amplitud.

En la actualidad, con el avance de la informática, existen paquetes estadísticos

que incluyen el cálculo de la potencia, como el InfoStat, G Power y el SPSS, entre

otros.

1.4. Transformación de datos. Origen e incidencia en las investigaciones

agropecuarias

Bartlett (1947) plantea que el propósito de las transformaciones de datos es

buscar una nueva escala de medida con el objetivo de hacer el análisis más

válido.

Box y Cox (1964) propusieron una técnica de transformación de potencia a las

observaciones con el fin de reducir anomalías, tales como: la no-aditividad, la no

normalidad y la heterocedasticidad.

18

Y ( )

0

log Y

0

Yλ =

(para Y > 0)

Menchaca (1973) señala que Box y Cox en 1964, consideran una familia

paramétrica de transformaciones de Y en Y(λ), donde se define λ como una

transformación particular, ellos asumen que para algún λ desconocido, las

observaciones transformadas Yi(λ) (i= 1, 2, …, n) satisfacen las hipótesis de base,

por otra parte Sakia (1992) plantea que esta transformación es conocida

precisamente como Box-Cox y ha mostrado una amplia flexibilidad y aplicabilidad

desde sus primeras apariciones.

Las transformaciones de datos se utilizan con frecuencia en el Análisis de

Varianza, siendo una alternativa, siempre que sean bien empleadas, pues se ha

detectado en varios estudios un uso indiscriminado de estas sin tener en cuenta el

cumplimiento de los supuestos teóricos, antes y después de aplicadas, ya que

estos no son verificados.

Peña y Peña (1986) manifiestan, que las transformaciones Box-Cox constituyen

una alternativa razonable para lograr la normalidad, más potente que la mayoría

de los procedimientos existentes usados en distribuciones asimétricas.

Según Méndez (2000) cuando los datos son normales, pero las varianzas son

heterogéneas, se utiliza diferentes transformaciones de datos (logarítmica, raíz

19

cuadrada o inversa), estas se vuelven a comprobar y si las varianzas son

homogéneas es correcto utilizar un ANAVA.

Cabrera et al. (2012) plantean que muchos datos provenientes de poblaciones de

plagas por ser datos discretos por lo regular no cumplen los supuestos teóricos y

cuando se emplean las transformaciones de datos no se ajustan a una distribución

Normal.

Entre las transformaciones de datos más empleadas en la rama agropecuaria se

encuentran: la raíz cuadrada, logarítmica y arcoseno ( p ), que están dadas de

acuerdo a la naturaleza de la variable en estudio.

Se considera que en las investigaciones agropecuarias u otras, el uso de la

transformación de datos ponen en evidencia:

El inconveniente de que los datos pasan a una escala de medida que no es

la original, por lo tanto se debe tener la debida precaución en el análisis de

los resultados.

Que estudios previos científicamente fundamentados han mostrado la poca

efectividad de su empleo.

Es por ello, que se debe propiciar el uso de Métodos Estadísticos alternativos más

flexibles ante el incumplimiento de los supuestos del Análisis de Varianza, como

es el caso de la Estadística no paramétrica u otros que tengan implícito diferentes

distribuciones de los datos originales.

20

1.5 Modelo Lineal Generalizado

1.5.1. Origen y desarrollo

Nelder y Wedderbum (1972) proponen una teoría unificadora de Modelación

Estadística que le dieron el nombre de Modelo Lineal Generalizado (MLGnz),

como una extensión de los Modelos Lineales Generales clásicos (MLG). Estos

autores mostraron una serie de técnicas comúnmente estudiadas de forma

separada que pueden ser reunidas bajo ese nombre MLGnz.

Los autores antes mencionados presentaron el concepto de MLGnz, y

posteriormente McCullag y Nelder (1989) presentan una amplia información sobre

estos modelos. La esencia radica en que el valor esperado de la variable

respuesta es denotada por μ = E(Y | X ) que se relaciona con la parte sistemática

del modelo como:

E( Y | X ) g( X) g( )

Donde:

Y: es una función monótona

η: predictor lineal

η = Xβ: función que relaciona μ

g: función de enlace

Por otra parte Mongotmery et al. (2005) y Faraway (2006) plantean que un MLGnz

está definido por dos componentes específicos. La respuesta debe ser un

21

miembro de la distribución de la familia exponencial y la función de enlace

describe de que forma se relacionan la media de la respuesta y una combinación

lineal de los predictores.

En el MLGnz la distribución de Y de la familia exponencial es de la forma:

y b

F (yІθ, ) = exp

+ c y,

a

Donde:

θ: se conoce como el parámetro canónico y representa la localización.

: es el parámetro de dispersión o de la escala.

a, b y c son funciones conocidas.

Verde (2000) señala que los MLGnz se especifican con tres componentes: el

componente aleatorio que identifica la distribución probabilística de la variable

respuesta, el componente sistemático que especifica una función lineal de

variables explicativas que es usada como un predictor y una asociación que

describe la relación funcional entre el componente sistemático y el valor esperado

del componente aleatorio.

En las investigaciones agropecuarias muchas veces se involucran situaciones

donde es difícil utilizar el MLG en los Análisis de Varianza y Regresión, porque las

variables

que

se

analizan

no

cumplen

los

supuestos

de

normalidad,

homogeneidad de varianzas e independencia de los errores.

22

Actualmente las Ciencias Agropecuarias demandan de herramientas estadísticas

que permitan obtener estimaciones más precisas, y teniendo en cuenta las

bondades que muestra este modelo, muchos autores recomiendan el empleo de

los MLGnz, muy utilizado en el análisis con variables discretas y categóricas.

Los mecanismos que llevaron a esta visión general de la Modelación Estadística

se remonta a más de un siglo. Una reseña histórica fue trazada por McCullagh y

Nelder en 1989 y Lidsey en 1997 (citados por García, 2002) a partir de diferentes

distribuciones (tabla 1.3).

Tabla 1.3. Modelos más empleados según la metodología del Modelo Lineal

Generalizado.

Distribuciones

Normal

Tipo de Análisis

Regresión Lineal

Múltiple

Análisis de Varianza

para diseños

experimentales

Normal ; Binomial ;

Bernuolli ; Poisson

Función de

Multinomial; Exponencial y verosimilitud

Gamma

Autores

Legendre y Gauss (siglo XIX)

Fisher (1920- 1935)

Fisher(1922); Bliss (1935);

Berkson (1944); Dike y

Patterson (1952);

Racha (1960); Birch (1963);

Feig y Zelen (1965); Zippin y

Armitage (1966); Gasser (1967)

y Nelder (1966)

Existen algunas diferencias entre el MLG y el MLGnz, estas están dadas porque

en el primero se debe cumplir determinados requisitos, como son: los errores

deben distribuir Normal, por tanto la variable debe ser continua, la varianza de los

errores debe ser constante y el modelo debe expresarse en forma aditiva.

23

En el caso del MLGnz se puede emplear a cualquier tipo de distribución, que tiene

un predictor lineal asociado a la variable dependiente y por otra parte este modelo

presenta una componente aleatoria, el método de estimación es el de Máxima

Verosimilitud, mientras que en el MLG el método es el de Mínimos Cuadrados

Ordinarios (Greene, 1999; Johnston, 2000 y Correa, 2007).

En la tabla 1.4 se hace una comparación entre el MLG y el MLGnz, considerando

sus características.

Tabla 1.4 Comparación entre el Modelo Lineal General y el Modelo Lineal

Generalizado.

Modelo

Lineal General

Lineal

Generalizado

Expresión del Modelo

Sistemática

Aleatoria

Xβ

Variable

respuesta

ε

Continua

h(y,θ)=exp[p(θ)

y-q(θ)+g(y)]

Continua

Categórica,

Discreta

(Poisson,

Multinomial,

entre otras.)

Xβ

donde:

p(θ), q(θ),y g(y)

son funciones

conocidas

Método de

Estimación

Mínimos

Cuadrados

Ordinarios

(MCO)

Máximo

Verosimilitud,

Mínimos

Cuadrados

Ponderados,

Mínimos

Cuadrados

Generalizados

Para el análisis del MLGnz se necesita conocer que distribución poseen los datos,

pues esta permite seleccionar la función de enlace apropiada a cada distribución.

Se denomina funciones de enlace canónicas aquellas que se aplican por defecto a

cada una de las distribuciones de errores. Esto no significa que siempre se deba

usar una única función de enlace para una determinada distribución. De hecho,

24

puede ser recomendable comparar diferentes funciones de enlace para un mismo

modelo y ver con cual se obtiene un mejor ajuste del modelo a los datos (Cayuela,

2010).

En la tabla 1.5, se expresan las funciones de enlace más usadas en el análisis de

MLGnz.

Tabla 1.5. Funciones de enlace más empleadas en el Modelo Lineal Generalizado.

Distribución

Funciones

de enlace

Funciones

canónicas

Normal

Identidad

η=μ

Poisson

Logarítmica

η = log (μ)

Binomial

Logit

Gamma

Recíproca

Normal

inversa

Recíproca2

η log

η

η=

Modelos de

análisis

Modelo

Lineal

clásico (Diseños

experimentales y

Regresión)

μ

1 μ

1

μ

1

2

Logarítmico

Logístico

Logarítmico

Probit

Empleo

Variables continuas

con errores

normalmente

distribuidos

Variables discretas

con errores con

distribución Poisson

Proporciones

(variables con

respuestas

dicotómicas o con

valores 0 y 1)

Variables continuas

con errores con

distribución Gamma

Variables que miden

toxicidad o cualquier

variable con

respuesta binaria

Entre las ventajas que ofrece el MLGnz, está que permite emplear una mayor

variedad de distribuciones para la variable respuesta, es decir, posibilita el ajuste

de un modelo con diferentes distribuciones.

25

En esencia este modelo descompone la variabilidad de la variable respuesta en

dos componentes una sistemática y la otra aleatoria asociada a una función de

enlace de acuerdo a la distribución que adopten los datos analizados.

Un aporte importante de este modelo es que permite analizar variables con

respuestas discretas y continuas, mientras que el MLG solamente analiza

variables de tipo continuas.

1.6. Otros Métodos Estadísticos que analizan variables discretas y

categóricas

Numerosos son los Métodos Estadísticos que se utilizan en la actualidad para el

análisis de variables discretas y categóricas. En la medida en que las

investigaciones progresan, se desarrollan nuevas técnicas para el análisis con

estos tipos de variables. Es por ello que surge la necesidad de establecer

semejanzas y diferencias entre las técnicas existentes para determinar su

superioridad o para establecer sus limitaciones y poder determinar el método más

apropiado ante una nueva situación.

El desarrollo de métodos para el análisis de las variables categóricas se comenzó

por los estudios de la investigación en las Ciencias Sociales y Biomédicas. Las

escalas categóricas son estudiadas en las Ciencias Sociológicas para medir

actitudes y opiniones. Las escalas categóricas en las Ciencias Biomédicas miden

si el resultado de un tratamiento médico es exitoso o no (Agresti, 2007).

26

Según Greene (1999), los modelos de naturaleza categórica son modelos de

probabilidad condicionada, por lo que p (y=j/xi) es una función de las

combinaciones lineales β X, donde β es el vector de los parámetros y X es el

vector de regresores, (i = 1, 2…k) y (j=0,1,2,j).

Correa (2007) plantea que la distribución de Poisson juega un importante papel en

la modelación del conteo de individuos en muchas áreas investigativas, se

caracteriza por un solo parámetro μ=n, donde μ es una esperanza matemática y

puede interpretarse como el número esperado de ocurrencias en un intervalo de

tiempo, área o espacio especificado y la tasa de ocurrencia (), se define como el

número esperado de ocurrencias del evento.

Con frecuencia las variables discretas y categóricas se relacionan con

distribuciones de probabilidad Binomial, Multinomial y Poisson, entre otras,

teniendo en cuenta estos elementos, Guerra et al. (2010) resumen en la tabla 1.6,

los principales Métodos Estadísticos relacionados con el análisis de variables

cualitativas, según el número de variables involucradas. De los procedimientos

clásicos reportados en esta tabla, los de más amplia aplicación, son los

correspondientes a la Estadística no paramétrica.

27

Tabla 1.6. Métodos Estadísticos relacionados con variables cualitativas.

Según número

de variables

Univariado

Bivariada

Multivariado

Métodos

Descriptivo

Moda, mediana, rango, cuantíles,

frecuencias, porcientos.

Tablas de frecuencia.

Gráficos de barras, sectores, entre

otros.

Tablas de frecuencia bivariada o

tablas de contingencia.

Medidas de asociación no

paramétricas (coeficientes de

contingencia, Spearman, Kendall, etc)

Gráficos de barras, mosaicos.

Coeficiente de fiabilidad.

Coeficiente de esfuerzo (Stress).

Matriz de correlaciones.

Análisis Cluster.

Análisis de Correspondencia Múltiple.

Escalamiento Multidimensional (EMD)

Escalamiento Óptimo.

Mapas Auto Organizados (SOM)

Inferencial

Dócima de

proporciones y

dócimas no

paramétricas.

Series temporales.

Dócima Chicuadrado.

Regresión Logit

Regresión Probit

Regresión Logística

Regresión Poisson

Modelo Log lineal

Regresión

Categórica(CATREG)

Modelo Lineal

Generalizado

Navarro et al. (2008) indican que la Regresión Categórica (CATREG), trabaja bajo

el enfoque de la Regresión con transformaciones, aplicando la metodología de

Escalamiento Óptimo desarrollada por el sistema Gifi en 1990, para transformar la

respuesta y los predictores, dando lugar a un modelo flexible.

La referencia de este autor a que el CATREG es un modelo flexible, se considera

que está dada, a que este amplía las posibilidades del Modelo de Regresión

clásico, mediante el uso del Escalamiento Óptimo (minimiza la función de pérdida

de información), aplicable a variables nominales, ordinales y numéricas,

simultáneamente.

El CATREG es un método a través del cual la regresión se aplica a una variable

respuesta en forma de categorías con el propósito de predecir la respuesta como

28

función de una o más variables independientes. El CATREG se ha desarrollado

como un método de regresión lineal para variables categóricas (Navarro et al.

2010).

El

Análisis

de

Componentes

Principales

Categórico

(CATPCA),

puede

considerarse como una técnica exploratoria de reducción de las dimensiones de

una base de datos incorporando variables nominales y ordinales de la misma

manera que las numéricas (Molina y Espinosa de los Monteros, 2010).

El Análisis Factorial de Correspondencia Múltiple es una técnica que se utiliza

para reducir la dimensionalidad y la elaboración de mapas preceptúales, ya que

estos se basan en la asociación entre objetos y un conjunto de características

descriptivas; además, va más allá de analizar la relación existente entre las

variables, porque permite conocer como está estructurada esta relación (Quaglino

y Pagura, 1998 y Aranzazu et al. 2007).

Trujillo del Pozo (2001) plantean que el Análisis de Correlación Canónica

proporciona variables que garantizan este resultado, y es recomendable su

utilización cuando tanto el número de variables endógenas, como las explicativas

son elevadas, además existen altas correlaciones de las variables de cada grupo

entre sí.

29

Mediante este método de reducción de variables se puede eliminar el ineludible

problema de multicolinealidad que ocasionaría la consideración de todas las

variables en un modelo de regresión.

El Escalamiento Multidimensional es un conjunto de técnicas que persiguen como

objetivo, la representación de datos a través de la construcción de una

configuración de puntos cuando se conoce una determinada información sobre

proximidades entre objetos (Linares, 2001; Miret et al., 2002; Mora y González,

2009 y Arce et al., 2010).

Por otra parte Miret et al. (2002) y Miret (2005) señalan que el Escalamiento

Multidimensional consiste esencialmente en representar disimilaridades entre

objetos o individuos, como distancias entre puntos en un espacio de dimensión

reducida, mientras que los Mapas Auto Organizados de Kohonen, se caracterizan

por su capacidad para clasificar un conjunto complejo de patrones de manera no

supervisada, extrayendo criterios de clasificación no obvios ni expresados de

manera explícita.

Otros criterios sobre modelos relacionados con las variables cualitativas, son

dados por Guerra et al. (2010), como son:

La Matriz DAFO, con implementación automatizada, se puede considerar como

un Modelo cualitativo de diagnóstico en diversas áreas de investigación.

30

El criterio de experto, a través del Método Delphy, se puede considerar como

un Modelo cualitativo de validación en determinadas situaciones.

Todos estos Métodos Estadísticos, resultan alternativas de análisis en las

investigaciones donde se analizan variables que son de tipo discretas y

categóricas.

31

CAPÍTULO II

LA ENCUESTA ESTADÍSTICA EN

CAPTACIÓN DE INFORMACIÓN Y SU USO

LA

CAPÍTULO II. LA ENCUESTA ESTADÍSTICA EN LA CAPTACIÓN DE

INFORMACIÓN Y SU USO

2.1. Introducción

Se aplicó una encuesta estadística bibliométrica y a los investigadores del Instituto

de Ciencia Animal, con el objetivo de diagnosticar el estado actual del uso de la

transformación de datos y de los Métodos Estadísticos no paramétricos en las

investigaciones de la Ciencia Agropecuaria en Cuba.

2.2. Materiales y métodos

2.2.1. Encuesta estadística bibliométrica

La encuesta estadística bibliométrica se realizó con el objetivo de conocer los

Métodos Estadísticos más empleados, así como las temáticas más abordadas en

el período analizado del 2000 al 2007.

Se revisaron 1418 artículos para conocer las temáticas, así como los Métodos

Estadísticos

no

paramétricos

más

abordados

en

revistas

científicas

correspondientes a las Ciencias Agropecuarias y Biológicas, pertenecientes al

fondo bibliotecario del Instituto de Ciencia Animal. Las revistas revisadas están

contenidas en bases de datos internacionales y en la Web of Science. Se

emplearon estas revistas por ser las colecciones más completas en el período que

se analiza.

32

Para el estudió se revisaron las revistas:

Revista Cubana de Ciencia Agrícola (RCCA)

Revista Ciencias Biológicas (CENIC)

Pastos y Forrajes (EPFIH)

Agrociencia (México)

Veterinaria de México (México)

Archivos de Zootecnia (España)

Ciencias Pecuarias (Colombia)

Los indicadores que se midieron fueron:

Nombre de la revista

Número de los artículos por revista

Tipo de variables analizadas

Métodos Estadísticos aplicados

Temáticas

tratadas

con

aplicación

de

Métodos

Estadísticos

no

paramétricos.

2.2.2. Encuesta estadística a los investigadores

Se desarrolló una encuesta en el 2011 (Anexo 2), para evaluar el conocimiento de

los investigadores sobre la transformación de datos, y el uso de Métodos

Estadísticos alternativos para evitar el empleo de estas en el análisis estadístico

de los resultados de las investigaciones desarrolladas en el Instituto de Ciencia

33

Animal. De un total de 89 investigadores, distribuidos en Titulares, Auxiliares,

Agregados y Aspirantes, fue posible encuestar 69, que representan el 77,53% de

todas las categorías con la siguiente representación por cada departamento, tabla

2.1.

Tabla 2.1. Encuestados por departamento.

Departamento

Monogátricos

Fisiología

Rumiantes

Pastos

Genética

Biomatemática

Total

%

13,3

24,6

26,7

15,9

7,2

7,2

100

Para el análisis de la encuesta a los investigadores se valoraron los siguientes

indicadores:

Departamento.

Empleo de transformaciones.

Número de transformaciones que emplean.

Métodos Estadísticos alternativos que usan.

Sabe que logra con el uso de la transformación de datos.

Interés por continuar con el uso de las transformaciones.

2.2.3. Organización, procesamiento y análisis estadístico de la información

Para el análisis de las encuestas estadísticas bibliométrica y a los investigadores,

la información fue tabulada en una base de datos de Excel para su posterior

procesamiento.

34

Para procesar la información de las revistas y las encuestas a investigadores se

empleó el método de Escalamiento Multidimensional PROXSCAL (en inglés

Multidimensional Sealing of Proximity) utilizando el paquete estadístico SPSS

versión 19.0 (2010).

El

procesamiento

de

las

encuestas

estadísticas

bibliométrica

y

a

los

investigadores se incluyeron tablas de frecuencia bivariadas (tablas de

contingencia), gráficos de barras y sectores, entre otros. Se evaluó la bondad de

ajuste de la solución multidimensional mediante los valores del Stress bruto

normalizado, la dispersión explicada (D.A.F, en inglés) y el coeficiente de

congruencia de Tucker.

Para interpretar las medidas de calidad del ajuste obtenida del Escalamiento

Multidimensional, Guerra (2009) propone una tabla del Stress; teniendo en cuenta

los valores dados por Kruskal en 1964, (citado por Mora y González, 2009), como

se refleja en la tabla 2.2.

Tabla 2.2. Interpretación de los valores del Stress (S).

Valores del Stress

S=0

0 < S ≤ 0,025

0,025 < S ≤ 0,05

0,05 < S ≤ 0,1

0,1 < S < 0,2

S ≥ 0,2

Interpretación de la bondad de ajuste

Ajuste perfecto

Ajuste excelente

Ajuste muy bueno

Ajuste bueno

Ajuste regular

Ajuste pobre

Para visualizar la información de la encuesta estadística bibliómetrica por revistas

se utilizó también el paquete estadístico Viscovery SOMine (2008), con el método

35

SOM-Wald Clusters, que combina de forma ordenada la información local del

mapa con el algoritmo de Cluster Jerárquico Clásico de Ward (Ward, 1963).

Del análisis de la encuesta bibliométrica se obtienen dos mapas, en el primero se

refleja los Métodos Estadísticos no paramétricos usados y en el segundo las

temáticas que más abordan estos métodos. En la parte inferior de cada mapa

aparece una escala con matices de colores, de más a menos intenso, si se analiza

de derecha a izquierda.

Se confeccionó la matriz DAFO para establecer un diagnóstico con los resultados

obtenidos de la encuesta a los investigadores.

2.3. Resultados y discusión

2.3.1. Encuesta estadística bibliométrica

En la tabla 2.3 se presentan las medidas de bondad de ajuste del Escalamiento

Multidimensional, relacionadas con la aplicación de los Métodos Estadísticos no

paramétricos por revistas analizadas. Con esta técnica se obtuvieron las medidas

de calidad de ajuste de la configuración de los datos, que presentan un resultado

excelente de acuerdo a lo que se muestra en la tabla 2.2.

Tabla 2.3. Bondad del ajuste de la configuración de los datos para los Métodos

Estadísticos no paramétricos.

Medida

Stress bruto normalizado

Dispersión explicada (D.A.F.)

Coeficiente de congruencia de

Tucker

Resultado

0,00092

0,99908

0,99954

36

Por otra parte se observa que la dispersión explicada (D.A.F) y el coeficiente de

congruencia de Tucker, corroboran la bondad del ajuste del método, con

resultados que se encuentran próximos a 100 %, por lo que logran explicar una

alta variabilidad.

Según Cuesta (2005), se considera un buen ajuste cuando el resultado obtenido

del Stress bruto normalizado se encuentra próximo a 0 y cuando el D.A.F y el

coeficiente de congruencia de Tucker son de al menos 0,80 (80%), que indica la

dispersión explicada por el método, estos coeficientes se suelen expresar en

porciento, lo que facilita su interpretación.

En la figura 2.1 se muestra la agrupación en dos dimensiones de aquellas revistas

que hacen uso de los Métodos no paramétricos. Se destacan tres grupos; en el

primero se ubica la Ciencias Biológicas, en el segundo Veterinaria de México y en

el tercero el resto de las revistas que presentan menos aplicaciones de estos

métodos.

El hecho de que la revista Ciencias Biológicas forme un grupo más aislado del

resto de las demás, pudiera estar asociado a que sus investigaciones están más

relacionadas a variables que son de tipo discretas y categóricas, por lo que sus

análisis estadísticos están más enfocados a los Métodos Estadísticos no

paramétricos.

37

Figura 2.1. Revistas relacionadas con la aplicación de los Métodos Estadísticos no

paramétricos.

En la figura 2.2, se reflejan los mapas referentes a la aplicación de los Métodos

Estadísticos no paramétricos con 214 aplicaciones. En este sentido sobresale las

revistas Ciencias Biológicas con las dócimas Prueba Exacta de Fisher, seguida

por Mann-Whitney y Kruskal-Wallis y la Veterinaria de México con la dócima Chicuadrado ( 2 ).

En este caso se obtuvo un ligero incremento en la aplicación de los Métodos

Estadísticos no paramétricos que expresado en términos relativos representan el

15,09 %, con respecto al 2,12 % obtenido por De Calzadilla (1999) en el período

1987-1997.

38

Agrociencia

Archivo Zootecnia

c3

Com Alea

c3

Com Alea

c1

c4

X2

c4

X2

MW

c2

KW

0

c1

1

3

6

7

c2

KW

PE Fisher

4

MW

8

10

11

13

14

0

1

3

PE Fisher

4

Ciencias Biologicas

6

7

8

c4

X2

c2

KW

5

11

13

c2

KW

PE Fisher

8

16

19

22

24

27

0,0

0,4

0,9

1,3

1,8

2,2

3,1

27

30

c1

c4

X2

MW

c2

KW

1,8

2,7

3,6

MW

c2

KW

PE Fisher

4,4

5,3

6,2

7,1

8,0

Veterinaria

0

3

6

PE Fisher

9

12

15

18

21

24

Leyenda. Métodos Estadísticos no paramétricos

más usados

c3

Com Alea

Clúster 2 (c2): MW (dócima de Mann Whitney)

c1

Clúster 2 (c2): KW (dócima de Kruskal Wallis)

Clúster 2 (c2): PE Fisher (dócima Exacta de Fisher)

c4

X2

MW

c2

KW

0

2,7

c3

Com Alea

c1

0,9

4,0

PE Fisher

RCCA

c3

Com Alea

0,0

3,6

MW

Pastos Forrajes

c4

X2

14

c1

MW

3

13

c3

Com Alea

c1

0

11

Ciencias Pecuaria

c3

Com Alea

c4

X2

10

2

5

7

Clúster 4 (c4):

2

(dócima

2 ) Chi-Cuadrado

PE Fisher

9

12

14

16

18

21

Figura 2.2. Métodos Estadísticos

estudios agropecuarios y biológicos.

23

no

paramétricos

más

usados

en

39

En la tabla 2.4 se muestra la bondad de ajuste del método, que al igual que en el

análisis anterior se corrobora el buen ajuste de la configuración de los datos,

considerando el Stress bruto normalizado, así como los resultados obtenidos por

el D.A.F y el coeficiente de congruencia de Tucker, estos últimos se encuentren

cercanos a 100%.

Mora y González (2009) indican que en el Escalamiento Multidimensional, el

método PROXSCAL minimiza el Stress bruto normalizado, estos valores se

obtienen mediante la fórmula introducida por Kruskal en 1964, quien ofreció una

guía para su interpretación.

Tabla 2.4. Bondad de ajuste de las temáticas por revistas, donde se aplican los

Métodos Estadísticos no paramétricos.

Medida

Stress bruto normalizado

Dispersión explicada (D.A.F.)

Coeficiente de congruencia de Tucker

Resultado

0,01539

0,98461

0,99228

Al tener en cuenta los criterios de bondad de ajuste, se considera que la solución

en dos dimensiones es apropiada. En la figura 2.3 se muestra la formación de

cuatro grupos, en el primero se unen aquellas revistas que tienen un

comportamiento similar en cuanto al análisis de sus temáticas por los Métodos

Estadísticos no paramétricos, en este sentido se observa que poseen poca

diversidad de estos en sus aplicaciones. El segundo grupo lo conforma la RCCA

que posee un comportamiento diferente, ya que realiza poco empleo de estos

métodos y en el tercer grupo se ubica Ciencias Biológicas y en el cuarto grupo se

40

encuentra Veterinaria de México, que son las que hacen un mayor empleo de la

estadística no paramétrica para el análisis de sus temáticas.

Según Guerrero y Ramírez (2002) el Escalamiento Multidimencional está basado

en la comparación de objetos o de estímulos, de forma que sí un individuo juzga a

los objetos A y B como los más similares, entonces las técnicas de Escalamiento

Multidimencional colocarán a los objetos A y B en el gráfico de forma que la

distancia entre ellos sea más pequeña que la distancia entre cualquier otro par de

objetos.

Figura 2.3. Revistas por temáticas con aplicación de los Métodos Estadísticos no

paramétricos.

En la figura 2.4 se visualizan las revistas donde sus temáticas son analizadas por

los Métodos Estadísticos no paramétricos aplicados a las Ciencias Agropecuarias.

41

En cada revista las temáticas que más abordan los Métodos Estadísticos no

paramétricos, son aquellas que enfocan su análisis desde el punto de vista teórico,

con la reproducción animal, estudios para probar y validar medicamentos en

humanos y salud animal, en este caso se destacan las revistas Agrociencia,

Archivos de Zootecnia, Ciencias Pecuarias, Ciencias Biológicas y Veterinaria de

México.

Sin embargo en otras temáticas que abordan las revistas no hay empleo de

Métodos Estadísticos no paramétricos, como es el caso de las revistas Pastos y

Forraje y la RCCA.

42

Agrociencia

Archivo Zootecnia

Past Prod Sem

c6

Bi otec

c4

c1

Est Ovi no

Prod Lec

Prod

c1

Prod Lec

Prod

Bovi n

c2

Aves

M ed

Ani Lab c3

Rep

c5

San Veg

Sal ud

1,0

2,0

Est Clhum

i

3,0

4,0

5,0

6,0

7,0

8,0

9,0

Bovi n

c2

Aves

M ed

Ani Lab c3

Rep

c5

San Veg

Sal ud

0,0

1,0

2,0

Ciencias Biologicas

Est Cl hum

i

3,0

4,0

Bi otec

c4

6,0

7,0

8,0

9,0

Past Prod Sem

c6

Bi otec

c4

Est Ovi no

c1

Est Ovi no

Prod Lec

Prod

c1

Prod Lec

Prod

Bovi n

c2

Aves

M ed

Ani Lab c3

Rep

c5

San Veg

Sal ud

2

4

Est Clhum

i

5

7

9

11

13

14

16

18

Bovi n

c2

Aves

M ed

Ani Lab c3

Rep

c5

San Veg

Sal ud

0,0

0,7

1,3

Est Cl hum

i

2,0

2,7

Pastos Forrajes

3,3

4,0

4,7

5,3

6,0

RCCA

Past Prod Sem

c6

Bi otec

c4

Past Prod Sem

c6

Bi otec

c4

Est Ovi no

c1

Est Ovi no

Prod Lec

Prod

c1

Prod Lec

Prod

Bovi n

c2

Aves

M ed

Ani Lab c3

Rep

c5

San Veg

Sal ud

0

5,0

Ciencias Pecuaria

Past Prod Sem

c6

0

Bi otec

c4

Est Ovi no

0,0

Past Prod Sem

c6

1

2

Est Clhum

i

3

4

5

6

7

8

9

10

Veterinaria

Bovi n

c2

Aves

M ed

Ani Lab c3

Rep

c5

San Veg

Sal ud

0

2

4

6

Est Cl hum

i

8

11

13

15

17

19

21

Leyenda. Temáticas más representativas

Past Prod Sem

c6

Bi otec

Clúster 1 (c1): investigaciones sobre Producción de semillas (Prod

Sem), Biotecnología (Biotec), Ovino, Producción de leche (Prod

Lec), Aves, Sanidad vegetal (San Veg).

c4

Est Ovi no

Clúster 2 (c2): estudios en Bovinos (Bovin) y Reproducción animal

c1

Prod Lec

(Rep).

Prod

Clúster 3 (c3): estudios médicos (Med), en animales de

Bovi n

c2

laboratorios (Ani Lab) y clínicos en humanos (Est Cli hum).

Aves

M ed

Ani Lab c3

Rep

c5

San Veg

Sal ud

0

2

5

7

Est Clhum

i

9

12

14

16

18

21

23

Clúster 4 (c4): métodos estadísticos (Est) aplicados a las ciencias

agropecuarias y Producción de alimento animal (Prod).

Clúster 5 (c5): estudios en Salud animal (Salud).

Clúster 6 (c6) investigaciones relacionadas con los Pastos (Pas).

Figura 2.4 Temáticas por revistas que emplean Métodos Estadísticos no

paramétricos para el análisis de sus investigaciones.

43

2.3.2. Encuesta estadística a los investigadores

En la encuesta a los investigadores (Anexo 2), se evidencia que el 97,1% de los

encuestados conocen con qué objetivo aplican la transformación de datos (figura

x y arcoseno ( p ) en el

2.5) y hacen mayor uso de las transformaciones

69,57% de los casos (48 encuestados), lo que se refleja en la tabla 2.5.

Este resultado se considera que está dado porque en las investigaciones

agropecuarias es frecuente la presencia de variables originadas por conteos y

porcientos,

que

según

autores

como

Steel

y

Torrie

(1992),

son

las

transformaciones adecuadas para este tipo de datos, cuando presentan

distribuciones de tipo Poisson y Binomial.

2,90%

Uso de transf. en total

Si

No

97,10%

Figura 2.5. Necesidad de aplicar la transformación de datos.

44

Tabla 2.5. Transformaciones de datos más empleadas según encuesta a los

investigadores.

Transformaciones

1

arcoseno

Dpto.

x

( p)

Log X

(1/x)

1

2

3

4

5

6

Total

%

3

10

8

1

1

0

23

33,3

8

5

6

4

1

1

25

36,2

0

1

2

5

0

2

10

14,5

0

0

1

0

0

1

2

2,9

x

2

1

1

1

3

1

9

13,0

Total

%

13

17

18

11

5

5

69

-

18,8

24,6

26,1

15,9

7,2

7,2

100

En la tabla 2.6 se presentan los aspectos más frecuentes manifestados por los

investigadores. Se obtuvo que un alto porciento de los encuestados conocen que

se logra con el uso de la transformación de datos, la usan con mayor frecuencia

en el ANAVA, desean continuar transformando y desconocen el uso de Métodos

Estadísticos alternativos.

Tabla 2.6. Aspectos más frecuente en las respuestas de las preguntas a los

investigadores.

Aspectos

Sabe que logra con el uso de la transformación de datos

Uso de la transformación de datos en el Modelo de Análisis de

Varianza