Gestión - Departamento de Ciencias de la Computación

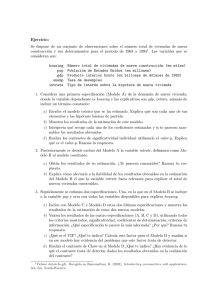

Anuncio