Estadísticos de rangos lineales

Anuncio

Capı́tulo 3

Estadı́sticos de rangos lineales.

3.1

Rango de un elemento de un conjunto.

Definición 3.1.1 Dado un conjunto de números reales {x1 , . . . , xm } llamamos

rango de uno cualquiera de sus elementos xi , y lo denotamos R(xi ), al lugar

que ocupa xi en el conjunto, luego de ordenarlo de menor a mayor, esto es:

R(xi ) =

m

1{xh ≤xi }

h=1

Cuando los elementos del conjunto son todos diferentes, el conjunto de

sus rangos es {1, 2, . . . , m}. Cuando esto no ocurre (en ese caso suele decirse

que hay empates) el conjunto de los rangos contiene números repetidos, y hay

entonces números entre 1 y m − 1 que no son rangos de ningún elemento.

En lo que sigue, vamos a aplicar la definición de rangos a variables aleatorias, y supondremos que sus distribuciones son tales que los empates quedan

excluı́dos con probabilidad 1.

Teorema 3.1.1 Si H es una función estrictamente creciente, el rango de yi =

H(xi ) en {H(xh ) : h = 1, 2, . . . , m} es el de xi en {xh : h = 1, 2, . . . , m}

La demostración es inmediata.

3.2

El problema de las dos muestras

A partir de dos muestras (X1 , . . . , Xm ) y (Y1 , . . . , Yn ), llamamos estadı́stico

lineal de rangos a un estadı́stico de la forma

T =

m

ψR(Xi ) ,

i=1

35

(3.1)

Enrique M. Cabaña.

Capı́tulo 3: Estadı́sticos de rangos lineales.

36

donde ψ = (ψ1 , . . . , ψm+n ) es un vector de m + n componentes, y R(Xi ) =

m

n

h=1 1{Xh ≤Xi } +

j=1 1{Yj ≤Xi } es el rango de Xi .

Vamos a suponer que las distribuciones de probabilidad de las variables

aleatorias involucradas son tales que no hay empates casi seguramente. En

particular, este es el caso cuando X1 , . . . , Xm ∼ F , Y1 , . . . , Yn ∼ G, y F y G

son funciones de distribución continuas.

El nombre problema de las dos muestras se aplica a la prueba de la hipótesis

nula de igualdad entre F y G.

Cuando se cumple H0 :“F = G”, cualquiera de los m+n

subconjuntos

m

de m números elegidos en {1, 2, . . . , m + n} tiene la misma probabilidad que

cualquier otro de ser el conjunto de los rangos de (X1 , . . . , Xm ). En particular,

P{R(Xi ) = j} =

1

,

m+n

y, si h = i y j = k,

P{R(Xh ) = j, R(Xi ) = k} =

1

1

.

m+nm+n−1

A partir de estas probabilidades, resulta inmediato calcular los momentos

de primero y segundo orden de T cuando se cumple H0 :

Teorema 3.2.1 Cuando se cumple H0 ,

ET =

m m+n

ψj

m + n j=1

(3.2)

y

m+n

m+n

mn

VarT =

ψj2 − (

ψj )2 /(m + n) .

(m + n)(m + n − 1) j=1

j=1

(3.3)

Demostración. Para cada i = 1, . . . , m, EψR(Xi ) = m+n

j=1 ψj P{R(Xi ) = j}

1 m+n

= m+n j=1 ψj es independiente de i, de modo que (3.2) se obtiene sumando

en i.

Si h = i, entonces

EψR(Xh ) ψR(Xi ) =

ψj ψk P{R(Xh ) = j, R(Xi ) = k}

j=k

=

1

ψj ψk ,

(m + n)(m + n − 1) j=k

Licenciatura en Estadı́stica.

3.2. Problema de las dos muestras

37

mientras que, para el caso h = i, encontramos

2

EψR(X

=

h)

m+n

ψj2 P{R(Xi ) = j} =

j=1

1 m+n

ψ2

m + n j=1 j

de modo que

2

ET = E

m

m ψR(Xh ) ψR(Xi ) =

h=1 i=1

=

=

EψR(Xh ) ψR(Xi ) +

h=i

m

h=1

m+n

m(m − 1)

m

ψj ψk +

ψ2

(m + n)(m + n − 1) j=k

(m + n) j=1 j

m+n

m(m − 1)

m

ψj2 ) +

ψj2

( ψj ψk −

(m + n)(m + n − 1) j,k

(m

+

n)

j

j=1

=

m(m − 1)

m

m−1

1−

( ψj )2 +

(m + n)(m + n − 1) j

m+n

m+n−1

y

VarT = ET 2 − (ET )2 =

+

m+n

ψj2

j=1

m(m − 1)

( ψj )2

(m + n)(m + n − 1) j

m+n

m+n

m

m2

n

ψj2 −

(

ψj )2

2

m + n m + n − 1 j=1

(m + n) j=1

=

2

EψR(X

h)

m+n

m−1

m

mn

m

−

ψj2 −

( ψj )2 ,

(m + n)(m + n − 1) j=1

m+n m+n m+n−1

j

2

que se reduce a (3.3).

Corolario 3.2.1.1 Si se eligen valores de ψ = (ψ1 , . . . , ψm+n ) con las condiciones de normalización

m+n

j=1

ψj = 0

m+n

ψj2 = m + n,

j=1

entonces

E( √

T

T

mn

) = 0, Var( √

)=

,

(m + n)(m + n − 1)

m+n

m+n

T

m

n

y Var( √m+n

) → µν cuando m + n → ∞, µ = lim m+n

, ν = lim m+n

.

Enrique M. Cabaña.

Capı́tulo 3: Estadı́sticos de rangos lineales.

38

Se observará que cuando T = m

R(Xi ) es un estadı́stico de rangos lineal,

i=1 ψ

∗

puede construirse otro estadı́stico T ∗ = m

i=1 ψR(Xi ) del mismo tipo, que es una

función determinı́stica (independiente de la muestra) de T , y que, por lo tanto,

posee la misma información que T , con coeficientes que cumplen las condiciones

de normalización que aparecen en el enunciado del corolario precedente. En

efecto, basta reemplazar cada ψj por

ψj∗ = (ψj −

ψk

m+n

/(m + n))(m + n)/(

(ψ

k

k

−

k=1

ψl /(m + n))2 ),

l

pues esta operación lleva T en

T∗ =

m

i=1

∗

ψR(X

= (T −

i)

m

m+n

m+n

j=1

ψj

m+n

) (m + n)/(

(ψ

k

k=1

−

ψl /(m + n))2 ),

l

que es un polinomio de primer grado en T con coeficientes que dependen

exclusivamente de los ψj , pero no de las muestras.

3.3

Acerca de la distribución de T bajo la hipótesis nula F = G.

Las distribuciones de funciones de los rangos, cuando F = G, pueden

obtenerse

m+n

de la observación indicada previamente de que cualquiera de los m subconjuntos de m números elegidos en {1, 2, . . . , m + n} tiene la misma probabilidad

que cualquier otro de ser el conjunto de los rangos de (X1 , . . . , Xm ).

La siguiente imagen geométrica da una descripción de la distribución de

los rangos de las X (y de las Y ) bajo H0 : “F = G”.

Teorema 3.3.1 A partir de las observaciones X1 , . . . , Xm , Y1 , . . . , Yn construimos el vector U = (U1 , . . . , Um+n ) cuyas componentes valen Uj = 1, cuando j

está en el conjunto RX = {R(X1 ), R(X2 ), . . . , R(Xm )}, y −1 en caso contrario.

A partir de U definimos S = (S0 , S1 , . . . , Sm+n ), con Sj = jk=0 Uk .

A cada S hacemos corresponder la poligonal de lados {((j−1, Sj−1 ), (j, Sj )) :

j = 1, 2, . . . , m + n}. Esta poligonal tiene un primer lado que une (0, 0) con

(1, 1) cuando la más pequeña de las observaciones es una X, o (0, 0) con (1, −1)

cuando es una Y . Luego un lado a 45 grados hacia arriba, si la siguiente

observación es una X, o hacia abajo si es una Y , y ası́ sucesivamente hasta

describir los m + n rangos.

Licenciatura en Estadı́stica.

3.3. Distribución de T cuando F = G.

Cada una de las

m+n

m

39

trayectorias poligonales de este tipo que unen (0, 0)

con (m + n, m − n) tiene la misma probabilidad (

m+n −1

)

m

que cualquier otra.

El paseo al azar simétrico simple obtenido cuando U1 , . . . , Um+n son independientes e idénticamente distribuidas con P{Uj = 1} P{Uj = −1} = 1/2

(j = 1, 2, . . . , m + n) y S se define de la misma manera a partir de U , tiene la

misma distribución.

El enunciado precedente, cuya demostración es inmediata, conduce a calcular probabilidades asociadas a H0 por simple enumeración de trayectorias.

Sugiere también qué tipo de estadı́sticos resultan apropiados para utilizar los

rangos en problemas de inferencia.

3.3.1

Efecto del desplazamiento relativo de una muestra

respecto a la otra.

Supongamos que nos interesa probar H0 , y detectar especialmente bien las

alternativas de desplazamiento relativo de la distribución de las X respecto de

la de las Y : H1 : “F (x) = G(x − c)”, para alguna constante c.

Cuando se cumpla la alternativa con c > 0, las X estarán desplazadas hacia la derecha de las Y . En ese caso, las variables con rangos pequeños serán

mayoritariamente Y , y los rangos grandes corresponderán a las X. Las trayectorias tenderán por lo tanto a comenzar dirigiéndose hacia abajo, y terminarán

subiendo, para llegar al punto terminal que está fijo. En otras palabras, las

trayectorias indicativas de que se cumple la alternativa serán las más bajas.

Por lo tanto, una prueba de la hipótesis de igualdad de las distribuciones sensible a la alternativa de desplazamiento a la derecha, se obtendrá tomando

como región crı́tica al conjunto de las trayectorias más bajas. Como bajo la

hipótesis nula todas las trayectorias tienen la misma

probabilidad, la canti

dad de trayectorias en la región crı́tica será α m+n

,

donde

α es el nivel de la

m

prueba.

Para precisar la observación precedente se requiere decidir cuáles son las

trayectorias más bajas, es decir, dar una medida de la altura de una trayectoria. Esto puede hacerse de diversas maneras, y da lugar a diferentes pruebas

basadas en los rangos.

Enrique M. Cabaña.

Capı́tulo 3: Estadı́sticos de rangos lineales.

40

3.3.2

Dos maneras de medir la altura de una trayectoria.

Dos de las maneras de decidir cuáles son las trayectorias más bajas, ambas

utilizadas en la construcción de pruebas, son las siguientes:

• Se describe la altura por medio de una combinación lineal con coeficientes

positivos de las alturas de los vértices:

m+n

aj S j .

j=0

Por ejemplo, si todos los pesos son iguales, obtenemos W1 = m+n

j=0 Sj .

En cambio, si sólo uno de los pesos es positivo y los restantes son nulos,

obtenemos simplemente Mj = Sj .

• Se describe la altura de acuerdo al mı̀nimo valor alcanzado por la trayectoria o por una función sencilla de la trayectoria, por ejemplo,

min

j=0,1,...,m+n

Sj ,

(Sj − j(m − n)), etc.

min

j=0,1,...,m+n

Entre los segundos están los estadı́sticos de Kolmogorov - Smirnov.

Observemos que los primeros pueden escribirse también en la siguiente

forma, que muestra que son estadı́sticos lineales de rangos:

m+n

aj S j =

j=0

donde ψk =

m+n

j=1

m+n

j=k

aj

j

Uk =

k=1

m+n

m+n

aj Uk =

k=1 j=k

m+n

ψk (1{k∈RX } − 2),

k=1

aj . Como consecuencia,

m+n

j=0

aj Sj =

m

ψR(Xi ) − 2

i=1

m+n

ψj ,

j=1

m+n

y esta expresión difiere de (3.1) en el término determinı́stico 2

modo que proporciona la misma información que el estadı́stico T .

3.4

3.4.1

j=1

ψj , de

Algunos ejemplos de pruebas de posición

basadas en estadı́sticos lineales de rangos.

La prueba de Wilcoxon.

La primera prueba basada explı́citamente en un estadı́stico lineal de rangos

que apareció en la bibliografı́a fué la de Wilcoxon. Se trata de una prueba

Licenciatura en Estadı́stica.

3.4. Algunos ejemplos de pruebas de posición.

41

sensible a desplazamientos relativos de las dos distribuciones. El estadı́stico

utilizado es

W =

m

R(Xi ),

i=1

que tiende a dar resultados significativamente grandes cuando las X están

desplazadas hacia la derecha de las Y , e, inversamente, significativamente

pequeños cuando están desplazadas hacia la izquierda. Los valores posibles

1

de W van desde un mı́nimo de m

el máximo m+n

i=1 i = 2 m(m + 1) hasta

i=n+1 i

m

1

= mn+ 2 m(m+1). Este estadı́stico es de la forma T = i=1 ψR(Xi ) con ψj = j,

de modo que Sψ = 12 (m+n)(m+n+1) y SCψ = 16 (m+n)(m+n+1)(2m+2n+1).

m (m+n)(m+n+1)

De (3.8) resulta EW = m+n

= m(m+n+1)

, y de (3.9), VarW

2

2

2

− (m+n)(m+n+1)

= mn(m+n+1)

.

4

12

La distribución de W puede obtenerse por enumeración directa, cuando los

tamaños de las muestras no son demasiado grandes. Además, para probar H0

no es necesario conocer completamente la distribución de W , sino que basta

tener las cuantilas 1 − α, α o 1 − α/2 y α/2, donde α es el nivel, según se

trate de una prueba unilateral sensible a F (x) = G(x − δ), δ > 0, una prueba

unilateral sensible a F (x) = G(x − δ), δ < 0, o una prueba bilateral con igual

peso en ambas partes de la región crı́tica, cuando se desea que la prueba sea

sensible a F (x) = G(x − δ), sin especificar el signo de δ. Por ejemplo, cuando

m = n = 5, α = .05 y la región crı́tica es de la forma W > c, tenemos que

encontrar c tal que la probabilidad de {W > c} sea 5%. El número posible de

trayectorias es 10

= 252. El 5% de esta cantidad es 12, 6.

5

Es claro que el máximo valor de W , que es 6 + 7 + 8 + 9 + 10 = 40

ocurre sólo cuando la ordenación de las variables es Y Y Y Y Y XXXXX. El

valor 39 también ocurre sólo una vez, en el caso Y Y Y Y XY XXXX. A partir de esta configuración, hay dos formas de reducir la suma de rangos en

una unidad para obtener W = 38, a saber, Y Y Y XY Y XXXX y Y Y Y Y XXY XXX ,

luego tres (Y Y XY Y Y XXXX, Y Y Y XY XY XXX y Y Y Y Y XXXY XX ) con suma 37, cinco

(Y XY Y Y Y XXXX, Y Y XY Y XY XXX, Y Y Y XXY Y XXX, Y Y Y XY XXY XX y Y Y Y Y XXXXY X )

con suma 36, etc. La probabilidad de {W > 35} es entonces 12/253 = 4.74%,

valor muy próximo al nivel deseado. Una trayectoria más que agregáramos

harı́a que el nivel fuera mayor que el 5%, de modo que la región crı́tica

{W > 35} resuelve nuestro problema, al menos aproximadamente, con la mejor

aproximación posible.

La distribución de W está tabulada para valores no muy grandes de m y

n. Para valores grandes existen aproximaciones asintóticas, que veremos más

adelante.

=

mn

(m+n)(m+n−1)

(m+n)(m+n+1)(2m+2n+1)

6

42

3.4.2

Enrique M. Cabaña.

Capı́tulo 3: Estadı́sticos de rangos lineales.

La prueba de Mann y Whitney.

El estadı́stico de Mann y Whitney es A = W − m(m + 1)/2, y varı́a entre 0 y

mn. Su esperanza bajo H0 es mn/2, y su variancia es la misma de W , ya que

ambos estadı́sticos difieren en una cantidad no aleatoria.

Resulta interesante observar que, si subdividimos el rectángulo de vértices

(0, 0), (m, m), (m + n, m − n), (n, −n), limitado por las dos trayectorias extremas, en los mn cuadrados de lados a 45o¯ que se obtienen intercalando n − 1

y m − 1 paralelas equidistantes entre los lados de pendiente positiva y los

de pendiente negativa, respectivamente, entonces A coincide con la cantidad

de esos cuadrados que están por encima de la trayectoria que representa la

ordenación conjunta de las dos muestras, y por debajo de la trayectoria más

alta.

Basta observar que al intercambiar dos observaciones contiguas XY para

llevarlas a Y X, dejando el resto sin modificar, esto aumenta en una unidad

tanto a A o a W como al número de cuadritos por encima de la trayectoria.

Como este número es cero para la trayectoria más alta, cuando A también

vale 0, se deduce que A y ese número coinciden. La enumeración de las doce

trayectorias más altas, es decir, las que dejan menos cuadrados por encima, que

hiciéramos en el ejemplo de aplicación de la Prueba de Wilcoxon a dos muestras

de tamaño 5, resulta mucho más simple cuando enumeramos las trayectorias

que dejan 0, 1, 2, 3, 4, o 5 cuadrados por encima, que son las que indican las

figuras anexas.

Trayectorias con A = 0 o 1.

Trayectorias con A = 2.

Trayectorias con A = 3.

Trayectorias con A = 4.

Licenciatura en Estadı́stica.

3.5. Ejemplos de pruebas lineales de rangos.

3.4.3

43

Una versión gráfica de la prueba de Wilcoxon.

Vamos a representar en un par de ejes cartesianos los valores X1 , . . . , Xm en

abscisas, y los Y1 , . . . , Yn en ordenadas. La cantidad de elementos de la muestra

de las Y menores que Xi es igual a la cantidad de intersecciones de las rectas

y = Yj , j = 1, . . . , n con la recta x = Xi que están por debajo de la bisectriz

y = x de los cuadrantes primero y tercero.

Por lo tanto, la cantidad de esas intersecciones correspondientes a las rectas

n

x = Xi para i = 1, . . . , m es m

i=1

j=1 1Yj <Xi . A esta suma falta agregarle

m m

i=1

h=1 1Xh ≤Xi para tener el estadı́stico W de Wilcoxon. Como consecuencia, coincide con el estadı́stico A de Mann y Whitney.

En resumen: La cantidad A de intersecciones de las rectas y = Yj con las

rectas x = Xi por debajo de y = x es igual al estadı́stico de Mann y Whitney.

Como consecuencia, si corresponde rechazar H0 cuando A < a

3.5

Algunos ejemplos de pruebas lineales de

rangos.

Las observaciones de las secciones precedentes llevan a considerar que coeficientes ψi monótonos son adecuados para detectar alternativas de desplazamiento de una muestra respecto de la otra.

Cuando nos interesa detectar cambios en la concentración o dispersión, en

ausencia de desplazamientos relativos, debemos poner de manifiesto cuándo

las X están concentradas en el centro, y las Y desplazadas hacia los extremos,

lo que indicarı́a que las X están más concentradas que las Y , o viceversa. El

estadı́stico T resulta sensible a estos comportamientos cuando los coeficientes

ψ crecen (o bien decrecen) desde el centro a los extremos. Por ejemplo, los

valores ψi = |i − 12 (m + n + 1)| o ψi = (i − 12 (m + n + 1))2 sirven para poner

de manifiesto cambios de dispersión.

La Tabla 3.1 indica los estadı́sticos utilizados en algunas de las primeras

pruebas propuestas en la literatura, y sus dos primeros momentos. Las regiones crı́ticas son de la forma T <const, T >const o la unión de ambas, con

constantes adecuadas en cada una de las desigualdades, y T = m

1=1 ψR(Xi ) .

Algunos de los estadı́sticos propuestos son apropiados para detectar cambios de posición, y otros para cambios de dispersión.

En cualquier caso, y para cada nivel α la obtención de la constante cα que

cumple la propiedad P{T > cα } = α, se puede hacer por simulación y también

por el cálculo exacto de la distribución de T .

44

Enrique M. Cabaña.

Capı́tulo 3: Estadı́sticos de rangos lineales.

Para obtener exactamente la distribución de T , se enumeran las m+n

m

ubicaciones posibles de las X en el conjunto de las m + n observaciones,

y

m+n

se calcula T en cada caso. Se obtiene ası́ un conjunto T de m números.

m+n −1

, cuando

m

−1

, si ν(t)

ν(t) m+n

m

Cada uno de los valores t ∈ T tiene la misma probabilidad

son todos diferentes. En general, la probabilidad de t es

es la cantidad de veces que se obtiene el valor

ten T .

m+n

Se observará que si C es la familia de los m subconjuntos de m elementos

de {1, 2, 3, . . . , m + n}, entonces T = { j∈C ψj : C ∈ C}, y este conjunto sólo

depende del conjunto desordenado {ψj : j = 1, 2, 3, . . . , m + n}. En otras

palabras, T resulta ser el mismo conjunto de sumas, no importa en qué orden

estén los elementos de ψ, con tal que estos sean los mismos.

Esta observación está en la base de la prueba de Siegel y Tuckey, incluida

en la Tabla 3.1, para la que esa tabla muestra que la esperanza y la variancia

de T coinciden con la esperanza y la variancia correspondientes a la Prueba

de Wilcoxon. No sólo conciden los momentos; coincide la distribución de T ,

porque los elementos de ψ son los mismos en ambas pruebas, aunque en otro

orden. En la prueba de Wilcoxon, los números 1, 2, . . . , m + n se ubican en

orden creciente en los m + n lugares del vector ψ. En cambio, en la de Siegel

y Tuckey, se distribuyen de manera que los valores más bajos están en los

extremos, y los más altos en el centro, para distinguir, de la misma manera

que en la Prueba de Ansari-Bradley, las alternativas de cambio de dispersión.

La diferencia es que las componentes de ψ en la prueba de Ansari-Bradley se

repiten de manera simétrica:

1 2 3 4 ... 4 3 2 1

mientras que en la de Siegel-Tuckey se cambian ligeramente para que no se

repitan:

1 4 5 8 ... 7 6 3 2

La ventaja de utilizar los mismos números como componentes de ψ es que

de esa manera, las tablas de la distribución del estadı́stico de Wilcoxon bajo

la hipótesis nula se aplican a la distribución del nuevo estadı́stico.

3.6

.

Programa para el cálculo de la distribución

de los estadı́sticos lineales de rangos

Licenciatura en Estadı́stica.

3.6. Ejemplos de pruebas lineales de rangos.

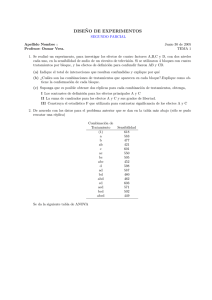

Tabla 3.1: Momentos de T =

de uso corriente.

Nombre

ψi

1=1

ψR(Xi ) correspondientes a algunas pruebas

ET =

Fisher y Yates

EΦ−1 (U(i) )

Van der Waerden

Φ−1 (i/(m + n + 1))

Wilcoxon

i

1

2

m

de la Mediana

i

+ 12 sign 12 − m+n

45

m

m+n

m+n

j=1

mn

×

(m+n)(m+n−1)

m+n

1

ψj2 − m+n

(

ψ j )2

j=1

j=1

VarT =

ψj

m+n

0

-

0

-

m(m+1)

2

+

mn

2

mn(m+n+1)

12

mn

,

4(m+n−1)

si m + n es par

m

2

mn

,

4(m+n)

si m + n es impar

Capon

E(Φ−1 (U(i) )2

Klotz

Φ−1 (i/(m + n + 1))2

Mood

i−

m+n+1 2

2

Ansari - Bradley

i ∧ (m + n + 1 − i)

m

-

-

-

m((m+n)2 −1)

12

mn(m+n+1)((m+n)2 −4)

180

m(m+n+2)

,

4

mn(m+n−2)(m+n+2)

,

48(m+n−1)

si m + n es par

si m + n es par

m(m+n+1)2

,

4(m+n)

mn(m+n+1)((m+n)2 +3)

,

48(m+n)2

si m + n es impar

Siegel - Tuckey

2(i ∧ (m + n + 1 − i)) −

1

2

1−(−1)i

2

de las Cuartilas

i

+ 12 sign(| 12 − m+n+1

| − 14 )

m(m+1)

2

+

si m + n es impar

mn(m+n+1)

12

mn

2

m(m+n−1)

2(m+n)

mn((m+n)2 −2(m+n)−1))

4(m+n)2 (m+n−1)

si m + n = 3 mod4

2km

, k = [(m + n)/4]

m+n

si m + n = 3 mod4

si m + n = 3 mod4

2kmn(m+n−2k)

(m+n)2 (m+n−1)

si m + n = 3 mod4

Savage

m+n

j=m+n+1−i

1

j

m

mn

m+n−1

1−

1

m+n

1

m+n

j

j=1

46

Enrique M. Cabaña.

Capı́tulo 3: Estadı́sticos de rangos lineales.

El siguiente programa enumera las combinaciones y calcula la distribución

de T , a partir de los datos m, n, p, donde p es un vector de m + n componentes que representa las componentes de ψ. El resultado es el vector “vcrit”,

cuyas componentes son los valores crı́ticos cα correspondientes a las regiones

de rechazo T < cα , para niveles α = 0.001, 0.005, 0.01, 0.025, 0.05, 0.1.

nu=m+n;

l=gamma(nu+1)/(gamma(m+1)*gamma(n+1));

t=zeros(1,l);

u=zeros(1,nu);

i=1;

h=[1:m];

t(1)=sum(p(h));

while h(1)<n+1

if h(m)<nu

h(m)=h(m)+1;

else

j=m-1;

while h(j)==n+j

j=j-1;

end

h(j)=h(j)+1;

for k=j+1:m

h(k)=h(k-1)+1;

end

end

i=i+1;

t(i)=sum(p(h));

end

t=sort(t);

vcrit=t(floor([.001 .005 .01 .025 .05 .1]*l)+1);

De este programa, por ejemplo, cuando se eligen m, n entre 2 y 10, y se

toma el vector p = (1, 2, . . . , m + n) − m+1

(1, 1, . . . , 1), que corresponde a la

2

Prueba de Mann y Whitney, se obtienen la Tabla 3.2.

El agregado al programa anterior de las lı́neas

a=m*sum(p)/nu;

b=m*n*(sum(p.^2)-(sum(p))^2/nu)/(nu*(nu-1));

x=[-3:.1:3];

y=a+sqrt(b)*x;

y el dibujo de las gráficas de (t, [0 : l]/l) y de (y, Φ(x)) permite comparar la

distribución de T con la distribución normal con la misma media y variancia.

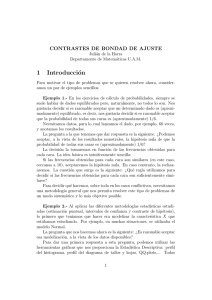

Las Figuras 3.1 muestran los resultados en los casos m = 2, n = 3 y m =

10, n = 10.

Se observará que las tablas de la distribución bajo H0 del estadı́stico de

Mann y Whitney valen también para el de Wilcoxon, sumando a los valores

crı́ticos la constante m(m + 1)/2, y, por los comentarios de la sección precedente, también son utilizables para el estadı́stico de Siegel y Tuckey.

Licenciatura en Estadı́stica.

3.7. Acerca de la distribución de T cuando F = G.

47

Tabla 3.2: Valores crı́ticos cα de la Prueba de Mann y Whitney de nivel α, con

región crı́tica T < cα , para muestras de tamaños m y n.

m

n=2

n=3

n=4

n=5

2

3

4

5

6

7

8

9

10

0

0

0

0

0

0

0

0

0

0

0

0

0

0

0

0

1

1

0

0

0

0

1

1

2

2

3

0

0

0

1

2

2

3

4

5

2

3

4

5

6

7

8

9

10

0

0

0

0

0

0

0

0

0

0

0

0

0

0

1

1

2

2

0

0

0

1

2

2

3

4

4

0

0

1

2

3

4

5

6

7

2

3

4

5

6

7

8

9

10

0

0

0

0

0

0

1

1

1

0

0

0

1

2

2

3

3

4

0

0

1

2

3

4

5

5

6

0

1

2

3

4

6

7

8

9

2

3

4

5

6

7

8

9

10

0

0

0

1

1

1

2

2

2

0

1

1

2

3

3

4

5

5

0

1

2

3

4

5

6

7

8

1

2

3

5

6

7

9

10

12

2

3

4

5

6

7

8

9

10

0

1

1

2

2

2

3

3

4

1

2

2

3

4

5

6

6

7

1

2

4

5

6

7

8

10

11

2

3

5

6

8

9

11

13

14

n=6

n=7

α = 0.5%.

0

0

0

0

1

1

2

2

3

4

4

5

5

7

6

8

7

10

α = 1%.

0

0

0

1

2

2

3

4

4

5

5

7

7

8

8

10

9

12

α = 2.5%.

0

0

2

2

3

4

4

6

6

7

7

9

9

11

11

13

12

15

α = 5%.

1

1

3

3

4

5

6

7

8

9

9

12

11

14

13

16

15

18

α = 10%.

2

2

4

5

6

7

8

9

10

12

12

14

14

17

16

19

18

22

n=8

n=9

n = 10

0

0

2

3

5

7

8

10

12

0

1

2

4

6

8

10

12

14

0

1

3

5

7

10

12

14

17

0

1

3

5

7

8

10

12

14

0

2

4

6

8

10

12

15

17

0

2

4

7

9

12

14

17

20

1

3

5

7

9

11

14

16

18

1

3

5

8

11

13

16

18

21

1

4

6

9

12

15

18

21

24

2

4

6

9

11

14

16

19

21

2

5

7

10

13

16

19

22

25

2

5

8

12

15

18

21

25

28

3

6

8

11

14

17

20

23

25

3

6

10

13

16

19

23

26

29

4

7

11

14

18

22

25

29

33

Enrique M. Cabaña.

Capı́tulo 3: Estadı́sticos de rangos lineales.

48

Figura 3.1: Funciones de distribución del estadı́stico de Mann y Whitney para

muestras de tamaño 2 y 3 (izquierda) y 10 y 10 (derecha) y función de distribución normal, con iguales media y variancia.

3.7

Acerca de la distribución de T bajo la alternativa F = G.

Llamemos f , g a las densidades de F y G, respectivamente, que supondremos

que existen. En ese caso, las densidad conjunta del vector de los estadı́sticos

de orden (X(a) , . . . , X(m) , Y(a) , . . . , Y(m) ) en (x1 , . . . , xm , y1 , . . . , yn ) con x1 < x2

< . . . < xm , y1 < y2 < . . . < yn es m!n!f (x1 )f (x2 ) . . . f (xm )g(y1 )g(y2 ) . . . g(yn ).

Vamos a introducir el vector aleatorio U definido por U = (U1 , . . . , Um+n ),

Uj = 1{j∈{R(Xi ):i=1,2,...,m}} , a partir del cual T y su esperanza se escriben en la

forma:

T =

m+n

j=1

ψj Uj , ET =

m+n

ψj P{Uj = 1}.

j=1

Llamemos U al conjunto de los valores posibles del vector aleatorio U .

De acuerdo a su definición, U es la familia de todos los vectores de m + n

componentes, que tienen m de ellas iguales a 1 y las restantes iguales a 0.

Para calcular P{Uj = 1} vamos a evaluar primero P{U = u} para cada u ∈ U

y luego P{Uj = 1} = u∈U ,uj =1 P{U = u}.

Licenciatura en Estadı́stica.

3.7. Acerca de la distribución de T cuando F = G.

49

Para u ∈ U,

P{U = u} =

...

m!n!

m+n

t1 <t2 <...<tm+n

=

...

m!n!

t1 <t2 <...<tm+n

[(f (tj ) − g(tj ))uj + g(tj )]dtj

j=1

m+n

j=1

f (tj )

1+

− 1 uj g(tj )dtj .

g(tj )

(x)

En el caso particular fg(x)

= 1 + τ k(x) que corresponde a la hipótesis nula

f (x) = g(x) cuando τ = 0, y a alternativas próximas a la hipótesis nula para

τ pequeño, obtenemos, con el agregado del subı́ndice τ que pone de manifiesto

la dependencia respecto a este parámetro,

Pτ {U = u} =

...

m!n!

m+n

t1 <t2 <...<tm+n

[1 + τ k(tj )uj ] g(tj )dtj .

(3.4)

j=1

Aunque el cálculo de la probabilidad a partir de esta fórmula sólo parece

practicable para valores muy particulares de los integrandos, la derivada respecto de τ en τ = 0 tiene una expresión relativamente sencilla:

m!n!

k(tj )uj

∂Pτ {U = u} =

...

∂τ

τ =0

=

m+n

uj

m+n

t1 <t2 <...<tm+n

...

t1 <t2 <...<tm+n

j=1

m!n!k(tj )

j=1

m+n

m+n

g(tj )dtj

j=1

g(tk )dtk =

m+n

uj Ek(Z(j) ),

j=1

k=1

donde Z(1) , . . . , Z(m+n) es una muestra ordenada de tamaño m + n de la distribución G con densidad g.

De aquı́ resulta

m+n

∂Pτ {Uh = 1} ∂Pτ {U = u} =

=

uj Ek(Z(j) )

∂τ

∂τ

u∈U ,uh =1

u∈U ,uh =1 j=1

τ =0

τ =0

=

m+n

uj 1{uh = 1}Ek(Z(j) ) =

u∈U j=1

= uh Ek(Z(h) )

u∈U

1{uh = 1} +

j=h

m+n

uj Ek(Z(j) )

j=1

Ek(Z(j) )

u∈U

1{uh = 1}

u∈U

1{uh = 1, uj = 1}

m+n−1

m+n−2

= uh Ek(Z(h) )

+

Ek(Z(j) )

m−1

m−2

j=h

Enrique M. Cabaña.

Capı́tulo 3: Estadı́sticos de rangos lineales.

m+n−1

m+n−2

= uh Ek(Z(h) )

−

m−1

m−2

50

m+n

m+n−2

+

m−2

m+n

j=1

m+n−2

Ek(Z(j) ) = uh Ek(Z(h) )

,

m−1

m+n

porque j=1 Ek(Z

(j) ) =

j=1 Ek(Zj ) = (m + n)Ek(Zj ), y, por la definición

1 de k, Ek(Zj ) = τ (f (x)/g(x) − 1)g(x)dx = 0.

Como consecuencia,

m+n

∂ET m+n−2

=

ψ

.

j Ek(Z(j) )

m−1

∂τ τ =0

j=1

(3.5)

El resultado tiene interés, porque describe localmente, cuando f es próxima

a g, cómo varı́a la esperanza del estadı́stico T cuando f se aparta de g en una

dirección descrita por la función k.

Esta descripción correspondiente a un caso extremadamente particular

puede generalizarse. En efecto, cuando las densidades admiten un desarrollo de primer orden de la forma

f (x)

= 1 + τ k(x) + o(τ ),

g(x)

en las condiciones que se establecen con precisión en el siguiente enunciado, el

resultado del cálculo previo de la derivada de ET respecto de τ en τ = 0 sigue

siendo válido.

Teorema 3.7.1 Para cada τ en un entorno de 0, consideremos muestras aleatorias simples Y1 , . . . , Yn cuya distribución tiene densidad g y X1 , . . . , Xm con

densidad fτ , y supongamos que existen funciones K y k tales que

fτ (x)

g(x)

=1+

τ kτ (x)

,

2

(3.6)

limτ →0 (kτ (x) − k(x))2 g(x)dx = 0, |kτ | ≤ K(x) para todo x, y

K m (x)g(x)dx < ∞ para todo m.

(3.7)

T

Cuando se cumplen esas condiciones, vale la expresión (3.5) para ∂ E

∂τ

τ =0

.

Licenciatura en Estadı́stica.

3.8. Un criterio para la selección de ψ.

Ejemplo 3.7.1 Cuando g(x) = ϕ(x) =

fτ (x)

g(x)

=

2

√1 e−x /2

2π

51

y fτ (x) = g(x−t), entonces

e−(x−t)2 /2

2

= exτ /2−τ /4

2 /2

−x

e

y

kτ (x) =

2 xτ /2−τ 2 /4

2

1

2

(e

− 1) = (xτ /2 − τ 2 /4 + (xτ /2 − τ 2 /4)2 eλ(xτ /2−τ /4) )

τ

τ

2

= x − τ /2 + τ (x/2 − τ /4)2 eλ(xτ /2−τ

2 /4)

con 0 < λ < 1.

La función kτ (x) está uniformemente acotada en valor absoluto por K(x)

= |x| + (1/2) + (|x|/2 + 1/4)2 e|x|/2+1/4 para |τ | ≤ 1, y su lı́mite cuando τ

tiende a cero es k(x) = x, que difiere de kτ en valor absoluto en menos

de

m

2 |x|/2+1/4

|τ |(1/2+(x/2+1/4) e

cuando |τ | ≤ 1. La función K satisface K ϕ <

∞, como resulta inmediato

verificar

debido

a la rapidez con que ϕ tiende a

2

cero en infinito, y | (kτ − k) ϕ| ≤ |τ | (1/2 + (x/2 + 1/4)2 e|x|/2+1/4 )ϕ(x)dx

→ 0 cuando τ → 0.

2

Demostración del Teorema. El desarrollo (3.6) nos permite escribir

fτ (x) = g(x)(1 + τ kτ (x) + τ 2 kτ2 (x)/4)

y entonces la expresión (3.4) de Pτ {U = u} es reemplazada por

...

m!n!

t1 <...<tm+n

m+n

j=1

1

1 + (τ kτ (tj ) + τ 2 kτ2 (tj ))uj g(tj )dtj ,

4

y el cociente incremental puede escribirse en la forma

1

(Pτ {U = u} − P0 {U = u})

τ

=

...

m+n

t1 <...<tm+n j=1

[kτ (tj ) +

τ kτ2 (tj )Q(τ kτ (tj ))]uj

m!n!

g(tk )dtk ,

k

donde Q es un polinomio.

Las hipótesis permiten pasar al lı́mite cuando τ → 0 dentro de la integral,

de modo que

m+n

∂Pτ {U = u} =

uj Ek(Z(j) ),

∂τ

j=1

τ =0

donde Z(1) , . . . , Z(m+n) es, como antes, una muestra ordenada de tamaño m+n

de la distribución con densidad g. A partir de aquı́, se repiten sin modificación

los argumentos utilizados para el caso particular tratado inicialmente.

2

Enrique M. Cabaña.

Capı́tulo 3: Estadı́sticos de rangos lineales.

52

3.8

3.8.1

Un criterio para la selección de los coeficientes.

Coeficientes localmente óptimos.

Los coeficientes ψ = (ψ1 , . . . , ψm+n ) intervienen en los resultados obtenidos

previamente:

E0 T =

m

mn

Sψ , Var0 T =

SCDψ ,

m+n

(m + n)(m + n − 1)

(3.8)

m+n

m+n−2

∂Eτ T =

ψ

,

j Ek(Z(j) )

m−1

∂τ τ =0

j=1

(3.9)

2

donde Sψ es la suma de las componentes del vector ψ, SCDψ = m+n

j=1 ψj

m+n

−( j=1 ψj )2 /(m + n) es la suma de cuadrados de diferencias con la media de

las componentes del mismo vector, y los subı́ndices agregados a la esperanza y

a la variancia nos recuerdan a qué valor de τ corresponden las distribuciones

bajo las que se calculan esos momentos.

Un criterio adecuado para la selección de ψ es pedir que el sesgo de T , una

vez tipificada bajo la hipótesis nula, sea lo mayor posible, al menos localmente,

cerca de τ = 0. Para obtenerlo, pediremos que la derivada respecto de τ de la

variable tipificada (Var0 T )−1/2 (T − E0 T ) sea lo más grande posible en valor

absoluto, esto es, buscaremos ψ que maximice

(Var0 T )−1

∂Eτ T ∂τ τ =0

2

=

m+n

j=1

ψj Ek(Z(j) )

m+n−2

m−1

mn

SCDψ

(m+n)(m+n−1)

2

.

El denominador no varı́a cuando a cada componente de ψ se agrega o

sustrae una constante, dado que sólo intervienen las diferencias de cada componente de ψ con el promedio de todas ellas, pero tampoco el numerador varı́a,

porque la suma de las esperanzas Ek(Zj ) es nula, como observamos más arriba.

Por lo tanto, podemos limitarnos a buscar soluciones para las que Sψ = 0, y

en ese caso la suma de cuadrados de diferencias que aparece en el cociente se

2

reduce a SCDψ = SCψ = m+n

j=1 ψj .

Tampoco varı́a el cociente cuando cada componente de ψ se multiplica

por una misma constante, porque tanto el numerador como el denominador

son homogéneos de segundo orden. Esto nos permite agregar la condición

m+n 2

j=1 ψj = 1, por ejemplo, sin alterar el máximo.

Licenciatura en Estadı́stica.

3.9. Distribución asintótica.

53

Encontramos entonces que los coeficientes que maximizan el sesgo relativo

del estadı́stico T son los que maximizan el producto interno m+n

j=1 ψj Ek(Z(j) )

∗

de los vectores ψ y κ = (Ek(Z(1) ), . . . , Ek(Z(m+n) )).

vectores ψ de norma

La solución a este problema es inmediata: De todos los

m+n

m+n 2

j=1 ψj = 1, ortogonales a 1 = (1, 1, . . . , 1) (ya que

j=1 ψj = 1), el que

∗

tiene mayor producto interno con κ es el que minimiza el ángulo (ψ, κ∗ ). Dado

que también κ∗ es ortogonal a 1, el vector ψ que minimiza el ángulo es el propio

κ∗ normalizado:

ψ̂ = κ∗ /||κ∗ ||.

En virtud de las observaciones anteriores, cualquier vector con componentes

ψj = a + bEk(Zj )

con a, b constantes cualesquiera, produce el mismo valor máximo del sesgo

relativo local.

Ejemplo 3.8.1 Como consecuencia del criterio precedente, se verifica que la

prueba de Fisher y Yates tiene los coeficientes localmente óptimos para detectar

desplazamientos a partir de una distribución normal.

2

3.8.2

Coeficientes aproximadamente óptimos.

Dado que las variables Z(j) pueden obtenerse mediante la transformación Z(j)

= G−1 (U(j) ), con U(1) , . . . , U(m+n) muestra ordenada de la distribución unij(m+n+1−j)

forme en (0, 1), y que VarU(j) = (m+n)

2 (m+n+1) → 0 cuando m + n → ∞ es de

j

esperar que U(j) sea próximo a su esperanza m+n+1

, y que Z(j) sea próximo a

j

−1

G ( m+n+1 ), de modo que, si k es suficientemente regular, se cumplirá aproxj

), con k(z) = κ(G(z)). Por lo tanto, una

imadamente Ek(Z(j) ) ≈ κ( m+n+1

versión aproximada de los coeficientes óptimos según el criterio de la sección

j

anterior es ψj = a + b κ( m+n+1

).

1 m+n

En este caso, m+n j=1 ψj ≈ a + b 01 κ(u)du.

Ejemplo 3.8.2 Como consecuencia, la prueba de van der Waerden tiene coeficientes aproximadamente óptimos para detectar desplazamientos a partir de

una distribución normal.

2

Enrique M. Cabaña.

Capı́tulo 3: Estadı́sticos de rangos lineales.

54

3.9

Distribución asintótica de los estadı́sticos

de rangos lineales.

3.9.1

Distribución bajo H0 : “F = G = F0 ”

Cuando los coeficientes ψj son de la forma

j

,

ψj = ψ

m+n+1

(3.10)

para alguna función adecuada ψ, el estadı́stico T =

cribirse en la forma

T =m

m

i=1

ψR(Xi ) puede es-

mFm (t) + nGn (t)

ψ

dFm (t),

m+n+1

(3.11)

donde Fm (t) = m1 m

i=1 1{Xi ≤t} es la función de distribución empı́rica de X1 ,

. . ., Xm . En efecto, integrar respecto de dFm equivale a sumar el integrando

evaluado en cada Xi y dividir por m. Por otra parte, el rango de Xi es

precisamente mFm (Xi ) + nGn (Xi ), donde Gn (t) = n1 nj=1 1{Yj ≤t} es la función

de distribución empı́rica de Y1 , . . . , Yn , y esto muestra la validez de (3.11).

Supondremos, sin pérdida de generalidad, ya que

los ψj pueden reem1

plazarse

sin

cambiar

la

información

por

a

+

bψ

,

que

ψ(u)du

= 0, y también

j

0

1 2

que 0 ψ (u)du = 1.

√

El puente empı́rico bX

m(Fm (t) − F (t)) converge a un F -puente

m (t) =

browniano bF , que puede escribirse en la forma bF (t) = bX (F (t)) donde bX es

un puente browniano tı́pico. De la misma manera, el puente empı́rico bYn (t) =

√

m(Gn (t) − G(t)) converge a un G-puente browniano bG , independiente de

bF , que puede escribirse en la forma bG (t) = bY (G(t)) donde bY es un puente

browniano tı́pico independiente de bX .

Usaremos los desarrollos

√

√

Y

Fm (t) = F0 (t) + bX

(t)/

m,

G

(t)

=

F

(t)

+

b

(t)/

m,

n

0

m

n

para escribir

T

m

mF0 (t) +

√

√

=

ψ

m+n

m+n

√

mbX

m (t) + nF0 (t) +

m+n+1

1

× dF0 (t) + √ dbX

(t)

m m

√

nbYn (t)

Licenciatura en Estadı́stica.

55

3.9. Distribución asintótica.

√

√ X

m

mbm (t) + nbYn (t) − F0 (t)

=√

ψ F0 (t) +

− ψ(F0 (t)) dF0 (t)

m+n+1

m+n

√

√ X

m mbm (t) + nbYn (t) − F0 (t)

+

ψ F0 (t) +

dbX

m (t)

m+n

m+n+1

√

√ X

mbm (t) + nbYn (t) − F0 (t)

m

ψ F0 (t) + λ

=√

m+n+1

m+n

√ Y

√ X

mbm (t) + nbn (t) − F0 (t)

×

dF0 (t)

m+n+1

m ψ(F0 (t))dbX

+

m (t)

m+n

√

√ X

m mbm (t) + nbYn (t) − F0 (t)

+

ψ F0 (t) + λ

m+n

m+n+1

√ X

√ Y

mbm (t) + nbn (t) − F0 (t) X

×

dbm (t)

m+n+1

En esta última expresión se ha utilizado la condición ψ(F0 (x))dF0 (x) = 0,

m

que hace desaparecer el término cuyo coeficiente √m+n

tiende a infinito cuando

m, n → ∞.

Si bien no haremos un razonamiento riguroso, que requiere imponer alguna

condición de regularidad a la función ψ, resulta plausible que, para ψ suficientemente regular, la distribución asintótica de esta expresión cuando m, n

m

n

tienden a intinito de modo que m+n

→ µ, m+n

→ ν, es la de

√

µ µ

√ bX (F0 (t))dψ(F0 (t)) + µ ν bY (F0 (t))dψ(F0 (t))

√

+ µ

√

1

=µ µ

0

=

ψ(F0 (t))dbX (F0 (t))

1

√ 1

√

bX (u)dψ(u) + µ ν

bY (u)dψ(u)] + µ

ψ(u)dbX (u)

√

=

µ(1 − µ)

√

1

µν

0

1

0

0

ψ(u)dbX (u) −

ψ(u)dwX (u) −

√

√

1

νµ

1

νµ

0

0

0

ψ(u)dbY (u)

ψ(u)dwY (u),

porque los puentes pueden expresarse en la forma bX (u) = wX (u) − uwX (1),

bY (u) = wY (u) − uwY (1), a partir de dos procesos

de Wiener tı́picos indepen1

1

dientes wX , wY , y las

integrales 0 ψ(u)dbX (u), 0 ψ(u)dwX (u) coinciden, ya

que difieren en w(1) 01 ψ(u)du, que vale cero.

Enrique M. Cabaña.

Capı́tulo 3: Estadı́sticos de rangos lineales.

56

Las variables gaussianas 01 ψ(u)dwX(u), 01 ψ(u)dwY (u) son independientes, con esperanzas nulas y variancias 01 ψ 2 (u)du = 1, de modo que la disT

tribución asintótica de √m+n

bajo H0 es normal, con esperanza cero y variancia

2

2

µ ν + µν = µν.

3.9.2

Distribución bajo alternativas contiguas.

Cuando

√ para cada n, las variables X1 , . . ., Xm tienen densidad fτ con τ

= δ/ m + n, las variables Y1 , . . ., Yn tienen densidad g, y estas densidades

cumplen las condiciones del Teorema 3.7.1, excepto (3.7) que basta que se

cumpla para m = 2, decimos que estamos en presencia de alternativas

con 2

tiguas.

La

función

k

del

enunciado

del

mismo

Teorema

cumple

k

(x)dF

0 (x)

2

≤

K (x)dF0 (x) < ∞. La escribiremos en la forma k(x) = cκ(F0 (x)), con

1 2

0 κ (u)du = 1. A los productos δck y δcκ los llamaremos apartamiento

asintótico y apartamiento asintótico tipificado de la sucesión de alternativas. El

producto δc da el tamaño de los apartamientos y las funciones k y κ, describen

su forma.

El llamado Tercer Lema de Le Cam indica que bajo las condiciones de

contigüidad, la distribución asintótica de los procesos empı́ricos es la misma

que bajo la hipótesis nula, más un sesgo que podemos calcular directamente:

Con nuestra notación asimétrica en que dejamos G constante igual a F0 ,

)

(g = f0 ) el sesgo asintótico de b(Y

es nulo, mientras que el de b(X)

n

m está dado

por

√

√ x

(X)

Ebm (x) = m(Fm (x) − F0 (x)) = m

(fδc/√m+n (x) − f0 (x))dx

=

√

x

−∞

→

√

x

µδc

−∞

κ(F0 (t))dF0 (t) =

√

u

µδc

De aquı́ resulta que la distribución lı́mite de

√

2 √

(x)

δckδc/√m+n (x) δ 2 c2 kδc/

m+n

f0 (x)dx

√

m

+

4(m + n)

m+n

−∞

1

µν

0

ψ(u)(dwX (u) +

√

µδcκ(s)ds) −

∼ Normal(0, µν) + µνδc

−∞

√T

m+n

√

κ(s)ds

es la de

1

νµ

0

ψ(u)dwY (u)

1

ψ(u)κ(u)du.

(3.12)

0

Esta expresión corresponde a la sucesión de alternativas contiguas, y también a la hipótesis nula, cuando se elige δ igual a cero.

Licenciatura en Estadı́stica.

3.10. Criterio alternativo para la selección de ψ.

3.9.3

57

Un criterio alternativo para la selección de los coeficientes.

A partir de (3.12), encontramos que el sesgo

del estadı́stico T es máximo

cuando ψ se elige de modo que la integral 01 ψ(u)κ(u)du sea máxima. De

todas las funciones ψ con integral nula y con integral del cuadrado igual a 1,

la que maximiza

la integral del producto con κ es proporcional a κ, a saber,

ψ̂(u) = κ(u)/

κ2 (s)ds.

Este resultado es asintóticamente equivalente al de los criterios de selección

de ψ considerados previamente.

Las tablas de las secciones siguientes, indican los valores de la función κ

para

algunas alternativas de interés. La constante c se ha elegido para que

1 2

0 κ (s)ds = 1. De esta manera, ψ̂ = κ.

Observemos que los criterios ψ̂ = κ encontrado en esta sección y ψj =

j

a + b κ( m+n+1

) obtenido en §3.8.2 coinciden, en virtud de (3.10), ya que coeficientes que difieren en posición o escala conducen a pruebas esencialmente

equivalentes.

3.10

La eficacia de un estadı́stico.

Cuando la sucesión de estadı́sticos Tm,n correspondientes a muestras de tamaños m, n tiene una distribución asintótica como la indicada en (3.12), hemos observado que conviene elegir los coeficientes ψ, a igualdad de otros parámetros,

de manera que maximicen el sesgo que produce cuando vale la alternativa,

respecto de la distribución correspondiente a la hipótesis nula. Esto se debe,

en particular, a que en ambos casos la variancia asintótica del estimador es la

misma.

Para cuantificar la sensibilidad de una sucesión de estadı́sticos Tm,n frente

a cierta sucesión de alternativas para las cuales el comportamiento asintótico

tiene la forma de (3.12), utilizaremos la diferencia de las esperanzas correspondientes a la alternativa y a la hipótesis nula, del estadı́stico tipificado.

En el caso (3.12) el cuadrado de esta diferencia o sesgo tipificado vale

1

(E(Tm,n |Hm,n ) − E(Tm,n |H0 ))2

ψ(u)κ(u)du

lim

= µν δc

m,n→∞

Var(Tm,n |H0 )

0

2

.

Cuando se comparan dos estadı́sticos lineales de rangos para la detección

de las mismas alternativas, con muestras de iguales tamaños, la relación entre estos sesgos tipificados depende de los coeficientes ψ elegidos. Llamamos

Enrique M. Cabaña.

Capı́tulo 3: Estadı́sticos de rangos lineales.

58

eficacia relativa del estadı́stico con coeficientes ψ respecto del estadı́stico con

coeficientes ψ para las alternativas con apartamiento asintótico tipificado κ al

cociente entre los cuadrados de los sesgos tipificados del primero respecto del

último, que vale

1

2

0 ψ (u)κ(u)du

e.r.κ (ψ , ψ) = 1

0 ψ(u)κ(u)du

Con la convención ψ2 = 01 ψ 2 (u)du = 1, la selección de ψ que produce la

máxima eficacia es ψ = κ. Llamaremos eficacia del estadı́stico con coeficientes

ψ a su eficacia relativa al estadı́stico que maximiza el sesgo, es decir,

1

0

eκ (ψ ) =

ψ (u)κ(u)du

1

2

0 κ (u)du

2

1

=

ψ (u)κ(u)du

2

,

0

porque 01 κ2 (u)du = 1.

Dadas dos sucesiones de alternativas

con apartamientos asintóticos tipi1

ficados κ y κ , el producto interno 0 κ(u)κ (u)du nos indica la eficacia del

estadı́stico lineal de rangos óptimo para una de ellas, respecto de la otra. En

la próxima sección describimos algunas sucesiones particulares de alternativas, sus apartamientos asintóticos, e indicaremos también algunos de estos

productos internos que nos muestran hasta qué punto un estadı́stico diseñado

para detectar de manera óptima cierta alternativa, resulta apto para detectar

también otras.

3.11

Algunos ejemplos de alternativas contiguas y sus apartamientos asintóticos.

3.11.1

Alternativas de cambio de posición.

Si F0 (con densidad f0 respecto de cierta medida µ) es la distribución de

(X1 , . . . , Xn ) bajo H0 , tomaremos H1 : “F = F0 (·− √δcn )”. Como consecuencia,

la densidad asociada a H1 es fn = f0 (· − √δcn ), y entonces

√

δc

√

f0 (x)

2 n

f0 (x − n )

k(x) = lim kn (x) = lim

−

1

.

= −c

n→∞

n→∞ δ

f0 (x)

f0 (x)

El coeficiente c =

−1/2

(f0 (x))2

dµ(x)

f0 (x)

se elige para que k = 1.

Licenciatura en Estadı́stica.

3.11. Ejemplos de alternativas contiguas.

59

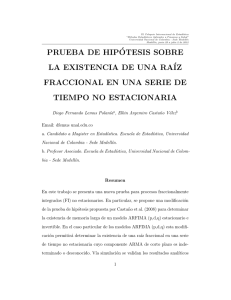

La Tabla 3.3 indica los valores de c, k(x) = κ(F0 (x)) y κ(u) correspondientes

a algunas distribuciones. Excepto la última (distribución de Cauchy) que no

tiene momentos finitos, las distribuciones se han tomado centradas en cero y

con variancia uno, para su normalización. La Figura 3.11.1 permite comparar

entre sı́ los apartamientos correspondientes a cada una de las distribuciones.

3.11.2

Alternativas de cambio de dispersión.

Nuevamente suponemos que F0 con densidad f0 respecto de µ es la distribución

asociada a H0 , y tomamos H1 : “F = F0 ((1 + √δcn )·). La densidad asociada a

H1 es fn (x) = (1 + √δcn )f0 ((1 + √δcn )x) y

√

δc

√

δc f0 (x)

2 n

f0 ((1 + n )x)

k(x) = lim

,

− 1 = c 1 + x

1+ √

n→∞ δ

n

f0 (x)

f0 (x)

f (x)

con c tal que c2 (1 + x f00 (x) )2 f0 (x)dµ(x) = 1. Para las mismas distribuciones

de la Tabla 3.3, los nuevos c, k(x), κ(x) se indican en la Tabla 3.4.

3.11.3

Pruebas óptimas para cambios de posición.

De acuerdo a los criterios de §3.8.1, la prueba localmente óptima para desplazamientos de distribuciones normales es la que tiene coeficientes proporcionales

a Eκ(Φ−1 (U(i) )), con κ = κnorm indicada en la primera lı́nea de la Tabla 3.3.

Se trata por lo tanto de la Prueba de Fisher y Yates indicada en la primera

lı́nea de la Tabla 3.1.

La prueba de van der Waerden indicada en la segunda lı́nea de la misma

tabla es la que hemos llamado aproximadamente óptima en §3.8.2, para las

mismas alternativas.

Los apartamientos asintóticos tipificados para desplazamientos

de distribu√

ciones logı́sticas son proporcionales a la abscisa (κlog = 3(2u − 1)), a menos

de cambios en posición o escala. Esto implica que las pruebas con coeficientes

de la misma forma, a saber, la de Wilcoxon o la de Mann y Whitney, son las

óptimas. Dado que en este caso κ es un polinomio de primer grado, coinciden

Eκ(U(i) ) y κ(EU(i) ), por lo que coinciden las pruebas localmente óptimas con

las aproximadamente óptimas.

Los apartamientos asintóticos para las distribuciones doble-exponenciales

son κde = sgn(u − 12 ), y esto implica que la Prueba de la Mediana es aproximadamente óptima para desplazamientos de estas distribuciones.

Enrique M. Cabaña.

Capı́tulo 3: Estadı́sticos de rangos lineales.

60

Tabla 3.3: Apartamientos asintóticos para alternativas de cambio de posición.

Normal: φ(x)

2

= √1 e−x /2

2π

Doble exponencial:

√

− 2|x|

fDE (x) = e √

2

Logı́stica: f√LG (x)

π eπx/ 3

√

3

√

=

(1+eπx/ 3 )2

Cauchy: fCA (x)

1

= π(1+x

2)

f (x)

f0 (x)

c

k(x) = −c f0 (x)

κ(u) = k(F0−1 (u))

−xφ(x)

1

x

κnorm = Φ−1 (u)

√

−sgn(x) 2fDE (x)

1

√

2

sgn(x)

κde = sgn(u − 12 )

3

π

√ eπx/√3 −1

3 πx/√3

e

+1

f0 (x)

√

√

π 2 eπx/ 3 (1−eπx/ 3 )

3(1+e

√

πx/ 3 )3

√

−2x

π(1+x2 )2

0

√

2 2x

1+x2

2

κlog =

κc =

√

√

3(2u − 1)

2 sin π(2u − 1)

3

2

1

0

-1

-2

-3

0

0.2

0.4

0.6

0.8

1

Figura 3.2: Apartamientos normalizados (κ(u), 0 ≤ u ≤ 1) para cambios en

posición (—: normal, · · ·: logı́stica, - - -: doble exponencial, -·-·: Cauchy).

Licenciatura en Estadı́stica.

3.11. Ejemplos de alternativas contiguas.

61

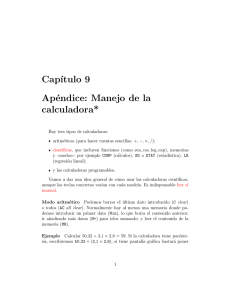

Tabla 3.4: Apartamientos asintóticos para alternativas de cambio de dispersión.

Distribución

c

Normal

1

√

2

Doble exponencial

1

Logı́stica

√ 3

3+π 2

√

2

Cauchy

k(x)

1

√

(1 −

2 √

κ(u)

√1 (1

2

x2 )

1−

√

2|x| √

πx eπx/√3 −1

−√

)

3 eπx/ 3 +1

√ 1−x2

2 1+x2

3

(1

3+π 2

− (Φ−1 (u))2 )

1 + log(1 − |2u − 1|)

√

3

(1

3+π 2

√

− (2u − 1) log

u

))

1−u

2 cos π(2u − 1)

2

0

-2

-4

-6

-8

0

0.2

0.4

0.6

0.8

1

Figura 3.3: Apartamientos normalizados (κ(u), 0 ≤ u ≤ 1) para cambios en

dispersión (—: normal, · · ·: logı́stica, - - -: doble exponencial, -·-·: Cauchy).

62

Enrique M. Cabaña.

Capı́tulo 3: Estadı́sticos de rangos lineales.

La vinculación exacta entre otras pruebas y las alternativas para las que

resultan óptimas no resulta evidente de la información contenida en las Tablas

3.1, 3.3 y 3.4.

La vinculación entre las Pruebas de Fisher y Yates y van der Waerden con

las alternativas de desplazamientos de la distribución normal luce muy natural.

La distribución normal tiene un uso muy extendido, y resulta razonable el

diseño de pruebas que reflejen adecuadamente alternativas de desplazamientos

de muestras normales. De la misma manera, resulta razonable el diseño de

pruebas sensibles al cambio de dispersión entre muestras normales, y ası́ han

surgido las pruebas de Capon y de Klotz, a las que hacen referencia los ejemplos

que siguen.

No ocurre lo mismo con las prueba de Wilcoxon o de Mann y Whitney,

porque la distribución logı́stica no tiene un uso tan frecuente, o, al menos,

no lo tenı́a cuando estas pruebas fueron propuestas. La elección de los coeficientes ψ iguales al rango (eventualmente a menos de cambios en posición

y escala) se debe a su simplicidad. De no haber estado familiarizados con la

distribución logı́stica no habrı́amos reconocido el vı́nculo entre esa distribución

y esas pruebas, y habrı́amos debido buscarlo resolviendo el problema inverso

de la determinación de los coeficientes ψ óptimos para una alternativa dada,

es decir, dados los coeficientes {ψj : j = 1, 2, . . . , m + n} ¿cuáles alternativas

refleja de manera óptima la prueba basada en T = m

i=1 ψR(Xi ) ? El problema

no está completamente determinado, pero el Ejemplo 3.11.3 lo resuelve en el

caso de la Prueba de Wilcoxon, al menos parcialmente.

Ejemplo 3.11.1 Prueba de Capon. De la Tabla 3.4 surge que el apartamiento

asintótico correspondiente a los cambios de dispersión de la distribución normal

es √12 (1 − (Φ−1 (u))2 ), de manera que la prueba con ψi = E(Φ−1 (U(i) ))2 es

localmente óptima.

2

Ejemplo 3.11.2 Prueba de Klotz.Si en vez de los coeficientes localmente óptimos utilizamos los aproximados, en la misma situación que da lugar a la

Prueba de Capon, obtenemos los coeficientes ψi = Φ−1 (i/(m + n + 1)).

2

Ejemplo 3.11.3 ¿Para muestras de qué distribuciones, resulta óptima la prueba de Wilcoxon para detectar desplazamientos relativos? Reemplacemos la

pregunta por la siguiente: ¿Para qué densidad f se obtiene un apartamiento

asintótico tipificado κ(u) proporcional a u, a menos de cambios en posición o

escala?

1

1 2

Dado

√ que κ debe cumplir 0 κ(u)du = 0, 0 κ (u)du = 1, encontramos

κ(u) = 3(2u − 1).

Licenciatura en Estadı́stica.

3.11. Ejemplos de alternativas contiguas.

63

(x)

Las expresiones k(x) = −c ff (x)

, κ(u) = k(F −1 (u)) vinculan el dato κ con

las incógnitas F, F = f . Al reemplazar κ por su valor encontramos la siguiente

ecuación diferencial:

√

f (x)

3(2F (x) − 1) = −c

.

f (x)

√

Una primera integración nos lleva a 3(F 2 (x) − F (x)) = −cf (x) + c1 , o

bien

f (x)

c2 =

,

F (x)(1 − F (x)) + c3

donde c2 y c3 son constantes vinculadas a c y c1 .

Para que la integral de f resulte finita, es necesario elegir c3 = 0, y entonces

la ecuación se escribe en la forma

f (x)

f (x)

+

= c2 ,

F (x) 1 − F (x)

que, integrada, nos da

log

F (x)

= c2 x + c4

1 − F (X)

y por consiguiente F (x) = (1 − F (x))c5 ec2 x , F (x) =

distribución logı́stica.

3.11.4

c5 e c3 x

,

1+c5 ec3 x

y esta es una

2

Cálculo de algunas eficacias.

La Tabla 3.5 indica los cuadrados de los productos internos de los apartamientos asintóticos que figuran en las Tablas 3.3 y 3.4, con las funciones ψ que

se indican en la misma Tabla 3.5, y que determinan los coeficientes de las

pruebas de van der Waerden, de Wilcoxon, de la mediana, de Klotz, de Mood,

de Ansari - Bradley, y de las cuartilas. Las funciones ψ están normalizadas

por un cambio de posición y escala, de modo que cumplan las condiciones

1

1 2

0 ψ(u)du = 0, 0 ψ (u)du = 1.

Enrique M. Cabaña.

Capı́tulo 3: Estadı́sticos de rangos lineales.

64

1

Tabla 3.5: Valores de (

0

κ(u)φ(u)du)2 .

κ(u), 0 < u < 1 (alternativas√de dezplazamiento)√

sgn(u − 12 )

3(2u − 1)

2 sin π(2u − 1)

ψ(u)

Φ−1 (u)

Φ−1 (u)

sgn(u − 12 )

√

3(2u − 1)

1

2/π = .6366

3/π = .9549

2/π = .6366

1

3/4 = .75

3/π = .9549

3/4 = .75

1

.4303

.8106

.6079

0

0

0

0

0

0

0

0

0

0

0

0

0

0

0

0

1−(Φ−1 (u))2

√

2

√

1 2

4

√ 5(u − 2 )

2 3u ∧ (1 − u)

1 − 21{1<4u<3}

κ(u), 0 < u < 1 (alternativas de cambio de dispersión)

u ))

√

3(1−(2u−1) log 1−u

√

1 + log(1 − |2u − 1|)

2 cos π(2u − 1)

2

ψ(u)

1−(Φ−1 (u))2

√

2

Φ−1 (u)

sgn(u

− 12 )

√

3(2u − 1)

0

0

0

0

0

0

0

0

0

0

0

0

1

.9765

.9771

.5508

2 3u ∧ (1 − u)

1 − 21{1<4u<3}

.3377

.1520

.3675

.3858

.1875

.4804

.3885

.1831

.4748

.4106

.2464

.8106

1−(Φ−1 (u))2

√

2

√

2

2(u

− 12 )2

√

3+π

Capı́tulo 4

Comparación de varias

muestras.

4.1

Problema de varias muestras.

Consideramos ahora k muestras aleatorias simples, independientes entre sı́,

de las distribuciones Fi , i = 1, 2, . . . , k. Llamamos Xi,1 , Xi,2 , . . . , Xi,ni a los

elementos de la i-ésima muestra. Llamamos problema de k muestras al que

consiste en probar la hipótesis nula H0 : F1 = F2 = . . . = Fk .

Vamos a considerar pruebas basadas en los rangos de cada uno de los

elementos de las muestras, en el conjunto formado por el agregado de todas

las muestras.

i

Los estadı́sticos lineales de rangos Ti = nj=1

ψR(Xi,j ) calculados para cada

una de las muestras se distribuyen bajo H0 de la misma manera que T (ver

(3.1)), en el caso de dos muestras, con la i-ésima muestra en el lugar de la

primera, y la unión de las restantes, en el lugar de la segunda. Con N =

i ni − ni , ponemos ni en el lugar de m y N − ni en el de n. No es necesario

hacer ningún cálculo nuevo para encontrar, aplicando

el Teorema 3.2.1, que

ni (N −ni ) N

1 N

2

2

bajo H0 ETi = nNi N

ψ

,

y

que

VarT

=

ψ

−

(

ψ

)

.

i

j=1 j

j=1 j

j=1 j

N (N −1)

N

Además, para h = i, tomando como primera muestra el conjunto de las

muestras h-ésima e i-ésima, tenemos que

Var(Th + Ti ) =

con SSψ =

N

j=1

ψj2 , Sψ =

(nh + ni )(N − nh − ni )

(SSψ − Sψ2 /N ),

N (N − 1)

1

N

N

j=1

ψj . Como, por otra parte,

Var(Th + Ti ) = VarTh + VarTi + 2Cov(Th , Ti ),

65

Enrique M. Cabaña.

Capı́tulo 4: Comparación de varias muestras.

66

deducimos que

SSψ − Sψ2 /N

Cov(Th , Ti ) = ((nh + ni )(N − nh − ni ) − nh (N − nh ) − ni (N − ni ))

2N (N − 1)

=−

nh ni

(SSψ − Sψ2 /N ).

N (N − 1)

Con las abreviaturas T = (T1 , T2 , . . . , Tk )tr , n= (n1 , n2 , . . . , nk )tr , p =

n/N , Σ = (diagp − pptr ) tenemos bajo H0 :

ET =

N

n

Sψ , VarT =

Σ(SSψ − Sψ2 /N ).

N

N −1

La distribución asintótica, como en el caso de dos muestras, es también

normal, y se puede deducir de la misma manera. Como consecuencia,

N −1

n

T − Sψ

2

N (SSψ − Sψ /N )

N

tiene distribución asintótica Normal(0, Σ).

Los mismos argumentos utilizados al estudiar la Prueba χ2 permiten concluir que

N −1

n

n

K=

T − Sψ (diagp)−1 T − Sψ

2

N (SSψ − Sψ /N )

N

N

tr

tiene distribución asintótica χ2 con k − 1 grados de libertad.

Kruskal y Wallis propusieron el uso del estadı́stico K para el caso particular

que generaliza la prueba de Wilcoxon. En ese caso Sψ = N (N + 1)/2, SSψ

= N (N + 1)(2N + 1)/6, SSψ − Sψ2 /N = N (N + 1)(2N + 1)/6 − N (N + 1)2 /4

1

= 12

(N + 1)(2N (2N + 1) − 3N (N + 1)) = N (N − 1)(N + 1)/12,

N

N

12

(Ti − ni (N + 1)/2)2

K= 2

N (N + 1) i=1

ni

=

N

Ti2

12

− 3(N + 1).

N (N + 1) i=1 ni

Kruskal y Wallis proporcionaron tablas para el cálculo del nivel de regiones

de la forma K >constante. Pueden obtenerse también de manera exacta mediante un cálculo combinatorio o de manera aproximada mediante simulaciones.