Apuntes

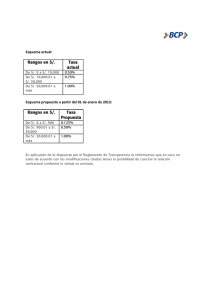

Anuncio

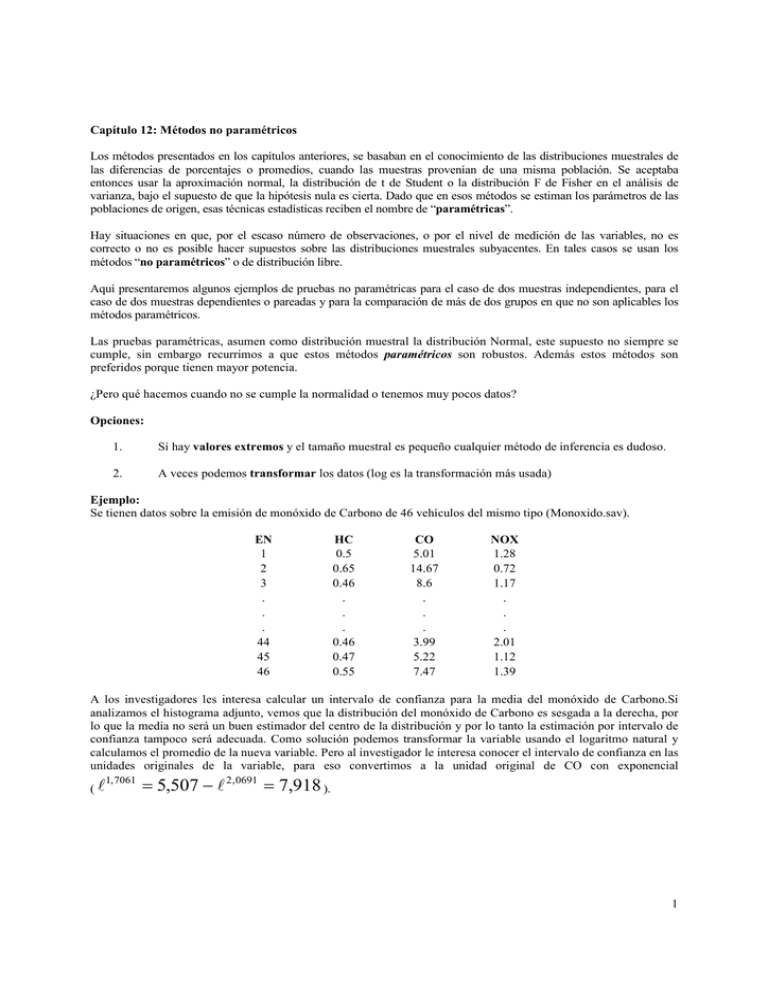

Capítulo 12: Métodos no paramétricos Los métodos presentados en los capítulos anteriores, se basaban en el conocimiento de las distribuciones muestrales de las diferencias de porcentajes o promedios, cuando las muestras provenían de una misma población. Se aceptaba entonces usar la aproximación normal, la distribución de t de Student o la distribución F de Fisher en el análisis de varianza, bajo el supuesto de que la hipótesis nula es cierta. Dado que en esos métodos se estiman los parámetros de las poblaciones de origen, esas técnicas estadísticas reciben el nombre de “paramétricas”. Hay situaciones en que, por el escaso número de observaciones, o por el nivel de medición de las variables, no es correcto o no es posible hacer supuestos sobre las distribuciones muestrales subyacentes. En tales casos se usan los métodos “no paramétricos” o de distribución libre. Aquí presentaremos algunos ejemplos de pruebas no paramétricas para el caso de dos muestras independientes, para el caso de dos muestras dependientes o pareadas y para la comparación de más de dos grupos en que no son aplicables los métodos paramétricos. Las pruebas paramétricas, asumen como distribución muestral la distribución Normal, este supuesto no siempre se cumple, sin embargo recurrimos a que estos métodos paramétricos son robustos. Además estos métodos son preferidos porque tienen mayor potencia. ¿Pero qué hacemos cuando no se cumple la normalidad o tenemos muy pocos datos? Opciones: 1. Si hay valores extremos y el tamaño muestral es pequeño cualquier método de inferencia es dudoso. 2. A veces podemos transformar los datos (log es la transformación más usada) Ejemplo: Se tienen datos sobre la emisión de monóxido de Carbono de 46 vehículos del mismo tipo (Monoxido.sav). EN 1 2 3 . . . 44 45 46 HC 0.5 0.65 0.46 . . . 0.46 0.47 0.55 CO 5.01 14.67 8.6 . . . 3.99 5.22 7.47 NOX 1.28 0.72 1.17 . . . 2.01 1.12 1.39 A los investigadores les interesa calcular un intervalo de confianza para la media del monóxido de Carbono.Si analizamos el histograma adjunto, vemos que la distribución del monóxido de Carbono es sesgada a la derecha, por lo que la media no será un buen estimador del centro de la distribución y por lo tanto la estimación por intervalo de confianza tampoco será adecuada. Como solución podemos transformar la variable usando el logaritmo natural y calculamos el promedio de la nueva variable. Pero al investigador le interesa conocer el intervalo de confianza en las unidades originales de la variable, para eso convertimos a la unidad original de CO con exponencial (l 1, 7061 = 5,507 − l 2,0691 = 7,918 ). 1 14 12 12 10 10 8 8 6 6 4 4 Desv. típ. = 5.26 2 2 Desv. típ. = .61 Media = 8.0 Media = 1.89 N = 46.00 0 2.0 6.0 4.0 10.0 8.0 14.0 12.0 18.0 16.0 N = 46.00 0 22.0 20.0 .50 1.00 24.0 .75 Monóxido de Carbono 1.50 1.25 2.00 1.75 2.50 2.25 3.00 2.75 3.25 Log(CO) Intervalo de confianza 95% para la media de CO (6,398 - 9,522) Intervalo de confianza 95% para la media del log CO (1,7061 - 2,0691) ¿Qué pasa con el supuesto de Normalidad? Pruebas de normalidad a Kolmogorov-Smirnov Shapiro-Wilk Estadístico gl Sig. Estadístico gl Monóxido de Carbono .187 46 .000 .842 46 Log(CO) .104 46 .200* .970 46 Sig. .000 .266 *. Este es un límite inferior de la significación verdadera. a. Corrección de la significación de Lilliefors 2 2 1 1 0 0 -1 -2 -3 -10 0 Valor observado 3. Gráfico Q-Q normal de Log(CO) 3 Normal esperado Normal esperado Gráfico Q-Q normal de Monóxido de Carbono 3 10 20 30 -1 -2 -3 .5 1.0 1.5 2.0 2.5 3.0 3.5 Valor observado También existen métodos paramétricos que asumen otras distribuciones, por ejemplo para el tiempo que demora en fallar un producto se usa una distribución de Weibull (ver diagrama adjunto). 2 3 4. Finalmente, existen los métodos que no asumen una distribución, también llamados de distribución libre o no paramétricos. Los métodos no paramétricos son la manera más directa de solucionar el problema de falta de normalidad. Estos métodos son muy simples de usar y están disponibles en SPSS. Pero tienen dos desventajas. Primero que tienen menos poder1 que las equivalentes soluciones paramétricas. También es importante distinguir que las pruebas de hipótesis no paramétricas NO contestan a la misma pregunta que las pruebas paramétricas. Por ejemplo si queremos hacer un test para docimar sobre el centro de la distribución, el test no paramétrico establece la hipótesis en términos de la mediana y el test paramétrico usa la media. Tipo Test Paramétrico Test no paramétrico Una muestra Test t simple Test del signo de rangos de Wilcoxon Muestras pareadas Test t simple Test del signo de rangos de Wilcoxon Dos muestras independientes Test t para muestras independientes Test de suma de rangos de Wilcoxon Más de dos muestras independientes ANOVA de un factor Test de Kruskal-Wallis Diseño en bloques aleatorios Ji cuadrado de Friedman ANOVA con bloques Existen dos grandes tipos de test no paramétricos, los que usan cuentas o números y los que usan rangos. En este capítulo revisaremos del test de suma de rangos de Wilcoxon y el Test de Kruskal-Wallis. Ejemplo: Se tienen dos parcelas experimentales. En una de las parcelas se sacó completamente la maleza y en la otra se dejó hasta 3 malezas por metro cuadrado. ¿Dañará la presencia de maleza la producción de maíz? Malezas por metro cuadrado Producción de maíz 0 166,7 172,2 165,0 176,9 3 158,6 176,4 153,1 156,0 Hipótesis En este problema la hipótesis nula es que la maleza no afecta la producción de maíz. La hipótesis alternativa es que la producción es menor cuando hay maleza. Si estamos dispuestos a asumir que la producción de maíz es Normal, o si tenemos un tamaño muestral razonablemente grande, usamos el test t para medias independientes. Las hipótesis son: H 0 : µ1 = µ2 H1 : µ1 > µ2 Cuando la distribución no es Normal, podemos re-escribir las hipótesis en términos de medianas: H 0 : mediana1 = mediana2 H1 : mediana1 > mediana2 ¿Qué tipo de test (paramétrico o no paramétrico) será el adecuado en este caso? 1 Se define poder o potencia del test como la capacidad del test para detectar hipótesis nulas falsas. Potencia = 1-β 4 Hacemos la prueba de normalidad: Pruebas de normalidad a YIELD WEEDS 0 3 Kolmogorov-Smirnov Estadístico gl Sig. .241 4 .341 4 Estadístico .938 .819 . . Shapiro-Wilk gl 4 4 Sig. .640 .140 a. Corrección de la significación de Lilliefors Gráfico Q-Q normal de YIELD Gráfico Q-Q normal de YIELD Para WEEDS= 3 1.0 .5 .5 0.0 0.0 Normal esperado Normal esperado Para WEEDS= 0 1.0 -.5 -1.0 164 166 168 170 172 174 176 178 -.5 -1.0 150 160 170 180 Valor observado Valor observado Tenemos muy pocos datos por lo tanto será adecuado hacer un test no paramétrico. Test de suma de rangos de Wilcoxon2 Este es un test de rangos. El primer paso será calcular los rangos de las observaciones. Transformación a rangos Ordenamos los datos de menor a mayor: Producción Rango 153,1 1 156,0 2 158,6 3 165,0 4 166,7 5 172,2 6 176,4 7 176,9 8 Pasar de los datos a sus rangos, es equivalente a transformar los datos. Los rangos retienen solamente el orden de las observaciones y no el valor numérico. Si la presencia de maleza afecta la producción de maíz esperamos que los rangos más pequeños sean de ese grupo. Podemos comparar la suma de los rangos de los dos tratamientos: Tratamiento Suma de rangos Sin maleza 23 Con maleza 13 Por definición la suma de rangos de 1 a 8 es: n(n +1) 8× 9 = 36 , donde n es el número total de observaciones. = 2 2 Por lo tanto podemos calcular la suma en uno de los grupos y el otro tiene que ser la diferencia (36- 23=13) Si no hay diferencia entre los tratamientos esperamos que los rangos sean la mitad en cada grupo, es decir 18. 2 Este test fue creado por el químico Frank Wilcoxon (1892-1965) en 1945. 5 Test de suma de rangos de Wilcoxon Se tiene una m.a.s de tamaño n1 de una población, y una segunda m.a.s de tamaño n2 de otra población. Hay n observaciones en total, donde n = n1 + n2. Se calcula el rango de las n observaciones. El test estadístico será la suma W de los rangos del grupo con menor suma de rangos, este será el estadístico de suma de rangos de Wilcoxon. Si las dos poblaciones tienen la misma distribución continua, entonces W tiene media: µW = n1 (n + 1) 2 y desviación estándar: σW = n1n2 (n + 1) 12 Donde n1 será el tamaño muestral del grupo con menor suma de rangos. El test de suma de rangos de Wilcoxon rechaza la hipótesis nula de que las dos poblaciones tienen la misma distribución cuando la suma de rangos W está lejos de su media. En el ejemplo del maíz queremos docimar: H0: no hay diferencias en la distribución de la producción de maíz en los dos grupos versus H1: la producción es mayor en el tratamiento sin malezas Nuestro test estadístico W=13 Bajo Ho W tiene media: Valor p = µW = 4(8 + 1) 4 × 4(8 + 1) = 18 y desviación estándar: σW = = 3,4641 12 2 P(W ≤ 13 | H 0 ) Necesitamos conocer la distribución muestral de W bajo la hipótesis nula. Existen tablas que dependen de n1 + n2. Veamos la salida qué nos da SPSS: Estadísticos de contrasteb U de Mann-Whitney W de Wilcoxon Z Sig. asintót. (bilateral) Sig. exacta [2*(Sig. unilateral)] Sig. exacta (bilateral) Sig. exacta (unilateral) Probabilidad en el punto YIELD 3.000 13.000 -1.443 .149 a .200 .200 .100 .043 a. No corregidos para los empates. b. Variable de agrupación: WEEDS 6 La salida de SPSS nos da el valor p exacto para la distribución muestral de W. El valor p para la hipótesis unilateral es 0,1 (valor p exacto según SPSS). Si comparamos con el equivalente test paramétrico t = - 1,554, valor p=0,171/2=0,0855, llegamos a la conclusión similar (recuerde que las hipótesis son distintas). Prueba de muestras independientes Prueba de Levene para la igualdad de varianzas F YIELD Se han asumido varianzas iguales No se han asumido varianzas iguales Sig. 1.256 .305 Prueba T para la igualdad de medias t gl Sig. (bilateral) Diferencia de medias Error típ. de la diferencia 95% Intervalo de confianza para la diferencia Inferior Superior -1.554 6 .171 -9.175 5.9056 -23.6254 5.2754 -1.554 4.495 .187 -9.175 5.9056 -24.8832 6.5332 La aproximación Normal El estadístico de suma de rangos W se aproxima a la distribución Normal cuando n es grande. Entonces podemos formar un test z para estandarizar a W: z= W − µW σW El valor de z en el ejemplo del maíz nos da: z= 13 − 18 = −1,44 3,4641 Esperamos rechazar para valores grandes de W si la hipótesis alternativa es verdadera, por lo que el valor p aproximado es: Valor p = P(Z ≤ −1,44) = 1 − 0,9251 = 0,0749 SPSS da el valor p exacto para W y el asintótico o aproximado que utiliza la aproximación a la Normal. Además SPSS nos entrega el estadístico U de Mann-Whitney, este es equivalente al test de suma de rangos de Wilcoxon. Empates La distribución exacta de test de Wilcoxon para suma de rangos se obtiene asumiendo que todas las observaciones tienen diferentes valores y por lo tanto su rango. En la práctica ocurre que muchas veces tenemos valores iguales. Lo que hacemos es asignar el valor promedio del rango que ocupan. Ejemplo: Observación 153 155 158 158 161 164 Rango 1 2 3,5 3,5 5 6 La distribución exacta del test de Wilcoxon se aplica a datos sin empates, por lo que deberemos ajustar la desviación estándar en la presencia de empates. 7 Ejemplo: La comida que se vende en eventos al aire libre puede ser menos segura que la de restoranes porque se prepara en lugares no acondicionados y a menudo por voluntarios. ¿Qué pensará la gente acerca de la seguridad de la comida en ferias? Un estudio preguntó a asistentes a este tipo de eventos: ¿Qué tan a menudo piensa usted que se enferma la gente que consume comida en eventos al aire libre? Las respuestas posibles eran: 1 = raramente 2 = de vez en cuando 3 = a menudo 4 = muy frecuentemente 5 = siempre En total 303 personas respondieron a la pregunta. De estos 196 eran mujeres y 107 hombres. ¿Existe evidencia que hombres y mujeres difieren en su percepción acerca de la seguridad en la comida de ferias al aire libre? Tabla de contingencia Sexo * Respuesta Recuento 1 Sexo F M Total 2 13 22 35 108 57 165 Respuesta 3 50 22 72 4 5 23 5 28 2 1 3 Total 196 107 303 Comparamos los porcentajes por filas: Tabla de contingencia Sexo * Respuesta % de Sexo Sexo F M Total 1 6.6% 20.6% 11.6% 2 55.1% 53.3% 54.5% Respuesta 3 25.5% 20.6% 23.8% 4 11.7% 4.7% 9.2% 5 1.0% .9% 1.0% Total 100.0% 100.0% 100.0% ¿Es la diferencia entre sexos significativa? H0: hombres y mujeres no difieren en sus respuestas H1: uno de los dos sexos da sistemáticamente mayores respuestas que el otro La hipótesis alternativa es de dos colas. Como las respuestas posibles son sólo 5 hay muchos empates. Veamos la salida de SPSS: 8 Rangos Respuesta Sexo F M Total N 196 107 303 Rango promedio 163.25 131.40 Suma de rangos 31996.50 14059.50 Estadísticos de contrastea Respuesta 8281.500 14059.500 -3.334 .001 .001 .000 .000 U de Mann-Whitney W de Wilcoxon Z Sig. asintót. (bilateral) Sig. exacta (bilateral) Sig. exacta (unilateral) Probabilidad en el punto a. Variable de agrupación: Sexo Tenemos suficiente evidencia para concluir que existen diferencias significativas entre la percepción acerca de la seguridad de la comida al aire libre entre hombres y mujeres. Como el tamaño de la muestra es grande podríamos haber usado el test paramétrico: Prueba de muestras independientes Prueba de Levene para la igualdad de varianzas F Respuesta Se han asumido varianzas iguales No se han asumido varianzas iguales 3.031 Sig. .083 Prueba T para la igualdad de medias t gl Sig. (bilateral) Diferencia de medias Error típ. de la diferencia 3.361 301 .001 .33 .099 3.365 218.856 .001 .33 .099 Pero en este caso, tenemos argumentos a favor del test no paramétrico. El test paramétrico asume que las respuestas tienen valor numérico y en realidad en una escala cualitativa. Usar rangos es más apropiado en este caso. 9 Test de Kruskal-Wallis El test de suma de rangos de Wilcoxon sirve para comparar dos tratamientos. Ahora veremos una alternativa no paramétrica al ANOVA de un factor es decir para comparar más de dos tratamientos, que corresponde al test de Kruskal-Wallis. Ejercicio: Veamos una nueva versión del problema de las malezas. El investigador en realidad probó 4 tipos de malezas 0, 1, 3 y 9 por metro cuadrado. Descripción de la Producción bajo distintas condiciones de maleza: Maleza n 0 1 3 9 Media Desviación típica 4 170.200 5.4216 4 162.825 4.4687 4 161.025 10.4933 4 157.575 10.1181 Gráfico Q-Q normal de YIELD Gráfico Q-Q normal de YIELD Para WEEDS= 1 1.0 .5 .5 0.0 0.0 Normal esperado Normal esperado Para WEEDS= 0 1.0 -.5 -1.0 164 166 168 170 172 174 176 178 -.5 -1.0 156 160 162 164 Valor observado Gráfico Q-Q normal de YIELD Gráfico Q-Q normal de YIELD Para WEEDS= 3 1.0 .5 .5 0.0 0.0 -.5 -1.0 150 Valor observado 160 166 168 Para WEEDS= 9 1.0 Normal esperado Normal esperado 158 Valor observado 170 180 -.5 -1.0 140 150 160 170 Valor observado Ya analizamos que en este caso es difícil probar normalidad con tan pocos datos, por lo tanto será conveniente usar un método no paramétrico. 10 Hipótesis y supuestos El test F de ANOVA responde a la hipótesis: H 0 : µ1 = µ 2 = ... = µ k H1 : al menos dos medias no son iguales. Los datos deben provenir de k poblaciones independientes, con distribución normal y con la misma desviación estándar. El test de Kruskal_Wallis es un test de rangos que reemplaza al test F de ANOVA. El supuesto acerca de la independencia de las poblaciones sigue siendo importante, pero ya no necesitamos normalidad. Asumiremos que la respuesta tiene una distribución continua en cada población. H0: las k distribuciones son iguales H1: una de ellas tiene valores sistemáticamente mayores Si todas las distribuciones tienen la misma distribución, esta hipótesis la podemos simplificar. H0: las k poblaciones tienen la misma mediana H1: no todas las medianas son iguales Recordemos la idea del ANOVA: tenemos una variación total observada de la respuesta como la suma de dos partes, una que mide la variación entre los grupos o tratamientos (suma de cuadrados entre tratamientos, SCE) y la otra que mide la variación entre las mediciones de un mismo tratamiento (suma de cuadrados dentro de los tratamientos, SCD). El test F de ANOVA rechaza la hipótesis nula de que las medias son iguales si la SCE es grande relativa a la SCD. La idea del test de Kruskal-Wallis es calcular los rangos de todas las respuestas y luego aplicar el ANOVA a los rangos en vez de las observaciones originales. Test de Kruskal-Wallis Se tienen k muestras aleatorias de tamaños n1, n2,...,nk. Hay n observaciones en total, donde n es la suma de los ni. Se calcula el rango de las n observaciones y sea Ri la suma de los rangos en el i-esima muestra o grupo. El estadístico de Kruskal-Wallis es: k Ri2 12 H= ∑ − 3(n + 1) n(n + 1) i =1 ni Cuando los tamaños ni son grandes y las k poblaciones tienen la misma distribución, H tiene aproximadamente una distribución de Ji-cuadrado con (k-1) grados de libertad. El test de Kruskal-Wallis rechaza la hipótesis nula de que todas las poblaciones tienen la misma distribución cuando H es grande. Vemos que así como el test de suma de rangos de Wilcoxon, el test de Kruskal-Wallis está basado en suma de rangos, mientras mayor sea la diferencia entre los rangos de los grupos mayor evidencia de que las respuestas son diferentes. La distribución exacta del estadístico H de Kruskal-Wallis bajo la hipótesis nula depende de los tamaños muestrales n1, n2,...,nk, por lo tanto las tablas son terribles. El cálculo de la distribución exacta es tan complicado que los softwares generalmente usan la aproximación de χ2 para obtener el valor p. Veamos lo rangos para el problema de las malezas. Como antes, también tenemos que corregir cuando existen empates. 11 Revisemos los datos de las malezas: Malezas por metro 0 1 3 9 166,7 166,2 158,6 162,8 Producción 172,2 165,0 157,3 166,7 176,4 153,1 142,4 162,7 176,9 161,1 156,0 162,4 Tenemos que calcular los rangos de todos los datos ordenados. Luego calcular H. En SPSS podemos calcular los rangos con: Transformar, Asignar rangos a casos 2 Ri Grupos Suma de Rangos 0 52,5 2756,25 1 33,5 1122,25 3 25,0 625,0 9 25,0 625,0 Total 136 H= 12 2756,25 1122,25 625,0 625,0 + + + − 3(17) 16(17) 4 4 4 4 H= 12 (1282,125) − 51 = 5,56 272 Rangos YIELD WEEDS 0 1 3 9 Total Estadísticos de contrastea,b N 4 4 4 4 16 Rango promedio 13.13 8.38 6.25 6.25 Chi-cuadrado gl Sig. asintót. YIELD 5.573 3 .134 a. Prueba de Kruskal-Wallis b. Variable de agrupación: WEEDS La diferencia con el cálculo de SPSS se debe a la corrección por empates. Esta corrección hace que la aproximación de Ji cuadrado sea más precisa. Es importante hacerla si hay muchos empates. Podemos comparar este test no paramétrico con su equivalente paramétrico: 12 180 170 160 150 YIELD 140 130 N= 4 4 4 4 0 1 3 9 WEEDS ANOVA YIELD Inter-grupos Intra-grupos Total Suma de cuadrados 340.667 785.542 1126.209 gl 3 12 15 Media cuadrática 113.556 65.462 F 1.735 Sig. .213 Vemos que llegamos a la misma conclusión, es decir que las malezas no afectan significativamente la producción de maíz. ¿Ustedes qué creen? Ejercicio: Se tienen datos del contenido en calorías y sodio de 3 tipos de vienesas: cerdo, mixtas, y de ave. 220 200 180 160 140 CALORIAS 120 100 80 60 N= 20 17 17 carne mixto ave TIPOS 13 Descriptivos CALORIAS N carne mixto ave Total 20 17 17 54 Media 155.80 158.71 122.47 146.22 Desviación típica 25.220 25.236 25.483 29.696 Error típico 5.639 6.121 6.181 4.041 Intervalo de confianza para la media al 95% Límite Límite inferior superior 144.00 167.60 145.73 171.68 109.37 135.57 138.12 154.33 Mínimo 90 107 86 86 Máximo 190 195 170 195 Prueba de homogeneidad de varianzas CALORIAS Estadístico de Levene .301 gl1 gl2 2 51 Sig. .741 ANOVA CALORIAS Inter-grupos Intra-grupos Total Suma de cuadrados 14074.369 32664.965 46739.333 gl 2 51 53 Media cuadrática 7037.184 640.490 F 10.987 Sig. .000 CALORIAS a,b HSD de Tukey TIPOS ave carne mixto Sig. N 17 20 17 Subconjunto para alfa = .05 1 2 122.47 155.80 158.71 1.000 .937 Se muestran las medias para los grupos en los subconjuntos homogéneos. a. Usa el tamaño muestral de la media armónica = 17.895. b. Los tamaños de los grupos no son iguales. Se utilizará la media armónica de los tamaños de los grupos. Los niveles de error de tipo I no están garantizados. ¿Cómo hacemos el análisis no paramétrico? 14 Estadísticos de contrastea,b Rangos CALORIAS TIPOS carne mixto ave Total Rango promedio 32.83 33.53 15.21 N 20 17 17 54 Chi-cuadrado gl Sig. asintót. CALORIAS 15.179 2 .001 a. Prueba de Kruskal-Wallis b. Variable de agrupación: TIPOS ¿Qué informamos a los consumidores de vienesas? RANK of CALORIAS a,b HSD de Tukey TIPOS ave carne mixto Sig. N 17 20 17 Subconjunto para alfa = .05 1 2 15.206 32.825 33.529 1.000 .987 Se muestran las medias para los grupos en los subconjuntos homogéneos. a. Usa el tamaño muestral de la media armónica = 17.895. b. Los tamaños de los grupos no son iguales. Se utilizará la media armónica de los tamaños de los grupos. Los niveles de error de tipo I no están garantizados. Lo que hicimos fue calcular los rangos de la variable respuesta (calorías) y luego analizamos paramétricamente la nueva variable. Esta propuesta no es absolutamente convencional y fue publicada por: Conover, W. Iman, R. (1981) Rank transformation as a bridge between parametric and non parametric studies. The American Statistican, 35: 124-133. Fisher, L. Van Belle, G. En Biostatistics, Wiley (1993 ) proponen rutinariamente hacer tanto el análisis paramétrico como su equivalente no paramétrico (cuando existe) y si las conclusiones son divergentes investigar el motivo. 15 Correlación por rangos de Spearman* Hasta ahora hemos analizado la correlación mediante el coeficiente de correlación lineal r de Pearson, sin embargo existen otros coeficientes de correlación útiles, particularmente el coeficiente de correlación por rangos de Spearman (rs). El uso de este coeficiente es apropiado cuando la escala de medida de las variables de interés no es cuantitativa sino que es ordinal. La r de Spearman es en realidad el coeficiente de correlación lineal r de Pearson, aplicado a los datos que satisfacen los requisitos de una escala ordinal. La ecuación más sencilla para el cálculo de rs cuando no existen empates, o existen pocos, con respecto al número de pares de datos (x, y) es: 6∑ (R( X i ) − R(Yi ) ) 2 rs = 1 − n3 − n Donde: R( X i ) es el rango del i-ésimo dato X y R (Yi ) es el rango del i-ésimo dato Y. Se puede mostrar que si los datos no tienen empates, la r de Pearson se reduce algebraicamente a la ecuación anterior. Ejemplo: Suponga que una gran corporación está interesada en calificar a un grupo de 12 aspirantes a gerentes según su capacidad de liderazgo. Se contrata a dos psicólogos para realizar el trabajo. Como resultado de sus exámenes y entrevistas, cada uno de los psicólogos, de manera independiente, han clasificado a los aspirantes según su capacidad de liderazgo. Los rangos van de 1 a 12, donde 1 representa el nivel máximo de liderazgo. Los datos aparecen en la tabla. ¿Cuál es la correlación entre las clasificaciones de los dos psicólogos? Sujeto 1 2 3 4 5 6 7 8 9 10 11 12 Orden de Psicólogo 1 6 5 7 10 2 3 9 1 11 4 8 12 Orden de Psicólogo 2 5 3 4 8 1 6 10 2 9 7 11 12 rs = 1 − Diferencias 1 2 3 2 1 -3 -1 -1 2 -3 -3 0 (R( X i ) − R(Yi ) )2 1 4 9 4 1 9 1 1 4 9 9 0 52 6 × 52 = 1 − 0,182 = 0,818 123 − 12 Comparemos con la salida de SPSS: * Spearman, C. (1904) "The proof and measurement of association between two things", American Journal of Psychology, 15: 72-101. 16 Correlaciones PSI1 Rho de Spearman PSI1 PSI2 Coeficiente de correlación Sig. (bilateral) N Coeficiente de correlación Sig. (bilateral) N PSI2 1.000 .818** . 12 .001 12 .818** 1.000 .001 12 . 12 **. La correlación es significativa al nivel 0,01 (bilateral). Correlaciones PSI1 PSI1 PSI2 Correlación de Pearson Sig. (bilateral) N Correlación de Pearson Sig. (bilateral) N 1 . 12 .818** .001 12 PSI2 .818** .001 12 1 . 12 **. La correlación es significativa al nivel 0,01 (bilateral). 14 12 10 8 6 4 PSI1 2 0 0 2 4 6 8 10 12 14 PSI2 En este caso los dos coeficientes de correlación son iguales, pero tenemos argumentos a favor de usar un método no paramétrico. 17