Extensión de Unity3D para la creación de HUDs modulares

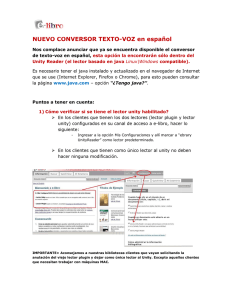

Anuncio