Análisis bayesiano de datos de supervivencia gamma utilizando

Anuncio

ESTADISTICA ESPAÑ^LR

Vol. 35. Núm. 134, 1993, págs. 629 a 644

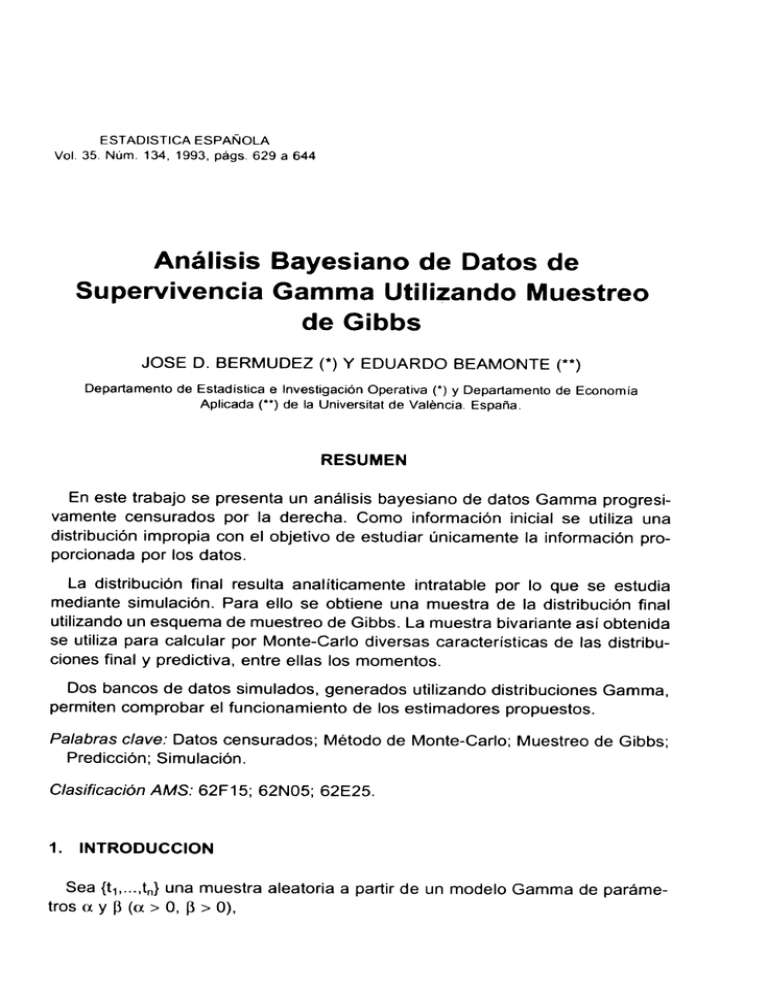

Análisis Bayesiano de Datos de

Supervivencia Gamma Utilizando Muestreo

de Gibbs

JOSE D. BERMUDEZ (*) Y EDUARDO BEAMONTE (*#)

Departamento de Estadística e Investigación Operativa (*^ y Departamento de Economía

Aplicada (**) de la Universitat de Valéncia. España .

RESUMEN

En este trabajo se presenta un análisis bayesiano de datos Gamrna progresivamente censurados por la derecha. Como información inicial se utiliza una

distribución impropia con el objetivo de estudiar únicamente la información proporcionada por los datos.

La distribución final resulta anal íticamente intratable por lo que se estudia

mediante simulación. Para ello se obtiene una muestra de la distribución final

utilizando un esquema de muestreo de Gibbs. La muestra bivariante así obtenida

se utiliza para calcular por Monte-Carlo diversas características de las distribuciones final y predictiva, entre ellas tos momentos.

Dos bancos de datos simulados, generados utilizando distribuciones Gamma,

permiten comprobar el funcionarniento de los estimadores propuestos.

Palabras clave: Datos censurados; Método de Monte-Carlo; Muestreo de Gibbs;

Predicción; Simulación.

Clasificación AMS: 62F 15; 62N05; 62E25.

1.

INTRODUCCION

Sea {t^,...,t^} una muestra aleatoria a partir de un modelo Gamma de parámetros a y ^3 (a > 0, ^3 > 0),

Ei:^U

{ ^,fROI^>r^f n # ^ti^>hr^^+^^1 A

(^

t`x ^^^ 1 exp{-^i t}, si t> 0.

f{t^a, (^) =^

^`( cx)

La distribución final, por el teorema de Bayes, resulta ser:

n(a, RIt1, -^-, tn) °^ n (a, R^ [r(a^1-n Rn"` exp {-^3 S 1+ a S2}, si a> 0 y^i > 0, (1)

siendo n (rx, R} la distribución inicial, y S^ y S2 los estadísticos sufcien#es:

n

S, = ^ t;,

i--1

n

S2 = ^ log{t;).

i=1

No parece que exista ninguna distribución inicial, n(a, ^3}, que permita

obtener de forma analítica la constante de proporcionalidad implícita en la

expresión {1 }, por io que se hace necesario emplear algún método de integración numérica. EI mismo inconveniente se presenta al intentar calcular los

momentos de la distribución final, las distribuciones marginales, la distribucián

predictiva, etc.

Esta situación se complica considerablemente si se desea utilizar !a distribución Gamma para modelizar un problema de supervivencia, pues será

habitual encontrar datos progresivamente censurados por la derecha. Sin

pérdida de generaíidad podemos suponer que {t^,..., tr} son los tiempos de

supervivencia correspondientes a los datos no censurados, mientras que

{Tr♦ ^,...,Tn} son los tiempos de censura correspondientes a ios datos censurados; esto es, del tiempo de supervivencia correspondiente al dato i-ésimo,

t;, sólo se sabe que es mayor que T;, para todo i= r+1,...,n. Así, la distribución

final resulta ser:

^ ^a^ ^^t^, ..., tr, Tr+ 1, ..., Tn) ^

,n (oc, ^i) ^r.(oc)l-n Rna ^,xp {-^3 S^^ + a S^^}

n

+^

11

^ t^` -1 exp {--^i t} dt,

(2)

donde S^^ y S2^ son, respectivamente, la suma de los r tiempos de supervivencia

correspondientes a los datos no c^ensurados y la suma de sus logaritmos.

La evaluación en cualquier punto (oc^, ^30) de la expresión (2) es realmente

costosa, pues exige calcular por métodos numéricos n-r integrales Gamma-incompleta. Por tanto, la obtención de la constante de proporcionalidad puede

resultar demasiado laboriosa y mucho más el cálculo de cualquier característica

de la distribución final, como por ejemplo, los primeros momentos.

ANAI E^il^y E^3F^YF.`-^IANC) OE^_ f.)^TO.`^ [^E_ SUPEFZVIVE^.NC.;IA C^AMML^ U^TILIIAN[-JC:) MUE:.S+F^E ^^ ^.,^ ^",IE^fs.`:^,

^7.^1

EI objetivo primordial en un análisis de supervivencia cansiste en predecir e1

tiempo de supervivencia de un nuevo individuo. Para ello es preciso obtener la

distribución predictiva, cuya densidad viene dada por:

f(t^t1, ... , tr^ Tr +- ^, ..,, T^) +m +^

^

^

_.Y_oc

ó ó r(a)

^ ^ ^exP {--R t} n (a, ^3^t^, -• -, tr^ Tr + ^, ..., T^) da d¢.

Luego es necesario evaluar una integral múltiple en cada punto, t, en el que

se quiera calcular la densidad predictiva.

Los problemas numéricos aquí expuestos no son privativos del modelo Garnma, de hecho aparecen con enorrne frecuencia al aplicar el paradigma bayesiano.

Por ello, en !os ^ ltimos años se ha realizado un considerable esfuerzo en la

búsqueda de métodos que permitan resolver dichos problemas. Cabe destacar

la idea de utilizar un remuestreo de la distribución final para calcular por MonteCar1o cualquiera de sus características (Smith y Gelfand, 1992). En el apartado

2 se discute brevemente cómo obtener una muestra de la distribución final,

comentando el muestreo de Gibbs como un caso part+cular, y cómo utilizarla. En

el apartado 3 se emplea el muestreo de Gibbs para estudiar la distribución final

(2). Este procedimiento se aplica, en el apar#ado 4, a unos datos simulados

procedentes de distribuciones Gamma de parárnetros a=^3 = 4 y a = 625, ^3 = 25.

Por último, el apartado 5 recoge algunos comentarios finales.

2.

MUESTREO DE LA DISTRIBUCION FINAL

EI trabajo de Gelfand y Smith (1990), posteriormente desarrollado en Smith y

Gelfand (1992), ha potenciado la aplicación de la metodología bayesiana estudiando la distribución final a través de una muestra aleatoria generada a partir

de dicha distribucián, en lugar de basar el estudio en la función de densidad final.

Una vez obtenida una muestra aleatoria {8^,...,9N} de tamaño N, suficientemente grande, a partir de la distribución final ^{^ ( Datos), es ^^osible calcular

cualquiera de sus características. Así por ejemplo, el vector de medias y la matriz

de covarianzas muestrales son la evaluación por Monte-Carlo de los correspondientes momentos de la distribución final.

Si el vector 8 se considera particionado en das subvectores, 6=(^, w), la

distribución marginal de cualquiera de ellos puede aproximarse mediante métodos de estimación de densidades, a partir de ios correspondientes subvectores

de la muestra {9; _{^;, w;); i= 1,..., N}. Alternativamente, si la distribución final

632

ESTA[31STlCA ESf'A^f+JC)l A

condicionada ^(^ ^ w, Datos) es numéricamente tratable, es aconsejable (Gelfand y Smith, 1990} obtener la distribucián final marginal de cp como:

N

n {^^IDatos) = ^ ^ n (c^ ^ c,^;, Datos).

^1 ; ^ ^

Similarmente, la distribución predictiva se obtiene calculando:

^

N

f {x^Datos) ^ N ^ f (x19;),

i^1

donde f(x I 8) es el modelo de los datos con los que se ha obtenido la distribucíón

fnal.

La ventaja de este proceder en e! análisis de la distribución final radica en que,

con frecuencía, es posible obtener una muestra aleatoria {e;} a partir de n(e (

Datos} sin necesidad de calcular ni tan siquiera la constante de proporcionalidad.

Así por ejemplo, los métodos de generación de variables aleatorias basados en

el algoritmo de aceptación-rechazo (ver, por ejemplo, Devroye, 1986; pág. 4í1),

sóio necesitan el núcleo de la distribución fina^, aunque sí requieren la especificación de una función importante, g(8}, suficientemente parecida a la distribución

final y saber caicular alguna buena cota superior del cociente n(8 ^ Datos} / g(8),

a ser posible su rnáximo.

Incluso el cálculo de esa cota se puede evitar utilizando el método SIR, una

especie de bootstrap ponderado propuesto por Rubin (1988), can el que se

obtiene una muestra que aproximadamente proviene de la distribucián final.

Como alternativa a esos métodos directos de generacián de varíables aleatorias se han propuesto métodos iterativos, basados en cadenas de Markov,

que tampoco requieren optimizar nínguna función (Metrópolis et al., 1953;

Hastings, 1970; Geman y Geman, 1984; Tanner y Vvong, 1987; Gelfand y

Smith, 1990).

Básicamente, tados esos métodos consisten en construir una función de transición que defina una cadena de Markov irreducible y para fa que la distribución

final sea estacionaria.

Así, a partir de un valor iniciai 8^°^ cuaiquiera, se genera una realización de esa

cadena de Markov, {9t'^}. Una vez la cadena es estacionaria, digamos en la etapa

m, !os demás valores {8^'}; i> m} constituyen una muestra, no aleataría, de la

distribución final. Esa muestra ya permite estudiar las características de la distribución final utilizando técnicas de estimación en cadenas de Markov (Hastings,

1970; Geweke, 1992}. Si, a pesar de ello, se desea construir una muestra

aleatoría de tamaño N, pueden observarse N realizaciones de la cadena de

Markvv partiendo de valores iniciales elegidos independientes (Gelfand y Smith,

ANAI._ISIS E^AYESI^NO UE UATOS C)E SUP"EF^VtVEhtCIA G^AMWIA UTIL ^IAN[^)E_) MUE^^TRE(^) C)E C:rIE^H^^á

^i^^

1990) o incorporar a la muestra únicamente una de cada m etapas, con m

suficientemente grande para que 9^'^^^^ y 8^'+m^ puedan considerarse independientes

(Geman y Geman, 19&4}.

El muestreo de Gibbs (Geman y Geman, 1984; Gelfand y Smith, 1990; Casella

y George, 1992; Stephens y Smith, 1992} es, sin duda, el método iterativo que

más se ha utilizado en la obtención de muestras de la distribución final. Consiste

en lo siguiente:

Sea 8=(8,, ..., ek)' e1 vector paramétrico y sean n(e,1e2, ..., ek), ^c (e2, le,, 83,

..., 8k), ..., n(8k^8^, ..., 9k _^) las distribuciones condicionales completas obtenidas

a partir de la distribución final n(8}. Partiendo de un punto inicial

9'0' =(8^°', ..., 9^°^)' se genera 81'^ a partir de ^(8^ ^ 8^°^, ..., 8^0^}, 9^^^ a partir de

n(62 ^ 6^'^, 8^0>,

, 8^°^), y asi hasta 8^'', generado a partir de n(8K ^ 8^^}, , 8^'^ ^),

con lo que se obtiene 8^' ^_(9^' ^, .. ., 8^'')'. Bajo condiciones muy generales, la

sucesián {8^'^} así construida es una reaiización de una cadena de Markov con la

distribución final como distribucián estacionaria (Gelfand y Smith, 1990}.

Este proceso exige que sea fácil muestrear a partir de las distribuciones

condicionales completas, pero eso suele ser trivial (utilizando métodos de aceptación-rechazo, por ejemplo) si el vector 6 se descampone de forma que todas

esas distribuciones condicionales sean univariantes. Por otra parte, no es necesario visitar cada condicional en el orden natural arriba utilizado, el resultado es

válido cualquiera que sea et orden con tai de que cada condicional sea visitada

con una frecuencia infinita (Geman y Geman, 1984). Por ello, el algoritmo D,A.

propuesto por Tanner y Wong { 1987) en su versión Monte-Cario, esto es cuando

sólo se dispone de 1as distribuciones condicionales compietas y se calculan las

demás candicionales por Monte-Carlo, no es más que un caso particular de

muestreo de Gibbs pero con un esquema de visitas a las condicionales distinto

(Gelfand y Smith, 1990).

Hasta ahora no existen resultados teóricos, de fácil utilización en aplicaciones concretas, sobre cuándo se puede considerar estacionaria la cadena de

Markov. En especial, sigue siendo un tema de investigación atractivo la búsqueda de métodos que sugieran autorrráticamente el número m de etapas

iniciales de fa cadena que deben ser desechadas, e incluso si es más eficiente

utilizar una o varias cadenas independientes para monitorizar esa convergencia; ver, por ejemplo, Gelman y Rubin (1992b), Smith y Roberts (1993) y

referencias allí citadas.

634

3.

E `^tAf)ISTtI"A E 5^^4NC71 A

MUESTREO DE GIBBS EN EL ANALISIS DE DATOS GAMMA

En ausencía de datos censurados, la distribución final sobre los parámetros de

un modelo Gamma víene dada por la expresión (1 }. Si se utiliza como inicial la

distribucic5n impropia

^ (^^ ^^ °C OCi' R-1 ^

la dístribución final es propia si n> 1 y viene dada por:

n Ca^ RIt1, ..., tn) °^ Er(

^^-n ^n a - 1

exp {--^i S ^ + a S2},

(3)

donde S^ y S2 están definidos en el apartado 1.

Las dis#ribuciones condicionales completas, necesarias para aplicar el muestreo de Gibbs, se calculan fácilmente a partir de (3) y resultan ser:

^c (a^^i, t1, . .. , t„) ^ CT(a)]w" -^- exp {a ( S2 + n log ^i)}, si a > 0,

a

(4)

^(Rla, t^, ..., tr,} -- Ga (Rln a^ S1>^

(5}

Puede utilizarse el algoritmo XG (para a> 1) y el teorema de Stuart (para a< 1)

(ver, por ejemplo, Devroye, 1986; págs. 407 y 420, respectivamente), para

obtener una muestra de la distribución (5). Más difícil resulta obtener una muestra

de (4). Una forma suficientemente rápida de hacerlo, consiste en utilizar un

algorítmo de aceptación-rechazo basado en una función importante t de Student

con 4 grados de libertad, y parámetros de localización y escala dados por los

momentos de la aproximación normal asintótica a la distribucián (4).

Para aplicar ei muestreo de Gibbs, sáfo es necesario partir de un valor inicial

at°^, generar R{'^ a partir de (5) tomando a= a^°^, generar a^^^ a partir de (4)

tomando R=^i^' }, y así sucesivamente.

En presencia de datos censurados puede considerarse como vector paramétrico completo el formado por !os parámetros del modelo, a y(3, y los datos

censurados no observados, tr+1,...,tn; esto es, 6=(a, ^3, tr+1,...,tn)'. Utilizando como

distribución iniciai

r,

^ ^a! ^^ tr + 1 ^ ..., tn^ = TL (a, ^^

^ ^ ^tila^ ^}+

i=r+1

con ac (oc, (3) ^ a^1 ^3-1 y^(t; ^ a, R) = Ga (t; ( oc, ^^}, i= r+ 1,...,n, !a distribución

final es:

7t (Cx, ^3, tr+^,...,t^ ^ t1,..., tr^ Tr+1,.... Tn} °`

ANAl.1SIS BAYf^SIANC^ UE DATOS DE SUPERVIVENt`,IA GAMMA UTIL.11_AN[:^C) MUE^IREU [JE C^;IFiE3`.^

__

..

__

._

___.

_._ ._.

__

__

_

_

.

_ _.

« r ^-- (a^l-n ^{na-

^3rj

_

-^ exp {-(3 S^ +(a -- 1) S2}, si a > 0, (3 > 0, t; > T;, para i=

= r+^,.,.,n.

Esta distribución coincide con (3) pero ahora S^ y S2 ya no son estadísticos

pues son función de los par^metros tr+^, ...,tn. Sin embargo, las distribuciones

condicionales completas de a y^i coinciden con (4) y(5) respectivamente,

mientras que la distribución condicional completa para cada t;, i= r+ 1,..., n, es

de la forma :

7L (t; ^ a, R, t;, . .. , ^i - 1 ^ ti + 1, , .. , ^n+ Tr + 1 ^ . . ., Tn^ _

-- n(t; j a., ^i, T;) a t°` -^ exp {-^3 t;} - Ga (t; I oc, ^3), si t; > T;.

(6)

Es fáci! obtener una muestra de la distribución ( 6); basta con obtener un valor

Ga (a, ^3), utilizando el mismo algoritmo que para generar de (5), y aceptarlo si

y sólo si es mayor que T;.

Así pues, el muestreo de Gibbs se puede obtener partiendo de un punto inicial

(a^°^, R^°^) , generando {tr°^ ^, ..., t^°^} a partir de (6), ^i^1^ a partir de ( 5) con ^c ^ ato^,

tr + 1- tc°^

tc°^

- t^°^

r+1^•••^ tnn>ac1 ^ a partir de (4} con ^3 =^ic' ^> t r+ 1r+

1+•••^

t-tc0^

n r

n^ y así

sucesivamente.

Una vez obtenida una muestra de la distribucián final, {(at'^, ^3{'^); i= 1, .. ., N},

los momentos muestrales son una solución Monte-Carlo a los momentos de 1a

distribución final, así:

N

1

N

N

E(a) ^ -- ^ ac^^, E(a2> ^ -1 ^ (a{'^)2, E(a ^) ^ -^_ ^ a^'^ E(R I ac`^, Si^^),

N^=^

N^-^

N^=1

(7)

siendo S^'^ = t1 +...+ tr + tr^+ ^+. .. + t;,^^, i- 1, ..., N.

Los momentos de ^3, aprovechando que (4) es numéricamente tratable, se

pueden obtener como:

1

N

c^^

1

c^^

N

n ac'^

E(R) ^-^__ ^E(RIa ,S1)=- ^ ^^ ^

N;i^

N;^^ S1

N

N

(8a)

.

E(^z^ ^_1 ^ E(R2 ^ ac^^, 51^^ ^ 1 ^ n a c'^ (n a c'^ _- 1).

N;^^

N ; ^ ^ S{'^

Sc'^

^

^

(8b)

De igual forma, la distribución fina! marginal de R se obtiene como:

n

(^^ t.,.

1^ ^tr^

c^^

^ N^Ga(^Inac^^,s,),

T r+1,...,Tn } .^ N

I ^

(9)

63E^

E. ;^ T A[.) ^ 51 ^ C:A E SPANC)l.A

mientras que la distribución predictiva resuita:

f(t^t1^ ••^tr^Tr+1,..,

^-

n}

c^^

^ 1_ N

c^^

N ^Ga(t^oc ^ R )

,-^

(10)

Cuaiquier otra característica deseada podría obtenerse de forma similar. Así

por ejemplo, la media de la predictiva y ia esperanza de su iogaritmo serían:

_...

E(t) ^ _1 ^".___a^'^

N ; ^ ^ ^{^y'

N

.

(11a)

.

E (log(t)) = ___ ^ {w(a''^) - !og(R^^'))•

N;-^

(11 b)

A partir de estas dos esperanzas se puede obtener la mejor aproximación

Gamma, según la divergencia de Kuiiback-Leibler, a la distribución predictiva.

Un problema práctico a resolver es ia eiección del punto inicial (a^°^, ^3^°^). Este

punto no debe estar muy aiejado de !os valores centrales de la distribución final

pues, aunque el muestreo de Gibbs tiene garantizada ia convergencia con independencia del punto iniciai, ésta puede ser muy lenta si dicho punto está situado

en ias coias de la distribución final.

Si el porcentaje de censura no es muy elevado, una posible elección de (a^°j,

(3^°^) es la solución a! sistema:

co>

m^ = °^^o^ , log(m2) = ^{oc^°^) - iog(a^0^),

R

( ^ 2)

siendo m^ y m2 las rnedias aritmética y geométrica de los datos no censurados.

De esta forma (at°^, ^i^°^) coincide con los parámetros de ta distribución Gamma

que minimiza la distancia de Kuilback-Leibler a ia distribución empírica de los

datos no censurados. Hay que señalar que al resolver (12) sólo buscarnos un

punto iniciai para el muestreo de Gibbs, por lo que sólo necesitamos una primera

aproximación a ia solución exacta.

Por supuesto, si el porcentaje de censura es elevado el punto (a^°^, ^3t°^)

obtenido a partir de { 12) puede estar demasiado alejado del centro de la distribución final. En efecto, pues ia muestra constituida por los datos censurados es

una muestra sesgada que tiende a proporcionar valores de supervivencia menores. En ese caso sería aconsejable utilizar estimadores de las medias aritmética

y geométrica de la distribución de supervivencia distintos de m^ y m2.

^^^

^NALISI`^ E3AYF^SIANQ [^E^^ UATUS C)E SUF'ERVIVE^NCIA GAMMA I..JTIh17AN[;1U MUE `,1kE (^^^- ^^>E (^,lE3f^^^^,

4.

EJEMPLOS NUMERICOS

EI análisis propuesto en el apartado anterior lo hemos aplicado a dos bancos

de datos generados a partir de distribuciones Gamma, utilizando un mecanismo

de censura progresiva por la derecha que proporciona aproximadamente un 90

por 100 de datos no censurados.

EI primero de ellos, de parámetros a= R= 4, consiste en 86 tiempos no

censurados con media aritmética 0,944 y media geométrica 0,85, y los 14 tiempos

de censura recogidos en la tabla 1.

TABLA 1

Tiempos de censura del banco de datos 1

0, 541

0,003

0,311

0, 553

0, 021

1,211

1,127

0,426

0,436

0, 262

0,139

0, 563

1, 366

0,404

Como punto de partida para el muestreo de Gibbs utilizamos (a^°}, ^i^°^) =(5,

5}, valores calculados por el procedimiento comentado en el apartado anterior,

redondeados al entero más próximo. Tras realizar 20.000 pasos en la cadena de

Markov (69 segundos en una estación SUN-SPARC} observamos que, como era

de esperar, las funciones autocorrelograma y autocorrelograrna parcial correspondientes a las series de alfas y betas correspondían perfectamente a un

proceso AR (1), con un coeficiente de autocorrelación del orden de 0.90 en ambos

casos.

Preferimos no utilizar esa ú nica realización de la cadena de Markov y, siguiendo las indicaciones de Gelman y Rubin ( 1992a), construimos en paralelo diez

realizaciones con el mismo punto de partida (a{°^, ^i^°^) =(5,5).

Monitorizamos la evolución de las cadenas de Markov para observar cuándo

podían considerarse estacionarias representando, en cada paso, el cociente a/^3

y^3. En la figura 1 se recoge la evolución de ^i mediante el máximo, el mínimo y

la media de los diez valores ^i observados en las cadenas de Markov. La

evolución de aJ^3 proporciona una gráfica similar aunque mostrando menor fluctuación.

E1 estudio definitivo de la distribución final y de la distribución predictiva lo

reaiizamos con los 1.600 puntos obtenidos desechando ios 50 primeros y, posteriormente, registrando uno de cada 50 de cada cadena de Markov. Asi, utilizando (7), (8), (11) y fórmulas similares, obtuvimos las caracteristicas de las

distribuciones final y predictiva dadas en la tabla 2.

E ^1AU^`^TIC;.A E SF'ANC)LA

9T

loo

^o

i^a

zoo

300

2^a

Figura 1. Evolución de los valores ^i observados en las diez cadenas de

Markov det banco de datos 1. Se representa el mínimo, media y m^ximo

de esos die^ valores en cada iteración.

Los momentos de los logaritmos de a y^i pueden utiliZarse para aproximar la

distribución final de [log{a}, log(^i)] mediante una distribución Normal bivariante.

Similarmente, ias dos marginales de oc y R pueden aproximarse mediante sendas

distribuciones log-narmales. En la figura 2 se muestra el histograma de los 1.600

valores de a, sobre el que se ha dibujado la aproximación log-normal. La figura

3 recoge la distribucián marginal de R, obtenida mediante la expresión (9), y su

aproximación !og-normal.

TABLA 2

Principales caracteristicas de las distribuciones final y predictiva

distribución final

media

varian^a

correlacien

predictiva

a

a

log{a}

log((3)

t

fog(t)

4,937

0,501

5,085

0,608

1,586

0,024

1,615

0,024

0,974

0,199

-0,135

0,233

0,949

0,949

Por último, en la figura 4 se muestra la distribución predictiva obtenida mediante la expresión t 10} y su mejor aproximación Gamma, según la divergencia

logarítmica de Kullback-Leibler, cuyos parámetros son 4,779 y 4,907.

ANAI I^^1^-; EiAYES ^ ANC) L.^E t7ATC)S t:)E SUPERVIVEN^;1A rAMMA ^.1T^^^Z^1r^^)c) MuE^STRE (^ (^t c^^E3E^:^

_

_

_

_

C39

10

Figura 2. Histograma de los valores a observados en el análisis del

banco de datos 1 y, en trazo discontinuo, su aproximación log-normal.

Figura 3.

Distribución marginal de ^3 en el análisis del banco de datos 1

y, en trazo discontinuo, su aproxirnacián log-normal.

e^o

E :^raD^:^r ^c1a € s^awot A

1 . 2T

3.5

Figura 4.

4

Distribución predictiva en el análisis del banco de datos 1 y,

en trazo discontinuo, su aproximacibn gamma.

EI segundo banco de datos analizado, obtenido a partir de una distribución

Gamma de parámetros a= 625 y j3 = 25, consiste en 92 tiempos no censurados,

con media aritmética 25,026 y media geométrica 25,009, y los 8 tiempos de

censura recagidos en la tabla 3.

TAB LA 3

Tiempas de censura del banco de datos 2

7, 920

3, 388

4,91$

6,495

13, 956

11,476

24,078

18,146

Utilizamos como punto de partida de las diez cadenas de Markov el par ^a^°^,

R^°^) ={546, 22), obtenido del mismo modo que en el primer ejemplo, y estudiamos

la evolución de las mismas, observando que se convertían en estacionarias con

bastante más lentitud y que necesitábamos un mayor tamaño muestral para

mejorar la solución Monte-Cario. Asi pues, realizamos el estudio definitivo de la

distribución final y de la distribución predictiva con los 10.000 puntos obtenidos

desechando !os 1.000 primeros y, posteriormente, registrando uno de cada 50

de cada cadena de Markov, obteniendo las características que se recogen en la

tabla 4.

ANAL I51^; E3AYF^S^ANC7 UE^ C^ATOS (^E^^ SUPE^.RVIVEN(^ IA GAMMA tJTILIZANUt) MUE`^TF^E C>> 1,^^ ^^i^hE^,`^,

6^1

TABLA 4

Principales caracteristicas de las dist^ibuciones ^nal y predictiva

predictiva

distribucián final

media

varianza

correlación

cx

R

ios(a)

io9(R)

t

iog(t)

717,231

11.314,939

28,656

18,079

6,564

0,022

3,34^

0,022

25,030

0,902

3,219

0,001

0,9997

0,9997

En las figuras 5 y 6 se representan el histograma de los valores a y la

distribución marginal de ^3 y, en trazo discontinuo, las aproximaciones log-norrnales obtenidas con los mornentos de los logaritmos de a y^i de la tabla 4.

5.

DISCUSION Y COMENTARIOS FINALES

Es de destacar la rapidez con la que se obtiene la distnibución predictiva. En todos

los bancos de datos analizados obtuvimos ésta con un menor tamaño muestral del

finalmente considerado. De hecho, en el primer ejemplo aquí comentado, con tan

sólo 500 puntos -lo que supone 15 segundos de cálculo- observamos un dibujo

de la densidad predictiva indistinguible del de la figura 4(las diferencias se encontraban en la cuarta cifra decimal de fas ordenadas). Por el contrario, las distribuciones

marginales de a y a parecen bastante más sensibies a la evolución de las cadenas

de Markov: requieren un mayor número de pasos en cada cadena (hasta conseguir

que sean estacionarias) y un mayor tamaño muestral (para rnejorar la solución

Monte-Car1o). De cualquier forma, el volumen de cálculo exigido por este procedimiento parece ser asequible para su utilización rutinaria.

En este trabajo hemos utilizado siempre una distribución inicial impropia, con

intención de no incórporar información inicial. Si se desea utilizar una distribución

inicial informativa n(a, R) es fácil transformar la muestra aleatoria, obtenida por el

método propuesto en el apartado 3, a otra muestra aleatoria que provenga de la

nueva distribución final. Para ello se puede utilizar el método de aceptación-rechazo,

empleando la distribución final aqui considerada como función importante.

Asi, sea C el máximo de la función h(a, ^3) = a^i ^{oc, j3), y sea U un número

aleatorio en el intervalo (0, 1). EI punto (a;, ^3;), i-ésimo punto de la muestra

aleatoria construida en el apartado 3, se aceptará como un punto de la nueva

muestra aleatoria si y sólo si:

U ^ ^ h (a^^ R^)•

C

64 2

E:STA[^I^^TIC;A E SF'ANC:)l.A

0.0035

0.003

0.0025

0.002

0.0015

o.ao^

0.0005

400

600

800

1000 12`00 1400

Figura 5. Histograrna de los valores a observados en el análisis del

banco de datos 2 y, en trazo discontinuo, su aproximación tog-normai.

20

Figura 6.

30

5a

60

Distribución marginal de ^i en el análisis del banco de datos 2

y, en trazo discontinuo, su aproximación log-normal.

ANAI ISI^ E3AYE SIANC? DE [_)AiC)S [^E SUPE:.RVlVENCIA C^AMMA UTlIiZANDC^ Ml.1F:^>TREO DE: C^IE3BS

E^4,3

Por último, señalar que los resultados presentados en el apartado anterior son

consistentes con los que hemos observado al analizar otros bancos de datos,

también generados a partir de distribuciones Gamma pero con distintos valores

paramétricos.

Los autores agradecen los comentarios de dos evaluadores anónimos a una

versión anterior de este trabajo.

BIBLIOGRAFIA

CASELLA, G. and GEORGE, E. I. {1992). «Explaining the Gibbs sampler». The Amer.

Statistician, 46, pp. 167-174.

DEVROYE, L. (1986). Non-Uniform Random Variate Generatian. New York: Springer-Verlag.

GELFAND, A. E. and SMITH, A. F. M. (1990). «Sarnpling-based approach to calculating marginal densities». J. Amer. Statist. Assoc., 85, pp. 398-409.

GELMAN, A. and RuBIN, D. B. (1992a). «A single series from the Gibbs sampler

provides a false sense of security». In Bayesian Statistics 4(J. M. Bernardo,

J. O. Berger, A. P. Dawid and A. F. M. Smith, eds.), pp. 625-631. Oxford: Oxford

University Press.

GELMAN, A. and RuBIN, D. B. (1992b). «Inference from iterative simulation (with

discussion)». Statistical Science, 7, pp. 457-511.

GEMAN, S. and GEMAN, D. (1984). «Stochastic relaxatian, Gibbs distributions, and

the Bayesian restoration of images». l. E. E. E. Transactions on Pattern Analysis

and Machine Intelligence, 6, pp. 721-741.

GEWEKE, J. (1992). «Evaluating the accuracy of sampling-based approaches to

the calculation of posterior moments». In Bayesian Statistics 4(J. M. Bernardo,

J. O. Berger, A. .P. David and A. F. M. Smith, eds.), pp. 169-193. Oxford: Oxford

University Press.

HASTINGS, W. K. (1970). «Monte-Carlo sampling methods using Markov chains and

their applications» . Biometrika, 57, pp. 97-109.

METROPOLIS, N., ROSENBLUTH, A. W., ROSENBLUTH, M. N., TELLER, A. H. and TELLER,

E. {1953). «Equations of state calcuiations by fast comput^ng machines».

J. Chem. Phys., 21, pp. 1087-1092.

RuBIN, D. B. (1988). «Using the SIR algorithm to simulate posterior distributions

(with discussion)». In Bayesian Statistics 3(J. M. Bernardo, M. H. DeGroot, D.

V. Lindley and A. F. M. Smith eds.), pp. 395-402. Oxford: Oxford University

Press.

6^14

^^ srAE>isT ^c^,^ F s^^^tvc>i ^

SN^iITH, A. F. M. and G^LFAND, A. E. (1992). «Bayesian statistics without tears: a

sampli^ng-resampiing perspective». The Amer. Statistician, 46, pp. 84-88.

SMtTH, A. F. %1A. ánd ROBERTS, G. O. (1993). «Bayesian computation via de Gibbs

sampler and related Markov chain Monte Carlo methods». J. Roy. Statist. Sac.

B, 55, PP. 3-23.

STEPHENS, D. and SMiTH, A. F. M. (1992). «Sampling-resampling techniques for

the computati©n of posterior densities in norrnal means problems». Test, 1, pp.

1-18.

TANNER, M. A. and WaNG, W. H. (1987). «The calculation of posterior distributions

by data augmentation». J. Amer. Statist. Assoc., 82, pp. 528-550.

BAYESIAN ANALYSIS OF GAMMA SURVIVAL DATA THROUGH GIBBS

SAMPLER

SUMMARY

This paper deals with the Bayesian analysis of Gamma data progressively

censored on the right. An improper prior distribution is used, but the resuits are

easily extended to any other prior.

The posterior distribution is studied through Gibbs sampler. A bivariate sample

from the posterior is obtained and used to compute, by Monte-Carlo methods,

some characteristics of the posterior and predictive distributions.

The paper ends with the analysis of two simulated data sets, originated from

two different Gamrna distributions.

Key words: Censored data; Gibbs sampler; Monte-Carlo method; Prediction;

Simulation.

Classification AMS: 62F 15; 62N05; 62E25.