Modelos estructurales de series de tiempo

Anuncio

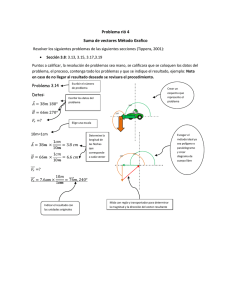

Modelos estructurales de series de tiempo Est. Laura I. Giménez Universidad Nacional del Nordeste Instituto Nacional de Tecnología Agropecuaria 1 Programa Jueves, 30 de julio de 2009 ⎯ Introducción al análisis de Series Temporales ⎯ Ejemplos ⎯ Modelos estructurales ⎯ Modelos ARMA y ARIMA ⎯ Componentes de los modelos estructurales: Nivel local y Tendencia lineal local Viernes, 31 de julio de 2009 ⎯ Estacionalidad e irregularidades ⎯ Ciclos ⎯ Variables explicativas ⎯ Formas espacio de estado ⎯ Filtrado y Suavizado ⎯ Hiperparámetros - Predicción ⎯ Aplicación a lluvias mensuales. Uso del programa Stamp 2 Bibliografía 1. Abril, J. C. (2004). Modelos para el Análisis de las Series de Tiempo. Ediciones Cooperativas. Buenos Aires. ISBN 987-1076-54-1. 377 pp. 2. Abril, J.C. (1999) Análisis de Series de Tiempo Basado en Modelos de Espacio de Estado. Editorial Universitaria de Buenos Aires. EUDEBA. ISBN 950-231024-1. 3. Feyerherm, A. M. and Bark, D. (1965). Statistical Methods for Persistent Precipitation Patterns. Journal of Applied Meteorology. Vol.4. 4. Harvey, Andrew C. (1989). Forecasting, structural time series models and the Kalman filter. Cambridge Press University. 5. Harvey, Andrew C. (1994). Time Series Models MIT Press. Cambrige, Massachusetts. 6. Instituto Nacional de Meteorología. www.inm.es 7. Pindyck, R. S. and Rubinfeld, D. L. (1976). Econometric models and economic forecasts. McGraw-Hill, Inc. Kogakusha LTD. 8. Uriel, Ezequiel (1985). Análisis de Series Temporales modelos ARIMA. Colección Abaco. Paraninfo Madrid. 3 Serie temporales Las series temporales consisten en observaciones realizadas a intervalos regulares de tiempo. Sus características salientes son: la tendencia, la cual representa el movimiento de la serie a largo de su recorrido y un patrón estacional el cual se repite, mas o menos, cada año. Un modelo de la serie necesitará capturar estas características. El modelo puede formularse asumiendo que la serie puede descomponerse de la siguiente forma: Serie Observada=tendencia+estacionalidad+irregular Donde la componente irregular refleja los movimientos no sistemáticos de la serie. También podemos asumir un modelo multiplicativo, el cual es apropiado para algunas series, Serie Observada=tendencia*estacionalidad*irregular Este modelo puede ser tratado como un modelo aditivo tomando logaritmo. ¿Para qué modelar? Hay dos razones para querer modelar una serie univariada. La primera es proveer una descripción de la serie en términos de su componente de interés. Al examinar la tendencia, veremos el movimiento principal de la serie. Puede ser de interés analizar el comportamiento estacional de la serie y, en algunos casos, puede ser interesante quitarlo para producir una serie ajustada estacionalmente. Un modelo estadístico explícito, apropiadamente formulado, clarifica los supuestos subyacentes y representa el movimiento de la serie, la cual puede tener un rango amplio de propiedades. El otro motivo subyacente de la construcción de un modelo es la predicción de valores futuros. Las series de tiempo pueden contener otros componentes. En la gráfica de observaciones anuales, además de la tendencia, es común observar comportamientos cíclicos. Por ejemplo, los movimientos en economía pueden verse desde el inicio hasta el final una recesión. Hay cambios sociales que pueden no permanecer en el tiempo. 4 Modelos estructurales El modelo estructural de una serie temporal es uno que arranca en términos de componentes, las cuales tienen una interpretación directa. El mismo no intenta representar el proceso de generación, ayuda a representar en forma “estilizada” la serie en términos de descomposición en componentes, tendencia, estacionalidad y ciclo. Ya que cada parte es de interés en si misma. La predicción desde un modelo univariado es simple, en el sentido que es, sólo una extrapolación de los movimientos pasados. Un modelo estructural de serie de tiempo permite que sus componentes sean estocásticas, la idea es que sus componentes sean lo suficientemente flexibles que permitan responder a cambios en el tiempo. La formulación estadística de la componente de tendencia en un modelo estructural, será lo suficientemente flexible para representar cambios generales en la dirección de la serie. En forma similar la componente estacional será flexible de manera que permita responder a cambios en el patrón estacional. Un modelo estructural de serie de tiempo es aquel en el cual la tendencia, la estacionalidad, el ciclo y el error, mas otros componentes relevantes, son modelados explícitamente. Comparado con la filosofía subyacente de los modelos ARIMA, donde la tendencia y la estacionalidad son eliminadas mediante diferenciación, el modelo estructural es lo opuesto. La facilidad de interpretación de los modelos estructurales de series de tiempo, los que siempre pueden ser puestos en la forma de espacio de estado, junto con la información asociada que producen el filtro y el suavizador de Kalman, hacen de ellos el vehículo natural para el tratamiento de los datos de series de tiempo. La idea básica de los modelos estructurales de series de tiempo (MEST) es que por medio de ellos se pueden expresar los componentes, tanto los observables como los no observables, de 5 una serie de tiempo como partes de modelos de regresión en donde las variables explicativas son funciones del tiempo con coeficientes que cambian a través del tiempo. Entonces, dentro de un marco de regresión, una tendencia simple sería modelada en términos de una constante por el tiempo con un disturbio, o error aleatorio, aditivo. Esto es yt = α + β t + ε t , t=1,…n Este modelo es fácil de estimar usando mínimos cuadrados simple, pero sufre la desventaja de considerar a la tendencia determinística. En general esto es muy restrictivo. En economía por ejemplo, si una variable es considerada que tiene tendencia determinística significaría que cualquier impulso económico de cualquier intensidad no tendrá efectos en el largo plazo, ya que todo retornará a su dada tendencia. La flexibilidad es introducida permitiendo que los coeficientes α y β evolucionen a través del tiempo como procesos estocásticos. De esta forma la tendencia se puede adaptar a los cambios subyacentes. La estimación actual, o filtrada, de la tendencia se la logra poniendo al modelo en su forma de espacio de estado y aplicándole luego el filtro de kalman. El filtrado significa computar el mejor estimador en cada momento t usando las observaciones disponibles hasta ese momento. Algoritmos relacionados se usan para hacer predicciones y para los suavizados. Esto último significa computar el mejor estimador en todos los puntos de la muestra usando al conjunto total de observaciones. Los parámetros en los modelos de espacio de estado usualmente se denominan hiperparámetros, para distinguirlos de los elementos del vector de estado los cuales pueden pensarse como parámetros aleatorios. La magnitud por la cual los parámetros aleatorios pueden variar está gobernada por hiperparámetros. Ellos pueden ser estimados por máxima verosimilitud, la llave de esto es la forma de espacio de estado y el filtro kalman. Para el trabajo aplicado, el punto es entender qué hacen los modelos y cómo deben ser interpretados los resultados. 6 Enfoque clásico El enfoque clásico del modelado de series de tiempo, está basado en el hecho de que un modelo general para cualquier serie estacionaria no determinística es el autorregresivopromedio móvil de orden (k,h), esto es yt = φ1 yt −1 + ... + φk yt − k + ε t + θ1ε t −1 + .. + θ hε t − h ε t ~ IID(0, σ 2 ) Este es el conocido modelo ARMA(k,h) , la estrategia de modelado consiste primero en especificar los valores adecuados de k y h, sobre el análisis de un correlograma muestral y otros estadísticos relevantes. Luego el modelo es estimado, bajo el supuesto de normalidad de los errores. Después se examinan los residuos para ver si su apariencia corresponde a la aleatoriedad y de computan varios estadísticos de prueba. En particular el estadístico Q* de Box-Ljung, el cual está basado en las primeras k autocorrelaciones de los residuos, se lo usa para testar la correlación serial de los residuos. Box y Jenkins (1976) se refieren a estos pasos como identificación, estimación y control de diagnóstico. Si este control es satisfactorio, el modelo está listo para ser usado en las predicciones. Si no lo es, se deberá intentar otra especificación. Box y Jenkins enfatizan el rol de la parsimonia, en el sentido que al seleccionar k y h los mismos deben ser pequeños. Ahora bien muchas series no son estacionarias. Con el objeto de resolver estas situaciones Box y Jenkins proponen que una serie debe ser diferenciada para hacerla estacionaria. Luego de ajustar un modelo ARMA, a la serie diferenciada, el correspondiente modelo integrado es usado para las predicciones. Si la serie es diferenciada d veces, el modelo total de la serie es denotado como ARIMA(k,d,h). Efectos estacionales pueden ser capturados mediante la diferenciación estacional. La metodología de selección de modelos para los modelos estructurales es de alguna manera diferente, en el sentido que se pone menos énfasis en la observación del correlograma de diversas transformaciones de la serie con el objeto de obtener una especificación inicial. Esto 7 no significa que no se observe el correlograma, pero él puede ser difícil de interpretar sin un conocimiento previo de la naturaleza de la serie, y en muestras pequeñas y/o con datos desordenados puede conducir a conclusiones erróneas. En lugar de ello, el énfasis está en la formulación del modelo en términos de componentes cuya presencia estaría sugerida por el conocimiento del fenómeno bajo estudio, de sus aplicaciones o por la inspección del gráfico de la serie, por ejemplo, con observaciones mensuales, uno debería incorporar desde un principio una parte estacional dentro del modelo., y solamente la sacará si luego prueba que no es significativa. Una vez que el modelo estructural ha sido estimado, el mismo tipo de prueba de diagnóstico que los usados para los modelos ARIMA pueden ser realizados con los residuos. En particular el estadístico de Box y Ljung puede ser computado siendo sus grados de libertad igual al número de autocorrelaciones residuales menos el número de hiperparámetros relativos. Pruebas estándares de falta de normalidad y heteroscedasticidad pueden ser aplicadas, como así también la prueba de la calidad predictiva. Los gráficos de los residuos pueden examinarse, de la misma manera por Box y Jenkins para la construcción de modelos ARIMA. En un modelo estructural de series de tiempo, estos gráficos pueden ser complementados con gráficos de los componentes suavizados. Estos, frecuentemente, suelen ser muy informativos puesto que permiten al investigador constatar si los movimientos en los componentes corresponden a lo que podría esperarse sobre la base del conocimiento previo. En las subsecciones siguientes se presentan los principales modelos estructurales de series de tiempo univariadas. Nivel Local Una serie de tiempo es un conjunto de observaciones y1, y2, y3,…yn ordenadas en el tiempo. El modelo básico para representar una serie de tiempo es el aditivo yt = μt + γ t + ϑt + ε t con t=1..n 8 Donde μt es la componente que cambia suavemente en el tiempo, γ t es el componente con período fijo llamado estacionalidad, ϑt es el componente periódico con frecuencia menor a la estacionalidad llamado ciclo y ε t es un componente irregular llamado error. Cuando las componentes se combinan en forma multiplicativa, yt = μt γ tϑt ε t se trabaja con los logaritmos de los valores, reduciendo este modelo a un modelo aditivo. El modelo estructural de series de tiempo mas simple presenta una situación en la que no hay estacionalidad, ni ciclos y la tendencia está compuesta por el nivel de la serie que cambia a través del tiempo. Ese nivel es modelado por un camino aleatorio “random walk” sobre el cual se le sobreimpone un error aleatorio o ruido blanco. Además, todas las variables aleatorias se distribuyen normalmente. Esto da el modelo denominado “modelo nivel local” (NL) yt = μt + ε t ε t N (0, σ ε2 ) μt = μt −1 + ηt ηt N (0, σ η2 ) para t=1,..n, donde ε t y ηt son mutuamente independientes. Una característica práctica muy importante del modelo es que el estimador del nivel, basado en la información disponible, está dado por un promedio móvil exponencialmente ponderado de las observaciones pasadas, donde la constante de suavizado es una función del cociente señal de ruido q= σ η2 / σ ε2 . La predicción de observaciones futuras, no importa cuantos pasos adelante, está dada por la misma expresión. Para un camino aleatorio puro, q es infinito, llegándose a que la predicción es la última observación. Cuando q tiende a cero la predicción se acerca a la media muestral. 9 Tendencia lineal local Los modelos de tendencia lineal local (TLL) reemplazan la tendencia determinística por una estocástica, la formulación es yt = μt + ε t ε t N (0, σ ε2 ) μt = μt −1 + βt −1 + ηt ηt N (0, σ η2 ) βt = βt −1 + ς t ς t N (0, σ ς2 ) Para t=1, ..n con los errores ε t , del nivel, ηt y la pendiente, ς t mutuamente independientes. Las magnitudes por las cuales el nivel μt y la pendiente βt cambian a través del tiempo, están gobernadas por los hiperparámetros relativos qη = σ η2 / σ ε2 , y qς = σ ς2 / σ ε2 . La función de predicción es la línea recta a partir de las estimaciones del nivel y de la pendiente al final de la muestra. Investigadores aplicados, cuando la tendencia no es clara, suelen establecer σ η2 =0 para ajustar el modelo con esta restricción. Si σ ς2 =0, tenemos que βt = βt −1 = βt − 2 .. = β , si β ≠ 0 , la tendencia es un camino aleatorio mas una constante, μt = μt −1 + β + ηt . t Así con α = μ0 , se verifica que yt = α + β t + ∑ηi + ε t . i =1 Aquí el comportamiento de yt está gobernado por dos componentes no estacionarios, una t tendencia lineal determinística y la tendencia estocástica ∑η . i =1 i Cuando σ ς2 =0 y β = 0 el modelo se reduce al modelo NL. t yt = α + ∑ηi + ε t i =1 10 Nótese que todos los sucesivos shocks ηt tienen efecto permanente en la sucesión yt por el hecho que no hay un factor que decaiga y afecte los valores pasados de ηt . Cuando σ ς2 =0, ση2 = 0 y β es diferente de cero, la tendencia es una función lineal determinística del tiempo, quedando el modelo para yt puede expresarse como clásico modelo de la tendencia lineal mas ruido yt = α + βt + ε t t −1 t j =1 i =1 yt = μ0 + β 0t + ∑ (t − j )ς j + ∑ηi + ε t Aquí cada elemento de la sucesión yt contiene una tendencia determinística, una tendencia estocástica y un componente irregular o error. Lo más interesante de este modelo es la forma de la tendencia, en lugar de ser determinística, los coeficientes del tiempo dependen de realizaciones pasadas de la sucesión ς j . Estos coeficientes pueden ser positivos para algunos valores de t y negativos para otros. En este caso como σ η2 y σ ς2 >0, el nivel y la pendiente de la tendencia pueden variar suavemente en el tiempo. Tendencia, estacionalidad e irregularidades La estacionalidad es un componente que se repite con periodicidad, dentro del tiempo bajo estudio. Las series pueden ser observaciones trimestralmente, mensualmente, diaria y estar sujetas a variaciones estacionales. Este componente necesita que se le permita que cambiar a través del tiempo, de la misma manera que se le dío mayor flexibilidad a la tendencia permitiéndole que sea estocástica. Sin embargo el argumento para que el componente estacional sea estocástico es menos fuerte que para la tendencia estocástica. Aunque es posibles que puedan suceder cambios en la estructura estacional. 11 Para modelar la estacionalidad supongase que hay “s” meses por año. Así para los datos mensuales s=12, para datos trimestrales s=4 y para datos diarios cuando se modela estructura semanal, s=7. Si el componente estacional es determinístico, debe tener la propiedad de sumar cero sobre el s −1 año anterior, esto asegura que no se confunda con la tendencia. Se sigue que ∑ γ t − j = 0 , por j =0 s −1 lo tanto γ t = −∑ γ t − j , t=s,s+1,…. En situaciones prácticas frecuentemente queremos que j =1 exista la posibilidad de que el componente estacional cambie en el tiempo. Una manera simple de lograrlo es agregando un término de error wt es la última relación, lo que da el modelo s −1 γ t = −∑ γ t − j + w j , t=1, ..n, donde los w j son independientes N (0, σ ω2 ) . j =1 Esta es la forma de variables ficticias (“dummy”) de la estacionalidad estocástica. Una alternativa es denotar el efecto de la estación j en el momento de tiempo t mediante γ jt y luego hacer que este término sea generado por un camino aleatorio. γ jt = γ j ,t −1 + ω jt , t=(i-1)s+j, i=1,2,…j=1,..,s Con un ajuste adecuado para asegurar que cada sucesivo conjunto de s componentes estacionales suma cero. La estacionalidad puede expresarse también en su forma trigonométrica, para estacionalidad constante es la siguiente: s/2 γ jt = ∑ (γ j . cos λ j t +γ *j . senλ j t ), λ j = j =1 2π j , j=1,…s/2 s Para estacionalidad que varía con el tiempo, esta puede hacerse estocástica agregando los términos aleatorios. Sin los términos del error este modelo estacional dará la misma estructura determinística que el modelo estacional con variables ficticias. De cualquier manera, con estacionalidad 12 estocástica es un mejor modelo porque permite que el componente estacional evolucione con mayor suavidad. Se puede mostrar que la suma de las estacionalidades sobre el año anterior sigue un modelo MA(s-2) en lugar de ser un ruido blanco. Los efectos estacionales están combinados en forma aditiva con la tendencia y los componentes irregulares. Ahora bien, en muchas aplicaciones, son combinados de manera multiplicativa. De cualquier manera tomando logaritmos y trabajando con el logaritmo de los valores podemos llegar a la estructura aditiva. El modelo estructural básico (MEB) yt = μt + γ t + ε t con t=1,…n Cada uno de los modelos estacionales presentados anteriormente puede ser combinado con cualquiera de los modelos de tendencia resultados un modelo estructural de serie de tiempo. Forma de Espacio de Estado Se presenta a continuación un enfoque unificado para el análisis de series de tiempo. El tratamiento técnico está basado en los métodos de espacio de estado. Estos métodos pueden ser aplicados a cualquier modelo lineal, incluyendo aquellos dentro de la clase de los autorregresivos integrados de promedios móviles. Todos los modelos lineales de series de tiempo tienen una representación en la forma de espacio de estado. Esta representación relaciona el vector de errores o disturbios ε t con el vector de observaciones yt vía un proceso de Marcov. La expresión es yt = Z tα t + ε t , ε t N (0, H t ) α t = Ttα t −1 + Rtηt , ηt N (0, Qt ) Donde yt es un vector de orden px1 de observaciones y α t es un vector de orden mx1 inobservable, llamado vector de estado. La idea subyacente en el modelo es que el desarrollo del sistema en el tiempo está determinado por α t . Pero debido a que α t no puede ser 13 observado directamente, debemos basar nuestro análisis en yt . Las matrices Z t , Tt , Rt , H t y Qt se suponen inicialmente conocidas y los términos del error se suponen que son independientes entre si en todo momento de tiempo. Las matrices Z t y Tt pueden depender de y1,….yt-1. El estado inicial α 0 se supone que es N(a0,P0) es independiente de ε1 ,...., ε n y de η1 ,...,ηn , se suponen conocidos a0 yP0 . Este modelo se llama modelo básico de espacio de estado (MBEE) aunque también se lo conoce usualmente como modelo lineal gaussiano de espacio de estado. A la primera ecuación se la denomina ecuación de medida o ecuación de observación y a la segunda la ecuación de transición o relación de transición o ecuación de estado. Es interesante destacar que la ecuación de medida es equivalente a un modelo de regresión con coeficientes α t estocásticos que satisfacen la ecuación transición. En muchas aplicaciones Rt es la matriz identidad. En modelos univariados p=1, por lo tanto Z t es un vector fila y H t es un escalar que se lo suele denotar como σ ε2 . Un modelo tendencia lineal local (TLL) puede ser puesto en la forma de espacio de estado, ⎛1⎞ ⎜ ⎟ ⎜0⎟ ⎜1⎟ por ejemplo Z t' = ⎜ ⎟ , ⎜0⎟ ⎜.⎟ ⎜⎜ ⎟⎟ ⎝0⎠ ⎛ μt ⎞ ⎜ ⎟ ⎜ βt ⎟ ⎜ γ ⎟ αt = ⎜ t ⎟ ⎜ γ t −1 ⎟ ⎜ . ⎟ ⎜⎜ ⎟⎟ ⎝ γ t −s+2 ⎠ ⎛1 ⎜ ⎜0 ⎜. ⎜ Tt = ⎜ ⎜ ⎜ ⎜ ⎜ ⎜⎜ ⎝ ⎛1 ⎜ ⎜0 ⎜0 Rt = ⎜ ⎜0 ⎜. ⎜⎜ ⎝0 1 . 1 . . . . . 0 . . . ⎞ ⎟ ⎟ . . . . . ⎟ ⎟ −1 −1 −1 −1 −1⎟ 1 0 0 0 0⎟ ⎟ 0 1 0 0 0⎟ . . . . . ⎟ ⎟ 0 0 . 1 0 ⎟⎠ 0 0 0⎞ ⎟ 1 0⎟ 0 1⎟ ⎟ 0 0⎟ . .⎟ ⎟ 0 0 ⎟⎠ 14 Ciclos Un ciclo es un componente periódico con frecuencia menor a la estacionalidad. Un ciclo determinístico puede ser expresado como una onda sinusoidal, esto es ϑt = α cos λt + β senλt con t=1,..,n Anteriormente se puntualizó que una estructura estacional puede ser modelada por un conjunto de tales ciclos definidos en las frecuencias estacionales. Agregando errores se permite que esta estructura cambie a través del tiempo. Una situación algo diferente puede suceder cuando queremos modelar el ciclo, el cual puede ser estocástico, y a diferencia de los ciclos estacionales, puede ser estacionario. La especificación estadística de tal ciclo ϑt es como sigue ⎛ ϑt ⎞ ⎛ cos λc ⎜ *⎟= ρ⎜ ⎝ ϑt ⎠ ⎝ − senλc senλc ⎞ ⎛ ϑt −1 ⎞ ⎛ kt ⎞ ⎟⎜ ⎟+⎜ ⎟ cos λc ⎠ ⎝ ϑt*−1 ⎠ ⎝ kt* ⎠ Donde λc es la frecuencia en radianes en el intervalo 0 ≤ λc ≤ π , k t* y k t* son 2 procesos ortogonales o ruido blanco mutuamente no correlacionados con media 0 y varianza común σ k2 y ρ es un factor amortiguador, perteneciente al intervalo [0,1]. El período es 2π / λc . Variables explicativas y análisis de intervención Las variables explicativas pueden ser fácilmente incluidas en un modelo estructural. Se denominan también variables ficticias, ellas son usadas para el manejo de las observaciones faltantes y de los efectos de las intervenciones. Si xt es un vector de kx1 variables explicativas observadas y β es el correspondiente vector de parámetros, el modelo yt = μt + xt´ β + ε t , t=1,..n, este puede ser considerado un modelo de regresión con componente de tendencia estocástica, μt . Si las varianzas son cero, el modelo se reduce a una expresión lineal con constante y una tendencia lineal. 15 El algoritmo de Kalman Introducción Se presenta un tratamiento general desde el punto devista de la inferencia clásica del modelo Gaussiano de espacio de estado. Las observaciones yt serán consideradas multivariadas y se discutirá el filtrado, suavizado, la estimación de los hiperparámetros y la predicción. El filtrado tiene por finalidad actualizar nuestro conocimiento del sistema cada vez que una nueva observación yt es obtenida. El suavizado nos permite basar las estimaciones de cantidades de interés en la muestra completa y1,….yn. Los parámetros en los modelos de espacio de estado usualmente se denominan hiperparámetros, presumiblemente para distinguirlos de los elementos del vector de estado los cuales pueden pensarse como parámetros aleatorios. Además recordemos que la magnitud por la cual los parámetros aleatorios pueden variar están gobernadas por estos hiperparámetros. La predicción tiene importancia especial en muchas aplicaciones del análisis de series de tiempo. Se pueden lograr resultados de las predicciones tomando a los valores futuros yn+1 yn+2 …como observaciones faltantes. El análisis estadístico de los modelos estructurales de series de tiempo está basado en la forma de espacio de estado. Los modelos gaussianos de espacio de estado pueden ser estudiados estadísticamente mediante el filtro de kalman y el suavizador asociado. La función de verosimilitud se la construye a partir del filtro de kalman en términos de la predicción un paso adelante, y es maximizada con respecto a los hiperparámetros por optimización numérica , el vector marcador (score) de los parámetros puede obtenerse a través de un algoritmo de suavizado asociado con el filtro kalman. Una vez que los hiperparámetros han sido estimado el filtro es usado para lograr predicciones de los residuos un paso adelante, lo que no permite calcular los estadísticos de diagnóstico para normalidad, correlación serial y bondad de ajuste. Con los resultados del filtrado y suavizado se logran predicciones de la serie bajo estudio. El 16 suavizador es utilizado para estimar componentes no observables, tales como la tendencia y la estacionalidad, y para calcular estadísticos de diagnósticos que sirven para detectar observaciones atípicas y cambios estructurales. La forma de espacio de estado Todos los modelos lineales de series de tiempo tienen una representación en la forma de espacio de estado. Esta representación relaciona el vector de errores o disturbios ε t con el vector de observaciones yt a través del proceso de Marcov α t , la expresión es: yt = Z tα t + ε t , ε t N (0, H t ) α t = Ttα t −1 + Rtηt , ηt N (0, Qt ) Donde yt es un vector de orden px1 y α t es un vector de orden mx1 inobservable, llamado vector de estado. La idea subyacente en el modelo es que el desarrollo del sistema en el tiempo está determinado por α t de acuerdo a la segunda ecuación, pero debido a que α t no puede ser observado directamente, debemos basar nuestro análisis en las observaciones yt . Las otras matrices de la ecuación, se suponen inicialmente conocidas y los términos de error se suponen independientes entre si en todo momento del tiempo. Las matricez Z y T pueden depender de y1,….yt-1. El estado inical α 0 se supone que es N(a0,P0) e independiente de los errores ε t y ηt . Este modelo inicial se lo denomina básico de espacio de estado (MBEE), aunque también se lo conoce como modelo lineal gaussiano de espacio de estado. La primera se denomina ecuación de observación y a la segunda ecuación de transición o relación de transición. Es interesante destacar que la ecuación de observación es equivalente a un modelo de regresión con coeficientes α t estocásticos que satisfacen la ecuación de transición. 17 Denotaremos como Yt-1 al conjunto de los y1,--yt-1, que es toda la información anterior al tiempo t=1. Comenzando en T=1 y construyendo la distribución de α t e yt recursivamente se puede demostrar que p( yt / α1 ,..., α t , Yt −1 ) = p( yt / α t ) y p(α t / α1 ,..., α t −1 , Yt −1 ) = p(α t / α t −1 ) estableciendo con ello la verdadera naturaleza markoviana del modelo. Filtrado El objetivo del filtrado es actualizar nuestro conocimiento del sistema cada vez que se obtiene una nueva observación yt . Una vez que el modelo ha sido puesto en su forma de espacio de estado, el camino está abierto para la aplicación de un número importante de algoritmos. En el centro de ellos está el filtro de kalman. Este filtro es un procedimiento recursivo para computar el estimador óptimo del vector de estado en el momento t, basado en la información disponible hasta ese tiempo t. En ciertas aplicaciones de ingeniería el filtro kalman es importante debido a la posibilidad de lograr estimaciones sobre la marcha. El valor actual del vector de estado es de interés y el filtro kalman permite que la estimación del vector de estado sea continuamente actualizada cada vez que una nueva observación está disponible. Otra razón para el rol central del filtro Kalman es que cuando los errores y el vector de estado inicial están normalmente distribuidos, permite que la función de verosimilitud sea calculada a través de lo que se conoce como la descomposición del error de predicción. Esto abre el camino para la estimación de cualquier parámetro desconocido en el modelo. También provee las bases para los tests estadísticos y especificación del modelo. La forma en que se deriva mas abajo el filtro kalman para el modelo de espacio de estado, se basa en el supuesto del estado inicial α 0 se supone que es N(a0,P0) e independiente de los errores ε t y ηt . Luego es usado un resultado estándar sobre la distribución normal multivariada para mostrar cómo es posible calcular recursivamente la distribución sobre 18 α t condicional a la información establecida en el tiempo t, para todo t de 1 a n. Estas distribuciones condicionales son a su vez normales y por lo tanto están completamente especificadas por sus matrices de medias y varianzas. Son estas cantidades las que el filtro de kalman computa. Así, spongase que queremos obtener la distribución a posteriori de α t +1 dado Yt . Puesto que todas las distribuciones condicionales son también normales. Supongamos que α t dado Yt −1 es N (at , Pt ) y la de α t dado Yt es N (at / t , Pt / t ) . Nuestro objetivo es calcular recursivamente at / t , Pt / t , at +1 , Pt +1 dado at , Pt Sea vt = yt − Z t at este es el error de predicción un paso adelante y satisface vt = yt − E ( yt / Yt −1 ) Iniciación: como iniciar el filtrado cuando se desconocen los parámetros a0 y P0 de la distribución de α 0 . Se presenta entonce la distribución difusa a priori, esto es, se fija a0 en un valor arbitrario y se hacen tender los elementos diagonales de P0 a infinito. Una aproximación adecuada puede, con frecuencia, alcanzarse numéricamente tomando a0 =0 y P0=KIm donde Im es la matriz identidad de orden m y K es un número finito grande. No obstante, en algunos casos esto conduce a inaceptables errores de redondeo, por lo que se requiere una técnica mas precisa. Suavizado: considerando ahora la estimación de α1 ,..., α n dada la muestra completa Yn. El estimador con error cuadrático medio mínimo (ECMM) de α t es α t = E (α t / Yn ) . Llamamos a esto el valor de suavizado de α t y llamamos a la operación de calcular esos alfas suavizado. Estimación de los hiperparámetros: Como ya lo vimos, los parámetros en los modelos de espacio de estado usualmente se denomina hiperparámetros, presumiblemente para distinguirse del vector de estado los cuales pueden pensarse como parámetros aleatorios. Además recordemos que la magnitud por la cual los parámetros aleatorios pueden variar está 19 gobernada por los hiperparámetros. Ahora debemos estimar por máxima verosimilitud los hiperparámetros del modelo de espacio de estado. Comenzamos construyendo la verosimilitud. Suponiendo que a0 y P0 son conocidos, la densidad conjunta de y1,..yn es p(Yn) =∏ p(y t /Yt-1 ) , donde p( yt / Yt −1 ) = N ( Z t at , Ft ) por lo tanto tomando los logaritmos obtenemos log L = − np 1 n 1 n log(2π ) − ∑ log Ft − ∑ vt´ Ft −1vt 2 2 t =1 2 t =1 Esto se llama descomposición del error de predicción del logaritmo de la verosimilitud. Predicción : Supongamos que y1,... yn que satisfacen el modelo de espacio de estado y queremos predecir yn +l , l= 1,2,..J. Queremos que la predicción sea con mínimo error medio cuadrático de predicción dada la muestra completa es Yn. 20 Pasos realizados en la modelización 1. Sobre la base de la inspección gráfica de las características saliente de la serie mensual, trimestral y anual, mas el conocimiento de la variabilidad de la variable bajo estudio. Se propone un modelo con un conjunto de componentes apropiados. Por ejemplo, las lluvias mensuales presentan gran variabilidad podría proponerse un modelo multiplicativo al cual se le aplicará la transformación logarítmica para hecerlo aditivo. 2. Incorporación de las variables de intervención que surgen del Modelo Estructural Básico. Este modelo está compuesto por el nivel y la pendiente ambos aleatorios, la estacionalidad trigonométrica aleatoria y un componente irregular. Esto se puede cambiar luego, pero inicialmente permitirá detectar valores extremos. Las variables de intervención surgen de la inspección de los residuos que pasan las bandas de confianza. 3. Estimación de los hiperparámetros de todas las componentes del modelo. Esto permite decidir si la componente es fija o aleatoria. Cuando la estimación del parámetro nos da Cero, significa que la componente correspondiente es fija. 4. Reformulación del modelo a través de análisis del Estado Final, en el cual se analiza la significancia de los valores que toman los componentes al final de la muestra. Los estimadores de suavizado de los componentes de tendencia, estacionalidad y cíclicos se obtienen utilizando toda la información de la muestra. Luego se analizan los residuos. 5. Análisis de Regresión: Los estimadores de los parámetros de regresión, los parámetros de las variables de intervención y las estimaciones fijas de estacionalidad. Estos estimadores pueden ser interpretados, en general, de la misma forma que un modelo de regresión estándar. Considerando que ellos son determinísticos (invariantes en el tiempo) y teniendo en cuenta el desvío estándar de las estimaciones, los t-valores deberían tener una distribución t si los hiperparámetros (relativos) fueran conocidos. Aunque ellos son normales asintóticamente. Una distribución t puede proveer una mejor aproximación a las propiedades para muestras pequeñas. Los P valores están basados en distribuciones normales. 6. Obtención de los estadísticos resumen del modelo : a. H(h) : test de heterosedasticidad, distribuido aproximadamente como F(h,h) b. r(t) : la autocorrelación residual a la distancia t (lag t) distribuida aproximadamente como N(0,1/T) c. DW : Durbin-Watson statistics, distribuido aproxidadamente como N(2,4/T) d. Q(P,d) : Box-Ljung Q-statistic basadas en los primeros P residuales de las correlaciones distribuidas aproximadamente como χ d y finalmente los coeficientes de determinación mas apropiados. 7. Evaluación de la bondad del modelo propuesto. Prediction error variance (PEV) la varianza o matriz de covarianza de error de predicción logrado paso a paso. Normalidad de los residuis utilizando el estadístico de Bowman-sheton, distribuida aproximadamente como χ2, 2 grados de libertad, AIC. 8. Predicción – extrapolación de valores futuros. 2 21 Ejemplo La serie analizada correponde a valores mensuales de la localidad de Monte Aloia, en la provincia de Pontevedra, Galicia. Esta serie consta de 204 observaciones de milímetros de lluvia caída mensual desde enero de 1991 hasta diciembre de 2007. Tabla 1. Mediana y desvíos absolutos respecto de la mediana (MAD) de Mes ENE FEB MAR ABR MAY JUN JUL AGO SET OCT NOV DIC Mediana 305.5 164 173 136 166.8 60.7 53 MAD 86.5 59.5 70.8 146.5 109 27 64 36.5 22 129 270 262.2 360 67 122 133 145.8 La precipitación anual promedio es de 2576.9 milímetros, con una variabilidad entre años de 483.92 mm. Figura 1. Lluvias mensuales de Monte Aloia y su logaritmo Serie de lluvias 972.0 777.6 Monte aloia 583.2 388.8 194.4 0.0 01-01-91 01-06-94 01-11-97 01-04-01 01-09-04 fecha 22 Serie transformada 7.2 5.8 Logaritmo lluvias 4.3 2.9 1.4 0.0 01-01-91 01-06-94 01-11-97 01-04-01 01-09-04 fecha Modelización Se presenta a continuación el modelo que surgió luego de la apreciación visual de la serie temporal, de la consideración de las estadísticas descriptivas mensuales y anuales, y después de seguir la secuencia de pasos que conduce a un modelo adecuado: yt = μt + γ t + ϑt + ∑λ x 10 i ( j) t + ε t , con t=1,2,…204 i =1 (1/1991 a 12/2007), siendo yt es el ln de las lluvias mensuales, μt es la componente de tendencia, γ t es la componente estacional, ϑt es la componente cíclica con frecuencia menor a la estacionalidad, λi y xi son el coeficiente y las variables de intervención y ε t es la componente irregular llamada error. Análisis de la tendencia Se estimaron los hiperparámetros, o varianzas de los disturbios correspondientes al nivel, y a la pendiente. Los hiperparámetros relativos, simbolizados qn y qζ , se obtienen del cociente de cada uno respecto de σ ε2 . En este caso qn = 0 y qζ = 0 lo que significa que la tendencia está compuesta de nivel fijo y de una posible pendiente determinística. Luego, al analizar la componente correspondiente a la pendiente, estimada con el filtrado y suavizado del vector de estado, se prueba la hipótesis β = 0 , mediante la aplicación de una prueba T, que dio como resultado T=-0.139273, P-valor= 0.8894 aceptando la hipótesis nula. En el análisis de la componente correspondiente al 23 nivel, se prueba la hipótesis μt = 4.9920 una prueba T, que dio como resultado T=102.55, Pvalor=0.000. Luego la tendencia está guiada por un camino aleatorio sin pendiente descrita por un nivel fijo. La componente de tendencia en el período estimado es 147.226, expresada en términos de la variable original. Análisis de la estacionalidad También la componente estacional se consideró fija, teniendo en cuenta el valor de los hiperparámetros relativos. Esto significa que cada año se repiten con presencia y con escasez de lluvias, dependiendo del mes. La prueba de χ 2 , realizada sobre los s-1 efectos estacionales bajo la hipótesis nula de no estacionalidad dio como resultado χ 2 =80.729, P-valor=0. Tabla 2. Aportes porcentuales promedio del patrón estacional al nivel de la serie mensual de Monte Aloia. EE APN 1 2 3 4 5 6 7 8 9 10 11 12 86.2 17.6 8.67 0.71 -0.5 -58.4 -64.8 -59.2 -9.6 107.2 86.1 102 EE : Efecto Estacional y APN: Aporte Porcentual al Nivel Los coeficientes estacionales que resultaron significativos fueron 1, 6, 7, 8, 10,11 y 12. Estos coeficientes representan los aportes promedio del patrón estacional al nivel de la serie mensual original. El resto de los meses el aporte es nulo. Análisis del ciclo El hiperparámetro relativo del ciclo fue igual a cero por lo tanto se consideró un componente fijo. El coeficiente ρ =1. El período representa 1.6 años. Incorporación de las variables de intervención En el modelo se incluyeron 10 variables de intervención. Tabla 3. Momento en el tiempo y significancia de los coeficientes estimados de las variables de intervención. 24 P-valor Año y Mes 1992. 7 1993. 2 1993. 7 1997. 3 1997. 9 1998. 8 2001.11 2001.12 2004. 2 2007.10 [ [ [ [ [ [ [ [ [ [ 0.0003] 0.0000] 0.0000] 0.0000] 0.0000] 0.0000] 0.0000] 0.0114] 0.0002] 0.0000] Las variables de intervención, 4 de las cuales se producen 2 en febrero y 2 en julio. En marzo, agosto, setiembre, octubre, noviembre y diciembre se registran 1 en cada mes. Análisis de la dependencia Temporal La tabla siguiente muestra 5 estadísticos que permiten el análisis del modelo considerando la adecuacidad del mismo en función la autodependencia. Tabla 4 Estadísticos y su significancia del ln de lluvias Valor del Estadístico P-Valor H(67)= 0.90371 [0.66010117] r( 1)= 0.01796 [0.39877515] r(13)= 0.00125 [0.49287836] DW=1.955 [0.37396768] Q(13,10)= 8.773 [0.55377382] Luego los P-valores que acompañan a los estadísticos no dan significativos. No hay autocorrelación residual a la distancia 1, ni 13, r(1) y r(13). No hay evidencia de correlación serial (DW), el estadístico H indica que se acepta la hipótesis de no heterosedasticidad y Q indica la adecuacidad de un modelo con 4 hipermarámetros. Medidas de Bondad de Ajuste y Análisis de los residuos La variancia del error de predicción PEV=0.409871,el criterio de información de Akaike, AIC=0.64682 y el coeficiente de determinación de las diferencias fue R2d=0.80895. Los residuos estimados para el modelo propuesto, tuvieron una Media=-0.024437 con un Desvío Estándar=0.946549. El test para el análisis de normalidad de los mismos, se realizó con estadístico 25 de Bowman-Sheton cuyo resultado fue BS Chi2=3.3961, P-valor=0.1830 aceptación la hipótesis de normalidad. Tabla 5. Año, Mes, valor de predicción y Desvío Estándar de las lluvias Período Predicción R.m.s.e. 2008. 1 2008. 2 2008. 3 2008. 4 2008. 5 2008. 6 2008. 7 2008. 8 2008. 9 2008.10 2008.11 2008.12 240.83 150.70 140.04 132.35 134.91 58.692 51.913 62.940 145.09 342.88 313.45 341.51 234.91 147.02 136.63 129.13 131.63 57.262 50.644 61.395 141.52 334.40 305.68 333.02 26