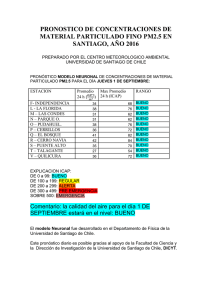

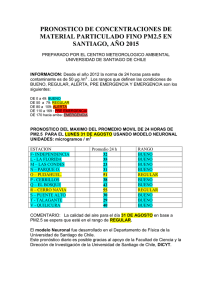

Tesisgiovannisalini-Nº21 - Departamento de Física

Anuncio