del control de calidad a la excelencia en la gestión

Anuncio

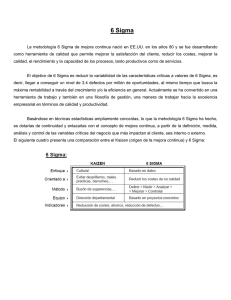

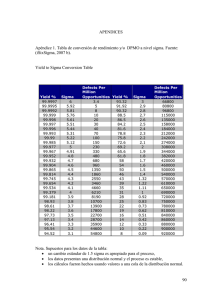

VI Congreso Galego de Estatística e Investigación de Operacións Vigo 5-7 de Novembro de 2003 DEL CONTROL DE CALIDAD A LA EXCELENCIA EN LA GESTIÓN. EJEMPLO DE APLICACIÓN EN MATERIALES COMPUESTOS. Salvador Naya Fernández Departamento de Matemáticas Universidade da Coruña RESUMEN El Control de Calidad fue introducido en Estados Unidos a principios del siglo XX. Al principio se entendía la Calidad como “conformidad con las especificaciones”, y hasta muy avanzados los años cincuenta la única forma de Gestión de Calidad era el Control de Calidad. A partir de los años setenta empieza a hablarse de Aseguramiento de la Calidad, y con la crisis económica de los años setenta se introduce el concepto de Calidad Total; en la actualidad se habla de Excelencia en la Gestión, surgiendo una serie de herramientas como el modelo EFQM de Excelencia, el Cuadro de Mando y los métodos Seis Sigma. En este trabajo se hace un breve recorrido histórico de la evolución de la Gestión de la Calidad hasta nuestros días y se aplica la metodología estadística a un problema de Control de Calidad en materiales compuestos. 1. INTRODUCCIÓN La Calidad ha experimentado una serie de cambios en estos últimos años, especialmente a partir de 1988 con el nacimiento de la EFQM (European Foundation for Quality Management) y de la aparición del concepto de Excelencia en la Gestión. Desde la primera acepción de calidad como “conformidad con las especificaciones” hasta nuestros días con la utilización de metodologías como Seis Sigma, existe como denominador común el empleo de la estadística. El papel que juega la estadística en todo el proceso de control de calidad es crucial. Una forma de expresarlo es la cita de W.G. Hunter, Profesor de la Universidad de Wisconsin, quien afirmó: “Si se deben mejorar los niveles actuales de calidad y productividad deben hacerse cambios en el modo en que se hacen las cosas en la actualidad, debería disponerse de buenos datos que sirvan como base racional sobre la cual hacer esos cambios. Una pregunta doble aparece: ¿qué datos tomar? y, una vez recogidos, ¿cómo deben analizarse? La Estadística es la ciencia que responde a esta doble pregunta”. Como propuesta de aplicación de las distintas herramientas se aplicarán estos conceptos al estudio de un material compuesto de fibra de carbono y resina epoxi. En este tipo de estudios de calidad es necesaria la realización de diseños de experimentos con el objeto de conseguir las mejores prestaciones de las variables que intervienen en el compuesto. Por otra parte, el control en producción puede hacerse midiendo parámetros como la dureza o el número de defectos, para lo que es de gran apoyo la utilización de los Gráficos de Control. 2. DEL CONTROL DE CALIDAD A LA CALIDAD TOTAL El concepto de Control de Calidad se remonta a la década 1930-1940 con los trabajos de W. Shewart, H.F.Dodge y E. Farell. De esta época datan los primeros gráficos de control. El Control de Calidad se desarrolló ampliamente durante la segunda guerra mundial por las necesidades de la industria armamentista. El grupo de estadísticos que durante la guerra trabajó intensamente en este campo (principalmente en la Universidad de Columbia) se extendió por todos los Estados Unidos al acabar la guerra y fue, en gran medida, el germen del crecimiento de la Estadística en las universidades americanas. Después de la guerra, el uso del Control de Calidad descendió notablemente, quedando relegado al que hacían las fábricas de armamento. En la mayor parte de las empresas, los departamentos de producción se desentendían del producto una vez había sido fabricado y dejaban en manos de los departamentos de comercialización los posibles problemas de calidad detectados posteriormente. W. Deming J. Juran G. Taguchi A partir de 1950, el estadístico estadounidense W.E. Deming (ignorado por completo en su patria) y el ingeniero americano J.M. Juran, inician el auge del control de calidad en la industria japonesa. En esos años, el mercado americano se vio completamente repleto de productos japoneses que, lejos de tener este auge tan espectacular por el bajo coste de la mano de obra (como indicaban entonces algunos analistas), ganaban cuota de mercado porque funcionaban mejor y duraban más. Poco después de la Segunda Guerra Mundial, la industria japonesa tenía una imagen de fabricantes de productos baratos, de baja calidad. Los japoneses iniciaron de inmediato un programa para mejorar esta imagen. El programa comenzó en 1949 con la mejora del sistema de telecomunicaciones de Japón, realizado por los ECL (Electrical Communication Laboratories), de la compañía NTT (Nippon Telephone and Telegraph). El Dr. Genichi Taguchi participó en este proyecto con la responsabilidad de promover la productividad en investigación y desarrollo para ECL. Para optimizar los costes de la experimentación, Taguchi desarrolló un enfoque del Diseño de Experimentos en términos de costes: la variación reducida se traduce en una mayor reproducibilidad, viabilidad y, finalmente, en grandes ahorros en costes tanto para el fabricante como para el cliente. Cualquier enfoque efectivo de la calidad debe dirigirse a la relación entre calidad y coste. Taguchi viajó a los Estados Unidos en 1962 y visitó la Universidad de Princetown como Investigador Asociado. Volvió a Japón y fue profesor en la Universidad Aoyama Gakuin, en Tokio, hasta 1982. Durante este tiempo, formó a miles de ingenieros en la industria, mientras colaboraba como consultor con las más importantes empresas japonesas, tales como Toyota Motors, Fuji Films y Nippondenso. Hoy en día es el Director Ejecutivo del American Supplier Institute, Inc. en Dearborn, Michigan. Es también Director del Japan Industrial Technology Institute, y trabaja como consultor independiente en Japón, Estados Unidos, China, India y Europa. Los métodos Taguchi se introdujeron en los Estados Unidos en los años 1980-82, con AT&T Bell Laboratories, Ford Motor Company y Xerox Corporation como pioneros. La Ingeniería de Calidad de Taguchi es una técnica sistemática que comprende todas las etapas del desarrollo de un producto, desde el diseño hasta la producción. Se divide generalmente en dos partes; una de ellas es la Ingeniería de Calidad fuera de línea, que es la que afecta a la optimización de los diseños (producto y proceso de producción), y la otra es la Ingeniería de Calidad en línea, y su ámbito es el control y optimización de la producción. Esta sistemática se basa en el empleo de una serie de métodos y desarrollos, tanto estadísticos como propios de ingeniería, así como unos aspectos filosóficos y culturales que enmarcan todo el proceso. Son también destacables las aportaciones del profesor Ishikawa, que intentó implicar en la calidad a todos los estamentos de la empresa, poniéndola al alcance de los niveles más bajos (desarrollo de las siete Herramientas Básicas de la calidad y la creación de los Círculos de Calidad. Por otra parte, Deming regresó en los años 70 a Estados Unidos y se hizo profeta en su tierra. A partir de ese momento, empezó a calar la idea de garantía de calidad entre los ingenieros americanos y la expresión Calidad Total entró en la jerga habitual de la producción. Desgraciadamente la reacción en Europa ha sido, en muchos casos, bastante más tardía quedando todavía mucho por hacer. El concepto de Calidad Total fue definido en 1986, por J.R. Houghton, el presidente de una de las compañías cristaleras más importantes en Estados Unidos, de la siguiente manera: “calidad es saber qué debe hacerse, tener las herramientas para hacerlo correctamente y luego hacerlo correctamente a la primera”. Detrás de todo ello está el principio japonés del kaizen, o continua búsqueda para incrementar la mejora. Desde luego, para poder realizar esto es absolutamente necesario dedicar mucho tiempo y dinero a la tarea de tratar de que el proceso funcione adecuadamente. 3. DE LA CALIDAD TOTAL A LA EXCELENCIA EN LA GESTIÓN Hasta los años sesenta la única forma de Gestión de la Calidad era el Control de Calidad. Durante los años setenta empieza a hablarse de Aseguramiento en la Calidad (“Quality Assurance”), que es definido por la organización ISO como “conjunto de acciones planificadas y sistemáticas necesarias, de carácter operativo, y utilizadas para verificar los requisitos relativos a la calidad del producto o servicio”. La extensión de esta idea a todas las áreas de la empresa, tanto a la parte productiva como de gestión, lleva al concepto de Calidad Total. Desde mediados de los años ochenta el panorama económico internacional se caracteriza por la globalización de los mercados y la aparición de nuevas tecnologías, todo ello crea un clima de competitividad como jamás se había conocido en las empresas. Surge así una nueva tendencia en la gestión de las organizaciones conocida como Excelencia en la Gestión, cuya puesta en marcha requiere un compromiso real de toda la dirección, con implicación de todas las personas involucradas en la empresa. En Europa la Excelencia en la Gestión llega, aproximadamente, una década más tarde que en Estados Unidos. Hata entonces, las empresas europeas adoptan modelos de Aseguramiento de la Calidad como los basados en las normas internacionales ISO 9000 (derivadas de la norma militar británica BS 5750). Estas normas contienen instrucciones y requisitos que debe de satisfacer una organización para demostrar su capacidad en cuanto a suministrar los productos conforme a los requisitos acordados, y han sido uno de los impulsores del nacimiento del concepto de Excelencia. En los últimos años, para ayudar a las empresas y organizaciones en su camino a la Excelencia en la Gestión de la Calidad, han surgido una serie de herramientas como son el Modelo EFQM de Excelencia, el Cuadro de Mando y Seis Sigma. En general, el “Modelo de Excelencia” es un conjunto de criterios agrupados por áreas que sirven de referencia para implementar un plan de Gestión de Calidad que pretende ajustarse a las bases de los grandes premios a la calidad. Así, los modelos más populares son los basados en el Premio Nacional de Calidad de Estados Unidos, conocido como “Malcolm Baldrige”, cuyo nombre hace referencia al Secretario de Comercio impulsor del mismo. El premio Deming es el Premio Nacional a la Calidad en Japón. A nivel europeo, a raíz de la creación en 1988 de la European Foundation for Quality Management (EFQM), se crea, en 1991, el Premio Europeo a la Calidad. Finalmente, el Modelo Iberoamericano de Excelencia a la Gestión es el último en aparecer en 1999. En este año 2003 se está realizando un nueva versión de las bases del Modelo Europeo, que comenzará a utilizarse en las candidaturas al premio de la EFQM del 2004. El Cuadro de Mando es una herramienta para la mejora de la Calidad basada en indicadores estratégicos. Partiendo de una misión (hecha por la organización) y una visión (lo que se quiere convertir) se proponen estrategias que se seguirán mediante indicadores. El modelo conocido como Cuadro de Mando Integral (Balanced Scorecard) utiliza como elemento clave los indicadores estratégicos para el control de los procesos. Seis sigma es sin duda, la herramienta de mayor implantación para la Gestión de la Calidad hoy en día. El término seis sigma, que prima la importancia del control de la variabilidad, es acuñado a mediados de los años ochenta por la empresa Motorola. Esta herramienta tiene una fuerte base estadística y pretende alcanzar unos niveles de calidad en los procesos y productos de 3.4 defectos por millón (de ahí el término seis sigma en referencia a los gráficos de control). La diferencia con otras herramientas anteriores es tener como prioridad las necesidades del cliente y la atención constante a la gestión, mejora y reinvención de los procesos empresariales. La popularidad de Seis Sigma se hizo patente a partir de 1995 por los buenos resultados alcanzados en General Electric. Hoy en día, es una de las herramientas más empleadas en las organizaciones para la Gestión de Calidad. Hace uso de las ideas de la Calidad Total y sobre todo del empleo de métodos estadísticos como el Diagrama de Pareto, el Diseño de Experimentos, los Gráficos de Control o el Análisis Modal de Fallos y Efectos (AMFE). En definitiva, dar una mayor importancia al Control Estadístico de Procesos. 4. ESTUDIO DE LA CALIDAD DE UN MATERIAL COMPUESTO Deseamos estudiar la fatiga de un material compuesto de resina epoxi-carbono (de los utilizados en los barcos de competición, raquetas de tenis, bicicletas, etc.). Partiendo de otros estudios sobre este tipo de material, se tomó la decisión de medir en laboratorio probetas de este material en el que como factores se consideren la inclinación de las fibras de carbono (tomando dos posibles niveles: a 0º y a 90º), otro factor de interés fue el grosor de las probetas (utilizando dos niveles: un primer laminado con 46.6% de fibra de carbono y un segundo laminado con un 49% de fibra); finalmente, otro factor a tener en cuenta fue el someter el compuesto a un postcurado o no someterlo, este postcurado se realizó en una estufa de laboratorio. La respuesta que se midió fue el número de deformaciones hasta la rotura de cada probeta, para lo cual se someten las unidades experimentales a un análisis mecanodinámico (las muestras se someten a una deformación senoidal y se mide el esfuerzo en función del tiempo). Por tanto, la variable respuesta es el número de compresiones (en miles) hasta la rotura de la muestra. Mediante la realización de un experimento factorial con empleo de una matriz de Taguchi, se comparan los factores y se estudian las posibles interacciones y se obtiene el valor que maximiza las compresiones, lo que generaría un valor máximo de la dureza del material a estudio con 97.250 compresiones hasta la rotura, que se obtendrían con la inclinación a 90º y con los valores de grosor grosor del 46.6% y sin postcurado. Finalmente, se llevará a cabo un estudio, mediante gráficos de control de medias, con metodología Seis Sigma, de las propiedades de las planchas del material elaborado. 5. REFERENCIAS Juran, J. .M., (1997). Manual de Control de Calidad . McGrawHill. Montgomery, D. (2001). Introduction to Statistical Quality Control. John Wiley & Sons, Inc. Cavanagh, R., Neuman R. y Pander, P. (2002). Las claves de seis sigma. McGrawHill.