El problema de las condiciones iniciales en los algoritmos de

Anuncio

ESTADISTICA ESPAÑOLA

Vol. 35, Núm. 132, 1993, págs. 141 a 167

EI problema de las condiciones íniciales

en los algoritmos de estimación recursiva

de modelos lineales

SONIA SOTOCA LOPEZ (*)

Departamento de Economía Cuantitativa

Facultad de CC. Económicas y Empresariales

Universidad Complutense de Madrid

RESUMEN

En este artículo se proponen dos soluciones para independizar los

resultados del método de estimación recursiva estándar de la influencia de condiciones iniciales arbitrarias. La primera solución consiste

en utilizar un algoritmo recursivo corregido que descuenta el efecto de

condiciones iniciales elegidas arbitrariamente sobre la estimación final

de los parámetros de un modelo de regresión. La segunda solución

se basa en el us^o de !os filtros basados en la propagación de la matriz

de información en lugar de la matriz de covarianzas. Estos algoritmos

disponen, por su propia naturaleza, de condiciones iniciales exactas y

son robustos numéricamente.

Palabras clave: condiciones iniciales, estimación recursiva, estimador

cresta, matriz de ínformación, estabilidad numérica.

Clasificación AMS: 62J05, 62J07.

(*) Quiero agradecer especialmente a Miguel Jerez por sus interesantes comentarios y

sugerencias. También deseo agradecer los comentarios recibidos de Rafael Flores, Mercedes GraciaDíez, Alfonso Novales, Teodosio Pérez, Gregorio R. Serrano y Daniel Peña. Los comentarios y

sugerencias recibidas de dos evaluadores anónimos han ayudado a mejorar sustancialrnente la

primera versión de este trabajo.

7

, "1 . j

.

INTRODUCCION

Como es bien sabido, el algoritmo de estimación por mínimos cuadrados

recursivos (MCR) es un casa particular del filtro de Kalman (ver, por ejemplo,

Jazwinsky, 1970) y, por consiguiente, un aspecto crucial para su uso es la

elección de condiciones iniciales.

En el contexto de los métodos de estimación recursiva, resulta frecuente utilizar

condiciones iniciales arbitrarias o, a lo sumo, diseñadas de acuerdo con una regla

heurística [ver Young (1984), pág. 27]. Este tipo de criterios ad-hoc puede dar

buenos resultados cuando se dispone de muestras grandes y/o en situaciones

de estimación bien condicionadas. Sin embargo, la práctica econométrica nos

enfrenta a menudo con problemas de estimación mal condicionados (debidos,

por ejemplo, a la presencia de multicolinealidad aproximada) que deben resolverse a partir de muestras muy limitadas. En estos casos, el uso de condiciones

iniciales arbitrarias puede dar lugar a la degradación numérica del proceso

recursivo, haciendo que las es#irnaciones finales del procedimiento no coincidan

con los resultados del método de mínimos cuadrados ordinarios (MCO).

En este ar#ículo se proponen dos soluciones para independizar fos resultados

del criterio MCR de la influencia de condiciones iniciales elegidas ad-hoc: a)

utilizar un algoritmo de estimación MCR corregido (MCRC} y b) utilizar un algoritma de estimación MCR basado en el filtro de la matriz de información [ver

Anderson y Maore (1979}]. EI criterio MCRC descuenta el efecto de condiciones

iniciales elegidas arbitrariamente sobre la estimación final de los parámetros de

un modelo. Este criterio se inicializa también con arbitrariedad, pero cuando se

dispone de cero grados de libertad se Ileva a cabo un paso intermedio de filtrado,

de forrna que los resultados de este filtro intermedio se convierten en las nuevas

condiciones iniciales del algoritmo MCR habitual. EI algoritmo de la matriz de

información puede inicializarse usando condiciones iniciales exactas, proporciona

resultados finales analíticamente idénticos a los del estimador por MCO y su

comportamiento numérico es sumamente estable, incluso en situaciones como

las anteriormente mencionadas.

Es importante señalar que éstas son dos soluciones alternativas. En general,

será preferible el criterio basado en la matriz de información cuando sólo se

requiera la estimación final de los mismos. Por el contrario, cuando sea interesante estudiar la evolución temporal de las estimaciones, es más conveniente

utilizar el método MCRC.

La estructura del artículo es la siguiente:

En el apartada 2, se describe el algoritmo de estimación MCR estándar, basado

en el filtro de Kalman y se demuestra que este método genera estimaciones

comparables a las de una regresión cresta (ridge regression). También, se

L

i^Ít(,.1Cj0. f: ^Ji`1 ^ ^ f

^^1 ) i I` I^^^iI( ,i( 1Í^I ^ `^ I^`JI^ .Jf^^ E:">

^Í`r

^^J^'S r7''^ ( 7'_Jf^i Í"^^, i:, ^)^

^ ^ ^^r"^, I! 1^v ^1^

^ i ^1.,.„:

^

y ^;

t,

1

^ ^^,J

describen las formas de cálculo habituales de las condiciones iniciales del criterio

MCR y se propone un método heurístico para su estimación. Aunque este método

también es arbitrario, evita la degradación numérica del algoritmo recursivo, en

algunos casos. Por último, se Ileva a cabo un análisis de la divergencia existente

entre las estimaciones finales obtenidas con MCR y con MCO.

En el apartado 3, se describen las dos soluciones propuestas al problema de

inicialización del criterio MCR. En primer lugar, se describe el algoritmo de

mínimos cuadrados recursivos corregidos (MCRC), que independiza los resultados del método MCR del efecto de condiciones iniciales. La segunda solución

surge al particularizar el filtro de información para el modelo de regresión líneal

con parámetros constantes, lo que permite obtener fas ecuaciones de un estimador recursivo alternativo (MCRI). Se demuestra que este método puede inicializarse a partir de condiciones iniciales exactas y se argumenta su robustez

numérica.

En el apartado 4 se aplican las tres estrategias de estimación recursiva consideradas a datos simulados. En los ejemplos, se consideran distintos tamaños

muestrales y distintas situaciones de condicionarniento. Por último, en el apartado 5, se resumen las conclusiones más importantes del trabajo.

2.

ESTIMACION RECURSIVA MEDIANTE EL FILTRO DE KALMAN

Sea el modelo de regresión lineal (MRL):

yt=Xi^+

(t - 1,2,...,n)

donde yt es la observación t-ésima de la variable dependiente, xt es un vector

(kx1) que contiene la observación t-ésima de las variabies explicativas, R es un

vector (kx 1) de parámetros desconocidos y^ t es una perturbación aleatoria que

se distribuye idéntica e indepedientemente con esperanza nufa y varianza constante 6?.

Es sabido que la estimación de [1) puede Ilevarse a cabo utilizando MCO con

toda fa muestra o bien recursivamente, aplicando el filtro de Kalman a las dos

ecuaciones siguientes:

Yc = xt ^c + ^c

[2]

^t=^3t-

[3]

en donde (3t representa el vector de parámetros correspondiente a una muestra

de tamaño t y[3^ refleja la hipótesis de parámetros constantes. Desde el punto

de vista de fa formulación en espacio de los estados, [2] es la ecuación de

^ ? r^ ; .

_

rk(

^+ ^

observación del modelo y[3j es la ecuación de estada. Por tanto, desde este

enfoque, !a variable endógena del MRL puede interpretarse como una señal

observable del vector de estado que es, a su vez, el vector de parámetros que

se desea estimar.

Las ecuaciones del estimador por mínimos cuadrados recursivos (MCRK) de

[1], surgen al particularizar el filtro de Kalman para el madelo dado por [2] y[3]

[ver Yaung (1984)]:

^t ^ ^t - ^ + kt E Yc - xi Rt - ^ )

C4]

kt = Vt ._ ^ xt ( xt VI _^ x t+ 1)-'

C5]

Vt =( Ik - kt x; ) Vt _^

C6]

La ecuación [4] indica que la estimación del vector de parámetros se actuaiiza

mediante una función lineal del error de predicción de yt comet'rdo al estimar ^3

con la información disponible hasta el instante t-1. EI factor de ponderación kt,

se conoce coma ganancia del filtro y su expresión figura en [5].

La matriz Vt, propagada a través de [6], es proporcional a!a matriz de covarianzas de los parámetros estimados con la información disponible hasta el

instante t, que denotamos por Pt. Es decir:

Vt = 1 Pt =( X^ Xt )-'

[7]

6?

en dande Xt es una matriz (txk} que recoge, por columnas, la información

muestral de cada variable explicativa hasta el instante t y se supone que

V^' = 0. Si dicha candición inicial no es nula, la relación entre ambas matríces

pasa a ser (ver Apéndice A}:

t

_ ^ ^^ 1 ^ ^ X^ xT ^_1

2.1.

Forrnas de cáiculo de las condiciones iniciales del criterio MCRK

Evidentemente, es necesario inicializar el algoritmo dado por [4]-[^] con unas

^

condiciones iniciales (^30, Vo}. Existen distintas formas de determinar las mismas:

a)

Condiciones iniciales arbitrarias (MCRKa).

b^

Método heurístico de cálculo de las condicianes iniciales (MCRKb).

c}

Condiciones iniciales estimadas por MCU (MCRKc}.

r'F^C.)E3l E M^ C)E LA^, (;(:7^^J^.)I(,Il')f^^JF.`^ li`Ji(.,I^L E^ E f^ ^ t.,^^^ At í^`;(:..^F^11^n^^r 7c., [^)E f:^^^^,^1i^^"F'•t .It^>f^^^ kE (, I)F;^,I^^/A

a)

Í4^)

Condiciones iniciales arbitrarias (MCRKa).

El criterio utilizado habitualmente [ver, entre otros, Young (1984}, pág. 27 y

Harvey (1989), pág. 107), consiste en fijar:

^

Qo= O

[8l

Vo ^ tl k

[^]

donde i es un escalar positivo y arbitrariamente grande.

Las condiciones iniciales [8]-[9], expresan un elevado grado de incertidumbre

acerca de la magnitud y el signo de los parámetros a estimar. Este criterio

^

responde a la idea de que, si no se dispone de información a priori, ^3o es una

variable aleatoria, afectada por una incertidumbre infinita. Obsérvese que las

condiciones [8]-[9) convergen a los dos primeras momentos de esta distribución

cuando i--^ ^. Puesto que el algoritmo MCRKa no puede propagarse comenzando con un valor infinito de T, en la práctica se utiliza un valor finito y arbitrariamente grande.

^

La expresión [4] puede escribirse en función de las condiciones iniciales [3o Y

Vo, de la forma (ver Apéndice A):

^

_

^

_ ^

t

Rt - ^ v0 1 + ^ xi xT )-1 ^ v01 ^0 + ^ xi Yi ^

[ 10]

y teniendo en cuenta [8] y[9], la expresión [10] se reduce a:

^

^t/MCRK

^

_

- ^ ^I k + ^ xi xT ) 1 ^ ^ xi Yi

)

[11]

r

en donde ^= 1/i es un escalar positivo y arbitrariamemente pequeño y[3t/MCRK

denota la estimación obtenida con el criterio MCRKa después de haber procesado t observaciones. La expresión [11] muestra que el estimador MCRKa puede

interpretarse como un estimador cresta (1) [ver Gruber (1990)]. Como es bien

sabido, este estimador es sesgado, aunque su varianza puede ser menor que la

del MCG si se elige adecuadamente la constante ^ que se añade a los elementos

de la diagonal principal de X t Xt. Sin embargo, el problema es que existen infinitos

valores de ^ que cumplen dicha propiedad y no resulta obvio cuál de ellos debe

seleccionarse.

(1) En este trabajo se utiliza «regresión cresta» para traducir la expresión inglesa ridge regression, debido a que es común su uso en la literatura especializada en casteflano. Una alternativa

probablemente más correcta sería hablar de «regresión riscal» como propone el Prof. Azorín.

^^.^F.?

f ^,ra

^^^,r,^^^^^^^ a

Hoel y Kennard (1970) sugieren probar con distintos valores de ^ a partir de

uno que mejore al MCO (es decir, con un error cuadrático medio más pequeño

que la estimación por MCU). Si a partir de un cierto rango de valores, el estimador

cresta no cambia mucho, entonces elegir el valor superior de dicho rango.

Schmidt (1976) propone elegir el valor de ^ que minimice el error cuadrático

medio del estimador cresta. Ei problema de este método es que el valor de ^ que

cumple esta condición no es computable, ya que depende del verdadero valor

del vector desconocido ^3.

Young { 1984) sugiere que un valor de ^ del orden de 1 Q^ es suficiente para

que el estimador MCRKa converga al MCO al final de la muestra. No obstante,

aunque es evidente que [11 ] converge a la expresión MCO cuando ^--^ o, éste

también es un criterio arbitrario. EI estimador cresta es consistente (ver Apéndice

B) y por tanto, para muestras grandes, un valor de ^ del orden que sugiere Young

puede ser suficiente. Sin embargo, para muestras pequeñas, ^ puede no ser una

cantidad despreciable con respecto a X^ Xt, dependiendo de cuál sea el arden

de magnitud de las variables explicativas.

Por otra parte, fa selección del factor ^ sin tener en cuenta la métrica def

problema de estimación, puede dar lugar a la acumulación de errores numéricos

en la propagación de Vt a través de [6]. Esto ocurre, sobre todo, si se escoge un

valar de t demasíado grande. En cambio, si t es excesivamente pequeño, las

condiciones iniciales no recogerían suficientemente la incertidumbre existente a

priori, haciendo que las estimaciones finales de los parámetros sean parecídas

a sus valores iniciales. Es decir, el efecto sería similar a implantar la restricción

de que cada parámetro sea «casi» igual a su condición inicial.

b)

Méfodo heurístico de cá^culo de las condiciones iniciales (MCRKbj

Proponemos un método heurístico más sencillo para elegir ^, consistente en

comparar la métrica de las matrices X t Xt y^Ik. ba escala de X t Xt puede medirse

por su traza o por una norma de dicha matriz. En ambos casos, se puede fijar

una tolerancia ^ tan pequeña como se quiera, de forma que:

< ^.

^

tr(XtXt)

[12]

o bien:

_

_ ^_

_

IlxtXtll2

< r:

[ 13]

^^ ^ E^FZ^.^^ii E^:r^A ^^E^^ ^ n^ ^,^ ^^,r^^C^i^^

IC)^,lE^ `^ IPJIC;IAC E `^i t^ rJ l C1`^ Al (. ^t ?^f ?^^' ^:`-, iJE E^

^ i^^^a^ :^^^_^r. ^^E^ ^^ ^ ^^^^^^^^r^^^^^

14 ^^l

^ + a2z

^ + ... + a^

SlendO (I XTt X tll 2=^ a^,

kk )'^ y a„ ( i= 1, ..., k) los elementos de

la diagonal principal de X t Xt.

Fijado ^, puede encontrarse el valor de t que hace que el estimador MCRK de

[i tienda al estimador MCO con toda la muestra. De esta forma, si el valor de T

es demasiado grande, lo cual podría dar lugar a la degradación numérica del

algoritmo, puede fijarse un valor de z más pequeño y buscar un factor de escala

adecuado para las variables independientes del modelo. EI inconveniente de este

método es que exige procesar toda la muestra para medir el tamaño de la matriz

X t Xt o, en su caso, para escalar adecuadamente los datos de las variables

explicativas, con lo que se desvirtúa el interés por la recursividad del algoritmo

MCRK. No obstante, aunque este método no resuelve el problema de la arbitrariedad de las condiciones iniciales, permite acotar los valores del factor z que

evitan la inestabilidad numérica del algoritmo.

Otra posible solución consistiría en utilizar alguna normalización de la matriz

X t Xt como por ejemplo, estandarizar los órdenes de magnitud de sus elementos.

Esta normalización reduciría el orden de magnitud de los datos y, por consiguiente, los posibles errores numéricos.

c)

Condiciones iniciales estimadas por MCO (MCRKc)

Otra posibilidad ya conocida en la literatura para conseguir condiciones iniciales del algoritmo recursivo, consiste en utilizar parte de la información muestral

disponible para su estimación. En concreto, se usan las k primeras observaciones

para inicializar el filtro:

^

NO ^( X k X k^-1 X k Yk

[ ^ 4^

Es decir, se obtiene una pr^mera estimación del vector ^3 aplicando MCO con

un grado de libertad y se actualiza la estimación de Pste vector de parámetros

para t= k+1, ..., n. La desventaja de este método consiste en que, de nuevo, se

desvirtúa la recursividad del procedimiento MCRK y no se obtiene una estimación

recursiva de los parámetros para las primeras k observaciones.

2.2.

Análisis de la divergencia entre las estimaciones finales obtenidas

con MCRKa y MCO

A partir de [11 ] y la expresión del estimador MCO es fácil ver que, una vez

procesada una muestra de tamaño t, la diferencia resultante en las estimaciones

,

"-^^^?A_P^^t' )^ A

obtenidas con los algoritmos McRKa y MCC^, depende exclusivamente de! tamaña de una matriz W^, definida como:

W^ = (^i^+ XtXc)^^ -- (XrXt)^'

[16]

Lema 1

^a traza de la matriz Wt, es una funcián creciente del tamaño del escalar T.

Demostración

Sea la factorización de la matriz X t X

[ 17]

Xi Xt = M ^ Z MT

donde S2 es una matriz diagonal que contiene los autovalores de X t X t y M es

una rnatriz ortogonal que contiene por columnas los autovectores de X; X t. Esta

factorización siempre existe al ser Xi X t una matriz definida positiva.

Puesto que las rnatrices ( X t X t)^' y(^I + X i X t)^' tienen los mismos autovectores (ver Schmidt, 1976), es fácil demostrar que Wt puede factorizarse de la

forma:

= M[(^I+SZ)-^-SZ^']MT = Mdiag

C ^^ ^ ^,; ^+- ^ ,

] MT

^ , 8,

donde ^,; es el autovalor i-ésimo de la matriz X t X t y el escalar [-- ^,,/^; (^; +^)] el

autovalor i-ésirno de la matriz diferencia Wt, siendo ésta definida negativa [la

matriz Wt es definida negativa si y sólo sí ( X i Xt )-(^I + X t X^ ) es definida

negativa].

A partir de [18], la traza de Wt es:

^

<0

tr ( Wt ) - _ ^

^' ^^(^r+^)

[1 g]

y derivando [19] con respecto al escalar ^, se obtiene:

^^tr ( Wt ) _ _ ^

1 _

^ - ^ ( ^,^ -^- ^ )^

r^^

[20]

^^,^^^F1^ E nna i^E^^ ^ a^^> ^ ^,^ 7r^r^i^^^^ ir^ir^^F ^-, ^r^^^ ;aA^_^^ ^^> E^,

( )^j

^a,l

^.i^;^^r^f ^^^ : ^

f f ^...aTl^4^ ^

^(. ^^.)^i

14y

El signo negativo de la derivada en [20] indica que, a medida que disminuye

el valor de ^(o bien, a medida que aumenta el valor del escalar t), aumenta el

tamaño de la matriz Wt. ^

Lema

Si algún autovalor de X i X t converge hacia cero, entonces tr(Wt) ---^ -^.

Demostración

Directamente de la expresión [19]. ^

Las implicaciones de estos dos lemas son inmediatas. EI Lema 1 establece

que la diferencia entre los resultados de las estimaciones MCRKa y MCO es una

función directa def tamaño del factor T. Por consiguiente, si no se dispone de

suficientes datos, la diferencia entre ambas estimaciones puede ser sustancial.

Por otra parte, según el Lema 2, el mal condicionamiento de la matriz X t X t afecta

directa y positivamente a la magnitud de la matriz Wt. Es decir, en las situaciones

en que exista un cierto grado de multicolinealidad, el estimador MCRKa puede

dar resultados muy diferentes a los de MCO.

3.

SOLUCIONES AL PROBLEMA DE CONDICIONES INICIALES EN EL

CRITERIO MCRKa

En este apartado se plantean dos métodos que permiten resolver el problema

de degradación de los resultados de MCRKa en presencia de colinealidad o

cuando la muestra es pequeña.

3.1.

Estimación mediante mínimos cuadrados recursivos corregidos

(MCRC)

Como se ha visto en el apartado 2, el algoritmo MCRKa inicializado arbitrariamente genera estimaciones comparables a una regresión cresta. En este sentido,

no está garantizada la convergencia del estimador MCRKa a su expresión MCO,

una vez procesada toda la muestra.

La idea que se propone para resolver este problema es la siguiente. Las

condiciones iniciales del tipo [8] y[9] pueden interpretarse como el resultado de

aplicar MCO a una muestra ficticia que forma el conjunto de información denotado

^^ f - G"^ ., ' ,^ r i

por I^^. Las observaciones que generan las estimaciones de ^3° y V° dadas por [8]

y [9], son ias siguientes:

Y° ^ 0

X ° --

1

yt

[21 ]

donde y° es un vectar (kx 1) que contiene las observaciones muestrales formadas

por el vector (y___k, y_^^+^ j, ..., y_^)T y x° es una matriz ( kxk) que contiene por

columnas la información muestral ficticia de las k variables explicativas del

modelo. Es decir, si denotamos por x° la columna j-ésima de X°, el vector xoT

.

estara armado por los elementos (x_k^, x__^k+^^^, ..., x_^^).

Dada la información representada por [21] es fácil ver que la estimación MCO

del vector [3 del MRL será:

NO =( X°T X° )i ^ X°T y° = O

V° _

^ XOT X° )

- TI

[22]

[23]

Por tanto, si las condiciones iniciales dadas en [8] y[9] provienen de procesar

el conjunto de inforrnación I°, la idea sería eliminar el efecto que esas observaciones ficticias tienen sobre las estimaciones MCRKa cuando se han procesado

k observaciones reales.

En resumen, para independizar el criterio MCRKa de la influencia de las

condiciones iniciales [81 y[9], pueden Ilevarse a cabo los siguientes pasos:

1)

Inicializar el algoritmo MCRKa con condiciones iniciales arbitrarias del tipo

[8] y[9] hasta el instante t=k (es decir, hasta disponer de cero grados de

libertad):

`dt = 1,2,...,k

2)

k t= Vt _^ xt ( x^ Vt _^ x^ + 1}^^

[24]

[^t = ^t--^ + kt ( Yt - xi Qc-^ )

[25]

Vt ={ I-- k t xt ) Vt__^ ( i-- k t x^ )T + k t k t

[26]

Eliminar el efecto del conjunto de información I° sobre la estimación [3k.

Para ello, se pueden utilizar las siguientes ecuaciones de corrección (2)

[ver Young ( 1984), p. 60]:

(2) Estas ecuaciones eiiminan de ia estimación final de los parámetros el efecto de una o varias

observaciones. Por ejemplo, podrían usarse para descontar el efecto de posibles observaciones

atípicas y/o influyentes. La aplicación de este filtro en nuestro contexto supone considerar como

influyentes las observaciones que generarian condiciones iniciales arbitrarias. Puede encontrarse una

demostración de las ecuaciones [27]-[29] en el Apéndice C.

f l

f'fl^ lfil f ti^^<', Ut L^`.

!)^J[i^^ ^r^f^t ., ^('^f( JAl E

^, r ^',, ^, ^ ^, ^ ^ ^^' ; ,

f!s = k+1, k+2, . .., k+k

kk = Vk Xk_s ( Xk_s Vk Xk_s

- 1^-1

r^^

_ "

T

k-^k + kk ^ yk-s ! xk-s h'k ^

kk Xk S ) Vk

3)

[28]

[29]

Utilizar las estimaciones ^k y Vk^ como condiciones iniciales del algoritmo recursivo [24]-[26], b't = k+1, k+2, ..., n.

Por tanto, esta estrategia supone I{evar a cabo un paso intermedio de filtrado

en el instante t=k. EI filtro dado por las ecuaciones [27]-[29], descuenta el efecto

de cada una de las observaciones ficticias generadas por las condiciones iniciales

[8]-[9], sobre la estimación de los parámetros obtenida hasta ese momento. Los

resultados de ese filtro intermedio se convierten en las nuevas condiciones

iniciales del algoritmo MCRKa habitual. La originalidad y ventaja de este procedimiento consiste en poder calcular recursivamente unas condiciones iniciales

que coinciden con la estimación MCO de [i resultante al procesar las primeras k

observaciones de la muestra.

Lema 3

Es fácil demostrar que después de propagar las ecuaciones [27], [28] y[29],

el estimador corregido ^k coincide con su expresión MCO para una rnuestra de

tamaño k.

Demostración

Escribiendo la ecuación [29] de la forma:

Uk Vk ^- I- kk xk-s

[30]

y como yk_S = 0 para s = k+1, k+2, ..,, k+k, la expresión [28] pasa a ser:

F^k

^ Vk Vk 1 ^k

[31 ]

Como se demuestra en el Apéndice A, la matriz Vt en el instante t=k tiene la

siguiente retación con su condición inicial:

k

Vk =( Vp ^+ ^ Xi XT )^^

[32]

C: `i r I i t} M`':; T i Í„^ ^ ~s ^^^^ ^ i {) l. r,`

1^)^;`^

y el correspondiente estimador de ^3 usando las primeras k observaciones:

k

M

^k = ^ vp-1 + ^ xi XT ^ _ 1 ^ ^0 ^ RO -}- ^ xi yi ^

^

1

^

[33]

1

en donde las condiciones iniciales son de la forma:

Vó1 = t^f

^

^o=o

[34]

Sustituyendo [33] en [31] y teniendo en cuenta [34], se obtiene:

k

^k - Vk ^

[35]

Xi yi

Por otro lado, sustituyendo [27] en [29] y aplicando el lema de inversión de

matrices a la expresión resultante se obtiene:

-1

*

1

T

Vk -^ Uk - Xk-s Xk-s ^

-1

T

T

1

k

-^ VO +^ Xi xi - xk-s Xk-s ^

^^ i

b' s= k+ 1, k+2, ..., k+k

[36]

Por tanto:

+ ^ xi XT - xk-s xk-s )-1 , ( ^ Xi yi ^

b` s= k+1, k+2,..., k+k

[37]

y teniendo en cuenta [21 ], una vez propagadas las ecuaciones de corrección se

obtiene:

^k - ^^ xixT ^ -1 ^^ xiyiÍ

^,

[38]

^=^

que coincide con la expresión del estimador MCO cuando se han procesado fas

k primeras observaciones. ^

La demostración anterior pone de manifiesto que la efección del escalar T en

el paso (1 } def algoritmo puede ser arbitraria. Es decir, sea cual sea el valor

elegido, en el paso (2) se descuenta el efecto de dicho escalar sobre la estimación de (3 usando k observaciones, asegurando que al final de ta muestra el

f^ l F'kC^)f3l EMA C.)f l_A5 C^.C)P^^C^)I(^..I(;)(^^1F^`^^ fNl(^.:I^,l._E^ `^ E^ l (^) 5 Al (;C^^!T^"^^"t.^^i`^, (^ ^ E

f^^;T^+h^/IA^^^^ICaPJ F?^-^:^:i ^4^^4^^aA

estimador obtenido coincide con el MCO. Por supuesto, lo más sencillo sería

hacerlo igual a uno (3).

3.2.

Estimación recursiva mediante el filtro de la matriz de informac^ón

(MCRI)

EI filtro de información se obtiene aplicando el lema de inversión de matrices

a las ecuaciones del filtro de Kalman [ver Anderson y Moore (1979), p. 138]. Por

tanto, ambos filtros son algebraicamente equivalentes. Las ventajas del filtro de

información con respecto al criterio MCRKa son dos:

1)

Permite instrumentar exactamente las condiciones iníciales que se aproximan en el filtro de Kalman mediante Vo = tl.

2)

Las matrices del filtro se propagan de forma estable a partir de las condiciones iniciales.

EI filtro de información propaga la inversa de Vt y un vector de estado ( at )

que es combinación lineal de los elementos del vector de estado original ( Rt ).

Las condiciones iniciales de este algoritmo son siempre:

[39]

V^' - 0

-o

y las ecuaciones del filtro de información particularizadas para el modelo dado

por [2]-[3], son las siguientes:

Vt"^ = Vt-i + xt xt

[41 ]

^

a*t _

C^2]

+ xt Yt

donde el vector de estimaciones de los parámetros originales del modelo se

recupera mediante la relación:

^

,^

^

a t= Ut- ^t

n

n ..

^ ^t = Uc a t

C^3]

(3) En la aplicación hecha con datos simulados (ver Apartado 4) se ha preferido utilizar un valor

de t= 106 porque es el que sugiere como adecuado, en general, Young (1984, p.27).

,^

.) I ^^^i.li:,.i i ii .l1 ,

1F

LA^^^^I

Escribiendo las ecuaciones [41 ] y[42] en función de las condiciones iniciales [39]

y [40J, se obtiene:

vt--1

^

^ vó 1+ ^ X' xT

[44]

,,

t

á t= á ó+^ x^ Y^

,,

[45]

y sustituyendo [39], [40], [44] y[45] en [43], resulta:

Rt MCRI ^ Í^ x^ xT )!' c^ x^ y^ )

^

^

^

dt = ñ, k+ ^,...,

n

[46]

^

en donde Rt McR, denota la estimación de ^i obtenida con el criterio MCRI, cuando

se han procesado t observaciones. La expresión [46] coincide exactamente con

la del estimador MCO para una muestra de tamaño t. Esto prueba la independencia del fiitro de información de las condiciones iniciales. La robusted nurnérica

del filtro surge al propagar la matriz de información como una suma de matrices

definidas positivas [ver (44}]. Además, el estimador MCRI es analíticamente

idéntico a la expresión MCO.

La desventaja de este método con respecto a MCRKa y MCRC es que para

recuperar la evolución de los parámetros originales, es necesario utilizar la

relación [43] que supone invertir la matriz de información cada vez que se añade

un nuevo dato.

Por último, cuando la matriz de regresión está mal condicionada pueden

utilizarse los Ilamados algoritmos de la raíz cuadrada de la matriz de covarianzas

o de la raíz cuadrada de la matriz de infarmación. Estos métodos se basan en

propagar una factorización de la matriz de covarianzas o de la matriz de información en lugar de las propias matrices. Las principales ventajas de los algoritmos de la raíz cuadrada son básicamente dos: 1) el cálculo de la matriz de

covarianzas o de la matriz de información a partir de su factorización nunca puede

Ilevar a una matriz no definida positiva y 2) la raíz cuadrada de una matriz de

covarianzas siempre está mejor condicionada que la propia matriz. La única

desventaja de estos métodos está en la mayor carga computacional que supone

su instrumentación en la práctica, aunque esto también dependerá de las dimensiones del problerna en concreto. Un estudio detallado de los algoritmos de la

raíz cuadrada puede verse en Bierman (1977) y Anderson y Moore (1979).

i l f'F^()fii E MF^ [)t l A; ^ ^ ^: 1fJUlí _ ^t j^df ,^, IPJI( .IAI E- `a E ^^ , t )^; :{l ,': ,f.'.+' "^"^ ^^

4.

.,^t

E °^T I"^-^t;r, ^rt 1^^ ^.,E ^ ^ Ef'^ ','. ;,

1 ^^^)

RESULTADOS EMPIRICOS CON DATOS SIMULADOS

En este apartado se ilustran los resultados teóricos de los apartadas anteriores,

utilizando datos simulados. En concreto, se han aplicado los criterios de estimación

MCRKa, MCRI y MCRC a dos modelos: el primero bien eondicionado (rnodelo I) y

el segundo mal condicionado (modelo II), para distintos tamaños muestrales.

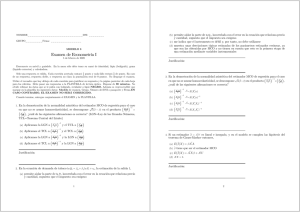

En la Tabla 1 se presentan los resultados de la estimación del modelo 1

mediante MCRKa, MCRI y MCRC. Los valores entre paréntesis son las desviaciones tipicas de las distribuciones empíricas. En la segunda calurnna de la

Tabla, se ofrece el número de condición de la matriz X t X t para los distintos

tamaños muestrales considerados. Este número es, en todos los casos, del orden

de magnitud de la unidad, lo que indica el buen condicionamiento del modelo.

A la vista de los resultados, puede concluirse que, con cualquiera de los t^es

procedimientos recursivos utilizados, a medida que aumenta el tamaño muestral, el

valor medio de las estimaciones finales se acerca cada vez más a su correspondiente valor teórico. Sin embargo, independientemente del tamaño muestral, el error

cometido (4) al estimar cualquier parámetro con MCRKa es siempre mayor que el

correspondiente a MCRI y MCRC. Además se observa que, para todas las muestras

consideradas, los resultados obtenidos con MCRI convergen numéricamente a los

obtenidos con MCRC. Es decir, el algoritmo MCRC realmente corrige el efecta de

condiciones iniciales arbitrarias [T = 106, como sugiere Young, (1984)] sobre el valor

final de las estimaciones, haciendo que éstas convergan a la MCO.

En la Tabla 2 se presentan los resultados de la simulación del modelo II. En

este caso, el número de condición de la matriz X t X t es del orden de 104. Este

modelo se ha generado incluyendo un término cons#ante y dos variables exógenas que evolucionan de acuerdo con la siguiente relación:

XZt = ZX3t + Ft dt = ^, ^ , .. .,11

donde ^t y x3t son procesos ruido blanco independientes entre si y el ratio

señal/ruido de esa relación es de 5.03.

En primer lugar, se observa que 1os algoritmos MCRKa, MCRI y MCRC estiman

adecuadamente el término c©nstante. Sin embargo, el error cometido en la

estimación de los parámetros asociados a las variables correlacionadas es siempre superior con M^RKa que con los otros dos procedimientos recursivos, tendiendo a cero más despacio que al utilizar MCRI y/o MCRC. AI comparar los

resultados de los criterios MCRI y MCRC, se aprecia, de nuevo, la convergencia

numérica de las estimaciones finales obtenidas con ambos procedimientos.

(4) Error en términos de la desviación entre el promedio de las estimaciones y el verdadero valor

del parámetro.

i w^,^)!S1lC C, E `>L'in^J+^.1^ ^^

^^

U^

^^

^^

^

<^i

lf^ ^

Q) ^

^•rO ^

^f

C7^

N

©

^

^

rCj

^- ^

© ^,.

^? ^-O©

N Q

O ^

C^r? p

O^j

^O

Cr?

O

ca a^

C° ^

ca

óc^

ao ^

^°'

^t ^

voo

^

c^©

ao Ó

tió

óc^

O ó

^á

óc^

ti.i

c^c^

v

^..^

^..^

^

^

p

0

^.i

^

N

.^.

^

^

^,.

O

N

C

O

t^

w

,.-..

,-,

,-^

Ñ

^-

CO ©

^ r-

C^

Ó

,.r-

C^ ©

._..

f

^

^

d- O

C^ G^

..^

N

^ CD

^ C'^

Ó C>

._.

^(M

d' O

C^ Ó

._,^

CD

^

.-,

<^

.. °i

-^-

,-..

CO

.^

0

m

^ c^.

M

^, ^

^ U

< ci

^^

lf') ^

1` ^

O^ ^

d`

Ñ r``

^

0 ^

N^

^

© 0

M^

^-^ ^

Mp ~`

O

o ^

M^

O

^ 0

GO GO

OiD N

^ M

p O

^ rn

a^o o

^ O

c.^o Ñ

cic^

^

óó

^

c^c^

^

©c^

^

óc^

^

.--.

.-

<r.^.

(.N

O N

^t rc^ó

._..

O')

<^i

.^

^ Ó

CO

^r ró©

..^

a^o ó

.-^

1^-

^

v o

oò

...,

^ ó

,--^

.^

M

^ CD

^t o

c^ó

t.,

~

O p

o0 ^

^ ^

oó

c^^

^ó

oó

^ó

ó^

N©

o^

Ñ

CT

M

^ o

oc^

..^

^f 3

^

N`^

o

©^

v

^

0

=v

^

O

^

a

^

^

^

a^

^,

<^

M^

•-a

c^o

^../

<^

a0 ^t7

^-o

0ó

V

^^

r^o

oc^

\../

04 C^

^ f`

f^

^ ó

óc^

.^

^ á

c^c^

^...

Ñ ó

c^c^

.....

N

Ó M

^.no

ó0

\^'

^ M

coo

0ó

`^I

N N

O)

^c i ó

óó

^...

o

d-, ó

0ó

...^

o

^

=

^

^

m

N

^,

^

^

j

^U

_

^

^

^

^

^

C

.^

^

o

.^

-^+_•

^

^v

c

o

c

^Ó

v^

^

N

^

^^

^

.o

^

^

^ ^

^

'>

X ó ^

^

T

V

` ^^ ,O

^ ^ •V

(`^O

E^E

C

^

^ ^ ^

^

^ ^ .^

^ o ,^

.^ ^; ó^^

•^ co .^

^ Ñ

^U

^ ^

,^

^ ^

^

ó. ^ ° ó ^a

^

^

.-^

cN

^

r=

^

O

^

ch

°

°

ó

ó

ó

^

U

M

z

z

^ ^ ^ ^ ^

^ ^ o ,^ 0

cn ^^ ^^ =

c^a co ^ ^ i.L

^ = Y

v co

^- •z ^ fY

^ U U

ó ^ Z Z ^ ^

z « ^ ^ « * ^

E l F:,^1^..7E31 E: r^1^ [)E: l As ^;^')N(.:)ic :IC)NE ^^ ^ rdl(,^^^1 E^; E N I ^'^^ a

<^

^

Cfl

^

^--

^ C j

^ l ^

^

Ñ

M

^

O^

O Ó

N

^ O

© O

^ O

© O

^- p

LY ^

r„

00 CD

^

c^ ó

00

M

^7 f-

Q^

M

co ó

r^ o

óó

...^

o©

o 0

^.n o

c^ó

..^

oó

0 0

u^ o

óó

.^

0ó

0 0

^n o

c^ó

...^

0ó

0 0

^.n o

óó

^.

oc^

0 0

^n o

óó

....

r^ ^

c^ ^

cn ^

r- ^

rn^

^. N

O 0

^ ^

O Q

M ©

O ^

M Ó

O 0

N Ó

O ^

.^--r

00 ^--

^t

O d^

r- o

^

^

OO Ñ

CO ^

^©

0 0

.....

0 0

....

0 0

`.

0 0

.^-

<^i

0ó

° ó

^n

ó ^

ó

oc^

^n ó

°

c^ ó

.._.

oó

°

^r^ ó

c^ c^

.^

0ó

^n ó

°

c^ ó

....

0ó

^n ó

o

ó ó

`..'

<^i

r-ci^

° ó

0ó

`^ci

° ó

0ó

`^á

° ó

0ó

°cv

° ó

o^;

CO^

`^ ó

oó

r- ^

o

ó

o á^

o

_ ó

M

Ó Ó

O Ó

^ Ó

N O

M ^

c^ó

^

ór^

......

óó

^

c^ó

.^

óc^

^..^

ó ó

^n o

c^o

^

ó ó

^n o

óc^

^

ó ©

^n o

óó

^

ó á

^n o

óó

^

ó ó

^n o

óó

^

O

_

^

<i

^^

Y ó

<^i

<^i

^-^•

N

M

.-^

O

r^ o

óó

^.

^^-

r^. o

c^ó

....

<cYi

^^

v^

^

00

.--

..-^..

^

^-•.

O ^--

M

OO

M

^

Ñ

U

Lf ')

^

t^-

O^

a0

z

M

M

r-

CD

07

N

N

N

Ñ

N

°

^n

°

ó

^y

o

°

o

L

z

Ó

r- o

óó

^..,

^

<a.

U O

r^. rn

^

j

r- o

óó

.^

<c^,.

r^^

R6?4r+^)^; f^,f E `^TIr^1r+(

^t

d O

U^

, ;(

M

,^>r^^ F^^^ r ^^F^;^^,^^^^^t•

1..5 7

E L ^h(.áHt._f.MA DE LA^ ^1C^NOIC^I(^NES INICIALES E^N l.C^)S ALC,(,^)RITM(^}^-, i^E:^ E.ST^M^C;IC)N REC.UR^^^IVA

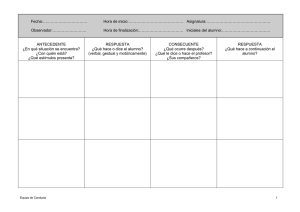

TAB LA 4

ECM resultantes de la estimación del parámetro ^iz

del modelo I con los criterios MCRKa, MCRI y MCRC

^

ECM( ^i2 >

N

30

50

100

200

500

MCRKa

MCRi

MCRC

0.439

0.386

0.184

0,087

0.019

0.065

0.049

o.os5

0.011

0.011

0.004

0.004

0.002

0.049

0.002

TAB LA 5

EC M resultantes de la estimación del parámetro R3

del modeto I con los criterios MCRKa, MCRI y MCRC

^

ECM( ^3^ )

N

30

50

100

200

500

MCRC

MCRKa

MCRi

0.046

0.041

0.018

0.010

0.003

0.029

0.029

0.024

0.024

0.013

0.006

0.002

0.014

0.006

0.002

TABLA 6

EC M resultantes de la estimación del parámetro R2

del modelo 11 con los criterios MCRKa, M C RI y MC RC

^

ECM( ^32 )

N

30

50

100

200

500

MCRKa

MCRI

MCRC

0.568

0.534

0.463

0.350

0.184

0.269

0.185

0.040

0.022

0.008

0.004

0.003

0.002

a.oo1

0.000

^^^

1k1(if.`;T C i

AP^' ij, ^^

TABLA 7

ECM resultantes de la estimación del parámetro (33

del modelo II con los criterios MCRKa, MCRI y MCRC

^

ECM( ^3^ ^

N

.

30

50

^oo

Zoo

500

5.

MCRKa

MCRI

0.087

0.088

0.079

0.062

0.067

0.044

0.009

0.046

0.058

o.oa4

0.031

0.002

0.005

0.002

MCRC

0.010

CONCLUSIONES

Las principales conclusiones del trabajo son las siguientes:

En un procedimiento recursivo, la estimación final de los parámetros puede

depender mucho de las condiciones iniciaies. Sin embargo, en la mayoría

de las aplicaciones económicas, apenas se cuen#a con información acerca

de los valores de los parámetros, por lo que las condiciones iniciales suelen

ser arbitrarias. Par esta razón, conviene utilizar algoritmos para los que se

disponga de condiciones iniciales exactas, como es el caso del criterio MCRI

o bien, algoritrnos que elirninen de alguna forma la influencia de condiciones

iniciales arbitrarias sobre la estimación final de los parámetros, como es el

caso del método MCRC.

La estimación recursiva es particularmente sensible a errores de redondeo

que se acumulan en el proceso recursivo y pueden Ilegar a invalidar los

resultados. Por ello, la estabilidad numérica debe ser un aspecta crucial a

la hora de elegir un algoritmo de estimación recursiva. EI algoritmo MCRI

es robusto numéricamente, mientras que el método MCRKa tiene problemas numéricas en situaciones que se presentan habitualmente en la práctica econométrica.

Se ha demostrado que el estimador MCRKa puede interpretarse como un

estimador cresta, mientras que el estimador MCRI coincide analíticamente

c©n el MCO. Por tanto, bajo las hipótesis habituales, el estimador MCRKa

es sesgado aunque consistente mientras que el MCRI es insesgado.

Se ha demostrado también que la divergencia entre las estimaciones finales

obtenidas con MCRKa y MCRI, depende exclusivamente de la magnitud de

una matriz denotada como Wt. EI tamaño de Wt (medido por su traza) es

2taE^l 4 M^ f^E L A`^ i,C ^N()I^ ,I^ )P^E ^ il^Jl(.IF{I F^ E hJ t^^^^, ,^,1 ^,`^iF;^,l r".^^ .^^, t;F E^,? i"J!^1^

'r

,P^ ^.^f ^ i^k1__^

A

tanto mayor cuanto peor condicionada esté la matriz X^ X, y cuanto mayor

sea el escalar que se añade a la diagonal principal de la misrna en las

condiciones iniciales estándar del método MCRKa.

Los resultados con datos simulados muestran que, incluso para muestras

suficientemente grandes y problemas bien condicionados, pueden producirse sesgos importantes en la estimación MCRKa. Sin embargo, independientemente del tamaño muestral disponible, el estimador MCRI proporciona

siempre estimaciones finales de los parámetros que coinciden exactamente

con los resultados obtenidos con MCO. Por otra parte, el estimador MCRC

genera estimaciones finales que convergen numéricamente a los obtenidos

con MCRI/MCO.

Si existe una gran incertidumbre inicial acerca del valor de los parámetros

y sólo se desea la estimación finai de los mismos, la mejor alternativa para

estimarlos recursivamente será MCRI. La razón es que este criterio presenta

importantes ventajas frente al algoritmo MCRKa: 1) independencia de condiciones iniciales, 2) su robusted numérica y 3) la convergencia exacta de

sus resultados finales a los obtenidos con MCO para toda la muestra.

Cuanda tenga interés estudiar la senda de evolución de los parámetros

estimados, así como su matriz de covarianzas en cada instante, puede ser

más conveniente utilizar el criterio MCRC. Este criterio tiene la ventaja, con

respecto al MCRI, de que no requiere invertir la matriz de información en

cada punto muestral para obtener el correspondiente vector de parámetros

asociados.

Por último, los métodos MCRKa y MCR1 pueden combinarse. Asi, es posible

utilizar el criterio MCRI para obtener condiciones iniciales estimadas por

MCO con un grado de libertad y después, actualizar las estimaciones de los

parámetros con MCRKa.

BIBLIOGRAFIA

ANDERSON, B. D. O. y MooRE, J. B. (1979). «Optimal filtering». Prentice-Hall, Inc.,

Englewood Cliffs, N.J.

ANDERSON, J. E. (1981). «Ridge estimation of house value deterrninants». Journal

of Urban Economics, n.° 9, 286-297.

BIERMAN, G. J. (1977). «Factorization methods for discrete sequential estimation».

Mathematics in Science and Engineering, 128, Academic Press, Inc., Califarnia.

164

E.^TAC)I;,11C;A E ^K'Fi^^(il A

BocK, M. E. (1975). «Minimax estimators of the mean of a rnultivariate distribution». Annals of Statistics, n.° 3, 209-218.

COOLEY, T. F., ROSENBERG, B. y WALL, K. D. (1977). «A note on optimal smoothing

for time varying coeffcient problems». Annals of Economic and Social measurerner^t, 6, n.° 4, 453-456.

GARBADE, K. (1977). «Two methods for examining the stability of regression

coefficients». Journal of the American Statistical Association, 72, n.° 357,

54-63.

GRUBER, M. H. J. (1990). «Regression estimators. A comparative study». Academic Press, INC., New York.

HARVEY, A. C. (1989). «Forecasting, structural tíme seríes models and the Kaiman

fiiter». University Press, Cambridge.

HOERL, A. E. j/ KENNARD, R. W. (1970). c<Ridge regression: biased estimation of

nonorthogonal problems». Technametrics, 12, 55-67.

.IAZW(NSKY, A. H. (1970}. «Stochastic Processes and Filtering Theory». Academic

Press, New York.

LJUNG, S. y LJUNG, L. (1985). «Error propagation properties of recursive least-squares adaptation algorithms». Automatica, 21, 157-167.

MARQUARDT, D. W. y SNEE, R. D. (1975). «Ridge regression in practice». American

Statistician, n .° 29, 3-20.

SCHMIDT, P. (1976). «Econometrics». Marcel Dekker, Inc., New York.

YouNG, P. (1984). «Recursive estimation and time-series analysis. An introduction». Springer-Verlag, Heidelberg.

APENDICE A

La expresión [10] puede demostrarse por inducción. En el instante t=1, la

ecuación [4] puede escribirse como:

[A.1 ]

^1 =( i-- k^ xi ) Ro + k1 Y1

Teniendo en cuenta que k1 = V^ x1 y ( I- k^ x^ )= V^ V^ 1, la expresíón [A.1 ]

queda como:

Í^1

= U1 VO 1 ^0 +

^✓ 1 x1 Y1 = V1 ( Vó ^ ^a +

x1Y1

)

[A.2]

^

_

F^l F^'f^C^)HIE-MA C.^E L_A5 C..'^)NC)IC^IC^)NES INIC^IAI_E^S E^N L(JS Al_GC^>F^ITM^.)S GE E.SI^IMAC::IUh^ kEC:UF^SIVA

_

__

__

__

__ . _

_-.

____

__

_ __ _ _

-- _

_

.

^,

_

Sustituyendo [5] en [6] y particularizando en el instante t=1, se obtiene:

[A.3]

V1 = Vp - Vp x1 ( X^ Vp X1 -^- 1)^1 X^ Vp

y aplicando el lema de inversión de matrices a la expresión [A.3]:

[A.^]

X1 X^ )-1

V1 =- ( V^ 1-f-

Por tanto, [A.2] se convierte en:

P^ _ ( V^ ^ + x ^ Xi )-^ ( Vó ^ ^o+ Xi Y ^)

^A-5^

En el i nstante t=2 , la ecuación [4] será :

^

g

(32 =( I - kz x 2 ) P^ + k2 y2 = Vz V^' ( V^ V^ '

^ + V^ x^ y^ )+ V2 x2 y2

[A.6]

= V s ( Vó' ^o + X1 Y^ + X2 Y2 )

donde:

V2 =( V^ 1+ x2 x2 )-1 =( V^ 1+ x1 x^ + x2 x2 )-1

[A.7]

y por tanto, [A.6] queda como:

1^2 =( V^ ^+ x^ x^ + x2 X2 )-^ ( Vó ^^o + Xi Y^ + Xz Yz )

Luego, por inducción, después de haber procesado t observaciones, se obtendrá

que:

.

^

_

_

Rt = ( V01 + ^ xi xi )^1 ( V01 ^0 + ^ xi Yi )

Otra forma de demostrar [10] consiste en utilizar ei resultado de que las

ecuaciones del algoritmo MCRKa son algebraicamente equivalentes a las del

MCRI. De este último filtro sabemos que ^= Vt ^t y sustituyendo [41 ] y[42] en

la expresión anterior, se obtiene:

^

^

Rt

=( VÓ 1+ ^ xi xT )-1 ( áó +^ xi Yi )

^

^

^.^

o bien:

^

Rt

^

^

-( VO 1+ ^ xi xT )-1 ( V0 1 RO +^ xi Yi ) ■

,-:^

^_i

.

^

.

^

k :; I C,t.j^^^' ^t.,A k ^^F:^í^Nl)t ^.

^ ^^

APENDICE B

^

La consistencia del estimador cresia (^^ ) se demuestra expresándolo en

^

función del estirnador MCO ( RMCO )

Rc =^^^ k+ i(^ ñ^-1 ^(T x RMCO

y tomando límites en probabilidad a ambos lados de la anterior ecuación, se

obtiene:

^

plim^i^ = plim

plim ^ XT X

N

^XTX+yIk

^

p^Im^^ MCO - ^

donde se ha tenido en cuenta que:

^

PiimaMCO = R

plim ^_k = 0

N

ññ_

plirn ___

_ _ ^x

T

N

suponiendo que ^xX sea una matriz no singular. ^

APENDICE C

^

Sea Rk la estimación por MCO del vector de parámetros ^i:

^

_

Rk =^ Xk Xk ^ 1 Xk Yk

[C.1]

Denotando por ^3k a fa estirnación por MCO de R cuando se elimina la observación

k-s de la muestra, se tiene:

_^ x k x k- xk-s Xk-s ^-1 ^ X k Yk - xk-s Yk-s )

[C.2]

Aplicando el lema de inversión de inversión de matrices a la expresión [C.2] y

Ilamando Vk =( X k X k)-^, se obtiene que:

Vk -f- Vk xk-s ^ ^- xk-s Uk xk-s ^-1 xk-s vk ][ X k Yk - xk-s Yk-s ]

^ L:: T ^^^."^t,!^.i^^:,^r^. E^{ (^,+_ ^f^^,!^.^^

^'4^^ )E^1 f^ MA f^E I A^^ ^:;^^Ni^)I(;I(^)r•^f ^^ IP^^^t^:^^t E^^:^^ E ^^^ ^;)^; ^l ^.^,^ ^^:^a^'^^.^r ^^, t:^E

1^7

o bien:

^

-+-

Vk Xk_s ^ ^- xk-s Uk Xk-s )' 1( xk s Nk ^ yk-s )

Llamando kk = Vk Xk_S ( Xk s Vk xk-s - 1)-^, la expresión anterior puede escribirse como:

"

T

"

k - ^k + kk ^ Yk-s - xk-s ^k ^

y aplicando, de nuevo, el lema de inversión de matrices, la matriz de cavarianzas

de ^k tiene la expresión:

Vk ^ Uk +

Vk xk-s

^^ Xk-s Vk xk-s ) 1 xk-s Vk -^ I - kk xk-s ^ Vk ^

S U M MARY

THE PROBLEM OF INITIAL CONDITIONS IN THE RECURSIVE

ESTIMATION OF LINEAL MODELS

This article proposes two solutions to allow the final recursive estimates of a regression model to be independent from arbitrary initial

conditions. The first solution uses a recursive algorithm which discounts the effect arbitrary initial conditions on the final parameter

estimates. The second solution uses filters based on propagating the

information matrix rather than the covariance matrix. By his own nature, this algorithm has exact initial conditions and is numerically robust.

Key words: Initial conditions, recursive estimation, ridge estimator,

information matrix, numerical stability.

AMS Classification: 62J05, 62J07.