Técnicas de encuestas por muestreo

Anuncio

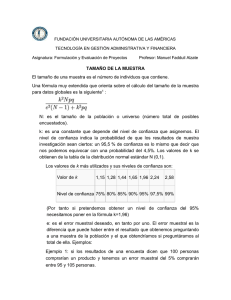

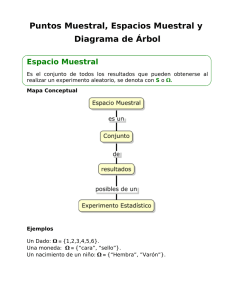

TÉCNICAS DE ENCUESTA POR MUESTREO Copyright © ESOMAR, 1995 Joan S. Alòs Texto presentado en el Seminario de ESOMAR celebrado en Caracas y México en 1990 Vamos a abordar en este capítulo en qué forma podemos obtener informaciones representativas del mercado, especialmente en cuanto acudimos a fuentes de información primarias y externas a la empresa. 1. EL UNIVERSO Si habláramos de población en general el universo consistiría en el censo detallado de dicha población; si habláramos de un canal de distribución, por ejemplo de alimentación, el censo de establecimientos que vendieran productos alimenticios constituiría el universo de este canal de distribución. Consecuentemente el universo va a ser la totalidad de elementos que deseamos investigar, es algo que siempre hay que definir puesto que rara vez el universo es toda la población, incluso en sondeos de población se suelen excluir sectores que por sus características o no son votantes o se considera que no están en edad de opinar, por ejemplo las edades infantiles o las ya muy avanzadas; pero ciertamente cuando estamos hablando de una investigación de mercado tendente a aportar información operativa encuadrada dentro de un plan de marketing, el universo es lo primero que hay que definir con claridad, ¿nos estamos refiriendo a todo el público?, ¿sólo a los compradores?, ¿a aquellos compradores que ya consumen nuestra marca?, ¿a los que consumen cierta categoría de producto?, ¿a los de todo el Estado?, ¿o sólo a los que viven en algunas zonas o áreas metropolitanas? La definición del universo consecuentemente debe ser precisa ya que ello nos permitirá cuantificar el potencial del mercado, abordar debidamente los medios de comunicación, elegir asimismo un estilo de producto y de comunicación, y en definitiva constituirá aquel colectivo que desde el punto 371 de vista marketing deberá aportarnos los ingresos necesarios para nuestra actividad y que desde el punto de vista de la investigación ha de aportarnos aquella información necesaria para la buena marcha del plan de marketing. Los elementos más clásicamente definitorios del universo suelen ser de tipo sociodemográfico: sexo, edad, clase social, lugar de residencia, etc. y de consumo: ser o no consumidor de cierta categoría de producto o de ciertos productos específicos o incluso de ciertas marcas o variedades específicas. Una vez elegido el universo será preciso cuantificarlo, tener una idea ni que sea aproximada de cuántos cientos, miles o millones de personas se trata. Generalmente vamos a trabajar en investigación de mercados con universos que estadísticamente se consideran infinitos, es decir que el tamaño de la población que hemos de estudiar no tiene una repercusión sensible sobre el tamaño de la muestra, prácticamente son independientes. El universo suele expresarse convencionalmente con la letra N (mayúscula) y la muestra con la letra n (minúscula), pues bien cuando √ (N — n) ———–— ≥ 0.95 n—1 se considera que a efectos prácticos el universo es infinito; ello sucede cuando, el número de elementos del universo es superior a los 100.000, pero de manera práctica también podemos considerar universos ya infinitos cuando N es igual a 50.000 salvo que la muestra que haya que entresacar sea proporcionalmente muy elevada. Pero podríamos preguntarnos porqué entresacar una muestra y no hacer el estudio sobre la totalidad del universo, lo que si se quiere es una pregunta retórica ya que simplemente el coste económico nos haría desistir de nuestro empeño; en efecto es enormemente costoso obtener información de toda la población, o de todo el universo, lo cual no obstante se hace de forma regular aproximadamente cada 10 años a través de los censos de población. Pero al margen de los motivos estrictamente económicos hay también otros que nos hacen desistir de plantearnos seriamente realizar una investigación sobre el conjunto del universo, uno es el factor tiempo: la dinámica del marketing no permite unos plazos de obtención de infor372 mación excesivamente largos como exigiría un estudio censal, pero también hay otro factor importante y es que difícilmente obtendríamos respuesta por parte de todo el universo, siempre habría personas ilocalizables o que finalmente se negarían a facilitar información, con lo cual evidentemente estaríamos produciendo un sesgo en los resultados sin que pudiéramos precisar exactamente cuáles; consecuentemente por todo este cúmulo de razones debemos pensar en otras formas de representar aquellos colectivos o universos que interesan a nuestros fines. 2. LA MUESTRA La muestra es precisamente la forma ideada para lograr representar un universo, con ello indicamos ya la cualidad fundamental de una muestra: ser representativa, es decir que nos permita tomar la parte por el todo; aquella información obtenida de la muestra debe ser válida para la totalidad del universo, es decir debe ser extrapolable al universo o dicho en un lenguaje sencillo: si nosotros extraemos 400 personas de un universo estadísticamente infinito y tabulamos sus respuestas, éstas dentro de unos ciertos márgenes de error previamente conocidos, van a ser las mismas que obtendríamos de otro conjunto de 400 personas de este mismo universo, en caso contrario no se trataría de una muestra sino únicamente de una visión parcial, sectorial, polarizada y definitivamente sesgada. El hecho de que la muestra deba ser representativa, puesto que es precisamente una extracción representativa del universo, nos va a llevar a toda una sistemática de actuación para obtenerla y a la aplicación de una ciertas leyes de tipo estadístico; digamos que estas premisas en investigación de mercados hacen referencia a cualquier muestra, cualquiera que sea su tamaño y cualquiera que sea la utilización que se hace de la misma, por lo tanto una muestra debe ser representativa tanto en un panel, que va a dar como resultado unas magnitudes al mercado, como en una encuesta, que va a dar como resultado unas determinadas proporciones o porcentajes de opiniones y hechos del mercado, como en un estudio de tipo cualitativo, descriptivo o motivacional que nos va a decir las actitudes y motivaciones que subyacen en el comportamiento de las personas; quiere ello decir que si realizamos un estudio basado en 4 dinámicas de grupo debemos tener la certeza de que caso de realizar 4 dinámicas con otras personas distintas, las conclusiones a las que llegaríamos serían las mismas, pudiendo variar sólo en matices pero no llevándonos en ningún caso a una toma de decisiones en marketing distinta; si ello no fuera así la investigación de mercados no tendría sentido. 373 Dentro de este contexto general de lo que es una muestra, debemos indicar también que en ocasiones se hacen estudios a muestras especialmente sesgadas, es decir no representativas de un universo; es simplemente por una similitud en cuanto al procedimiento o en cuanto al léxico que se les llama en esta forma, podemos imaginar por ejemplo encuestas a líderes de opinión, cuyas respuestas ciertamente no van a ser representativas del conjunto de la población pero que sin embargo pueden tener un peso importante en sí mismas o incluso como conjunto, y es bajo esta perspectiva que hay que verlas; en este caso, también en un sentido estricto, podríamos decir que el universo que pretendemos representar no es por ejemplo el de nuestro conjunto de consumidores sino específicamente el de líderes de opinión que pueden afectar a nuestra actividad o nuestros planteamientos. 3. COMO GARANTIZAR UNA BUENA REPRESENTACIÓN Este es realmente el quid del muestreo. Fundamentalmente para poder garantizar una buena representatividad hemos de tener presentes dos principios: 1.º la aleatoriedad, es decir la no intencionalidad en la selección de un elemento determinado del universo 2.º la probabilidad, en el sentido de respetar que todos los elementos del universo tengan la misma probabilidad de entrar a formar parte de la muestra. Esta probabilidad no siempre es pareja a la proporcionalidad; nos explicamos, en ocasiones el universo viene estratificado en formas muy descompensadas, es posible que ciertas regiones de un país o ciertas áreas metropolitanas tengan una concentración de población mucho mayor que otras; consecuentemente si queremos representar las áreas menos extensas y guardar la proporcionalidad en las áreas con mayor proporción, podríamos irnos a unos niveles de muestra muy elevados y por otra parte innecesarios para dar respuestas válidas sobre estas áreas; por el contrario si elegimos unas muestras mínimamente representativas para las áreas mayores y guardamos el principio de proporcionalidad, nos vamos a encontrar con que en las áreas menores la muestra es totalmente insuficiente. Consecuentemente la probabilidad en muchas ocasiones se respeta a nivel de cada uno de los estratos en que podemos subdividir el universo pero no entre los estratos; lógicamente ello proporciona unas ciertas dife374 rencias en cuanto a la precisión pero salvo que se trabaje con desproporciones muy elevadas la incidencia sobre el grado de precisión es realmente aceptable; en todo caso siempre existe la posibilidad, y suele hacerse, de reequilibrar esta muestra por ordenador para dar unos resultados totales, es decir dar a cada estrato teóricamente la muestra que le corresponde aunque no se haya hecho, así por ejemplo la zona menos favorecida puede tener un peso de reequilibraje igual a 1 y aquellas más favorecidas en que se ha hecho proporcionalmente menos muestra, multiplicarlas precisamente por el factor de desproporcionalidad. Para garantiza la aleatoriedad hay básicamente dos procedimientos: el procedimiento aleatorio simple, y el procedimiento aleatorio sistemático. En el aleatorio simple todos los elementos del universo forman parte de cada una de las extracciones de elementos muestrales en cada una de las extracciones; un ejemplo ilustrativo puede ser el de un sistema de lotería en que todos los números, uno por uno, están en el bombo y cada vez se va extrayendo una bola. Para llevar a cabo este procedimiento en la práctica, lo ideal es poder disponer de un censo nominal de la población y hacer unas extracciones por sorteo; este proceso aleatorio simple, sin duda el más puro, presenta no obstante algunos problemas de consideración que hacen que sea desestimado en la mayor parte de los casos. Por un lado puede suceder que la muestra obtenida sea enormemente dispersa territorialmente, lo que encarecería enormemente el coste de obtención de información; por otra parte, salvo que el tamaño muestral sea realmente muy grande, existe el riesgo de que por azar algunos estratos del universo no hayan sido cubiertos o apenas cubiertos y en otros, en cambio, haya una proporción bastante mayor, lo que sin duda podría introducirnos unos sesgos en los resultados. El procedimiento aleatorio sistemático se ilustra por ejemplo en el caso de la lotería, en que hay un bombo correspondiente a cada una de las cifras de unidades, decenas, centenas, millares y centenas de millar que pueden contener el número premiado y se extrae una bola de cada bombo. En el terreno de los estudios de mercado, el procedimiento aleatorio sistemático pretende garantizar a priori la representatividad de todos los estratos, de manera que aseguremos la proporcionalidad, dentro de los límites que antes hemos señalado, y dentro de cada estrato la probabilidad nos vendrá garantizada ya por un procedimiento de selección que puede ya, si se desea, ser aleatorio simple. No obstante, dadas las dificultades existentes en la inmensa mayor parte de países en tener unos censos nominales de los universos, se suele proceder a un sistema de selección polietápica de ma375 nera que nos vayamos acercando hasta el último elemento de la muestra, que en el caso que consideramos sería un individuo. Una selección muestral polietápica pasa por las siguientes fases: 1.ª 2.ª 3.ª 4.ª 5.ª 6.ª una repartición de la muestra por estratos, generalmente se trata de regiones de un determinado país o de diversos países en estudios multinacionales. dentro de estos estratos, por zonas, se reparte también la muestra por niveles de hábitats, asegurando así la representatividad tanto de hábitats rurales, como semiurbanos, urbanos o metropolitanos. dentro de estas celdillas de zona hábitat, se eligen por sorteo las ciudades, o en general las poblaciones a entrevistar, participando cada población con tantos números en el sorteo como número de habitantes tenga. dentro de los pueblos y ciudades elegidos se hace una selección de edificios, generalmente a través del sistema de rutas aleatorias o «random route», que esencialmente consiste en recorrer una ruta en zig zag, una vez elegido aleatoriamente un punto de partida en aquella población o ciudad y si el tamaño de la muestra es grande, ésta se subdivide en rutas que suelen oscilar entre las 5 y 10 entrevistas teniendo cada una de ellas un punto de partida y un itinerario en zig zag a seguir. consiste en la selección aleatoria de viviendas dentro del edificio, para lo cual el entrevistador con la ayuda de un selector sortea el piso al que debe acudir y dentro del rellano elegido la puerta concreta, o la vivienda concreta, en la que debe hacer la entrevista. se sortea el individuo a entrevistar dentro de la vivienda, sorteando entre aquellos que reúnen las características fijadas en el universo tales como sexo y edad por ejemplo. Sin embargo pese a que la teoría nos indica que el sistema de random sampling o muestra aleatoria es el indicado, de forma creciente las muestras se realizan por el sistema de cuotas. En el muestreo por cuotas exigimos a priori unas proporciones de determinadas características, generalmente conocidas por estudios anteriores, y así podemos exigir que en la muestra formen parte determinada proporción de hombres y de mujeres dentro de cada uno de estos grupos, unas proporciones determinadas de edades y por ejemplo dentro de estos subgrupos unas proporciones determinadas de usuarios del producto a estudiar o de algunas marcas concretas. Si en la selección de estas perso376 nas no ha intervenido la intencionalidad, sino que dentro de cada una de las cuotas establecidas se ha dejado la selección al azar, puede ser también un buen método de muestreo y suficientemente representativo. ¿Por qué se hacen relativamente tan pocos muestreos por un procedimiento aleatorio simple o aleatorio sistemático? Un primer factor es el coste ya que en muchas ocasiones la persona que deberíamos entrevistar en aquel momento no está presente en el hogar o en el lugar donde hayamos ido a buscarla o no dispone de tiempo; teóricamente habría que hacer un segundo intento o quizá hasta un tercero y finalmente si no se logra la entrevista, hacer una sustitución estricta por cuotas; ello ya es de por sí costoso en entrevistas realizadas en grandes ciudades pero el coste ya puede ser prohibitivo cuando estas entrevistas se están realizando en hábitats rurales, con entrevistadores desplazados, y que se verían imposibilitados de acabar su ruta, su labor en el transcurso del día, o máxime dos días, que suelen estar en cada uno de estos puntos. Además del problema de coste está también el problema de tiempo, podríamos tardar demasiado tiempo en obtener información y quizá una vez obtenida esta información ya no nos fuera útil para la toma de decisiones. Pero existen asimismo problemas de tipo técnico para garantizar que verdaderamente toda la labor de sistema aleatorio se está haciendo con absoluto rigor, ya que en muchas ocasiones nos faltarán datos suficientes para poder precisar estos extremos, por ejemplo podemos encontrarnos ciudades o áreas en que el número de viviendas por edificio varíe fuertemente de un edificio a otro: ¿es justo entonces dar la misma probabilidad de contacto a todos los edificios?, podemos hallarnos también en ocasiones con una variación relativamente amplia del número de miembros del hogar de una a otra vivienda, ¿podemos conocer ésto a priori y consecuentemente hacer un sistema de muestreo más preciso?. Si a estos inconvenientes en coste, en tiempo y técnicos, añadimos el conocimiento que venimos acumulando por el hecho de que la investigación lleva años de existencia y que generalmente es sistemática, vamos adquiriendo una gran cantidad de conocimientos acerca de cómo está estratificado el mercado y podemos entonces ya garantizar a priori las distintas proporciones en que las personas deben aparecer en la muestra, sea en función de su sexo, edad, poder adquisitivo, lugar de residencia, o bien en función de otros aspectos referidos al consumo habitual, ocasional, o no consumo de un producto de una marca determinada, o aspectos referidos por ejemplo a su audiencia de medios, etc.; si tenemos en cuenta además que a menudo el tamaño de la muestra es bastante pequeño, casi en el límite de lo tolerable por motivos de tipo económico, el riesgo en un sistema 377 de muestreo estrictamente aleatorio es ciertamente grande, en tanto que un sistema de cuotas nos va a garantizar mejor la representatividad de la muestra. Consecuentemente el sistema aleatorio va a quedarnos para estudios con muestras suficientemente amplias y cuando no dispongamos de una información lo bastante precisa sobre aquel mercado, siendo verdaderamente difícil establecer unas cuotas a priori cuando en muchas ocasiones ésto es precisamente lo que estamos intentando descubrir; de ahí que el sistema de muestreo por cuotas tenga una implantación creciente. Ciertamente en países en donde existen unas fuentes estadísticas completas, manejables y de bajo coste, es más fácil acudir a sistemas aleatorios, puesto que se dispone de listado de individuos, de viviendas, o se sabe en un núcleo determinado por ejemplo cuántas familias viven, cómo están agrupadas y distribuidas en la población, cuál es el tamaño de cada una de estas familias, etc. Pero de forma creciente se está acudiendo al muestreo por cuotas o de tipo mixto. 4. EL TAMAÑO DE LA MUESTRA Y EL MARGEN DE ERROR Sin duda cuando se habla de muestra el aspecto más candente es el del tamaño y la precisión que este tamaño pueda aportarnos. Comencemos por decir de qué depende y de qué no depende el tamaño de la muestra. El tamaño de la muestra en general dentro de la investigación de mercados, por lo que hemos comentado anteriormente, no depende del tamaño del universo, en cambio si puede depender del grado de homogeneidad dentro de este universo o de la característica que estemos buscando dentro del mismo. Pongamos un ejemplo sencillo: disponemos de dos bolsas, en una de las cuales hay naranjas y en otra limones; las naranjas debemos servirlas en el postre y los limones durante la comida, si encargamos al pinche de cocina que nos entregue la bolsa conteniendo naranjas ¿qué número de extracciones tendrá que hacer?, evidentemente le bastará con abrir una de las bolsas y examinar uno de sus elementos, en el supuesto evidentemente de que nuestro proveedor no nos haya hecho la jugarreta de mezclar naranjas y limones; si abre la bolsa y en ellas saca un limón, evidentemente en aquella bolsa habrá limones y es la que tendremos que utilizar durante la comida, y en la otra habrá naranjas y es la que tendremos que utilizar en los postres. Si aquello que intentamos averiguar es muy sencillo y viene repartido además de forma muy homogénea en todo el 378 universo, podemos permitirnos unas muestras menores que si aquello que intentamos averiguar u observar es bastante más complejo; supongamos que en una bolsa tenemos una variedad de frutos secos, si nosotros pretendemos saber cuál es esta variedad desde un punto de vista cualitativo, es decir qué tipo de frutos secos hay, nos bastará una extracción relativamente pequeña, pero si además queremos saber la proporción en que se hallan presentes estos frutos secos, sin duda necesitaremos un tamaño de muestra mayor. Dicho ésto vamos a operar como si el grado de homogeneidad nos fuera desconocido. Ello estadísticamente se expresa en la forma en que p=q=50%, es decir la probabilidad de que se de un fenómeno o su contrario son iguales; cualquier otra probabilidad, mayor o menor, nos permitiría unos tamaños de muestra más reducidos, en el caso de las naranjas o los limones, por definición la probabilidad de que si en una bolsa sacamos un limón todos fueran limones es del 100%, con independencia del número de limones (universo) que pudiera haber en la bolsa, con lo que nos basta, como hemos indicado, con sacar un solo elemento. Hay otro factor que también nos va a influir en el tamaño de la muestra y es nuestro grado de permisividad, es decir hasta qué punto nos importa que los resultados sean más o menos exhaustivos, qué transcendencia tiene ésto para nosotros; generalmente consideramos que las respuestas obtenidas se distribuyen conforme a una ley normal y la curva de la ley normal es prácticamente asintótica con el eje de abcisas, es decir que se encuentra con ella en más infinito y en menos infinito; evidentemente en investigación de mercados no precisamos una rigurosidad tan elevada como si de un experimento científico de alta tecnología se tratara, podemos perfectamente prescindir de esta parte de la curva, que ya es muy próxima al eje de abcisas, es decir que las frecuencias que aparecen con estos valores extremos es ya evidentemente muy pequeña, son lo que podríamos llamar casos marginales, casos atípicos, consecuentemente que dentro de un universo la probabilidad de que aparezcan es muy reducida. ¿Pero hasta qué punto vamos a ser permisivos en este sentido? En líneas generales se establece que para la investigación de mercados el punto de permisividad es el de 2 σ a uno y otro lado, por lo tanto ± 2 σ del valor medio de la curva de distribución normal, y ello nos cubre el 95,5% de las respuestas posibles; sabemos por lo tanto que hay 4,5% de posibilidades de que aparecieran otras respuestas distintas a las que hemos tenido 379 y que consecuentemente nos pudieran hacer variar ligeramente los resultados, pero el coste de obtener esta información marginal sería ciertamente caro; por poner un ejemplo, si en vez de este nivel de confianza, que así se le llama, de 2 σ lo quisiéramos de 3 σ –que nos cubriría el 99,7% del área de distribución normal– para ganar este 4% precisaríamos de un tamaño de muestra más de 2 veces superior, consecuentemente seguimos trabajando con el nivel de confianza de 2 σ. El nivel de confianza de 2 σ viene a decirnos que si repitiéramos la muestra con elementos distintos 100 veces, el valor promedio obtenido no diferiría significativamente del que hemos hallado en el 95,5% de los casos, en el otro 4,5% este valor podría diferir pero evidentemente no alejarse hasta extremos que pudieran llevarnos a unas conclusiones de marketing distintas. Y finalmente otro aspecto influyente en el tamaño de la muestra es el error muestral que estemos dispuestos a asumir, el cual nos vendrá muy condicionado por la gravedad de la decisión que tengamos que tomar. Finalmente pues el tamaño muestral para poblaciones infinitas lo podemos expresar con esta fórmula: K2 p q n = —————– e2 Dentro de la fórmula n es el tamaño muestral para una población infinita, K es la constante que nos representa el nivel de confianza y que como comentábamos en la investigación de mercados usualmente toma el valor 2; observemos que si quisiéramos reducir el riesgo en cuanto al nivel de confianza y pasáramos a un valor 3, el tamaño de la muestra nos aumentaría exactamente en 9/4 puesto que es K2 y no K la que afecta directamente al tamaño de la muestra; p y q son las probabilidades complementarias de respuesta y que cuando no dispongamos de otro tipo de información vamos a suponer que son igual a 50%, es decir el caso más desfavorable en que se maximiza más la muestra; e es el error muestral que estamos dispuestos a admitir, el grado de precisión, y que viene afectado inversamente al cuadrado, consecuentemente cuanto mayor sea el error admitido menor va a ser la muestra. A partir de la fórmula de tamaño muestral podemos deducir fácilmente la fórmula del error muestral, que tomando ya como referencia K igual a 2, la fórmula sería la siguiente: 380 e=±2 √ p q ————— n ello referido como siempre a poblaciones infinitas; en el caso de que la población fuera finita la fórmula sería la siguiente: n=±2 √ p q (N – n) ——————— n (N – 1) ¿Cómo hay que interpretar el margen de error? En el supuesto de que estemos examinando un porcentaje del 50% y hubiéramos realizado 100 entrevistas, el valor de e (margen de error) sería de ± 10; ello quiere decir que el valor del 50% que hemos hallado en la muestra, dentro del universo podría oscilar entre 60 y 40 —es decir entre 50 + 10 y 50 – 10— 95,5 de cada 100 veces; para reducir este abanico la solución es ir ampliando el tamaño de la muestra. Si pretendemos reducir este margen de error de ± 10 a ± 5 observaremos que la muestra necesaria no es el doble, es decir 200 entrevistas, sino el cuádruple, 400 entrevistas. Consecuentemente enseguida nos podemos construir una tabla sencilla que nos ponga en relación los errores muestrales con el tamaño muestras para el caso de máxima indeterminación en que p=q=50% y siempre para este nivel de confianza igual a 2. Error muestral ± 10 ± 5 ± 2.5 ± 1.25 ± 0.62 Tamaño muestral 100 400 1.600 6.400 25.600 Puede observarse que reducir drásticamente el margen de error supone un esfuerzo económico enormemente elevado, puesto que los tamaños muestrales se van cuadriplicando cada vez. Consecuentemente hay que hilar muy fino en cuanto al margen de error, el riesgo que uno está dis381 puesto a asumir, el grado de precisión que necesita para no ir a tamaños que acabarían siendo impagables, pero por otra parte no quedarse en unos tamaños tan reducidos, por baratos que sean, a partir de los cuales no pudiéramos tomar decisiones operativas. ¿En qué forma consecuentemente hay que determinar el tamaño muestral? 5. LA ESTRATIFICACIÓN. EL ERROR RAZONABLE Conocemos qué aspectos estadísticos afectan el tamaño muestral y su implicación en el grado de precisión y en el riesgo que corremos. ¿Cómo podemos compaginar estos aspectos con una inversión en investigación razonable? En primer lugar si disponemos ya de información anterior o de apreciaciones fiables respecto al valor de p, consecuentemente respecto al grado de homogeneidad, inmediatamente al calcular el tamaño muestral en vez de hacer p=q=50% pondremos el valor de p que haga al caso, supongamos un valor de 75%; si siguiéramos manteniendo un tamaño muestras de 100 entrevistas, el error muestral nos disminuiría de un 10 a un 8.7, pero podemos optar por no disminuir el margen de error y seguir aceptando el valor 10%, y consecuentemente disminuir el tamaño muestral, lo que nos abarata el estudio; en este supuesto nos bastaría con realizar 75 entrevistas en vez de 100, reduciendo el coste, sino de manera proporcional en un 25%, si de una forma sensible. Sin embargo en la mayor parte de ocasiones no dispondremos de estimadores previos o la variedad de objetivos a cubrir será tan amplia que en algún caso tendremos que admitir esta indeterminación en que p=q=50%; en estos casos que suelen ser la generalidad, no tiene sentido plantearse el error muestral que uno está dispuesto a admitir para el total del universo, sino para el estrato de universo más pequeño sobre el que razonablemente deban tomarse decisiones. Imaginemos por un momento un país de 15 millones de habitantes, que se divide en cuatro regiones distintas en las que es posible emprender acciones de marketing diferenciadas y que estas regiones tengan una población respectivamente: Región A: 1 millón de habitantes Región B: 2 millones de habitantes Región C: 4 millones de habitantes Región D: 8 millones de habitantes Total: 15 millones de habitantes 382 Plantearnos el margen de error para el conjunto de 15 millones es poco operativo; imaginemos que estamos dispuestos a aceptar un margen de error de ± 5 para este total de 15 millones, el tamaño muestral sería de 400 entrevistas; si estas entrevistas se distribuyeran de forma proporcional –como es ideal hacerlo–, la región más pequeña, con un millón de habitantes, se representaría únicamente en base a 27 entrevistas, lo que nos da un margen de error para esta región de ± 19%, es decir que ante un porcentaje de un 50% únicamente podemos afirmar que en 95 de cada 100 casos, dentro de la población de esta región, este porcentaje puede oscilar entre 69% y 31%, en una proporción consecuentemente que en números redondos va de 1 a 2; huelga decir por otra parte que difícilmente podríamos lograr una buena representatividad a partir únicamente de 27 entrevistas, ya que sería enormemente difícil poder respetar los principios de aleatoriedad y probabilidad dentro de esta región. El proceso de construcción del tamaño muestral consecuentemente es el contrario. Fijémonos el margen de error que estamos dispuestos a asumir en la región más pequeña y admitamos por ejemplo que pueda ser de ± 10%, en cuyo caso en esta región deberíamos de realizar 100 entrevistas y si hiciéramos un muestreo estrictamente proporcional representaríamos la totalidad de este país con 1.500 entrevistas; el error muestral para el conjunto consecuentemente sería fruto de esta construcción muestral, no sería un error inicialmente buscado; en este caso concreto para 1.500 entrevistas sería de ± 2.6%, pero de hecho nos da igual que sea este valor, como que sea un 4 ó un 5%; ello nos puede llevar en algunos casos en que la desproporción entre áreas es manifiesta a hacer muestras no proporcionales como anteriormente hemos indicado; una muestra razonable podría ser por ejemplo: Región 1 Región 2 Región 3 Región 4 Total Habitantes Muestra 1.000.000 2.000.000 4.000.000 8.000.000 15.000.000 100 200 300 400 1.000 Error muestral % ± ± ± ± 10.0 7.1 5.8 5.0 ? para el conjunto de las 1.000 entrevistas el error teórico sería de ± 3.2%, aunque ésta es sólo una aproximación puesto que el error muestral del conjunto viene algo afectado por la desproporción; concretamente el margen de error para muestras no proporcionales nos viene dado por la siguiente fórmula: 383 e=±2 √ p q ——— n2 Σ np2 ——— na siendo np la muestra proporcional que correspondería al estrato y na la muestra aproporcional. En el caso que nos ocupa el error muestral final de estas 1.000 entrevistas no sería de ± 3.2% sino de ± 4.9%, es decir que los datos totales podrían oscilarnos, en el caso del 50% entre 45 y 55, pero en vez de hacer 1.500 entrevistas hemos hecho 1.000, lo que supone un ahorro de coste importante. Como se suele decir, finalmente el tamaño muestral no depende tanto del error y de la estadística como del presupuesto disponible, sin embargo hay que coger este aserto con toda precaución y saber hacer los números, teniendo presente que en ocasiones es preferible no disponer de información que disponer de alguna que nos pueda llevar a tomar decisiones erróneas. Este aspecto de la estratificación y el error que estamos dispuestos a asumir para el estrato más pequeño es como hemos comentado el básico en la construcción del tamaño muestras y de su reparto, y ello es válido tanto para estudios de tipo cuantitativo como de tipo cualitativo. Observemos que para los estudios cualitativos el número de reuniones o entrevistas en profundidad a hacer, va a depender del número de distintos estratos del universo, entendiendo aquí los estratos desde un punto de vista cualitativo como algo más reducido o más segmentado, puesto que al margen de diferencias objetivas en grupos de consumidores, hay que pensar también en la productividad de los grupos, y esta productividad se da fundamentalmente, salvo en algunas técnicas específicas de contraste, cuando los grupos son homogéneos, quiere ello decir que en general dentro de un grupo no podremos mezclar personas de distinto sexo, de edades muy diferenciadas, de niveles sociales muy diversos y es posible que en ocasiones en ciertos países haya otros aspectos que también impidan una buena comunicación, ya sea en función de raza o religión, por ejemplo. El tamaño muestral cualitativo para cada estrato se aconseja que sea de un mínimo de dos reuniones de grupo y de cinco entrevistas en 384 profundidad; en ocasiones será preciso utilizar ambos tipos de técnicas, en otros nos bastará con una de ellas. Si el número de estratos es muy amplio, en ocasiones será posible reducir este número de grupos hasta 1 por estrato. 6. LOS OTROS ERRORES Podemos medir y apreciar con bastante finura los errores estrictamente estadísticos, los errores esperados; sin embargo hay otras fuentes de error o de sesgo en las encuestas que difícilmente pueden medirse en forma de tantos por ciento, por lo que la única solución es intentar minimizarlos al máximo. Estos errores provienen de dos tipos de fuentes distintas, por una parte de quienes no contestan a la encuesta siendo requeridos para ello y por otra parte de aquellos que han contestado. Quienes no contestan a la encuesta puede ser bien por un motivo expreso, es decir se les ha podido abordar pero se niegan a contestar, o por un motivo tácito: la persona que teóricamente teníamos que entrevistar, por ejemplo en un proceso de rutas aleatorias, no ha podido ser contactada por no hallarse en el hogar o porque no hay acceso permitido a esta vivienda, ignorando cómo habrían contestado estas personas si hubiéramos podido convencerlas o si en vez de hacer el intento de entrevista una vez, lo hubiéramos repetido en más ocasiones. Al respecto existen algunos estudios y ciertamente los «no contestan» o las personas sustituidas tienen en general una opinión distinta a aquellas que han contestado y ello viene dado tanto por su posición socioeconómica, como por su talante social, como por un distinto tamaño o estructura familiar, etc., pero difícilmente se puede decir y menos prever a priori cuál es exactamente el sesgo producido. En función del riesgo en la decisión a tomar, en ocasiones habrá que exigir un segundo intento de entrevista o lograr un contacto vía telefónica previo por ejemplo a un contacto personal, con el fin de asegurarse la mayor cobertura posible de gente entrevistada; también podrá exigirse que las sustituciones de una persona que no se encuentra, o de una vivienda a la que no se puede acceder, o en la que no hay nadie, se hagan por un sistema de cuotas, es decir tomando aquellos datos mínimos del hogar que quizá un vecino nos puede contestar, o que podemos observar, y buscar una vivienda o una persona de aquellas mismas características. La otra gran posible fuente de errores proviene de aquellas personas que han contestado, bien sea porque han contestado con inexactitud, bien sea por la forma en que les hemos preguntado. Las inexactitudes 385 por parte de las personas entrevistadas, si las preguntas han sido correctamente formuladas, en general vienen a compensarse por la ley de los grandes números; estamos hablando de omisiones o equivocaciones totalmente involuntarias y que tanto podían producirse en un sentido como en otro; sin embargo en ocasiones ésto no es así y el sesgo, cuando se produce, se produce siempre en el mismo sentido, por ejemplo de aquel tipo de respuesta que haga quedar mejor al entrevistado; en estos casos conviene tener recursos a lo largo de la entrevista para poder verificar algunas de las respuestas. Pero generalmente el problema no viene tanto de la respuesta en sí misma como de ésta en relación a la pregunta que se ha efectuado; es de capital importancia disponer de cuestionarios que sean absolutamente neutros, que permitan al máximo la facilidad de expresión y de opinión por parte de los entrevistados, y que sean formuladas de una manera estrictamente profesional por parte de los entrevistadores. Hay algunos temas que son más difíciles de abordar que otros y que consecuentemente producen sesgos en las respuestas, hay que ser consciente de ello y si acaso tomar las respuestas partiendo de unas mismas preguntas en un sentido no absoluto sino relativo, viendo como han ido evolucionando a lo largo del tiempo aún sabiendo a ciencia cierta que la respuesta obtenida no refleja exactamente el pensamiento o forma de actuar de la población. Tras la recogida de información sobre el terreno caben aún algunos errores en el procesamiento de los datos puesto que algunas de las respuestas son abiertas y hay que codificarlas; puede haber aquí un error en la interpretación o incluso un error propiamente en la codificación –poner un código en vez de otro inadvertidamente– y ello puede seguir en la grabación de esta información en un soporte informático que puede asimismo dar lugar a unas desviaciones indeseadas. Todo y con ello, como decíamos, lo más que se puede hacer es poner un exquisito cuidado en todos estos aspectos, no descuidarnos en ningún momento puesto que el margen de error estadístico podría ser ridículamente mínimo en relación a los errores verdaderamente cometidos. Digamos por último que el error real no siempre se corresponde con el error teóricamente estimado; en líneas generales si se han cuidado todos los detalles es posible que el error real sea menor que el error teórico, y ello viene influenciado sobre todo por el grado de homogeneidad que exista dentro de la población en cuanto a los temas que se han investigado. Hay formas de conocer cuál es este error a posteriori, fórmulas que son senci386 llas en el caso de que hayamos obtenido unos promedios a partir de unas puntuaciones, por ejemplo a grados de acuerdo o desacuerdo sobre algunas frases que hayamos podido sugerir, puesto que podemos calcular fácilmente la desviación típica. Respecto a los porcentajes hay una forma sencilla de ver hasta qué punto oscilan dentro de la muestra, que es repartir las respuestas entre los cuestionarios pares y los impares, entendiendo que tanto pares como impares son dos submuestras representativas de la muestra realizada; si se quiere llegar a mayor detalle y la muestra es suficientemente amplia, pueden dividirse estos resultados entre los 10 números terminales de los cuestionarios dando lugar consecuentemente a 10 submuestras. 7. BIBLIOGRAFÍA ORTEGA MARTÍNEZ, M.: Manual de investigación comercial, Ediciones Pirámide, Madrid 1990. AZORÍN, F.: Curso de muestreo y aplicaciones, Aguilar, Madrid. COCHRAN, W.: Técnicas de muestreo, Cecsa, México. DAVIS, S. A.: Análisis elemental de encuestas, Trillas, México. DENING, W. E.: Sample Desing in Business Research, John Wiley and Sons, Nueva York. DESAIE, J.: Théorie et pratique des sondages, Dunod, París. KISH, L.: Muestreo de encuestas, Trillas, México. SÁNCHEZ, J. L.: Muestreo de poblaciones finitas aplicado al diseño de encuestas, INE, Madrid. STEPHAN, F. F. y McCATHY, P. J.: Sampling Opinions: An Analysis of Survey Procedure, John Wiley and Sons, Nueva York. 387 8. FORMULARIOS La mayor parte de las realizaciones prácticas que se realizan en investigación de mercados en cuanto al tema estadístico están recogidos en formularios y en prontuarios que facilitan extraordinariamente las labores de cálculo, asimismo las calculadoras de bolsillo o de sobremesa facilitan los cálculos especialmente de los errores muestrales; por ejemplo para el caso de p=q=50% y un nivel de confianza de 2, para averiguar el error muestral de un tamaño de muestra determinado basta con teclear el tamaño, por ejemplo 400, sacar la raíz cuadrada y el inverso: el resultado es 0.05, el error muestral sería exactamente este resultado multiplicado por 100, es decir 5.0%. En este capítulo de formularios vamos a dar también una tabla de números aleatorios, que son las que se utilizan para los procesos de selección muestral, por ejemplo sortear dentro de la población de un estrato determinado exactamente el número de habitantes al que tocaría hacer una entrevista lo cual –salvo que dispongamos de un censo nominal de habitantes– nos va a indicar el pueblo en el que vive; a partir de ahí podemos aplicar una selección ya sistemática e ir obteniendo el resto de puntos muestrales. Adjuntamos también una tabla de distribución normal tipificada, otra de cálculo de tamaño muestral para un nivel de confianza de 2 y para distintas probabilidades de p y de q; basta con leer en el margen izquierdo cuál es el límite de error que uno está dispuesto a tolerar y cruzarlo con la columna de los valores p/q, obteniendo el tamaño muestral necesario para que el error sea el deseado; imaginemos que estamos dispuestos a admitir un error de ± 5.0 y la probabilidad de respuesta que esperamos es del 30%, en este caso el tamaño muestral necesario sería de 336 entrevistas. En otra tabla indicamos el tamaño de la muestra en poblaciones finitas, también para un nivel de confianza igual a 2 y para p=q=50%; para averiguar el tamaño de la muestra entramos por la columna de la izquierda que nos indica el tamaño de la población, supongamos 5.000, y cruzamos hasta hallar la columna del error muestral que estemos dispuestos a tolerar, supongamos un 5%, en este caso la muestra sería de 370 entrevistas; obsérvese que si el tamaño de la población fuera de 100.000, para un error de ± 5%, el tamaño de la muestra necesario sería 398, en tanto que en poblaciones infinitas es de 400; incluso para una muestra de 50.000 la diferencia es de 3 entrevistas, serían necesarias 397. 388 Otro cuadro nos dará los márgenes de error para poblaciones infinitas, para un nivel de confianza igual a 2 y para distintas probabilidades de p y q; en la columna de la izquierda podemos entrar por ejemplo con una muestra de 600 entrevistas y observar que para una probabilidad del 10% el error muestras sería de ± 2.5. Adjuntamos también una tabla de distribución x2 de Pearson, lo que nos permitirá reconocer si existen o no diferencias significativas entre dos distribuciones provenientes de muestras distintas. Y por último adjuntamos unos formularios de entre los más usuales que se utilizan en investigación de mercados. 389 FORMULARIO BÁSICO 1) Cálculo del error muestral a) Muestras proporcionales E=±2 E p q N n √ p q ——— n N–n × ———— N–1 = error estadístico = probabilidad entre 1 y 100 = complementario de p = tamaño del universo = tamaño de la muestra y entonces E = ± 2 √ p q ——— para N ≥ 100.000 puede n N–n eliminarse ——— (universo infinito) N–1 Para un nivel de confianza de 2 σ (95,5%) El error muestral para universos «infinitos» se reduce a la mitad cada vez que se cuadruplica la muestra E± 20 10 5 2,5 1,25 0,62 (para p=q=50) ——————————————————————————— n 25 100 400 1.600 6.400 25.600 390 b) Muestras no proporcionales E=±2 √ p q ——— n2 Σ np2 ——— na np: muestra proporcional del estrato na: muestra aproporcional del estrato n: muestra total 2. Cálculo del tamaño muestral 4pqN n = ———————— (universo finito) E2 (N–1) + 4p q 4pq n = ———— (universo infinito) E2 3. Cálculo del número de puntos muestrales Puntos Muestrales = 30 + √ N ———— – 150 1.000 4. Cálculo de diferencias significativas a) Entre dos porcentajes de una misma muestra Si p1 > p2 numéricamente, y p1 – E1 > p2 + E2 significativo realmente 391 b) Entre dos porcentajes de muestras independientes Si p1 > p2 numéricamente, y p1 – p 2 > 2 c) √ p1 q1 ——— p2 q2 + ——— significativo realmente Entre dos distribuciones Aplicar test de X2 grados de libertad = n.º de resultados – 1 Resultados F1 F2 F1 – F 2 (F1 – F2)2 (F1 – F2)2 ————– F1 A B C • • valor X2 Total ▼ Frecuencia absoluta de la muestra patrón ▼ id. de la muestra a comparar 392 Si el valor X2 es mayor que el de la tabla la diferencia puede ser significativa dejando al azar únicamente el porcentaje de probabilidades indicado en la columna de la izquierda. grados libertad d) 1 2 3 4 5 6 7 8 9 10 5% valor máx. X2 3,84 5,99 7,81 9,49 11,07 12,6 14,1 15,5 16,9 18,3 95% valor máx. X2 0,04 0,10 0,35 0,71 1,14 1,63 2,17 2,73 3,32 3,94 Entre dos medias de muestras independientes Si m 1 > m2 numéricamente, y m1 – m2 > 2 √ 2 G1 ——— n1 G2 2 + ——— significativo realmente n2 m = media G = desviación típica = e) √Σ 2 (X1 – X) ————— n Entre dos medias de muestras dependientes Si m 1 > m2 numéricamente, y G1 G2 m1 – —— > m2 + —— significativo realmente √n √n 393