El fallo de la democracia - Ciencia sin seso…locura doble

Anuncio

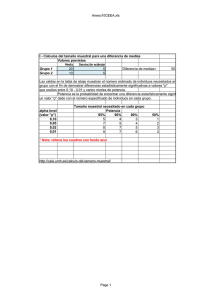

El fallo de la democracia Que nadie se preocupe que hoy no vamos a hablar de política. En su lugar, hoy trataremos de algo bastante más interesante. Hoy vamos a hablar de las votaciones en las revisiones narrativas. ¿De qué estoy hablando?. Sigue leyendo y lo comprenderás. Vamos a ilustrarlo con un ejemplo totalmente ficticio, además de absurdo. Supongamos que queremos saber si los que ven más de dos horas de televisión al día tienen más riesgo de presentar ataques agudos de caspa. Nos vamos a nuestra base de datos favorita, que puede ser TripDatabase o Pubmed y hacemos una búsqueda. Obtenemos una revisión narrativa con seis trabajos, cuatro de los cuales no obtienen un riesgo relativo mayor en los teleadictos de presentar ataques de caspa y dos en los que se encuentran diferencias significativas entre los que ven mucha o poca televisión. ¿Qué conclusión sacamos?. ¿Es o no es un riesgo ver mucha tele?. Lo primero que se nos pasa por la cabeza es aplicar la norma democrática. Contamos cuántos estudios obtienen un riesgo con un valor de p significativo y en cuántos el valor de la p no es estadísticamente significativo (tomando el valor arbitrario de p = 0,05). Qué bien, parece una solución razonable. Tenemos dos a favor y cuatro en contra, por lo que parece claro que ganan los de “en contra”, así que podemos concluir tranquilamente que el ver la tele no es un factor de riesgo para presentar ataques de caspa. El problema es que podemos estar metiendo la pata, también tranquilamente. Esto es así porque estamos cometiendo un error bastante habitual. Cuando hacemos un contraste de hipótesis partimos de la hipótesis nula de que no existe efecto. Nosotros al hacer el experimento siempre obtenemos una diferencia entre los dos grupos, aunque sea por puro azar. Así que calculamos la probabilidad de, por azar, encontrar una diferencia como la que hemos obtenido o mayor. Este es el valor de p. Si es menor de 0,05 (según el convenio habitual) decimos que es muy poco probable que se deba al azar, por lo que la diferencia debe ser real. Resumiendo, una p estadísticamente significativa existe. El problema, y ahí radica nuestro error en puesto, es que lo contrario no se cumple. Si la p es estadísticamente significativa) puede significar que pero también que el efecto sí que existe pero el potencia estadística suficiente para detectarlo. indica que el efecto el ejemplo que hemos mayor de 0,05 (no es el efecto no existe, estudio no tiene la Como sabemos, la potencia depende del tamaño del efecto y del tamaño de la muestra. Aunque el efecto sea grande, puede no ser estadísticamente significativo si el tamaño de la muestra no es suficiente. Así, ante una p > 0,05 no podemos concluir con seguridad que el efecto no es real (simplemente, no podemos rechazar la hipótesis nula de no efecto). Visto esto, ¿cómo vamos a hacer una votación contando cuántos estudios hay a favor y cuántos en contra?. En algunos de los que no se detecta significación puede ser por falta de potencia y no porque el efecto sea real. En nuestro ejemplo hay cuatro estudios no significativos frente a dos pero, ¿podemos estar seguros de que los cuatro indican ausencia de efecto?. Ya hemos visto que la respuesta es no. Lo correcto en estos casos es aplicar técnicas de metanálisis y obtener un valor resumen ponderado de todos los estudios de la revisión. Veamos otro ejemplo con los cinco estudios que veis en la figura que os adjunto. Aunque los riesgos relativos de los cinco estudios indican un efecto protector (son menores de 1, el valor nulo) ninguno alcanza significación estadística porque sus intervalos de confianza cruzan el valor nulo, que es el uno para los riesgos relativos. Sin embargo, si obtenemos un resumen ponderado, éste tiene mayor precisión que los estudios individuales, por lo que, aunque el valor del riesgo relativo es el mismo, el intervalo de confianza es más estrecho y ya no cruza el valor nulo: es estadísticamente significativo. Aplicando el método de los votos habríamos concluido que no existe efecto protector, mientras que parece probable que sí existe cuando aplicamos el método adecuado. En resumen, el método de la votación no es fiable y no debe emplearse. Y esto es todo por hoy. Ya veis que la democracia, aunque buena política, no lo es tanto al hablar de estadística. No hemos hablado nada cómo se obtiene un valor resumen ponderado de todos los estudios de revisión. Hay varios métodos que se siguen según el metanálisis aplique modelo de efecto fijo o de efectos aleatorios. Pero esa es otra historia… en de la un