Tema 3 de Teoría.

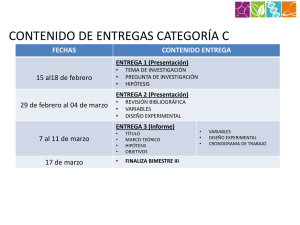

Anuncio

Tema 3. Estrategia de investigación

ÍNDICE TEMÁTICO

Psicología Experimental

Manuel Miguel Ramos Álvarez

1

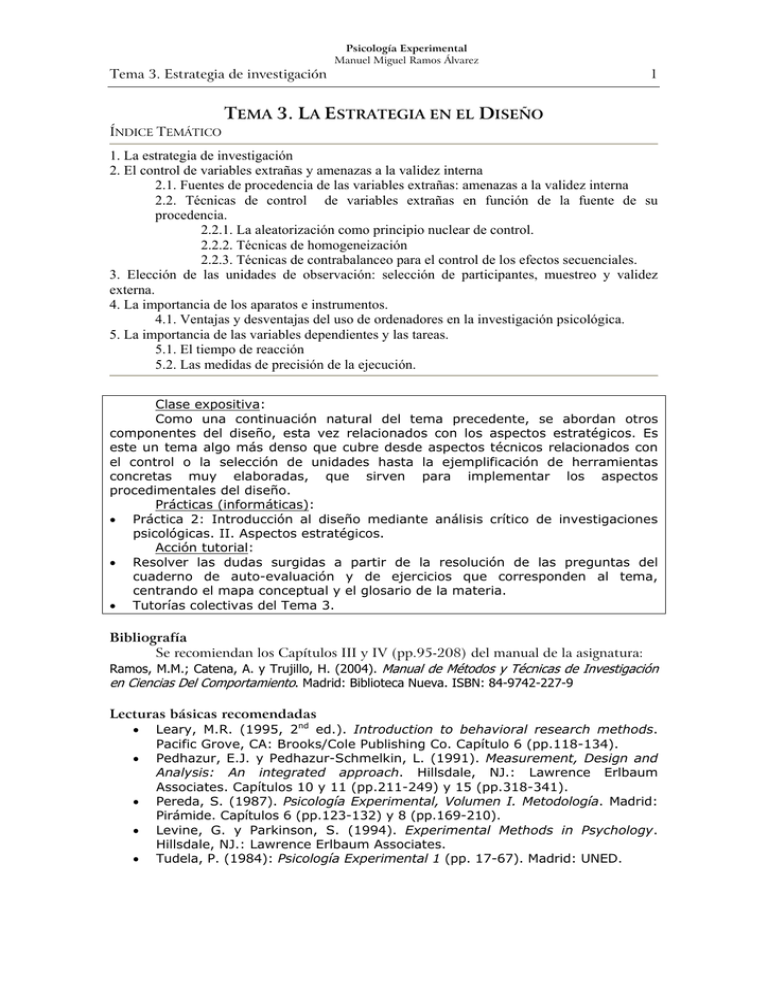

TEMA 3. LA ESTRATEGIA EN EL DISEÑO

1. La estrategia de investigación

2. El control de variables extrañas y amenazas a la validez interna

2.1. Fuentes de procedencia de las variables extrañas: amenazas a la validez interna

2.2. Técnicas de control de variables extrañas en función de la fuente de su

procedencia.

2.2.1. La aleatorización como principio nuclear de control.

2.2.2. Técnicas de homogeneización

2.2.3. Técnicas de contrabalanceo para el control de los efectos secuenciales.

3. Elección de las unidades de observación: selección de participantes, muestreo y validez

externa.

4. La importancia de los aparatos e instrumentos.

4.1. Ventajas y desventajas del uso de ordenadores en la investigación psicológica.

5. La importancia de las variables dependientes y las tareas.

5.1. El tiempo de reacción

5.2. Las medidas de precisión de la ejecución.

Clase expositiva:

Como una continuación natural del tema precedente, se abordan otros

componentes del diseño, esta vez relacionados con los aspectos estratégicos. Es

este un tema algo más denso que cubre desde aspectos técnicos relacionados con

el control o la selección de unidades hasta la ejemplificación de herramientas

concretas muy elaboradas, que sirven para implementar los aspectos

procedimentales del diseño.

Prácticas (informáticas):

• Práctica 2: Introducción al diseño mediante análisis crítico de investigaciones

psicológicas. II. Aspectos estratégicos.

Acción tutorial:

• Resolver las dudas surgidas a partir de la resolución de las preguntas del

cuaderno de auto-evaluación y de ejercicios que corresponden al tema,

centrando el mapa conceptual y el glosario de la materia.

• Tutorías colectivas del Tema 3.

Bibliografía

Se recomiendan los Capítulos III y IV (pp.95-208) del manual de la asignatura:

Ramos, M.M.; Catena, A. y Trujillo, H. (2004). Manual de Métodos y Técnicas de Investigación

en Ciencias Del Comportamiento. Madrid: Biblioteca Nueva. ISBN: 84-9742-227-9

Lecturas básicas recomendadas

• Leary, M.R. (1995, 2nd ed.). Introduction to behavioral research methods.

Pacific Grove, CA: Brooks/Cole Publishing Co. Capítulo 6 (pp.118-134).

• Pedhazur, E.J. y Pedhazur-Schmelkin, L. (1991). Measurement, Design and

Analysis: An integrated approach. Hillsdale, NJ.: Lawrence Erlbaum

Associates. Capítulos 10 y 11 (pp.211-249) y 15 (pp.318-341).

• Pereda, S. (1987). Psicología Experimental, Volumen I. Metodología. Madrid:

Pirámide. Capítulos 6 (pp.123-132) y 8 (pp.169-210).

• Levine, G. y Parkinson, S. (1994). Experimental Methods in Psychology.

Hillsdale, NJ.: Lawrence Erlbaum Associates.

• Tudela, P. (1984): Psicología Experimental 1 (pp. 17-67). Madrid: UNED.

Tema 3. Estrategia de investigación

Psicología Experimental

Manuel Miguel Ramos Álvarez

2

2.- El control de variables extrañas y amenazas a la validez interna.

•

•

•

•

•

•

•

•

•

•

•

•

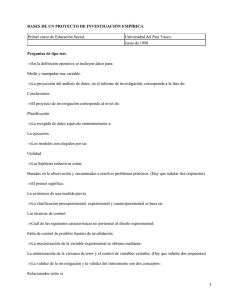

El objetivo último de la Ciencia consiste en poder llegar a proporcionar explicaciones

causales de los acontecimientos. Es decir, se trata fundamentalmente de establecer la

relación ó nexo causal que liga a un acontecimiento antecedente respecto al que

constituye el consecuente.

Entre todos los esquemas de investigación, el que permite lograr este objetivo de

manera estricta es el de tipo experimental.

Ejemplo:

Investigador educativo que desea comparar la eficacia de tres métodos de

enseñanza de habilidades de cálculo.

Se piensa que el mejor método de los tres es el que se basa en el sistema

autoformativo propio del sistema de Crédito Europeo para explicar los conceptos

fundamentales –llamémosle C, le sigue el método que alterna autoformación con

explicaciones clásicas según principios y teoremas –llamémosle B- y que el peor de

todos es el que se venía utilizando de manera tradicional, el método A, que no

utiliza para nada experiencias autoformativas.

Aplica sendos métodos a sendas aulas de una facultad y al final del curso mide el

resultado del rendimiento en Análisis de Datos.

Resultados: Al finalizar el estudio se obtuvo un rendimiento promedio de 5 puntos

para los alumnos que recibieron el método A, de 7 puntos para los del método B y de

9 puntos para los del método C.

Conclusión: A favor de la hipótesis de investigación, puesto que el mayor

rendimiento se observa con el método C, le sigue el B y el que conlleva menor

rendimiento es A.

¿Esta es la única causa que explica los resultados observados o hay otras

posibilidades alternativas?

El tipo de aula. Las diferencias observadas en el rendimiento promedio se debieran

en parte al hecho de que los alumnos de los tres tipos de aulas son diferentes. En el

aula C podrían haber estado los de mayor aptitud numérica.

Variables relevantes extrañas o fuentes de confusión y son amenazas potenciales

a la validez interna. El criterio de validez interna hace referencia, como ya se indicó,

al nexo causal entre las variables de la investigación; de manera que a mayor certeza

sobre dicha conexión o explicación causal mayor validez interna asociada al diseño.

El control constituye la vía para conseguir que la investigación tenga validez interna.

Neutralizando el aula como factor alternativo. Por ejemplo, supongamos que

seleccionamos a un tercio de los niños de cada una de las tres aulas y les aplicamos

cada uno de los tres métodos. Razonemos esto con más detenimiento.

Tema 3. Estrategia de investigación

Psicología Experimental

Manuel Miguel Ramos Álvarez

3

Rendimiento Estadística

2.- Ejemplificación de los principios de control

10

8

6

Método

Otros

4

2

0

M.A

M.B

M.C

Método enseñanza

Rendimiento Estadística

¾ Los incrementos en rendimiento no se explican por el método sino más bien por la

intervención de otros factores.

10

8

6

Método

Otros

4

2

0

M.A

M.B

M.C

Método enseñanza

¾ Ahora, las diferencias en rendimiento se deben a las variaciones en el tipo de método

(la porción oscura superior de cada uno de los histogramas) y no a los otros factores

puesto que la intervención de estos es la misma a través de las medidas de

rendimiento (los tres histogramas contienen una proporción equivalente de este

factor).

¾ Estos ejemplos ilustran el principio fundamental de la neutralización de variables

extrañas: se trata de repartir por igual la influencia de las mismas a través de

los diferentes niveles de la variable independiente manipulada, para evitar que

constituyan una fuente de confusión con respecto a la variable independiente.

¾ El error de medida o la fiabilidad de los instrumentos atañe a otros aspectos

del diseño más que a la validez interna.

Tema 3. Estrategia de investigación

Psicología Experimental

Manuel Miguel Ramos Álvarez

4

2.1.- Fuentes de procedencia de las variables extrañas: amenazas a la validez

interna (CUADRO 3.1. Las variables extrañas según su origen)

PARTICIPANTES

SITUACIÓN

Estables.

Ambientales

Situación o contexto

experimental.

Características de la

demanda

Experimentador

Tarea

Motivación.

Inestabilidad por

fluctuaciones menores

Historia.

Maduración

Sesgo de selección

diferencial.

Pérdida de participantes

[Rol de “sujeto experimental”

e interpretación y reacción

ante los tratamientos].

[Regresión media].

Procedimiento

INHERENTES AL DISEÑO

Efectos secuenciales

de orden y de transferencia

Error progresivo: Práctica,

fatiga.

Instrumentación

[Efecto reactivo a la medida

pre]

2.1.- Fuentes de procedencia de las variables extrañas: amenazas a la validez

interna (CUADRO 3.2. Principales amenazas contra la validez interna)

A) ORDEN CAUSAL AMBIGUO

B) SELECCIÓN

C) HISTORIA

D) MADURACIÓN

E) REGRESIÓN A LA MEDIA

F) PÉRDIDA DE PARTICIPANTES (ATRICIÓN)

G) REACTIVO DE LA PRUEBA

H) INSTRUMENTACIÓN

I) EFECTOS ADITIVOS O INTERACTIVOS

Tema 3. Estrategia de investigación

Psicología Experimental

Manuel Miguel Ramos Álvarez

5

2.2.- Técnicas para el control de variables extrañas en función de la fuente

procedencia

FUENTE

Participantes

Situación

Diseño

MANIPULACIÓN

Intrasujetos

Entregrupos

Intrasujetos

Entregrupos

Intrasujetos

Entregrupos

TÉCNICA CONTROL

[automático]

de homogeneización

de homogeneización

de homogeneización

contrabalanceo

----------------

Tema 3. Estrategia de investigación

Psicología Experimental

Manuel Miguel Ramos Álvarez

6

2.2.1.- La aleatorización como principio nuclear de control.

•

•

•

¿Cómo se podría lograr el principio general de equiparación o distribución uniforme

de las variables extrañas o fuentes de confusión a través de los niveles de la variable

manipulada?

Una de las formas más elementales de lograr esto consiste en asignar completamente

al azar tales fuentes a los tratamientos.

A partir de aquí podríamos diferenciar dos niveles de control: en un nivel inicial se

situaría el que se ejerce expresamente sobre variables extrañas concretas y en un nivel

superior se situaría el control mediante el azar que pretende el control de las variables

no conocidas.

Escaso control

Control sólo de Nivel I

NO EXPERIMENTAL

CUASI-EXPERIMENTAL

-

Control completo

Nivel I. explícito.

Nivel II. Por aleatorización

EXPERIMENTAL

+

INFERENCIAS CAUSALES.

Descartar Interpretaciones

alternativas

Métodos de aleatorización.

• Tabla de números aleatorios como la que se puede encontrar en muchos manuales

especializados de análisis estadístico (v.gr. San Martín y Pardo, 1989)

• Mediante funciones sencillas que hoy día incluyen muchos programas informáticos

que tienen que ver con el análisis estadístico (desde programas sencillos como Excel a

los más especializados como SPSS).

• Otras pruebas más sofisticadas, de las cuales se puede encontrar una revisión en

Algarabel y Sanmartín (1990) o más recientes en Shadish et.al. (2001).

Tema 3. Estrategia de investigación

Psicología Experimental

Manuel Miguel Ramos Álvarez

7

2.2.2.- Variantes de la técnica de Homogenización para el control de variables

extrañas.

•

•

•

Aleatorización

Constancia

Igualación

o Bloqueo

o Balanceo

o Bloqueo aleatorio, Cuadrado Latino y Cuadrado Grecolatino.

o Emparejamiento y estratificación.

Constancia

• Para lograr el objetivo general hacemos que las vvee adopten el mismo valor en el

experimento. Así lo que era originalmente una variable se ha convertido en una

constante y por tanto no puede explicar las diferencias que se observaran en la vd.

• Es la variante más usual con variables extrañas procedentes de la situación (i.e.

temperatura, iluminación, ruido) pero la más inadecuada con variables de los

participantes.

o Si se aplica sobre fuentes de los participantes, puede llevarnos a agotar la

muestra, dejándonos sin personas disponibles por tantas imposiciones.

o Se pierde información sobre el efecto que podrían introducir las supuestas

variables extrañas. Es decir, nunca sabremos si efectivamente dichas variables

eran o no relevantes a fin de cuentas.

o Decrementa el grado de generalidad de los resultados, es decir en contra de la

validez externa.

o Se queda al nivel inicial de control, es decir no se consideran todas aquellas

fuentes de confusión que están por determinar.

Igualación-Bloqueo

• El objetivo es bloquear –neutralizar- a la ve manteniendo los diferentes valores de la

ve en la misma proporción a través de los niveles de la vi. Esto no implica que los

porcentajes tengan que ser equivalentes en la ve.

Igualación-balanceo

• Un caso especial del bloqueo cuando respetamos la distribución que se cumple en la

población de referencia. Esto nos permite ganar en validez externa.

Igualación- Bloqueo aleatorio

• Es también un caso especial del bloqueo para vvee cuantitativas que opera en dos

pasos.

1) Para homogeneizar a los niveles de la vi respecto a la ve de interés, ordenamos los

valores de la ve en un conjunto de bloques -cada uno con tantos individuos como

valores tenga la vi2) Aleatorizamos a los individuos dentro de cada bloque para reasignarlos al azar a

cada nivel de la vi manipulada. Así garantizamos también el control de otras vvee no

conocidas.

Tema 3. Estrategia de investigación

Psicología Experimental

Manuel Miguel Ramos Álvarez

8

2.2.2.- Variantes relacionadas con el bloqueo.

Las técnicas de emparejamiento o estratificación se refieren a las técnicas de control por

igualación-homogenización, de manera que los estratos son muy similares a los Bloques

que surgen de las variantes que se acaban de exponer.

• Estrictamente el emparejamiento (matching) se refiere a la igualación aplicada en

términos extremos, donde las puntuaciones de cada bloque o estrato son

prácticamente idénticas, mientras que en bloqueo las puntuaciones de cada estrato

son similares pero no idénticas.

• La estratificación también es similar a bloqueo, pero donde hay más unidades de

observación que niveles de la variable independiente, luego cada bloque se puede

entender como un estrato ligeramente diferente de otros y de ahí el nombre

alternativo.

Tema 3. Estrategia de investigación

Psicología Experimental

Manuel Miguel Ramos Álvarez

2.2.3. Razonamiento sobre los efectos secuenciales.

9

Tema 3. Estrategia de investigación

Psicología Experimental

Manuel Miguel Ramos Álvarez

2.2.3. Razonamiento sobre los efectos secuenciales.

10

Tema 3. Estrategia de investigación

Psicología Experimental

Manuel Miguel Ramos Álvarez

11

2.2.3. Técnicas de contrabalanceo para el control de los efectos secuenciales

(CUADRO 3.6. Tipos de contrabalanceo)

A) CONTRABALANCEO INTRASUJETO:

Se emplea una secuencia en la que los niveles aparezcan en imagen especular, con

objeto de contrarrestar los efectos secuenciales, en concreto sirve cualquiera de las

secuencias que aparecen a continuación o una mezcla de las mismas:

Orden: 1º 2º 3º 4º

Sec.1: a1 a2 a2 a1

Sec.2: a2 a1 a1 a2

B) CONTRABALANCEO INTRAGRUPO COMPLETO:

El control queda garantizado por la utilización de las a! secuencias posibles. Con a=3

niveles de variable independiente se necesitan 3!=3x2x1 = 6 secuencias.

C) CONTRABALANCEO INTRAGRUPO INCOMPLETO:

El control queda garantizado mediante el algoritmo de D’amato y “a” secuencias para

un número par de niveles ó “2a" secuencias para un número impar de niveles. Se logra

que todos los niveles aparezcan en todos los órdenes posibles el mismo número de

veces.

Tema 3. Estrategia de investigación

Psicología Experimental

Manuel Miguel Ramos Álvarez

12

3.- Delimitación de las unidades de la investigación: selección de participantes,

muestreo y validez externa.

CUADRO 3.8. Amenazas a la validez externa: Razones por las que pueden ser

incorrectas las inferencias sobre cómo los resultados de los estudios podrían

mantenerse a través de variaciones en personas, contextos, tratamientos y

resultados

a.

b.

c.

d.

e.

•

•

•

•

Interacción de la relación causal con las unidades de observación

Interacción de la relación causal con las variaciones en el tratamiento

Interacción de la relación causal con las variables dependientes

Interacción de la relación causal con los marcos contextuales

Mediación dependiente del contexto

La aleatorización una vez más, pero referida a la selección de los parámetros de la

investigación más que a la asignación de las mismas: selección de la muestra de

unidades (i.e. participantes), unidades, tratamientos, efectos y contextos.

Si algún parámetro es especialmente importante desde el punto de vista del modelo

teórico que guía la investigación, se podrían aplicar las recomendaciones generales

respecto al control de variables. Para los parámetros más relevantes sería preferible

una especie de “bloqueo aleatorio”.

Obviamente el tipo de estudio que se ha sugerido es con frecuencia poco viable por

los recursos que conlleva. Especialmente, la representatividad de la muestra es algo

que se lleva a cabo en pocas investigaciones de nuestro campo, a pesar de que

constituya un aspecto importante. Así, es más frecuente este planteamiento en

investigaciones realizadas en contextos aplicados y unido sobre todo a cierto tipo de

diseños, fundamentalmente el de encuestas.

En el esquema experimental la aproximación es diferente: los factores que pueden

alterar el grado de generalidad se estudian de manera explícita. Es decir, las muestras

son seleccionadas de una manera deliberada más que aleatoria, y por lo tanto la

generalidad sólo se puede lograr mediante la realización de series experimentales.

¾ Repasar las técnicas de muestreo

Tema 3. Estrategia de investigación

Psicología Experimental

Manuel Miguel Ramos Álvarez

4. La importancia de los aparatos e instrumentos

•

•

Gran diversidad de instrumentos de investigación en el campo de la

Psicología: tests y cuestionarios, cajas de condicionamiento, ordenadores o

técnicas de registro de actividad cerebral.

Enfoque: Diferentes aparatos permiten el estudio de diferentes aspectos del

comportamiento.

•

Ejemplo: el procesamiento de información no consciente, que se presenta por

debajo del umbral de conciencia, percepción subliminal.

•

El uso de proyectores estroboscópicos y sobre todo de taquistoscopios mejoró

considerablemente la presentación de estímulos, pero los procedimientos

experimentales seguían teniendo limitaciones importantes.

Los ordenadores resolvieron definitivamente las limitaciones anteriores.

o Su estructura (hardware) : unidad central de procesamiento (CPU)

que tiene bajo su control un conjunto de elementos, entre los que

destacan la memoria del sistema, y un conjunto de mecanismos de

Entrada/Salida (E/S) como discos fijos y removibles, tarjeta gráfica y

monitor, teclado, ratón, micrófonos, altavoces, impresora, etc.

o Funcionan ejecutando programas (software) que pueden estar

escritos en diferentes lenguajes de programación, que difieren en su

nivel (código máquina, ensamblador y C pueden ser considerados de

bajo nivel, y Prolog, Pascal, Basic, sean visuales o no, pueden

considerarse de alto nivel) y en su estructuración (ensamblador,

Pascal y Visual Basic son estructurados, pero no Basic, por ejemplo).

•

13

Tema 3. Estrategia de investigación

Psicología Experimental

Manuel Miguel Ramos Álvarez

4.1.- Ventajas y desventajas del uso de ordenadores

Ventajas

• La complejidad del diseño experimental que permiten. Con un instrumental

relativamente barato es posible:

o utilizar simultáneamente estímulos visuales, auditivos, táctiles, etc.,

o controlando todos los aspectos relativos al tiempo de inicio,

finalización, duración, intensidad, etc.;

o controlar cajas de condicionamiento de manera que en cada una de

ellas se esté realizando simultáneamente un procedimiento diferente;

o registrar conjuntos de respuestas diferentes a distintos sujetos (o al

mismo sujeto); controlar la extensión de lesiones, etc.

• Permite investigar con una resolución temporal suficientemente buena para

la gran mayoría de las investigaciones en casi todas las áreas de la Psicología.

Precisión cercana al milisegundo.

• Permiten un elevado grado de control experimental. Puede eliminar la

influencia del experimentador, y de las interacciones sujeto-experimentador.

• Cuando el procedimiento tiene que cambiar en función de la ejecución del

sujeto.

• Con los periféricos adecuados pueden sustituir a prácticamente cualquier

instrumento de investigación, y permiten almacenar cantidades ingentes de

datos.

•

•

•

Desventajas

Aunque baratos en su configuración básica, son instrumentos caros, cuando se

consideran los periféricos que permiten realizar la investigación de calidad. Por

ejemplo, en el ámbito de la neuroimagen por encima de 2-3 millones de euros.

La preparación de los programas para llevar a cabo los procedimientos de las

investigaciones.

o Pueden ya estar preparados por empresas (por ejemplo, el registro de

EEG mediante Neuroscan).

o En bastantes ocasiones es el propio investigador quien tiene que

escribirlos.

o Destacar programas que permiten diseñar una gran variedad de

estudios con un bajo coste de aprendizaje (e-prime, Psyscope, …)

La aplicación automática de los procedimientos puede privar al investigador de

observar a sus participantes mientras realizan la tarea. Por ejemplo, si los sujetos

se distraen durante la realización de la misma.

14

Tema 3. Estrategia de investigación

Psicología Experimental

Manuel Miguel Ramos Álvarez

15

5. La importancia de las variables dependientes y las tareas. A- Introducción a las

variables dependientes.

La variable dependiente debe cumplir tres propiedades: Fiabilidad, validez y

sensibilidad.

FIABILIDAD.

• La variable dependiente debe ser medida de manera fiable, especialmente cuando

lo que interesa es su valor absoluto. Por ejemplo, la latencia de frenado de un

conductor: determinar exactamente cuánto tiempo es necesario para que el

conductor pise el freno contando desde el momento en que se presenta la señal

adecuada.

• Depende de manera crucial del instrumento de medida de que se disponga.

• Desde un punto de vista relativo, para comparar medidas. Por ejemplo, comparar

las latencias de frenado de un grupo de personas cuya tasa de alcohol en sangre

supera el máximo legal con la de un grupo que no ha consumido alcohol. La

fiabilidad de la medida afecta en tal caso en dos sentidos:

o El tamaño o magnitud del efecto (ES) hace referencia a la relación

entre la medida del efecto y la del error.

o La potencia del test estadístico, que hace referencia a la probabilidad

de no detectar un efecto real.

Que se relacionan de manera lineal: Ef Observ = Ef Re al

o

Fiabilidad

Incremento en fiabilidad debe traducirse en un incremento en

potencia, pero también implica que cualquier cambio en fiabilidad

que se traduzca en un incremento de la varianza de las

puntuaciones llevará aparejada una disminución de la potencia.

VALIDEZ.

• Especialmente “validez de constructo” según la teoría clásica de tests. Por

ejemplo, la actividad eléctrica de la piel es una medida válida de ansiedad en

tanto en cuanto los cambios en ansiedad produzcan cambios en la actividad

electrodermal.

• La variable dependiente es válida si su valor depende del constructo al cual se

supone que afecta la variable independiente.

SENSIBILIDAD.

• Una variable dependiente puede ser válida, pero aún así ser la causante de un

resultado nulo si carece de sensibilidad. La sensibilidad hace referencia al

tamaño del cambio en el constructo que es necesario para que se produzca un

cambio en la variable dependiente.

• Las variables dependientes producen una limitación importante en el rango y

tipos de teorías que permiten construir.

•

Se abordarán dos de las más representativas: El tiempo de reacción y la

precisión de la ejecución.

Tema 3. Estrategia de investigación

Psicología Experimental

Manuel Miguel Ramos Álvarez

5.1.- El tiempo de reacción

Definición de la variable:

• El tiempo que transcurre desde el momento en que aparece el estímulo hasta

el momento en que se inicia la respuesta correspondiente al mismo.

• La adecuación entre la respuesta y el estímulo suele establecerse de manera

arbitraria. Por ejemplo, presionar la tecla “C” cuando se presente una vocal en

la pantalla del ordenador.

• Habitualmente las instrucciones indican al participante cuya velocidad de

respuesta pretende medirse que procure responder con la mayor rapidez y

precisión posibles.

Métodos o tareas más representativas:

El método sustractivo de Donders.

• Diseñar varias tareas que difiriesen de forma mínima en el número de

procesos implicados. La comparación entre dichas tareas permite inferir

cuánto se tarda en realizar cada proceso en el que difieren las tareas.

Comparar TR simple, de elección y selectivo.

• Valoración: en realidad implica varios supuestos que no son estudiados

expresamente: Serialidad, independencia de los tiempos, Aditividad y Pura

inserción.

• Desarrollos recientes: comparar dos tareas que, supuestamente, difieran sólo

en el proceso de interés. La diferencia entre el mapa de actividad de ambas

revelará qué área cerebral es la encargada de llevar a cabo ese proceso.

El método de factores aditivos de Sternberg.

• Estrategia: manipular variables independientes en lugar de comparar tareas

diferentes. La diferencia en el tiempo de reacción entre las diferentes

condiciones experimentales estaría indicando no tanto el tiempo necesario

para realizar el proceso cuanto su cualidad de funcionamiento.

• Valoración: Soluciona los dos problemas centrales del método sustractivo: la

aditividad de los tiempos invertidos en cada proceso y la pura inserción. Pero

presenta problemas en la lógica (ver Broadbent) de interpretación de las

interacciones y de la ausencia de las mismas, con respecto al funcionamiento

cognitivo.

• Desarrollos recientes: Su uso en relación con las estructuras anatómicas que

están encargadas de realizar los procesos. Sustrayendo las imágenes de

actividad cerebral correspondientes a dos condiciones de semejanza deberían

eliminarse las zonas encargadas de procesos a los cuales no afecta la

manipulación (por ejemplo, relacionadas con la respuesta), y resaltar las zonas

encargadas de realizar el proceso de interés.

16

Tema 3. Estrategia de investigación

Psicología Experimental

Manuel Miguel Ramos Álvarez

17

5.1.- Opciones de análisis para las medidas de Tiempo de Reacción

1) Los procesos producen una distribución normal, pero durante la tarea intervienen

una serie de variables incontrolables (distracción del sujeto, parpadeos, etc.) que

alargan algunos de los tiempos de reacción. Luego, eliminar esos tiempos anómalos.

Medias recortadas. Si se eliminan datos (usualmente en los extremos) para buscar la

normalización, la media que se obtiene en ese caso se califica como recortada.

• Medias recortadas con punto de corte fijo.

• Medias recortadas con punto de corte variable.

• Media semi-recortada.

Medias ponderadas. Se calcula un peso o ponderación para cada tiempo como una

función inversa de la distancia de la puntuación a alguna medida de tendencia central

(media o mediana).

Transformaciones de los tiempos. Resolver el problema de la asimetría mediante

alguna clase de transformación que normalice los datos originales, necesariamente no

lineal, y por tanto, cabe el peligro de que se pierda información sobre los procesos

subyacentes a la tarea.

• Mediana.

• Media geométrica.

• Media armónica.

2) Se asume que los procesos de los que depende la variable dependiente producen esa

forma de distribución, por lo que el análisis de datos debería considerar todos los

parámetros necesarios (la media y desviación típica de la normal y la media de la

exponencial).

•

•

La distribución ex-gaussiana es de las más destacadas, para explicar la distribución

observada de tiempos en tareas en las que se asume dos etapas de procesamiento.

La función de densidad de la ex-gaussiana queda caracterizada por tres parámetros,

dos relativos a la distribución normal, la media (μ) y la desviación típica (σ), y otro

relativo a la exponencial, la media (τ).

Tema 3. Estrategia de investigación

Psicología Experimental

Manuel Miguel Ramos Álvarez

18

5.2. Las medidas de precisión de la ejecución. Definición

Definición de la variable:

¾ Interés en la precisión con la que se realizan tareas, que implica un criterio

preestablecido que permite determinar si el sujeto ha respondido correctamente o

no.

¾ La tarea consiste en indicar si se ha presentado (por ejemplo, diciendo SI) o no

un determinado estímulo en cada uno de los ensayos.

Variantes:

Tareas psicofísicas clásicas o uniprocesuales.

• El estímulo se presenta en todos los ensayos y hay que indicar si el estímulo se ha

presentado o no. Esto es, si ha detectado o no la presencia del estímulo.

• Supuesto: la respuesta refleja de manera directa los resultados del único proceso

supuesto entre Estímulo y Respuesta, que en el caso de tareas psicofísicas sería el

sensorial o de detección.

• Problema: TTAA pueden haberse debido en parte a factores no sensoriales, sino

estratégicos.

Tareas psicofísicas modernas o biprocesuales.

• Se asume que la respuesta no refleja directamente el resultado del proceso

sensorial, sino que es preciso añadir un segundo proceso, decisor, que recibe una

entrada procedente del sensorial, pero que dependía de las estrategias, motivación

e intereses del sujeto, y que se encarga de decidir la respuesta.

• Cambio en la tarea: Introducir además de los ensayos en los que se presenta el

estímulo (llamados ensayos con señal, SR), otro conjunto de ensayos en los que el

estímulo no está presente, llamados ensayos en blanco o ensayos de ruido (R).

• Ahora los resultados de la respuesta del sujeto pueden ser cuatro según aparecen

en la matriz de confusión, con solamente dos resultados que proporcionan

información no redundante, i.e. TA y TFA.

TA ≡ P(SI/SR) =

a

b

y TFA ≡ P(SI/R) =

a+c

b+d

Tema 3. Estrategia de investigación

Psicología Experimental

Manuel Miguel Ramos Álvarez

19

5.2. Las medidas de precisión de la ejecución. Estimación de los parámetros

asociados a la precisión

Teorías de Umbral.

• p nos indica la probabilidad de que se produzca una sensación, un índice puro

de la sensibilidad del sistema sensorial sin contaminaciones del segundo

proceso.

• g indica la tendencia a adivinar y es independiente de la sensibilidad.

• Las estimaciones se realizan mediante un árbol de probabilidades.

p=

TA

{=

Y

TA − TFA

1 − TFA

g=TFA

p{ + (1 - p) TFA

123 {

X

P .origen

Pendiente

β0

β1

Teoría de Detección de Señales

• La precisión (d’) y el criterio se computan a partir de las dos tasas, según la

teoría probabilística Bayesiana.

• d’ es la distancia entre las medidas de localización (las medias) de las dos

distribuciones expresada en unidades típicas. d ' =

•

d ' = Z TFA − Z TA . Para ello se emplea la distribución normal.

El criterio de respuesta es un cociente entre dos verosimilitudes, una

correspondiente a la señal y otra al ruido:

β=

•

μ SR − μ R

. En la práctica,

σR

YzTA

YzTFA

β=

p( s c / SR)

, en la práctica:

p( s c / R)

. Obtener los valores de ordenada correspondientes a las zz según la

Normal.

Característica fundamental: Habilidad para separar la precisión del individuo

(d’) de sus sesgos de respuesta. Ambos parámetros son independientes.