Obtención simultánea de multicolinealidad y observaciones

Anuncio

r

ESTADISTICA ESPANOLA

Vol. 30, Núm. 1 17, i 98$, págs. 83 a 98

Obtención simultánea de multicolinealidad y

observaciones influyentes

SANTIAG O VELI LLA CER DAN

Dpto. de Estadística e I nv. Operativa

Facultad de CC. Matemáticas - Uníversidad Complutense

Ciudad Universitaria - 28040-Madrid

RESUMEN

En este artículo se describe un método de obtención simultánea de multicolinealidad e influencia en regresión lineal. EI método está basada en técnícas de análisis de condición aplicadas

sobre determinadas perturbaciones de la matriz de diseño. EI

comportamiento del método se ilustra con un ejemplo práctica,

Palabras clave: Análisis de condición, diagnósticas,

^olinealidad, observaciones influyentes.

multi-

Clasificación A.M.S.: 62J05

INTRODUCCION

Sea el modelo lineal de regresíón múltiple

Y=X f^+^

en el que Y es un vector nx1 de respuestas, X es una matriz nxm de

constantes conocidas, ^ es un vector mx 1 de parámetros y E es un vector

nx 1 de errores para el que se supondrán las hipótesis usuales E(F) = 0 y

EST =^[)iS7 I( ^ ^1 EtiP> ^^Ol.. ^

K -^

V(F;) -= ^' I„ . La matriz X será siempre de rango completo y con término

indepe^,Jiente de modo que X=(1 ^, X,) donde 1 ^ es un vector nx 1 de

coordenadas unitarias y X, es una matriz nxp. Por tanto, m=p+1, convenio

de constante utilización en este trabajo. EI ajuste de (1,1) por el método de

mínimos cuadrados es una herramienta estadística de aplicación universal

que, pese a su relativa sencillez, esté lastrada por varios incomenientes de

carácter práctico.

En este sentido, dos de las principales fuentes de distorsión en los

resultados de un anélisis mínimo-cuadrático de (1.1) son la mu/tico/ínea/idad entre las columnas de ia matriz X y la aparición de oóservaciones

influyentes dentro de! conjunto de datos. Tradicionalmente, ambos problemas se tratan por separado debido a sus diferentes orígenes y característícas.

EI propósíto de este trabajo es proponer un método de abtención simultánea de ambos problemas. En la sección 2 se establece la notación y se

presenta la motivación subyacente al método. La sección 3 contiene los

resultados teóricos que fundamentan el denominado método reducido aplícable, únicamente, a la detección de multicolinealidad y casos extremas. En

la secciór^ 4, esta teoria se aplica al estudio de un ejemplo numérico. La

sección 5 extiende el método reducido al método general y la sección 6

contiene los comentarios finales.

2.

MOTIVACION

Como es sabido, la multicolinealidad o, en palabras sinónimas, colinealidad

o mala condicion se refiere a la existencia de dependiencias lineales aproximadas entre las variables regresoras del modelo. Esta situación tiende a

provocar la aparición de problemas de ínestabilidad

numérica y estadística

^

en el estimador mínimo-cuadrático usual ^ y, como consecuencía directa, la

disminución de la eficacia y fiabilidad de los mínimos cuadradas lineales. La

multicolinealidad es un problema muy complejo que puede aparecer par

distíntas razones y, a su vez, puede producir diversos efectos perjudiciales.

Interesantes referencias son los trabajos de Belsley, Hush y Welsch (1 982)

y Gunst (1983).

Desde el punto de vista de esta exposición es interesante centrarse, brevemente, en la detección del problema mediante los Ilamados diagnóstícos

que actúan como indicadores del grado de condición de fos datos. EI modelo (1.1) puede reescribirse en la forma

Y = 1„ ao+Z a+E

(2.1)

ó^

tJEiTEtiC'IOti SIM(;LTA^fEA DE Mt'L.TIC'(^LItiEALIDAD

donde Z es la matrii nxp de datos tipificados. Por diversas razones se considera más conveniente analizar !a multícolinealidad entre las columnas de

Z que entre las columnas de la matriz original X. Dos clases de diagnóstico

interesan fundamentalmente en este trabajo.

Sea Z'Z la matriz de correlaciones asociada al modelo (1.1). Los factores

de inflación de la varianza son los elementos diagonales de la inversa

(Z'Z)^'

VIF^=z^^ (^ _ /, . . . , p) .

(2.2 )

denotados VI F en virtud de sus iniciales en inglés ( variance inflation factor).

EI nornbre obedece a la representación var (rz^) _^ z^^ = a2 VI F^ . Los factores

(2.2) se deben a 11l^arquard (1970).

Es reconocido que los diagnósticos más eficaces son los que proporciona

la descomposición espectral de la matríz de correlación

Z'Z = G D C'

( 2. 3)

En {2.3), C=(;^, ,..., yP ) es una matriz ortogonal pxp de autovectores normalizados y D= diag ( a^, ,..., a.p ) contiene, en su diagonal, los autovalores

de Z'Z en sentido creciente (0 ^ ^., < ^2 <. . . < ^p ). Sean Z = (z, , . . . , zp ) y

, ). Puestoque ^. ,^ _ ,^^^ Z'Z ,^; = ^) Z i;^ ^^ ?, cuando a., ^ ^ 0 es '"

Y; _ (^k;

Z^;=,^,;z, +. . . . . . + ^^P;rP o

(2.4)

Así, en virtud de 12.4), cuando a.^ es pequeño se tíene una multicolinealidad

descrita por las coordenadas altas del autovector norma^izado correspond'+ente y^^ .

Fínafinente, otros diagnósticos relacionados con el autosistema son Ios

índices de condición r^k =(^p /,^.k )^ (k = 1,..., p) de los cuales el más

importante es el número de condición k(Z) = r^, . Estos indices, de carácter

originalmente numérico, se deben a Belsley, Kuh y Welsch (1982).

Por otro lado, es conocido que los resultados de un análisis mínimocuadrático pueden depender fuertemente de una observación o reducido

grupo de observaciones. La palabra observación engloba la estructura cor^junta (x; , Y; ) formada por la r-ésima fila de la matriz de diseño x; y la

i-ésima respuesta Y;. Se juzga que una observación es influyente cuando

su eliminación del conjunto de datos altera sustancialmente los resultados.

La influencia de una observación puede proceder de cada una de sus

partes cornponentes, Así la respuesta Y; puede tener un carácter aberrante o«outlier» lo que tiende a provocar la aparición de un valor anómalo

del correspondiente residual mínimo-cuadrático e; = Y, -- x'; (3. Sea

V= X(X'X)^' X' _(v,; ) la matriz de proyección sobre la variedad lineal enw

ES^TAD[STIC'A ESPAÑULA

gendrada por las columnas de X. Puesto que, bajo el modelo {1.1), var{e;} _

rr2 (1-v;; } es conveniente consíderar una adecuada tipificación de e; para

evitar problemas de varianza no constante y, asi, una herramienta importante en la detección de c<outliers» es el residual estudentizado interno

r; _

(2.5}

Q (1_v„)^

donde Q es el estimador usual de la desviación típica.

De acuerdo con !a partición X= f 1 ^, X, ) es x; =(1,x;, ) donde x;, es de px 1.

Puede ocurrir que x;, esté alejado del centroide x de las variables regresoras

lo que suele calíbrarse por !a magnítud del correspondiente elemento diagona! v;; de la matriz de proyeccíón V. Sean .^ la matriz nxp de datos centrados asocíada a(1.1) y z; !a i--ésima fíla de la matriz Z de {2.1 }. Se prueba

que

1

_ ^ , _^

_

v;; _-+ tx;, - x J rz Z} (x;^ - x l=

n

(2.6)

1

-- - + z; ^Z'Z )"' z;

n

(2.7)

Por tanto, según {2.6), v-^

,^ a x relativa a la matriz. de

„ --^^ es la distancía de x.

producto escalar {Z'Z)-'. Hoaglin y Welsch t 1978) recomiendan declarar la

fiia extrema cuando v;; > 2m/n. Se hablará de v;; como del potencia/ de !a

observación i-ésima.

La investigación de! problema se ha centrado en la elaboracíón de medidas de la influencia de una observación que combinan, en su mayoría, información procedente del bloque básico (r, , v;; ^. E! libro de Cook y Weisberg (19$2) es, en este contexto, un manual de referencia fundamental.

Tras este breve resumen de los dos problemas que componen el título de

este trabajo parece estar justificado que, tradicianalmente, los problemas

de colinealidad y#ilas extremas se traten independientemente. Hablando en

términos informales la multicolinealidad haría referencia a una perturbación

relativa a!as columnas de la matriz de diseño mientras que la aparíción de

filas extremas sería un problema referente a!a estructura de filas de dicha

matriz. Ei objetivo de esta investigación es presentar un método de detección simulténea de ambos problemas basado en !a aplicación de técnicas

de análísis de condición a determinadas modificaciones de la matriz de diseño tipificada Z.

OBTENCION SIMCJLTANEA DE MULTICOLINEALtDAD

$i

Considérese la familia de matrices nxm.

Z;=(Z.d;) (i=1,...,n)

(2.8^

(i)

donde d; _{O ,..., 1,..., 0} es el i--ésimo vector canónico de R". Dada la

estructura del vector d; es raionable suponer que las cOlínealidades en Z; y

Z estén relacionadas. Más remarcable aún es el hecho de la existencia de

una dependencia entre diagnósticos de Z; y el potencial de la observacidn

i-ésima. En efecto, sean Vz = Z(Z'Z1^' Z' la matriz de proyección ortogonal

sobre la variedad lineal engendrada por las columnas de Z,C(Z),VZ d; = Zc; ,

donde c; es de px 1, y v;; {z) ^ z,' (Z'Z)-' 2; . EI cuadrado de la distancia de d; a

C{Z) es

^^ d;-Zc; ^^ 2= ^Í d;-Vz d; ^^ 2= 1--v;; (z)

(2.9)

Según {2.9} una fila extrema provoca la aparición de una dependencia !ineal aproximada entre las columnas de Z; . En resumen, cabe esperar que el

análisis de colinealidad en Z; proporcione información simultánea sobre la

colinealidad en Z y sobre los potenciales v;; {z). Una observación importante

es que, por construcción, las matrices Z; tienen columnas de longítud unitaria

.

En la sección 5 se extiende esta motivación a la familia de matrices de

nx(r»+1)

Z*= {Z*,al; }

{i = 1 , . . . , n)

(2.^0)

donde Z* es de forma (Z,y), siendo y el vector de respuestas tipificadas. La

idea es usar el análisis de colinealidad sobre ias matrices {2.10) con el fin

de detectar colinealidad en Z y observaciones influyentes bien por su carácter extremo o bien por su carácter «outlier».

3.

ANALISIS DE CO LI N EALI DAD EIV Z;

Esta sección se divide en dos partes claramente diferenciadas. En la

primera parte, se obtienen resultados teóricos que, en la segunda, se emplean para desarrollar un método práctico esquemati2ado en etapas para

un análisis simultáneo de la colinealidad en Z y ios potenciales de las

observaciones.

3.1 Resultados teáricos

Sean i^ {1 ,..., n} fijo. En virtud de (2.8) la matriz mxm de productos

cruzados Z; Z; presenta la estructura

$ i'^

ESTA>JtSTlc^a ESPatiOLA

(3.1 }

1

dande z; es la i-ésima fila de la matriz Z. Es f^cil probar que (3.1) es

definida positiva. Los dos diagndsticos más importantes de la condición de

Z: son los factores de inflación de la varianza y ei autosistema de (3.1 }.

3.1.1 Factores de inflación de la varianza

Se denatarén por VIF^, {j i 1,.,., p} los p primeros factores de (3.1 } y por

VI F' el último. Sea a, _(Z'Z}^' z, . En virtud de expresiones (A.1 } y(A.2 } de!

apéndice relativas a la inversa (Z; Z, }-' se tiene

1

(3.3)

VIF^.; ^ VlF^ +

1 - v„ (z)

donde a; _(a^;1. EI resultado de (3.3) es particularmente interesante porque

establece una conexión dírecta entre un diagnóstica de colinealidad en Z; y

e! potencial v,; (z^.

A partir de {3.2) pueden investígarse propiedades adicionales de los p

primeros factores de inflación de la varianza de Z, . Sea c^ el j-ésimo vector

canónico de RP ( j= 1,..., p}. En virtud de la desigualdad de CauchySchwartz es a?= (c^ (Z'Z)^'z; )^ ^ VI F^ v;, (z) ( j= 1,..., p). Sustituyendo en

C3.2} se Ilega a la desigualdad.

VIF^

(3.4}

(j=1 ,...,p}

VIF^<_VIF^;<

1 - v„ (z)

De {3.4} se deduce que los p prímeros factores de inflación de la varianza

de Z; son superiores, uno a uno, a los correspondierites de Z. Además,

cuando v;; (zJ -^ 0 es Vi F^,; ---^ VI F^ ( j= 1,..., p}. Esta última conclusión

puede obtenerse también como corolario del siguiente

TEQREMA 3.1

Si v;; (z)-^ 0, la norma euclídea de la diferencia entre (Z; Z; )^' y la matriz

mxm

(Z'Z)-' 0

0

tiende a 0.

1

(3.^}

89

C)BTFZ(^!O^. SlMI LTA`E:•^ D^ Ml'LTJ( ()l_ItiE.ALli^AD

D EMOS TRA CION

SI (I . ^I E denota la norma euclídea de una matriz es fácil demostrar,

usando (A.1), (A.2 ) y la desigu aldad a2^, < V I F^ v„ (z) (j = 1 ,..., p}, que

I) (Z; Z, }-^

<<

v„ (^}

2

(Z'ZI-'

0

0

1

1

^„ (z)

v^ ( z)

(^1/IF^ } +

(1--v„ (2 ^ }^ '

( ^ -v„ (z})2

1-- v„

^viF2+^ viF

J

^

/=k

expresión que tíende a cero cuando v„ (z} tiende tarnbién a cero.

Finaimente, a la vista de (3.31 y(3.4) puede comentarse que, medida por

los factores de inflacíón de la varianza, la perturbación causada en la

coiinealidad de ia matriz de diseño al añadir la columna d, es tanto menor

cuanto sea el potencial v;; {z).

3.1.2 Autosistema

Sean 0 < ^:, ;<^ 2;<...< ^^, ; los autovalores de la matríz Z; Z; y

y^;; (j = 1,..., m) los correspondientes autovectores normalizados. Dos son

los resultados que conforman este apartado. EI teorema 3.2 es un análogo

al teorema 3.1 relativo a los factores de inflación de la varianza mientras

que el teorema 3.3 es un teorema de separacíón entre los autovalores de la

matriz ( 3.1) y ios de la matriz de correlación Z'Z. Supóngase que (x, ..., y)

indica una ordenación de coordenadas en sentido creciente.

TEOREMA 3.2

S i v;; (z) --^. 0, ( ^ ^ ; . . . . , ^,r,. ^ ) --^^ ( ^., , . . . , ,^^, 1 }

DEMOSTRA CION

En virtud del teorema 3.1 la inversa de Z,' Z; tiende a la matriz ( 3.5) en

norma euclídea cuando v;;(z) ---3 0. Como {3.5) es definida positiva, Z; Z;

también tiende, en norma euclídea, a la matriz

)

(3.6)

de autovalores (.^, ,..., í^a 1 }(Stewart (1973), cap. IV). Teniendo en cuenta

la continuidad de los autovalores considerados como funcionales de la matriz correspondiente (Kato, 1982} se tiene

90

ESTADISTICA ESPAÑn1.A

Como consecuencia directa, se tiene ^,; --^^, ,^.m,; -^ ^ ^,p y también

k(Z;) --^^ k(Z}.

Este teorema 3.2 tiene un inrnediato análogo para autovector en virtud, de

nuevo, de los resultados del libro de Kato 11982). Por consiguiente, cuando

v;; tz) --^ o el autovector normalizado y,,; asociado a í^,,; está próximo a1

autovector r»x1 ty', , 0)' de la rnatriz (3.6) correspondiente al autovalor ^,, .

EI siguiente resultado muestra cómo, salvo en situaciones de carácter patológico, los autovalores de la matriz Z'Z separan, uno a uno, a ios autovalores de la matriz (3.1).

TEOREMA 3.3

Sea C la matriz ortogonal pxp de la descomposición espectral de la matriz Z'Z. Si los autovalores de Z'Z son todos distintos entre sí y

k; = Cí; es un vector px1 cuyas componentes son todas distintas de 0, se

tiene

C^

^

/^.1 i ^ /^.1

C /^,2 i ^ /^.2 ^ . . . . . . . . C 1^,p C

^ m, i

DEMOSTRA CIÓN

Consultar Vefilla (1987}

3,2 M^todo reducido

La teoría desarrollada en esta sección puede utilizarse para proponer un

método práctico de detección simultánea de colinealidad y observaciones

extremas. EI procedimiento se ejecuta en etapas:

i} Calcular las n magnitudes VIFi (i= 1 , . . . , %%}.

En virtud de la identidad ^3.3) el análisis de VI Fi es equivalente a la detección de potencial en ^ 1.1). EI cálculo de VIFi puede efectuarse empleando, por ejemplo, subrutinas de! paquete de programas IMSL.

ii) Calcular i° tal que mín VIF' = VIFi°.

i

Si VI F^° ^ 1 0, equivalentemente, v;o;o lz) ^ 0

los diagnósticos de Z'Z se pueden aproxímar por los de Z;o Z;o en virtud de

los teoremas 3.1 y 3.2.

EJEMPL^

En esta sección se discute un ejemplo ilustrativo de la aplicación de la

teoría de la sección 3. Se trata de un conjunto de datos muy conocido

relativo a un modelo

OBTENCION SIMLILTANEA DE MULTICOLINEAL[DAD

9I

Y- j^o + Q, x, +%32 x^ Q3 x3 +^ sobre n = 19 ratas y que ha sido analizado anteriormente por Cook y Weisberg ( 1982), Weisberg (1985) y Cook (1986),

entre otros. Los datos aparecen recogidos en la Tabla 4.1

TAF3LA DE DATOS

X,

x2

x3

Y

176

176

190

176

200

167

188

195

176

165

158

148

14 9

163

170

186

146

181

149

6.5

9.5

9.0

8.9

7.2

8.9

8.0

10.0

8.0

7.9

6.9

7.3

5.2

8.4

7.2

6.8

7.3

9.0

6.4

0.88

0.88

1.00

0.88

1.00

0.83

0.94

0.98

0.88

0.84

0.80

0.74

0. 7 5

0.81

0.85

0.94

0.76

0.90

0.7 5

0.42

0.25

0.56

0,23

.023

0.32

0.37

0.41

0.33

0.38

0.27

0.36

0.21

0.28

C?.34

0.28

0.30

0.3 7

0.46

n=19,m=4,p=3.

EI significado de las variables es

Y=

porcentaje retenido de una dosis de droga en el hígado de

la rata.

.

peso de la rata en gra mos.

x2= peso dei hígado en gramos.

x3 =

dosis relativa de droga administrada.

ESTA[)ISTI( A ESPAti(.)LA

yZ

De análisis anteriores es sabido que la observación 3 es extrema con un

potencia! v33 = 0.85. Un aspecto hasta ahora no suficientemente explorado

es la existencia de una fuerte colinealidad estructural en los datos de la tabla 4.1. La regla de asignación de la droga en el experimento subyacente

es la de administrar, aproximadamente, 40 mg. de droga por Kg. de peso

corporal y, por tanto,

( x, / 10 0 )

t4.1 ^

2

La relación ( 4.1 ) establece, entonces, una dependencia lineal aproximad^

entre las columnas 1 y 3 de la matriz X. En este ejemplo conviven, pues,

los problemas de colinealidad y observaciones extremas. La detección simultánea de ambos pueden efectuarse usa^^do e! método de la sección 3.

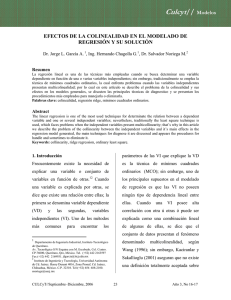

En la primera etapa se trata de examinar !os diagnósticos VIF'. La figura

4.1 es un gráfico caso por caso en el que se detecta inmediatamente el

caso 3 c^mo extremo. EI caso íe= 9 resulta ser aquel cun el menor diagnóstico VI F^

•^ • • • • * • • • ^ ♦ • • • • f • • • • + • • • • ♦. • • ^ * • • • • ♦ •

5.25

+

•

+^

Figura 4.1

T

•

•

•

•

•

•

•

^ 3.50

♦

1.75

♦

+

vlF^

l

1

t

.

•

^ O.oo

^^\

^\

^.---+Ic - r ---t

0^-- ^' --^f^-^- - - * ---i=

^

.

•

^

•f•••• ♦• • s•^••••F••••*•• ••+• •••♦•••• *•

3.

.

15

9.

6.

I ndice de caso

12

18

OBTENC(ON SIMULTANEA DE MULT!(^'OLINEAl.^IUAD

93

La tabla 4.2 contiene, en su primera columna, los diagnósticos VI F^ s

^^ 1,2,3), ^., s y que detectan inmediatamente una situación de colinealidad

debida a la fuerte asociacián lineal entre las variables x, y x^ en corcondancia con la información de (4.1). ^a columna derecha de esta tabla muestra

los correspondientes diagnósticos calculados para la matriz tipificada Z.

Obsérvese que, en consonancia con las conclusiones de los teoremas 3.1 y

3.2, la diferencia entre la colinealidad en Zs y Z es muy pequeña.

x,

x2

x3

V I F^,s

V I F^

51.3 9 7

1.336

50.664

51.000

1.336

50.336

^ r,s = 0.009 8

^,, = 0.0099

0.7097

-0.0094

. 0.7095

-0.0095

^ m/n, 9 -

--0.7 044

^min

=

_0.7 047

--0.010 7

TABLA 4.2

5.

EXTENSfOIVES

Los resultados de la sección 3 tienen una extension natural a la detección simultánea de multicolinalidad y observaciones influyentes usando

técnicas de análisis de condición en las matrices Z* de (2.10). La matriz

Z* _(Z,y) es la versión tipificada de la matriz ampliada X* _(X,Yy asociada al

modelo (1.1 }.

Sea V* ^(v;; )= X* (X* X* j -' X*' ia matriz de proyección sobre la variedac^

lineal engrendrada por las columnas de X*. Puede demostrarse que

v;*= 1 ^ (1 - v;; ) (1 - ^/n-m)

( 5 .1)

de donde (5.1) crece con las coordenadas del bloque (v;;, r?). De hecho,

Andrews y Pregibon ( 1978) desarrollan una medida de influencia de coinci-

y^i

^:s^^r ^^r^is-r^ic^.^^ E^.^P.^ti^^t ^^

de con 1-v;; , Sea z,*' (z; , y, ) la estructura formada por i--ésima fila de Z y la

i--ésima respuesta tipificada y, . En analogía con (2.7) se tiene

v,^ _ ^ + z;" ( Z *' Z * ) ^' z *

n

{ 5.2 )

_ 1 + v,* (z)

n

donde v;* (z) = z*(Z*' Z* )-' z*

AI efectuar un desarrollo paralelo al de la seccián 3 aplicado, esta vez, a

Z* se han de obtener, por fuerza, métodos de estudio simultáneo de potenciales ampliados v,^(z) y de la colinealidad en Z. En virtud de los resultados

expuestos en Velilla (1 9$7, cap. II) ésta última está relacionada con la

colinealidad en Z,

5.1 Factores de inflación de la varianza.

No es el objetivo de esta sección entrar en el detalle de la exposición

teórica correspondiente que puede encontrarse en Velilla ( 1987). Desde el

punta de vista práctico los resultados más importantes se obtienen con los

factores de inflación de la varianza de Z;`. Sean VI F^; ( j= 1,..., p) y VI Fm;

los m primeros factores de inflación de la varianza asociados a Z* y sea

VI F'' el úitimo. Sean también VI F^ ( j= 1 ,..., p) y VI Fm los factores asociados a Z*. se demuestra que

e;

VIF^,=VIF*+ (1-v,*(z))-' ( c,(Z'Z)-'

(5.3)

(j = 1,..., p) donde c^ es el j--ésirYio vector canónico de RP, ^^ e1 j-ésímo

estimador rnínimo-cuadrático en el modelo (2.1) y SCE ia suma de cuadrados de los errores en el modelo ( 1.1). Más importantés que (5.3) son las

expresiones de V 1 Fm ; y V I F*'. Se tiene

V I F*,.; = V I F m (1- r^ (z) /n--mr'

S. 4)

Y

1

VIF*'=

(5.5)

1- v^* (z)

En (5.4), r; (z) es una modificación del resídual r; de (2.5) dada por

r; (z) _

(5.6)

1 )z

OHT^E^i('I(7ti SIMI'L_T^^!tiE.^^ f)E M['1.TIt^O1_!ti^•^(_^ll)^^f)

De acuerdo con (5.6) y 12.7) r; (z) ^ r, cuando n es grande. Un «outlier»

tiende, pues, a provocar la aparíción de un diagnóstico anómalos VI F^„ . Por

otro lado, en ( 5.51 VI F*' es función monótona de la medida de influencia

v,*(z) de 15.2).

5.2 Método generat.

Tres son las etapas de este método general.

i} Estudiar los valores de VI F*' (i = 1,..., n).

Las observaciones inf(uyentes se destacarán en un gráfico caso por

caso.

iij Distinguir si la observación z,* (z; , y; ) es extrema Iz, ) o«outlier» (y; ).

De (5.4) es ínmediato que un gráfico caso por caso de

*

v m, i

_ (1-r^ (z) /n-mr'

( 5 .7 )

1/ I Fm

es aproximadamente equivalente al gráfico de r?. Análogamente a

(5.1) es v;*(z) = 1 -(1-v;; (z1} (1--r?(z)/n-m) y sustituyendo en (5.5) se

tiene

VIFm VIF*^

VIF'=

*

(5.$)

V m, i

que, según (3.3), depende directamente del potencial de la observación %-ésima.

iii) Calcular i° tal que mín V/F*'=VIF*^°.

i

Aproximar los diagnósticos de Z*' Z* por los de Z ó Z o y analizar la colinealidad en Z usando las técnicas de Velilla (1987), cap. II).

5.3 Ejemplo

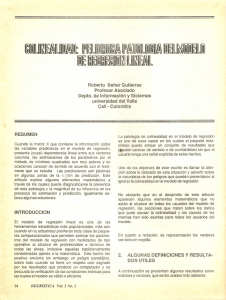

Valviendo de nuevo al ejemplo de la sección 4, la figura 5.1 es un gráfico

caso por caso de VIF*' que detecta inmediatamente la observación 3 como

infiuyente. La figura 5.2 es el gráfico análogo de

VIFm; /VIFm que, por lo que se refiere a los residuales, no indica nada

anormal. La pecu liaridad observación 3 se debe, entonces, a que x3 está

alejado del centro de los datos.

96

ESTADISTIC'A ESPAÑOLA

• t • • • • +• • • • f . • • • ♦ • • • . ♦ • • • . ♦ • . • . + • • • • + •

5.2 5

+

^

Figura 5.1

}

.

.

3.50

V I F'

1 . 75

.

.

+

I

1

.

.

.

•

.

.

^

^

.

+

.

•

.

t

♦

^^

^

^

1l\

• ^

^

0.00

+

#

a ^ • • • • ^ • • •

^

^Y .^^.^_'• *

• t r • • • ^ • • • • T' • • • • ^ i ^ • • ^ • • • ^ + •

15

9.

3.

6.

12

18

Indice de caso

••♦•• ••♦• •••♦•••• ♦•••• *•• •• ♦•• ••♦•• : • ♦ ^

1 •50

*

t

Figura 5.2

•

•

^

1.25

^

♦

•

^.

i

,^

/

•

.

V^Fm

1.00

+

.750

.

f

^"

^-# 1^ ^--^á ^t!

^

.

t

•t•^• •• t• • • •t•• •• t• • • • t • • •• *• • • •t • • •• t•

3.

9.

fi•

1Z

Indice de caso

15

18

9%

OBTENCION SIMULTANEA DE MULTICOLINEALIDAD

6.

DISCUSION Y SUMARIO

Este art%u1o describe un método de obtención simult^nea de colineaiidad

e influencia en regresión lineal. La idea es utilizar técnicas de análisis de

condición como herramientas de obtención de información conjunta sobre

ambos problemas. EI método puede ejecutarse empleando paquetes de

programas conocidos.

La idea de buscar una estructura de análisis combinado de multicolinealidad e influencia se encuentra en Hocking y Dunn (1982), donde se propone una técnica basada en los gráficos de componentes principaies. EI

método de este trabajo incorpora diagnósticos gráficos y conclusiones

deducidas de importantes resultados teóricos.

Finalmente, una exposición más detaliada de los desarroiios y ei ejemplo

de este artículo puede encontrarse en Velilia (1987^.

APENDICE:

DED UCC/ON DE LA S ECUA CIONES ( 3.2 ) y ( 3. 3).

En virtud de la expresián ( 3. ^) es inmdiato © btener usando, por ejempio,

Draper y Smith (1985, p^g. 127)

a;

(Z^^-Z^ 2^ ^-)

`

^ -V;; (Z^

!^` Z' \-1 ^

(A.1)

a;^

1

1-v;; (z)

1-v;; (z)

.

donde a;= (a^; )_(Z'Z)-' z; es un vector px1 y v;; (z) = z; (Z'Z)+' z; . Adem^s,

a; a;

(Z'Z_Z^Z, )-^ - (Z'Z)-^ +

(A.2)

1-v;; (z)

E.^^T 1[)IS^^TI(^^•^ ESF'^>^it)I^.A

SUMMARY

SIMULTANEOUS OBTAINMENT OF MULTICOLLINEARITY

AND INFLUENTIAL OBSERVATIONS

A new method for simultaneous obtainment of multicollinearity and influence in linear regression is described . The method is

based on certain techniques of condition analysis applied on

specific perturbations of the design matrix. The behaviour of the

method is illustrated by means of a practical example.

Key words.^ Condition analysis, diagnostics, influential observations, multicollinearity.

REFERENCIAS

ANDREWS, D.F. Y PREGIB©N, D. (1978). Finding outliers that matter.

Journal of the Royal Statistical Society, Serie B, 40, 85-93.

BELSLEY, D.A., KuH, E. y WELSCH, R.E. (1980). Regression Diagnostics. New

York, Wiley.

CooK, R.D. (19861. Assesment of Local Influence. Journal of the Royal

Statistical Society. SerieB, 48, 133-189.

C oo K, R. D. y W E I S B E R G, S. (19 82 ). Residuals and lnfluence in Regression.

New York, Wiley, 2.8 edicián.

GUNST, R.F. (1983). Regression Analysis with Milticollinear Predictor

Variables. Communications in Statistícs, 12, 2217-2260.

'

HOAGLIN, D.C. y WELSCH, R. (1978). The Mat matrix in Regression and

ANOVA. Ameriean Statistician, 32, 17-22.

HoCKING, R.R. y DuNN, M.R. (19$2). Collinearity, Influential Data and Ridge

Regression. Simposio de la Universidad de Delaware sobre Regresión

Rid 9 e.

KATO, T. (1982). A short lntroduction to Perturbation Theory for Linear

Operators. Springer Verlag.

MARQUARDT, D.W. (1 970). Generalized Inverses, Ridge Regression, Biased

Linear Estimation. Technometrics, 12, 591-612.

STEWART, G.W. (1973). lntroduction ta Matrix Computations. Academic

Press.

V ELI LLA, S. (1 98 7). Contríbuciones al ^4 nálisis de los problemas de lnfluencia

y Multicolinealidad en Regresión Lineal. Tesis Doctoral. Universidad

Complutense.

WEISBERG, S. (1985). Applied Línear Regression. New York, Wiley,

2.a edición.