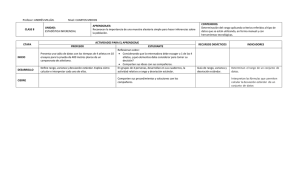

Diseños de investigación, procedimientos - Psicología-UNAM

Anuncio