Universidad Rey Juan Carlos Curso 2011–2012 Inteligencia Artificial Ingenier´ıa Inform´

Anuncio

Universidad Rey Juan Carlos

Inteligencia Artificial

Ingenierı́a Informática

Hoja de Problemas 11

Aprendizaje por refuerzo

Curso 2011–2012

1. Cuáles de las siguientes afirmaciones acerca del algoritmo Q-learning son ciertas

(a) Para garantizar la convergencia de los valores Q a los valores Q∗ óptimos, el

entorno tiene que ser determinista.

(b) Para garantizar la convergencia de los valores Q a los valores Q∗ óptimos, el

entorno tiene que ser estacionario.

(c) Los algoritmos de aprendizaje por refuerzo aprenden la pólitica óptima π ∗ (s)

usando un conjunto de parejas < s, π ∗ (s) >

(d) Los algoritmos de aprendizaje por refuerzo en su versión básica necesitan almacenar un valor Q(s, a) para toda pareja estado-acción < s, a >

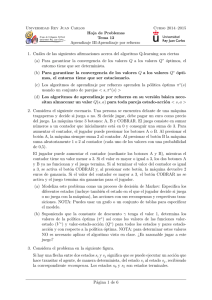

2. Considera el problema en figura.

-10

s0

50

s1

-10

s2

-10

-10

s3

-10

s4

100

s5

-10

Si hay una flecha entre dos estados si y sj significa que se puede ejecutar un acción

que hace transitar el agente, de manera determinista, del estado si al estado sj ,

recibiendo el correspondiente reward. Los estados s0 y s5 son estados terminales.

(a) Calcule los valores V ∗ (s) para todos los estados, suponiendo que γ = 0,8. Calcule

también los valores de Q∗ (s, a) para todas las parejas estado-acción, indicando

para cada estado las acciones que el agente ejecutará, una vez aprendida Q∗ (s, a).

(b) Calcule los valores V ∗ (s) para todos los estados, suponiendo que γ = 0,99. Calcule también los valores de Q∗ (s, a) para todas las parejas estado-acción, indicando

para cada estado las acciones que el agente ejecutará, una vez aprendida Q∗ (s, a).

¿Que diferencia hay respecto al caso anterior? Argumente su respuesta.

3. Considera el siguiente problema con un único estado. Hay una tragaperra con tres

posibles botones (A, B y C), cada uno de los cuales devuelve un reward de 4, 5 y 3

respectivamente. Queremos aprender a seleccionar el botón que má reward genera,

utilizando Q-learning con γ = 0 (ya que es un problema con un único estado) para

entornos deterministas. Supongamos que al principio los valores Q(a) son todos 0.

(a) Compara la suma de los rewards obtenidos ası́ como los valores de Q(a) aprendidos después de 5 interacciones con la tragaperra, usando la polı́tica se selección

greedy, -greedy con = 0,01 y -greedy con = 0,1. Si la selección de la acción

a ejecutar se basa en el valor Q(a) y hay más de una acción con el mismo valor

de Q(a), se elije en order alfabético. Para simular la aleatoriedad de las polı́ticas

-greedy utilice la siguiente secuencia de números aleatorios {0,30,950,40,9990,2}

para decidir si usar la acción a con valor Q(a) máximo. En el caso que haya que

elegir una de las otras acciones al azar, elija en orden alfabético.

Página 1 de 2

Hoja de Problemas 11

Aprendizaje por refuerzo

(b) ¿Que pasarı́a si se inicializan los valores Q(a) todos a 10, y se aplica la polı́tica

greedy?

Página 2 de 2

![[3] y [4] utilizan un modelo SVAR para identificar los efectos de los](http://s2.studylib.es/store/data/007703112_1-5ecba4aeb5e7127f7149d9e1119d9c75-300x300.png)