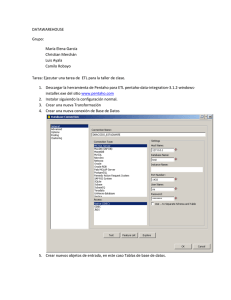

Integración Open Source Estudiantes: José Del Orbe – A00107746 Roxanna Alburquerque – A00109167 Asignación: Practica VI Profesor(a): Juan Pablo Valdez Fecha: 27 de junio 2023, Santo Domingo DN. 1. Defina ETL. Extract, Transform and Load frecuentemente abreviado ETL) es el proceso que permite a las organizaciones mover datos desde múltiples fuentes, reformatearlos y limpiarlos, y cargarlos en otra base de datos, data mart, o data warehouse para analizar, o en otro sistema operacional para apoyar un proceso de negocio. 2. ¿En cuáles situaciones es usual utilizarlos? Data warehousing: En la construcción y mantenimiento de almacenes de datos (data warehouses), el proceso ETL es esencial. Business Intelligence (BI): En el ámbito de la inteligencia empresarial, el ETL se utiliza para extraer datos de diversas fuentes operativas y transformarlos en un formato adecuado para el análisis. Integración de datos: Cuando una organización tiene múltiples sistemas y bases de datos dispersos, el ETL se utiliza para integrar y consolidar los datos en una única. Migración de datos: En los proyectos de migración de sistemas, el ETL se utiliza para extraer los datos del sistema antiguo, transformarlos según los requisitos del nuevo sistema y cargarlos en él. Análisis de big data: En entornos de big data, donde se manejan grandes volúmenes de datos no estructurados o semi estructurados, el ETL se utiliza para extraer y transformar los datos antes de que sean analizados. 3. Mencione alguna de las soluciones de ETL Open Source que conozca. Apache nifi Talend open studio Pentaho data integration 4. ¿A qué se refiere el proceso de transformación? La transformación de datos tiene como objetivo principal asegurar que los datos estén en el formato y estructura adecuados para su uso posterior, por lo tanto, aplica las transformaciones necesarias a los datos extraídos. Esto puede incluir limpiar los datos, realizar conversiones de formato, aplicar reglas de negocio y cualquier otra manipulación requerida. 5. Qué es un área de andamiaje (staging)? El staging area es un espacio de almacenamiento temporal de los datos durante un proceso de ETL, este se ubica en medio entre el origen y el destino, que puede ser un datawarehouse (almacén electrónico donde generalmente una empresa u organización mantiene una gran cantidad de información) o un datamart. Con la utilización de un staging area podemos realizar cargas atemporales que nos permitan agilizar ciertos procesos, también disponemos de un lugar en el cual se pueda desarrollar sin peligro alguno la validación de integridad. 6. ¿Cómo datos? puedo implementar una carga incremental de La carga incremental se refiere al proceso de actualizar o cargar solo los cambios o adiciones más recientes en un sistema de datos, en lugar de volver a cargar todos los datos completos cada vez. En lugar de procesar y cargar todos los datos nuevamente, la carga incremental identifica y carga solo los cambios realizados desde la última carga. Como implementar: • • • • Identificación de cambios: En este paso, debes determinar qué registros han sido modificados o añadidos desde la última carga. Puedes utilizar las estrategias mencionadas anteriormente, como marcas de tiempo, identificadores incrementales o columnas de control. Filtrado de datos: Basado en los cambios identificados, filtra solo los registros que han sido modificados o añadidos. Esto te permitirá reducir el volumen de datos a cargar. Carga de datos: Carga los registros filtrados en el destino correspondiente, como un data warehouse, una base de datos de informes o cualquier otro sistema de almacenamiento. Utiliza la lógica de inserción o actualización adecuada según los requisitos de tu aplicación. Actualización de registros de control: Actualiza los registros de control o metadatos utilizados para realizar la carga incremental. Esto puede incluir actualizar la marca de tiempo, el identificador más alto procesado, la fecha de última carga, entre otros.