TEORÍA DE COLAS TEORÍA DE LA INFORMACIÓN TEORÍA DE LOS JUEGOS

Anuncio

TEORÍA DE COLAS

TEORÍA DE LA INFORMACIÓN

TEORÍA DE LOS JUEGOS

TEORÍA DE DECISIÓN

LEIDY PAOLA GONZÁLEZ CELIS

ESTUDIANTE DE ADMINISTRACIÓN DE EMPRESAS

RUBIELA TOVAR CARDOZO

PROFESORA DE SISTEMAS DE INFORMACIÓN

UNIVERSIDAD SURCOLOMBIANA

FACULTAD DE ECONOMÍA Y ADMINISTRACIÓN

NEIVA-HUILA

2014-2

TEORÍA DE COLAS

Definiciones iniciales

La teoría de colas es el estudio matemático del comportamiento de líneas de

espera. Esta se presenta, cuando los "clientes" llegan a un "lugar"

demandando un servicio a un "servidor", el cual tiene una cierta capacidad

de atención. Si el servidor no está disponible inmediatamente y el cliente

decide esperar, entonces se forma la línea de espera.

Una cola es una línea de espera y la teoría de colas es una colección de

modelos matemáticos que describen sistemas de línea de espera

particulares o sistemas de colas. Los modelos sirven para encontrar un buen

compromiso entre costes del sistema y los tiempos promedio de la línea de

espera para un sistema dado.

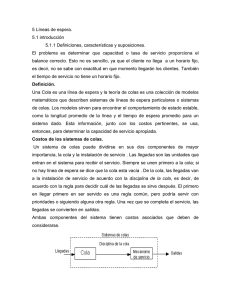

Los sistemas de colas son modelos de sistemas que proporcionan servicio.

Como modelo, pueden representar cualquier sistema en donde los trabajos o

clientes llegan buscando un servicio de algún tipo y salen después de que

dicho servicio haya sido atendido. Podemos modelar los sistemas de este

tipo tanto como colas sencillas o como un sistema de colas interconectadas

formando una red de colas. En la siguiente figura podemos ver un ejemplo

de modelo de colas sencillo. Este modelo puede usarse para representar una

situación típica en la cual los clientes llegan, esperan si los servidores están

ocupados, son servidos por un servidor disponible y se marchan cuando se

obtiene el servicio requerido.

El problema es determinar qué capacidad o tasa de servicio proporciona el

balance correcto. Esto no es sencillo, ya que un cliente no llega a un horario

fijo, es decir, no se sabe con exactitud en que momento llegarán los clientes.

También el tiempo de servicio no tiene un horario fijo.

Los problemas de "colas" se presentan permanentemente en la vida diaria:

un estudio en EEUU concluyó que, por término medio, un ciudadano medio

pasa cinco años de su vida esperando en distintas colas, y de ellos casi seis

meses parado en los semáforos.

Introducción a la Teoría de Colas

En muchas ocasiones en la vida real, un fenómeno muy común es la

formación de colas o líneas de espera. Esto suele ocurrir cuando la demanda

real de un servicio es superior a la capacidad que existe para dar dicho

servicio. Ejemplos reales de esa situación son: los cruces de dos vías de

circulación, los semáforos, el peaje de una autopista, los cajeros

automáticos, la atención a clientes en un establecimiento comercial, la avería

de electrodomésticos u otro tipo de aparatos que deben ser reparados por

un servicio técnico, etc.

Todavía más frecuentes, si cabe, son las situaciones de espera en el

contexto de la informática, las telecomunicaciones y, en general, las nuevas

tecnologías. Así, por ejemplo, los procesos enviados a un servidor para

ejecución forman colas de espera mientras no son atendidos, la información

solicitada, a través de Internet, a un servidor Web puede recibirse con

demora debido a congestión en la red o en el servidor propiamente dicho,

podemos recibir la señal de líneas ocupadas si la central de la que depende

nuestro teléfono móvil está colapsada en ese momento, etc.

Origen:

El origen de la Teoría de Colas está en el esfuerzo de Agner Kraup Erlang

(Dinamarca, 1878 - 1929) en 1909 para analizar la congestión de tráfico

telefónico con el objetivo de cumplir la demanda incierta de servicios en el

sistema telefónico de Copenhague. Sus investigaciones acabaron en una

nueva teoría denominada teoría de colas o de líneas de espera. Esta teoría es

ahora una herramienta de valor en negocios debido a que un gran número de

problemas pueden caracterizarse, como problemas de congestión llegadasalida.

Modelo de formación de colas.

En los problemas de formación de cola, a menudo se habla de clientes, tales

como personas que esperan la desocupación de líneas telefónicas, la espera

de máquinas para ser reparadas y los aviones que esperan aterrizar y

estaciones de servicios, tales como mesas en un restaurante, operarios en

un taller de reparación, pistas en un aeropuerto, etc. Los problemas de

formación de colas a menudo contienen una velocidad variable de llegada de

clientes que requieren cierto tipo de servicio, y una velocidad variable de

prestación del servicio en la estación de servicio.

Cuando se habla de líneas de espera, se refieren a las creadas por clientes o

por las estaciones de servicio. Los clientes pueden esperar en cola

simplemente por que los medios existentes son inadecuados para satisfacer

la demanda de servicio; en este caso, la cola tiende a ser explosiva, es decir,

a ser cada vez mas larga a medida que transcurre el tiempo. Las estaciones

de servicio pueden estar esperando por que los medios existentes son

excesivos en relación con la demanda de los clientes; en este caso, las

estaciones de servicio podrían permanecer ociosas la mayor parte del

tiempo. Los clientes puede que esperen temporalmente, aunque las

instalaciones de servicio sean adecuadas, por que los clientes llegados

anteriormente están siendo atendidos. Las estaciones de servicio pueden

encontrar temporal cuando, aunque las instalaciones sean adecuadas a

largo plazo, haya una escasez ocasional de demanda debido a un hecho

temporal. Estos dos últimos casos tipifican una situación equilibrada que

tiende constantemente hacia el equilibrio, o una situación estable.

En la teoría de la formación de colas, generalmente se llama sistema a un

grupo de unidades físicas, integradas de tal modo que pueden operar al

unísono con una serie de operaciones organizadas. La teoría de la formación

de colas busca una solución al problema de la espera prediciendo primero el

comportamiento del sistema. Pero una solución al problema de la espera

consiste en no solo en minimizar el tiempo que los clientes pasan en el

sistema, sino también en minimizar los costos totales de aquellos que

solicitan el servicio y de quienes lo prestan.

La teoría de colas incluye el estudio matemático de las colas o líneas de

espera y provee un gran número de modelos matemáticos para describirlas.

Se debe lograr un balance económico entre el costo del servicio y el costo

asociado a la espera por ese servicio

Objetivos de la Teoría de Colas

Los objetivos de la teoría de colas consisten en:

Identificar el nivel óptimo de capacidad del sistema que minimiza el

coste global del mismo.

Evaluar el impacto que las posibles alternativas de modificación de la

capacidad del sistema tendrían en el coste total del mismo.

Establecer un balance equilibrado ("óptimo") entre las

consideraciones cuantitativas de costes y las cualitativas de servicio.

Hay que prestar atención al tiempo de permanencia en el sistema o en la

cola: la "paciencia" de los clientes depende del tipo de servicio específico

considerado y eso puede hacer que un cliente "abandone" el sistema.

Elementos existentes en un modelo de colas

Fuente de entrada o población potencial: Es un conjunto de individuos (no

necesariamente seres vivos) que pueden llegar a solicitar el servicio en

cuestión. Podemos considerarla finita o infinita. Aunque el caso de infinitud

no es realista, sí permite (por extraño que parezca) resolver de forma más

sencilla muchas situaciones en las que, en realidad, la población es finita

pero muy grande. Dicha suposición de infinitud no resulta restrictiva

cuando, aún siendo finita la población potencial, su número de elementos es

tan grande que el número de individuos que ya están solicitando el citado

servicio prácticamente no afecta a la frecuencia con la que la población

potencial genera nuevas peticiones de servicio.

Cliente: Es todo individuo de la población potencial que solicita servicio.

Suponiendo que los tiempos de llegada de clientes consecutivos son

0<t1<t2<..., será importante conocer el patrón de probabilidad según el cual

la fuente de entrada genera clientes. Lo más habitual es tomar como

referencia los tiempos entre las llegadas de dos clientes consecutivos:

consecutivos: clientes consecutivos: T{k} = tk - tk-1, fijando su distribución

de probabilidad. Normalmente, cuando la población potencial es infinita se

supone que la distribución de probabilidad de los Tk (que será la llamada

distribución de los tiempos entre llegadas) no depende del número de

clientes que estén en espera de completar su servicio, mientras que en el

caso de que la fuente de entrada sea finita, la distribución de los Tk variará

según el número de clientes en proceso de ser atendidos.

Capacidad de la cola: Es el máximo número de clientes que pueden estar

haciendo cola (antes de comenzar a ser servidos). De nuevo, puede

suponerse finita o infinita. Lo más sencillo, a efectos de simplicidad en los

cálculos, es suponerla infinita. Aunque es obvio que en la mayor parte de los

casos reales la capacidad de la cola es finita, no es una gran restricción el

suponerla infinita si es extremadamente improbable que no puedan entrar

clientes a la cola por haberse llegado a ese número límite en la misma.

Disciplina de la cola: Es el modo en el que los clientes son seleccionados

para ser servidos. Las disciplinas más habituales son:

La disciplina FIFO (first in first out), también llamada FCFS (first come first

served): según la cual se atiende primero al cliente que antes haya llegado.

La disciplina LIFO (last in first out), también conocida como LCFS (last come

first served) o pila: que consiste en atender primero al cliente que ha llegado

el último.

La RSS (random selection of service), o SIRO (service in random order), que

selecciona a los clientes de forma aleatoria.

Mecanismo de servicio: Es el procedimiento por el cual se da servicio a los

clientes que lo solicitan. Para determinar totalmente el mecanismo de

servicio debemos conocer el número de servidores de dicho mecanismo (si

dicho número fuese aleatorio, la distribución de probabilidad del mismo) y la

distribución de probabilidad del tiempo que le lleva a cada servidor dar un

servicio. En caso de que los servidores tengan distinta destreza para dar el

servicio, se debe especificar la distribución del tiempo de servicio para cada

uno.

La cola, propiamente dicha, es el conjunto de clientes que hacen espera, es

decir los clientes que ya han solicitado el servicio pero que aún no han

pasado al mecanismo de servicio.

El sistema de la cola: es el conjunto formado por la cola y el mecanismo de

servicio, junto con la disciplina de la cola, que es lo que nos indica el criterio

de qué cliente de la cola elegir para pasar al mecanismo de servicio. Estos

elementos pueden verse más claramente en la siguiente figura:

Un modelo de sistema de colas debe especificar la distribución de

probabilidad de los tiempos de servicio para cada servidor.

La distribución más usada para los tiempos de servicio es la exponencial,

aunque es común encontrar la distribución degenerada o determinística

(tiempos de servicio constantes) o la distribución Erlang (Gamma).

Notación de Kendall

Por convención los modelos que se trabajan en teoría de colas se etiquetan

Las distribuciones que se utilizan son:

• M: Distribución exponencial (markoviana)

• D : Distribución degenerada (tiempos constantes)

• E k : Distribución Erlang

• G : Distribución general

M / M / s : Modelo donde tanto los tiempos entre llegada como los tiempo de

servicio son exponenciales y se tienen s servidores.

M / G / 1: Tiempos entre llegada exponenciales, tiempos de servicio general y

1 sólo servidor

La teoría de la información, también conocida como teoría matemática de la

comunicación (mathematical theory of communication) o teoría matemática

de la información, es una propuesta teórica presentada por Claude E.

Shannon y Warren Weaver a finales de la década de los años 1940. Esta

teoría está relacionada con las leyes matemáticas que rigen la transmisión y

el procesamiento de la información y se ocupa de la medición de la

información y de la representación de la misma, así como también de la

capacidad de los sistemas de comunicación para transmitir y procesar

información.1 La teoría de la información es una rama de la teoría

matemática y de las ciencias de la computación que estudia la información y

todo lo relacionado con ella: canales, compresión de datos y criptografía,

entre otros.

TEORÍA DE LA INFORMACIÓN

Historia

La teoría de la información surgió a finales de la Segunda Guerra Mundial, en

los años cuarenta. Fue iniciada por Claude E. Shannon a través de un

artículo publicado en el Bell System Technical Journal en 1948, titulado Una

teoría matemática de la comunicación (texto completo en inglés). En esta

época se buscaba utilizar de manera más eficiente los canales de

comunicación, enviando una cantidad de información por un determinado

canal y midiendo su capacidad; se buscaba la transmisión óptima de los

mensajes. Esta teoría es el resultado de trabajos comenzados en la década

1910 por Andrei A. Markovi, a quien le siguió Ralp V. L. Hartley en 1927,

quien fue el precursor del lenguaje binario. A su vez, Alan Turing en 1936,

realizó el esquema de una máquina capaz de tratar información con emisión

de símbolos, y finalmente Claude Elwood Shannon, matemático, ingeniero

electrónico y criptógrafo estadounidense, conocido como "el padre de la

teoría de la información”, junto a Warren Weaver, contribuyó en la

culminación y el asentamiento de la Teoría Matemática de la Comunicación

de 1949 –que hoy es mundialmente conocida por todos como la Teoría de la

Información-. Weaver consiguió darle un alcance superior al planteamiento

inicial, creando un modelo simple y lineal: Fuente/codificador/mensaje

canal/decodificador/destino. La necesidad de una base teórica para la

tecnología de la comunicación surgió del aumento de la complejidad y de la

masificación de las vías de comunicación, tales como el teléfono, las redes

de teletipo y los sistemas de comunicación por radio. La teoría de la

información también abarca todas las restantes formas de transmisión y

almacenamiento de información, incluyendo la televisión y los impulsos

eléctricos que se transmiten en las computadoras y en la grabación óptica

de datos e imágenes. La idea es garantizar que el transporte masivo de datos

no sea en modo alguno una merma de la calidad, incluso si los datos se

comprimen de alguna manera. Idealmente, los datos se pueden restaurar a

su forma original al llegar a su destino. En algunos casos, sin embargo, el

objetivo es permitir que los datos de alguna forma se conviertan para la

transmisión en masa, se reciban en el punto de destino y sean convertidos

fácilmente a su formato original, sin perder ninguna de la información

transmitida.2

Desarrollo de la teoría

El modelo propuesto por Shannon es un sistema general de la comunicación

que parte de una fuente de información desde la cual, a través de un

transmisor, se emite una señal, la cual viaja por un canal, pero a lo largo de

su viaje puede ser interferida por algún ruido. La señal sale del canal, llega a

un receptor que decodifica la información convirtiéndola posteriormente en

mensaje que pasa a un destinatario. Con el modelo de la teoría de la

información se trata de llegar a determinar la forma más económica, rápida y

segura de codificar un mensaje, sin que la presencia de algún ruido

complique su transmisión. Para esto, el destinatario debe comprender la

señal correctamente; el problema es que aunque exista un mismo código de

por medio, esto no significa que el destinatario va a captar el significado que

el emisor le quiso dar al mensaje. La codificación puede referirse tanto a la

transformación de voz o imagen en señales eléctricas o electromagnéticas,

como al cifrado de mensajes para asegurar su privacidad. Un concepto

fundamental en la teoría de la información es que la cantidad de información

contenida en un mensaje es un valor matemático bien definido y medible. El

término cantidad no se refiere a la cuantía de datos, sino a la probabilidad de

que un mensaje, dentro de un conjunto de mensajes posibles, sea recibido.

En lo que se refiere a la cantidad de información, el valor más alto se le

asigna al mensaje que menos probabilidades tiene de ser recibido. Si se

sabe con certeza que un mensaje va a ser recibido, su cantidad de

información es cero.3

Finalidad

Otro aspecto importante dentro de esta teoría es la resistencia a la distorsión

que provoca el ruido, la facilidad de codificación y descodificación, así como

la velocidad de transmisión. Es por esto que se dice que el mensaje tiene

muchos sentidos, y el destinatario extrae el sentido que debe atribuirle al

mensaje, siempre y cuando haya un mismo código en común. La teoría de la

información tiene ciertas limitaciones, como lo es la acepción del concepto

del código. El significado que se quiere transmitir no cuenta tanto como el

número de alternativas necesario para definir el hecho sin ambigüedad. Si la

selección del mensaje se plantea únicamente entre dos alternativas

diferentes, la teoría de Shannon postula arbitrariamente que el valor de la

información es uno. Esta unidad de información recibe el nombre de bit.

Para que el valor de la información sea un bit, todas las alternativas deben

ser igual de probables y estar disponibles. Es importante saber si la fuente

de información tiene el mismo grado de libertad para elegir cualquier

posibilidad o si se halla bajo alguna influencia que la induce a una cierta

elección. La cantidad de información crece cuando todas las alternativas son

igual de probables o cuanto mayor sea el número de alternativas. Pero en la

práctica comunicativa real no todas las alternativas son igualmente

probables, lo cual constituye un tipo de proceso estocástico denominado

Markoff. El subtipo de Markoff dice que la cadena de símbolos está

configurada de manera que cualquier secuencia de esa cadena es

representativa de toda la cadena completa.

Teoría aplicada a la tecnología

La Teoría de la Información se encuentra aún hoy en día en relación con una

de las tecnologías en boga, Internet. Desde el punto de vista social, Internet

representa unos significativos beneficios potenciales, ya que ofrece

oportunidades sin precedentes para dar poder a los individuos y conectarlos

con fuentes cada vez más ricas de información digital. Internet fue creado a

partir de un proyecto del departamento de defensa de los Estados Unidos

llamado DARPANET (Defense Advanced Research Project Network) iniciado

en 1969 y cuyo propósito principal era la investigación y desarrollo de

protocolos de comunicación para redes de área amplia para ligar redes de

transmisión de paquetes de diferentes tipos capaces de resistir las

condiciones de operación más difíciles, y continuar funcionando aún con la

pérdida de una parte de la red (por ejemplo en caso de guerra). Estas

investigaciones dieron como resultado el protocolo TCP/IP (Transmission

Control Protocol/Internet Protocol), un sistema de comunicaciones muy

sólido y robusto bajo el cual se integran todas las redes que conforman lo

que se conoce actualmente como Internet. El enorme crecimiento de Internet

se debe en parte a que es una red basada en fondos gubernamentales de

cada país que forma parte de Internet, lo que proporciona un servicio

prácticamente gratuito. A principios de 1994 comenzó a darse un

crecimiento explosivo de las compañías con propósitos comerciales en

Internet, dando así origen a una nueva etapa en el desarrollo de la red.

Descrito a grandes rasgos, TCP/IP mete en paquetes la información que se

quiere enviar y la saca de los paquetes para utilizarla cuando se recibe.

Estos paquetes pueden compararse con sobres de correo; TCP/IP guarda la

información, cierra el sobre y en la parte exterior pone la dirección a la cual

va dirigida y la dirección de quien la envía. Mediante este sistema, los

paquetes viajan a través de la red hasta que llegan al destino deseado; una

vez ahí, la computadora de destino quita el sobre y procesa la información;

en caso de ser necesario envía una respuesta a la computadora de origen

usando el mismo procedimiento. Cada máquina que está conectada a

Internet tiene una dirección única; esto hace que la información que se envía

no equivoque el destino. Existen dos formas de dar direcciones, con letras o

con números. Realmente, las computadoras utilizan las direcciones

numéricas para mandar paquetes de información, pero las direcciones con

letras fueron implementadas para facilitar su manejo a los seres humanos.

Una dirección con letras consta de dos a cuatro partes. Una dirección

numérica está compuesta por cuatro partes. Cada una de estas partes está

dividida por puntos.

Ejemplo: sedet.com.mx 107.248.185.1

Una de las aplicaciones de la teoría de la información son los archivos ZIP,

documentos que se comprimen para su transmisión a través de correo

electrónico o como parte de los procedimientos de almacenamiento de

datos. La compresión de los datos hace posible completar la transmisión en

menos tiempo. En el extremo receptor, un software se utiliza para la

liberación o descompresión del archivo, restaurando los documentos

contenidos en el archivo ZIP a su formato original. La teoría de la

información también entra en uso con otros tipos de archivo; por ejemplo,

los archivos de audio y vídeo que se reproducen en un reproductor de MP3

se comprimen para una fácil descarga y almacenamiento en el dispositivo.

Cuando se accede a los archivos se amplían para que estén inmediatamente

disponibles para su uso.4

Elementos de la teoría

Esquema de la comunicación ideado por Claude E. Shannon.

Fuente

Una fuente es todo aquello que emite mensajes. Por ejemplo, una fuente

puede ser una computadora y mensajes sus archivos; una fuente puede ser

un dispositivo de transmisión de datos y mensajes los datos enviados, etc.

Una fuente es en sí misma un conjunto finito de mensajes: todos los

posibles mensajes que puede emitir dicha fuente. En compresión de datos

se tomará como fuente el archivo a comprimir y como mensajes los

caracteres que conforman dicho archivo.

Tipos de fuente

Por la naturaleza generativa de sus mensajes, una fuente puede ser aleatoria

o determinista. Por la relación entre los mensajes emitidos, una fuente puede

ser estructurada o no estructurada (o caótica).

Existen varios tipos de fuente. Para la teoría de la información interesan las

fuentes aleatorias y estructuradas. Una fuente es aleatoria cuando no es

posible predecir cuál es el próximo mensaje a emitir por la misma. Una

fuente es estructurada cuando posee un cierto nivel de redundancia; una

fuente no estructurada o de información pura es aquella en que todos los

mensajes son absolutamente aleatorios sin relación alguna ni sentido

aparente. Este tipo de fuente emite mensajes que no se pueden comprimir;

un mensaje, para poder ser comprimido, debe poseer un cierto grado de

redundancia; la información pura no puede ser comprimida sin que haya una

pérdida de conocimiento sobre el mensaje.5

Mensaje

Un mensaje es un conjunto de ceros y unos. Un archivo, un paquete de

datos que viaja por una red y cualquier cosa que tenga una representación

binaria puede considerarse un mensaje. El concepto de mensaje se aplica

también a alfabetos de más de dos símbolos, pero debido a que tratamos

con información digital nos referiremos casi siempre a mensajes binarios.

Código

Un código es un conjunto de unos y ceros que se usan para representar un

cierto mensaje de acuerdo a reglas o convenciones preestablecidas. Por

ejemplo, al mensaje 0010 lo podemos representar con el código 1101 usando

para codificar la función (NOT). La forma en la cual codificamos es arbitraria.

Un mensaje puede, en algunos casos, representarse con un código de

menor longitud que el mensaje original. Supongamos que a cualquier

mensaje S lo codificamos usando un cierto algoritmo de forma tal que cada

S es codificado en L(S) bits; definimos entonces la información contenida en

el mensaje S como la cantidad mínima de bits necesarios para codificar un

mensaje.

Información

La información contenida en un mensaje es proporcional a la cantidad de

bits que se requieren como mínimo para representar al mensaje. El concepto

de información puede entenderse más fácilmente si consideramos un

ejemplo. Supongamos que estamos leyendo un mensaje y hemos leído

"cadena de c"; la probabilidad de que el mensaje continúe con "aracteres"

es muy alta. Así, cuando efectivamente recibimos a continuación "aracteres"

la cantidad de información que nos llegó es muy baja pues estábamos en

condiciones de predecir qué era lo que iba a ocurrir. La ocurrencia de

mensajes de alta probabilidad de aparición aporta menos información que la

ocurrencia de mensajes menos probables. Si luego de "cadena de c" leemos

"himichurri" la cantidad de información que estamos recibiendo es mucho

mayor.

TEORÍA DE JUEGOS

CONCEPTOS BÁSICOS

La teoría de los juegos es una teoría matemática que pretende describir y

predecir el comportamiento de los agentes económicos. Muchas decisiones

dependen de las expectativas que se tengan sobre el comportamiento de los

demás agentes económicos. Es el caso del comportamiento de las empresas

en un mercado en el que opera un reducido número de las mismas, las

cuales establecerán unos precios según cómo cada una suponga la reacción

de las demás. En otros casos, la decisión de reducir los precios dependerá

de si la empresa piensa que las demás reducirán a su vez los suyos o si los

mantendrán constantes. De igual forma, la negociación de un sindicato con

los empresarios dependerá de las estrategias que adopten uno y otro en

función de los procedimientos que creen adoptará el contrario.

La interacción entre los agentes económicos y, por lo tanto, la dependencia

de la adopción de decisiones racionales con respecto a las suposiciones

que hace cada agente sobre las elecciones y estrategias que adoptarán los

demás, ha dado lugar a esta nueva rama de la teoría económica conocida

como teoría de juegos. Surgió a partir de un estudio pionero, ya clásico:

Teoría de juegos y comportamiento económico (1944), de John von

Neumann y Oskar Morgenstern.

Se puede establecer una analogía entre la teoría de juegos y algunos juegos

donde la estrategia de cada jugador depende de los movimientos que

realicen los demás. Para deducir las estrategias óptimas bajo distintos

supuestos sobre el comportamiento del resto, la teoría de juegos tiene que

analizar distintos aspectos: las consecuencias de las distintas estrategias

posibles, la posibilidad de que varios �jugadores� se conviertan en

aliados, el grado de compromiso entre éstos y el grado en que cada juego

puede repetirse, proporcionando a todos los jugadores información sobre

las distintas estrategias posibles.

A pesar de la dificultad de analizar todos estos aspectos, los expertos en la

teoría de juegos han podido identificar ciertas pautas de comportamiento

comunes a distintos juegos. Un instrumento de análisis muy utilizado es la

creación de una matriz de resultados. En el caso sencillo de dos jugadores,

la matriz de resultados indica los beneficios y pérdidas de cada jugador en

función de las distintas estrategias que adoptan. Se puede demostrar que

algunos juegos tendrán una matriz en la que existirá un equilibrio tipo Nash

(debido a John F. Nash, premio Nobel de Economía en 1994). En el equilibrio

de Nash (en un juego con dos jugadores, X e Y) la elección de X es óptima

dada la de Y, y la elección de Y es óptima dada la de X. En esta situación,

cuando se conocen las decisiones estratégicas, ningún jugador puede

arrepentirse de la estrategia que ha adoptado. Sin embargo, el equilibrio de

Nash no tiene por qué desembocar en un resultado tan óptimo como el que

se derivaría de una cooperación directa entre ellos. Un famoso ejemplo de

esta situación es el del �dilema del prisionero�, en la que los dos

jugadores reciben estímulos para confesar su culpabilidad, pero su situación

sería más afortunada si existiera una coordinación adecuada entre ellos.

ESTRATEGIAS DE MAXIMIN Y MINIMAX

Por lo general, para cada estrategia que adopta un jugador o empresa,

existen varias estrategias (reacciones) abiertas para el otro jugador. El

resultado de cada combinación de estrategias empleadas por los dos

jugadores se conoce como rendimiento. Al rendimiento de todas las

estrategias se le conoce como matriz de rendimiento.

En la teoría de los juegos, el jugador A sabe que el jugador B siempre

responderá a A con la acción que minimice las ganancias de A, debido a que

ésta es la estrategia que minimiza las pérdidas de B. Así, el jugador A

adoptará una estrategia de maximín . Es decir, A seleccionará la estrategia

que maximice su ganancia mínima, anticipándose a la reacción de B. Como

es de esperarse, el jugador B adoptará una estrategia de minimax que

minimice las ganancias de A, porque ésa es la estrategia que minimiza las

pérdidas de B.

• Los juegos de suma cero son aquellos en los cuales las ganancias de un

jugador son iguales a las pérdidas del otro.

• Los juegos estrictamente determinados son aquellos en los cuales el

maximín es igual al minimax.

• Se denomina punto de silla a la solución o el resultado de un juego

estrictamente determinado.

EJEMPLO: DILEMA DEL PRISIONERO

Se arresta a dos sospechosos por robo, y si se les condena, cada uno

recibiría una sentencia de 10 años. Sin embargo, si ninguno confiesa, la

evidencia bastaría para una sentencia de 1 año por posesión de bienes

robados. Se interroga a cada sospechoso por separado y no se permite

comunicación entre ellos. El fiscal promete impunidad al que confiese, pero

la totalidad de la sentencia de 10 años al que no confiese. Si confiesan

ambos, cada uno obtiene una sentencia reducida de 5 años. La matriz de

rendimiento para este caso sería:

TEORÍA DE DECISIÓN

La teoría de la decisión es una área interdisciplinaria de estudio,

relacionada con casi todos los participantes en ramas de la

ciencia, la Administración, Economía, la psicología (basados en

perspectivas cognitivo-conductuales). Concierne a la forma y al

estudio del comportamiento y fenómenos psíquicos de aquellos

que toman las decisiones (reales o ficticios), así como las

condiciones por las que deben ser tomadas las decisiones.

Partes de la teoría

La mayor parte de la teoría de la decisión es normativa o

prescriptiva, es decir concierne a la identificación de la mejor

decisión que pueda ser tomada, asumiendo que una persona que

tenga que tomar decisiones (decision maker) sea capaz de estar

en un entorno de completa información, capaz de calcular con

precisión y completamente racional. La aplicación práctica de

esta aproximación prescriptiva (de como la gente debería hacer y

tomar decisiones) se denomina análisis de la decisión y

proporciona una búsqueda de herramientas, metodologías y

software para ayudar a las personas a tomar mejores decisiones.

Las herramientas de software orientadas a este tipo de ayudas se

desarrollan bajo la denominación global de Sistemas para la

ayuda a la decisión (decision support systems, abreviado en

inglés como DSS).

Como parece obvio que las personas no se encuentran en estos

entornos óptimos y con la intención de hacer la teoría más

realista, se ha creado un área de estudio relacionado que se

encarga de la parte de la disciplina más positiva o descriptiva,

intentando describir qué es lo que la gente realmente hace

durante el proceso de toma de decisiones. Se pensó en esta

teoría debido a que la teoría normativa, trabaja sólo bajo

condiciones óptimas de decisión y a menudo crea hipótesis, para

ser probadas, algo alejadas de la realidad cotidiana. Los dos

campos están íntimamente relacionados; no obstante, es posible

relajar algunas presunciones de la información perfecta que llega

al sujeto que toma decisiones, se puede rebajar su racionalidad y

así sucesivamente, hasta llegar a una serie de prescripciones o

predicciones sobre el comportamiento de la persona que toma

decisiones, permitiendo comprobar qué ocurre en la práctica de

la vida cotidiana.

Tipos de decisiones

Existen tipos de decisión que son interesantes desde el punto de

vista del desarrollo de una teoría, estos son:

Decisión sin riesgo entre mercancías inconmensurables

(mercancías que no pueden ser medidas bajo las mismas

unidades)

Elección bajo impredecibilidad

Elección intertemporal - estudio del valor relativo que la gente

asigna a dos o más bienes en diferentes momentos del tiempo

Decisiones sociales: decisiones tomadas en grupo o bajo una

estructura organizativa

Elección entre mercancías inconmensurables

Esta área es importante cuando se ha de tomar la decisión de

elegir, por ejemplo, entre comprar una tonelada de cañones.

Elección bajo incertidumbre

Esta área representa el principal esfuerzo de investigación en la

teoría de la decisión. El procedimiento se basa en el valor

esperado ya conocido en el siglo XVII. El filósofo francés Blaise

Pascal ya lo enunciaba en sus famosas dudas, contenidas en su

Pensamientos, publicado en 1670. La idea del valor esperado

consiste en que cuando afrontamos con un número de acciones,

cada una de ellas con un número de resultados asociados a una

probabilidad diferente, el procedimiento racional es identificar

todos los posibles resultados de las acciones, determinar sus

valores (positivos o negativos) y sus probabilidades asociadas

que resultan de cada acción y, al multiplicar los dos valores, se

obtiene el valor esperado. La acción elegida deberá ser aquella

que proporcione el mayor valor esperado. En 1738, Daniel

Bernoulli publicó un documento influyente denominado

Exposición de una nueva Teoría sobre la Medida del Riesgo, en la

que emplea la paradoja de San Petersburgo para mostrar que el

valor esperado debe ser normativamente erróneo. Proporciona un

ejemplo con un mercante holandés que intenta decidir si asegurar

la carga que quiere enviar desde Ámsterdam a San Petersburgo

en invierno, cuando se sabe que hay un 5% de probabilidad de

perder la carga durante el viaje. En su solución, define por

primera vez la función de utilidad y calcula la utilidad esperada en

vez del valor financiero.

En el siglo XX el interés por este tema fue reiniciado por un

artículo de Abraham Wald en 1939 señalando los dos temas

centrales de la estadística ortodoxa de aquel tiempo: los test de

hipótesis estadísticas y la teoría de la estimación estadística, que

podrían ser aspectos especiales del problema general de la

decisión. Este artículo introduce muchos de los ingredientes

actuales de la moderna teoría de la decisión, incluyendo

funciones de pérdida, función de riesgo, reglas de decisión

admisibles, distribuciones a priori, teoría de Bayes de la decisión,

y reglas minimax para la toma de decisión. La frase "teoría de la

decisión" fue empleada por primera vez en el año 1950 por E. L.

Lehmann.

El crecimiento de la teoría de probabilidad subjetiva, procedente

del trabajo de Frank Ramsey, Bruno de Finetti, Leonard Savage y

otros, extendiendo el ámbito de la teoría de la utilidad a

situaciones donde sólo la teoría de la probabilidad subjetiva

puede ser empleada. En este tiempo se asume que en economía

la gente se comporta como agentes racionales humanos que

toman decisiones bajo riesgo. El trabajo de Maurice Allais y

Daniel Ellsberg mostró que no es tan fácilmente formalizar estas

situaciones. La teoría prospectiva de Daniel Kahneman y Amos

Tversky dio lugar a la economía comportacional. En esta teoría se

enfatiza en las capacidades humanas (opuestas a lo

normativamente correcto) en la toma de decisiones basada en

"perdidas y ganancias", la gente es más focalizada en los

cambios en sus estados de utilidad y en la estimación subjetiva a

menudo sesgada por anclaje.

La Apuesta de Pascal es un ejemplo clásico de elección ante

incertidumbre. La incertidumbre, de acuerdo con Pascal, está en

saber si Dios existe. Las creencias o escepticismos personales

sobre la elección de creer en su existencia.

Elección atemporal

Esta área concierne a un tipo de tomas de decisión donde

intervienen una serie de acciones en diferentes instantes de

tiempo. Por ejemplo, si recibiera una gran cantidad de euros en

un instante de tiempo, podría gastarlos en unas vacaciones de

lujo, proporcionándome un placer inmediato, o por el contrario

podría invertirlo en un plan de pensiones, que me proporcionaría

un beneficio en el futuro. Surge la pregunta de cuál es la decisión

óptima, la respuesta depende parcialmente de factores tales

como el valor de esperanza de vida, la inflación, el interés, la

confianza en el sistema de pensiones, etc. Sin embargo aunque

todos estos factores fueran tomados en cuenta a la hora de tomar

la decisión, el comportamiento humano se desvía de las

predicciones de la teoría prescriptiva, dando lugar a modelos

alternativos en los que, por ejemplo, el interés objetivo se

reemplaza por un descuento subjetivo.

Decisiones complejas

Otras áreas de la teoría de la decisión conciernen con la dificultad

de tomar decisiones debido en parte a la "complejidad" de

cálculo de las expectativas, o bien por la complejidad de la propia

organización que tiene que tomar las decisiones. En tales casos

la teoría no se fija tanto en obtener un cálculo basado en como se

desvía una decisión real de una óptima, sino en la medida de la

dificultad de determinar el comportamiento óptimo a la hora de

tomar la decisión. Un ejemplo de esta teoría puede encontrarse

en el Club de Roma, que ha desarrollado un modelo de

crecimiento económico y de recursos basado en un modelo que

puede ayudar a los políticos a tomar decisiones en situaciones

complejas.

Paradoja de la elección

Se ha observado en muchos casos que existe la paradoja de que

muchas capacidades de elegir puede dar lugar a una pobre

decisión o incluso a una elección errónea. En algunas ocasiones

se ha analizado el problema desde una parálisis del análisis, real

o percibido, o incluso desde una ignorancia racional. Un gran

número de investigadores incluido Sheena S. Iyengar y Mark R.

Lepper ha publicado estudios basados en este fenómeno.1 Una

popularización de este análisis fue realizado por Barry Schwartz

en su libro The Paradox of Choice.2